6 chiến lược hiệu quả ngăn chặn ảo giác trong mô hình ngôn ngữ lớn (LLM)

- Ảo giác trong LLM xảy ra khi mô hình tạo ra nội dung nghe có vẻ hợp lý nhưng thực tế sai lệch hoặc vô nghĩa, ví dụ như đưa ra thông tin sai về triệu chứng bệnh Addison

- Sáu chiến lược ngăn chặn ảo giác trong LLM bao gồm:

• Sử dụng dữ liệu chất lượng cao làm nền tảng kiến thức cho mô hình

• Áp dụng mẫu dữ liệu có cấu trúc rõ ràng để kiểm soát định dạng và phạm vi phản hồi

• Điều chỉnh các tham số như nhiệt độ, tần suất để tối ưu hóa đầu ra

• Thiết kế prompt kỹ lưỡng với hướng dẫn và vai trò rõ ràng

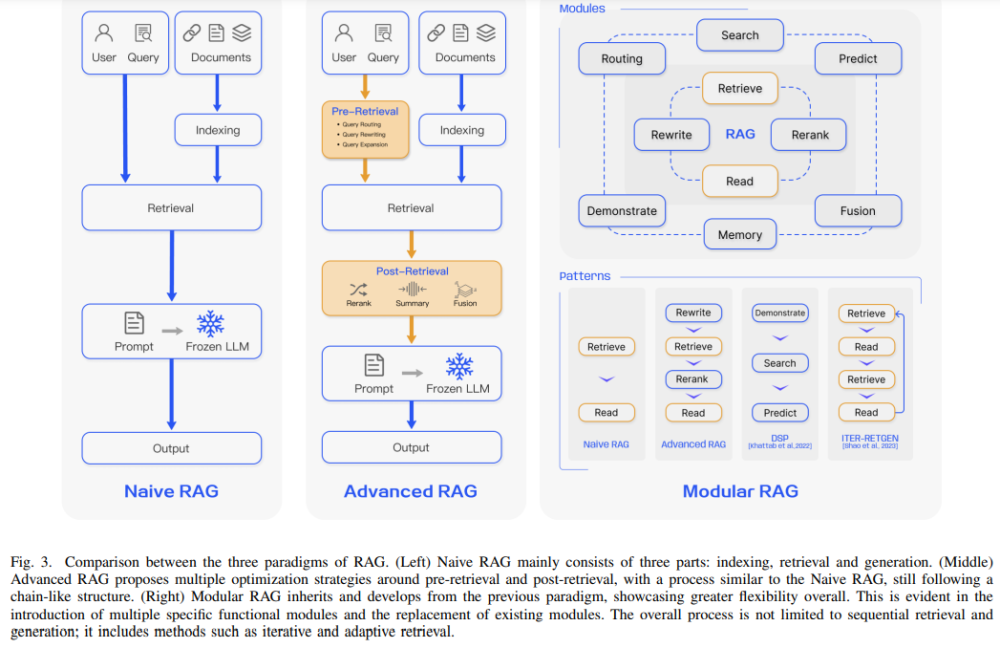

• Sử dụng tạo sinh được tăng cường bởi truy xuất dữ liệu ngoài (RAG) để tích hợp nguồn kiến thức bên ngoài

• Duy trì kiểm tra thực tế bởi con người, đặc biệt trong các lĩnh vực quan trọng

- Lợi ích khi giảm thiểu ảo giác:

• Tăng độ tin cậy trong các ứng dụng quan trọng như y tế, pháp lý

• Nâng cao niềm tin của người dùng vào công nghệ AI

• Ngăn chặn thông tin sai lệch trong tài chính, y học

• Tuân thủ các nguyên tắc đạo đức AI

• Tiết kiệm thời gian và nguồn lực nhờ giảm nhu cầu kiểm tra

• Thúc đẩy nghiên cứu và phát triển AI

• Mở rộng khả năng triển khai AI trong môi trường đòi hỏi độ chính xác cao

📌 Sáu chiến lược từ dữ liệu chất lượng đến giám sát con người tạo nên khung làm việc toàn diện để ngăn chặn ảo giác trong LLM. Các phương pháp này đảm bảo mô hình tạo ra nội dung đáng tin cậy và chính xác cho nhiều ứng dụng quan trọng.

https://www.marktechpost.com/2024/12/08/what-are-hallucinations-in-llms-and-6-effective-strategies-to-prevent-them/

Thảo luận

Follow Us

Tin phổ biến