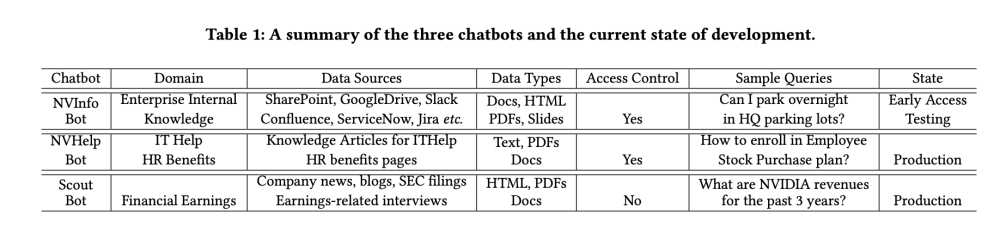

AI tools

View All

-

Ngày 4.9.2025, OpenAI công bố đang phát triển nền tảng tuyển dụng AI mang tên OpenAI Jobs Platform, dự kiến ra mắt giữa năm 2026.

-

CEO mảng Ứng dụng Fidji Simo khẳng định mục tiêu: “dùng AI để tìm ra sự kết nối hoàn hảo giữa nhu cầu doanh nghiệp và kỹ năng lao động.” Sẽ có kênh riêng cho doanh nghiệp nhỏ và chính quyền địa phương để tiếp cận nhân tài AI.

-

Đây là động thái mở rộng của OpenAI ra khỏi sản phẩm cốt lõi ChatGPT, cùng với các ứng dụng tiềm năng khác như trình duyệt web và mạng xã hội.

-

Đáng chú ý, nền tảng này đưa OpenAI vào thế cạnh tranh trực tiếp với LinkedIn (do Reid Hoffman sáng lập, hiện thuộc Microsoft – đối tác tài chính lớn nhất của OpenAI). LinkedIn gần đây cũng đã tích hợp AI để nâng cao khả năng ghép nối ứng viên và nhà tuyển dụng.

-

OpenAI còn triển khai OpenAI Academy, nơi sẽ cấp chứng chỉ “AI fluency” cho các cấp độ khác nhau. Chương trình thử nghiệm OpenAI Certifications sẽ khởi động cuối năm 2025.

-

OpenAI hợp tác với Walmart – một trong những nhà tuyển dụng tư nhân lớn nhất thế giới – trong chương trình chứng chỉ này. Mục tiêu: chứng nhận 10 triệu người Mỹ vào năm 2030.

-

Bối cảnh: nhiều lãnh đạo công nghệ lo ngại AI sẽ tác động mạnh đến việc làm. CEO Anthropic Dario Amodei cảnh báo 50% công việc văn phòng cấp thấp có thể biến mất trước 2030.

-

Trong blog, Simo thừa nhận rủi ro mất việc không thể tránh, nhưng nhấn mạnh OpenAI sẽ đóng góp bằng cách giúp người lao động thông thạo AI và kết nối với doanh nghiệp cần kỹ năng này.

-

OpenAI đồng thời tham gia sáng kiến nâng cao hiểu biết AI của Nhà Trắng. Ngày 4.9.2025, Sam Altman cùng các lãnh đạo Big Tech dự kiến gặp Tổng thống Donald Trump tại Nhà Trắng để thảo luận chính sách AI.

📌 OpenAI chính thức thách thức LinkedIn với Jobs Platform, dự kiến ra mắt 2026, tập trung ghép nối việc làm nhờ AI. Song song, OpenAI Academy đặt mục tiêu chứng nhận kỹ năng AI cho 10 triệu người Mỹ trước 2030, hợp tác Walmart. Trong bối cảnh AI có thể xóa 50% công việc văn phòng thấp cấp, chiến lược này giúp OpenAI vừa mở rộng kinh doanh, vừa gắn chặt với sáng kiến giáo dục AI của Nhà Trắng.

https://techcrunch.com/2025/09/04/openai-announces-ai-powered-hiring-platform-to-take-on-linkedin/

-

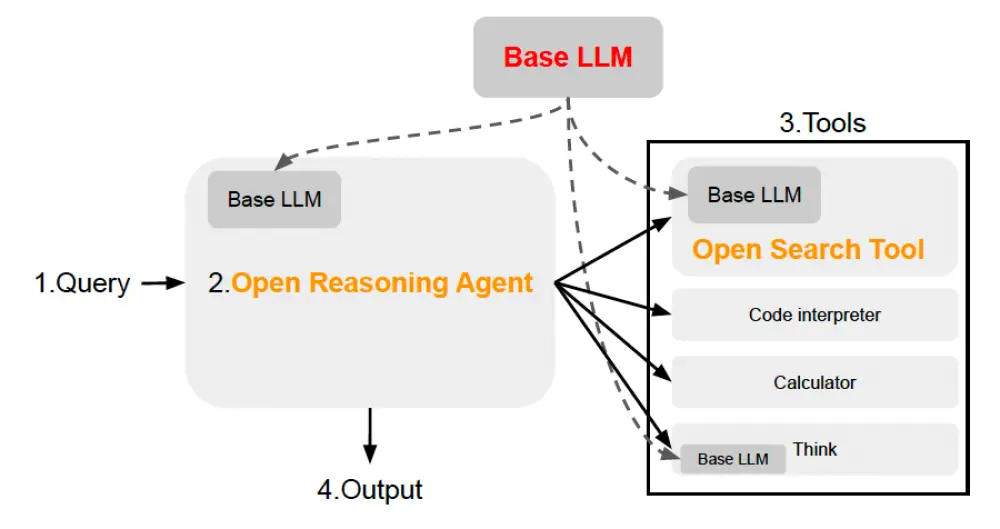

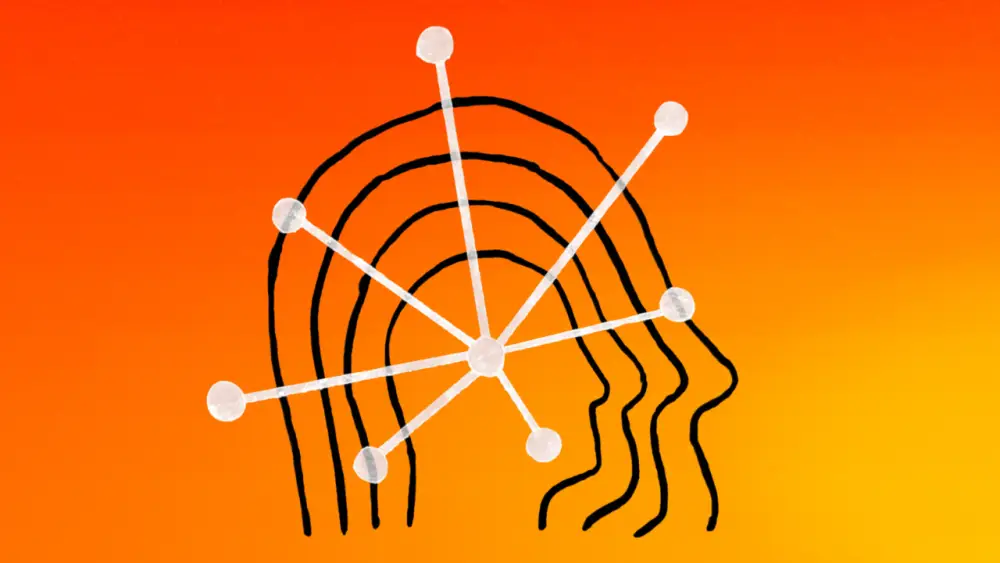

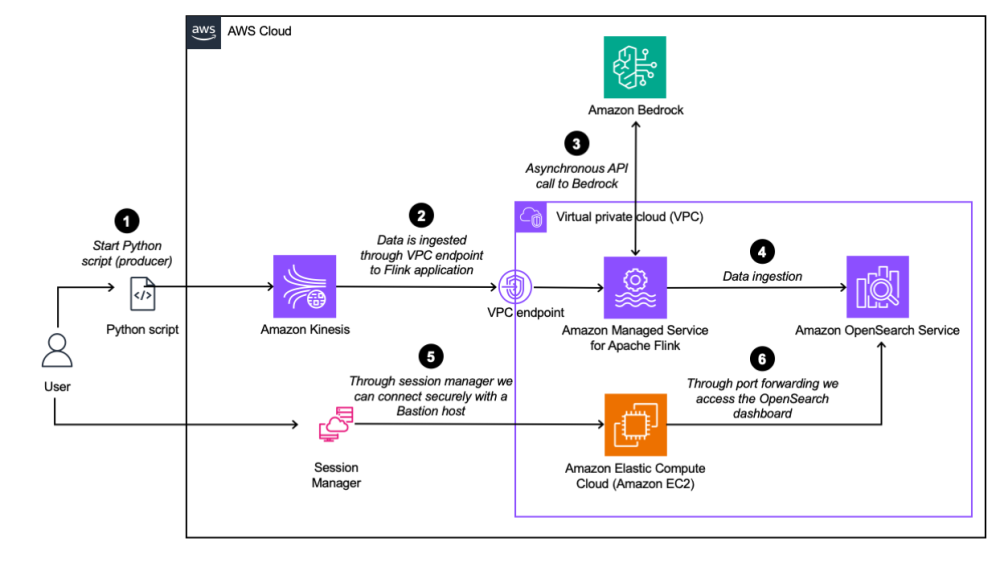

Hệ thống Horizon Line của Israel, phát triển từ năm 2018 trong Bộ Tình báo, sử dụng AI và dữ liệu lớn để dự báo xu hướng toàn cầu, hỗ trợ hoạch định chiến lược quốc gia. Hiện được vận hành bởi Bộ Đổi mới, Khoa học và Công nghệ.

-

Horizon Line bao gồm 4 nền tảng song song, mỗi nền tảng xử lý một lĩnh vực khác nhau: xu hướng xã hội-chính trị, công nghệ tương lai, chuỗi cung ứng, và “siêu xu hướng” (mega-trends).

-

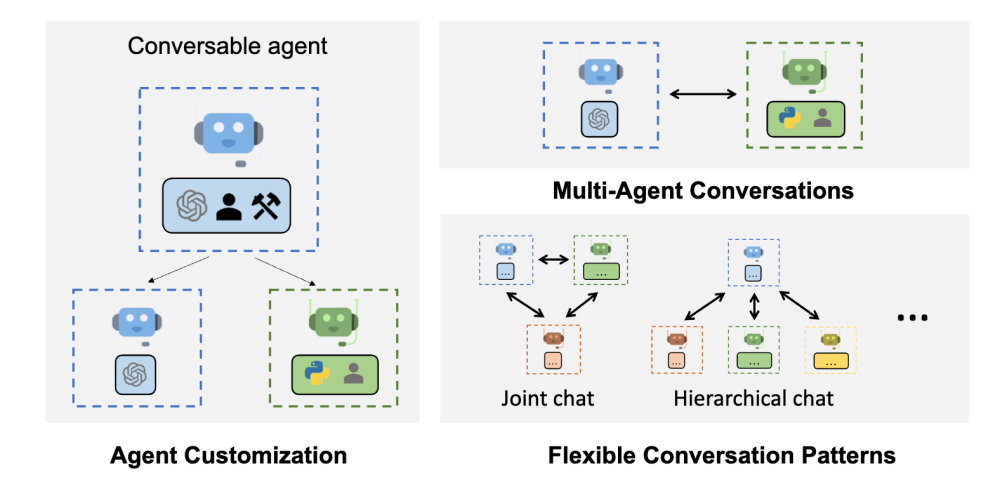

Hệ thống sử dụng mô hình AI đa tác nhân (multi-agent AI), trong đó các “tác nhân” chuyên gia tranh luận và phân tích hơn 4.000 công nghệ tương lai, sau đó tạo ra báo cáo chi tiết kèm biểu đồ và nguồn dữ liệu.

-

Dự báo đáng chú ý của hệ thống trong quá khứ:

-

Cảnh báo COVID-19 và biến động chuỗi cung ứng toàn cầu.

-

Xác định cạnh tranh Mỹ - Trung là chuyển biến cấu trúc, không chỉ là xu hướng tạm thời dưới thời Trump.

-

Nhận diện sớm sự phát triển của robot hình người và đề xuất chính sách cho các bộ ngành Israel.

-

-

Báo cáo mới nhất cảnh báo:

-

Chuyển đổi từ trật tự thế giới đơn cực sang đa cực, với các xung đột lan rộng.

-

Gia tăng bất bình đẳng toàn cầu, hệ thống kinh tế hiện tại đang suy yếu.

-

Nguy cơ các cuộc chiến khu vực liên tiếp (châu Âu, Trung Đông, Trung Quốc - Đài Loan) hình thành một “Thế chiến III phi tập trung”.

-

-

Tiến sĩ Victor Israel cho rằng hệ thống giống như “phòng thí nghiệm cho thực tại thay đổi”, nhằm cung cấp cảnh báo chiến lược để chính phủ không bị bất ngờ trước các “con sóng lớn”.

-

8 lĩnh vực cốt lõi được theo dõi gồm: ý thức hệ, khí hậu, dân số, quan hệ quốc tế, kinh tế, xã hội, công nghệ và địa chính trị – tất cả được phân tích như mạng lưới ảnh hưởng lẫn nhau, không tách biệt.

-

Dù vậy, tiến sĩ Israel thừa nhận: công nghệ không thể thay thế con người ra quyết định, và cảnh báo chỉ có giá trị nếu chính phủ hành động theo khuyến nghị. Vụ tấn công ngày 7/10 không thể được dự báo nếu các dấu hiệu bị bỏ qua hoặc hiểu sai.

-

Israel đang thúc đẩy chiến lược mới: đa dạng hóa quan hệ quốc tế (với Ấn Độ, châu Âu), chuẩn bị cho thời kỳ bất ổn kéo dài, đồng thời đổi mới chương trình giáo dục để phù hợp với kỷ nguyên AI.

📌 Hệ thống AI Horizon Line của Israel đã chứng minh khả năng dự báo xu hướng toàn cầu như đại dịch, cạnh tranh Mỹ - Trung và bất ổn địa chính trị. Horizon Line bao gồm 4 nền tảng song song, mỗi nền tảng xử lý một lĩnh vực khác nhau: xu hướng xã hội-chính trị, công nghệ tương lai, chuỗi cung ứng, và “siêu xu hướng” (mega-trends). 8 lĩnh vực cốt lõi được theo dõi gồm: ý thức hệ, khí hậu, dân số, quan hệ quốc tế, kinh tế, xã hội, công nghệ và địa chính trị – tất cả được phân tích như mạng lưới ảnh hưởng lẫn nhau, không tách biệt. Tuy nhiên, vụ khủng bố ngày 7/10 cho thấy, cảnh báo vô nghĩa nếu Chính phủ không có hành động.

https://www.ynetnews.com/tech-and-digital/article/sjwzzi89le

-

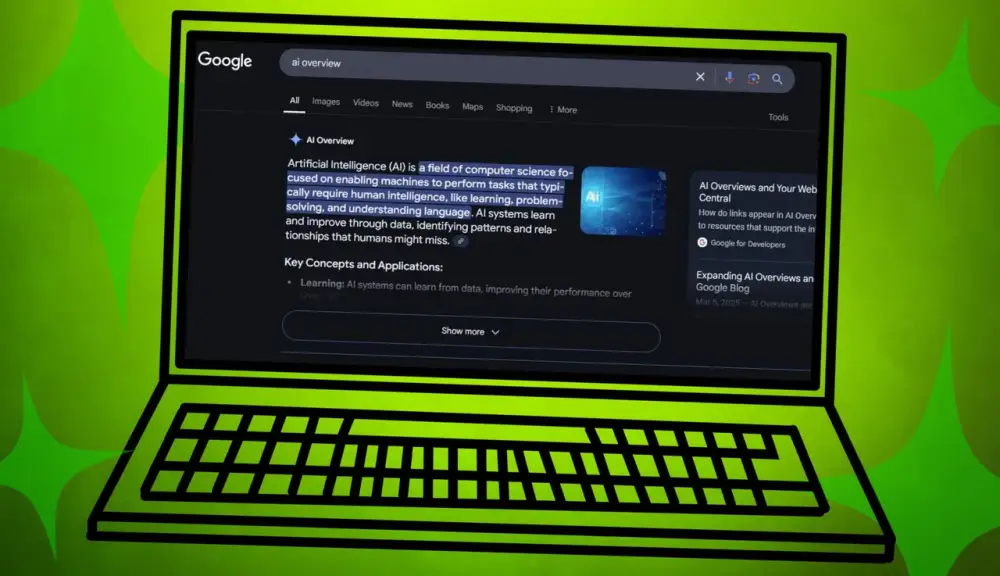

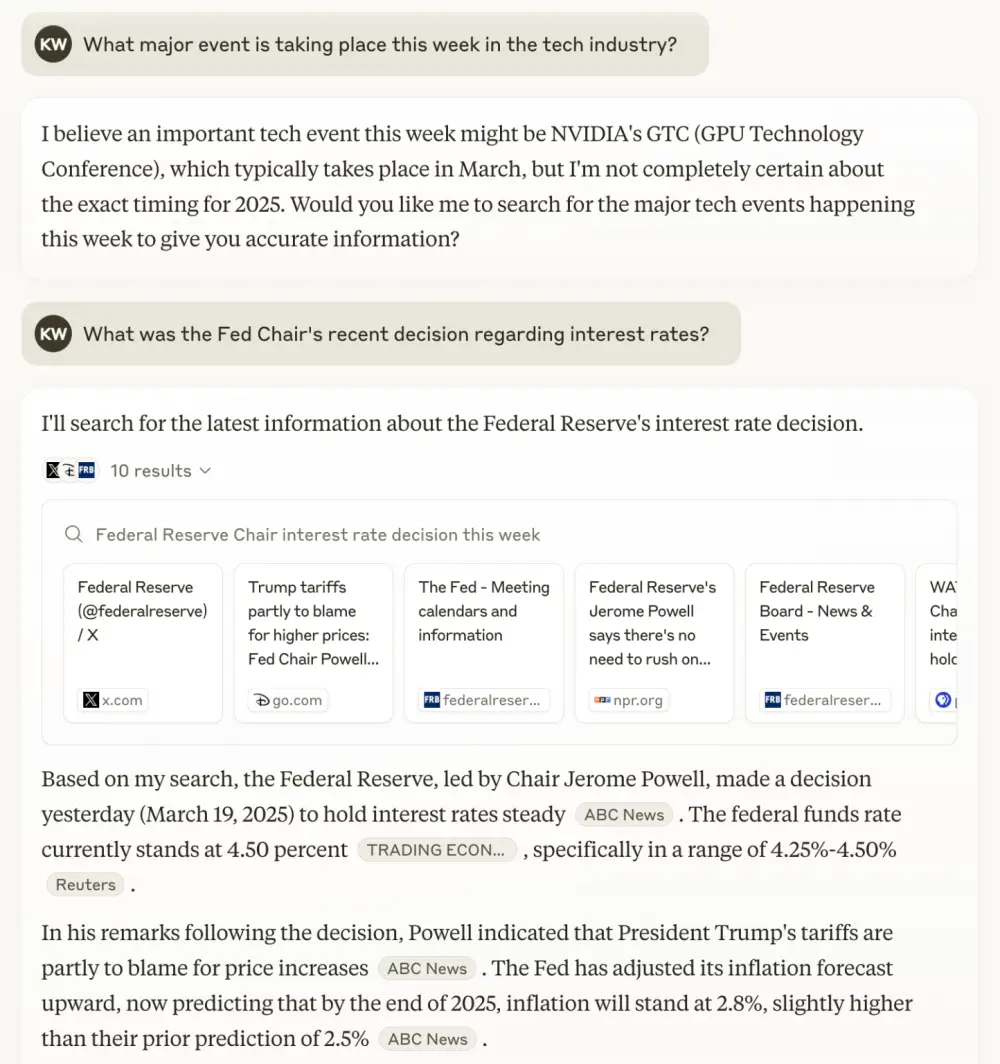

AI đang đặt lại câu hỏi về cách phân phối và khai thác giá trị từ sự chú ý của người dùng trên web.

-

Trình duyệt, từng là công cụ cũ kỹ, nay trở thành vũ khí chiến lược trong kỷ nguyên AI.

-

Perplexity bất ngờ đưa ra đề nghị 34,5 tỷ USD mua lại Chrome. Động thái này phụ thuộc vào phán quyết chống độc quyền buộc Google thoái vốn. OpenAI cũng bày tỏ quan tâm và được cho là phát triển trình duyệt riêng.

-

Chrome hiện có lượng người dùng gấp ba lần Safari. Google từng trả 20 tỷ USD cho Apple (2022) để giữ vị trí mặc định trên Safari. Nếu Chrome có chủ mới, giá trị doanh thu tiềm năng có thể vượt 60 tỷ USD/năm.

-

Tuy nhiên, sự phát triển của chatbot AI có thể làm giảm số lượt tìm kiếm và doanh thu quảng cáo – yếu tố từng duy trì giá trị trình duyệt.

-

Ba kịch bản về tương lai trình duyệt với AI:

-

AI tích hợp trong trình duyệt: hỗ trợ so sánh giá, đọc nhiều bài đánh giá, xử lý tác vụ lặp lại – nhưng người dùng vẫn kiểm soát.

-

Chatbot điều khiển trình duyệt: AI mở tab và lướt web thay cho con người, như agent trong ChatGPT. Người dùng chỉ giám sát ở mức tối thiểu.

-

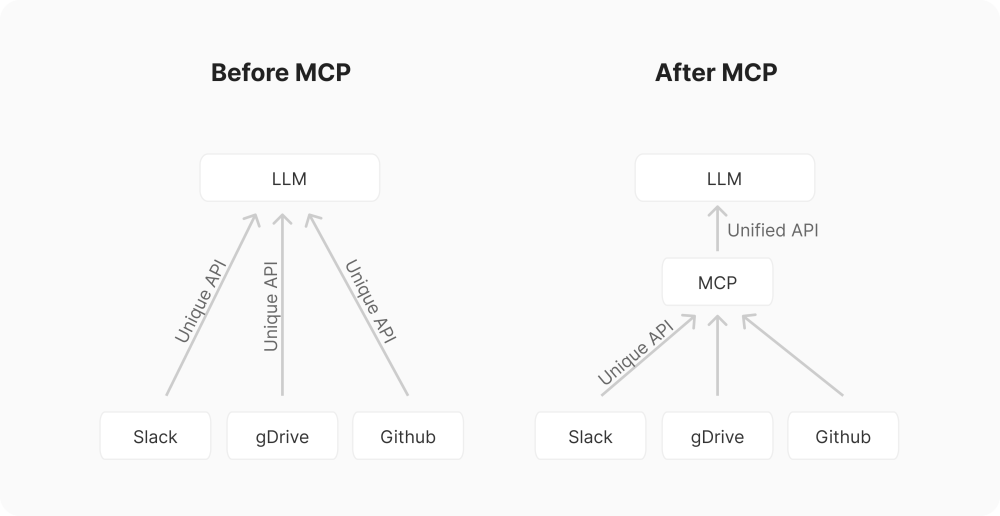

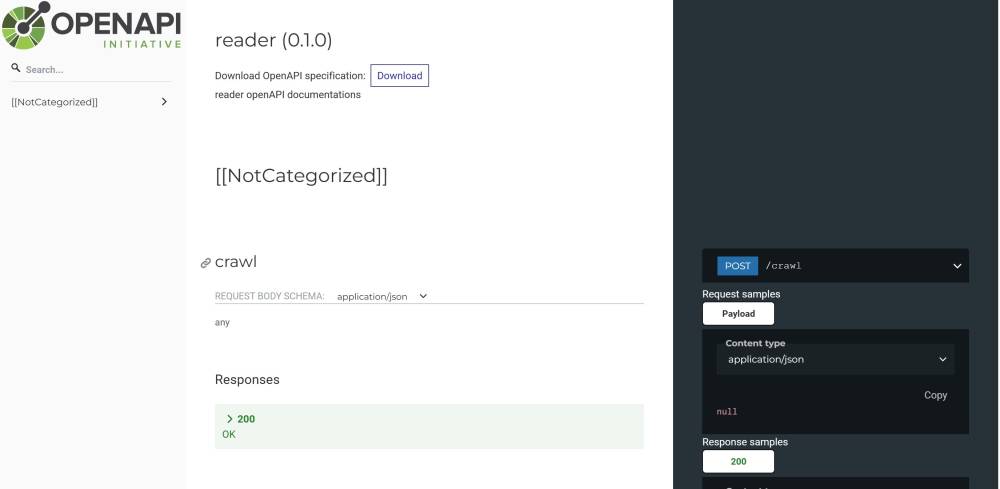

Web cho AI agents: bỏ qua trình duyệt truyền thống, AI kết nối trực tiếp dịch vụ qua API và giao thức mới (MCP, A2A), không cần sự chú ý của con người.

-

-

Vai trò cuối cùng của trình duyệt vẫn chưa rõ, nhưng sự chú ý của con người vẫn là tài sản giá trị nhất. Nếu AI giúp tối ưu hóa tác vụ thường ngày, con người có thể dành nhiều thời gian hơn cho dịch vụ hữu ích.

-

Ngược lại, nếu chatbot hút hết sự chú ý, mô hình web hiện tại – dựa vào trình duyệt và quảng cáo – sẽ bị lung lay.

📌 Trình duyệt trở thành chiến trường mới trong kỷ nguyên AI: Perplexity đề nghị 34,5 tỷ USD mua Chrome, OpenAI nghiên cứu đối thủ. Với Chrome chiếm ba lần người dùng Safari và giá trị tiềm năng 60 tỷ USD/năm, câu hỏi lớn là khi chatbot giảm nhu cầu tìm kiếm, liệu trình duyệt còn giữ vai trò trung tâm hay sẽ bị thay thế bởi “agentic web” do AI vận hành?

https://www.ft.com/content/3bdaa695-6dc6-44d4-93c1-cc766cc707f5

How AI will change the browser wars

The ability to steer large audiences to particular digital services has huge strategic value

Headshot for Richard Waters

Richard WatersAdd to myFT

The Google Chrome logo displayed on a laptop and smartphone screen, with red and green lighting in the background

As chatbots answer more questions directly, there are likely to be fewer searches and less ad revenue for browsers like Google Chrome © Bloomberg

Richard Waters

Mass use of artificial intelligence calls into question behaviours that have underpinned some of the biggest online markets. Among them: how will people’s attention be directed and monetised, if much of what they do on the internet is channelled through chatbots or automated away through AI agents?

Those questions are at the heart of a new war that is brewing around web browsers. Software from the early days of the web might seem an unlikely competitive weapon in the AI era. But its ability to steer large audiences to particular digital services still has huge strategic value, and it is being repurposed to play an important supporting role.

Last week’s announcement by AI upstart Perplexity that it is willing to pay $34.5bn for Google’s Chrome browser was a sighting shot in this emerging battle. The offer will be moot unless the judge presiding over a US antitrust trial forces Google to sell. OpenAI has also signalled it would like to buy Chrome, while reports suggest it is developing a browser of its own.

The interest in Chrome highlights the central role browsers have played in digital distribution. But the battle that is brewing over browsers also points to disruption ahead, as AI changes the way people find information or carry out actions over the web.

Take the value of distribution first. Google paid Apple $20bn to be the default in its Safari browser in 2022, according to evidence produced during its antitrust trial. Chrome has more than three times as many users as Safari, so a new owner might hope for annual revenue of more than $60bn. That points to a far higher potential sale price than Perplexity has offered.

This, however, assumes a continuation of the status quo in which Google splits its ad revenue in return for default browser placement. The whole point of the antitrust case is to cut Google down to size, so letting it bid under a new owner to remain the default in Chrome would defeat the purpose of forcing it to divest in the first place.

Also, will those Google users continue to be worth as much as they are today? As chatbots answer more questions directly, there are likely to be fewer searches and less ad revenue.

This leads to the next question: how exactly will AI change the nature of browsing? More automation implies less human intervention. Three different models for how this might evolve are starting to emerge.

In one, AI embedded into a browser supercharges the user experience by taking over some of the browsing functions. You could, for instance, ask the AI to open multiple web pages to compare airline fares or look at several reviews of a new movie. The browser performs routine work and provides some hand-holding, but a person stays in charge.

This is the direction most browser makers have been moving in (though Google, perhaps wary of stirring up fresh antitrust scrutiny if it moves too aggressively to embed its AI in Chrome, has been cautious so far).

Recommended

John Thornhill

Brace for a crash before the golden age of AI

Construction work takes place on a portion of land between Walnut and Larrison Road and north of Early Road on an $11 billion Amazon Web Services data center

A second approach also involves AI taking on browsing duties, though it takes place from within an AI app. A chatbot opens a browser of its own, then emulates a person, clicking through web pages. This is the idea behind the agent in ChatGPT. The user can still monitor this automated browsing, though the degree of involvement may be small.

In the third, AI agents use purpose-built tools to work online, rather than operating through browsers that were designed for humans. They tap into online services or databases through APIs (or programming “hooks”), and they use new web protocols, with names like MCP and A2A, that are designed to facilitate “agentic” action online. This is a web designed with AI automation at its heart, no human attention required.

What part browser software will end up playing is unclear. As with much about AI, it will take time to see how people adapt to the new technology.

But one thing is certain: human curiosity and attention are a constant that won’t go away. There may be new ways to accomplish routine tasks online, but if that results in people spending more time on the websites or services they find most useful, the value of that attention might actually increase.

AI companies like to claim this means they do not represent an existential threat to the web in its current form, and that businesses that depend on the web for an audience will continue to thrive. Perhaps. But if much of the attention is sucked away by a chatbot, the future of web browsing looks tenuous.

-

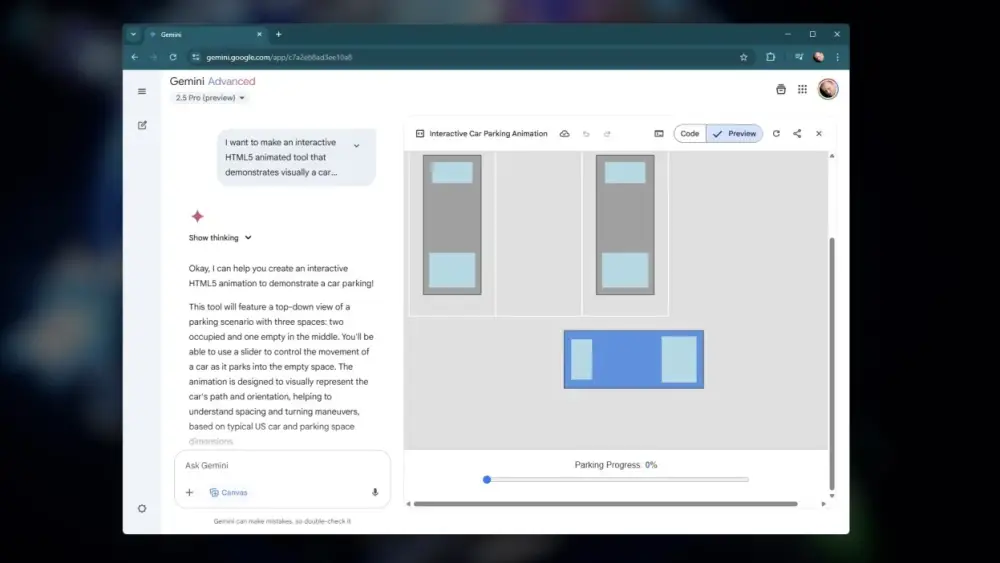

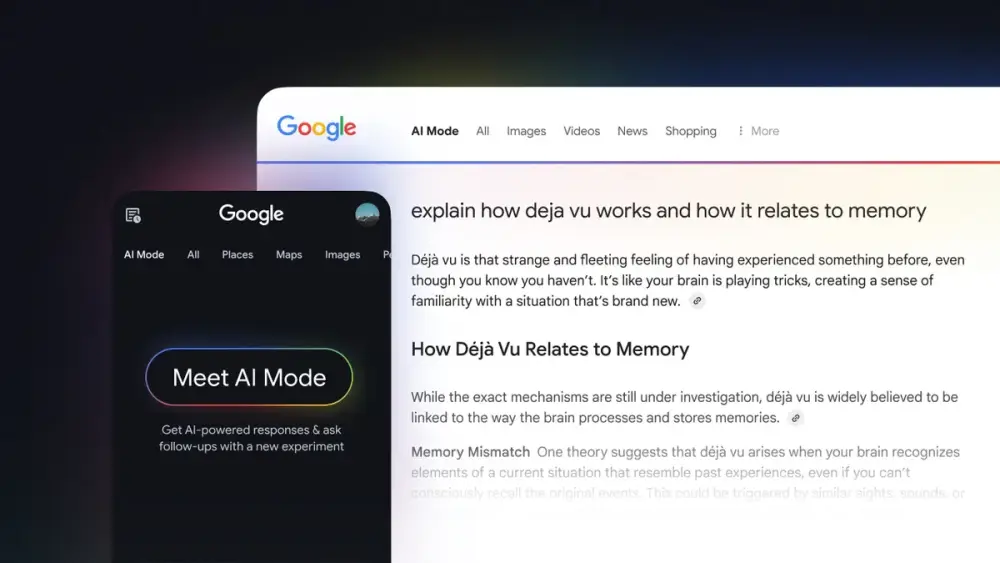

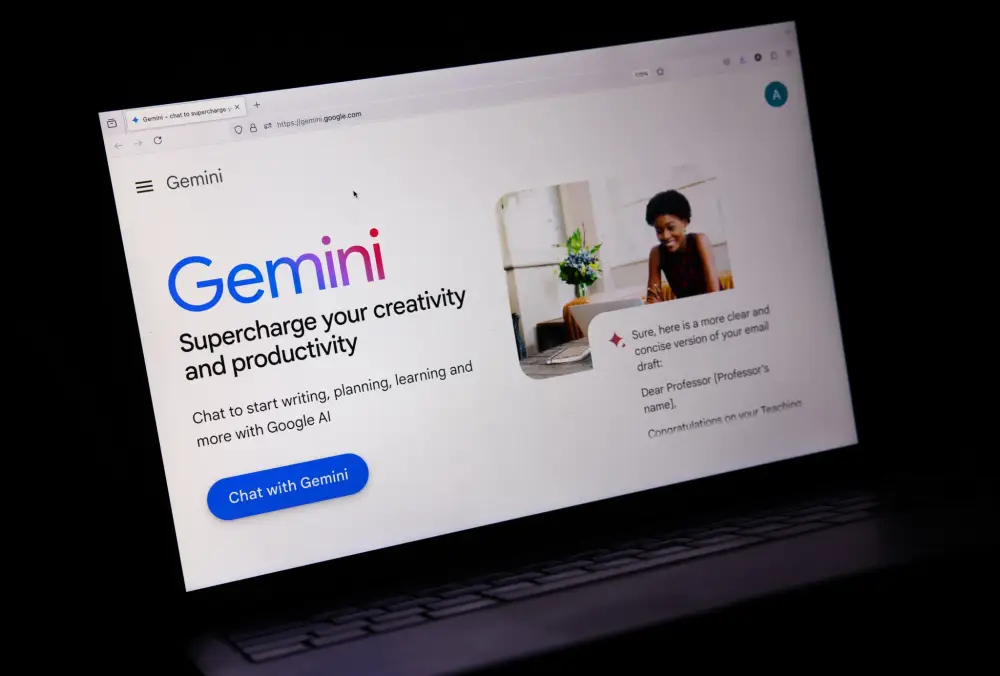

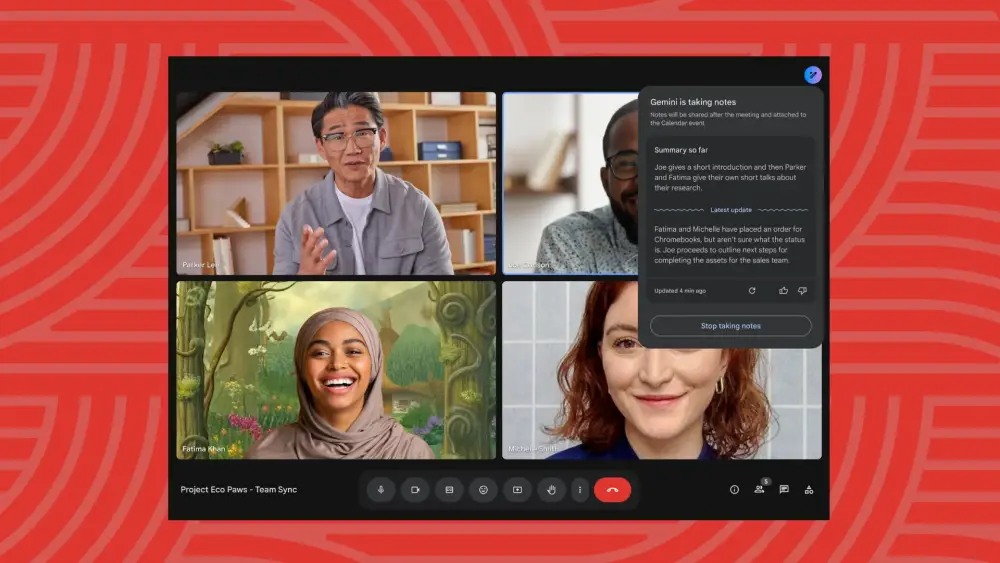

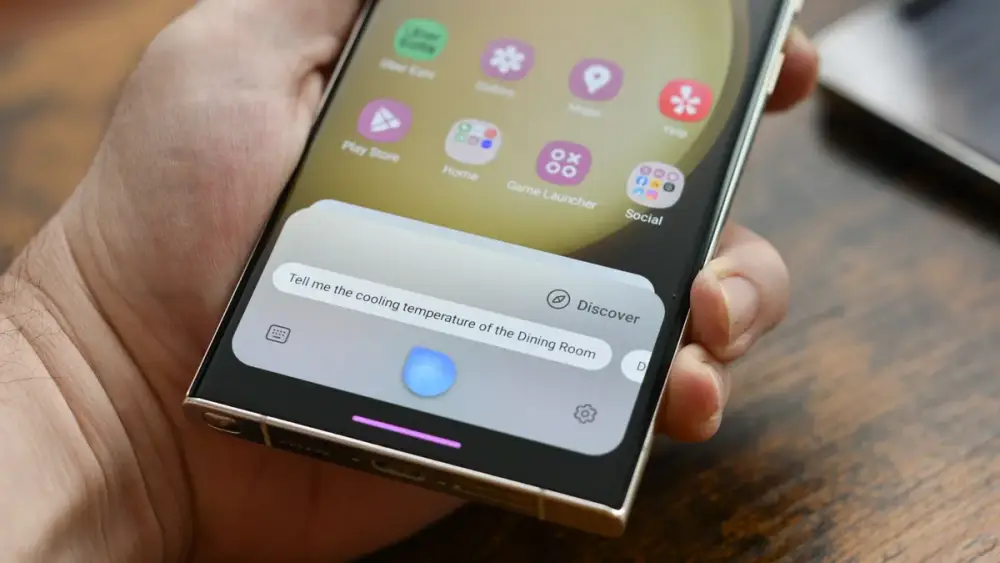

Google vừa công bố nâng cấp toàn diện cho Gemini Live, biến trợ lý AI này trở nên trực quan, biểu cảm và kết nối sâu hơn với hệ sinh thái ứng dụng Google.

-

Tính năng hướng dẫn trực quan mới cho phép Gemini đưa ra chỉ dẫn ngay trên màn hình khi người dùng chia sẻ camera. Ví dụ: chọn giày phù hợp với trang phục hoặc xác định dụng cụ đúng trong hộp đồ nghề.

-

Tính năng này sẽ có mặt đầu tiên trên Pixel 10 từ ngày 28/8/2025, và sẽ được mở rộng sang thiết bị Android khác và iOS trong vài tuần tới.

-

Gemini Live giờ có thể kết nối trực tiếp với Google Calendar, Tasks và Keep, giúp người dùng đặt lịch, tạo nhắc nhở và danh sách mua sắm trong cùng một luồng hội thoại.

-

Các ứng dụng Messages, Phone, Clock và tích hợp sâu hơn với Google Maps sẽ được bổ sung sớm, mở rộng khả năng xử lý các tình huống đời sống như gửi tin nhắn, gọi điện hay tìm đường.

-

Một ví dụ thực tế: đang tìm quà sinh nhật cho mẹ với Gemini, bạn có thể nói "Gọi bố để hỏi xem ông có thể mua món này không" và Gemini sẽ thực hiện ngay cuộc gọi.

-

Trợ lý này cũng hiểu tình huống và ngữ cảnh di chuyển – có thể giúp bạn tìm tàu điện, và khi phát hiện bạn trễ giờ, có thể gửi tin nhắn cho bạn bè mà bạn chỉ cần ra lệnh bằng giọng nói.

-

Google cải tiến mô hình âm thanh giúp Gemini trò chuyện biểu cảm hơn, với các yếu tố như ngữ điệu, nhịp điệu, tông giọng, tạo ra trải nghiệm tự nhiên hơn.

-

Người dùng có thể yêu cầu Gemini nói chậm để ghi chú, nói nhanh khi gấp, hoặc thậm chí dùng giọng vui nhộn hay pha giọng nhân vật như khi kể chuyện về Julius Caesar.

-

Các nâng cấp này là một phần trong tầm nhìn biến Gemini thành trợ lý AI toàn năng hàng ngày, giúp bạn xử lý công việc, giao tiếp và khám phá thế giới xung quanh dễ dàng hơn.

📌 Google đưa Gemini Live lên tầm cao mới với khả năng hướng dẫn trực quan qua camera, giọng nói biểu cảm và tích hợp sâu với Google Apps. Tính năng sẽ có mặt đầu tiên trên Pixel 10 từ ngày 28/8/2025 và mở rộng nhanh chóng. Với những cập nhật này, Gemini đang tiến gần hơn tới việc trở thành một trợ lý AI thực sự "người hóa", hỗ trợ tự nhiên và hiệu quả trong mọi khía cạnh đời sống.

https://blog.google/products/gemini/gemini-live-updates-august-2025/

-

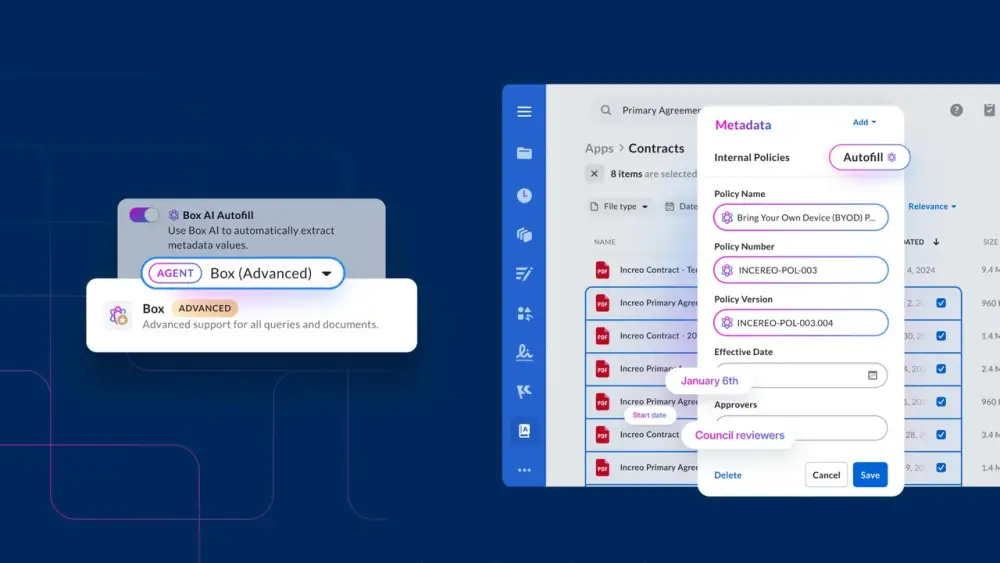

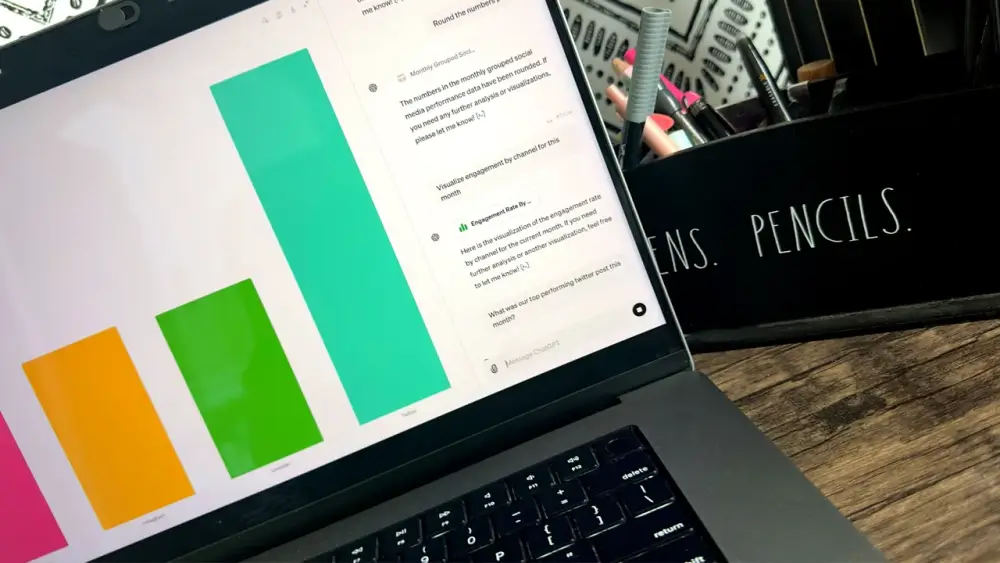

Ngày 18/8/2025, Microsoft công bố tích hợp AI Copilot trực tiếp vào Excel bằng một hàm mới mang tên =COPILOT().

-

Tính năng hiện dành cho người dùng beta của Microsoft 365 Copilot (30 USD/người/tháng) qua chương trình Insider.

-

Hàm =COPILOT hoạt động giống các hàm Excel truyền thống, với cú pháp: =COPILOT("prompt", ô hoặc phạm vi dữ liệu, "ngữ cảnh khác").

-

Ví dụ: trong một bảng dữ liệu đánh giá máy pha cà phê, công thức =COPILOT("Summarize this feedback into a paragraph",D4:D18) tại ô D21 tự động sinh bản tóm tắt nhận xét.

-

Người dùng có thể thay đổi prompt để rút gọn thành một câu, hoặc phân loại dữ liệu theo nhóm có sẵn (Taste, Ease of Use, Noise, Other).

-

Công thức phức tạp hơn có thể trả về nhiều cột dữ liệu cùng lúc, như Category, Sentiment, và Emoji. Điều này cho phép lập pivot table trực tiếp từ kết quả AI.

-

Ngoài phân tích dữ liệu nội bộ, Copilot còn truy xuất thông tin từ knowledge graph. Ví dụ: nhập =COPILOT("List airports codes from major airports in",E3) sẽ trả về mã sân bay theo tên quốc gia ở ô E3.

-

Công thức có thể lồng ghép với các hàm Excel khác, chẳng hạn =WRAPROWS(COPILOT("List airports codes from major airports in",E3),3,"") để sắp xếp dữ liệu thành ma trận 3x3.

-

Microsoft cho biết đây là bước tiến chiến lược nhằm “AI hóa” toàn bộ hệ sinh thái Office, đồng thời tận dụng sức mạnh hạ tầng trung tâm dữ liệu AI.

-

Catherine Pidgeon (Head of Product Excel Core) và Joe McDaid (Principal PM Manager) là những người trực tiếp giới thiệu qua blog và video demo.

-

Microsoft dự kiến mở rộng tính năng trong tương lai, sau khi thử nghiệm ở nhóm beta.

📌 Microsoft vừa đưa Copilot AI trực tiếp vào Excel với hàm =COPILOT(), biến ô tính thành nơi tóm tắt, phân loại và truy xuất dữ liệu tự động. Tính năng này mở ra cách phân tích bảng tính mới, khi chỉ cần công thức thay vì thao tác thủ công. Dù mới dành cho người dùng beta trả phí, Microsoft dự kiến mở rộng rộng rãi, biến Excel thành công cụ AI mạnh mẽ bậc nhất trong văn phòng số.

https://www.theregister.com/2025/08/18/microsoft_adds_copilot_ai_formulas/

-

Ngày 18/08/2025, Grammarly công bố ra mắt 9 AI agent hỗ trợ người dùng trong việc viết và đánh giá bài luận, được tích hợp trong nền tảng soạn thảo mới “AI-native writing surface”, miễn phí cho người dùng Grammarly Free và Pro.

-

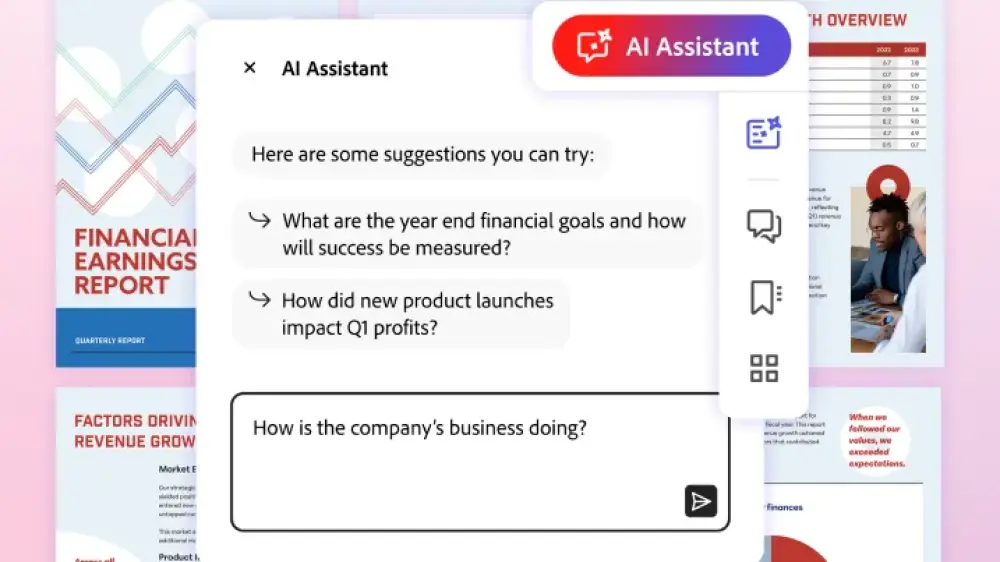

AI chấm điểm (AI grader agent) là tính năng nổi bật nhất, cho phép đánh giá chất lượng bài viết dựa trên tài liệu khóa học và thông tin công khai về giảng viên. AI này đưa ra điểm số dự kiến và gợi ý cách cải thiện trước khi nộp bài.

-

Một số AI agent nổi bật khác:

-

Reader Reactions Agent: dự đoán phản ứng, câu hỏi của người đọc sau khi đọc bài viết.

-

Proofreader Agent: đưa ra chỉnh sửa ngữ pháp và diễn đạt ngay trong văn bản.

-

Paraphrase Agent: giúp diễn đạt lại câu theo tông giọng, đối tượng hoặc phong cách cụ thể.

-

Citation Finder Agent: tự động tạo trích dẫn đúng chuẩn cho các luận điểm.

-

Expert Review Agent: cung cấp phản hồi chuyên sâu theo từng chủ đề.

-

-

Dành cho giáo viên, Grammarly cung cấp:

-

Plagiarism Checker Agent: kiểm tra đạo văn bằng cách so sánh với cơ sở dữ liệu học thuật và web.

-

AI Detector Agent: xác định mức độ khả năng văn bản do con người hoặc AI viết, đưa ra điểm số tin cậy.

-

-

Hai công cụ phát hiện đạo văn và AI-generated chỉ khả dụng cho người dùng Grammarly Pro tại thời điểm ra mắt. Các tính năng này sẽ được mở rộng cho nhóm người dùng Enterprise và Education cuối năm nay, cùng với một số AI agent khác đang phát triển.

📌 Grammarly vừa tung ra 9 AI agent miễn phí và Pro, nổi bật là công cụ chấm điểm bài luận dựa trên nội dung khóa học và hồ sơ giảng viên, giúp sinh viên cải thiện bài viết trước khi nộp. Công cụ phát hiện đạo văn và AI-generated được tích hợp cho giáo viên, đánh dấu bước tiến lớn trong giáo dục AI và phát triển kỹ năng tư duy phản biện

https://www.theverge.com/news/760508/grammarly-ai-agents-help-students-educators

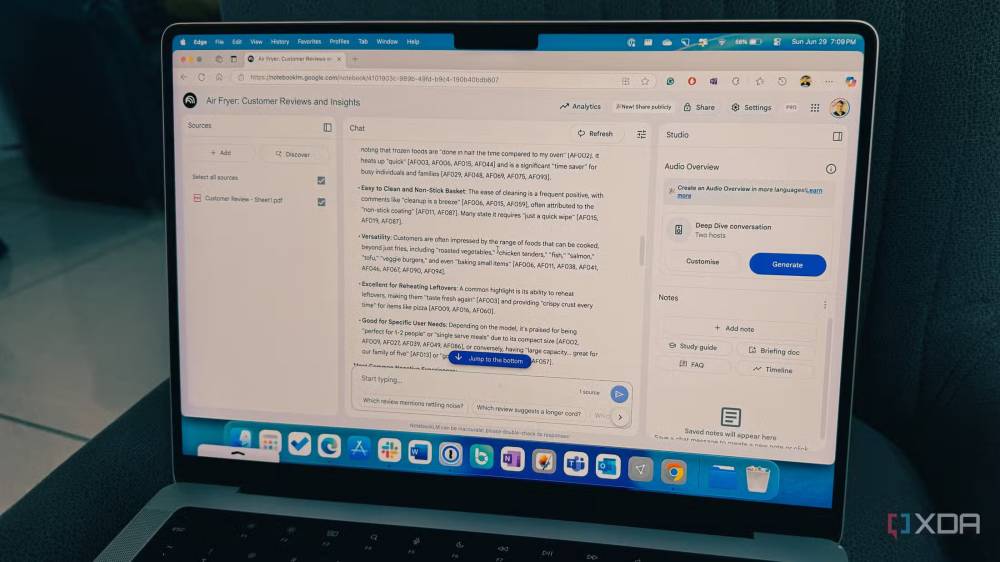

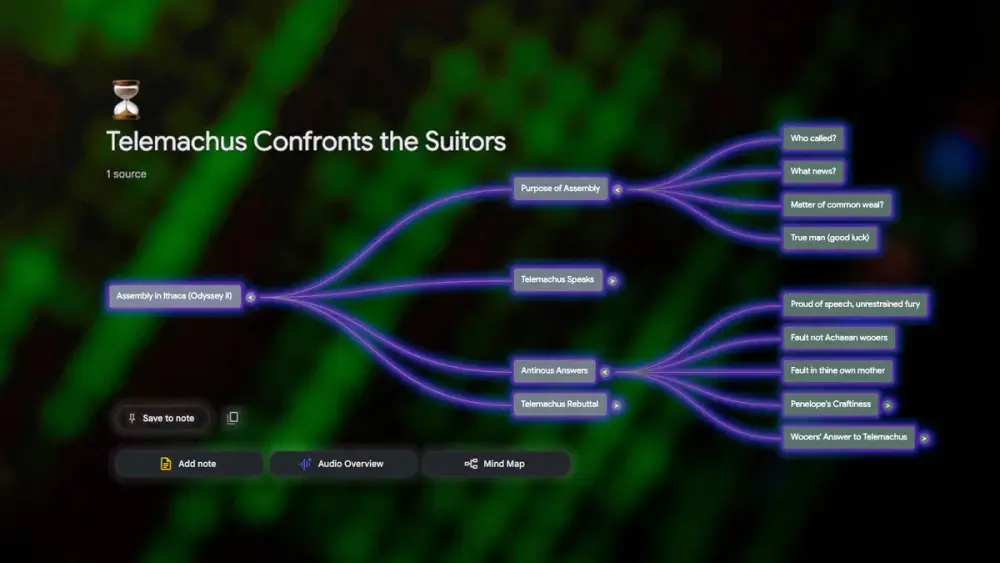

• Tác giả từng chỉ dùng NotebookLM (AI nghiên cứu cá nhân hóa của Google) vì đáp ứng đầy đủ nhu cầu học tập và báo chí, nhưng nhận ra sai lầm khi bỏ qua các công cụ AI khác.

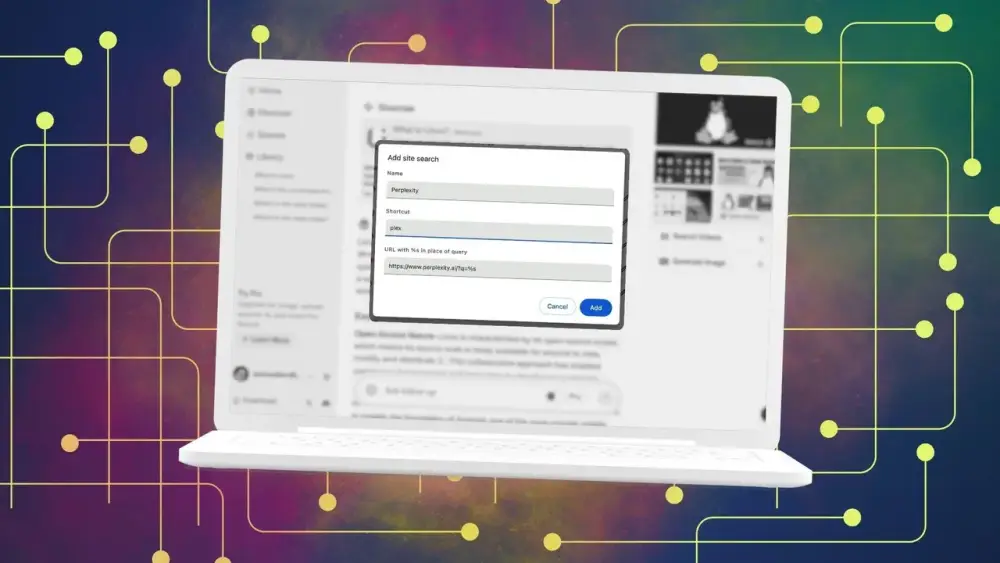

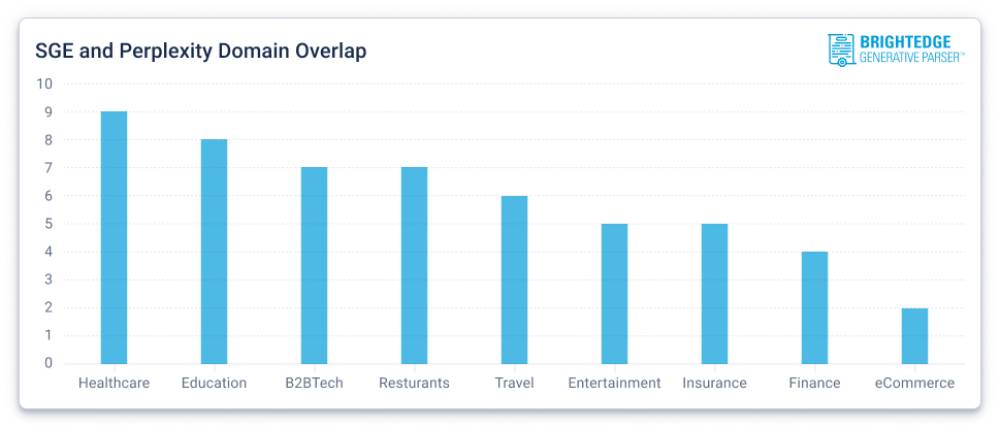

• Kết hợp NotebookLM với Perplexity giúp tìm nguồn đáng tin cực nhanh. Perplexity được dùng chủ yếu để tìm và liệt kê nguồn từ tab Sources thay vì câu trả lời, tiết kiệm hàng giờ tìm kiếm thủ công.

• Quy trình: tìm nguồn với Perplexity → nhập vào NotebookLM → dùng NotebookLM phân tích và tóm tắt, đặc biệt với tính năng Audio Overviews, biến thời gian di chuyển thành giờ học hiệu quả.

• Mind Maps của NotebookLM trực quan hóa mối liên hệ giữa các nguồn (cả nguồn cá nhân và nguồn mới từ Perplexity), giúp nhận diện khoảng trống kiến thức.

• ChatGPT đóng vai trò mở rộng phạm vi, trả lời các câu hỏi ngoài dữ liệu NotebookLM, cung cấp ví dụ thực tế, giải thích bổ sung và kết nối với chủ đề khác.

• Study Mode mới của ChatGPT biến nội dung NotebookLM thành bài giảng tương tác, quiz, và hướng dẫn từng bước, giúp nắm chắc kiến thức.

• Bộ ba này tạo quy trình liền mạch: Perplexity (tìm nguồn) → NotebookLM (hiểu nội dung) → ChatGPT (mở rộng & đào sâu).

• Tác giả từng thử kết hợp NotebookLM với nhiều công cụ khác (Slack, Google Docs, Excel) nhưng chưa bộ đôi nào mạnh bằng bộ ba này.

📌 Sự kết hợp NotebookLM, Perplexity và ChatGPT giúp tối ưu học tập và nghiên cứu: tìm nguồn nhanh, phân tích sâu, và mở rộng kiến thức không giới hạn. Với Audio Overviews, Mind Maps và Study Mode, bộ ba này không chỉ tiết kiệm hàng giờ làm việc mà còn nâng hiệu quả tiếp thu thông tin lên mức tối đa.

https://www.xda-developers.com/paired-notebooklm-with-chatgpt-and-perplexity/

-

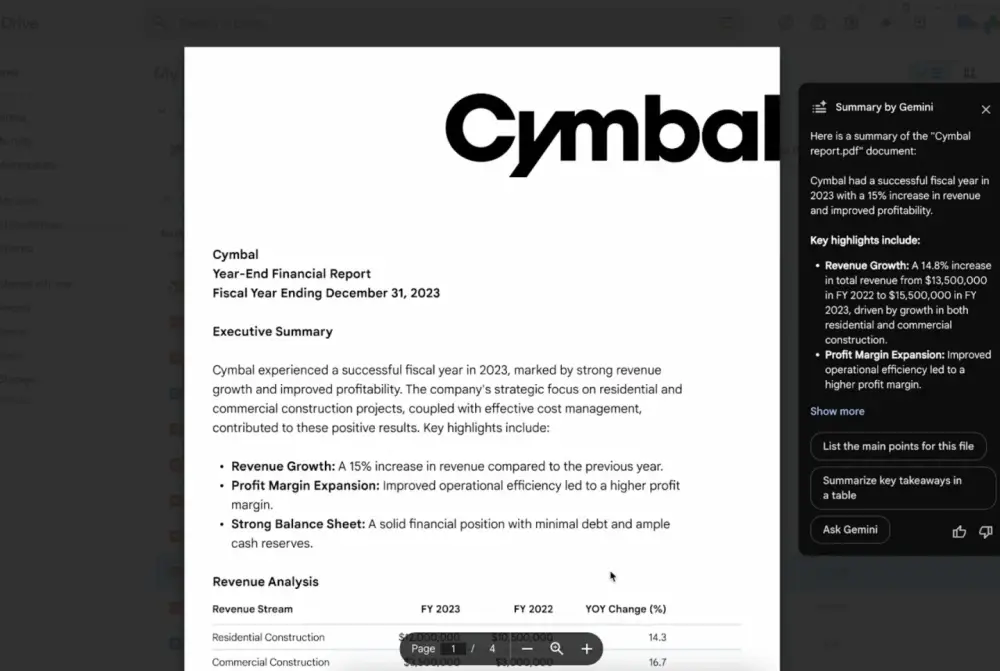

Google vừa nâng cấp Gemini trong Google Drive, tăng khả năng phân tích PDF với cửa sổ ngữ cảnh (context window) lên đến 1 triệu token.

-

Trước đây, khi xử lý tài liệu dài như nghiên cứu khoa học, hợp đồng pháp lý hay báo cáo lớn, Gemini có thể bị mất mạch thông tin vì phải đọc theo từng phần nhỏ.

-

Nâng cấp mới cho phép AI “ghi nhớ” toàn bộ tài liệu cùng lúc, giúp hiểu mạch nội dung từ đầu đến cuối, nhận diện chủ đề xuyên suốt và liên kết thông tin từ nhiều phần khác nhau.

-

Lợi ích thực tế:

-

Tóm tắt chính xác hơn đối với tài liệu dài và phức tạp.

-

Trả lời câu hỏi chi tiết đòi hỏi thông tin từ nhiều phần khác nhau trong file.

-

Phân tích và tổng hợp dữ liệu toàn bộ nghiên cứu hoặc báo cáo chỉ trong một cuộc hội thoại.

-

-

Nâng cấp này đặc biệt hữu ích cho người làm nghiên cứu, luật, tài chính hoặc bất kỳ ai cần xử lý nhanh thông tin từ tài liệu PDF dài.

-

Tính năng đã khả dụng cho người dùng có các gói sau:

-

Google Workspace: Business Standard/Plus, Enterprise Standard/Plus

-

Người dùng có add-on Gemini Education hoặc Gemini Education Premium

-

Google One AI Premium

-

-

Đây là ví dụ rõ ràng về việc Google ứng dụng công nghệ mô hình AI tiên tiến để cải thiện trải nghiệm và hiệu suất trong các ứng dụng năng suất lõi của mình.

📌 Google nâng cấp Gemini trên Google Drive với cửa sổ ngữ cảnh 1 triệu token, giúp đọc và phân tích toàn bộ PDF dài trong một lần, tăng độ chính xác tóm tắt và trả lời câu hỏi. Tính năng hỗ trợ các gói Workspace, Education và Google One AI Premium, đặc biệt hữu ích cho nghiên cứu, luật và phân tích dữ liệu.

https://chromeunboxed.com/gemini-in-google-drive-just-got-a-massive-pdf-analysis-upgrade/

-

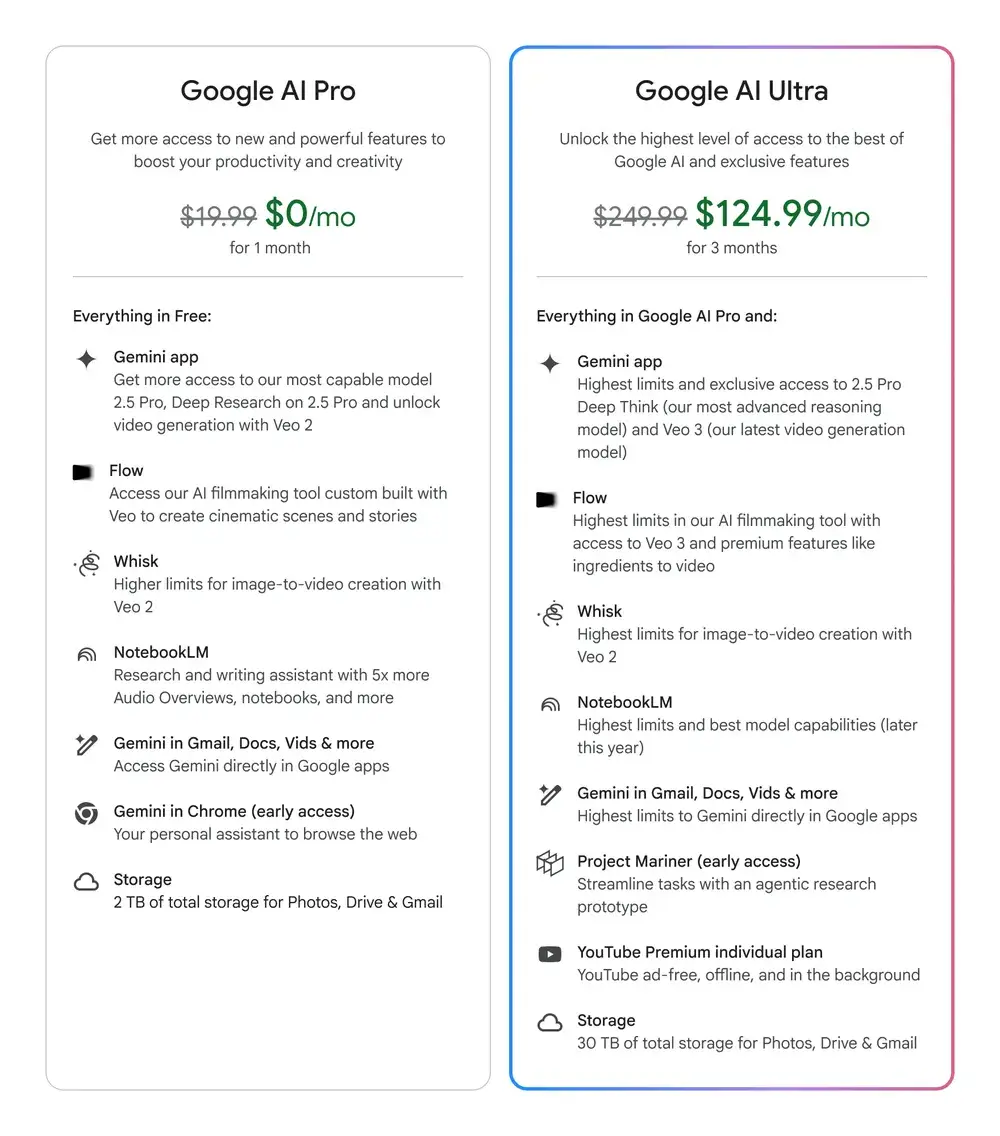

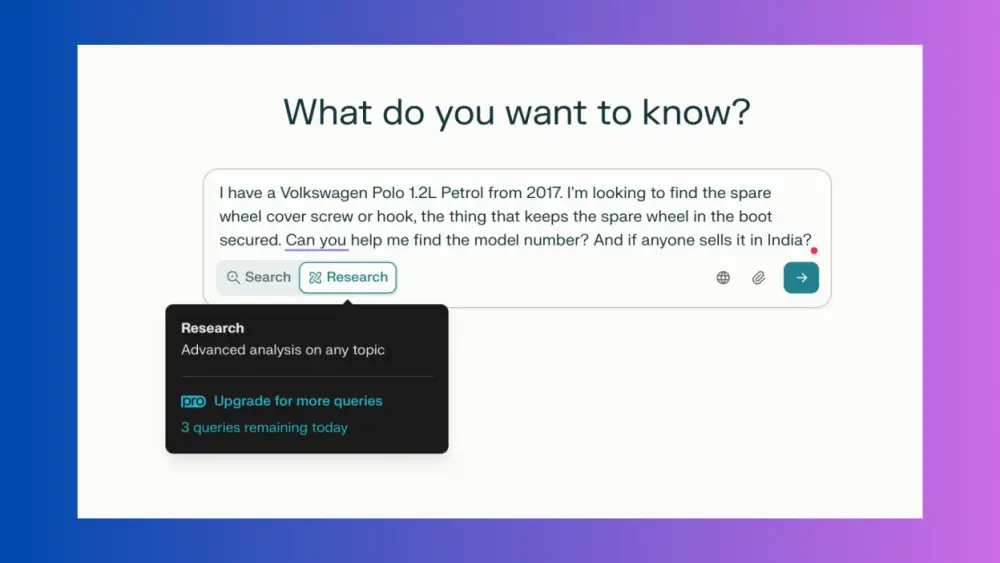

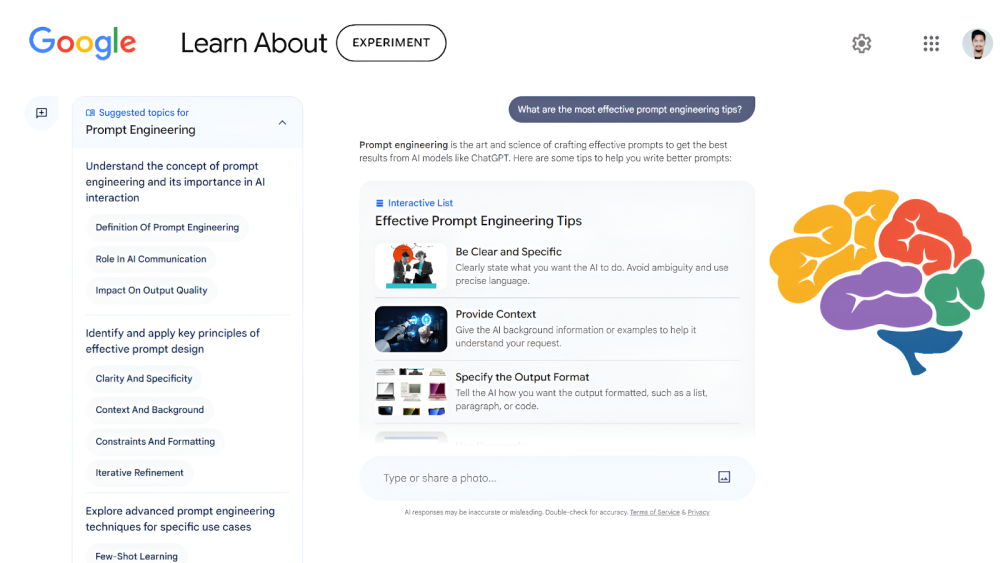

Google cung cấp gói AI Pro miễn phí 1 năm cho học sinh tại Mỹ, Nhật Bản, Indonesia, Hàn Quốc và Brazil nhằm nâng cao hiệu quả học tập thông qua trí tuệ nhân tạo.

-

Tính năng Guided Learning giúp học sinh hiểu sâu vấn đề thay vì chỉ nhận câu trả lời nhanh. Hệ thống chia nhỏ bài học theo từng bước, điều chỉnh giải thích theo nhu cầu cá nhân, sử dụng tệp môn học để tạo hướng dẫn học và hỗ trợ bằng video, hình ảnh trực quan.

-

Học bằng hình ảnh được tích hợp sẵn: khi hỏi về các chủ đề phức tạp như quang hợp hay tế bào, Gemini sẽ tự động thêm ảnh chất lượng cao, sơ đồ hoặc video YouTube vào câu trả lời để hỗ trợ hiểu sâu hơn.

-

Công cụ ôn thi thông minh cho phép tạo flashcard và giáo trình tự động từ kết quả bài kiểm tra hoặc tài liệu lớp học, giúp học sinh ôn tập hiệu quả hơn.

-

Người dùng được truy cập thêm vào Gemini 2.5 Pro, hỗ trợ trả lời nhanh câu hỏi và xử lý hình ảnh.

-

Deep Research tổng hợp báo cáo nghiên cứu chuyên sâu từ hàng trăm trang web, giúp tiết kiệm thời gian tìm tài liệu.

-

NotebookLM hỗ trợ học sinh ghi chú, tổ chức ý tưởng, với khả năng xử lý gấp 5 lần dữ liệu âm thanh và video.

-

Veo 3 cho phép biến văn bản hoặc ảnh thành video 8 giây có âm thanh.

-

Jules – trợ lý AI lập trình – có giới hạn sử dụng cao hơn, giúp sửa lỗi và phát triển tính năng mới cho dự án mã nguồn.

-

Gói Google AI Pro còn đi kèm 2 TB dung lượng lưu trữ, phục vụ lưu trữ bài học, dự án và ghi chú.

📌 Google triển khai hàng loạt công cụ học tập mới trong ứng dụng Gemini, nổi bật với chế độ học có hướng dẫn, tích hợp hình ảnh trực quan, tạo flashcard từ kết quả kiểm tra và truy cập miễn phí Google AI Pro tại 5 quốc gia Mỹ, Nhật Bản, Indonesia, Hàn Quốc và Brazil. Gói nâng cấp cung cấp AI Gemini 2.5 Pro, công cụ Deep Research, NotebookLM, Veo 3, Jules và 2 TB dung lượng lưu trữ, hỗ trợ học sinh học nhanh, hiểu sâu và ôn thi hiệu quả hơn.

https://blog.google/products/gemini/new-gemini-tools-students-august-2025/

-

GoTo và Indosat Ooredoo Hutchison vừa ra mắt Sahabat-AI, mô hình AI tạo sinh quy mô lớn đầu tiên do Indonesia phát triển, hỗ trợ 5 ngôn ngữ, bao gồm cả tiếng Java và Sunda – hai ngôn ngữ địa phương phổ biến.

-

Mô hình này có 70 tỷ tham số (parameters), phản ánh độ chính xác và khả năng hiểu ngôn ngữ phức tạp cao hơn so với các AI quy mô nhỏ.

-

Indonesia có 280 triệu dân và hơn 500 ngôn ngữ bản địa, tạo ra nhu cầu cấp thiết về AI hiểu được bối cảnh văn hóa và ngôn ngữ trong nước.

-

Sahabat-AI đã được phát hành mã nguồn mở từ tháng 11 năm ngoái, với sự tham gia phát triển của các trường đại học lớn như Đại học Indonesia và Gadjah Mada, cùng với các tập đoàn truyền thông lớn trong nước.

-

Người dùng có thể truy cập công cụ này qua ứng dụng GoPay, đặt câu hỏi bằng tiếng Indonesia như “Tổng thống Prabowo là người thế nào?” và nhận câu trả lời tự nhiên dựa trên nguồn thông tin từ báo chí địa phương.

-

Trái ngược với các công ty AI Mỹ như OpenAI (ChatGPT) và Microsoft (Copilot), Sahabat-AI lưu trữ và xử lý dữ liệu hoàn toàn trong lãnh thổ Indonesia, tuân thủ chủ quyền dữ liệu.

-

Trong khi đó, theo thỏa thuận thương mại với chính quyền Trump, Indonesia đồng ý cho phép chuyển dữ liệu cá nhân sang Mỹ – một động thái có thể ảnh hưởng đến quyền riêng tư nếu không được giám sát chặt.

-

Satya Nadella, CEO của Microsoft, từng công bố khoản đầu tư 1,7 tỷ USD vào AI tại Indonesia vào tháng 4/2024, thể hiện mức độ cạnh tranh mà Sahabat-AI phải đối mặt.

-

Dù vậy, việc phát triển AI bản địa như Sahabat-AI cho thấy Indonesia đang chọn cách tự chủ công nghệ, tập trung vào bản sắc văn hóa và ngôn ngữ.

📌 Sahabat-AI – AI nội địa đầu tiên của Indonesia với 70 tỷ tham số và hỗ trợ tiếng Java, Sunda – đánh dấu bước ngoặt chiến lược của quốc gia 280 triệu dân giữa áp lực cạnh tranh từ OpenAI và Microsoft. Với dữ liệu xử lý hoàn toàn trong nước, AI bản địa này không chỉ là công cụ, mà còn là tuyên ngôn chủ quyền công nghệ.

https://asia.nikkei.com/Business/Technology/Artificial-intelligence/Indonesia-s-GoTo-and-Indosat-launch-home-grown-AI-chat-tool

Indonesia's GoTo and Indosat launch home-grown AI chat tool

-

Ngày 31/7/2025, startup AI Manus (Singapore) công bố tính năng mới "Wide Research", cho phép người dùng sử dụng hơn 100 agent AI song song để thực hiện các tác vụ nghiên cứu, tổng hợp hoặc sáng tạo quy mô lớn.

-

Không giống các công cụ “Deep Research” chuyên đào sâu một vấn đề, Wide Research của Manus ưu tiên xử lý khối lượng lớn thông tin cùng lúc, giúp tăng tốc độ và mở rộng phạm vi nghiên cứu đáng kể.

-

Trong một bản demo, Manus cho thấy 100 agent đã được khởi tạo để so sánh giày thể thao theo kiểu dữ liệu lớn – bao gồm thiết kế, giá cả và tình trạng hàng hóa – cho ra kết quả dưới dạng bảng tính và trang web chỉ trong vài phút.

-

Ngoài phân tích, Wide Research còn có thể ứng dụng trong sáng tạo như thiết kế poster với 50 phong cách khác nhau, trả về file tải xuống đầy đủ.

-

Mỗi agent là một phiên bản Manus đầy đủ chức năng, không bị giới hạn bởi vai trò cố định như "quản lý", "lập trình viên" hay "thiết kế viên", cho phép thực hiện bất kỳ tác vụ tổng quát nào.

-

Tính năng này hiện khả dụng cho người dùng gói Pro (199 USD/tháng), và sẽ mở dần cho gói Plus và Basic. Mỗi phiên bản đi kèm mức tín dụng, số lượng tác vụ đồng thời và khả năng truy cập công cụ tạo nội dung.

-

Cấu trúc hạ tầng được Manus mô tả là điện toán đám mây cá nhân, nơi mỗi phiên làm việc là một máy ảo riêng biệt, điều phối qua ngôn ngữ tự nhiên.

-

Mặc dù Manus nhấn mạnh ưu điểm về tốc độ và phạm vi, bản phát hành không cung cấp dữ liệu benchmark hay so sánh hiệu quả cụ thể so với phương pháp nghiên cứu tuần tự bằng một agent duy nhất.

-

Trong cộng đồng AI, các hệ thống đa tác tử thường gặp thách thức về tính điều phối, chi phí tài nguyên, lỗi phối hợp và độ trễ, như đã thấy ở Claude hay các nền tảng khác.

-

Manus thừa nhận Wide Research vẫn đang ở giai đoạn thử nghiệm, nhưng coi đây là nền tảng cho các ứng dụng AI quy mô lớn trong tương lai.

-

Startup này đang đặt cược vào kiến trúc AI đa tác tử tổng quát thay vì mô-đun chuyên biệt, với mục tiêu tạo ra hệ sinh thái AI linh hoạt và mở rộng quy mô không giới hạn.

📌 Manus giới thiệu Wide Research – công cụ AI cho phép khởi tạo hơn 100 tác tử AI chạy song song để phân tích, tổng hợp và sáng tạo quy mô lớn. Dù chưa có đánh giá hiệu năng rõ ràng, đây là bước thử nghiệm táo bạo cho kiến trúc AI mới, định hình tương lai các tác vụ nghiên cứu và sáng tạo bằng AI.

https://venturebeat.com/ai/youve-heard-of-ai-deep-research-tools-now-manus-is-launching-wide-research-that-spins-up-100-agents-to-scour-the-web-for-you/

-

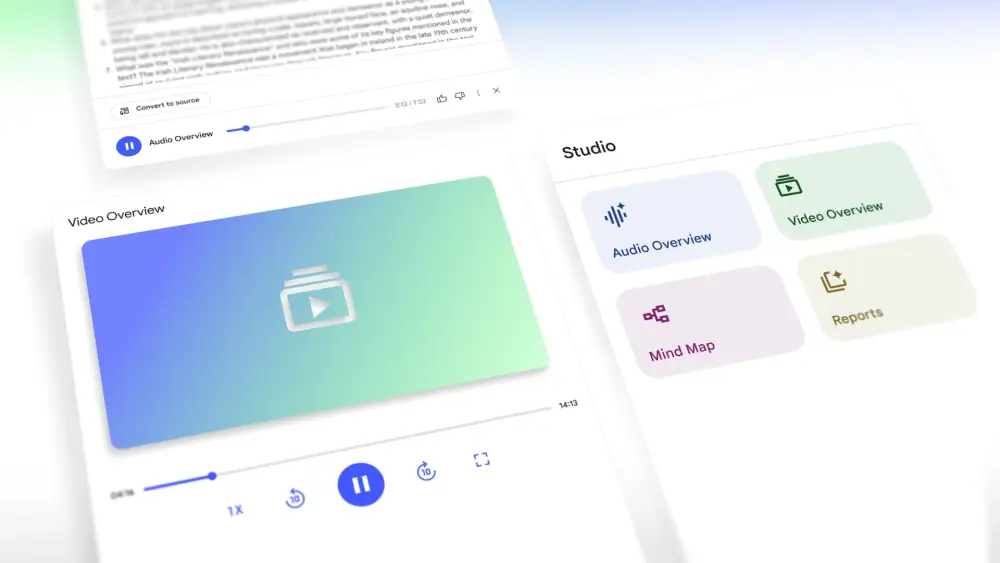

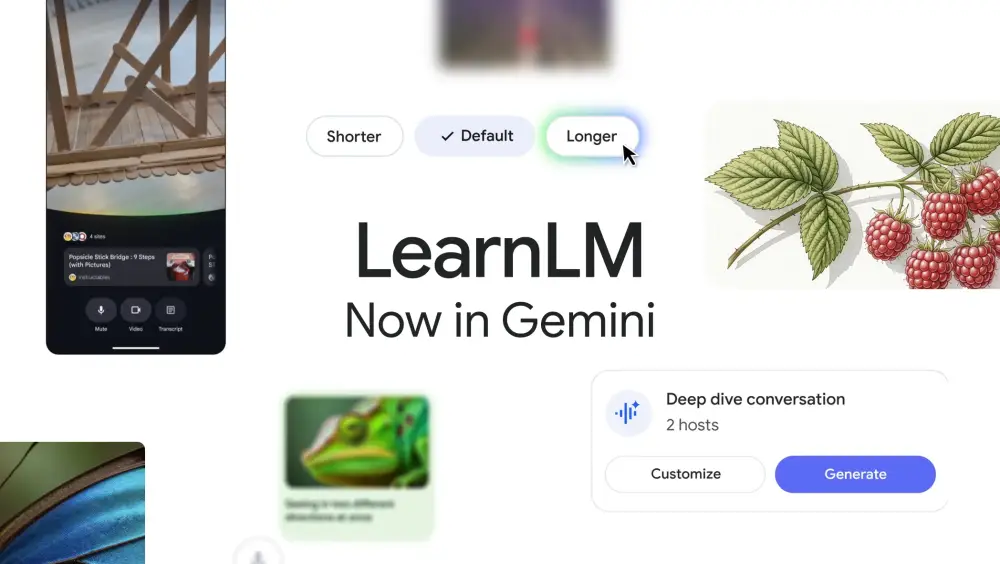

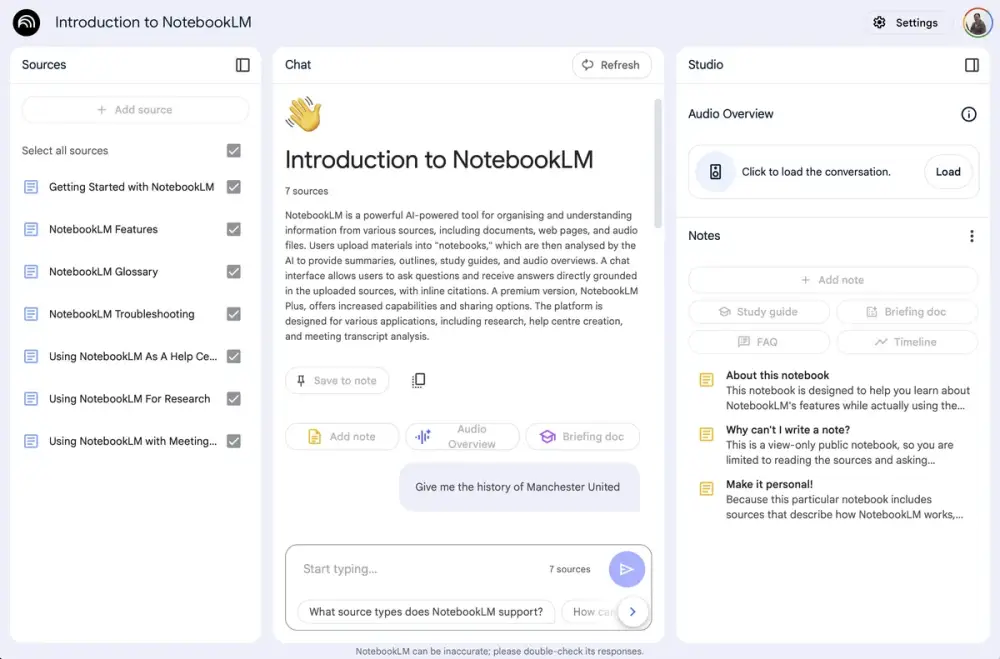

Google vừa cập nhật lớn cho NotebookLM, trợ lý nghiên cứu cá nhân tích hợp AI, với hai điểm nổi bật: Video Overviews và nâng cấp giao diện Studio.

-

Video Overview là tính năng mới giúp người dùng hiểu nội dung phức tạp qua video trình chiếu có dẫn truyện bằng AI, kèm hình ảnh, biểu đồ, trích dẫn và số liệu rút ra từ tài liệu gốc.

-

Đây là lựa chọn thay thế trực quan cho Audio Overview, rất phù hợp để giải thích quy trình, số liệu hoặc khái niệm trừu tượng.

-

Người dùng có thể tùy chỉnh nội dung video: chọn chủ đề, mục tiêu học, trình độ kiến thức, đối tượng người xem, ví dụ như "Tôi là người mới, giúp tôi hiểu sơ đồ này" hoặc "Tôi là chuyên gia, hãy chỉ tập trung vào phần Z."

-

Video Overview hiện đã có cho tất cả người dùng sử dụng tiếng Anh, các ngôn ngữ khác sẽ được hỗ trợ trong tương lai gần.

-

Studio panel được thiết kế lại hoàn toàn, cho phép người dùng tạo nhiều phiên bản của cùng một định dạng trong một notebook thay vì giới hạn một bản như trước.

-

Giờ đây bạn có thể tạo nhiều Audio Overview, Video Overview, Mind Map hoặc Report khác nhau – mỗi bản phục vụ mục tiêu, nhóm hoặc phần nội dung riêng.

-

Ví dụ:

-

Với notebook công khai, tạo Audio Overview bằng nhiều ngôn ngữ để tiếp cận khán giả toàn cầu.

-

Với nhóm làm việc, tạo Video Overview tùy chỉnh theo vai trò: kỹ thuật, quản lý, đào tạo…

-

Với sinh viên, tạo nhiều Mind Map hay Video Overview cho từng chương học để ôn tập có hệ thống.

-

-

Bốn công cụ chính (Audio, Video, Mind Map, Report) được đặt thành ô riêng ở đầu Studio, và người dùng có thể đa nhiệm, ví dụ nghe Audio Overview trong khi xem Mind Map.

-

Tính năng Studio mới sẽ triển khai đến tất cả người dùng trong vài tuần tới, hứa hẹn giúp học và chia sẻ kiến thức dễ dàng, linh hoạt và toàn diện hơn bao giờ hết.

📌 NotebookLM nâng tầm khả năng hỗ trợ học tập và nghiên cứu với Video Overview – video trình bày bằng AI giúp giải thích nội dung phức tạp cực kỳ trực quan. Bên cạnh đó, Studio mới cho phép tạo nhiều định dạng trong cùng một notebook, giúp người dùng học tập hiệu quả hơn, chia sẻ dễ dàng hơn và tùy biến theo nhu cầu riêng biệt.

https://blog.google/technology/google-labs/notebooklm-video-overviews-studio-upgrades/

-

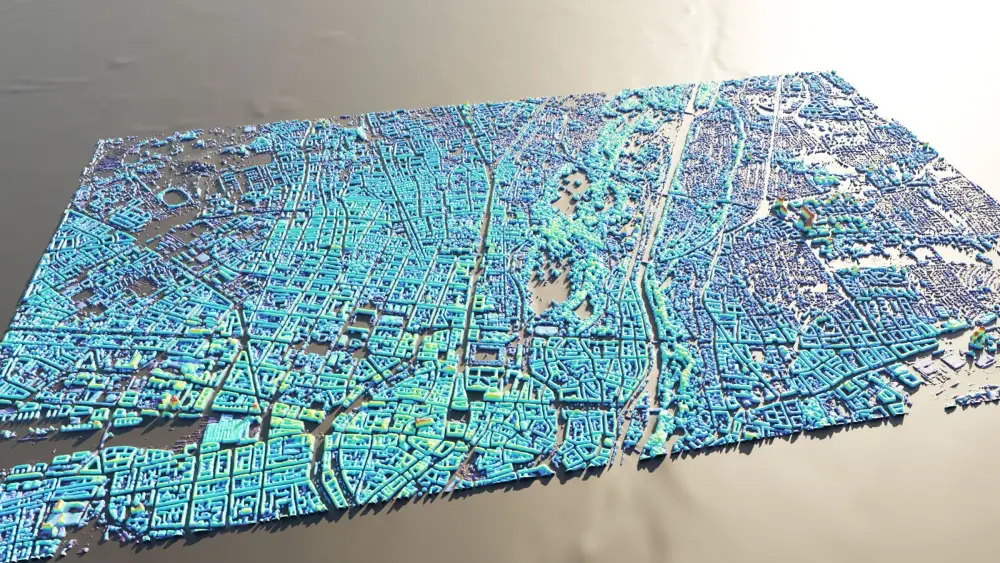

Google vừa công bố Google Earth AI, một tập hợp các mô hình và bộ dữ liệu AI địa lý nhằm giải quyết những thách thức lớn nhất toàn cầu như biến đổi khí hậu, thiên tai và đô thị hóa.

-

Bộ công cụ này là kết quả của nhiều năm nghiên cứu, mở rộng từ sáng kiến Geospatial Reasoning, bao gồm các mô hình AI dự đoán thời tiết chi tiết, cảnh báo lũ lụt và phát hiện cháy rừng.

-

Một phần quan trọng trong công bố này là AlphaEarth Foundations, đóng vai trò nền tảng dữ liệu hỗ trợ các mô hình AI địa lý.

-

Các mô hình không chỉ hữu ích trong môi trường nghiên cứu mà đã được triển khai thực tế qua các tính năng như cảnh báo lũ lụt và cháy rừng trên Google Search và Google Maps.

-

Ngoài ra, các mô hình hỗ trợ quy hoạch đô thị, hiểu hành vi di chuyển của dân cư, và cải thiện y tế cộng đồng thông qua phân tích hình ảnh và dữ liệu dân số động.

-

Google Earth AI hiện đã tích hợp vào Google Earth, Google Maps Platform và Google Cloud, cung cấp thông tin có thể hành động cho người dùng, doanh nghiệp và tổ chức chính phủ.

-

Google khẳng định cam kết cung cấp các công cụ AI mạnh mẽ để đối phó với khủng hoảng môi trường và xã hội, đồng thời đưa ra quyết định dựa trên dữ liệu địa lý chính xác.

📌 Google Earth AI mang đến một bước tiến lớn trong AI địa lý, với các mô hình dự đoán lũ lụt, cháy rừng và phân tích đô thị chính xác. Dữ liệu và mô hình đã được tích hợp vào Google Search, Maps và Cloud, giúp hàng triệu người ra quyết định thông minh hơn trước thiên tai và thách thức toàn cầu.

https://blog.google/technology/ai/google-earth-ai/

-

Google Gemini Pro được đánh giá 9/10 điểm bởi CNET nhờ cải thiện rõ rệt về độ chính xác, khả năng lập trình, tạo hình ảnh và tích hợp sâu với các dịch vụ Google.

-

Với mức giá 20 USD/tháng, Gemini Pro bao gồm 2 TB lưu trữ đám mây, công cụ tạo ảnh và video, rất phù hợp với người dùng chuyên sâu về nghiên cứu, sáng tạo nội dung và lập trình.

-

Phiên bản Pro dựa trên mô hình Gemini 2.5 Pro, có tốc độ phản hồi tốt, khả năng xử lý truy vấn phức tạp cao hơn so với Gemini Flash (miễn phí), nhờ dùng nhiều tài nguyên tính toán hơn.

-

Khả năng lập trình vượt mong đợi: Tác giả bài viết, không có nền tảng lập trình, đã có thể tạo tiện ích Chrome hoạt động hoàn chỉnh chỉ qua việc “vibe coding” – mô tả bằng lời và để AI viết code.

-

Sai sót vẫn tồn tại: Gemini Pro vẫn có thể phạm lỗi logic, đặc biệt khi gặp các yêu cầu lạ như sơ đồ mạch HDMI 24 cổng hay công thức pha trà sữa lành mạnh.

-

Trong lĩnh vực mua sắm, Gemini Pro kém hơn ChatGPT khi không đưa liên kết sản phẩm, không hiển thị hình ảnh và thường thiếu thông tin giá cả – buộc người dùng mở thêm Google Search.

-

Về tạo ảnh, Gemini Pro làm tốt hơn phiên bản miễn phí, thể hiện tốt phong cách nghệ thuật theo yêu cầu, tránh lỗi “logic thế giới” như ngồi sai hướng hay ánh sáng phi thực tế.

-

Nhược điểm nhỏ: khi quá tải, hệ thống tự động chuyển sang Gemini Flash, khiến một số phản hồi giảm chất lượng, người dùng cần để ý và chuyển lại bằng tay.

-

Google khẳng định Gemini Pro có khả năng xử lý 1 triệu token trong bối cảnh hội thoại, giúp trả lời sâu, giữ ngữ cảnh tốt hơn hẳn GPT-4 (thường giới hạn 128k token).

📌 Google Gemini Pro đã vượt qua những chỉ trích ban đầu và trở thành một đối thủ AI thực thụ của ChatGPT Plus. Với khả năng lập trình dễ tiếp cận, tạo hình ảnh sát ý tưởng, và độ chính xác cao hơn phiên bản cũ, Gemini Pro xứng đáng là lựa chọn đáng giá cho những ai cần một công cụ hỗ trợ nghiên cứu, sáng tạo hoặc lập trình. Tuy nhiên, điểm yếu trong mảng mua sắm và vài lỗi logic nhỏ vẫn cần cải thiện.

https://www.cnet.com/tech/services-and-software/gemini-pro-review-my-go-to-ai-chatbot-costs-20-per-month/

-

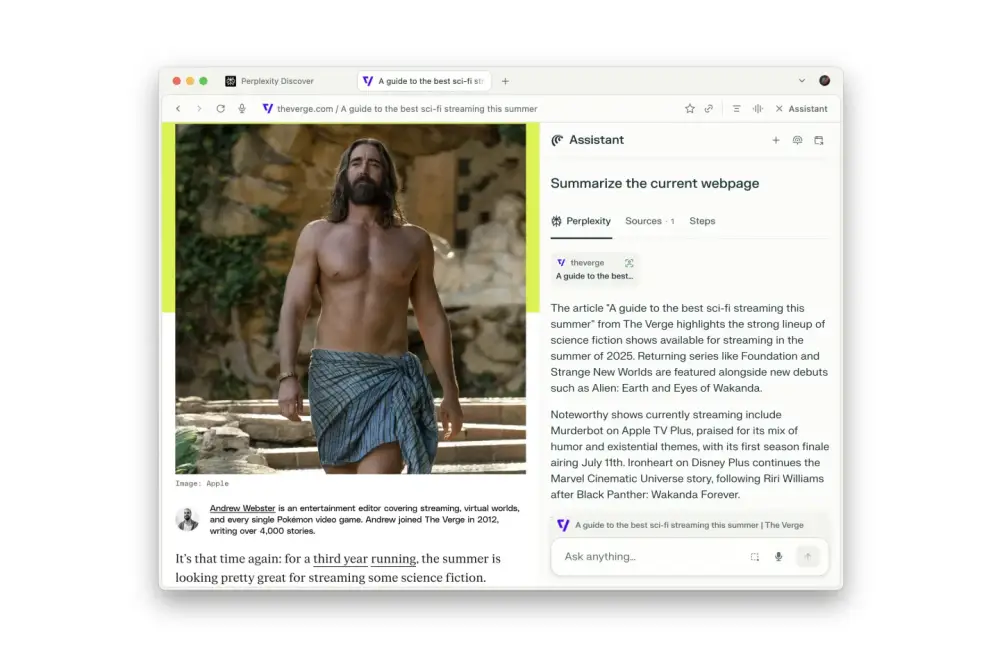

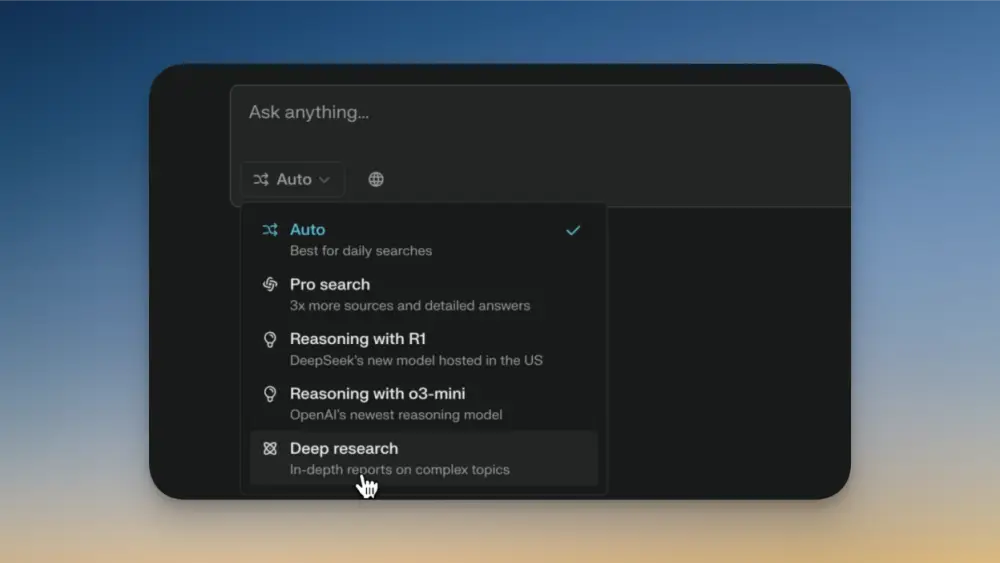

Perplexity vừa ra mắt Comet, trình duyệt tích hợp AI, hướng đến thay thế Chrome với khả năng thực hiện nhiều tác vụ tự động thay người dùng. Hiện tại, chỉ người dùng gói Perplexity Max hoặc có quyền truy cập sớm mới dùng được.

-

Khi nhập truy vấn vào thanh địa chỉ, Comet thay thế Google Search bằng “answer engine” của Perplexity, hiển thị kết quả ngắn gọn và đường link liên quan, giúp người dùng tìm nhanh mà không cần lọc hàng loạt kết quả như Google.

-

Nút Assistant mở ra một giao diện trò chuyện bên phải trang (sidecar), nơi AI có thể:

-

Tóm tắt bài viết

-

Mô tả hình ảnh

-

Tổng hợp video YouTube

-

So sánh sản phẩm từ các tab đang mở

-

-

Sau khi liên kết tài khoản Google, người viết thử nghiệm thấy Comet có thể:

-

Gửi email chứa dự báo bão cho chính mình

-

Tự đóng các tab không dùng hơn 15 phút

-

Viết và đăng bài lên X

-

Hủy đăng ký email quảng cáo từ Fubo và Fanatics

-

Chấp nhận lời mời LinkedIn từ người có ≥5 kết nối chung

-

-

Tính năng “take control of my browser” cho phép AI thực hiện các thao tác như:

-

Mở phần bình luận bị ẩn và tóm tắt phản ứng

-

Mua hàng Amazon: thêm cát thủy sinh và keo sửa iPad vào giỏ, chọn giao hàng 1 ngày, dùng phương thức thanh toán mặc định và đặt hàng

-

Đặt bàn nhà hàng (dù vẫn còn lỗi như dùng email placeholder thay vì thật)

-

-

Một số tác vụ như mua sắm hoặc đặt chỗ vẫn còn lỗi nhẹ do hạn chế mô hình AI hiện tại, nhưng Perplexity cho biết sẽ được cải thiện sớm.

-

So với Gemini trong Chrome, Comet vượt trội về khả năng hành động trực tiếp, thực hiện các bước mà Google mới chỉ thử nghiệm.

📌 Comet của Perplexity không chỉ thay thế tìm kiếm mà còn thực hiện các tác vụ web phức tạp như đặt hàng Amazon, hủy email quảng cáo, và tóm tắt nội dung tức thì. Dù đôi lúc chậm hơn người thật, đây chính là trình duyệt AI mà Google đang cố gắng xây dựng, mang lại trải nghiệm “AI hành động” chưa từng có.

https://www.theverge.com/news/709025/perplexity-comet-ai-browser-chrome-competitor

-

CEO Aravind Srinivas khẳng định trình duyệt là ứng dụng sát thủ của AI, là môi trường lý tưởng để xây dựng AI agent vì có thể truy cập dữ liệu cá nhân, đăng nhập và thực hiện hành động như con người, trong khi vẫn đảm bảo bảo mật và minh bạch.

-

Comet là trình duyệt AI xây dựng trên Chromium, giúp người dùng dễ dàng chuyển dữ liệu, tiện ích mở rộng từ Chrome sang, đồng thời tích hợp lớp “sidecar” AI để hỗ trợ ngay trên giao diện web mà không cần mở thêm tab.

-

Agent chỉ truy cập dữ liệu người dùng khi được yêu cầu và không lưu trữ toàn bộ thông tin. Perplexity đảm bảo người dùng có quyền xóa hoặc từ chối lưu prompt cho việc huấn luyện AI.

-

Comet đang ở giai đoạn beta, giới hạn cho người dùng cao cấp 200 USD/tháng, và được dùng trong nhiều tình huống như tạo quảng cáo, điều hành smart home, tổng hợp nội dung YouTube, xử lý email rác, và tuyển dụng qua LinkedIn.

-

Sử dụng Comet sidecar để xử lý tức thời nội dung trang như Slack, Gmail, YouTube đang là tính năng phổ biến nhất.

-

Tuy vẫn còn “mong manh” ở các nhiệm vụ dài (ví dụ: tuyển dụng phức tạp, kết nối nhiều nền tảng), CEO dự đoán chỉ trong 6–12 tháng tới, mô hình reasoning mới sẽ hoàn thiện khả năng này.

-

So với Model Context Protocol (MCP), Srinivas đánh giá trình duyệt có tính khả thi cao hơn vì bảo mật và đơn giản hơn trong hiện tại. Tuy nhiên, Perplexity sẵn sàng tích hợp MCP khi cần thiết.

-

Dự kiến IPO năm 2028–2029, Perplexity đặt mục tiêu đạt 1 tỷ USD doanh thu và có lãi, mở đường trở thành đối thủ đáng gờm của Google trong tìm kiếm và trình duyệt.

📌 CEO Perplexity tin rằng trình duyệt sẽ là hệ điều hành AI mới, giúp tự động hóa từ email, tìm kiếm, đến tuyển dụng. Với Comet, Perplexity không chỉ tái định nghĩa trình duyệt mà còn đặt mục tiêu IPO với 1 tỷ USD doanh thu, hướng tới thay thế Google cả về công nghệ và trải nghiệm.

https://www.theverge.com/decoder-podcast-with-nilay-patel/708256/perplexity-ceo-decoder-aravind-srinivas-comet-browser-ai-search

-

Google và Perplexity đang triển khai các chương trình tặng miễn phí gói AI cao cấp cho người dùng tại Ấn Độ nhằm cạnh tranh với ChatGPT và tăng mức độ phổ biến.

-

Gói Perplexity Pro trị giá ₹19.600/năm (khoảng 235 USD) và Google AI Pro trị giá ₹19.500/năm (khoảng 233 USD) đều đang được cung cấp miễn phí với điều kiện nhất định.

-

Perplexity Pro:

-

Hợp tác với Airtel để tặng miễn phí cho người dùng di động, internet băng thông rộng và DTH.

-

Người dùng chỉ cần đăng nhập vào ứng dụng Airtel Thanks bằng số tài khoản đã đăng ký, chọn banner ưu đãi Perplexity Pro.

-

Từ đó, người dùng sẽ được chuyển hướng đến trang kích hoạt, nơi có thể liên kết tài khoản hiện tại hoặc tạo tài khoản mới để sử dụng dịch vụ miễn phí trong 12 tháng.

-

Dịch vụ có thể truy cập qua website hoặc ứng dụng Android/iOS.

-

-

Google AI Pro:

-

Không hợp tác với đơn vị nào, chỉ dành riêng cho sinh viên Ấn Độ đủ điều kiện.

-

Điều kiện:

-

Đăng ký tại trường học được công nhận

-

Có email trường học chính thức, địa chỉ Gmail cá nhân và phương thức thanh toán hợp lệ

-

Là cư dân Ấn Độ trên 18 tuổi

-

-

Gói này bao gồm quyền truy cập vào Gemini 2.5 Pro AI, Gemini Live, DeepMind, Veo 3 và NotebookLM.

-

Hạn chót nộp đơn: 15/09/2025. Sau đó, Google sẽ ngừng tiếp nhận đăng ký.

-

📌 Người dùng Ấn Độ hiện có thể tiết kiệm gần 40.000 INR (~468 USD) nhờ ưu đãi miễn phí từ Google và Perplexity. Gói Perplexity Pro đi kèm qua Airtel, còn Google AI Pro hỗ trợ sinh viên đủ điều kiện đến hết ngày 15/09/2025. Đây là cơ hội hiếm để trải nghiệm AI tạo sinh cao cấp hoàn toàn miễn phí.

https://www.republicworld.com/tech/how-to-get-free-perplexity-pro-google-ai-pro-subscriptions-in-india

-

Chatbot như ChatGPT từng là biểu tượng của AI hiện đại, nhưng giờ đây trình duyệt web mới là nơi AI đang phát triển mạnh mẽ nhất.

-

Lý do: chatbot hiện không có quyền truy cập dữ liệu cá nhân trực tiếp như email, tài khoản ngân hàng… như trình duyệt có thể cung cấp.

-

Hai sản phẩm mới thể hiện xu hướng này: ChatGPT Agent và Comet browser của Perplexity.

-

ChatGPT Agent: sử dụng một trình duyệt cơ bản để lướt web thay người dùng, nhưng chỉ ở chế độ read-only, không thể truy cập các trang đã đăng nhập, tốc độ xử lý chậm, mất tới 50 phút để tìm một chiếc đèn trên Etsy và không thêm được sản phẩm vào giỏ hàng dù nói đã làm.

-

Comet: trình duyệt máy tính để bàn cho phép mô hình ngôn ngữ lớn (LLM) truy cập các trang đã đăng nhập và thực hiện nhiệm vụ, nhưng vẫn có lỗi như báo cáo hoàn thành nhiệm vụ nhưng thực tế chưa làm, hoặc tuyên bố có thể làm nhưng sau đó phủ nhận.

-

Giao diện phụ “sidecar” của Comet được đánh giá cao trong việc tóm tắt hoặc nghiên cứu nội dung trang web, tuy nhiên, trải nghiệm tổng thể vẫn còn mong manh và dễ lỗi.

-

Dù cả hai sản phẩm còn hạn chế và chỉ có trong các gói đăng ký đắt đỏ do chi phí tính toán cao, xu hướng hợp nhất AI và trình duyệt đang rõ ràng.

-

Perplexity và OpenAI đều đang phát triển các mô hình suy luận tùy chỉnh, giúp thực hiện các nhiệm vụ phức tạp nhiều bước.

-

CEO Aravind Srinivas tin vào tiến bộ của mô hình suy luận, trong khi OpenAI đang dùng một mô hình chưa công khai cho ChatGPT Agent.

📌 Trình duyệt đang trở thành môi trường AI lý tưởng mới khi chatbot thuần túy không thể truy cập dữ liệu cá nhân hiệu quả. Dù Comet và ChatGPT Agent còn hạn chế như tốc độ chậm, báo sai kết quả, chúng phản ánh xu hướng rõ rệt: AI sẽ không chỉ trò chuyện mà còn tự hành động trong thế giới web.

https://www.theverge.com/command-line-newsletter/710313/ai-moves-chatbots-to-web-browser-chatgpt-agent-perplexity-comet

-

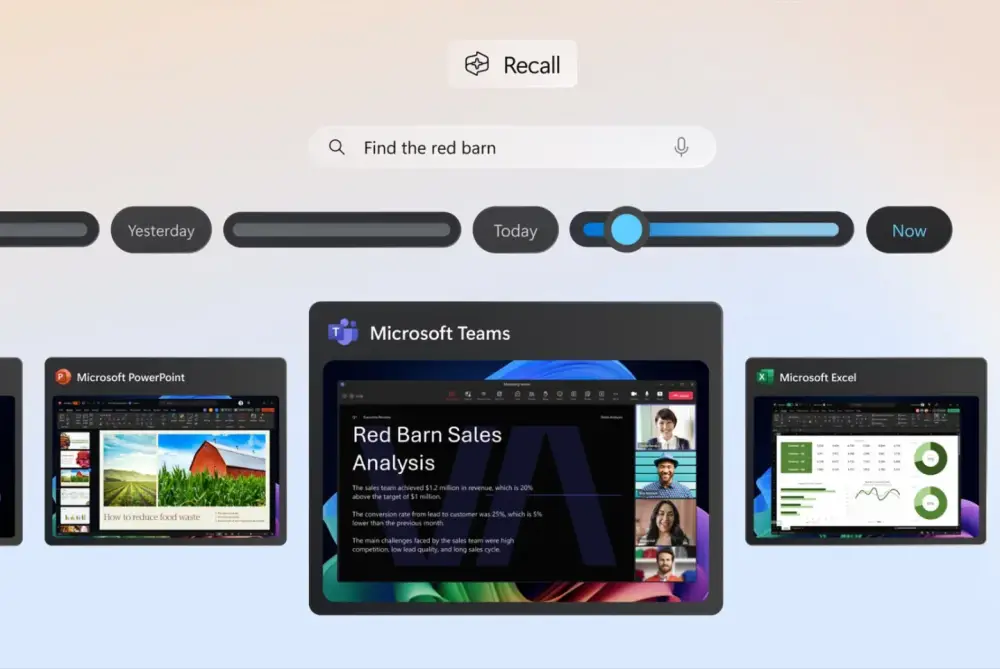

Microsoft vừa tung bản cập nhật mới cho Copilot Vision, cho phép AI quét và nhìn toàn bộ màn hình máy tính thay vì chỉ hai ứng dụng cùng lúc như trước đây.

-

Người dùng có thể chủ động kích hoạt tính năng này bằng cách nhấn biểu tượng kính (glasses icon) trong ứng dụng Copilot và chọn màn hình desktop hoặc cửa sổ ứng dụng/browser cụ thể mà họ muốn AI quan sát.

-

Khác với tính năng Recall tự động chụp màn hình theo chu kỳ, Copilot Vision hoạt động tương tự chia sẻ màn hình trong cuộc gọi video – người dùng kiểm soát khi nào AI được quyền “nhìn thấy”.

-

Copilot Vision có thể phân tích nội dung hiển thị, đưa ra nhận xét, trả lời câu hỏi, thậm chí hướng dẫn thao tác trực tiếp bằng lời nói. Ví dụ, giúp chỉnh sửa bản CV, đưa ra mẹo thiết kế sáng tạo hoặc hướng dẫn chơi game.

-

Tính năng này là bước mở rộng từ phiên bản thử nghiệm ban đầu năm ngoái, nơi Copilot chỉ có thể nhìn và hiểu nội dung đang hiển thị trong trình duyệt Microsoft Edge.

-

Ngoài khả năng trên desktop, Copilot Vision cũng có thể “nhìn thấy” thông qua camera điện thoại để đưa ra phản hồi tức thì về hình ảnh hoặc vật thể mà người dùng đang hướng đến.

-

Microsoft hướng đến việc biến Copilot Vision trở thành “trợ lý quan sát thông minh” có thể đồng hành trong mọi tình huống: công việc, học tập, chơi game hay sáng tạo nội dung.

📌 Microsoft nâng cấp Copilot Vision giúp AI quét toàn màn hình máy tính để hỗ trợ người dùng phân tích nội dung, trả lời câu hỏi và hướng dẫn thao tác trực tiếp. Đây là bước tiến từ khả năng đọc trình duyệt sang toàn bộ desktop, biến Copilot thành công cụ đồng hành thông minh cho công việc và sáng tạo.

https://www.theverge.com/news/707995/microsoft-copilot-vision-ai-windows-scan-screen-desktop

-

Tác giả sử dụng NotebookLM để giúp cháu gái 12 tuổi hiểu bài hóa học về cấu trúc hạt, nhưng nhanh chóng phát hiện rằng NotebookLM chỉ dựa vào tài liệu đã tải lên và không thể trả lời nếu thông tin không có sẵn trong đó.

-

Khi đặt câu hỏi về proton, neutron và electron, NotebookLM trả lời không có dữ liệu, trong khi Gemini ngay lập tức cung cấp lời giải thích dễ hiểu và phù hợp với trẻ nhỏ.

-

Để khai thác tối đa, tác giả mở NotebookLM bên trái và Gemini bên phải (Windows + mũi tên trái/phải) – cho phép chuyển đổi liền mạch giữa hai công cụ.

-

NotebookLM có giới hạn trong việc tìm và tương tác với nguồn bên ngoài – tính năng Discover chỉ đề xuất khoảng 10 nguồn và không hỗ trợ tạo liên kết giữa nguồn tải lên và kiến thức chung.

-

Gemini vượt trội khi tìm kiếm nguồn tin, có thể:

-

Liệt kê hàng chục đường dẫn hữu ích.

-

Giải thích lý do từng liên kết phù hợp với đối tượng cụ thể (trẻ em, người mới học...).

-

Giúp lọc ra 10/20 liên kết dễ hiểu nhất cho bé gái 10 tuổi.

-

-

Sau khi thu thập liên kết, tác giả nhập chúng vào NotebookLM – nơi có thể xử lý và tương tác với tối đa 50 nguồn tài liệu cùng lúc.

-

Để tạo nội dung chất lượng cao từ các nguồn đã lọc, Gemini được dùng để tạo prompt tạo sách thiếu nhi về cấu trúc hạt, và còn hỗ trợ rút gọn prompt dưới 2.000 ký tự để phù hợp với NotebookLM.

-

Nhờ đó, người dùng có thể tận dụng ưu điểm mạnh của từng công cụ:

-

Gemini: tìm kiếm thông tin ngoài phạm vi tài liệu, lọc, tổng hợp và hỗ trợ sáng tạo nội dung.

-

NotebookLM: phân tích sâu và xử lý đồng thời nhiều tài liệu tải lên, tạo trải nghiệm nghiên cứu hợp nhất.

-

-

Cuối cùng, tác giả cảnh báo người dùng không nên phụ thuộc hoàn toàn vào AI, vì nghiên cứu cho thấy điều đó có thể làm suy giảm tư duy phản xạ và khả năng phân tích của não bộ. AI chỉ nên là công cụ hỗ trợ – không thay thế tư duy con người.

📌 Kết hợp NotebookLM với Gemini giúp bạn dễ dàng tạo nội dung, giảng giải kiến thức khó, và tìm nguồn chất lượng – như tạo sách thiếu nhi chỉ với vài prompt. Tuy nhiên, AI chỉ nên là công cụ đồng hành, không thay thế tư duy con người. Khi dùng đúng cách, bạn có thể khai thác sức mạnh của cả hai để học tập và sáng tạo hiệu quả hơn.

https://www.xda-developers.com/supercharge-notebooklm-with-gemini/

-

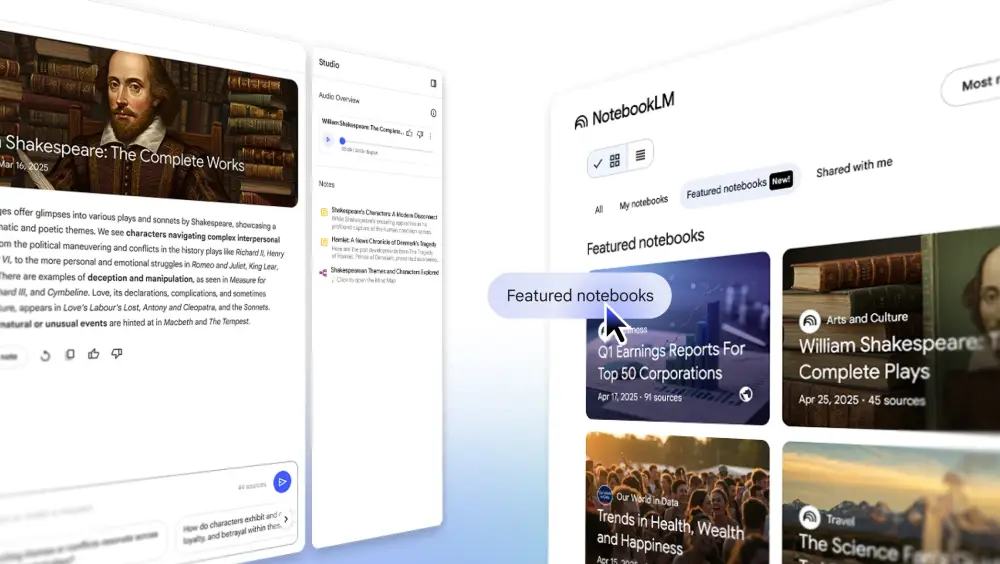

Google Labs vừa công bố tính năng “featured notebooks” trong nền tảng NotebookLM, mang đến các sổ tay chuyên đề từ các chuyên gia, học giả và tổ chức uy tín trên toàn cầu.

-

Người dùng có thể khám phá các chủ đề như khoa học, sức khỏe, tài chính, văn học, giáo dục và du lịch thông qua các sổ tay do các đối tác chọn lọc nội dung kỹ lưỡng.

-

Một số sổ tay nổi bật gồm:

-

Lời khuyên sống thọ từ Eric Topol, tác giả cuốn "Super Agers"

-

Dự báo năm 2025 từ báo cáo "The World Ahead" của The Economist

-

Tư vấn cuộc sống từ chuyên mục "How to Build A Life" của Arthur C. Brooks trên The Atlantic

-

Hướng dẫn du lịch Yellowstone từ góc nhìn khoa học và sinh học

-

Dữ liệu phúc lợi con người dài hạn từ dự án Our World In Data (Oxford)

-

Lời khuyên nuôi dạy con từ Jacqueline Nesi – giáo sư tâm lý học

-

Tác phẩm hoàn chỉnh của Shakespeare cho sinh viên và học giả

-

Theo dõi báo cáo tài chính quý I của 50 công ty lớn toàn cầu

-

-

Tính năng chính của NotebookLM bao gồm:

-

Đọc nguồn gốc nội dung

-

Đặt câu hỏi sâu và được trả lời dựa trên tài liệu gốc có trích dẫn

-

Audio Overviews – bản nghe tóm tắt tự động

-

Mind Maps – bản đồ tư duy theo chủ đề chính

-

-

Google cũng triển khai tính năng chia sẻ sổ tay công khai, cho phép cộng đồng đăng hơn 140.000 sổ tay chỉ trong 4 tuần.

-

The Economist cho biết đây là hợp tác đầu tiên với nền tảng AI và kỳ vọng sổ tay sẽ giúp người đọc hiểu rõ xu hướng toàn cầu năm 2025.

-

Đại diện The Atlantic bày tỏ sự hào hứng về việc “sách trong tương lai sẽ tương tác và tiến hóa cùng người đọc”.

📌 NotebookLM giới thiệu tính năng featured notebooks với nội dung từ The Economist, The Atlantic và chuyên gia toàn cầu. Người dùng có thể khám phá qua bản đồ tư duy, nghe tóm tắt âm thanh và đặt câu hỏi dựa trên nguồn gốc dữ liệu. Hơn 140.000 sổ tay công khai đã được chia sẻ trong tháng qua, đánh dấu bước tiến lớn trong học tập bằng AI tạo sinh.

https://blog.google/technology/google-labs/notebooklm-featured-notebooks/

-

Ba người cha tại Anh đã sáng lập Luna – một ứng dụng sử dụng AI để tạo ra sách truyện minh họa dựa trên câu trả lời đơn giản của trẻ em, giúp tăng hứng thú đọc sách.

-

Luna được phát triển trong 2 năm, cho phép trẻ nhập thông tin về thú cưng, đồ chơi, món ăn yêu thích hoặc kỳ nghỉ… và ứng dụng sẽ tạo ra một câu chuyện minh họa trực tuyến cá nhân hóa.

-

Lara Lewington, người dẫn chương trình công nghệ Tech Now (BBC), nhận xét Luna là một "ý tưởng thú vị cho tương lai kể chuyện".

-

Trước bối cảnh tỷ lệ biết chữ ở trẻ em Anh giảm mạnh, Luna được coi là một công cụ hỗ trợ khi chỉ 1/3 trẻ em từ 8-18 tuổi yêu thích đọc sách (theo khảo sát của National Literacy Trust - NLT).

-

Bridget Phillipson, Bộ trưởng Giáo dục, đã công bố năm 2026 là Năm Quốc gia Đọc Sách, kêu gọi cha mẹ đọc cho con hằng ngày.

-

Một trong những người sáng lập, Greg Findon, cho biết con anh đã tạo hơn 100 cuốn sách, suýt gây quá tải iPad.

-

Luna được thiết kế nhằm "bổ sung" chứ không thay thế sách truyền thống. Đồng sáng lập Omar Bakhshi khẳng định cả hai hình thức có thể hỗ trợ lẫn nhau.

-

Tuy nhiên, các tác giả như Joanne Harris cảnh báo AI là “mối đe dọa hiện sinh” với ngành xuất bản, đặc biệt với dịch giả và biên tập viên.

-

Luna hiện chưa in sách giấy, nhưng đang cân nhắc, hiện mới chỉ có hiệu ứng âm thanh lật trang để tạo cảm giác như thật.

-

Ứng dụng cũng nhằm giải quyết sự suy giảm tương tác đọc giữa cha và con, vốn chỉ còn chưa đến 50% vào năm 2024.

📌 Ứng dụng Luna dùng AI tạo sách truyện cá nhân hóa giúp trẻ em đọc sách nhiều hơn, đáp ứng nhu cầu kể chuyện sáng tạo giữa lúc chỉ 1/3 trẻ từ 8-18 tuổi thích đọc. Tuy bị giới xuất bản chỉ trích, Luna vẫn khẳng định vai trò bổ trợ, không thay thế sách truyền thống.

https://www.telegraph.co.uk/news/2025/07/12/parents-turn-ai-stories-get-children-read/

-

Dia – trình duyệt AI mới từ Browser Company – mang đến trải nghiệm lướt web hoàn toàn mới bằng cách tích hợp chatbot AI ngay trong cửa sổ trình duyệt, cho phép người dùng hỏi và nhận phản hồi mà không cần rời khỏi trang đang đọc.

-

Ví dụ: khi xem video dài 20 phút, người dùng có thể yêu cầu tóm tắt nội dung chính trong vài giây. Khi đọc tin tức, chatbot liệt kê các bài liên quan giúp hiểu sâu hơn.

-

Người dùng có thể nhờ AI kiểm tra chính tả, giải thích cụm từ, hoặc tư vấn khi viết bài – tất cả diễn ra trực tiếp trên Google Docs, YouTube hoặc trang báo.

-

Dia sử dụng nhiều mô hình AI mạnh như ChatGPT (OpenAI), Claude (Anthropic), Gemini (Google) và tự động chọn mô hình phù hợp theo nội dung câu hỏi.

-

Trái với ChatGPT hay Gemini vốn yêu cầu sao chép nội dung sang tab khác, Dia giữ người dùng trong cùng một giao diện, giúp duy trì luồng công việc.

-

Dia hiện miễn phí cho máy Mac theo hình thức mời dùng, nhưng sẽ sớm triển khai gói đăng ký từ 5 USD/tháng đến vài trăm USD/tháng tùy mức độ sử dụng AI.

-

Dù mạnh mẽ, Dia vẫn mắc lỗi như các AI khác. Ví dụ: chatbot bỏ sót ưu đãi trên trang Wirecutter dù nó hiển thị ngay trên trang.

-

Dia chia sẻ dữ liệu duyệt web với nhà cung cấp AI theo yêu cầu người dùng, có ràng buộc hợp đồng xóa dữ liệu. Tuy nhiên, chuyên gia khuyến nghị tránh dùng AI với nội dung nhạy cảm như bệnh lý hay tài liệu mật.

-

Dia cho thấy trình duyệt có thể trở thành cổng giao tiếp AI chính trong tương lai, thay vì chỉ là công cụ tải trang web như truyền thống.

-

Với xu hướng ngày càng tích hợp AI vào trình duyệt (như Safari, Chrome), Dia đại diện cho bước nhảy vọt, nơi AI không chỉ hỗ trợ mà còn hiểu và đồng hành cùng người dùng theo ngữ cảnh.

📌 Dia đưa trải nghiệm trình duyệt lên tầm cao mới: tóm tắt video tức thì, trả lời câu hỏi tại chỗ, hỗ trợ viết văn bản – tất cả trong một giao diện. Miễn phí ban đầu nhưng sẽ có gói từ 5 USD/tháng, Dia đại diện cho tương lai duyệt web tích hợp AI, nơi người dùng không còn đơn thuần đọc mà còn tương tác và sáng tạo với sự hỗ trợ của AI.

https://www.nytimes.com/2025/07/11/technology/personaltech/ai-internet-browser-dia.html

Is A.I. the Future of Web Browsing?

-

While writing this column on the Google Docs website, I asked the chatbot if I used “on the cusp” correctly, and it confirmed that I did.

-

While reading a news article about the Texas floods, I asked the browser’s chatbot to tell me more about how the crisis unfolded. The bot generated a summary about the history of Texas’ public safety infrastructure and included a list of relevant articles.

-

While watching a 22-minute YouTube video about car jump starters, I asked the chatbot to tell me which tools were best. Dia immediately pulled from the video’s transcript to produce a summary of the top contenders, sparing me the need to watch the entire thing.

How does it work?

But aren’t there imperfections?

What about privacy?

How much will this cost?

-

NotebookLM là công cụ AI tạo sinh hỗ trợ ghi chú và nghiên cứu giúp các startup và doanh nghiệp nhỏ tiết kiệm thời gian, tăng tốc ra quyết định và phát triển chiến lược.

-

Tổng hợp và phân tích thông tin nhanh chóng: Công cụ giúp thu thập và xử lý dữ liệu từ các nguồn khác nhau như website, báo cáo, đánh giá người dùng… Ví dụ, một startup phát triển phần mềm quản lý có thể so sánh điểm mạnh/yếu và tính năng của đối thủ chỉ bằng cách đặt câu hỏi trong NotebookLM.

-

Cải thiện quản lý tri thức nội bộ: Các doanh nghiệp có thể tạo một cơ sở dữ liệu thông minh chứa thông tin khách hàng, tài liệu họp, hướng dẫn nhân viên mới... Mọi thành viên có thể đặt câu hỏi và nhận câu trả lời chính xác từ hệ thống trung tâm này mà không cần tìm kiếm thủ công.

-

Phân tích đánh giá khách hàng hiệu quả: Doanh nghiệp có thể tải lên hàng trăm đánh giá từ Amazon, eBay, Best Buy… dưới dạng PDF, rồi dùng NotebookLM để xác định các phàn nàn phổ biến, đề xuất tính năng mới hoặc phân tích tỉ lệ đánh giá 5 sao.

-

Google Sheets tích hợp Gemini có chức năng tương tự nhưng mất phí 20 USD/tháng và chỉ xử lý được từng bảng tính. NotebookLM miễn phí và linh hoạt hơn khi xử lý hàng loạt tài liệu.

-

Sức mạnh chính: Khả năng hỏi đáp theo ngữ cảnh, lưu ghi chú trực tiếp và tạo "AI nội bộ" giúp doanh nghiệp hoạt động hiệu quả hơn, nhanh chóng hơn và đưa ra quyết định chính xác hơn.

📌 NotebookLM của Google là công cụ AI tạo sinh lý tưởng cho doanh nghiệp nhỏ nhờ ba lợi thế lớn: tổng hợp dữ liệu nhanh, quản lý kiến thức thông minh và phân tích phản hồi khách hàng hiệu quả. Dễ dùng, miễn phí và hỗ trợ đa định dạng tài liệu, đây chính là “vũ khí” giúp tăng tốc đổi mới và nâng cao năng suất.

https://www.xda-developers.com/reasons-notebooklm-killer-app-small-businesses-startups/

-

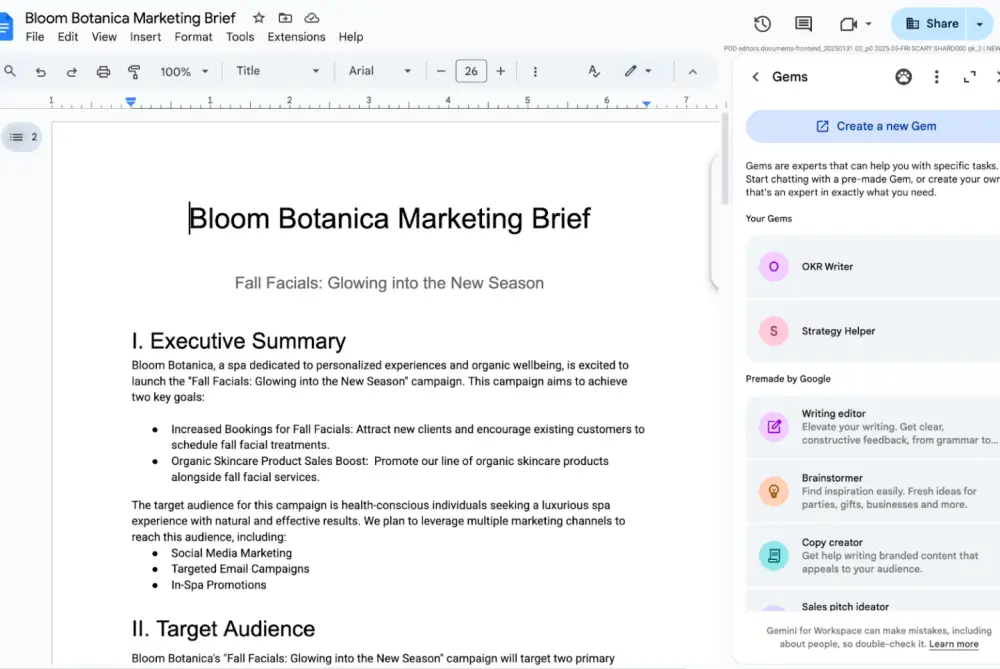

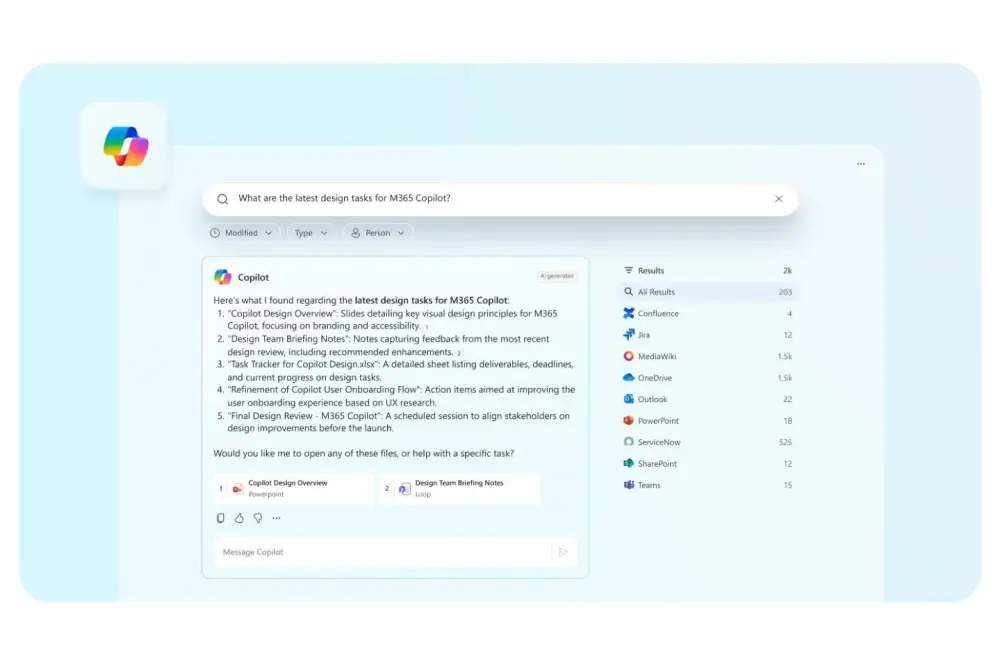

Google vừa công bố cập nhật quan trọng cho người dùng Workspace: Gemini Gems, các chatbot AI tùy chỉnh, nay có thể được truy cập trực tiếp trong thanh bên của Docs, Sheets, Slides, Gmail và Drive mà không cần mở ứng dụng Gemini riêng.

-

Gemini Gems là phiên bản AI có thể cá nhân hóa theo từng nhiệm vụ – từ viết bài theo tông thương hiệu đến hỗ trợ ôn thi, chỉnh sửa văn bản hay tạo ý tưởng bán hàng.

-

Trước đây, Gems chỉ hoạt động trong ứng dụng Gemini. Giờ đây, cả Gems có sẵn lẫn Gems do người dùng tạo đều có thể hoạt động trong Workspace.

-

Một số ví dụ ứng dụng thực tế:

-

Gem copywriting tạo nội dung theo đúng tệp khách hàng, với dữ liệu đã được nạp sẵn.

-

Gem hỗ trợ bán hàng phân tích thông tin của công ty hoặc khách hàng để đưa ra tương tác phù hợp.

-

Assistant Gem theo vai trò công việc, giúp tóm tắt nội dung và tạo nội dung nội bộ hiệu quả hơn.

-

Persona Gem mô phỏng phản ứng của CEO hoặc quản lý cấp cao, giúp kiểm thử tính thuyết phục của nội dung.

-

-

Người dùng có thể tạo Gems mới tại gemini.google.com/gems/create hoặc chọn “Tạo Gem mới” ngay trong panel của Workspace.

-

Dù không thể tạo Gems trực tiếp trong Workspace, người dùng vẫn có thể gắn thẻ (@mention) và truy cập tài liệu, thư mục để hỗ trợ các tác vụ liên quan.

-

Tính năng này bắt đầu được triển khai từ ngày 2/7/2025, nhưng có thể mất hơn 15 ngày để xuất hiện với toàn bộ người dùng.

-

Việc tích hợp này giúp người dùng giảm thao tác lặp lại, tiết kiệm thời gian và nâng cao tính linh hoạt của Gemini AI trong công việc hàng ngày.

📌 Google chính thức đưa Gemini Gems vào Workspace, cho phép truy cập các chatbot tùy chỉnh ngay trong Docs, Sheets, Slides và Gmail. Người dùng có thể sử dụng các trợ lý AI chuyên biệt cho copywriting, bán hàng, truyền thông nội bộ... Tính năng đã bắt đầu triển khai từ 2/7 và hứa hẹn nâng cao đáng kể trải nghiệm làm việc cùng AI.

https://www.theverge.com/news/697352/google-gemini-gems-workspace-apps-docs-gmail

-

Google chính thức tích hợp Gemini vào Google Sheets thông qua gói Google Workspace, giúp người dùng tận dụng AI để xử lý dữ liệu và tạo báo cáo.

-

Để sử dụng, cần bật tính năng này trong bảng điều khiển Admin, bật Alpha Features tại mục Generative AI.

-

Khi mở Google Sheets, biểu tượng Gemini sẽ xuất hiện. Người dùng có thể tương tác trực tiếp qua thanh bên Gemini, đặt câu hỏi hoặc yêu cầu AI thực hiện các tác vụ trong sheet.

-

Ví dụ, có thể yêu cầu Gemini tạo bảng dữ liệu mới, phân tích xu hướng từ dữ liệu có sẵn hoặc gợi ý biểu đồ phù hợp với dữ liệu.

-

Ngoài giao diện thanh bên, Google hỗ trợ công thức mới: =AI(), giúp tương tác với Gemini ngay trong ô tính.

-

Cú pháp công thức:

-

=AI("Prompt", Phạm_vi_dữ_liệu)

-

Tham số thứ hai (vùng dữ liệu) là tùy chọn.

-

-

Ví dụ sử dụng:

-

Tạo tên tài liệu cho dòng dữ liệu:

=AI("Generate a document name suitable for this row", A2:F2) -

Tóm tắt bảng dữ liệu:

=AI("Summarize the data in one line", Table1)

-

-

Sau khi nhập công thức, nhấn "Generate and Insert" để thực thi và có thể kéo công thức xuống các dòng khác để áp dụng cho toàn bộ dữ liệu.

-

Gemini không chỉ hỗ trợ tạo văn bản mà còn giúp phân loại, tóm tắt và hỗ trợ đề xuất dựa trên ngữ cảnh dữ liệu trong sheet.

-

Đây là bước tiến quan trọng giúp người dùng tăng tốc phân tích dữ liệu và tự động hóa công việc ngay trong Google Sheets.

📌 Google Gemini trong Google Sheets cho phép tạo báo cáo, phân tích và tự động hóa với công thức =AI hoặc thông qua Gemini sidebar. Để dùng cần bật trên Google Workspace, hỗ trợ tạo bảng, gợi ý biểu đồ và tóm tắt dữ liệu cực nhanh, tiết kiệm hàng giờ làm việc.

https://www.kdnuggets.com/a-beginners-guide-to-mastering-gemini-google-sheets

-

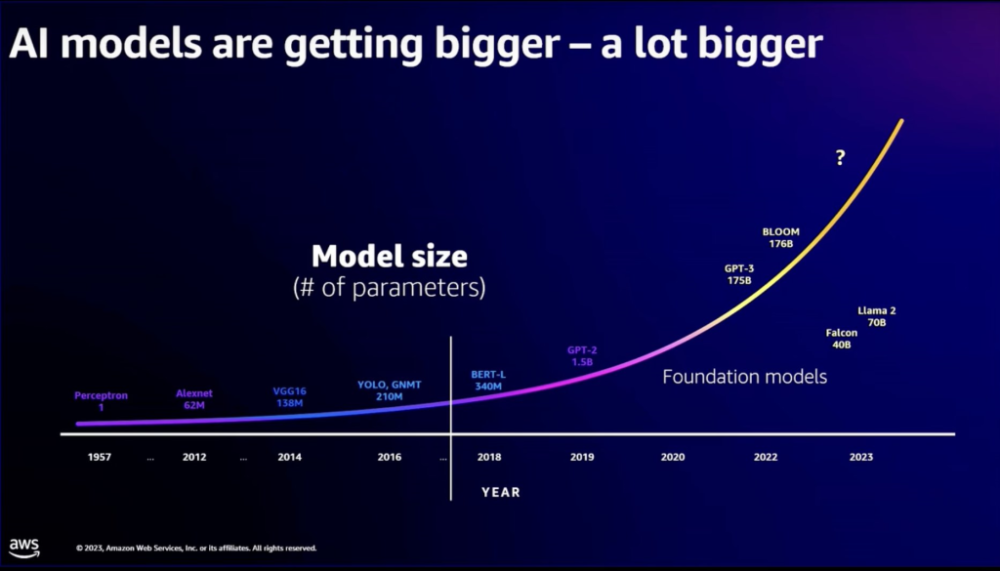

Thị trường AI dự kiến đạt 4.8 nghìn tỷ USD vào năm 2033, và có thể đóng góp 15.7 nghìn tỷ USD cho nền kinh tế toàn cầu vào năm 2030 theo PwC.

-

Satya Nadella (CEO Microsoft):

-

Dùng AI Copilot để đọc tóm tắt email và tin nhắn Teams.

-

Sử dụng ít nhất 10 agent tùy chỉnh từ Copilot Studio để hỗ trợ chuẩn bị họp và nghiên cứu.

-

Thay vì nghe podcast, ông tải transcript lên Copilot để trò chuyện và phân tích nội dung cùng trợ lý AI trong lúc di chuyển.

-

-

Sam Altman (CEO OpenAI):

-

Thừa nhận sử dụng AI cho những việc "nhàm chán" như xử lý email, tóm tắt tài liệu.

-

Sau khi có con đầu lòng vào tháng 2/2025, Altman dùng AI liên tục để nghiên cứu các giai đoạn phát triển của trẻ.

-

Cho rằng AI đã trở thành một phần không thể thiếu trong cuộc sống cá nhân và gia đình.

-

-

Jensen Huang (CEO Nvidia):

-

Nvidia hiện có vốn hóa hơn 3 nghìn tỷ USD.

-

Dùng AI như gia sư cá nhân để học nhanh các lĩnh vực mới, từ cấp độ "giải thích như cho đứa trẻ 12 tuổi" đến trình độ tiến sĩ.

-

Sử dụng ChatGPT và Perplexity gần như mỗi ngày để nghiên cứu chuyên sâu, ví dụ như trong lĩnh vực khám phá thuốc bằng máy tính.

-

Nhấn mạnh AI giúp rút ngắn khoảng cách công nghệ: "AI sẽ nói ngôn ngữ mà bạn muốn".

-

-

Tim Cook (CEO Apple):

-

Công bố hệ thống Apple Intelligence tại WWDC 2024 với nhiều tính năng AI mới.

-

Dùng AI để tóm tắt các email dài, giúp tiết kiệm đáng kể thời gian trong ngày.

-

Chia sẻ AI "đã thay đổi cuộc sống của tôi" trong phỏng vấn với Wall Street Journal.

-

Trước đó trên Good Morning America, Cook từng bày tỏ sự phấn khích với tương lai của AI.

-

-

Jeremy Wacksman (CEO Zillow):

-

Dùng ChatGPT để tóm tắt thông tin cuộc họp hoặc dữ liệu cần thiết theo đúng cách ông muốn, giúp tiết kiệm thời gian hơn so với việc đọc transcript hoặc xem video tua nhanh.

-

Tổ chức các "AI Days" trong nội bộ công ty để khuyến khích nhân viên thử nghiệm và áp dụng AI.

-

Zillow cũng tích hợp tìm kiếm ngôn ngữ tự nhiên powered by AI trên nền tảng từ năm 2023.

-

Nhóm sản phẩm tại Zillow đang dùng công cụ AI như Replit để tạo prototype nhanh chóng.

-

📌 AI đã trở thành công cụ thiết yếu trong cuộc sống của các CEO hàng đầu: Satya Nadella tiết kiệm thời gian nhờ Copilot, Sam Altman dùng AI để hỗ trợ việc nuôi con, Jensen Huang học mọi lĩnh vực với AI như gia sư, Tim Cook tối ưu hoá email nhờ Apple Intelligence và Jeremy Wacksman biến AI thành trợ lý cá nhân cho mọi dữ liệu công việc. AI không chỉ thay đổi cách họ làm việc mà còn định hình lại cả cuộc sống hàng ngày.

https://www.businessinsider.com/how-ceos-use-ai-apple-tim-cook-openai-sam-altman

From podcasts to fatherhood, here's how CEOs are using AI

- CEOs are integrating AI into their personal lives.

- Nvidia's Jensen Huang uses AI as a tutor, while Apple's Tim Cook organizes emails with the tech.

- The AI market is projected to hit $4.8 trillion by 2033.

Microsoft's Satya Nadella

OpenAI's Sam Altman

Nvidia's Jensen Huang

Apple's Tim Cook

Zillow's Jeremy Wacksman

-

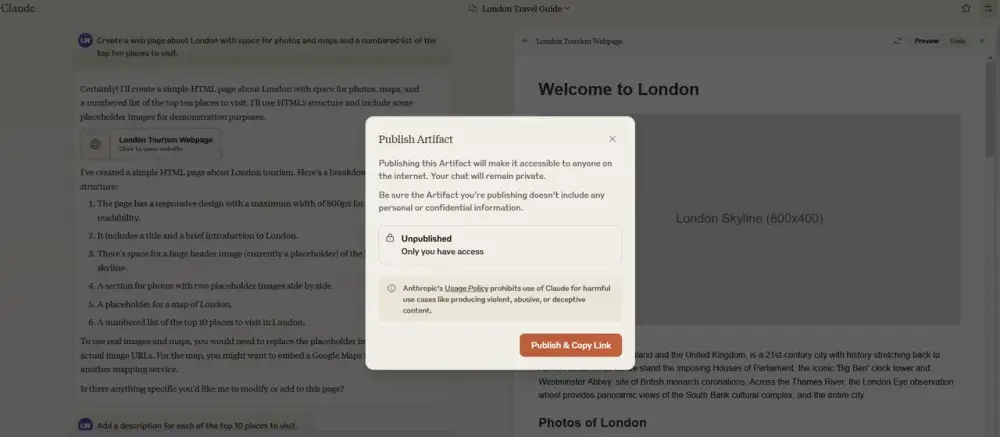

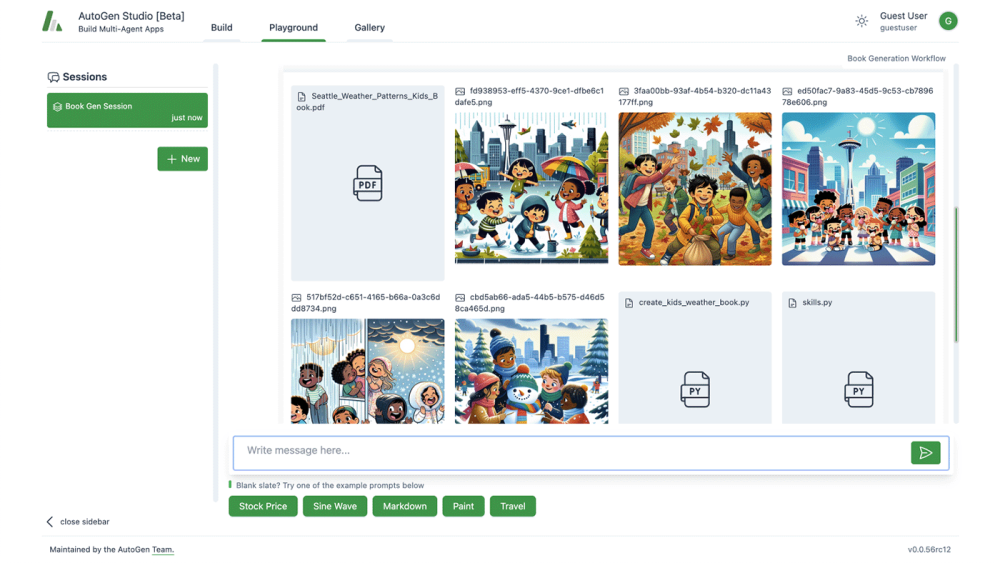

Artifacts là công cụ giúp người dùng tạo ứng dụng, trò chơi, tài liệu hoặc AI assistant mà không cần viết mã, chỉ bằng trò chuyện với Claude.

-

Ứng dụng Artifacts phù hợp cho nhiều mục đích:

-

Prototype sản phẩm: Tạo landing page, app demo nhanh chóng.

-

AI assistant cá nhân hóa: Như trợ lý viết email, chatbot lên kế hoạch đám cưới, hoặc trợ lý công thức nấu ăn cho gia đình.

-

Game học tập: Tạo game giúp trẻ học bảng cửu chương hoặc ứng dụng học ngôn ngữ tương tác.

-

Công cụ cho doanh nghiệp nhỏ: Ví dụ bảng quản lý tiến độ, theo dõi kho hàng hoặc dashboard trực quan.

-

-

Để tạo artifact:

-

Truy cập tab Artifacts trong ứng dụng Claude (chỉ trên desktop).

-

Miêu tả vấn đề hoặc ý tưởng cho Claude.

-

Claude sẽ hỏi thêm để làm rõ, sau đó tạo ứng dụng dựa trên mô tả.

-

Có thể bật chế độ AI powered artifacts để tích hợp AI trò chuyện ngay trong ứng dụng.

-

-

Tính năng chỉnh sửa:

-

Iterate: Yêu cầu Claude chỉnh sửa giao diện, thêm chức năng hoặc thay đổi phong cách.

-

Debug: Chỉ cần mô tả lỗi bằng ngôn ngữ tự nhiên, Claude sẽ giúp sửa.

-

Fork: Dễ dàng tạo nhánh mới từ phiên bản trước để thử nghiệm ý tưởng khác mà không ảnh hưởng bản gốc.

-

-

Chia sẻ artifact:

-

Nhấn Publish để tạo liên kết công khai.

-

Người khác có thể xem, sử dụng hoặc Remix để tạo bản tùy chỉnh riêng.

-

📌 Artifacts biến quá trình sáng tạo ứng dụng AI trở nên dễ dàng, không cần viết mã. Chỉ cần trò chuyện với Claude, bạn có thể tạo game, chatbot, dashboard hoặc bất kỳ công cụ AI nào trong vài phút. Hỗ trợ chia sẻ dễ dàng và chỉnh sửa linh hoạt, phù hợp cả cho cá nhân, giáo viên, doanh nghiệp nhỏ lẫn sáng tạo chuyên sâu.

https://support.anthropic.com/en/articles/11649427-use-artifacts-to-visualize-and-create-ai-apps-without-ever-writing-a-line-of-code

-

Bộ công cụ trí tuệ nhân tạo mang tên Humphrey được chính phủ Anh triển khai rộng rãi trong khu vực công, sử dụng các mô hình AI từ OpenAI, Anthropic và Google.

-

Tất cả công chức tại Anh và xứ Wales sẽ được đào tạo sử dụng AI để nâng cao năng suất, trong nỗ lực cải tổ toàn bộ bộ máy hành chính.

-

Tuy nhiên, chính phủ không có hợp đồng độc quyền với các công ty công nghệ lớn mà dùng mô hình "trả theo lượt dùng" qua các hợp đồng điện toán đám mây hiện có.

-

Giới phê bình lo ngại về tốc độ và quy mô triển khai AI của Big Tech khi luật mới cho phép sử dụng dữ liệu có bản quyền trừ khi chủ sở hữu từ chối – điều gây phẫn nộ trong giới nghệ sĩ.

-

Nghệ sĩ nổi tiếng như Elton John, Paul McCartney, Kate Bush lên tiếng phản đối việc AI học từ tác phẩm của họ mà không xin phép hoặc trả thù lao.

-

Các công cụ như Consult, Lex và Parlex sử dụng mô hình GPT của OpenAI; trong khi Redbox – hỗ trợ soạn thảo tài liệu – tích hợp GPT, Claude và Gemini.

-

Chuyên gia Ed Newton-Rex cảnh báo việc chính phủ vừa phụ thuộc vào AI của Big Tech vừa đồng thời phải xây dựng chính sách quản lý sẽ gây xung đột lợi ích.

-

AI thường xuyên gây lỗi “ảo giác” (hallucination) – đưa ra thông tin sai – nên yêu cầu phải ghi lại lỗi và đánh giá định kỳ để đảm bảo minh bạch.

-

Chính phủ Anh cho biết đã thiết lập hướng dẫn sử dụng AI, đánh giá hiệu quả qua các thử nghiệm, và đảm bảo kiểm soát con người trong những quyết định quan trọng.

-

Một số phần mềm như AI Minute chỉ tốn 0,5 bảng (khoảng 0,63 USD) để ghi chú cuộc họp 1 giờ, giúp tiết kiệm một giờ hành chính.

-

Bộ Khoa học, Đổi mới và Công nghệ khẳng định việc dùng AI không hạn chế khả năng quản lý, tương tự như NHS vừa mua thuốc vừa giám sát ngành dược.

📌 Chính phủ Anh đang đẩy mạnh ứng dụng AI như Humphrey vào toàn bộ công vụ, dùng mô hình từ OpenAI, Anthropic và Google. Tuy nhiên, việc triển khai nhanh gây tranh cãi do liên quan bản quyền và nguy cơ lệ thuộc Big Tech. Các công cụ giúp giảm chi phí, nhưng giới nghệ sĩ phản ứng mạnh và chuyên gia kêu gọi ghi nhận lỗi AI để kiểm soát chặt chẽ hơn.

https://www.theguardian.com/technology/2025/jun/15/government-roll-out-humphrey-ai-tool-reliance-big-tech

-

Ngày 12/6/2025, Google chính thức triển khai các tính năng mới cho Gemini AI trong Google Workspace, mở rộng khả năng tóm tắt file PDF và phản hồi Google Forms.

-

Khi người dùng mở một tệp PDF trong Google Drive, Gemini tự động tạo thẻ tóm tắt nội dung, đồng thời hiển thị các hành động gợi ý như:

-

“Viết đề xuất mẫu”

-

“Liệt kê câu hỏi phỏng vấn dựa trên hồ sơ đính kèm”

-

-

Tính năng này hỗ trợ hơn 20 ngôn ngữ, đang được triển khai dần và sẽ xuất hiện trong vài tuần tới với người dùng Google Workspace.

-

Với Google Forms, Gemini giờ có thể tóm tắt phản hồi của người tham gia cho các câu hỏi ngắn và dạng đoạn văn. Tóm tắt sẽ hiển thị ở tab “Responses” khi có hơn 3 phản hồi cho câu hỏi.

-

Tính năng này hiện chỉ hỗ trợ tiếng Anh và sẽ chính thức ra mắt người dùng Google Workspace từ ngày 26/6/2025.

-

Google cũng giới thiệu công cụ “help me create” trong Google Forms – cho phép người dùng tạo biểu mẫu tự động dựa trên mô tả tự nhiên.

-

Người dùng có thể đính kèm thêm tài liệu như Docs, Sheets, Slides hoặc PDF để Gemini tích hợp thông tin vào biểu mẫu.

-

Ví dụ: một công ty mộc có thể tải lên danh mục sản phẩm, từ đó Gemini sẽ tạo form báo giá để gửi khách hàng.

-

Tính năng này cũng hỗ trợ tiếng Anh, và sẽ bắt đầu triển khai cho các domain Workspace thông thường từ 7/7/2025.

📌 Google nâng cấp Gemini AI giúp người dùng Workspace tiết kiệm thời gian khi tóm tắt file PDF, phản hồi Google Forms và tự động tạo biểu mẫu từ mô tả. Các tính năng bắt đầu triển khai từ tháng 6–7/2025, hỗ trợ hơn 20 ngôn ngữ cho PDF và tiếng Anh cho Forms. Đây là bước tiến lớn giúp nâng cao hiệu suất công việc qua AI tích hợp sâu trong các công cụ văn phòng.

https://www.theverge.com/news/686684/google-gemini-ai-workspace-pdf-form-summary-features

-

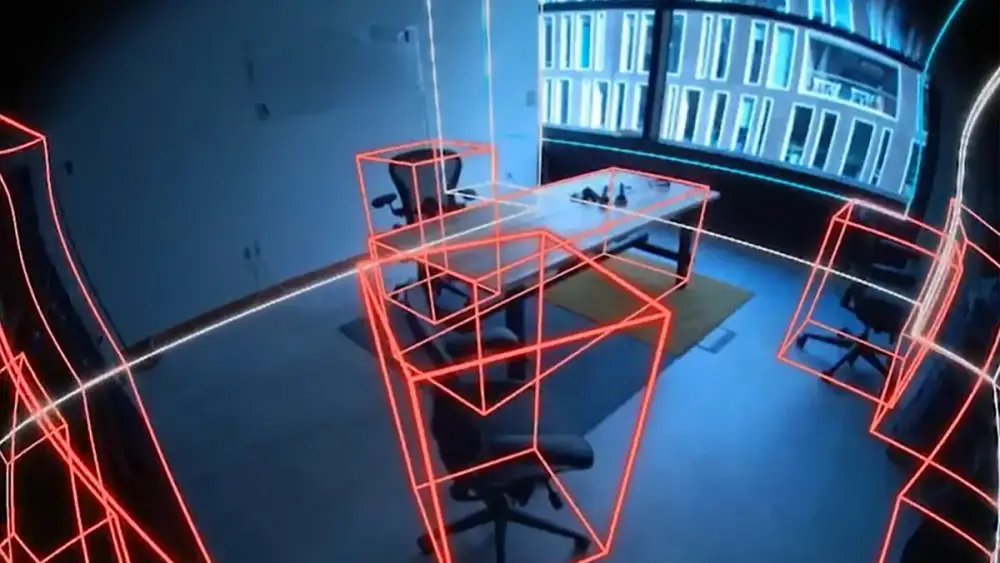

Tại sự kiện Augmented World Expo 2025, Qualcomm giới thiệu bước đột phá với Snapdragon AR1+ Gen 1 – bộ xử lý giúp kính thông minh vận hành AI tạo sinh (Gen AI) hoàn toàn trên thiết bị, không cần kết nối điện thoại hoặc internet.

-

Ziad Asghar, Phó Chủ tịch cấp cao phụ trách XR của Qualcomm, đã trò chuyện trực tiếp với AI thông qua kính RayNeo X3 Pro, trình diễn một tình huống tại siêu thị mà không cần bất kỳ thiết bị phụ trợ nào.

-

AI được tích hợp là Llama 1B, một mô hình ngôn ngữ nhỏ (SLM), xử lý yêu cầu về món ăn "fettuccine alfredo" và phản hồi qua âm thanh và hiển thị ngay trên kính.

-

Snapdragon AR1+ Gen 1 nhỏ hơn 26% so với thế hệ trước, mang lại cải tiến rõ rệt về kích thước, hiệu suất hình ảnh và khả năng chạy mô hình AI. Đây là yếu tố quan trọng để thiết kế kính mỏng nhẹ nhưng vẫn mạnh mẽ.

-

Qualcomm xác định đây là cuộc cách mạng mới: kính AI sẽ không còn là phụ kiện mà trở thành thiết bị chính, hoạt động độc lập như một trợ lý tác tử.

-

Ngoài AR1+, Qualcomm còn hỗ trợ đa dạng thiết bị XR khác như Snapdragon XR2 và XR2+, phù hợp với các thiết bị thực tế hỗn hợp khác nhau.

-

Qualcomm cũng đang xây dựng kiến trúc modular để kết nối kính với đồng hồ, nhẫn thông minh hoặc cảm biến, tạo nên hệ sinh thái AI đeo tay phong phú.

-

AI trên kính sẽ có khả năng nhìn và hiểu thế giới thông qua camera cao cấp – cho phép phản hồi chủ động, tăng cường ngữ cảnh và hiểu biết đối tượng theo thời gian thực.

-

Đây là dấu mốc đầu tiên trong hành trình biến kính thông minh thành tác tử AI thực thụ, hoạt động độc lập, cá nhân hóa và hiệu quả với độ trễ siêu thấp.

📌 Qualcomm vừa công bố AR1+ Gen 1 – bộ xử lý đầu tiên cho phép kính thông minh chạy Gen AI hoàn toàn trên thiết bị, không cần điện thoại hay đám mây. Trong buổi demo lịch sử tại AWE 2025, kính RayNeo X3 Pro đã trò chuyện với người dùng và phản hồi trực tiếp. Đây là bước ngoặt lớn trong ngành kính thông minh, mở ra kỷ nguyên AI tác tử đeo tay với hiệu suất cao, cá nhân hóa sâu và độ trễ thấp. Qualcomm đang đặt nền móng cho tương lai XR thông minh và độc lập.

https://venturebeat.com/games/qualcomm-shares-its-vision-for-the-future-of-smart-glasses-with-on-glass-gen-ai/

-

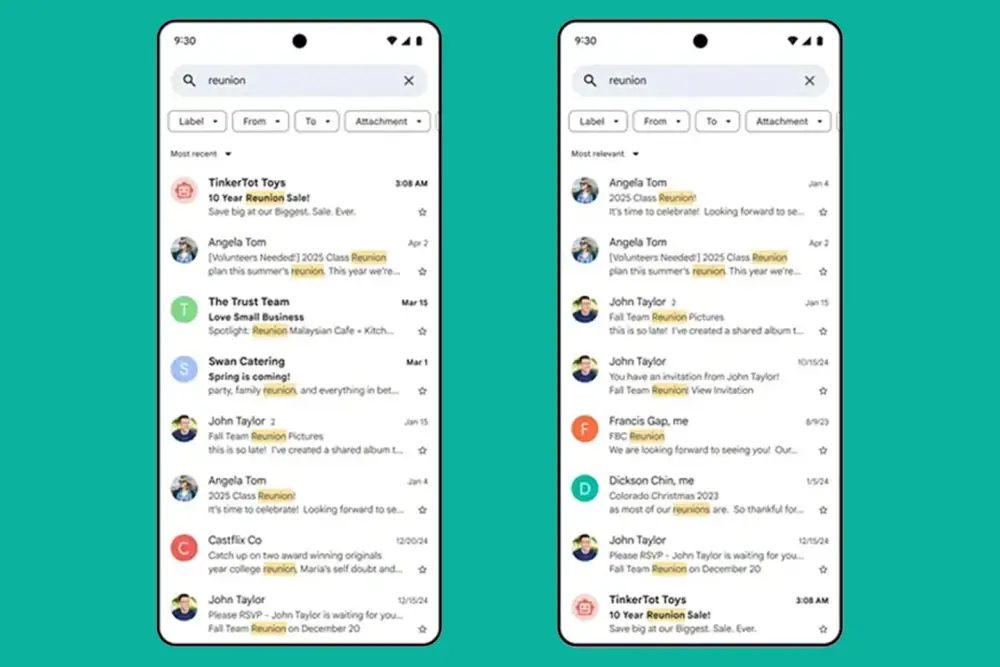

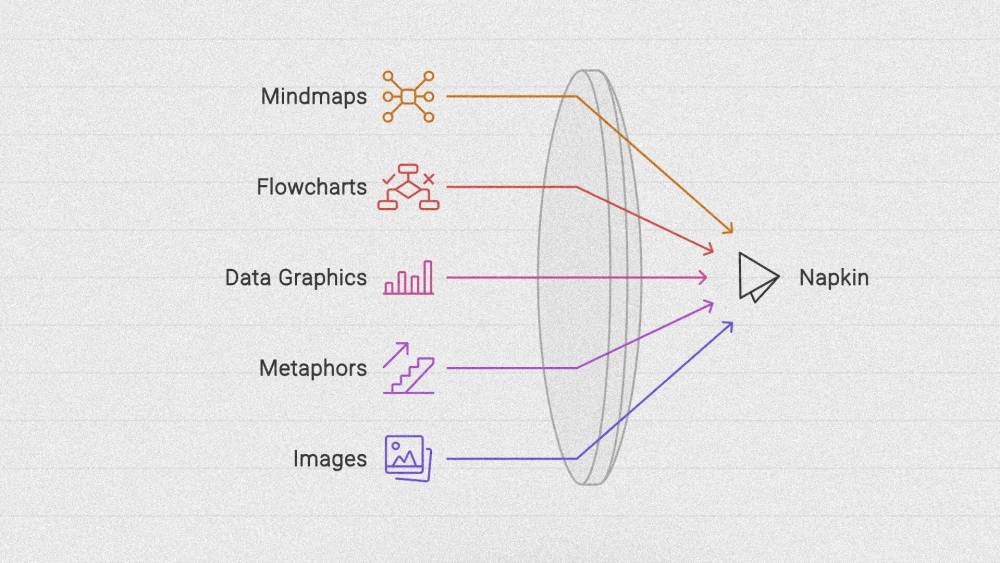

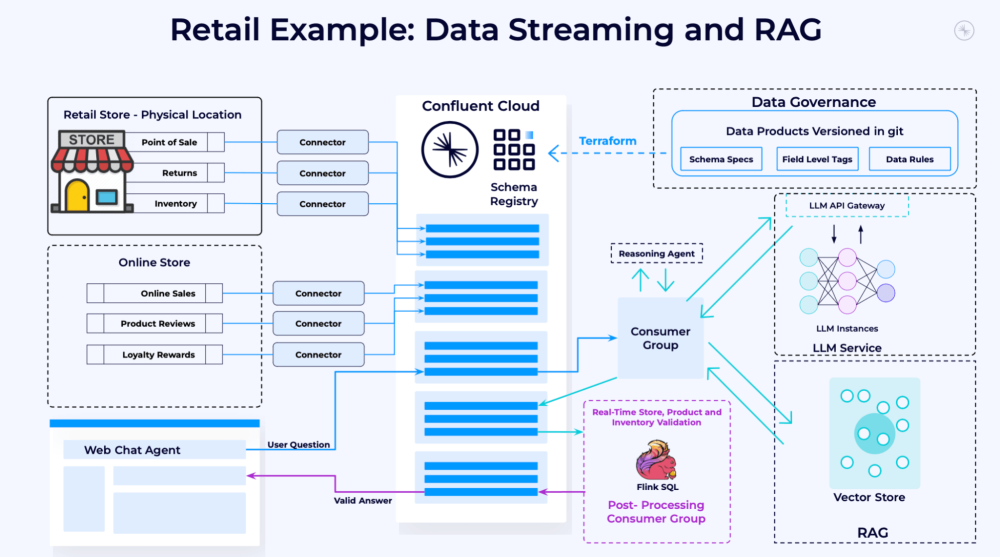

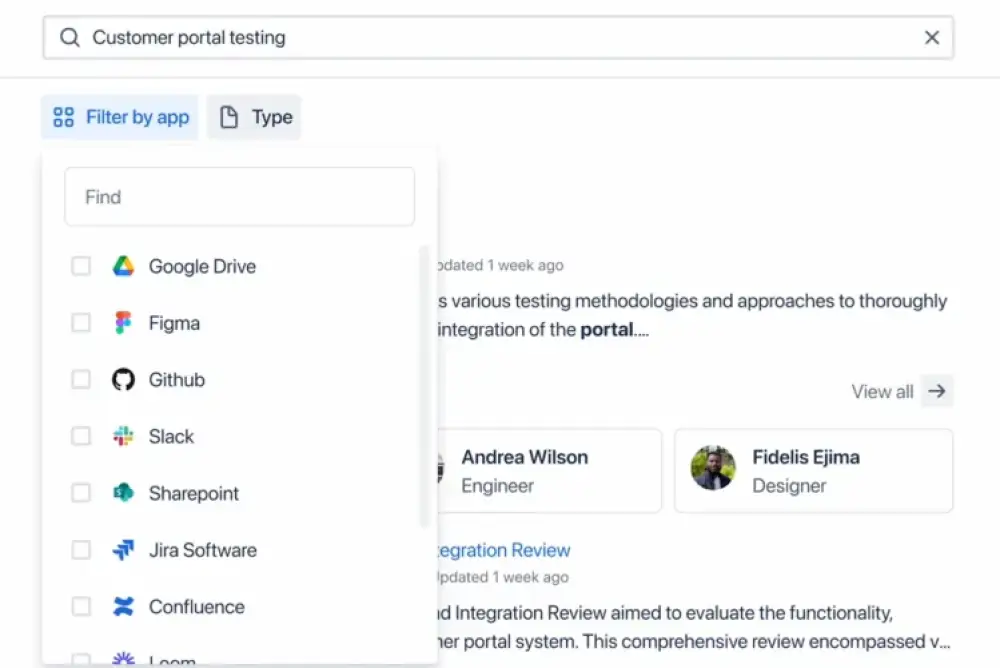

Trong kỷ nguyên AI, tìm kiếm doanh nghiệp không còn đơn thuần là khớp từ khóa, mà chuyển sang khả năng hiểu ngữ nghĩa và thực hiện hành động thông minh qua giao diện hội thoại.

-

Thách thức lớn nhất hiện nay là dữ liệu:

-

Doanh nghiệp sở hữu lượng lớn dữ liệu phi cấu trúc (email, cuộc gọi, tin nhắn Slack) chứa giá trị lớn nhưng khó truy cập do phân tán, không đồng nhất, thiếu chuẩn hóa và nhạy cảm với bảo mật.

-

Nếu AI không được cấp quyền truy cập đúng, hệ thống dễ tạo ra kết quả sai lệch hoặc không tin cậy (“rác vào, rác ra”).

-

-

Tiến hóa công nghệ tìm kiếm gồm 3 tầng:

-

Vector Search: Biến dữ liệu và truy vấn thành vector, cho phép tìm kiếm theo ý nghĩa chứ không phải từ khóa đúng.

-

Knowledge Graphs: Tạo mạng lưới dữ liệu có quan hệ (ai, cái gì, ở đâu...) để cung cấp ngữ cảnh sâu hơn.

-

NL2SQL: Biến ngôn ngữ tự nhiên thành truy vấn SQL, giúp truy cập dữ liệu có cấu trúc dễ dàng hơn.

-

-

Salesforce kết hợp RAG + Data Cloud + AI hội thoại:

-

RAG (Retrieval-Augmented Generation) cho phép AI kết nối dữ liệu nội bộ theo thời gian thực, tạo câu trả lời đúng bối cảnh doanh nghiệp thay vì trả lời chung chung.

-

AI có thể cá nhân hóa tương tác khách hàng, viết nội dung tiếp thị phù hợp với dữ liệu mới nhất hoặc trả lời hỗ trợ khách hàng dựa trên lịch sử tương tác.

-

-

Tương lai là hệ thống tác tử AI tự chủ:

-

Một đội ngũ AI trong doanh nghiệp tự động xử lý tác vụ phức tạp như nghiên cứu thị trường, tổng hợp thông tin đối thủ, phản hồi khách hàng – tất cả đều dựa trên dữ liệu thời gian thực.

-

-

Thách thức cần giải quyết:

-

Tích hợp hệ thống dữ liệu dị biệt

-

Làm sạch và chuẩn hóa dữ liệu

-

Xây dựng ontology phản ánh ngữ nghĩa doanh nghiệp

-

Đảm bảo hiệu suất truy vấn và xử lý lớn

-

📌 Tìm kiếm doanh nghiệp đang bước vào kỷ nguyên mới: từ khớp từ khóa sang hiểu ngữ nghĩa và hành động thông minh. Salesforce kết hợp vector search, knowledge graphs và RAG để biến AI từ người quan sát thành tác tử tự hành động. Với khả năng truy cập dữ liệu thời gian thực, AI có thể xử lý tác vụ phức tạp như phản hồi khách hàng, tạo nội dung, và phân tích thị trường. Đây là bước đệm cho doanh nghiệp thông minh vận hành bằng AI tự chủ.

https://venturebeat.com/ai/beyond-the-keyword-how-ai-is-forging-the-future-of-enterprise-search/

-

The Browser Company ra mắt Dia, một trình duyệt hoàn toàn mới, đưa AI vào trung tâm trải nghiệm web cá nhân, thay vì chỉ tái thiết kế tab như sản phẩm cũ Arc.

-

Giao diện của Dia giống Chrome nhưng hiện đại hơn, với thanh chat AI tích hợp bên phải giúp người dùng tương tác với tab, lịch sử duyệt web và các trang đã đăng nhập.

-

Người dùng có thể hỏi AI về bất cứ nội dung nào đang mở, tổng hợp thông tin từ nhiều tab, hỗ trợ lập kế hoạch, học tập, mua sắm, viết email, hay thậm chí nhận tư vấn hẹn hò.

-

Hệ thống “kỹ năng” (skills) cho phép Dia điều phối giữa các mô hình AI khác nhau, kích hoạt các tác vụ cụ thể như tìm áo khoác theo lịch sử mua sắm, hay soạn email dựa trên thói quen viết của người dùng.

-

Thay vì phát triển mô hình riêng, Dia sử dụng hệ thống định tuyến thông minh để chọn đúng AI và đúng dữ liệu cho từng tác vụ, giống cách App Store cung cấp ứng dụng chuyên biệt.

-

3 lợi thế lớn của trình duyệt:

-

Quan sát và học thói quen người dùng qua lịch sử duyệt web

-

Sở hữu omnibox (CMD-T) – điểm nhập liệu trung tâm trên máy tính

-

Quản lý cookie – cho phép tương tác sâu với các trang đã đăng nhập

-

-

Dia có thể “nhìn thấy” mọi nội dung trong các website người dùng đang đăng nhập – mở đường cho tương lai agent AI có thể thay người dùng thực hiện tác vụ online như đặt lịch, mua hàng, gửi email…

-

Đội ngũ phát triển cẩn trọng về quyền riêng tư: dữ liệu được lưu và mã hóa cục bộ, nội dung gửi lên máy chủ sẽ bị xóa ngay sau xử lý.

-

Trải nghiệm ban đầu nổi bật của Dia là trò chuyện với tab và xử lý tác vụ đa bước không cần copy/dán hay chuyển đổi ứng dụng.

-

Về lâu dài, Dia có thể trở thành “trợ lý AI cá nhân hóa” đi cùng người dùng mọi nơi – tương tự như Spotify hiểu gu âm nhạc, Dia sẽ hiểu cách bạn sống và làm việc.

📌 Dia là trình duyệt mới dùng AI làm trung tâm, cho phép trò chuyện trực tiếp với tab, lịch sử và website đã đăng nhập. Với hệ thống định tuyến AI thông minh và bảo mật dữ liệu nội bộ, Dia không chỉ là trình duyệt, mà là một trợ lý kỹ thuật số học thói quen của bạn theo thời gian. Mục tiêu: trở thành ứng dụng bạn không thể rời bỏ trong kỷ nguyên AI.

https://www.theverge.com/web/685232/dia-browser-ai-arc

-

Perplexity – công ty khởi nghiệp AI tìm kiếm – đang phát triển trình duyệt AI có tên Comet, dự kiến phát hành rộng rãi trong vài tháng tới, hiện chỉ có 1.200 người dùng thử nghiệm.

-

Comet có giao diện giống trình duyệt truyền thống nhưng tích hợp trợ lý AI bên cạnh, có thể duyệt tab, trích xuất dữ liệu và gửi email kết quả, như thống kê 780 triệu truy vấn/tháng của Perplexity.

-

CEO Aravind Srinivas mô tả Comet như "tầng chính xác" của AI, nơi trình duyệt và AI sống cùng người dùng, hướng đến trải nghiệm cá nhân hóa hoàn toàn.

-

Không chỉ Perplexity, Google tích hợp Gemini AI vào Chrome, Opera và The Browser Company cũng đẩy mạnh tính năng AI. OpenAI đang cân nhắc phát triển trình duyệt riêng.

-

Thị trường trình duyệt đang đứng trước thời điểm bất ổn khi Bộ Tư pháp Mỹ đề xuất buộc Google bán Chrome vì độc quyền tìm kiếm. Chrome có thể trị giá tới 20 tỷ USD.

-

Perplexity và OpenAI bày tỏ mong muốn mua lại Chrome nếu Google buộc phải bán, dù OpenAI có lợi thế tài chính lớn hơn (định giá 300 tỷ USD so với 14 tỷ USD của Perplexity).

-

Perplexity cũng học theo chiến lược của Google bằng cách thương lượng với các hãng điện thoại như Samsung và Motorola để tích hợp trình duyệt hoặc công cụ tìm kiếm AI vào thiết bị mặc định.

-

Tuy nhiên, hợp đồng giữa Google và Motorola đã chặn Perplexity trở thành trợ lý mặc định. CEO Srinivas cáo buộc Google can thiệp sau hậu trường để phá vỡ thỏa thuận.

-

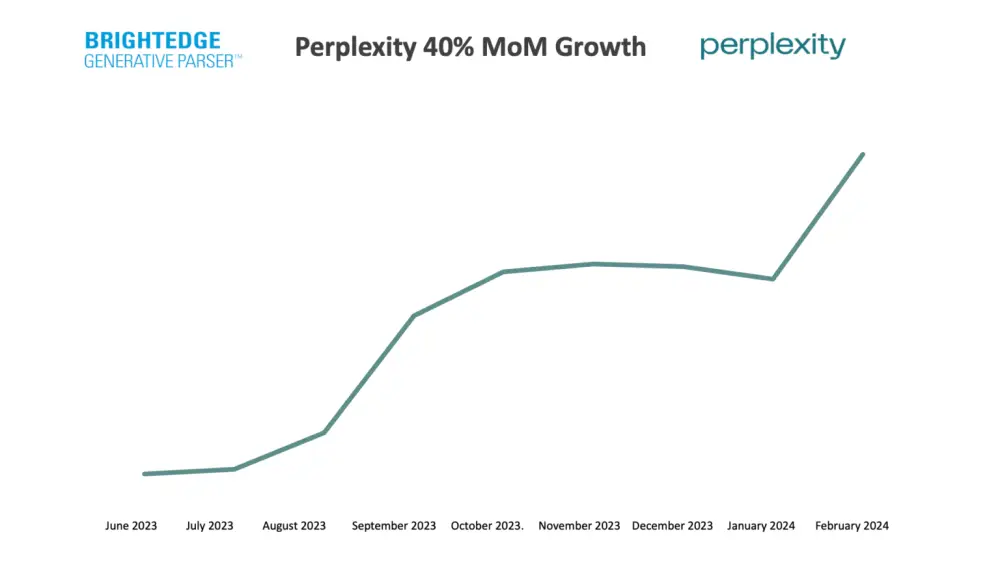

Trong khi đó, Perplexity tiếp tục gây ấn tượng với AI tìm kiếm thời gian thực và đóng gói sản phẩm nhanh, giúp hãng chiếm lợi thế sớm so với nhiều đối thủ.

-

Dù vậy, việc thuyết phục người dùng chuyển sang một trình duyệt AI mới vẫn là thách thức lớn nhất trong việc thay đổi thói quen Internet tồn tại từ hàng thập kỷ.

📌 Perplexity đặt cược vào Comet – trình duyệt AI tích hợp trợ lý thời gian thực – để định hình lại cách con người dùng Internet. Với 780 triệu truy vấn/tháng, thương lượng với Samsung và tham vọng cạnh tranh Chrome trị giá 20 tỷ USD, Perplexity đang khai hỏa cuộc chiến trình duyệt AI với Google, OpenAI và các "ông lớn" công nghệ khác.