AI tips

View All

-

Ba thủ thư chuyên nghiệp đã cùng thử nghiệm ChatGPT 5, Google AI Mode, AI Overviews và các công cụ khác để đánh giá khả năng trả lời chính xác. Họ coi AI như “người bán xe cũ” – cần tin nhưng luôn kiểm chứng.

-

Bài học đầu tiên: Google AI Mode vượt trội so với các công cụ khác, kể cả ChatGPT 5, đặc biệt tốt cho nghiên cứu kiểu “kim đáy bể”. Nó chạy hàng chục tìm kiếm đồng thời, phân tích và tổng hợp. AI Overviews kém chính xác hơn.

-

Bài học thứ hai: Hãy cực kỳ cụ thể khi hỏi AI. AI không biết đặt câu hỏi ngược lại như thủ thư. Người dùng cần thêm bối cảnh, giới hạn thời gian, ví dụ minh họa. Có thể yêu cầu AI tự phản biện (“đưa quan điểm ngược lại”, “chỉ ra thiếu sót”…) để đa chiều hơn.

-

Bài học thứ ba: Nhận diện các điểm mù của AI.

• Kiến thức bị giới hạn thời gian (ChatGPT 5 chỉ cập nhật đến 30/9/2024 nếu không có web search).

• Kém trong xử lý hình ảnh.

• Thiếu quyền truy cập nguồn học thuật và dữ liệu trả phí. -

Bài học thứ tư: Luôn kiểm tra trích dẫn. AI có thể dẫn link nhưng trả lời sai hoặc dựa trên nguồn thiếu uy tín. Người dùng cần kiểm chứng tác giả, tổ chức, ngày xuất bản. Đặc biệt cảnh giác với nguồn từ Reddit hay mạng xã hội.

-

Bài học thứ năm: Hỏi nhiều lần và so sánh. Mở tab khác, thử lại trên các AI khác. Nếu câu trả lời đồng nhất, đáng tin hơn; nếu khác biệt, có cơ hội soi chiếu. Luôn nên có kiến thức nền (“two-book minimum”) để nhận diện sai sót và tránh lạc lối.

-

Khi không chắc chắn, hãy tìm đến thủ thư thật. Nhiều thư viện công cộng và đại học hiện cung cấp dịch vụ “virtual reference” để hỗ trợ trực tuyến.

📌 Để khai thác AI hiệu quả, cần dùng Google AI Mode thay vì AI Overviews, đặt câu hỏi cụ thể, nhận diện các điểm mù của AI, luôn kiểm chứng trích dẫn, và so sánh kết quả trên nhiều công cụ AI. Thử nghiệm cho thấy AI có thể tiết kiệm thời gian, nhưng nếu không cảnh giác, người dùng dễ sa vào thông tin sai lệch. Bí kíp là: “Tin tưởng, nhưng phải xác minh.”

https://www.washingtonpost.com/technology/2025/09/02/ai-search-engines-tips-use/

-

Nghiên cứu cho thấy AI tạo sinh đang làm suy giảm kỹ năng nhận thức cốt lõi, khi người dùng ngày càng phụ thuộc vào công cụ để giải quyết vấn đề, thay vì tự tư duy.

-

Vấn đề bắt nguồn từ “cognitive offloading” – xu hướng bộ não né tránh khó khăn và dựa vào công nghệ. Khác với GPS hay máy tính bỏ túi, AI có phạm vi ứng dụng quá rộng, khiến tâm trí “tắt máy” khi dùng.

-

Một nghiên cứu với gần 1.000 sinh viên: nhóm dùng ChatGPT để giải toán ban đầu vượt 48% so với nhóm tự làm, nhưng khi kiểm tra không có AI, kết quả lại thấp hơn 17%. Tức là lợi ích ngắn hạn che giấu sự thụt lùi dài hạn.

-

Trong hàng không, FAA khuyến khích phi công bay thủ công một số chặng để duy trì kỹ năng, tránh phụ thuộc autopilot – bài học tương tự cho AI.

-

4 thói quen quan trọng:

-

Draft first, prompt second – phác thảo ý tưởng trước rồi mới dùng AI chỉnh sửa, giúp duy trì năng lực giải quyết vấn đề.

-

Dùng AI như gia sư Socratic – yêu cầu hướng dẫn từng bước thay vì đáp án sẵn, sau đó tự giải thích lại để kiểm chứng mức độ hiểu.

-

Timeouts và checklist – tạm dừng để đánh giá phản hồi của AI, đặt câu hỏi: có sai sót không, có thiên kiến không, có thiếu góc nhìn nào không.

-

AI fast – dành thời gian làm việc hoàn toàn không dùng AI để rèn luyện “cơ bắp nhận thức”.

-

-

Các nghiên cứu khác cũng cảnh báo: phụ thuộc AI làm giảm tư duy phản biện (Swiss Business School, Microsoft survey), tăng nguy cơ tiếp nhận thiên kiến như hình ảnh AI tạo ra về “financial managers” (85% là nam da trắng, trái ngược thực tế <45%).

-

Giáo dục và doanh nghiệp cần thiết kế khung sử dụng AI cân bằng: vừa khai thác lợi ích, vừa giữ nguyên nền tảng kỹ năng con người.

📌 ChatGPT và AI tạo sinh có thể làm suy giảm khả năng tư duy, nếu dùng thiếu kiểm soát. Vấn đề bắt nguồn từ “cognitive offloading” – xu hướng bộ não né tránh khó khăn và dựa vào công nghệ. Khác với GPS hay máy tính bỏ túi, AI có phạm vi ứng dụng quá rộng, khiến tâm trí “tắt máy” khi dùng. Bằng chứng: sinh viên dùng AI giải toán cao hơn 48% ban đầu, nhưng thấp hơn 17% khi thi lại không có AI. 4 giải pháp bao gồm: tự phác thảo trước, dùng AI như gia sư, áp dụng checklist để tránh thiên vị và thực hành “AI fast” nghĩa là dành thời gian làm việc hoàn toàn không dùng AI để rèn luyện “cơ bắp nhận thức”. AI nên là công cụ đồng hành, không phải thay thế, để duy trì sự sáng tạo và sức mạnh nhận thức con người.

https://www.wsj.com/tech/ai/chatgpt-tips-smarter-dc33a0fd

How to Make Sure ChatGPT Doesn’t Make You Dumber

Generative AI tools are quietly weakening our cognitive skills. Here are four ways to keep that from happening.

By Paul Rust and Nina Vasan

Sept. 3, 2025 2:04 pm ET

Beth Goody

ChatGPT is down, and dread sets in. You stare at the blank document. The report is due in two hours, but the thought of writing it yourself feels overwhelming. The analytical skills that once kicked in automatically—like breaking down problems, organizing thoughts and finding the right words—now seem impossibly difficult. When did thinking become this hard?

These moments of technological dependence are becoming increasingly common as generative AI reshapes how we work, learn and think. At our lab, we’ve spent a decade treating patients, studying how technology shapes the human mind, and supporting the integration of mental-health and well-being principles into AI and social-media platforms. As generative AI enters workplaces and schools at unprecedented speed, we’re observing a troubling phenomenon: the quiet erosion of our cognitive capabilities.

The allure of the technology is powerful. As our colleague Darja Djordjevic, a psychiatrist at Harlem Hospital and Columbia University says, “Here is a machine that is always available, endlessly enthusiastic, and seemingly competent in every domain. That creates a powerful feedback loop. You skip the discomfort of starting from scratch and get rewarded in seconds.”

No wonder our brain, delighted to dodge difficulty, craves these shortcuts. Humans have always used technology for cognitive offloading—using external tools to reduce mental demands. We write notes to remember, use calculators for arithmetic, and rely on GPS for navigation.

Where previous technologies affected discrete skills, however, generative AI tools raise the stakes. These tools are so expansive in their applications, so autonomous in their execution, that when we activate them, our minds effectively power down.

Therein lies the risk. The very convenience that boosts short-term productivity may also be accelerating long-term cognitive atrophy, across more domains than any technology before it. Drawing on insights from psychology, patient care, aviation research and behavioral science, we offer four habits that foster a more deliberate relationship with ChatGPT—one that fortifies, rather than diminishes, our cognitive faculties.

1. Draft first, prompt second

Like muscles, our cognitive skills weaken when unused. Offloading entire tasks to AI may diminish cognitive capabilities such as problem-solving, creative thinking and critical reasoning.

A recent study of nearly 1,000 students offers an unsettling glimpse of this phenomenon. Students using ChatGPT to solve math problems initially outperformed their peers by 48% during practice. But when tested without AI, their scores dropped 17% below their unassisted counterparts. Short-term gains masked long-term losses.

This pattern isn’t confined to the classroom. In aviation, research shows that overreliance on autopilot dulls pilots’ manual flying skills. The Federal Aviation Administration thus encourages pilots to fly route segments manually to ensure proficiency is maintained.

Psychologists have long emphasized the power of “mastery experiences”—struggling through and conquering difficult tasks—as the single strongest predictor of self-efficacy, our internal belief in competence. When ChatGPT skips the hurdle for us, mastery never materializes; over time the very capacity fades, confidence erodes, and dependence deepens.

To keep your skills sharp, outline your approach before opening the chat window. Think through the problem and jot down ideas; bullet points suffice. Then ask the model to elaborate or polish. This initial manual effort may feel like returning to the gym after months away, but deliberate practice preserves both skills and confidence.

2. Use AI as a tutor

Have you noticed that after asking Perplexity or ChatGPT for answers, you can articulate concepts fluently while viewing the screen, but an hour later, clarity evaporates and you fumble explaining them to colleagues?

When we ask AI for answers directly, we engage less deeply—and memory and understanding suffers. A preliminary MIT study found that individuals who used ChatGPT to write essays had poorer recall of their own work. The result echoes the “Google effect,” in which easy fact‑finding dampens internal memory retention; similarly, research shows GPS use decreases spatial memory.

But with AI, it isn’t just isolated facts at risk: We may lose grasp of entire concepts and ideas because explanations arrive in a single click.

One possible remedy: Turn the bot into a Socratic tutor. Instead of “Give me the answer,” try “Guide me through the problem so I can solve this on my own.” Request step-by-step explanations. After completing the task, close the window and re‑explain the idea in your own words to test retention.

In one study with chemistry students, a modified version of ChatGPT that withheld direct solutions and supplied only incremental hints fostered greater engagement and learning outcomes than the default model. The small shift from prompting for product to prompting for process cultivates lasting comprehension.

3. Timeouts and checklists

How often do you find yourself mechanically copying AI output, only to wince when colleagues point out glaring errors that somehow escaped your notice?

Heavy AI reliance extends beyond skill atrophy into compromised judgment and bias. A Swiss Business School study of 666 participants and a Microsoft survey of 319 knowledge workers this year both found that heavy AI reliance correlated with poorer critical-thinking skills.

This exposes us to automation bias, prompting us to accept machine judgments uncritically and inherit its blind spots: In one behavioral science experiment, volunteers forfeited a larger cash prize simply because an AI warned them not to trust their human partner, even after evidence showed cooperation would pay.

The risk goes deeper than a single bad decision; if we don’t reflect on AI’s output critically, we might internalize the machine’s inherent biases. In one experiment, participants were shown AI-generated images of “financial managers”; 85% of the AI-images depicted white men, despite the reality that, in the U.S., fewer than 45% of financial managers are men, let alone white. Alarmingly, after being exposed to the AI-images, participants also showed a greater tendency to associate that identity with the role.

To counter this bias, people can use “cognitive forcing” tools—methods borrowed from medicine and aviation—to shift thinking from our swift, intuitive processing to slow, deliberate analysis. Doctors use “diagnostic timeouts” to double-check reasoning; pilots run mental checklists before takeoff. Apply the same approach: When AI delivers answers, pause. Restate the main points aloud or in writing. Then run a mental checklist: Can this be verified? What perspectives might be missing? Could this be biased? Such metacognitive prompts catch mistakes and spark originality and critical thinking.

Research shows that workers with stronger metacognitive skills become more creative when using ChatGPT. Additionally, a preliminary study showed that students who were instructed to ask themselves metacognitive questions—such as “How closely does the response align with what you expected?” and “Is there anything in the response that you do not fully understand?”—when conducting searches with GenAI demonstrated higher levels of critical thinking.

4. Try an AI fast

The most direct path to preserving your intellectual faculties is to declare certain periods “AI-free” zones. This can be one hour, one day, even entire projects. Doing things yourself is the most reliable way to prevent dependency and ensure your cognitive capabilities remain sharp.

As generative AI continues its inexorable rise, it forces fundamental reckonings about human capability itself, both institutionally and individually.

In corporate environments, it raises questions about talent and value creation. Companies investing heavily in AI productivity tools may inadvertently be undermining their workforce’s long-term capabilities.

Educational institutions face an even thornier challenge: Outright bans on generative AI risk would leave students digitally illiterate in an AI-saturated world, yet unrestricted access risks undermining the very thinking abilities education aims to develop. The challenge demands nuanced, evidence-based frameworks that teach students to harness AI’s benefits while preserving critical-skill formation.

None of this argues of course for shelving generative AI. Few of us would trade Wikipedia for a paper encyclopedia or swap Excel for an abacus. The challenge is cultivating a mindful relationship with the technology; one that captures its leverage without letting it hollow out our faculties.

Generative AI can be a partner, muse, and accelerator. But without deliberate boundaries, this omnipresent assistant won’t just help us write, it will become the author while we, the humans, merely click “send.”

Paul Rust is a research fellow at Brainstorm: The Stanford Lab for Mental Health Innovation, and a doctoral candidate in theoretical medicine at University Witten/Herdecke in Germany. Nina Vasan is the founder and director of Stanford Brainstorm and chief medical officer of Silicon Valley Executive Psychiatry. They can be reached at

• Tác giả từng chỉ dùng NotebookLM (AI nghiên cứu cá nhân hóa của Google) vì đáp ứng đầy đủ nhu cầu học tập và báo chí, nhưng nhận ra sai lầm khi bỏ qua các công cụ AI khác.

• Kết hợp NotebookLM với Perplexity giúp tìm nguồn đáng tin cực nhanh. Perplexity được dùng chủ yếu để tìm và liệt kê nguồn từ tab Sources thay vì câu trả lời, tiết kiệm hàng giờ tìm kiếm thủ công.

• Quy trình: tìm nguồn với Perplexity → nhập vào NotebookLM → dùng NotebookLM phân tích và tóm tắt, đặc biệt với tính năng Audio Overviews, biến thời gian di chuyển thành giờ học hiệu quả.

• Mind Maps của NotebookLM trực quan hóa mối liên hệ giữa các nguồn (cả nguồn cá nhân và nguồn mới từ Perplexity), giúp nhận diện khoảng trống kiến thức.

• ChatGPT đóng vai trò mở rộng phạm vi, trả lời các câu hỏi ngoài dữ liệu NotebookLM, cung cấp ví dụ thực tế, giải thích bổ sung và kết nối với chủ đề khác.

• Study Mode mới của ChatGPT biến nội dung NotebookLM thành bài giảng tương tác, quiz, và hướng dẫn từng bước, giúp nắm chắc kiến thức.

• Bộ ba này tạo quy trình liền mạch: Perplexity (tìm nguồn) → NotebookLM (hiểu nội dung) → ChatGPT (mở rộng & đào sâu).

• Tác giả từng thử kết hợp NotebookLM với nhiều công cụ khác (Slack, Google Docs, Excel) nhưng chưa bộ đôi nào mạnh bằng bộ ba này.

📌 Sự kết hợp NotebookLM, Perplexity và ChatGPT giúp tối ưu học tập và nghiên cứu: tìm nguồn nhanh, phân tích sâu, và mở rộng kiến thức không giới hạn. Với Audio Overviews, Mind Maps và Study Mode, bộ ba này không chỉ tiết kiệm hàng giờ làm việc mà còn nâng hiệu quả tiếp thu thông tin lên mức tối đa.

https://www.xda-developers.com/paired-notebooklm-with-chatgpt-and-perplexity/

-

Đặt câu hỏi như người thật

Perplexity hiểu ngôn ngữ tự nhiên. Thay vì dùng từ khóa khô khan, hãy đặt câu hỏi đầy đủ như: “Những đột phá mới nhất về công nghệ pin xe điện là gì?” -

Lựa chọn nguồn tìm kiếm phù hợp

-

Web (mặc định): dùng cho tin tức phổ thông, blog công nghệ, báo chí.

-

Academic sources: phù hợp với tài liệu khoa học, nghiên cứu chuyên sâu.

-

Social sources: truy cập diễn đàn, mạng xã hội, đánh giá người dùng.

-

Finance sources: tìm hiểu thông tin tài chính, đầu tư, xu hướng thị trường.

-

-

Sử dụng tính năng theo chuỗi hội thoại

Sau khi có kết quả, bạn có thể tiếp tục hỏi: “Công nghệ anode silicon ảnh hưởng thế nào đến thời gian sạc?”, và Perplexity sẽ ghi nhớ ngữ cảnh để trả lời chính xác hơn. -

Kiểm tra nguồn trích dẫn

Mỗi thông tin đều có kèm liên kết nguồn cụ thể. Bạn có thể nhấp vào số dẫn để xem bài gốc, từ đó kiểm chứng độ tin cậy. -

Tận dụng Pro Searches miễn phí mỗi ngày

Khi bật biểu tượng vòng lặp “X”, Perplexity sẽ dùng AI tiên tiến nhất để trả lời chi tiết hơn. Nên dùng khi cần phân tích chuyên sâu, ví dụ: “So sánh chi phí dài hạn của pin lithium-ion và solid-state”. -

Đặt câu hỏi cụ thể thay vì mơ hồ

Thay vì “pin EV”, hãy hỏi “những phương pháp tái chế pin EV hiệu quả nhất năm 2025”. Điều này giúp Perplexity cung cấp thông tin chính xác hơn. -

Tận dụng tính năng Discover và Spaces

-

Discover: tập hợp tin tức và thông tin mới nhất.

-

Spaces: lưu và tổ chức chuỗi tìm kiếm theo chủ đề, ví dụ như “du lịch châu Âu”, “tài chính cá nhân”...

-

-

Sử dụng các tính năng miễn phí một cách chiến lược

Các bộ lọc nguồn, follow-up liên tục và số lượt Pro Search mỗi ngày là công cụ mạnh nếu dùng đúng lúc đúng chỗ. -

Cân nhắc nâng cấp lên gói Pro ($20/tháng)

Gói trả phí mở khóa thêm: tìm kiếm nâng cao không giới hạn, tải lên tệp & hình ảnh, nhiều nguồn hơn và trải nghiệm mượt mà hơn.

📌 9 mẹo trên sẽ giúp bạn sử dụng Perplexity AI như một chuyên gia: từ việc đặt câu hỏi đúng cách, chọn nguồn phù hợp đến tận dụng Pro Search hiệu quả. Dù dùng bản miễn phí hay trả phí, bạn đều có thể truy xuất thông tin chính xác, có dẫn nguồn và tiết kiệm thời gian đáng kể.

https://www.fastcompany.com/91367673/perplexity-tips

-

Nick Turley, người đứng đầu ChatGPT tại OpenAI, chia sẻ mẹo yêu thích là sử dụng tính năng giọng nói vào mỗi buổi sáng trên đường đi làm. Anh dùng ChatGPT để diễn đạt và sắp xếp lại suy nghĩ, tạo ra danh sách việc cần làm ngay khi đến nơi.

-

Dù tính năng voice còn một số trục trặc nhỏ, Turley cho rằng việc nói ra suy nghĩ giúp định hình tư duy tốt hơn và mong muốn tính năng này được cải thiện trong năm sau.

-

Mark Chen, giám đốc nghiên cứu tại OpenAI, tiết lộ anh yêu thích tính năng nghiên cứu sâu (deep research). Anh dùng ChatGPT để "preflight" – tìm hiểu trước về người sắp gặp mặt, đặc biệt là trong các buổi thảo luận về AI.

-

ChatGPT giúp Chen nắm bắt bối cảnh, điểm chung và gợi ý các chủ đề có thể cùng quan tâm với người đối thoại.

-

Andrew Mayne, cựu chuyên gia truyền thông khoa học tại OpenAI, sử dụng ChatGPT để gợi ý món ăn khi đi nhà hàng. Anh chụp ảnh thực đơn và nhờ ChatGPT lập kế hoạch bữa ăn phù hợp với chế độ ăn kiêng.

-

Tuy nhiên, Mayne và Turley cảnh báo không nên dùng ChatGPT để chọn rượu, vì ChatGPT đôi khi tạo ra tên rượu không có thật, gây lúng túng khi gọi món.

-

CEO OpenAI, Sam Altman, tiết lộ trong podcast tháng 1 và tháng 6 rằng ông dùng ChatGPT để xử lý email, tóm tắt tài liệu và gần đây còn dùng để nghiên cứu các giai đoạn phát triển của trẻ nhỏ, hỗ trợ trong vai trò làm cha.

-

Altman thừa nhận việc chăm con trước đây không cần AI, nhưng giờ đây ông "không biết mình xoay sở ra sao nếu không có ChatGPT".

📌 ChatGPT được nhân viên OpenAI tận dụng trong nhiều tình huống đời thường: sắp xếp suy nghĩ buổi sáng, nghiên cứu đối tác gặp gỡ, và chọn món ăn theo chế độ. Tính năng voice giúp tổ chức việc cần làm, tính năng nghiên cứu sâu hỗ trợ giao tiếp, còn tính năng phân tích hình ảnh thực đơn giúp ăn uống thông minh. Sam Altman cũng dùng ChatGPT như một công cụ thiết yếu cho công việc và vai trò làm cha.

https://www.businessinsider.com/openai-employees-sam-altman-share-3-favorite-tips-chatgpt-2025-7

OpenAI employees share their 3 favorite tips for using ChatGPT

- OpenAI employees spoke about how they use ChatGPT during a recent podcast episode.

- They said the technology is useful on their morning commutes and at restaurants.

- Sam Altman has said he uses ChatGPT in "boring ways," and recently shared he leans on it as a dad.

-

Hơn 400 triệu người dùng ChatGPT mỗi tuần, nhưng nhiều người không khai thác hết tiềm năng của nó khi brainstorming do prompt quá đơn giản.

-

Theo nghiên cứu của Wharton School, các ý tưởng do ChatGPT tạo ra thường giống nhau đến 21%, ví dụ với đề bài sáng tạo từ vợt tennis và ống nước, nhiều gợi ý đều chỉ là biến thể của vòi tưới cây.

-

5 bước để brainstorm hiệu quả hơn với ChatGPT:

-

Rõ ràng và cụ thể:

-

Yêu cầu các ý tưởng phải đa dạng về hình thức, lĩnh vực hoặc khu vực địa lý.

-

Ví dụ: “Đưa ra 10 địa điểm du lịch hè ở các vùng khác nhau của Mỹ”.

-

-

Sử dụng chuỗi tư duy (chain-of-thought prompts):

-

Yêu cầu AI tạo ý tưởng, rồi kết hợp, làm táo bạo hơn, sau đó tinh chỉnh lại.

-

Hoặc để AI hỏi ngược bạn như: “Bạn mong muốn kết quả gì?”

-

-

Nhập vai (role-playing):

-

Giao cho ChatGPT vai trò như “chuyên gia du lịch” hoặc “phụ huynh 12 tuổi”.

-

Tạo bối cảnh cụ thể để AI sáng tạo theo nhu cầu sát thực tế hơn.

-

-

Kiểm định và phản biện ý tưởng:

-

Gửi cho AI danh sách ý tưởng rồi yêu cầu chọn top theo tiêu chí cụ thể.

-

Kêu gọi AI đóng vai nhà phê bình, nhìn từ góc độ người dùng và nhà đầu tư.

-

-

Xác minh và quyết định cuối cùng:

-

Người dùng phải là người chịu trách nhiệm lựa chọn cuối cùng.

-

AI chỉ hỗ trợ “đốt cháy giai đoạn nhàm chán”, còn ý tưởng đột phá vẫn do con người chọn lọc.

-

📌 Brainstorm với ChatGPT hiệu quả hơn bằng cách đặt câu hỏi rõ ràng, nhập vai sáng tạo, và yêu cầu AI phản biện hoặc đánh giá ý tưởng theo tiêu chí cụ thể. Đừng chỉ dừng ở prompt đơn giản – hãy “chơi đùa” với AI để khai thác sức mạnh sáng tạo thực sự. Nhưng nhớ rằng, bạn mới là người quyết định cuối cùng, không phải AI.

https://www.washingtonpost.com/business/2025/06/13/ai-chatgpt-brainstorm/

How to better brainstorm with ChatGPT in five steps

-

Bối cảnh năm 2025: Doanh nghiệp đang "ngộp thở" giữa vô số công cụ AI, đòi hỏi một bản đồ rõ ràng để chọn đúng mô hình phù hợp với từng nhiệm vụ.

-

OpenAI (GPT-4o, GPT-4.1, o-series):

-

GPT-4o: đa năng, nhanh, hỗ trợ đa phương thức (text, ảnh, âm thanh), phù hợp với sáng tạo nội dung, phân tích phản hồi khách hàng.

-

GPT-4.1: xử lý văn bản lớn (1 triệu tokens), phù hợp với phân tích tài liệu đồ sộ.

-

o3, o4-mini: mạnh về suy luận, phù hợp với mã hóa, toán học, hỗ trợ kỹ thuật cao.

-

-

Google Gemini (2.5 Pro, 2.5 Flash, Gemma 3):

-

Tập trung vào khả năng đa phương thức và ngữ cảnh mở rộng.

-

2.5 Pro: giỏi phân tích dữ liệu phức tạp, mã hóa nâng cao.

-

2.5 Flash: tốc độ cao, tiết kiệm chi phí.

-

Gemma: nguồn mở, hỗ trợ các nhà phát triển cá nhân hóa AI.

-

-

Anthropic Claude (Claude 4 Opus, Sonnet):

-

Đề cao sự an toàn, chính xác, minh bạch.

-

Claude 4 Opus: mã hóa chính xác, xử lý tài liệu pháp lý dài.

-

Sonnet: cân bằng giữa hiệu năng và chi phí.

-

-

Meta Llama 4 (Maverick, Scout):

-

Hướng đến cộng đồng mã nguồn mở, cho phép tuỳ biến sâu.

-

Maverick: sáng tạo nội dung cao, hội thoại tự nhiên.

-

Scout: xử lý ngữ cảnh siêu lớn (10 triệu tokens).

-

-

Chuyên biệt khác:

-

DeepSeek: giỏi mã hóa và toán học, tối ưu chi phí.

-

Grok (xAI): truy cập thông tin thời gian thực từ nền tảng X.

-

-

Khung lựa chọn AI:

-

Bắt đầu từ vấn đề doanh nghiệp.

-

Chọn theo tính cách nhiệm vụ: sáng tạo vs. logic.

-

Xem xét vai trò đội nhóm: marketing, tài chính, kỹ thuật.

-

Sử dụng nền tảng đa mô hình như Magai để linh hoạt hơn.

-

📌 Với sự xuất hiện của các "Titan AI" như GPT-4o, Gemini 2.5, Claude 4 và Llama 4, doanh nghiệp năm 2025 có thể chọn lựa dựa trên nhiệm vụ: sáng tạo (GPT-4o, Maverick), phân tích logic (Claude 4, o3), xử lý đa phương thức (Gemini), hoặc tùy biến sâu (Llama Scout). Việc lựa chọn đúng mô hình theo H.U.M.A.N. framework sẽ giúp tăng hiệu suất và giảm rủi ro công nghệ.

https://theaihat.com/a-field-guide-to-the-2025-ai-titans-choosing-the-right-ai-model-for-your-business/

-

-

Hiểu sự giao thoa giữa xu hướng và ngành nghề của bạn: Không cần chạy theo mọi công nghệ mới, điều quan trọng là nhận diện AI đang ảnh hưởng thế nào đến ngành, cách ra quyết định và kỳ vọng của đội nhóm đối với lãnh đạo.

-

Thực hành trực tiếp với AI: Hướng dẫn sử dụng các công cụ AI trong công việc hằng ngày giúp làm quen và xóa bỏ sự sợ hãi công nghệ.

-

Bắt đầu từ tư duy phát triển và kiến thức nền tảng: Xác định lý do học AI, phát triển tư duy học tập liên tục, chọn nguồn học phù hợp và áp dụng vào thực tế.

-

Tham gia mô phỏng tình huống thực tế với AI: Đặt mình vào các tình huống "giả lập" để huấn luyện khả năng phản ứng, thích nghi và ra quyết định trong môi trường bị AI thay đổi.

-

Dành thời gian cố định mỗi tuần cập nhật tin tức AI: Thiết lập thói quen học hỏi định kỳ để theo kịp sự phát triển nhanh chóng của công nghệ.

-

Tập trung vào nội dung AI liên quan trực tiếp đến công việc: Chọn lọc các lớp học, hội thảo phù hợp với ngành nghề thay vì theo xu hướng chung.

-

Xem học AI là một phần của phát triển nghề nghiệp liên tục (CPD): Đưa AI vào kế hoạch đào tạo bắt buộc hàng năm để đảm bảo năng lực số luôn được cập nhật.

-

Tập trung vào ứng dụng thực tế thay vì từ khóa hot: Hiểu rõ AI dùng để làm gì, không cần hiểu sâu thuật toán mà cần nắm được khả năng áp dụng cụ thể.

-

Thử nghiệm AI với các nhiệm vụ rủi ro thấp: Bắt đầu từ những việc bạn có chuyên môn để dễ dàng phát hiện lỗi AI và xây dựng niềm tin sử dụng công nghệ.

-

Dạy lại người khác về AI để hiểu sâu hơn: Tạo nhóm học nhỏ, sử dụng ngôn ngữ đơn giản và ví dụ dễ hiểu để truyền đạt lại cho đồng nghiệp hoặc gia đình.

-

Tìm các vấn đề hằng ngày mà AI có thể giải quyết: Giới thiệu AI thông qua giải pháp thực tế như tự động hóa báo cáo, lọc khách hàng tiềm năng... để thấy lợi ích rõ rệt.

-

Sử dụng AI trong khuôn khổ hướng dẫn của công ty: Bắt đầu từ những ứng dụng cơ bản như chỉnh sửa văn bản, đồng thời kiểm tra chính sách bảo mật, công cụ được phép dùng.

-

Tìm hiểu chất lượng dữ liệu và thiên lệch trong AI: Hiểu nguồn dữ liệu và cách AI xử lý thông tin giúp tránh rủi ro và dùng AI có đạo đức, hiệu quả hơn.

-

Nhìn AI như công cụ giải quyết vấn đề, không phải mục tiêu học: Phân tích bài toán bạn đang gặp và tìm hiểu AI có thể hỗ trợ ở đâu, thay vì học AI một cách trừu tượng.

-

Đầu tư học các khóa AI cơ bản chuyên biệt theo ngành nghề: Tận dụng các khóa học miễn phí hoặc có phí, tìm hiểu AI áp dụng cụ thể vào công việc hiện tại.

-

Áp dụng tư duy “AI đồng hành” thay vì “AI thay thế”: Xem AI là bạn đồng hành trong suy nghĩ và ra quyết định, luyện tập với các thử thách thực tế hàng tuần để cải thiện khả năng tương tác với AI.

-

📌 Với 16 chiến lược từ các chuyên gia Forbes, mọi chuyên gia có thể xây dựng hiểu biết về AI thông qua thực hành, đào tạo ngành nghề, mô phỏng thực tế và áp dụng tư duy AI đồng hành. Từ việc dạy người khác đến thử nghiệm tác vụ đơn giản, đây là lộ trình thiết thực để duy trì sự cạnh tranh và hiệu quả trong thời đại AI đang phát triển chóng mặt.

https://www.forbes.com/councils/forbescoachescouncil/2025/05/30/how-to-build-ai-literacy-16-ways-to-stay-relevant-as-a-professional/

-

OpenAI đăng tải tài liệu "ChatGPT Enterprise - Models & Limits" ngày 03.05.2025 nhằm giải thích sự khác biệt và hướng dẫn chọn model ChatGPT phù hợp, không chỉ cho doanh nghiệp mà áp dụng cho mọi người dùng.

-

ChatGPT hiện cung cấp 5 model chính: GPT-4o, o3, o4-mini, o4-mini-high và GPT-4.5; người dùng ChatGPT Plus (20 USD/tháng, khoảng 500.000 VNĐ) mới được tùy chọn model.

-

GPT-4o là model "omni" đa năng, cập nhật thông tin thời gian thực, tối ưu cho tóm tắt nội dung, gợi ý ý tưởng, soạn email; hỗ trợ đầy đủ tính năng: tạo GPT tùy chỉnh, sinh ảnh, canvas, audio nâng cao, phân tích dữ liệu.

-

GPT-4.5 nổi bật về sáng tạo, giao tiếp cảm xúc tốt hơn, thích hợp cho các ý tưởng sáng tạo, yêu cầu độ linh hoạt, cảm xúc và giao tiếp cao cấp, sáng tạo nội dung.

-

o4-mini tối ưu cho tác vụ kỹ thuật nhanh: câu hỏi STEM, lập trình, suy luận hình ảnh nhanh.

-

o4-mini-high dành cho các tác vụ kỹ thuật chuyên sâu: mã hóa nâng cao, toán học, giải thích khoa học, cần độ chính xác cao hơn.

-

Model o3 được khuyên dùng cho các nhiệm vụ phức tạp, đa bước: lập kế hoạch chiến lược, phân tích chuyên sâu, mã hóa chuyên biệt, toán học/phân tích nâng cao, và suy luận hình ảnh chuyên sâu.

-

Tài liệu phân tích rõ ràng các ưu thế, điểm mạnh của từng model, giúp người dùng lựa chọn chính xác dựa trên nhu cầu công việc cụ thể.

📌 Lời khuyên của OpenAI giúp người dùng tiết kiệm chi phí khi chọn đúng model ChatGPT: GPT-4o đa năng, GPT-4.5 mạnh về sáng tạo, o4-mini và o4-mini-high chuyên về kỹ thuật, o3 cho phân tích sâu – tối ưu hóa trải nghiệm AI tạo sinh với 20 USD/tháng.

https://www.bleepingcomputer.com/news/artificial-intelligence/openai-document-explains-when-to-use-each-chatgpt-model/

-

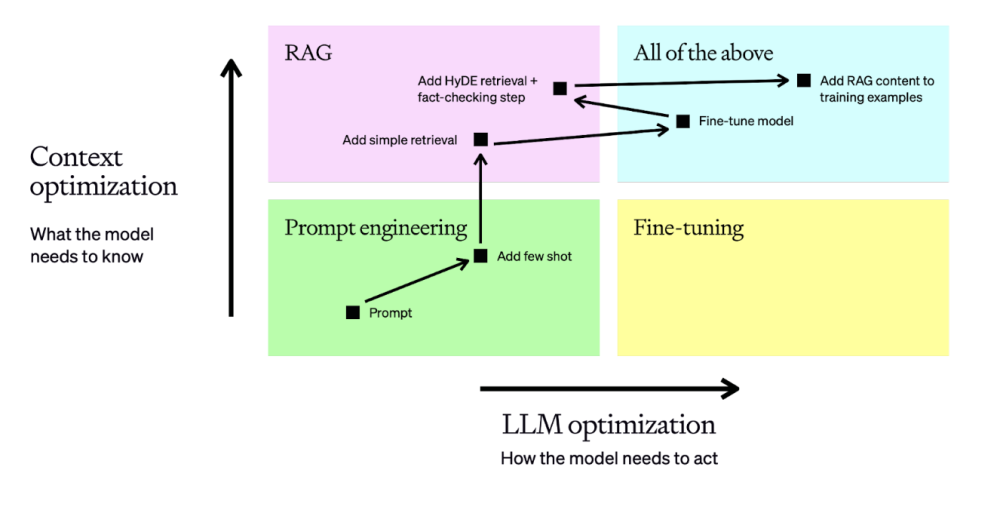

Tác động của AI tạo sinh khiến các nhà quản lý sản phẩm cân nhắc lại cách lựa chọn mô hình phù hợp (LLM, ML truyền thống hay rule-based).

-

Quyết định có nên dùng AI cần dựa trên đánh giá cụ thể về:

-

Đầu vào và đầu ra của nhu cầu khách hàng, ví dụ đầu vào là sở thích bài hát và đầu ra là playlist tùy chỉnh như Spotify.

-

Số lượng tổ hợp đầu vào-đầu ra: càng nhiều trường hợp khác biệt ở quy mô lớn thì càng cần ML, ngược lại tác vụ lặp lại đơn giản có thể dùng hệ thống luật.

-

Mức độ phát hiện được pattern giữa đầu vào-đầu ra: Nếu có pattern, nên xem xét supervised/semi-supervised ML, tiết kiệm hơn LLM; nếu không có pattern, hoặc yêu cầu đầu ra mở rộng, có thể dùng LLM.

-

Chi phí và độ chính xác: LLM tốn kém khi mở rộng, đầu ra đôi khi không chính xác dù có fine-tuning/prompt engineering; mô hình supervised cổ điển, network classifier hoặc rule-based phù hợp hơn nếu cần đầu ra chính xác, định sẵn.

-

-

Bảng tổng kết các trường hợp sử dụng:

-

Tác vụ lặp lại, đầu ra giống nhau cho cùng đầu vào: không cần ML, chỉ dùng rule-based.

-

Tác vụ lặp lại, đầu ra khác nhau cho cùng đầu vào: nên dùng LLM tạo sinh (ví dụ tạo ảnh, đề xuất mới).

-

Tác vụ lặp lại, đầu ra tương tự cho nhiều đầu vào: cân nhắc giữa rule-based và classifier/topic modelling, tùy mức độ phức tạp và có pattern hay không.

-

Tác vụ lặp lại, đầu ra khác nhau cho đầu vào khác nhau: ML hoặc LLM gần như là bắt buộc, vì số tổ hợp lớn (hỗ trợ khách hàng, tìm kiếm…).

-

Tác vụ không lặp lại, đầu ra mở rộng: LLM là lựa chọn phù hợp (phân tích review, dự đoán văn bản).

-

-

Khuyến nghị: Luôn đánh giá kỹ nhu cầu, chi phí và độ chính xác sản phẩm trước khi quyết định dùng AI tạo sinh (LLM), tránh lạm dụng cho bài toán đơn giản.

📌 Framework chỉ ra: Chỉ nên dùng LLM khi tổ hợp đầu vào-đầu ra phức tạp, khó pattern, hoặc yêu cầu đầu ra sáng tạo. Nhiều tác vụ vẫn phù hợp với rule-based hoặc ML truyền thống để tiết kiệm chi phí và đạt độ chính xác cao hơn.

https://venturebeat.com/ai/not-everything-needs-an-llm-a-framework-for-evaluating-when-ai-makes-sense/

-

Nghiên cứu cho thấy nhân hóa (anthropomorphism) – mức độ chatbot AI giống con người – có ảnh hưởng lớn hơn cả lòng tin trong quyết định thuê chatbot làm việc số như CPA ảo (chuyên viên thuế).

-

Trong một thí nghiệm, người tham gia chọn giữa CPA là người thật và một avatar AI. Mặc dù lòng tin vào người thật cao hơn, nhưng yếu tố ảnh hưởng mạnh nhất đến quyết định thuê chính là cảm giác AI có "giống người" hay không.

-

AI được nhân hóa càng giống con người thì càng dễ được tin tưởng và thuê, bất chấp thực tế AI không có trách nhiệm pháp lý như con người. Điều này cho thấy cảm giác quen thuộc đóng vai trò cực kỳ quan trọng.

-

Nghiên cứu này phân biệt rõ "lòng tin" (trust) và "mất lòng tin" (distrust) là hai khái niệm độc lập, không nằm trên cùng một trục. Lòng tin tăng khả năng thuê, còn mất lòng tin lại liên quan đến cảm giác xấu hổ khi chia sẻ thông tin nhạy cảm.

-

Trong thí nghiệm, các đối tượng phải thuê một chuyên gia kê khai thuế sau khi mất 60.000 USD trên thị trường chứng khoán. Họ xem video về CPA là người thật hoặc avatar AI, rồi đánh giá theo thang đo về lòng tin, nhân hóa, trí tuệ AI và cảm giác xấu hổ khi chia sẻ thông tin.

-

Kết quả: người tham gia đánh giá avatar AI thấp hơn về mức độ nhân hóa (trung bình 4.42 so với 5.15) và trí tuệ (5.35 so với 5.61). Họ cũng ít muốn thuê AI hơn (4.22 so với 4.77), dù mức độ xấu hổ không chênh lệch rõ rệt (3.33 so với 3.20).

-

Dữ liệu phân tích bằng mô hình CBSEM cho thấy: nhân hóa có ảnh hưởng lớn nhất đến ý định thuê (hệ số β cao gấp đôi trust), trong khi mất lòng tin có ảnh hưởng rất lớn đến cảm giác xấu hổ (f2 = .316, R2inc = 0.240).

-

Loại bỏ đường dẫn từ distrust đến embarrassment khiến trust trở thành yếu tố có ý nghĩa thống kê, nhưng sức ảnh hưởng của mô hình giảm đáng kể (R2 chỉ còn 0.10). Điều này chứng minh rằng distrust là yếu tố riêng biệt và mạnh mẽ.

-

Việc tương tác với AI không tự động làm tăng hoặc giảm lòng tin, mà là do người dùng cảm nhận AI ít giống người, nên ít tin hơn và ít muốn thuê.

-

Kết quả nhấn mạnh vai trò trung tâm của việc thiết kế AI giống người hơn – từ biểu cảm, giọng nói đến cử chỉ – để tăng cường khả năng được tin tưởng và sử dụng.

-

Thống kê mẫu nghiên cứu: 781 người Mỹ tham gia, cân bằng theo giới tính, độ tuổi và chủng tộc. Trình độ học vấn từ dưới phổ thông đến tiến sĩ. Cả hai giới tính đều có xu hướng ít thuê AI hơn, với giới tính ảnh hưởng rõ (β = -.086).

📌Nghiên cứu cho thấy nhân hóa AI ảnh hưởng mạnh hơn cả lòng tin trong quyết định thuê chatbot làm việc số, đặc biệt khi so sánh giữa CPA là người thật và avatar AI. Distrust không chỉ là thiếu trust, mà là yếu tố cảm xúc riêng biệt – ảnh hưởng lớn đến việc chia sẻ thông tin nhạy cảm. AI càng giống người thì càng dễ được tin và thuê, bất chấp việc không có trách nhiệm pháp lý như con người.

https://cacm.acm.org/research/the-importance-of-distrust-in-trusting-digital-worker-chatbots/

-

Chúng ta đang bước vào kỷ nguyên "nền kinh tế know-how" nơi kiến thức thực tiễn về AI được chia sẻ, token hóa và giao dịch như một tài sản có giá trị.

-

Mặc dù đầu tư vào AI đang tăng mạnh trên toàn cầu, nhưng lợi nhuận thực tế chưa tương xứng với kỳ vọng do thiếu kiến thức thực tiễn để chuyển đổi công cụ AI thành giá trị kinh tế.

-

Hiện có hơn 50.000 giải pháp AI đang hoạt động, tốc độ phát triển công nghệ vượt xa tốc độ học hỏi của doanh nghiệp và nhân viên về cách sử dụng hiệu quả.

-

Nhiều công ty đang đầu tư hàng triệu đô vào năng lực AI nhưng gặp khó khăn trong việc chuyển đổi thành lợi nhuận thực tế, thiếu những ứng dụng thực tế cụ thể.

-

Savion Ray, một công ty truyền thông châu Âu, đã giảm 96% thời gian nghiên cứu thị trường và cắt giảm thời gian chỉnh sửa video từ 8 giờ xuống dưới 1 giờ, tăng cơ sở khách hàng từ 15 lên 25 mà không cần tuyển thêm nhân viên.

-

Waku, một startup hàng tiêu dùng ở New York với 5 nhân viên, đã biến AI thành "đồng nghiệp thứ 6", tự động hóa các nhiệm vụ CFO, nghiên cứu, email và bài thuyết trình.

-

Yum Bakery tại Canada sử dụng Claude để dự báo nhu cầu và tối ưu hóa theo dõi hàng tồn kho, tiết kiệm 50 giờ mỗi chu kỳ, giảm lãng phí và đảm bảo các thỏa thuận nhà cung cấp tốt hơn.

-

TRN, một mạng lưới tuyển dụng toàn cầu tại Anh, đã sử dụng AI để phân tích hoạt động của thành viên, tăng tỷ lệ mở email bằng cách điều chỉnh nội dung theo nhu cầu người dùng thời gian thực.

-

Chia sẻ kiến thức AI không chỉ thúc đẩy việc áp dụng mà còn tạo ra sân chơi bình đẳng bằng cách biến know-how thành tài nguyên có thể chia sẻ, điều chỉnh và giao dịch.

-

Báo cáo 2025 của LinkedIn nhấn mạnh 39% lãnh đạo ưu tiên kỹ năng mềm như khả năng thích ứng cùng với kiến thức AI, đảm bảo lợi ích AI vượt ra ngoài giới hạn của các chuyên gia kỹ thuật.

-

Goldman Sachs ước tính đầu tư AI toàn cầu có thể đạt gần 200 tỷ đô la trong năm nay, nhưng mắt xích còn thiếu là lớp kiến thức thực tiễn AI - cầu nối giữa khả năng công nghệ tiên tiến và tác động kinh tế rộng rãi.

📌 Kiến thức thực tiễn về AI đang trở thành tài sản có giá trị trong nền kinh tế mới. Với hơn 50.000 giải pháp AI hiện có và dự báo đóng góp 13 nghìn tỷ đô la vào GDP toàn cầu đến năm 2030, việc chia sẻ và thương mại hóa AI know-how là chìa khóa để biến tiềm năng thành lợi nhuận thực tế.

https://www.weforum.org/stories/2025/03/ai-know-how-final-piece-of-the-adoption-puzzle/

#WEF

-

Tác giả bài viết từng hoài nghi về AI tạo sinh, cho rằng công nghệ này bị thổi phồng quá mức và không thực sự hiệu quả khi sử dụng cho công việc nghiêm túc.

-

Vào đầu năm 2023, ChatGPT bắt đầu phát triển mạnh mẽ, nhưng tác giả đã phản đối vì thấy nó chỉ là "một khái niệm tồi được nhồi nhét vào mọi thứ".

-

Các vụ sa thải nhân viên do các giám đốc điều hành thích ý tưởng thay thế con người bằng robot không đáng tin cậy đã gây tổn hại cho nhiều người lao động và doanh nghiệp.

-

Cuối năm 2023, tác giả mô tả Microsoft Copilot AI chatbot như "một người kể chuyện - một động cơ sáng tạo hỗn loạn bị ép vào vai trò trợ lý ảo nghiêm túc, với những đường nối luôn hiện rõ".

-

Đến năm 2025, công cụ AI tạo sinh thực sự có thể hữu ích, nhưng chỉ khi sử dụng đúng cách, và tác giả đã tìm ra bí quyết.

-

Bí quyết: Để có kết quả tốt nhất từ AI tạo sinh, bạn phải "bộc lộ đối thoại nội tâm" của mình. Mô hình AI hoạt động tốt nhất khi được cung cấp nhiều thông tin và ngữ cảnh.

-

Khác với Google yêu cầu truy vấn ngắn gọn, AI tạo sinh cần nhiều chi tiết. Nếu bắt đầu cuộc trò chuyện với một câu hỏi đơn, bạn sẽ không nhận được phản hồi sâu sắc.

-

Thay vì đặt câu hỏi, bạn nên suy nghĩ thành tiếng, lặp lại với một chút qua lại, cung cấp nhiều chi tiết, xem hệ thống nói gì, rồi chọn điều thú vị để đào sâu.

-

Tác giả gợi ý thử nghiệm bằng cách sử dụng nút microphone trong ứng dụng ChatGPT trên điện thoại để nói chuyện theo kiểu dòng ý thức, không cần chỉnh sửa.

-

AI tạo sinh không đưa ra quyết định, bạn mới là người quyết định. Bạn thể hiện gu thẩm mỹ và có thể đẩy AI theo hướng này hay hướng khác để có ý tưởng.

-

AI tạo sinh không nên thay thế suy nghĩ mà là công cụ khám phá khái niệm và kết nối giữa chúng, giúp viết email tốt hơn hoặc lập kế hoạch marketing.

-

AI có thể ảo giác và bịa ra thông tin, vì vậy bạn cần giữ não bộ hoạt động. Nếu sử dụng AI tạo sinh, hãy cố gắng sử dụng nó để trở nên người hơn, không phải ít người hơn.

-

Các công ty đang quảng bá công cụ AI tạo sinh đang bán cho bạn thứ sai lầm. Cách họ nói về công nghệ không phải cách bạn nên sử dụng nó.

-

AI tạo sinh nên được coi là đối tác brainstorming, không phải công cụ tìm kiếm. Nó là một công cụ trong bộ công cụ của bạn, không phải câu trả lời cuối cùng.

📌 AI tạo sinh năm 2025 đã tiến bộ vượt bậc nhưng cần được sử dụng đúng cách thông qua đối thoại nội tâm và tương tác qua lại. Thay vì đặt câu hỏi ngắn gọn, người dùng nên "nói chuyện thoải mái" với AI, cung cấp nhiều ngữ cảnh để nhận được kết quả tốt nhất, biến AI thành đối tác sáng tạo thay vì công cụ tìm kiếm đơn thuần.

https://www.computerworld.com/article/3853747/the-secret-to-using-generative-ai-effectively.html

-

Tác giả cho rằng các công cụ AI miễn phí hiện nay đã đủ khả năng đáp ứng nhu cầu của hầu hết người dùng thông thường.

-

So sánh giữa phiên bản miễn phí và trả phí của các công cụ AI phổ biến như ChatGPT, Gemini, Microsoft Copilot:

-

Phiên bản miễn phí thường có giới hạn về tính năng và thời gian sử dụng

-

Phiên bản trả phí cung cấp quyền truy cập vào các mô hình AI tiên tiến hơn và các tính năng nâng cao

-

Lý do tác giả chỉ sử dụng công cụ AI miễn phí:

-

Chi phí cao: ChatGPT Plus, Microsoft Copilot Pro và Google One AI Premium Plan đều có giá 20 USD/tháng

-

Chất lượng phản hồi vẫn phụ thuộc nhiều vào kỹ năng viết prompt của người dùng

-

Các mô hình trả phí vẫn có thể đưa ra câu trả lời không chính xác, ví dụ GPT-4.5 vẫn có 37% khả năng bị ảo giác

-

Một số lưu ý khi sử dụng công cụ AI:

-

Thử nghiệm nhiều công cụ khác nhau để chọn ra câu trả lời phù hợp nhất

-

Cải thiện kỹ năng viết prompt để tăng chất lượng phản hồi

-

Kiểm tra tính chính xác của thông tin nhận được

-

Các tính năng cao cấp thường sẽ được tích hợp vào phiên bản miễn phí sau một thời gian, ví dụ như GPT-4 hiện đã có sẵn trong ChatGPT miễn phí

📌 Công cụ AI miễn phí ngày càng mạnh mẽ, đáp ứng được nhu cầu của đa số người dùng. Chỉ cần 20 USD/tháng cho phiên bản trả phí, nhưng vẫn cần kỹ năng viết prompt tốt và kiểm tra độ chính xác. Nên dùng thử nhiều công cụ miễn phí trước khi quyết định trả phí.

https://www.makeuseof.com/free-vs-paid-ai-tools-why-i-never-pay-for-ai/

7 mẹo sử dụng ChatGPT để tối đa hóa năng suất – cách thử ngay

Tính năng nổi bật

Tác giả: Amanda Caswell

Công bố: 2 ngày trước

ChatGPT đã cách mạng hóa cách chúng ta tiếp cận AI, giúp tích hợp liền mạch vào các công việc hàng ngày để tăng cường hiệu suất và hiệu quả. Từ việc tóm tắt hướng dẫn sử dụng thiết bị gia dụng đến cung cấp lời khuyên để bắt đầu một ngày mới, ChatGPT đã chứng minh sự đa năng của mình.

Dưới đây là 7 mẹo và chiến lược yêu thích mà bạn có thể áp dụng để khai thác tối đa tiềm năng của ChatGPT, từ cách làm chủ câu lệnh, sử dụng hướng dẫn tùy chỉnh cho đến việc quản lý bộ nhớ.

1. Trò chuyện tạm thời cho thông tin nhạy cảm

Nếu bạn cần thực hiện một truy vấn mà không muốn nó được lưu trong lịch sử trò chuyện, hãy sử dụng tính năng trò chuyện tạm thời của ChatGPT.

Ví dụ: Nếu bạn muốn tìm kiếm các mẹo chọn nhẫn đính hôn hay ý tưởng cho Ngày lễ tình nhân và không muốn người khác biết, tính năng này sẽ đảm bảo các cuộc trò chuyện không được lưu trữ, duy trì sự riêng tư và bảo mật.

2. Nhanh chóng truy xuất các cuộc trò chuyện trước đó

Để tìm lại các truy vấn trước đây, bạn có thể sử dụng thanh tìm kiếm hoặc các phím tắt. Nhập từ khóa hoặc cụm từ mà bạn nhớ, ChatGPT sẽ tìm kiếm trong tất cả các cuộc trò chuyện trước đó của bạn dựa trên từ khóa.

Nếu không tìm thấy, có thể bạn đã đăng nhập bằng một email khác hoặc sử dụng chế độ tìm kiếm tạm thời.

3. Làm chủ các phím tắt

Sử dụng các phím tắt giúp tăng tốc thao tác và cải thiện hiệu quả làm việc:

- Command Shift C: Sao chép phản hồi gần nhất.

- Command Shift O: Mở một cuộc trò chuyện mới.

- Command Shift S: Bật hoặc tắt thanh bên.

- Command Shift I: Truy cập hướng dẫn tùy chỉnh.

- / (dấu gạch chéo): Hiển thị danh sách hành động trong cuộc trò chuyện.

4. Tận dụng tính năng tìm kiếm nâng cao

Tính năng tìm kiếm nâng cao của ChatGPT cho phép bạn:

- Xem nhiều hình ảnh liên quan đến truy vấn.

- Truy cập nguồn có thể nhấp để có thêm thông tin.

- Thảo luận thêm về các kết quả tìm kiếm.

Khi cần thông tin chính xác và toàn diện theo thời gian thực, bạn có thể yêu cầu ChatGPT sử dụng tìm kiếm trực tiếp trên web.

5. Quản lý bộ nhớ để cá nhân hóa tương tác

ChatGPT có thể nhớ các thông tin về bạn để cá nhân hóa câu trả lời. Tuy nhiên, nếu bạn không muốn ChatGPT nhớ, bạn có thể xóa bộ nhớ của nó:

- Cài đặt > Cá nhân hóa > Quản lý bộ nhớ.

Ngoài ra, bạn có thể yêu cầu ChatGPT nhớ các thông tin cụ thể bằng cách nói "Hãy nhớ điều này cho các lần trò chuyện sau."

6. Tùy chỉnh hành vi của ChatGPT với hướng dẫn cá nhân

Người dùng ChatGPT Plus có thể cung cấp các hướng dẫn tùy chỉnh, giúp ChatGPT trả lời theo cách bạn muốn. Tùy chỉnh này tạo ra trải nghiệm sử dụng nhất quán và phù hợp hơn.

Đồng thời, bạn có thể kiểm soát thông tin cá nhân của mình bằng cách tắt tính năng sử dụng nội dung của bạn cho việc huấn luyện mô hình trong phần cài đặt dữ liệu.

7. Lưu trữ trò chuyện để quản lý lịch sử gọn gàng

Tính năng lưu trữ cho phép bạn:

- Dọn dẹp giao diện chính bằng cách di chuyển các cuộc trò chuyện không cần thiết ra khỏi lịch sử chính.

- Các cuộc trò chuyện đã lưu trữ vẫn có thể được tìm kiếm và tham chiếu khi cần thiết.

Đây là một cách hiệu quả để giữ giao diện gọn gàng nhưng vẫn giữ thông tin cần thiết trong tầm tay.

Mẹo bổ sung: Nâng cấp hình ảnh ngay trong ChatGPT

ChatGPT có khả năng xử lý hình ảnh. Bạn có thể cải thiện nội dung hình ảnh bằng cách sử dụng thư viện Python Pillow để chỉnh sửa, nâng cấp và tinh chỉnh các yếu tố trong ảnh một cách nhanh chóng mà không cần rời khỏi nền tảng. Điều này rất hữu ích cho các nhiệm vụ yêu cầu chỉnh sửa hình ảnh nhanh chóng.

ChatGPT không chỉ là một công cụ trò chuyện mà còn là một trợ lý mạnh mẽ giúp tăng năng suất. Với các mẹo trên, bạn có thể sử dụng ChatGPT một cách hiệu quả nhất để hỗ trợ công việc và cuộc sống hàng ngày.

https://www.tomsguide.com/ai/chatgpt/7-chatgpt-hacks-to-maximize-your-productivity-heres-how-to-try-them

- Nick Turley, giám đốc sản phẩm OpenAI, chia sẻ 5 mẹo quan trọng giúp người dùng tối ưu trải nghiệm với ChatGPT trong podcast "Hard Fork"

- Mẹo 1 - Sử dụng chế độ giọng nói:

* Có 9 giọng nói người thật được thu âm bởi diễn viên chuyên nghiệp

* Người dùng có thể tương tác bằng giọng nói thay vì gõ phím

* Chế độ nâng cao chỉ dành cho người dùng Plus và Team

- Mẹo 2 - Kích hoạt tính năng ghi nhớ:

* ChatGPT có thể lưu trữ thông tin cá nhân, công việc, sở thích của người dùng

* Người dùng có thể tắt hoặc xóa bộ nhớ bất cứ lúc nào

* Giúp cải thiện độ chính xác trong các phản hồi

- Mẹo 3 - Tạo GPT cá nhân:

* Không cần kiến thức lập trình

* Tùy chỉnh theo nhu cầu cụ thể như học ngôn ngữ, phân tích dữ liệu

* Có thể tích hợp DALL-E để tạo hình ảnh

* Lựa chọn chế độ riêng tư hoặc chia sẻ công khai

- Mẹo 4 - Tải lên và xử lý tài liệu:

* Hỗ trợ nhiều định dạng văn bản, bảng tính, thuyết trình

* Tự động phân tích, tóm tắt và trích xuất thông tin

* Chỉ dành cho người dùng Plus và Enterprise

- Mẹo 5 - Kết hợp văn bản và hình ảnh:

* Tích hợp DALL-E để tạo hình ảnh từ hội thoại

* ChatGPT có khả năng hiểu và diễn giải hình ảnh

* Cho phép kết hợp linh hoạt giữa nội dung văn bản và hình ảnh

📌 Giám đốc sản phẩm OpenAI giới thiệu 5 tính năng mạnh mẽ của ChatGPT: chế độ giọng nói với 9 giọng đọc, khả năng ghi nhớ thông tin, tạo GPT cá nhân không cần lập trình, xử lý tài liệu đa dạng và tích hợp công nghệ DALL-E để xử lý hình ảnh.

https://www.businessinsider.com/openai-head-of-product-shares-5-tips-for-using-chatgpt-2024-11

• Quy tắc 5:55 là phương pháp tận dụng ChatGPT trong khung giờ hiệu quả nhất, bắt đầu từ 5 giờ sáng (giờ máy chủ) khi chất lượng phản hồi đạt đỉnh

• Phân tích cho thấy các ưu điểm vào thời điểm 5 giờ sáng:

- Tải máy chủ thấp hơn 70%

- Chất lượng phản hồi cao hơn 23%

- Tốc độ xử lý nhanh hơn 45%

- Tỷ lệ lỗi giảm 60%

• Hệ thống gồm 3 giai đoạn:

- 5:00-5:55 sáng: Tập trung tạo nội dung, lập trình, phân tích

- 2:00-2:55 chiều: Tối ưu và cải thiện kết quả buổi sáng

- 8:00-8:55 tối: Nhân rộng kết quả qua phân phối và tự động hóa

• 5 nguồn thu nhập chính:

- Tạo nội dung: 100-150 USD/ngày

- Hỗ trợ lập trình: 80-120 USD/ngày

- Dịch vụ kinh doanh: 60-100 USD/ngày

- Dịch vụ sáng tạo: 40-80 USD/ngày

- Nội dung giáo dục: 40-70 USD/ngày

• Chiến lược triển khai trong 3 tuần:

- Tuần 1: Xây dựng nền tảng

- Tuần 2: Tối ưu hóa quy trình

- Tuần 3: Mở rộng quy mô

• Yếu tố then chốt để thành công:

- Tuân thủ chính xác thời gian

- Kỹ thuật viết prompt hiệu quả

- Kiểm soát chất lượng đầu ra

📌 Quy tắc 5:55 không chỉ là việc sử dụng ChatGPT đúng giờ mà là hệ thống toàn diện tạo thu nhập ổn định từ AI. Với 3 khung giờ vàng và 5 nguồn thu, người dùng có thể kiếm trung bình 300 USD (7,3 triệu đồng) mỗi ngày khi áp dụng đúng phương pháp.

https://cabanacatalogs.com/555-rule-how-regular-people-are-making-300-day-using-chatgpt/

• Người dùng ChatGPT Plus có thể tạo file PowerPoint trực tiếp trong chat bằng công cụ phân tích dữ liệu, tài khoản miễn phí bị giới hạn truy cập

• Phương pháp 1: Tạo file PPT từ nội dung slide và ghi chú người thuyết trình

- Yêu cầu ChatGPT tạo dàn ý với chi tiết và điểm chính cho mỗi slide

- Mở rộng chi tiết các điểm chính nếu cần

- Tạo ghi chú thuyết trình chi tiết

- Chuyển đổi dàn ý thành file PowerPoint

- Tải và chỉnh sửa file trong PowerPoint

• Phương pháp 2: Tạo code VBA cho PowerPoint

- Phù hợp với tài khoản miễn phí đã hết giới hạn sử dụng

- Tạo dàn ý và ghi chú thuyết trình

- Yêu cầu ChatGPT viết code VBA

- Chạy code trong PowerPoint để tạo slide

• Phương pháp 3: Tóm tắt tài liệu có sẵn

- Tải lên file Word hoặc PDF (dưới 512MB)

- ChatGPT tạo dàn ý thuyết trình từ nội dung file

- Tạo ghi chú và file PowerPoint từ dàn ý

• Phương pháp 4: Sử dụng GPT tùy chỉnh

- Dùng Presentation and Slides GPT tích hợp với SlidesGPT

- Tự động tạo slide với hình ảnh, biểu tượng và ghi chú

- Có thể tải ảnh từng slide miễn phí

- Cần đăng ký Pro để tải file có thể chỉnh sửa

📌 ChatGPT cung cấp 4 phương pháp linh hoạt để tạo bài thuyết trình PowerPoint, từ tạo trực tiếp đến dùng code VBA và tích hợp SlidesGPT. Người dùng Plus có nhiều tính năng hơn, trong khi tài khoản miễn phí bị giới hạn nhưng vẫn có thể tạo slide hiệu quả.

https://www.slashgear.com/1707490/chatgpt-create-powerpoint-presentation/

- Nén mô hình là một giải pháp quan trọng để cải thiện hiệu suất và giảm chi phí cho các ứng dụng AI trong bối cảnh ngày càng phức tạp.

- Các doanh nghiệp phải đối mặt với những thách thức như độ trễ, mức tiêu thụ bộ nhớ và chi phí tính toán khi triển khai mô hình AI.

- Các mô hình lớn như LLMs và mạng nơ-ron sâu thường yêu cầu tài nguyên tính toán đáng kể, làm tăng chi phí vận hành.

- Việc sử dụng các kỹ thuật nén mô hình giúp giảm kích thước và yêu cầu tính toán của mô hình mà không làm giảm hiệu suất.

- 3 kỹ thuật nén chính được đề cập là:

- Cắt tỉa mô hình (Model Pruning): Giảm kích thước mô hình bằng cách loại bỏ các tham số không quan trọng, dẫn đến giảm thời gian suy diễn và mức tiêu thụ bộ nhớ.

- Lượng tử hóa (Quantization): Giảm độ chính xác của các số liệu mô hình từ 32-bit xuống 8-bit, giảm kích thước bộ nhớ và tăng tốc độ suy diễn.

- Chưng cất tri thức (Knowledge Distillation): Đào tạo một mô hình nhỏ hơn để bắt chước hành vi của một mô hình lớn hơn, giúp chuyển giao hiệu suất mà không cần nhiều tài nguyên tính toán.

- Các mô hình nén có thể thực hiện dự đoán nhanh hơn, giúp cải thiện trải nghiệm người dùng trong các ứng dụng thời gian thực, như xác minh danh tính tại sân bay.

- Nén mô hình không chỉ giúp tiết kiệm chi phí mà còn giảm mức tiêu thụ năng lượng, góp phần vào mục tiêu bền vững môi trường.

- Mô hình nén cho phép doanh nghiệp triển khai AI trên các thiết bị biên, như điện thoại thông minh, mà vẫn duy trì hiệu suất cao.

- Việc áp dụng các kỹ thuật này giúp doanh nghiệp giảm sự phụ thuộc vào phần cứng đắt đỏ và tăng cường khả năng cạnh tranh trên thị trường.

📌 Doanh nghiệp có thể cải thiện hiệu suất AI và giảm chi phí bằng cách áp dụng các kỹ thuật nén như cắt tỉa, lượng tử hóa và chưng cất tri thức, giúp tiết kiệm tài nguyên và nâng cao trải nghiệm người dùng.

https://venturebeat.com/ai/here-are-3-critical-llm-compression-strategies-to-supercharge-ai-performance/

1. Định dạng nội dung để trả lời các câu hỏi cụ thể, tập trung vào việc xây dựng uy tín từ các nguồn đáng tin cậy

2. Phân tích xu hướng tìm kiếm tổng hợp và mô hình để tối ưu nội dung theo ý định tìm kiếm

3. Xác định từ khóa liên quan và mô hình hành vi người dùng để tạo nội dung chất lượng cao

4. Xây dựng chiến lược SEO xoay quanh các công cụ tìm kiếm tạo sinh mới nổi

5. Sử dụng AI để phân tích nội dung do con người viết thay vì tạo nội dung hoàn toàn bằng AI

6. Cập nhật dữ liệu quan trọng theo thời gian thực

7. Tối ưu hóa nội dung cho tìm kiếm bằng giọng nói

8. Sử dụng AI để điền vào các khoảng trống mà con người bỏ sót

9. Sử dụng AI để soạn thảo nội dung chất lượng cao có mục tiêu

10. Tận dụng AI để tìm các lĩnh vực cần cải thiện

11. Tự động hóa cá nhân hóa nội dung

12. Khai thác các chủ đề đang thịnh hành

13. Tự động tạo thẻ meta và mô tả động

14. Tập trung vào các yếu tố cơ bản của SEO

15. Tương tác với AI trong một cuộc đối thoại mang tính xây dựng

16. Dự báo xu hướng tìm kiếm và hiệu suất từ khóa trong tương lai

17. Xác định các chủ đề nội dung tốt dựa trên từ khóa phổ biến

18. Trao đổi trực tiếp với khách hàng để hiểu cách họ mô tả vấn đề

📌 18 chiến lược từ Forbes Technology Council nhấn mạnh sự cân bằng giữa công nghệ AI và yếu tố con người trong SEO. Các chuyên gia khuyến nghị tập trung vào nội dung chất lượng cao, tối ưu tìm kiếm bằng giọng nói và phân tích dữ liệu thời gian thực để cải thiện hiệu quả SEO.

https://www.forbes.com/councils/forbestechcouncil/2024/11/06/how-to-optimize-seo-in-the-ai-age/

• Mô hình AI suy luận o1 đại diện cho bước tiến quan trọng trong lĩnh vực trí tuệ nhân tạo, với khả năng vượt trội hơn các chuyên gia trong việc giải quyết các vấn đề phức tạp.

• Llama 3.1 Nemotron do NVIDIA phát triển là giải pháp nguồn mở thay thế cho các mô hình độc quyền như GPD 40 và Gemini 1.5 Pro.

• Kỹ thuật Chain of Thought prompting giúp AI phân tích vấn đề phức tạp thành các bước nhỏ hơn, mô phỏng quá trình tư duy của con người.

• Các thách thức chính khi phát triển mô hình o1:

- Yêu cầu tài nguyên tính toán cao

- Lo ngại về bảo mật dữ liệu

- Kiến trúc mô hình và quá trình đào tạo phức tạp.

• Quy trình xây dựng mô hình o1:

- Thiết lập môi trường và cài đặt phần mềm cần thiết

- Triển khai hệ thống bằng lệnh terminal và lập trình Python

- Tạo framework đa tác tử AI chuyên biệt

- Tích hợp kỹ thuật Chain of Thought

- Kiểm thử và tinh chỉnh liên tục.

• Tối ưu hóa mô hình thông qua:

- Lưu kết quả dưới dạng file văn bản để dễ dàng xem xét

- Điều chỉnh thông số cân bằng tốc độ và độ chính xác

- Cập nhật dữ liệu và cải tiến thường xuyên

- Theo dõi các chỉ số hiệu suất.

📌 Mô hình AI suy luận o1 cục bộ sử dụng Llama 3.1 Nemotron của NVIDIA là giải pháp nguồn mở hiệu quả, giúp người dùng tiết kiệm chi phí tính toán và đảm bảo quyền riêng tư. Kỹ thuật Chain of Thought cho phép AI xử lý thông tin theo cách tương tự con người, nâng cao khả năng suy luận và giải quyết vấn đề phức tạp.

https://www.geeky-gadgets.com/how-to-build-and-optimize-your-o1-ai-model/

- Custom GPTs là phiên bản tùy chỉnh của ChatGPT, được thiết kế chuyên biệt cho từng nhiệm vụ cụ thể, giúp hợp nhất nhiều công việc trên một nền tảng duy nhất, tăng hiệu quả và giảm thời gian chuyển đổi giữa các ứng dụng khác nhau.

- Người dùng có thể truy cập Custom GPTs thông qua gói ChatGPT Plus bằng cách gọi tên chúng qua ký hiệu "@", sau đó lưu vào thanh công cụ để sử dụng nhanh hơn.

- StratGPT giúp lập kế hoạch hàng ngày hiệu quả, chia thời gian thành các khối công việc hợp lý và đưa ra đề xuất về thời gian nghỉ. Ví dụ: bắt đầu ngày làm việc với cuộc họp lúc 9 giờ sáng, hoàn thành dự án lúc 1 giờ chiều và xen kẽ thời gian nghỉ.

- Research Assistant GPT hỗ trợ tìm kiếm và tóm tắt thông tin nhanh chóng, giúp người dùng so sánh các công cụ hoặc tìm hiểu xu hướng mới mà không cần mất thời gian tìm kiếm thủ công.

- Excel Formula Generator GPT là công cụ tối ưu cho những ai không quen thuộc với công thức Excel. Người dùng có thể tải lên dữ liệu mẫu và yêu cầu GPT tạo ra các công thức cần thiết, chẳng hạn như tính phần trăm hoặc tham chiếu ô.

- Report Writer GPT giúp tạo báo cáo nhanh chóng bằng cách nhận dữ liệu từ tệp CSV hoặc văn bản dán vào chat, đặc biệt hữu ích khi làm việc với lượng dữ liệu lớn. Người dùng có thể tinh chỉnh báo cáo để phù hợp với từng đối tượng nhận.

- Email and Mail Writer GPT hỗ trợ soạn thảo email chuyên nghiệp từ những bản nháp cơ bản. Ví dụ, người dùng có thể yêu cầu GPT tóm tắt nội dung chính của báo cáo và đề xuất các bước tiếp theo trong email gửi cho quản lý.

📌

Custom GPTs là giải pháp tối ưu cho quản lý công việc hàng ngày, tích hợp nhiều chức năng như lập kế hoạch, nghiên cứu, xử lý dữ liệu và soạn thảo email. Những công cụ này giúp tiết kiệm thời gian và tăng năng suất, cho phép người dùng tập trung vào những nhiệm vụ quan trọng mà không bị phân tâm bởi các chi tiết nhỏ.

https://www.makeuseof.com/build-a-team-of-ai-assistants-with-custom-gpts/

• NotebookLM là công cụ giúp bạn hiểu sâu hơn về bất kỳ chủ đề nào bạn đang làm việc.

• Steven Johnson, tác giả nhiều cuốn sách về khoa học tư duy và lịch sử đổi mới, đã tham gia vào dự án NotebookLM từ đầu cách đây 2 năm.

• NotebookLM cho phép tạo các sổ tay riêng biệt cho từng chủ đề hoặc dự án. Bạn có thể tải lên tối đa 50 "nguồn" với tổng cộng 25 triệu từ từ PDF, Google Docs, trang web và video YouTube.

• Công cụ này sử dụng khả năng đa phương thức của Gemini 1.5 để đánh giá và kết nối các nguồn bạn đã thêm vào.

• Bạn có thể đặt câu hỏi về nội dung hoặc yêu cầu NotebookLM định dạng theo cách cụ thể, kèm theo trích dẫn liên kết đến các đoạn gốc liên quan nhất.

• Thông tin cá nhân của bạn không bao giờ được chia sẻ hoặc sử dụng để huấn luyện mô hình.

• 8 mẹo sử dụng NotebookLM hiệu quả từ Steven Johnson:

1. Thử nghiệm với các tài liệu gần đây, ngay cả khi chúng không liên quan.

2. Tạo một sổ tay chính và từ đó xác định các sổ tay theo chủ đề.

3. Sử dụng NotebookLM để kết nối thông tin từ các nguồn khác nhau.

4. Bắt đầu với các câu hỏi gợi ý.

5. Yêu cầu NotebookLM trình bày thông tin theo nhiều cách khác nhau.

6. Không ngại thử nghiệm các ứng dụng sáng tạo.

7. Chuyển đổi nguồn của bạn thành Audio Overviews.

8. Xem lại các phiên trò chuyện NotebookLM của bạn.

• NotebookLM có thể chuyển đổi nội dung tải lên thành FAQ, tài liệu tóm tắt, dòng thời gian, mục lục, hướng dẫn học tập hoặc Audio Overview.

• Công cụ này hữu ích cho cả công việc, học tập và các dự án sáng tạo như viết tiểu thuyết hay phát triển trò chơi.

• Tính năng Audio Overview mới cho phép điều chỉnh định dạng cuộc trò chuyện và tập trung vào các khía cạnh cụ thể của nguồn tài liệu.

📌 NotebookLM là trợ lý AI đa năng giúp tổng hợp và phân tích thông tin từ nhiều nguồn. Với khả năng xử lý 25 triệu từ, 50 nguồn tài liệu đa dạng và các tính năng như Audio Overview, NotebookLM hỗ trợ hiệu quả cho nghiên cứu, học tập và sáng tạo.

https://blog.google/technology/ai/notebooklm-beginner-tips/

• ChatGPT đang được các nhà văn chuyên nghiệp sử dụng như một công cụ để mở rộng khả năng sáng tạo của họ, không phải để thay thế việc viết.

• Phản hồi biên tập: David Cornue, một biên kịch, sử dụng ChatGPT như một phòng viết kịch 24/7 để nhận phản hồi biên tập. Anh yêu cầu ChatGPT đóng vai trò nhà biên kịch kỳ cựu để đưa ra nhận xét về các bản thảo và đề cương của mình.

• Tìm từ: Farhad Manjoo, cựu phóng viên New York Times, sử dụng ChatGPT để "tìm từ". Thay vì tra cứu từ điển hoặc Google, anh nhờ ChatGPT gợi ý từ ngữ chính xác và ẩn dụ phù hợp.

• Phỏng vấn ngược: Stew Fortier, nhà văn và doanh nhân, áp dụng kỹ thuật "phỏng vấn ngược" với ChatGPT. Anh yêu cầu ChatGPT đặt câu hỏi để khai thác ý tưởng và thúc đẩy suy nghĩ sáng tạo của mình.

• Viết hài: Sarah Rose Siskind, biên kịch hài kịch, sử dụng ChatGPT để nghiên cứu bối cảnh cho các câu chuyện cười. Cô yêu cầu ChatGPT cung cấp thông tin về các chủ đề cụ thể để tìm ý tưởng cho phần mở đầu, sau đó tự viết phần kết thúc hài hước.

• Nghiên cứu và xây dựng thế giới: Elle Griffin, tiểu thuyết gia, sử dụng ChatGPT để nghiên cứu và xây dựng thế giới trong tác phẩm. ChatGPT giúp cô tìm kiếm thông tin nhanh chóng và khám phá những kết nối bất ngờ cho cốt truyện.

• Các tác giả nhấn mạnh rằng họ vẫn là người kiểm soát quá trình sáng tạo, sử dụng ChatGPT như một công cụ hỗ trợ chứ không phải để thay thế việc viết của họ.

• ChatGPT được ví như một cộng tác viên sáng tạo luôn sẵn sàng, giúp các nhà văn vượt qua tình trạng bế tắc ý tưởng và tập trung vào phần sáng tạo thú vị nhất của quá trình viết.

• Các tác giả khuyến khích sử dụng ChatGPT một cách có chủ đích, đặt ra ranh giới rõ ràng để đảm bảo giữ được tiếng nói và phong cách riêng của mình.

📌 ChatGPT đang trở thành trợ lý đắc lực cho các nhà văn chuyên nghiệp, hỗ trợ họ trong nhiều khía cạnh của quá trình sáng tạo như nhận phản hồi, tìm từ, nghiên cứu và phát triển ý tưởng. Tuy nhiên, các tác giả vẫn giữ vai trò chủ đạo, sử dụng AI như một công cụ để nâng cao năng suất và sáng tạo của mình.

https://openai.com/chatgpt/use-cases/writing-with-ai/

• Tài liệu nội bộ của Amazon cung cấp hướng dẫn cho nhân viên bán hàng AWS về cách trả lời câu hỏi liên quan đến OpenAI và các đối thủ AI khác.

• Tài liệu nêu ra 9 yếu tố quan trọng nhất mà khách hàng cân nhắc khi mua mô hình và dịch vụ AI tạo sinh:

- Khả năng tùy chỉnh: có thể điều chỉnh mô hình AI cho các yêu cầu cụ thể

- Cá nhân hóa: sử dụng dữ liệu nội bộ của công ty để tạo ra kết quả AI phù hợp hơn

- Độ chính xác: mức độ phù hợp của kết quả tạo ra với mục tiêu mong muốn

- Bảo mật: các biện pháp bảo vệ dữ liệu và quyền riêng tư

- Giám sát: khả năng phát hiện các vấn đề như độ lệch, thiên vị hoặc suy giảm chất lượng đầu ra

- Chi phí: tổng chi phí bao gồm đầu tư ban đầu và chi phí liên tục

- Dễ sử dụng: khả năng sử dụng, tích hợp và hỗ trợ của mô hình

- AI có trách nhiệm: tuân thủ các hướng dẫn đạo đức, giải quyết thiên vị, giải thích kết quả

- Đổi mới: vị thế của nhà cung cấp dịch vụ như một nhà đổi mới so với các đối thủ khác

• AWS tập trung vào việc bán các mô hình nền tảng và cơ sở hạ tầng đám mây cần thiết để xây dựng dịch vụ AI, thay vì tập trung vào chatbot AI phổ biến.

• Tài liệu nêu bật các "Đề xuất Giá trị" của AWS như dễ dàng xây dựng và tùy chỉnh AI, bảo mật mạnh mẽ, cơ sở hạ tầng hiệu quả về giá, chip AI riêng và các ứng dụng AI như Amazon Q.

• AWS khẳng định họ là nhà cung cấp đám mây hàng đầu với nhiều dịch vụ AI tạo sinh nhất, với doanh thu hàng tỷ đô la từ các dịch vụ AI.

• Công ty coi đây là giai đoạn đầu của AI tạo sinh và trang bị cho đội ngũ bán hàng thông tin để giúp khách hàng hiểu tại sao AWS là nơi tốt nhất để xây dựng ứng dụng AI tạo sinh.

📌 Amazon tiết lộ 9 yếu tố then chốt khách hàng cân nhắc khi mua AI, tập trung vào cơ sở hạ tầng đám mây và mô hình nền tảng thay vì chatbot. AWS khẳng định vị thế dẫn đầu với nhiều dịch vụ AI tạo sinh nhất, doanh thu hàng tỷ đô la từ AI.

https://www.businessinsider.com/amazon-l-9-factors-customers-consider-before-buying-ai-aws-2024-8

- AI tạo sinh đang giúp các tổ chức thực hiện nhiều công việc hơn trong thời gian ngắn hơn, nhờ vào việc áp dụng một tâm thế tò mò và cởi mở.

- Clara Shih, CEO của Salesforce AI, nhấn mạnh rằng việc áp dụng tư duy phát triển là cách tốt nhất để các doanh nghiệp đối phó với sự thay đổi nhanh chóng do AI tạo sinh mang lại.

- Lareina Yee từ McKinsey đã thảo luận với Clara về sức mạnh biến đổi của AI tạo sinh trong việc tăng tốc quy trình làm việc và tầm quan trọng của quản lý thay đổi.

- Clara cho biết, một trong những điểm mạnh lớn nhất của các mô hình ngôn ngữ lớn là khả năng phân tích và tổng hợp dữ liệu phi cấu trúc, giúp khai thác tối đa thông tin từ internet và dữ liệu nội bộ của công ty.

- Dữ liệu phi cấu trúc, như video, biên bản cuộc gọi và email, chỉ chiếm chưa đến 20% dữ liệu mà các công ty có thể khai thác.

- Clara sử dụng AI tạo sinh hàng ngày để tóm tắt và tổng hợp thông tin từ các podcast và tài liệu nghiên cứu, giúp tiết kiệm thời gian.

- Các mô hình ngôn ngữ lớn giúp giảm thời gian giải quyết vấn đề của khách hàng từ 10 đến 20%, cải thiện hiệu suất làm việc.

- Clara nhấn mạnh rằng không phải lúc nào các công ty cũng cần sử dụng các mô hình tiên tiến nhất như GPT-4, mà có thể điều chỉnh các mô hình nhỏ hơn và hiệu quả hơn.

- Quá trình triển khai AI trong doanh nghiệp thường bắt đầu từ việc chứng minh các trường hợp sử dụng đầu tiên và tìm kiếm lợi tức đầu tư (ROI).

- Clara cho rằng việc quản lý thay đổi là thách thức lớn hơn so với công nghệ, vì mọi nhân viên đều cần phải học cách sử dụng AI để làm việc hiệu quả hơn.

- Cô cũng cảnh báo về các rủi ro liên quan đến AI, bao gồm quyền riêng tư dữ liệu, thông tin sai lệch, phân biệt đối xử và sự thay thế công việc.

- Clara kêu gọi các tổ chức phải chuẩn bị cho sự thay đổi trong mô hình công việc, nơi con người và AI sẽ làm việc cùng nhau để tối ưu hóa quy trình.

📌 AI tạo sinh đang thay đổi cách thức làm việc, giúp tăng tốc quy trình và tối ưu hóa hiệu suất. Clara Shih từ Salesforce nhấn mạnh rằng việc khai thác dữ liệu phi cấu trúc và quản lý thay đổi là chìa khóa để thành công trong kỷ nguyên AI.

https://www.mckinsey.com/capabilities/mckinsey-digital/our-insights/approaching-generative-ai-with-a-beginners-mindset

#McKinsey

• Bài viết giới thiệu cách triển khai kiến trúc mô hình ngôn ngữ liên kết, trong đó một agent gửi truy vấn của người dùng cùng với các công cụ có sẵn đến một LLM trên cloud để ánh xạ prompt thành các hàm và đối số.

• Các thành phần chính được sử dụng bao gồm:

- OpenAI GPT-4 Omni làm LLM trên cloud

- Microsoft Phi-3 làm SLM ở edge

- Ollama làm công cụ suy luận cho Phi-3

- Nvidia Jetson AGX Orin làm thiết bị edge để chạy Ollama

- Cơ sở dữ liệu MySQL và máy chủ API Flask chạy cục bộ

- Chroma làm kho vector cục bộ để tìm kiếm ngữ nghĩa

• Các bước triển khai:

1. Chạy Ollama trên Jetson Orin

2. Chạy MySQL DB và máy chủ API Flask

3. Tạo chỉ mục cho PDF và đưa embedding vào Chroma DB

4. Chạy agent mô hình ngôn ngữ liên bang

• Agent sẽ gửi truy vấn và danh sách công cụ đến GPT-4 trên cloud để ánh xạ thành các hàm và đối số.

• Nếu có công cụ phù hợp, agent sẽ thực thi các hàm để tạo ngữ cảnh từ cơ sở dữ liệu. Nếu không, nó sẽ sử dụng tìm kiếm ngữ nghĩa trong Chroma DB.

• Ngữ cảnh thu được sẽ được gửi đến SLM ở edge (Phi-3) để tạo ra câu trả lời chính xác về mặt thực tế.

• Mã nguồn và hướng dẫn chi tiết được cung cấp để triển khai từng bước của kiến trúc này.

• Phương pháp này tận dụng khả năng của LLM trên cloud để xử lý truy vấn phức tạp, đồng thời sử dụng SLM ở edge để tạo ra câu trả lời cuối cùng, giúp bảo vệ dữ liệu nhạy cảm.

📌 Kiến trúc mô hình ngôn ngữ federated kết hợp LLM trên cloud (GPT-4) và SLM ở edge (Phi-3) để xử lý truy vấn hiệu quả. Agent điều phối luồng dữ liệu giữa cloud và edge, sử dụng công cụ cục bộ hoặc tìm kiếm ngữ nghĩa để tạo ngữ cảnh, đảm bảo câu trả lời chính xác và bảo mật.

https://thenewstack.io/how-to-run-an-agent-on-federated-language-model-architecture/

• Salesforce chỉ ra 4 yếu tố quan trọng giúp doanh nghiệp tận dụng tối đa cuộc cách mạng AI tạo sinh:

- Có nhà cung cấp AI đáng tin cậy

- Xây dựng nền tảng dữ liệu vững chắc

- Quy trình làm việc khuyến khích thử nghiệm

- Linh hoạt nâng cấp mô hình AI

• 77% doanh nhân toàn cầu lo sợ bỏ lỡ cơ hội từ AI tạo sinh. Năm 2023, họ đã chi 16 tỷ USD cho công nghệ này và dự kiến tăng lên 140 tỷ USD vào năm 2027.

• Chỉ 10% số người hoàn toàn tin tưởng AI giúp ra quyết định, 56% người dùng gặp khó khăn trong việc có được kết quả đáng tin cậy từ AI tạo sinh.

• 80% khách hàng cho rằng việc con người xác thực kết quả AI là quan trọng. Hơn 50% nói họ sẽ tin tưởng AI hơn nếu biết kết quả đã được con người xác nhận.

• 82% nhân viên cho rằng cải thiện độ chính xác và bảo mật dữ liệu sẽ tăng niềm tin vào hệ thống AI. 53% sẽ tin tưởng hơn vào mô hình AI được đào tạo bằng dữ liệu độc quyền của công ty.

• Chỉ 41% tổ chức có chiến lược dữ liệu thống nhất. 95% lãnh đạo IT cho biết vấn đề tích hợp dữ liệu cản trở việc áp dụng AI.

• Chỉ 21% công ty có chính sách AI, dẫn đến 55% nhân viên sử dụng công cụ AI tạo sinh không được phê duyệt tại nơi làm việc.

• Doanh nghiệp nên ưu tiên các giải pháp turnkey để nhân viên dễ dàng thử nghiệm AI trong môi trường rủi ro thấp.

• 80% lãnh đạo IT doanh nghiệp đang sử dụng nhiều mô hình AI, 69% dự định thêm mô hình mới trong tương lai gần.

• Salesforce khuyên doanh nghiệp nên thử nghiệm và phân tích các tiêu chuẩn đánh giá để chọn mô hình AI phù hợp nhất.

📌 Salesforce nhấn mạnh 4 yếu tố then chốt giúp doanh nghiệp thành công với AI: xây dựng lòng tin, nền tảng dữ liệu vững chắc, khuyến khích thử nghiệm và linh hoạt với mô hình mới. 77% doanh nhân lo bỏ lỡ AI, chi tiêu dự kiến tăng từ 16 tỷ USD (2023) lên 140 tỷ USD (2027).

https://www.inc.com/ben-sherry/4-keys-to-enterprise-ai-success-according-to-salesforce.html

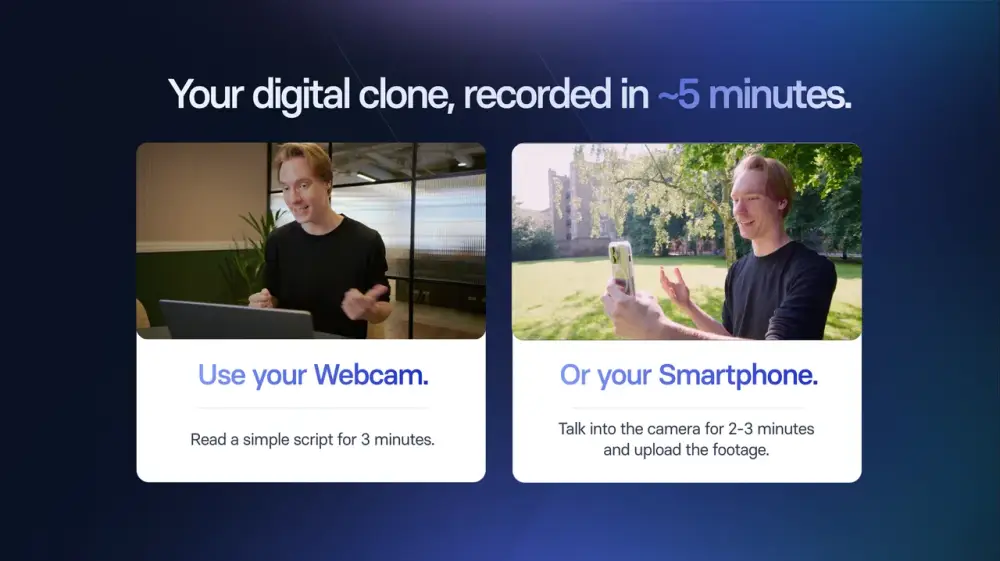

• Synthesia vừa công bố tính năng Personal Avatars, cho phép người dùng tạo bản sao kỹ thuật số của chính mình chỉ trong vài phút.

• Để tạo avatar, người dùng cần quay 2 phút video bằng điện thoại hoặc webcam, sau đó tải lên và đồng ý cho Synthesia sử dụng hình ảnh để tạo AI.

• Avatar AI có thể nói hơn 30 ngôn ngữ, bất kể người dùng có biết ngôn ngữ đó hay không. Nó sử dụng giọng nói được nhân bản từ giọng của chủ nhân.

• Công nghệ auto alignment giúp avatar có cử chỉ, ngôn ngữ cơ thể phù hợp với nội dung đang nói.

• Synthesia mã hóa dữ liệu để bảo vệ avatar khỏi bị lạm dụng, chỉ tạo avatar khi có sự đồng ý rõ ràng và xóa dữ liệu khi người dùng yêu cầu.

• Tính năng này có thể ứng dụng trong nhiều lĩnh vực như tạo nội dung, đào tạo, quảng cáo, truyền thông nội bộ doanh nghiệp...

• Personal Avatars hiện có sẵn cho người dùng các gói Starter, Creator và Enterprise của Synthesia.

• Đây là bước tiếp theo sau khi Synthesia ra mắt nền tảng tạo video AI toàn diện Synthesia 2.0 vào tháng trước.

• Mục tiêu của Synthesia là "mở rộng ranh giới của giao tiếp kỹ thuật số" bằng cách tạo ra nội dung cá nhân hóa, chân thực.

• Công nghệ này có thể giúp tạo ra các video đào tạo, hướng dẫn, quảng cáo... một cách nhanh chóng và tiết kiệm chi phí.

• Tuy nhiên, việc sử dụng avatar AI cũng đặt ra những lo ngại về quyền riêng tư và khả năng lạm dụng công nghệ này.

📌 Synthesia giới thiệu tính năng Personal Avatars, cho phép tạo bản sao kỹ thuật số nói được 30 ngôn ngữ chỉ từ 2 phút video. Công nghệ này mở ra khả năng tạo nội dung cá nhân hóa nhanh chóng, tiết kiệm chi phí trong nhiều lĩnh vực, nhưng cũng đặt ra thách thức về bảo mật và đạo đức.

https://www.zdnet.com/article/clone-yourself-with-these-personal-ai-avatars/

• Namelix: Công cụ AI tạo tên thương hiệu ngắn gọn, dễ nhớ. Học từ sở thích của bạn để đưa ra gợi ý tốt hơn theo thời gian. Có thể tìm kiếm tên miền và tạo logo tức thì.

• Figma: Công cụ thiết kế hàng đầu cho phép các nhóm thiết kế và phát triển cùng làm việc. Cung cấp thiết kế UI đơn giản được tạo bởi AI, cho phép lặp lại nhanh chóng và chỉnh sửa hàng loạt nhiều khung hình.

• Shopify: Nền tảng thương mại điện tử số 1, hỗ trợ doanh nghiệp mọi quy mô. Có trình tạo cửa hàng kéo thả không cần code, mẫu tùy chỉnh và nhiều ứng dụng để khởi động, vận hành và phát triển cửa hàng trực tuyến hiệu quả.

• Hypefury: Tự động hóa quản lý mạng xã hội, tiết kiệm thời gian và tăng tương tác. Tự động retweet các tweet hay nhất và chuyển đổi thành bài đăng Instagram. Giúp tạo ý tưởng viral, viết bài đăng nhanh chóng và phát triển khán giả.

• Carrd: Nền tảng miễn phí để xây dựng trang web một trang đơn giản, đáp ứng mọi thiết bị. Lý tưởng cho hồ sơ cá nhân, trang đích. Cung cấp hàng chục mẫu đẹp mắt trên mọi kích thước màn hình.

• Fathom: Giải pháp báo cáo, phân tích và dự báo tài chính. Giúp đo lường và theo dõi các chỉ số KPI quan trọng. Tạo báo cáo quản lý tùy chỉnh và lên lịch gửi báo cáo kịp thời.

• Beehiiv: Nền tảng bản tin mạnh mẽ được tạo bởi đội ngũ Morning Brew. Cung cấp công cụ chỉnh sửa và thiết kế mạnh mẽ để dễ dàng khởi chạy và mở rộng quy mô bản tin mà không cần học code.

• Notion: Không gian làm việc tất cả trong một được hỗ trợ bởi AI. Giúp viết, lập kế hoạch, tổ chức và thực hiện ý tưởng. Đa ngôn ngữ và cho phép tạo nhãn, thẻ tùy chỉnh.

• Zapier: Tự động hóa quy trình làm việc trên hơn 7.000 tích hợp ứng dụng. Sử dụng AI để tăng năng suất bằng cách chuyển đổi ý tưởng thành quy trình làm việc và bot.

• Motion: Lịch AI tự động lập kế hoạch công việc dựa trên nhiệm vụ và ưu tiên của bạn. Tối ưu hóa lịch suốt cả ngày và đảm bảo bạn luôn biết nhiệm vụ tốt nhất cần làm tiếp theo.

• Copy.AI: Tự động hóa việc tạo nội dung, tìm kiếm khách hàng tiềm năng quy mô lớn và làm phong phú CRM. Nền tảng AI GTM xử lý các tác vụ tốn thời gian để nhóm tập trung vào bán hàng.

• PhantomBuster: Tăng năng suất của nhóm bán hàng, tiếp thị và tăng trưởng bằng cách tự động hóa thu thập dữ liệu và tiếp cận. Có hơn 100 tự động hóa và quy trình làm việc được xây dựng sẵn.

📌 12 công cụ AI miễn phí này bao gồm Namelix, Figma, Shopify, Hypefury, Carrd, Fathom, Beehiiv, Notion, Zapier, Motion, Copy.AI và PhantomBuster. Chúng giúp đơn giản hóa hoạt động, tăng năng suất và phát triển doanh nghiệp hiệu quả từ đặt tên thương hiệu đến tự động hóa quy trình, cho phép doanh nhân tập trung vào hoạt động kinh doanh cốt lõi.

https://aitoolsclub.com/build-your-business-from-scratch-12-free-ai-tools-to-get-you-started/

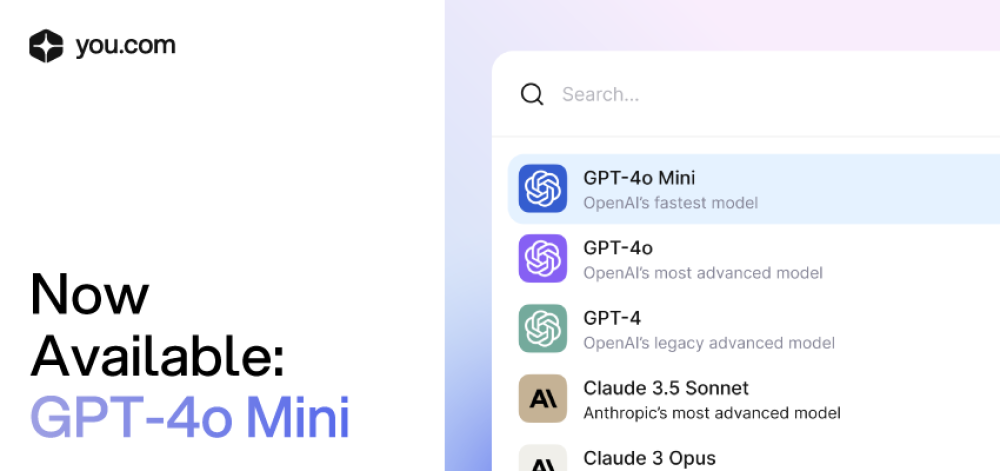

• OpenAI vừa ra mắt mô hình GPT-4o mini, phiên bản nhỏ gọn của GPT-4o nhưng vẫn giữ nguyên sức mạnh.

• GPT-4o mini có hiệu suất gần tương đương GPT-4o trên các bài kiểm tra về lập luận, toán học, lập trình, đa phương thức,...

• So với các mô hình nhỏ khác như Gemini Flash, Claude Haiku và GPT-3.5 Turbo, GPT-4o mini vượt trội hơn hẳn.

• Có 3 cách để truy cập GPT-4o mini:

1. Đăng nhập ChatGPT:

- Miễn phí cho người dùng ChatGPT Free, Plus và Team

- Cần tạo tài khoản và đăng nhập để sử dụng

- Người dùng Plus có thể chọn GPT-4o mini từ menu

2. OpenAI Playground:

- Nền tảng cho phép tùy chỉnh mô hình

- Phải trả phí sử dụng

- Có thể điều chỉnh các thông số như Temperature, Maximum Tokens,...

3. You.com:

- Cung cấp nhiều mô hình AI khác nhau trên cùng một nền tảng

- Miễn phí sử dụng GPT-4o mini

- Trải nghiệm có thể khác so với bản gốc do You.com tăng cường

• GPT-4o mini được tích hợp vào ChatGPT thay thế cho GPT-3.5 đối với người dùng miễn phí

• OpenAI Playground yêu cầu trả phí nhưng cho phép tùy chỉnh mô hình linh hoạt hơn

• You.com cung cấp trải nghiệm miễn phí với nhiều mô hình AI khác nhau trên cùng một nền tảng

📌 GPT-4o mini là phiên bản nhỏ gọn nhưng mạnh mẽ của GPT-4o, vượt trội so với các mô hình nhỏ khác. Người dùng có thể truy cập miễn phí qua ChatGPT và You.com, hoặc trả phí qua OpenAI Playground để tùy chỉnh. Mô hình mới này mở ra cơ hội tiếp cận AI tiên tiến cho nhiều đối tượng hơn.

https://www.zdnet.com/article/want-to-try-gpt-4o-mini-3-ways-to-access-the-smarter-cheaper-ai-model-and-2-are-free/

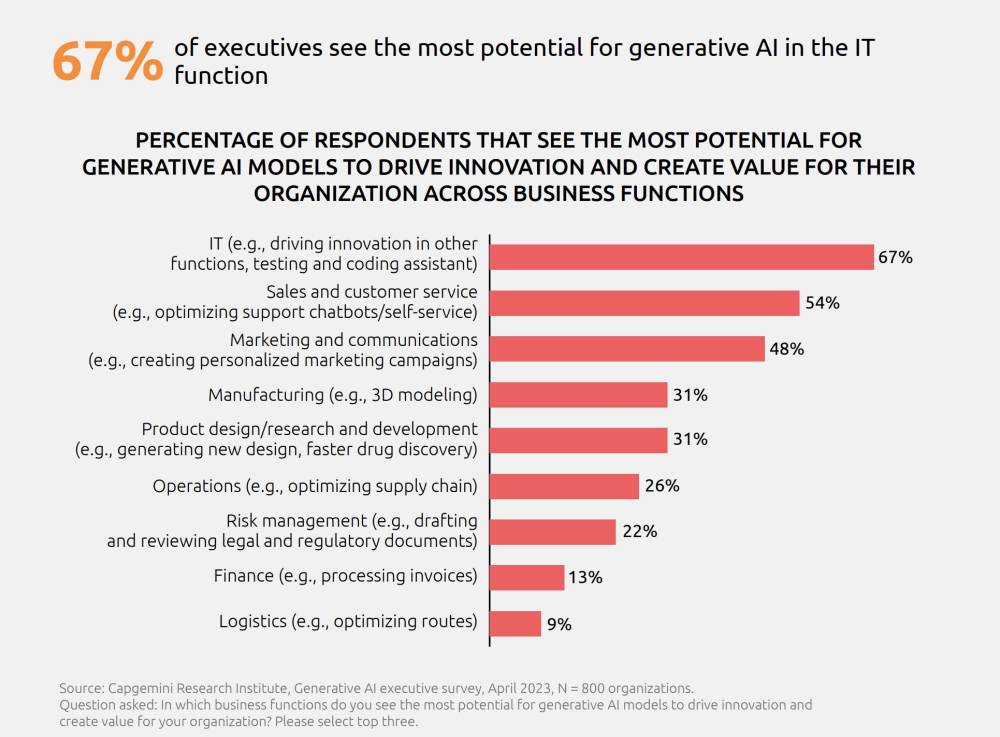

• Theo nghiên cứu của Capgemini, đa số các ngành đều gặp khó khăn lớn trong việc chuyển đổi các dự án thử nghiệm AI thành giải pháp sản xuất.

• Nguyên nhân chính là do ranh giới số, nhân viên số và dữ liệu kém chất lượng.

• Steve Jones, EVP tại Capgemini, cho rằng các tổ chức đã quá quen với việc sử dụng dữ liệu kém chất lượng và hy vọng sẽ sửa chữa ở hệ thống nguồn.

• Dự đoán đến năm 2030, 50% quyết định kinh doanh sẽ được đưa ra bởi AI, chủ yếu trong các ứng dụng chuỗi cung ứng tự động.

• Nhân viên số cần có khả năng đưa ra quyết định dựa trên dữ liệu thời gian thực, không thể chờ đợi dữ liệu được làm sạch.

• Các mô hình ngôn ngữ lớn (LLM) cần tiếp cận thông tin phản ánh thực tế hoạt động của doanh nghiệp để tránh đưa ra quyết định sai lầm.

• Doanh nghiệp cần xây dựng mô hình vận hành số, mô tả rõ ràng vấn đề cần giải quyết và ranh giới của AI.

• Cần xác định rõ dữ liệu nào nên và không nên được sử dụng để đưa ra quyết định, AI được phép ảnh hưởng đến những gì.

• Mỗi giải pháp AI trong công ty sẽ bị ràng buộc bởi chức năng cụ thể của nó, tuân theo các quy tắc và động lực khác nhau.

• Cần xem xét AI dưới góc độ quản lý và áp dụng kinh doanh, thay vì chỉ tập trung vào công nghệ.

• Các nhân viên số cần có khả năng hợp tác với con người và với nhau, đặt ra câu hỏi trong phạm vi ranh giới rõ ràng.

• Thiết kế ứng dụng cần thay đổi, đưa dữ liệu lên phía trước để nhân viên số có thể sử dụng ngay lập tức.

• Tổ chức cần kiểm soát mô hình vận hành số của mình để triển khai nhân viên số thành công.

• Thách thức lớn là giúp nhân viên kinh doanh không am hiểu công nghệ có thể phát triển sự nghiệp thông qua tương tác với AI.

📌 Capgemini chỉ ra rằng để triển khai AI thành công, doanh nghiệp cần thay đổi mô hình vận hành số, xác định rõ ranh giới cho AI, và cải thiện chất lượng dữ liệu. Dự kiến đến năm 2030, 50% quyết định kinh doanh sẽ do AI đưa ra, đòi hỏi sự thay đổi lớn về tổ chức và cách tiếp cận dữ liệu.

https://venturebeat.com/ai/capgemini-digs-into-the-real-reasons-that-gen-ai-proof-of-concepts-never-take-off/

• AI tạo sinh tập trung vào việc tạo ra nội dung mới dựa trên các mẫu trong dữ liệu. Nó sử dụng các kỹ thuật như VAE và GAN để tạo ra đầu ra thực tế, phù hợp cho đổi mới và khám phá các khả năng mới.

• AI phân tích tập trung vào việc phân tích dữ liệu hiện có để tìm ra các mẫu và xu hướng, đưa ra dự đoán và khuyến nghị. Nó sử dụng các phương pháp như phân tích hồi quy, phân cụm và phân loại để cung cấp thông tin chi tiết có thể hành động.