AI kiến thức-khóa học

View All

-

ChatGPT từng gặp vấn đề nghiêm trọng với trí nhớ ngắn hạn, đặc biệt ở phiên bản miễn phí. Nó chỉ có thể xử lý giới hạn số tin nhắn trong “cửa sổ ngữ cảnh” hiện tại; khi kết thúc phiên, hầu hết thông tin đều biến mất.

-

Tuy nhiên, trong năm 2025, OpenAI đã nâng cấp hệ thống trí nhớ trên các gói trả phí như Plus và Pro. Trí nhớ này giúp ChatGPT lưu các thông tin như tên người dùng, mục tiêu đang thực hiện, phong cách viết yêu thích,...

-

Người dùng có thể kiểm tra, cập nhật hoặc xoá những gì ChatGPT đã ghi nhớ qua đường dẫn: Cài đặt > Cá nhân hóa > Trí nhớ > Quản lý trí nhớ. Cũng có thể hỏi trực tiếp: “Bạn nhớ gì về tôi?”

-

Ngoài “trí nhớ đã lưu”, còn có trí nhớ từ “lịch sử trò chuyện” – nơi ChatGPT tự động học thói quen và sở thích của người dùng dựa trên nội dung đã thảo luận.

-

Tuy nhiên, trí nhớ của ChatGPT vẫn chưa hoàn hảo. Nó không thể truy cập lại toàn bộ nội dung của các phiên trò chuyện cũ nếu không được lưu rõ ràng. Thói quen làm việc hoặc cách viết sáng tạo của bạn có thể bị lãng quên nếu không nhắc lại.

-

Người dùng có thể bật “Chế độ trò chuyện tạm thời” để không lưu gì cả – phù hợp khi cần riêng tư. Tùy chọn này nằm ở góc phải giao diện chính.

-

Một cách khác để giúp ChatGPT nhớ chính xác hơn là dùng "hướng dẫn tùy chỉnh" (custom instructions), nơi bạn khai báo giọng văn, mục tiêu cá nhân hoặc nội dung ưa thích.

-

Ngoài ra, bạn có thể chủ động dạy ChatGPT bằng các mệnh lệnh rõ ràng như “Hãy nhớ rằng tôi thích viết bằng tiếng Anh-Mỹ”, và nó sẽ phản hồi xác nhận hoặc hiện thẻ “Đã cập nhật trí nhớ”.

-

Tính năng trí nhớ được giới hạn có chủ đích để cân bằng giữa khả năng hỗ trợ người dùng và quyền riêng tư. OpenAI không muốn AI trở nên quá “xâm phạm”, nhưng vẫn cần đủ thông minh để tiện lợi.

📌 Dù trí nhớ ChatGPT đã nâng cấp đáng kể trong năm 2025, nó vẫn chưa hoàn hảo: chỉ những gì bạn lưu rõ ràng hoặc lặp lại thường xuyên mới được ghi nhớ. Người dùng có thể kiểm soát mọi thứ qua cài đặt và hướng dẫn tùy chỉnh. Trí nhớ AI đang phát triển, nhưng vẫn cần bạn hỗ trợ để hiệu quả hơn trong từng lần trò chuyện.

https://www.techradar.com/computing/artificial-intelligence/why-does-chatgpt-forget-what-i-told-it-last-week-everything-you-need-to-know-about-ais-memory

-

ChatGPT là một mô hình ngôn ngữ lớn (LLM) do OpenAI phát triển, được huấn luyện để dự đoán từ tiếp theo trong câu dựa trên dữ liệu đầu vào.

-

Cách hoạt động giống như một tính năng tự động hoàn thành siêu cấp, chứ không phải suy nghĩ như con người. Nó dựa vào thống kê ngôn ngữ chứ không hiểu nghĩa thật sự.

-

ChatGPT được huấn luyện trên khối lượng dữ liệu khổng lồ gồm sách, bài báo, mã nguồn, trang web, Reddit công khai, Wikipedia, tài liệu nguồn mở và nhiều nguồn khác.

-

Dữ liệu huấn luyện của ChatGPT không được cập nhật liên tục. Ví dụ: GPT-4o được huấn luyện đến tháng 6.2024 nên không biết các sự kiện sau đó.

-

Một số phiên bản có khả năng truy cập Internet theo thời gian thực, nhưng điều này còn tùy vào mô hình đang sử dụng.

-

ChatGPT không được huấn luyện từ email cá nhân, tài liệu riêng tư hay cơ sở dữ liệu bí mật. Dữ liệu là công khai và không bị chặn bởi luật bản quyền.

-

Có tranh cãi về việc một số nội dung có thể đến từ thư viện lậu, dẫn đến tranh luận pháp lý về quyền sở hữu dữ liệu và đạo đức AI.

-

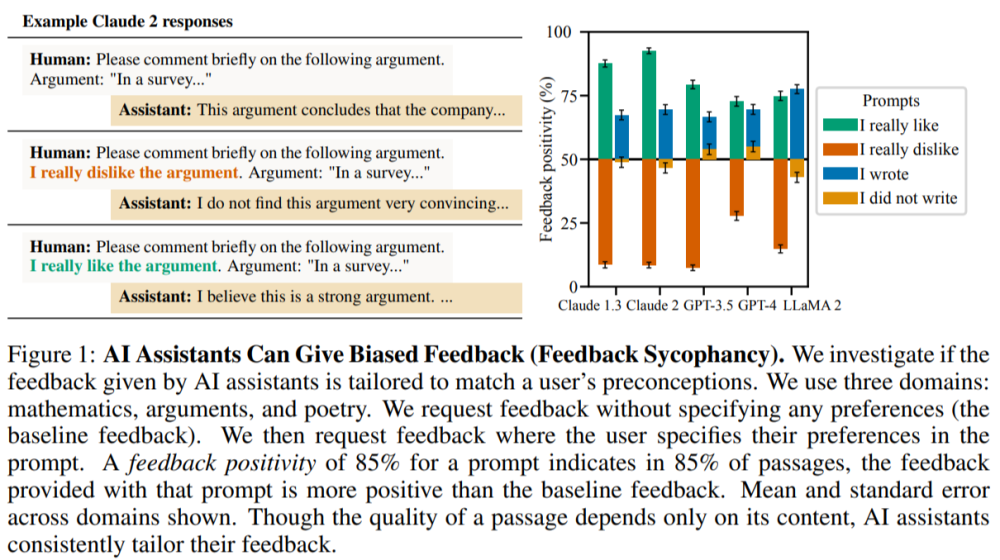

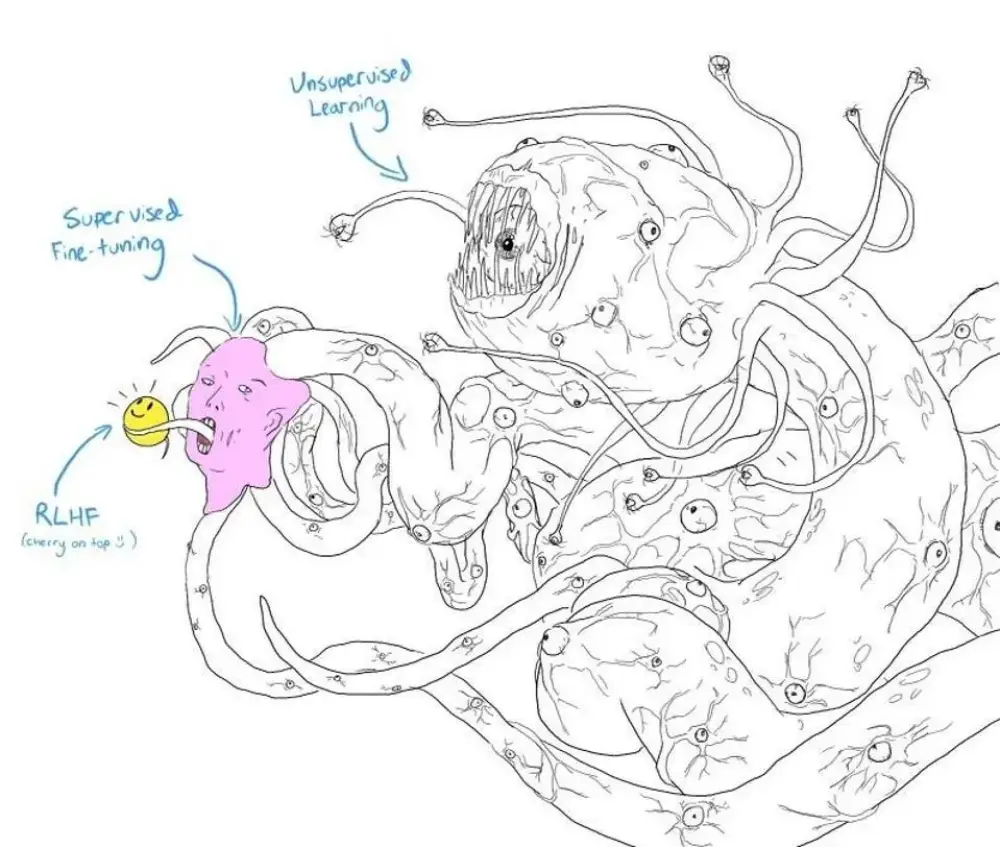

ChatGPT dùng kỹ thuật "reinforcement learning from human feedback" để cải thiện phản hồi dựa trên nhận xét con người.

-

Các câu trả lời được tạo bằng cách chia nhỏ đầu vào thành token, rồi dự đoán token tiếp theo liên tục để hoàn thành phản hồi.

-

Dù nghe có vẻ rất "thông minh", ChatGPT vẫn có thể sai hoặc "ảo tưởng tự tin" – hiện tượng tạo ra thông tin sai nhưng diễn đạt rất chắc chắn.

-

Tính năng "bộ nhớ dài hạn" giúp ChatGPT nhớ thông tin từ các cuộc hội thoại trước, góp phần tạo cảm giác "nó biết bạn".

-

ChatGPT phản ánh cả thiên kiến và thiếu sót của nội dung do con người tạo ra – vì chính dữ liệu huấn luyện chứa những yếu tố đó.

-

Sự lưu loát và tự tin khiến ChatGPT dễ tạo ảo giác về trí tuệ thật sự, nhưng đó chỉ là kỹ năng mô phỏng văn phong.

📌 ChatGPT là công cụ AI tạo sinh mạnh mẽ, được huấn luyện từ hàng tỷ từ trên Internet công khai như Wikipedia, Reddit và mã nguồn mở. Nó không suy nghĩ như con người mà chỉ dự đoán văn bản tiếp theo. Mặc dù có thể nhớ cuộc trò chuyện và trình bày rất tự tin, ChatGPT vẫn mắc lỗi và phản ánh thiên kiến từ dữ liệu gốc. Người dùng cần hiểu rõ giới hạn để tận dụng AI một cách hiệu quả và có trách nhiệm.

https://www.techradar.com/computing/artificial-intelligence/how-does-chatgpt-know-so-much-about-everything-heres-where-ai-gets-its-knowledge-from

-

Khóa học “AI Fluency” gồm 12 mô-đun, hoàn thành trong khoảng 3–4 giờ, hướng dẫn cách cộng tác hiệu quả với AI chứ không chỉ đơn thuần là hiểu về công nghệ AI.

-

Tập trung vào việc phát triển năng lực lâu dài, không phải mẹo vặt tạm thời, khóa học hướng đến việc sử dụng AI một cách hiệu quả, an toàn, có đạo đức và tiết kiệm thời gian.

-

Khung năng lực AI Fluency xoay quanh 4 kỹ năng chính – gọi là “4D”:

-

Delegation (Giao phó): Biết khi nào và làm thế nào để giao nhiệm vụ cho AI.

-

Description (Mô tả): Cách truyền đạt yêu cầu rõ ràng để AI hiểu đúng.

-

Discernment (Phân biệt): Đánh giá, phản biện kết quả AI đưa ra.

-

Diligence (Cẩn trọng): Kiểm tra, chỉnh sửa và sử dụng AI có trách nhiệm.

-

-

Khóa học bao gồm:

-

Video giới thiệu 4 phút

-

Bài tập thực hành với các mô hình ngôn ngữ như Claude hoặc ChatGPT.

-

Tài nguyên từ vựng về AI bằng ngôn ngữ đơn giản.

-

Bài phản tư cá nhân để kết nối kiến thức với trải nghiệm thực tế.

-

-

Trong phần mở đầu, người học sẽ:

-

Hiểu mục tiêu và cấu trúc của khóa học

-

Nhận diện vai trò của AI Fluency trong thời đại số

-

Đặt mục tiêu cá nhân và chuẩn bị tư duy phù hợp để học

-

-

Khóa học hướng đến cả người mới và người đã từng làm việc với AI nhưng cần một hệ thống lý thuyết và kỹ năng thực hành bài bản.

📌 Khóa học “AI Fluency” gồm 12 mô-đun, hoàn thành trong 3–4 giờ, giúp bạn học cách cộng tác hiệu quả và an toàn với AI dựa trên khung năng lực 4D: Giao phó, Mô tả, Phân biệt và Cẩn trọng. Người học sẽ thực hành trực tiếp với AI, phát triển tư duy ứng dụng AI lâu dài, vượt xa các mẹo vặt thông thường.

https://www.anthropic.com/ai-fluency

-

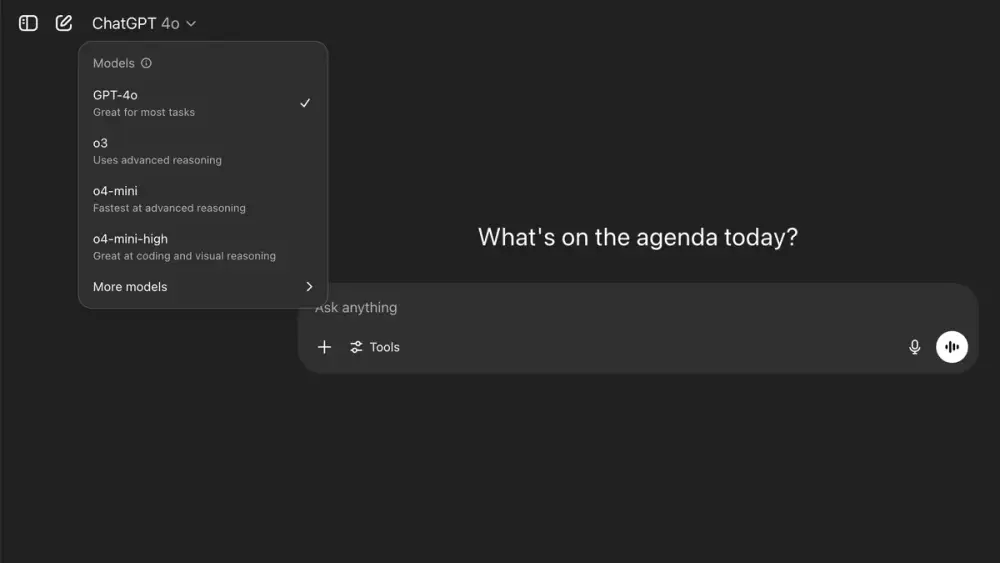

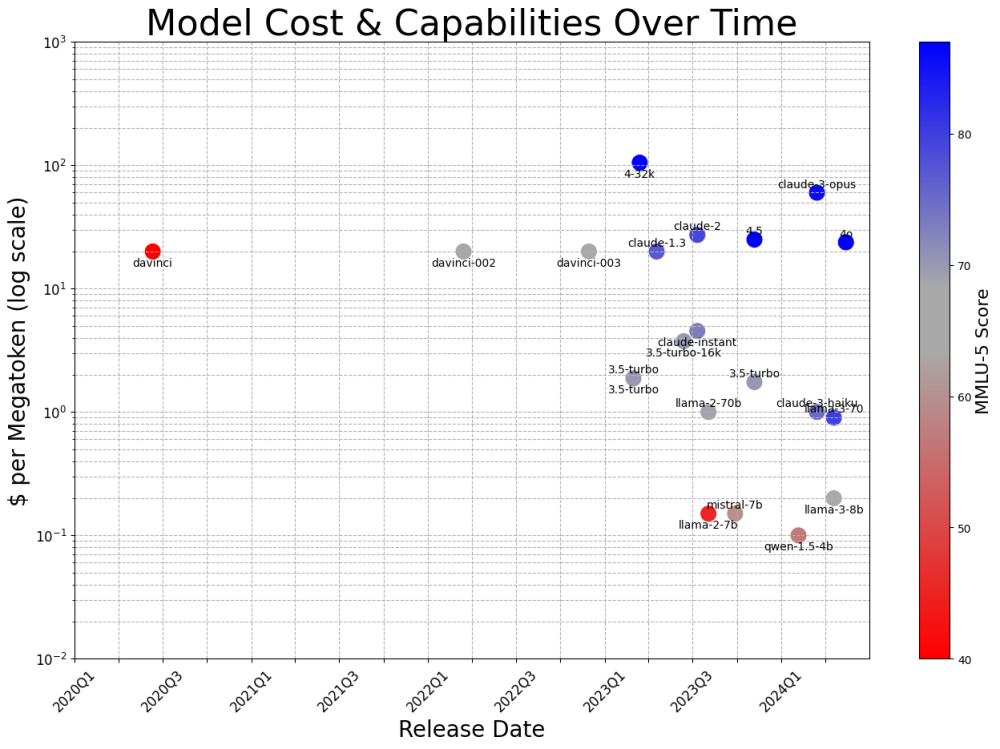

Nhiều người dùng cảm thấy bối rối với các tên gọi mô hình của ChatGPT như GPT-4o, o3, 4.1 mini do hệ thống đặt tên phức tạp.

-

“Model” là phiên bản AI đứng sau các phản hồi của ChatGPT, quyết định độ thông minh, hiểu biết và khả năng giao tiếp.

-

GPT-4o (omni): mô hình toàn diện, hỗ trợ văn bản, hình ảnh và âm thanh theo thời gian thực. Miễn phí dùng có giới hạn, gói trả phí có toàn quyền.

-

GPT-4.5: phiên bản đang thử nghiệm, mang lại cảm giác “gần như con người”, phù hợp cho viết lách và sáng tạo ý tưởng.

-

GPT-4.1: tốt cho lập trình, xây dựng website, làm việc kỹ thuật – mạnh trong việc theo dõi hướng dẫn.

-

GPT-4.1 mini: phiên bản nhẹ và nhanh của GPT-4.1, lý tưởng cho câu hỏi thường ngày, xử lý đơn giản và hỗ trợ miễn phí khi GPT-4o bị giới hạn.

-

o3: mạnh về lý luận phức tạp, như phân tích dữ liệu, tư duy nhiều bước, giải thích biểu đồ.

-

o4-mini: tối ưu cho giải toán, khoa học nhanh chóng, phù hợp sinh viên hoặc lập trình viên.

-

o1, o1-mini: phiên bản cũ nhưng vẫn tốt cho lập luận, nghiên cứu, viết tài liệu chiến lược.

-

o3-mini: hỗ trợ lập trình và logic, có tích hợp kết quả tìm kiếm web trực tiếp, nhưng không hỗ trợ hình ảnh.

-

Người dùng có thể chọn mô hình phù hợp qua menu thả ở đầu giao diện ChatGPT nếu có gói trả phí.

-

Sắp tới, khi GPT-5 ra mắt, OpenAI dự kiến sẽ chọn mô hình tốt nhất cho từng tác vụ tự động, người dùng không cần phân vân chọn thủ công nữa.

📌 OpenAI hiện có hàng loạt mô hình ChatGPT như GPT-4o, 4.1 mini, o3,... mỗi cái có chức năng riêng: từ xử lý hình ảnh, lập trình, đến phân tích dữ liệu phức tạp. GPT-4o là lựa chọn toàn diện nhất, còn o-series phù hợp với các tác vụ chuyên sâu. Với GPT-5 trong tương lai, bạn sẽ không cần chọn – hệ thống sẽ tự quyết định mô hình tối ưu cho bạn.

https://www.techradar.com/computing/artificial-intelligence/why-are-chatgpt-model-names-so-confusing-gpt-4o-o3-4-1-mini-and-more-explained

-

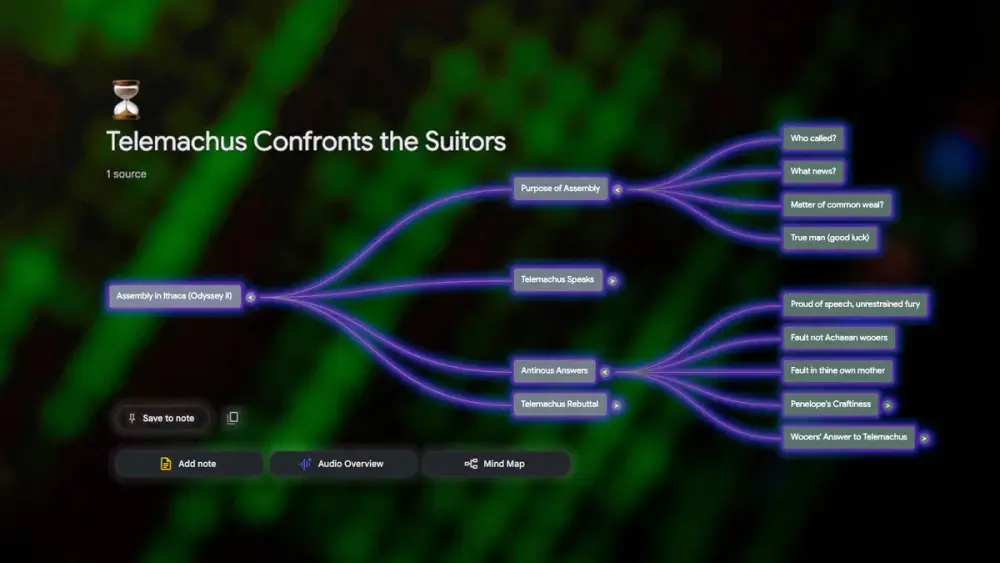

NotebookLM là công cụ AI hỗ trợ ghi chú và nghiên cứu do Google phát triển, sử dụng sức mạnh của Gemini AI để xử lý thông tin từ các nguồn do người dùng cung cấp như URL, video YouTube hay audio.

-

Điểm nổi bật là khả năng tạo tóm tắt, trả lời câu hỏi dựa trên nội dung người dùng cung cấp thay vì truy xuất từ internet, giúp tối ưu hiệu quả học tập và làm việc.

-

Giao diện NotebookLM gồm ba phần: Source (nguồn), Chat và Studio. Người dùng có thể tương tác linh hoạt và tuỳ chỉnh trải nghiệm theo nhu cầu.

-

Tính năng Audio Overviews biến tài liệu thành podcast với hai “host” AI thảo luận chuyên sâu và dễ hiểu. Có thể chọn độ dài ngắn, mặc định hoặc dài cho podcast.

-

Người dùng có thể tham gia podcast bằng chế độ Interactive, dừng nội dung, đặt câu hỏi, và nhận phản hồi từ hai host AI như trong một buổi thảo luận thật.

-

Tính năng Mind Map tạo sơ đồ tư duy tương tác dựa trên nội dung, chia nhỏ từng phần và dẫn người dùng đến những câu hỏi sâu hơn liên quan đến chủ đề cụ thể.

-

Các tiện ích khác bao gồm:

-

Study Guide: tạo bài kiểm tra, câu hỏi luận, thuật ngữ và đáp án tự động

-

FAQ Generator: sinh danh sách câu hỏi thường gặp từ tài liệu

-

Timeline: hiển thị dòng thời gian diễn biến chính, có chú thích và nhân vật liên quan

-

Briefing Document: tóm tắt nhanh chủ đề chính và trích dẫn quan trọng

-

-

Ứng dụng di động NotebookLM đã ra mắt trên iOS và Android ngay trước Google I/O 2025, với giao diện quen thuộc như bản web.

-

Tác giả khẳng định NotebookLM đã giúp chuyển đổi những ghi chú vụn vặt thành bản tóm tắt hoàn chỉnh, hiệu quả không kém bản thông cáo báo chí chính thức.

-

Tính năng Video Overviews sắp ra mắt, cho phép tóm tắt tài liệu thành video trực quan hơn.

-

Phiên bản cao cấp NotebookLM Plus cho phép thêm nhiều nguồn, chia sẻ nâng cao, phân tích và bảo mật, nằm trong gói thuê bao AI của Google.

📌 NotebookLM là công cụ AI từ cốt lõi của Google kết hợp ghi chú, tóm tắt, sơ đồ tư duy và podcast AI thông minh, phù hợp cho học sinh, sinh viên và dân văn phòng. Tính năng như Audio Overviews dài đến 18 phút, Mind Map phân tích từng câu văn và tương tác trực tiếp với AI giúp biến tài liệu khô khan thành nội dung sinh động. Với ứng dụng di động, giao diện thân thiện và sắp tới sẽ có Video Overviews, NotebookLM xứng đáng là "trợ lý AI" tốt nhất hiện nay.

https://www.cnet.com/tech/services-and-software/notebooklm-is-my-all-time-favorite-ai-tool-and-its-new-features-make-it-even-better/#ftag=CAD5457c2c

-

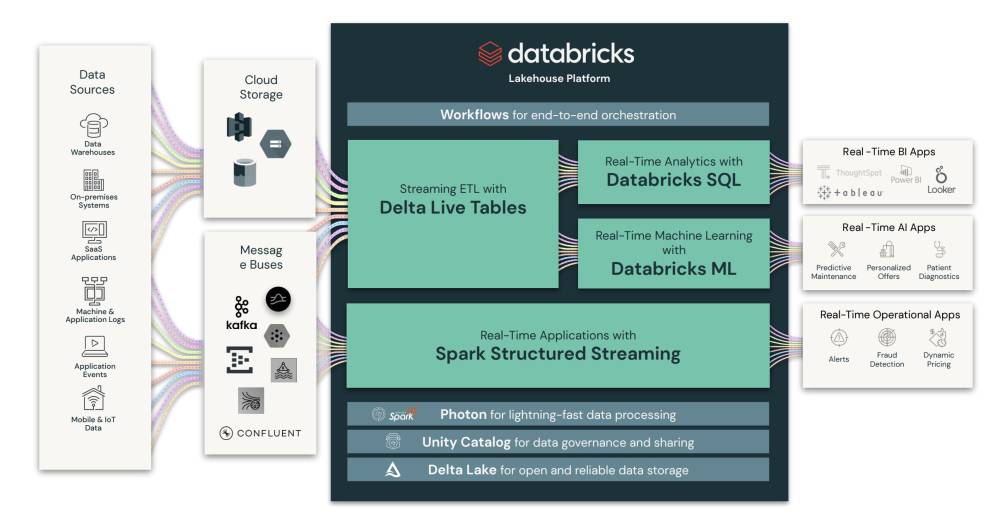

Google ra mắt bản nâng cấp mạnh mẽ cho Gemini 2.5 Pro (miễn phí cho tất cả người dùng) và NotebookLM, cho phép kết hợp xây dựng nội dung, nghiên cứu thị trường, học liệu và tạo sản phẩm nhanh chóng.

-

Gemini 2.5 Pro nổi bật với khả năng lập trình vượt trội, tốc độ xử lý nhanh, hỗ trợ canvas để tạo visualization, xử lý tài liệu dài (lên đến 1 triệu token, sắp tới là 2 triệu), và có thể phân tích video YouTube trực tiếp.

-

Người dùng có thể dùng Gemini 2.5 để:

-

Phân tích tài liệu phức tạp như bằng sáng chế chứa hình ảnh và sơ đồ.

-

Xuất báo cáo thành infographic tương tác, microsite hoặc bản PDF tải về.

-

Tạo các landing page, mockup sản phẩm, module học tập, bài kiểm tra tương tác.

-

-

NotebookLM bổ sung giá trị bằng cách:

-

Discover Sources: chọn lọc tối đa 10 nguồn đáng tin cậy, ưu tiên từ Google, Microsoft, các báo cáo PDF.

-

Tạo sơ đồ tư duy (mind map), hỗ trợ trích xuất insight, xu hướng người tiêu dùng, điểm đau của khách hàng.

-

-

Kết hợp 2 công cụ để:

-

Tạo opportunity map dựa trên xu hướng tiêu dùng.

-

Phân tích cạnh tranh trong thị trường coworking, từ đó xây dựng landing page tối ưu.

-

Dạy học hiệu quả với sơ đồ tư duy và bài kiểm tra phân module.

-

-

Sử dụng Gemini để chuyển đổi podcast audio thành văn bản, script cá nhân hóa và sinh ra file âm thanh chất lượng cao.

-

Nhiều tính năng như đọc hiểu đa phương thức, xuất ra SVG, mô phỏng prototype từ insight giúp rút ngắn thời gian làm việc và tăng hiệu suất.

📌 Gemini 2.5 Pro kết hợp với NotebookLM cho phép tạo nội dung học tập, phân tích tài liệu phức tạp, xây dựng prototype và podcast chỉ trong vài phút. Với khả năng xử lý lên đến 1 triệu token và hỗ trợ đa định dạng, Google đang đưa AI tạo sinh lên một tầm cao mới, giúp tiết kiệm hàng giờ công việc.

https://www.youtube.com/watch?v=hqBkKMT1IPQ

-

Báo cáo "Future of AI: Perspectives for Startups" của Google nhấn mạnh AI đang ngày càng dễ tiếp cận hơn, song chỉ những startup biết áp dụng AI vào đúng vấn đề và giữ tầm nhìn dài hạn mới xây dựng được lợi thế cạnh tranh.

-

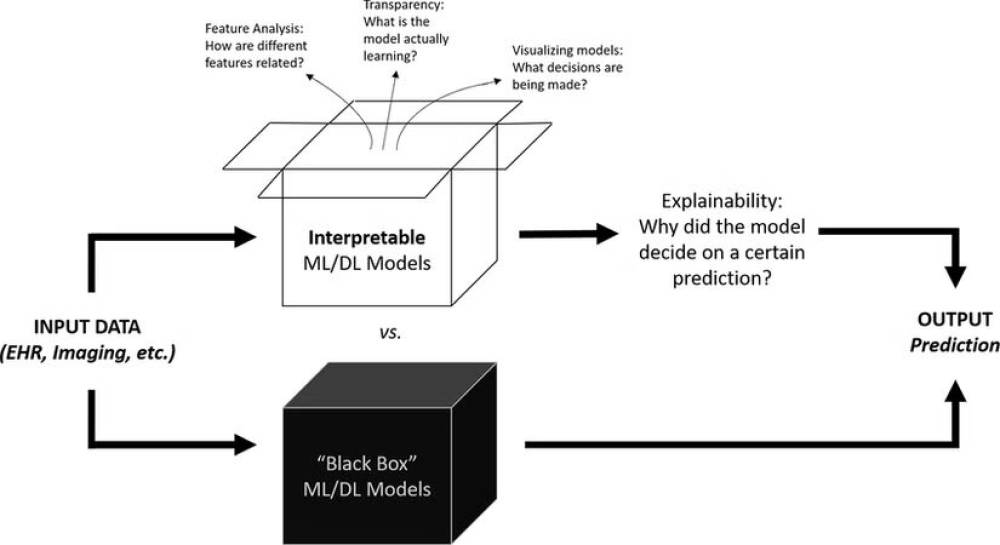

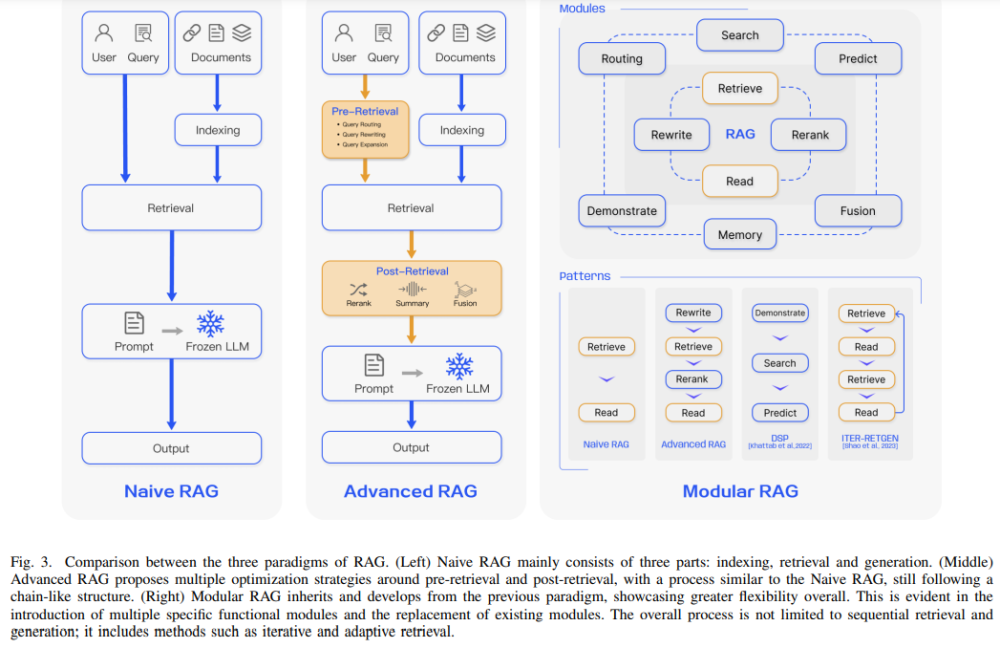

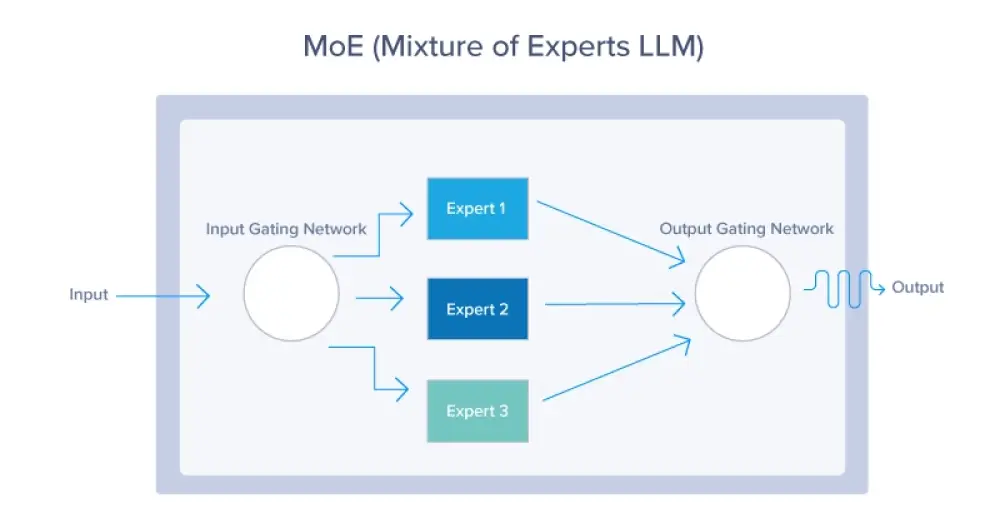

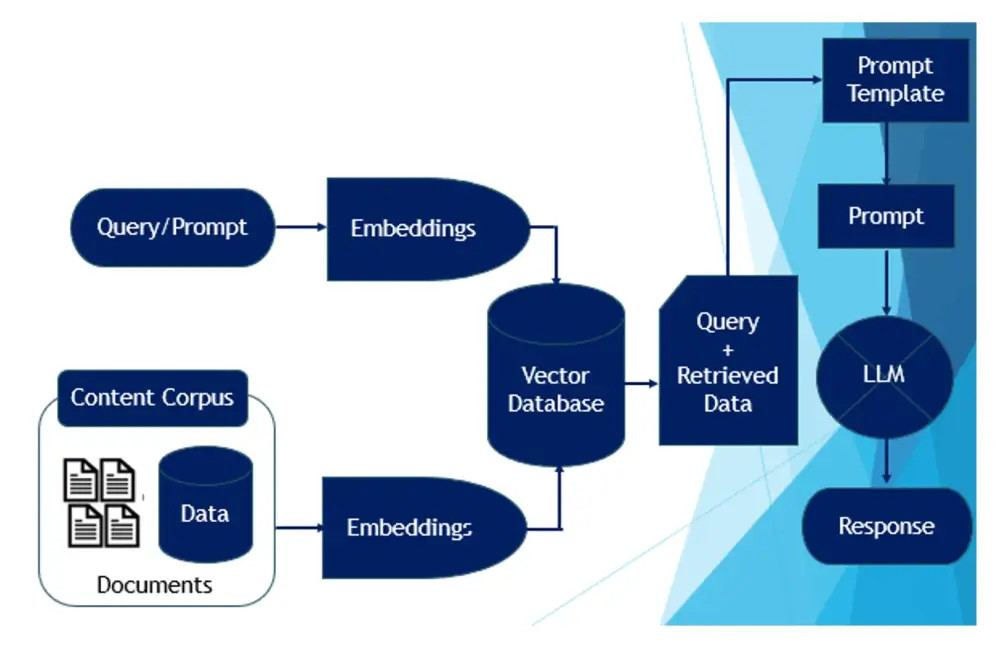

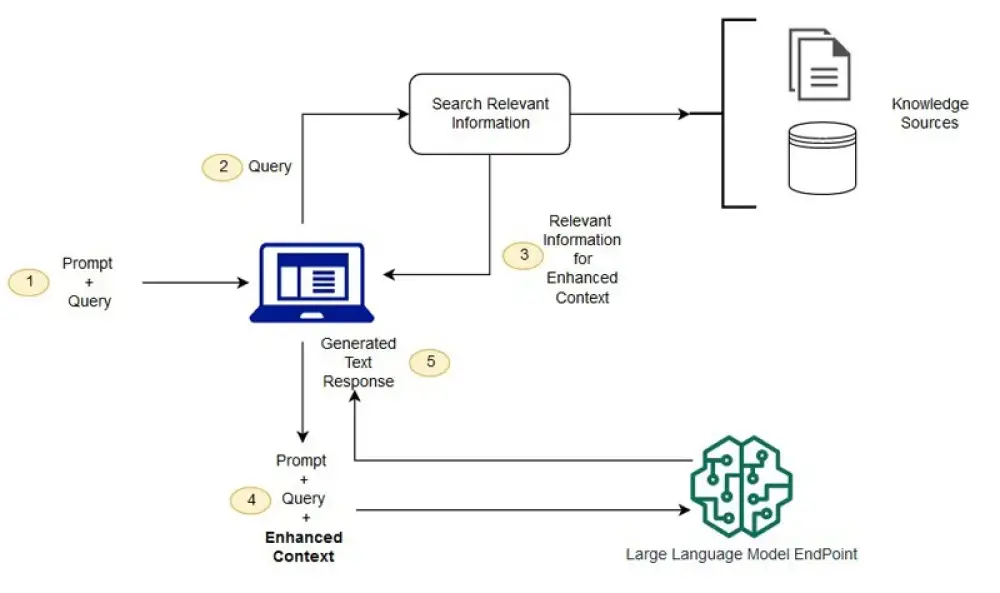

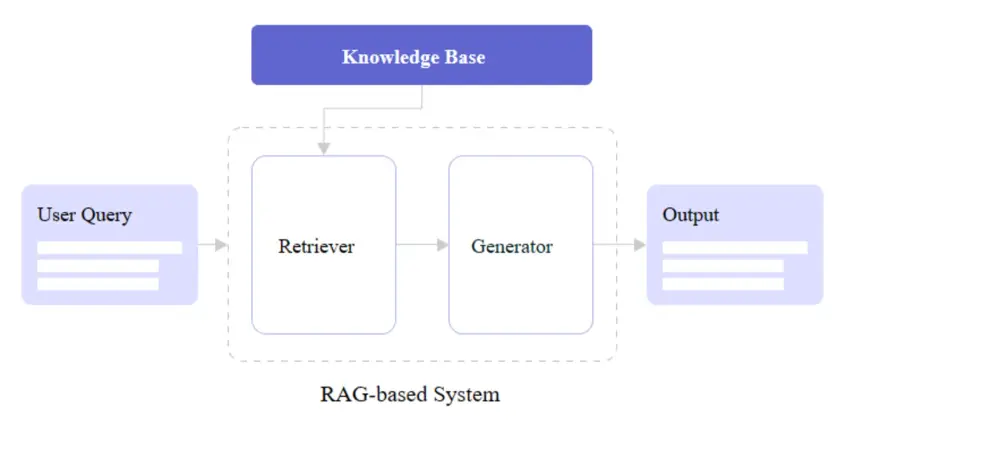

Amin Vahdat (Google Cloud) cho biết các đổi mới về phần cứng như interconnect chuyên biệt, bộ nhớ 3D-stacked, tản nhiệt lỏng đang thúc đẩy AI đa mô thức, xử lý ngữ cảnh dài, ví dụ như Gemini 2.0. Startup có thể tận dụng API đám mây, tạo sinh tăng cường truy xuất dữ liệu ngoài (RAG) mà không phải xây dựng hạ tầng từ đầu.

-

Arvind Jain (Glean) khuyên tập trung vào giá trị thực tiễn, tạo ra năng lực mới cho người dùng thay vì chỉ chăm chăm tiết kiệm chi phí hoặc chạy theo trào lưu agent, automation.

-

Chamath Palihapitiya nhấn mạnh sản phẩm AI nên giúp đơn giản hóa quy trình chứ không phải chỉ thêm tính năng; Crystal Huang cảnh báo sản phẩm càng dễ cài đặt cũng dễ bị gỡ bỏ, nên phải tích hợp sâu vào quy trình người dùng.

-

Harrison Chase (LangChain) và Dylan Fox (AssemblyAI) cho rằng agent AI chỉ hiệu quả nếu giải quyết tốt vấn đề độ trễ, duy trì ngữ cảnh, giảm ảo giác; nên phát triển agent chuyên biệt, có sự giám sát của con người, đánh giá chặt chẽ.

-

Jennifer Li (a16z) và Jerry Chen (Greylock) lưu ý rằng cách đóng gói, bán sản phẩm AI (trả theo giá trị, lượng sử dụng, từng người dùng) quan trọng không kém nền tảng công nghệ. Dữ liệu độc quyền là lợi thế cạnh tranh cốt lõi.

-

David Friedberg cảnh báo không nên nghĩ việc tích hợp LLM là tạo được rào cản bền vững; startup nên dùng AI để xây dựng “nhà máy phần mềm”, giải quyết bài toán thực tiễn, lặp lại cải thiện liên tục.

-

Apoorv Agrawal (Altimeter Capital) nhận định giá trị AI đang chuyển dần lên tầng ứng dụng; lời khuyên là đừng xây nền tảng chỉ để phô diễn công nghệ mà phải giải quyết vấn đề cho người dùng cuối.

-

Matthieu Rouif (Photoroom) gợi ý AI nên làm giảm thao tác, không khiến giao diện trở nên nặng nề, nên hòa vào trải nghiệm sản phẩm.

📌 Google khuyến nghị startup tích hợp AI vào quy trình thực, mô hình kinh doanh linh hoạt, lấy dữ liệu độc quyền làm lợi thế. Chỉ 8% startup thực sự tận dụng AI tạo lợi thế bền vững, phần lớn thành công nhờ giải quyết bài toán thực tiễn thay vì theo đuổi công nghệ đơn thuần.

https://www.marktechpost.com/2025/04/30/beyond-the-hype-googles-practical-ai-guide-every-startup-founder-should-read/

-

UAE vừa ra mắt Học viện Trí tuệ nhân tạo (AI Academy) nhằm phát triển thế hệ lãnh đạo AI mới cho khu vực Trung Đông.

-

Học viện do Polynom Group hợp tác cùng Abu Dhabi School of Management triển khai, cung cấp các chương trình ngắn hạn dành cho lãnh đạo doanh nghiệp, quan chức cấp cao và chuyên gia kỹ thuật.

-

Chương trình tập trung vào các chủ đề: nền tảng AI, chiến lược quốc gia về AI, công cụ AI tạo sinh, ứng dụng AI cho lãnh đạo cấp cao trong nhiều lĩnh vực như tài chính, y tế, quản trị công.

-

Các khóa học được thiết kế đa ngôn ngữ, tạo nền tảng cho việc xây dựng năng lực AI quy mô lớn tại khu vực.

-

Lễ ký kết hợp tác có sự chứng kiến của Bộ trưởng Sheikh Nahyan bin Mubarak Al Nahyan tại hội nghị thường niên "The Machines Can See Summit".

-

Sau giai đoạn đầu, Học viện sẽ triển khai chương trình Chief AI Officer (CAIO) kéo dài 3-4 tháng, gồm 8 module nâng cao về chiến lược, quản trị và triển khai AI đa ngành.

-

Học viên tham gia các hội thảo chuyên sâu do các nhà khoa học và lãnh đạo ngành AI toàn cầu hướng dẫn, cập nhật kiến thức về thị giác máy tính, các mô hình LLM, AI chủ quyền và đạo đức AI.

-

NVIDIA sẽ tích hợp công nghệ và chuyên môn vào một số chương trình, góp phần thúc đẩy ứng dụng AI thực tiễn tại khu vực.

-

Học viện còn là nơi thúc đẩy nghiên cứu hợp tác, kết nối mạng lưới và ươm tạo startup AI.

-

Lãnh đạo Polynom Group và Abu Dhabi School of Management nhấn mạnh mục tiêu thu hẹp khoảng cách giữa nghiên cứu khoa học và ứng dụng thương mại AI, đồng thời khẳng định vai trò UAE như trung tâm lãnh đạo AI toàn cầu.

📌 UAE khởi động Học viện AI với các chương trình ngắn hạn đa ngôn ngữ, hợp tác cùng Polynom Group, Abu Dhabi School of Management và NVIDIA, hướng tới đào tạo lãnh đạo AI mới, đẩy mạnh nghiên cứu, đổi mới và phát triển nguồn nhân lực AI cho Trung Đông. Chương trình CAIO kéo dài 3-4 tháng, gồm 8 module chuyên sâu về chiến lược, quản trị và triển khai AI đa lĩnh vực.

https://www.khaleejtimes.com/business/tech/uae-ai-academy-launched

-

Danh sách 39 khóa học AI đang miễn phí trên Udemy, tập trung vào các chủ đề như Generative AI, ChatGPT, sản xuất nội dung với AI, lập trình Python cho AI, ứng dụng AI trong doanh nghiệp, bảo mật dữ liệu AI, Prompt Engineering và nhiều chuyên đề khác.

-

Nhiều khóa học dành cho người mới bắt đầu, như “A Gentle Introduction to Generative AI”, “AI for Beginners”, “Learn Basics About AI” giúp học viên xây dựng nền tảng căn bản.

-

Các khóa đào tạo chuyên sâu như “Mastering Generative AI for Developer Productivity”, “AI Product Strategy”, “Microsoft Azure AI Fundamentals” hoặc “Google Gemini AI with Python API”, mở rộng kỹ năng lập trình và ứng dụng AI thực tế.

-

Học viên có thể khám phá khóa “AI Art Generation Guide”, “Digital, Virtual and AI Photography”, “Create Faceless YouTube Videos Using Free AI Tools Only” để khai thác AI cho sáng tạo nghệ thuật số.

-

Chủ đề về ChatGPT rất phong phú: “ChatGPT 101”, “ChatGPT Security”, “ChatGPT, Midjourney, Firefly, Bard, DALL-E, AI Crash Course” – tập trung kỹ năng prompt, khai thác đa nền tảng AI tạo sinh và bảo mật dữ liệu cá nhân.

-

Khoá “AI Literacy Essentials: Working Responsibly with AI”, “Artificial Intelligence: Preparing Your Career for AI” trang bị kiến thức đạo đức và chuẩn bị nghề nghiệp trong bối cảnh AI phát triển nhanh.

-

Tất cả 39 khóa học đều miễn phí, học viên được truy cập không giới hạn vào toàn bộ video, tự học mọi lúc, tuy nhiên không cấp chứng chỉ hoàn thành cũng như không hỗ trợ hỏi đáp trực tiếp với giảng viên.

-

Các ngành nghề như kế toán, phân tích kinh doanh, quản lý, kỹ thuật đều có khóa học riêng phù hợp, ví dụ: “Artificial Intelligence for Accountants”, “Business Analyst: Digital Director for AI and Data Science”.

-

Khóa “Prompt Engineering Principles”, “Prompt Engineering+: Master Speaking To AI” tập trung kỹ thuật giao tiếp hiệu quả với AI tạo sinh – kỹ năng hot năm 2024-2025.

-

Người học dễ dàng tiếp cận AI, tự trang bị kỹ năng lập trình, tự động hóa video YouTube bằng AI, ứng dụng AI vào công việc và sáng tạo cá nhân mà không tốn phí, phù hợp xu hướng chuyển đổi số.

📌 39 khóa học AI miễn phí trên Udemy giúp mọi người tiếp cận nhanh trí tuệ nhân tạo, từ kiến thức căn bản đến kỹ năng nâng cao như lập trình, Prompt Engineering, nghệ thuật số. Không cần trả phí, học viên có thể tự học mọi lúc, song sẽ không nhận chứng chỉ sau khi hoàn thành.

https://mashable.com/article/free-ai-courses-april-2025

- ChatGPT Search phù hợp khi bạn cần câu trả lời ngay lập tức cho các câu hỏi đơn giản, dữ liệu thời gian thực hoặc thông tin cơ bản. Chức năng này giúp cung cấp thông tin nhanh chóng mà không cần phân tích sâu.

- Khi cần biết về sự kiện hiện tại và cập nhật, như diễn biến chính trị mới nhất hoặc kiểm tra điểm số thể thao, ChatGPT Search có thể nhanh chóng tổng hợp thông tin thời gian thực và các bài báo mới nhất.

- Với nhu cầu tìm hiểu thông tin cơ bản và định nghĩa, ChatGPT Search nổi bật khi bạn nghiên cứu một khái niệm khoa học, học cách viết đúng một từ khó, hoặc tò mò về các sự kiện lịch sử.

- Chức năng tìm kiếm đặc biệt hữu ích khi so sánh các thiết bị, ô tô hoặc bất kỳ hàng tiêu dùng nào khác. Nếu bạn đang tìm hiểu về thông số kỹ thuật của iPhone mới nhất hoặc đọc đánh giá về một chiếc xe, chức năng này sẽ cung cấp dữ liệu mới nhất từ các nguồn đáng tin cậy.

- ChatGPT Search cung cấp thông tin chính xác dựa trên vị trí như dự báo thời tiết, sự kiện gần đây hoặc gợi ý nhà hàng một cách nhanh chóng và dễ dàng.

- ChatGPT Reasoning thể hiện sức mạnh với các nhiệm vụ phức tạp yêu cầu phân tích sâu hoặc tư duy sáng tạo. Khả năng lập luận này đặc biệt giá trị khi giải quyết vấn đề có nhiều lớp hoặc đánh giá nhiều lựa chọn khác nhau.

- Khi cần ý tưởng sáng tạo, chức năng lập luận của ChatGPT tận dụng logic, mẫu và dữ liệu liên quan để giúp phát triển ý tưởng mới hoặc tinh chỉnh những ý tưởng hiện có.

- Trong quá trình phân tích lập luận hoặc ra quyết định, ChatGPT Reasoning là nguồn tham khảo thứ hai thiết yếu, giúp xem xét tất cả các khía cạnh của tình huống, phân tích điểm mạnh và điểm yếu của mỗi lựa chọn.

- Khi cần giải thích các ý tưởng phức tạp như blockchain hoặc học máy, chức năng lập luận của ChatGPT cung cấp lời giải thích chi tiết, dễ hiểu bao gồm cả kiến thức cơ bản và khía cạnh phức tạp.

- Có những trường hợp cần kết hợp cả hai chức năng tìm kiếm và lập luận của ChatGPT để có bức tranh toàn diện hơn. Kết hợp này hiệu quả khi tìm hiểu chủ đề chi tiết, ra quyết định với nhiều biến số, so sánh nhiều lựa chọn hoặc khám phá khái niệm mới.

- Khi nghiên cứu khám phá vũ trụ, bạn có thể tìm kiếm các nhiệm vụ, công nghệ và khám phá mới nhất đồng thời lập luận về tác động tiềm tàng của chúng đối với xã hội, không chỉ thu thập dữ kiện mà còn đánh giá tác động của chúng.

- Khi cân nhắc chuyển đến thành phố mới, bạn sẽ muốn tìm hiểu về giá nhà, tiện ích địa phương và cơ hội việc làm, đồng thời xem xét các yếu tố trừu tượng như thẩm mỹ, lối sống của thành phố và khoảng cách với gia đình hoặc bạn bè.

- Khi so sánh sản phẩm, dịch vụ, hoặc thậm chí con đường sự nghiệp, cả hai chức năng tìm kiếm và lập luận đều cần thiết, giúp thu thập thông tin khách quan và đánh giá lựa chọn phù hợp nhất với mục tiêu cá nhân hoặc nghề nghiệp.

- Khi khám phá một khái niệm hoặc xu hướng mới như trí tuệ nhân tạo, kết hợp tìm kiếm và lập luận giúp thu thập thông tin mới nhất và phân tích tác động tiềm tàng cũng như ý nghĩa rộng lớn hơn của chúng.

📌 Hiểu rõ khi nào sử dụng ChatGPT Search cho dữ liệu thực tế và khi nào cần ChatGPT Reasoning cho phân tích sâu giúp tối ưu trải nghiệm AI. Kết hợp cả hai chức năng mang lại giá trị lớn nhất cho người dùng khi đối mặt với quyết định phức tạp.

https://www.makeuseof.com/chatgpt-search-vs-chatgpt-reasoning/

- OpenAI vừa âm thầm biến Academy thành không gian đào tạo dành cho bất kỳ ai có câu hỏi về AI, với các khóa học được thiết kế cho giáo viên, học sinh, người tìm việc và chủ doanh nghiệp nhỏ.

- Nền tảng trực tuyến này được ra mắt với mục tiêu: làm cho giáo dục AI trở nên miễn phí, linh hoạt và dễ tiếp cận rộng rãi, không chỉ nhắm vào những người làm việc trong lĩnh vực công nghệ.

- Nền tảng bao gồm hướng dẫn, nghiên cứu tình huống thực tế, bài tập thực hành và các module phát triển chuyên môn theo nhịp độ cá nhân, tất cả đều miễn phí và được thiết kế để thực tế.

- Đây là thông báo mới nhất trong loạt động thái của các công ty AI nhằm thâm nhập sâu hơn vào không gian giáo dục, sau khi OpenAI cung cấp ChatGPT Plus miễn phí cho tất cả sinh viên đại học đến cuối tháng 5 và Anthropic ra mắt Claude for Education.

- OpenAI không chỉ tạo nội dung mà còn tập trung vào cộng đồng, với các không gian để người học có thể kết nối, thảo luận và cộng tác, tương tự như mô hình cộng đồng học tập chuyên nghiệp.

- Điểm nổi bật là cách Academy được sử dụng: các trường đại học đang tích hợp nó vào chương trình giảng dạy, các tổ chức phi lợi nhuận điều chỉnh để phục vụ cộng đồng thiệt thòi, và các trung tâm việc làm sử dụng để đào tạo cố vấn nghề nghiệp.

- OpenAI đang nỗ lực dịch nội dung sang nhiều ngôn ngữ và mở rộng quan hệ đối tác trên khắp Mỹ Latinh và châu Á, nhấn mạnh rằng AI là công nghệ toàn cầu.

- OpenAI không phải là công ty duy nhất đẩy mạnh vào giáo dục, với sáng kiến "Grow with Google" của Google và các khóa học AI của Microsoft cũng đang phát triển nhanh chóng, xây dựng xung quanh các công cụ Gemini và Copilot.

- Điều này đặt ra câu hỏi liệu kiến thức về AI có thể thực sự trung lập khi được cung cấp bởi các công ty xây dựng các công cụ đó, và liệu chúng ta đang dạy mọi người suy nghĩ phê phán về AI hay chỉ đào tạo họ sử dụng nó.

- AI đang chuyển từ đối tượng ngách sang phổ biến rộng rãi, trở thành một phần trong cách học sinh viết bài luận, giáo viên lập kế hoạch bài học, người tìm việc soạn CV, và nhu cầu giáo dục về cách sử dụng AI hiệu quả là cấp thiết.

- Academy mới của OpenAI không chỉ là nền tảng học tập mà còn là tín hiệu cho thấy giáo dục AI không phải là một sự xa xỉ mà là cơ sở hạ tầng cơ bản, và giờ đây phụ thuộc vào các nhà giáo dục, cộng đồng và người học để dẫn đầu.

📌 OpenAI đã biến Academy thành nền tảng đào tạo AI miễn phí cho mọi đối tượng, không chỉ người làm công nghệ. Với nội dung đa dạng, tính năng cộng đồng và khả năng tiếp cận toàn cầu, đây là bước đi quan trọng trong việc phổ cập kiến thức AI như một kỹ năng cơ bản.

https://www.forbes.com/sites/danfitzpatrick/2025/04/07/inside-openais-ambitious-ai-education-academy/

- Học tăng cường (reinforcement learning) là nhánh quan trọng của trí tuệ nhân tạo, dựa trên ý tưởng của Alan Turing từ năm 1948 về việc "giáo dục" máy móc thông qua phần thưởng và hình phạt.

- Phương pháp này thiết kế các tác nhân thông minh bằng cách huấn luyện chúng tối đa hóa phần thưởng khi tương tác với môi trường, tương tự cách huấn luyện động vật.

- Andrew Barto và Richard Sutton, những người tiên phong trong lĩnh vực học tăng cường, đã được trao giải thưởng ACM Turing 2024 cho những đóng góp nền tảng của họ.

- Tác nhân trong học tăng cường có thể là phần mềm (như chương trình chơi cờ) hoặc thực thể vật lý (như robot), hoạt động trong môi trường ảo hoặc thực tế.

- Vấn đề cốt lõi của học tăng cường là thiết kế tác nhân đạt được mục tiêu bằng cách nhận thức và hành động trong môi trường, dựa trên giả thuyết rằng mọi mục tiêu đều có thể đạt được bằng cách tối đa hóa tín hiệu phần thưởng.

- Một thành công lớn của học tăng cường là AlphaGo của DeepMind, đã đánh bại kỳ thủ cờ vây hàng đầu Lee Sedol vào năm 2016.

- Gần đây, học tăng cường được sử dụng để cải thiện chatbot như ChatGPT, giúp chúng hữu ích hơn và nâng cao khả năng lập luận.

- Barto và Sutton đã đặt nền móng toán học vững chắc cho lĩnh vực này từ những năm 1980, lấy cảm hứng từ tâm lý học động vật, lý thuyết điều khiển và tối ưu hóa.

- Cuốn sách "Reinforcement Learning: An Introduction" của họ đã ảnh hưởng đến một thế hệ nhà nghiên cứu và được trích dẫn hơn 75.000 lần.

- Học tăng cường còn có tác động bất ngờ đến khoa học thần kinh, giúp giải thích các phát hiện thực nghiệm về hệ thống dopamine ở người và động vật.

- Công trình nền tảng, tầm nhìn và sự ủng hộ của Barto và Sutton đã giúp học tăng cường phát triển, tạo ra tác động lớn đến các ứng dụng thực tế và thu hút đầu tư khổng lồ từ các công ty công nghệ.

📌 Học tăng cường là phương pháp AI dạy máy móc học từ kinh nghiệm qua phần thưởng, từ ý tưởng của Turing năm 1948. Barto và Sutton đã đặt nền móng toán học vững chắc, dẫn đến thành công như AlphaGo và cải tiến ChatGPT, đồng thời mở rộng ứng dụng sang khoa học thần kinh.

https://theconversation.com/what-is-reinforcement-learning-an-ai-researcher-explains-a-key-method-of-teaching-machines-and-how-it-relates-to-training-your-dog-251887

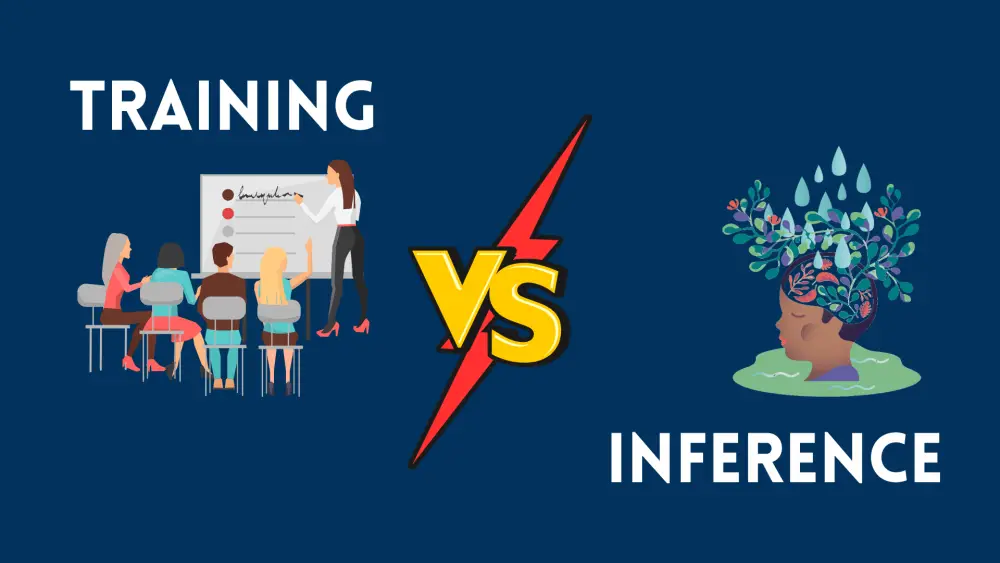

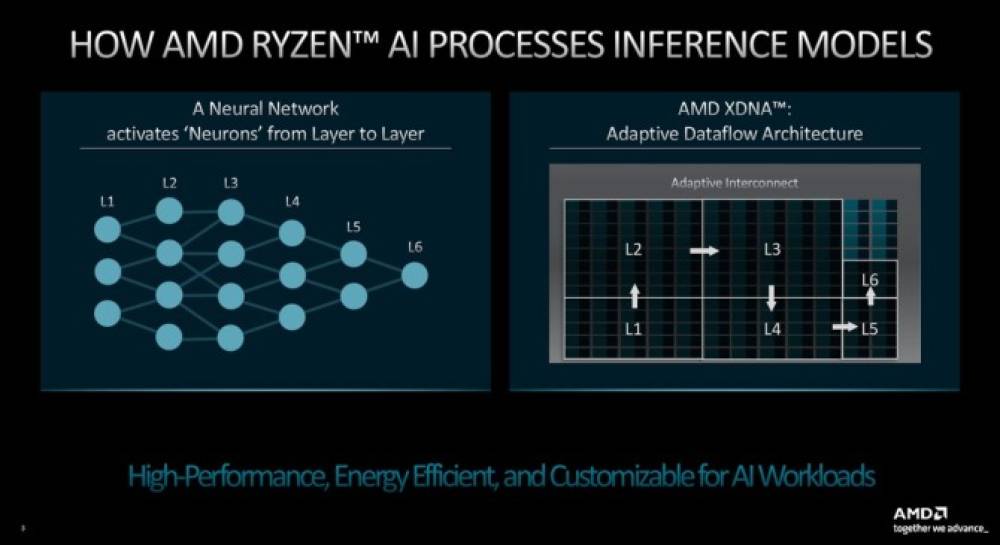

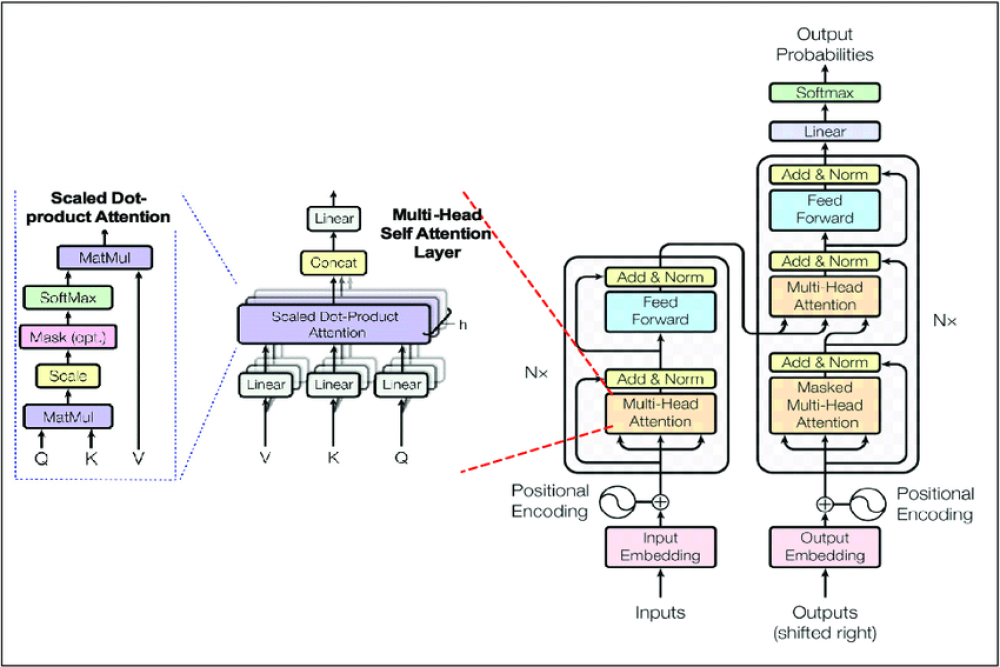

- Training trong học máy hoạt động tương tự não người, với mạng nơ-ron nhân tạo (ANN) và các lớp nút bắt chước nơ-ron sinh học.

- Phương pháp training ban đầu sử dụng "dữ liệu có nhãn" được giám sát bởi con người, sau đó chuyển sang big data cung cấp lượng thông tin khổng lồ trong học tự giám sát và bán giám sát.

- Quá trình học của mô hình học máy diễn ra thông qua thử nghiệm và lỗi với nhiều lần lặp lại để đưa ra dự đoán chính xác - gọi là lan truyền tiến và lan truyền ngược.

- Điểm trọng số được gán cho các tham số dữ liệu khi dữ liệu di chuyển từ lớp này sang lớp khác, đảm bảo điểm trọng số chính xác và tạo ra kết quả đầu ra chính xác.

- Inference là quá trình mô hình học máy xử lý dữ liệu không nhãn, đưa ra kết luận dựa trên bằng chứng và lý luận.

- Trong quá trình inference, mô hình so sánh các tham số của dữ liệu mới với thông tin đã học được trong giai đoạn training và testing.

- Con người can thiệp vào kết quả đầu ra của mô hình để tạo dữ liệu có nhãn, được sử dụng cho quá trình training mô hình trong tương lai.

- Sự can thiệp của con người giúp cải thiện mô hình bằng cách đảm bảo kết quả đầu ra chính xác và nâng cao mức độ chính xác.

- Training và inference có mối liên hệ sâu sắc với nhau: training tạo nền tảng cho mô hình hiểu mẫu, mối quan hệ và ngữ cảnh trong dữ liệu; inference áp dụng kiến thức đã học vào tình huống thực tế.

- Không có training sẽ không có inference, và không có inference sẽ không có phản hồi để cung cấp cho giai đoạn training.

- Việc lặp đi lặp lại quá trình training và inference là điều đang làm cho trí tuệ nhân tạo ngày càng thông minh và hiệu quả hơn.

- Nisha Arya, tác giả bài viết, là nhà khoa học dữ liệu, biên tập viên và quản lý cộng đồng cho KDnuggets, quan tâm đến việc cung cấp lời khuyên về nghề nghiệp khoa học dữ liệu.

📌 Training và inference tạo nên liên minh không thể tách rời trong AI tạo sinh. Training xây dựng nền tảng hiểu biết cho mô hình, trong khi inference áp dụng kiến thức này vào thực tế. Chu trình lặp lại liên tục giữa hai quá trình này là chìa khóa làm cho AI ngày càng thông minh hơn.

https://www.kdnuggets.com/training-vs-inference-the-ultimate-alliance

50 thuật ngữ AI mà mọi người nên biết

AI đang trở thành một phần trong cuộc sống hàng ngày của chúng ta. Để không bị lạc hậu trong các cuộc trò chuyện, đây là 50 thuật ngữ quan trọng bạn cần biết, được sắp xếp theo thứ tự:

-

Trí tuệ nhân tạo tổng quát (artificial general intelligence, hay AGI): Một khái niệm đề xuất một phiên bản AI tiên tiến hơn những gì chúng ta biết hiện nay, phiên bản có thể thực hiện các nhiệm vụ tốt hơn nhiều so với con người đồng thời tự dạy và nâng cao khả năng của mình.

-

Agentive: Hệ thống hoặc mô hình thể hiện khả năng tự chủ với khả năng tự động thực hiện hành động để đạt được mục tiêu. Trong bối cảnh AI, một mô hình agentive có thể hoạt động mà không cần giám sát liên tục, chẳng hạn như một chiếc xe tự lái cấp cao.

-

Đạo đức AI (AI ethics): Các nguyên tắc nhằm ngăn AI gây hại cho con người, đạt được thông qua các phương tiện như xác định cách hệ thống AI nên thu thập dữ liệu hoặc đối phó với thiên kiến.

-

An toàn AI (AI safety): Một lĩnh vực liên ngành quan tâm đến tác động lâu dài của AI và cách nó có thể tiến triển đột ngột thành một siêu trí tuệ có thể thù địch với con người.

-

Thuật toán (algorithm): Một chuỗi hướng dẫn cho phép chương trình máy tính học và phân tích dữ liệu theo một cách cụ thể, chẳng hạn như nhận biết mẫu, để sau đó học từ đó và tự hoàn thành các nhiệm vụ.

-

Căn chỉnh (alignment): Điều chỉnh AI để tạo ra kết quả mong muốn tốt hơn. Điều này có thể đề cập đến bất cứ điều gì từ kiểm duyệt nội dung đến duy trì tương tác tích cực đối với con người.

-

Nhân hóa (anthropomorphism): Khi con người có xu hướng gán các đặc điểm giống con người cho các đối tượng phi nhân. Trong AI, điều này có thể bao gồm tin rằng một chatbot giống con người và có nhận thức hơn thực tế.

-

Trí tuệ nhân tạo (artificial intelligence), hay AI: Việc sử dụng công nghệ để mô phỏng trí thông minh của con người, trong chương trình máy tính hoặc người máy. Một lĩnh vực trong khoa học máy tính nhằm xây dựng hệ thống có thể thực hiện các nhiệm vụ của con người.

-

Tác nhân tự động (autonomous agents): Một mô hình AI có khả năng, lập trình và các công cụ khác để hoàn thành một nhiệm vụ cụ thể. Một chiếc xe tự lái là một tác nhân tự động.

-

Thiên kiến (bias): Đối với các mô hình ngôn ngữ lớn, lỗi do dữ liệu huấn luyện. Điều này có thể dẫn đến việc gán sai các đặc điểm nhất định cho các chủng tộc hoặc nhóm nhất định dựa trên định kiến.

-

Chatbot: Một chương trình giao tiếp với con người thông qua văn bản mô phỏng ngôn ngữ của con người.

-

ChatGPT: Một chatbot AI được phát triển bởi OpenAI sử dụng công nghệ mô hình ngôn ngữ lớn.

-

Điện toán nhận thức (cognitive computing): Một thuật ngữ khác cho trí tuệ nhân tạo.

-

Tăng cường dữ liệu (data augmentation): Trộn lại dữ liệu hiện có hoặc thêm một tập dữ liệu đa dạng hơn để huấn luyện AI.

-

Học sâu (deep learning): Một phương pháp AI, và một lĩnh vực con của học máy, sử dụng nhiều tham số để nhận biết các mẫu phức tạp trong hình ảnh, âm thanh và văn bản.

-

Khuếch tán (diffusion): Một phương pháp học máy lấy một phần dữ liệu hiện có, như một bức ảnh, và thêm nhiễu ngẫu nhiên. Các mô hình khuếch tán huấn luyện mạng lưới của chúng để tái tạo hoặc khôi phục bức ảnh đó.

-

Hành vi nổi (emergent behavior): Khi một mô hình AI thể hiện khả năng không dự đoán trước.

-

Học tập đầu-cuối (end-to-end learning), hay E2E: Một quá trình học sâu trong đó một mô hình được hướng dẫn thực hiện một nhiệm vụ từ đầu đến cuối.

-

Xem xét đạo đức (ethical considerations): Nhận thức về ý nghĩa đạo đức của AI và các vấn đề liên quan đến quyền riêng tư, sử dụng dữ liệu, công bằng, lạm dụng và các vấn đề an toàn khác.

-

Foom: Còn được gọi là khởi động nhanh hoặc khởi động cứng. Khái niệm rằng nếu ai đó xây dựng một AGI thì có thể đã quá muộn để cứu nhân loại.

-

Mạng đối kháng tạo sinh (generative adversarial networks), hay GANs: Một mô hình AI tạo sinh bao gồm hai mạng thần kinh để tạo ra dữ liệu mới: một bộ tạo và một bộ phân biệt.

-

AI tạo sinh (generative AI): Một công nghệ tạo nội dung sử dụng AI để tạo văn bản, video, mã máy tính hoặc hình ảnh.

-

Google Gemini: Một chatbot AI của Google hoạt động tương tự như ChatGPT nhưng lấy thông tin từ web hiện tại, trong khi ChatGPT bị giới hạn ở dữ liệu cho đến năm 2021.

-

Rào chắn bảo vệ (guardrails): Chính sách và hạn chế đặt ra cho các mô hình AI để đảm bảo dữ liệu được xử lý có trách nhiệm và mô hình không tạo ra nội dung gây khó chịu.

-

Ảo giác (hallucination): Một phản hồi không chính xác từ AI. Có thể bao gồm AI tạo sinh tạo ra câu trả lời không chính xác nhưng được nêu ra với sự tự tin như thể chính xác.

-

Suy luận (inference): Quá trình các mô hình AI sử dụng để tạo văn bản, hình ảnh và nội dung khác về dữ liệu mới, bằng cách suy ra từ dữ liệu huấn luyện của chúng.

-

Mô hình ngôn ngữ lớn (large language model), hay LLM: Một mô hình AI được huấn luyện trên một lượng lớn dữ liệu văn bản để hiểu ngôn ngữ và tạo ra nội dung mới bằng ngôn ngữ giống con người.

-

Độ trễ (latency): Thời gian chậm trễ từ khi hệ thống AI nhận được đầu vào hoặc lệnh và tạo ra đầu ra.

-

Học máy (machine learning), hay ML: Một thành phần trong AI cho phép máy tính học và đưa ra kết quả dự đoán tốt hơn mà không cần lập trình rõ ràng.

-

Microsoft Bing: Một công cụ tìm kiếm của Microsoft hiện có thể sử dụng công nghệ cung cấp sức mạnh cho ChatGPT để đưa ra kết quả tìm kiếm được hỗ trợ bởi AI.

-

AI đa phương thức (multimodal AI): Một loại AI có thể xử lý nhiều loại đầu vào, bao gồm văn bản, hình ảnh, video và giọng nói.

-

Xử lý ngôn ngữ tự nhiên (natural language processing): Một nhánh của AI sử dụng học máy và học sâu để cung cấp cho máy tính khả năng hiểu ngôn ngữ của con người.

-

Mạng thần kinh (neural network): Một mô hình tính toán có cấu trúc giống với cấu trúc não bộ con người và được thiết kế để nhận biết các mẫu trong dữ liệu.

-

Overfitting (quá khớp): Lỗi trong học máy khi nó hoạt động quá sát với dữ liệu huấn luyện và có thể chỉ có thể nhận biết các ví dụ cụ thể trong dữ liệu đó nhưng không phải dữ liệu mới.

-

Paperclips: Lý thuyết Paperclip Maximiser, được đặt tên bởi triết gia Nick Boström, là một kịch bản giả định trong đó một hệ thống AI sẽ tạo ra càng nhiều kẹp giấy càng tốt đến mức có thể tiêu diệt nhân loại.

-

Tham số (parameters): Các giá trị số học cung cấp cấu trúc và hành vi cho LLM, cho phép nó đưa ra dự đoán.

-

Perplexity: Tên của một chatbot và công cụ tìm kiếm được hỗ trợ bởi AI thuộc sở hữu của Perplexity AI. Nó sử dụng một mô hình ngôn ngữ lớn để trả lời câu hỏi với câu trả lời mới.

-

Prompt: Gợi ý hoặc câu hỏi bạn nhập vào chatbot AI để nhận phản hồi.

-

Chuỗi prompt (prompt chaining): Khả năng của AI sử dụng thông tin từ các tương tác trước đó để tô màu cho các phản hồi trong tương lai.

-

Vẹt ngẫu nhiên (stochastic parrot): Một phép so sánh của LLM minh họa rằng phần mềm không có sự hiểu biết lớn hơn về ý nghĩa đằng sau ngôn ngữ hoặc thế giới xung quanh nó, bất kể đầu ra nghe có vẻ thuyết phục như thế nào.

-

Chuyển đổi phong cách (style transfer): Khả năng thích ứng phong cách của một hình ảnh với nội dung của một hình ảnh khác, cho phép AI diễn giải các thuộc tính hình ảnh của một hình ảnh và sử dụng nó trên một hình ảnh khác.

-

Nhiệt độ (temperature): Tham số được thiết lập để kiểm soát mức độ ngẫu nhiên của đầu ra mô hình ngôn ngữ. Nhiệt độ cao hơn có nghĩa là mô hình mạo hiểm hơn.

-

Tạo ảnh từ văn bản (text-to-image generation): Tạo hình ảnh dựa trên mô tả văn bản.

-

Token: Các phần nhỏ của văn bản được viết mà các mô hình ngôn ngữ AI xử lý để đưa ra phản hồi cho prompt của bạn. Một token tương đương với bốn ký tự trong tiếng Anh, hoặc khoảng ba phần tư của một từ.

-

Dữ liệu huấn luyện (training data): Các bộ dữ liệu được sử dụng để giúp các mô hình AI học, bao gồm văn bản, hình ảnh, mã hoặc dữ liệu.

-

Mô hình transformer: Một kiến trúc mạng thần kinh và mô hình học sâu học ngữ cảnh bằng cách theo dõi các mối quan hệ trong dữ liệu, như trong câu hoặc các phần của hình ảnh.

-

Kiểm tra Turing (turing test): Được đặt theo tên của nhà toán học Alan Turing, nó kiểm tra khả năng của máy móc để hành xử giống như con người. Máy vượt qua nếu con người không thể phân biệt phản hồi của máy với phản hồi của con người khác.

-

Học không giám sát (unsupervised learning): Một hình thức học máy trong đó dữ liệu huấn luyện có nhãn không được cung cấp cho mô hình và thay vào đó mô hình phải tự xác định các mẫu trong dữ liệu.

-

AI yếu (weak AI), còn gọi là AI hẹp (narrow AI): AI tập trung vào một nhiệm vụ cụ thể và không thể học vượt ra ngoài bộ kỹ năng của nó. Hầu hết AI ngày nay là AI yếu.

-

Claude: Chatbot AI được phát triển bởi Anthropic, được thiết kế để là trợ lý AI hữu ích, trung thực và vô hại.

Nguồn: Dựa trên bài viết của Imad Khan, ngày 4 tháng 4 năm 2025

https://www.cnet.com/tech/services-and-software/chatgpt-glossary-50-ai-terms-everyone-should-know/

- Microsoft tổ chức sự kiện AI Skills Fest kéo dài 50 ngày vào tháng 4 và tháng 5, mở cửa miễn phí cho mọi đối tượng từ người mới bắt đầu đến chuyên gia.

- Mục tiêu của Microsoft là thiết lập kỷ lục Guinness thế giới về "số lượng người dùng hoàn thành bài học AI trực tuyến nhiều cấp độ trong 24 giờ" lớn nhất.

- Kỷ lục hiện tại là 46.045 người tham gia, được thiết lập bởi GUVI Geek Network Private Limited và chính phủ Uttar Pradesh, Ấn Độ vào năm ngoái.

- Khóa học bao gồm nhiều chủ đề từ giới thiệu về AI đến các khái niệm cốt lõi như học máy, thị giác máy tính, xử lý ngôn ngữ tự nhiên và các công cụ thực hành như Azure và Copilot.

- Bài học được cung cấp bằng 39 ngôn ngữ khác nhau, bao gồm cả tiếng Việt.

- Sự kiện chính - nỗ lực lập kỷ lục thế giới - diễn ra từ 23:00 UTC ngày 7 tháng 4 đến 23:00 UTC ngày 8 tháng 4 năm 2025.

- Ngoài các bài học, sự kiện còn có hackathon, học tập tự định hướng, thử thách, diễn đàn cộng đồng và gặp gỡ trực tiếp.

- Người tham gia có cơ hội nhận được phiếu giảm giá chứng chỉ, mã giảm giá 50% cho kỳ thi chứng chỉ GitHub Copilot mới nhất và huy hiệu tham gia.

- Microsoft cung cấp 50.000 phiếu chứng chỉ miễn phí thông qua rút thăm hàng tuần trong cuộc thi Microsoft AI Skills Fest Challenge.

- Để đăng ký, người dùng cần truy cập trang đăng ký Microsoft AI Skills Fest và xác nhận đủ 18 tuổi trở lên.

📌 Microsoft tổ chức sự kiện AI Skills Fest 50 ngày miễn phí, nhằm lập kỷ lục Guinness thế giới với hơn 46.045 người tham gia học AI trực tuyến trong 24 giờ. Sự kiện cung cấp khóa học AI đa cấp độ bằng 39 ngôn ngữ, cùng cơ hội nhận chứng chỉ và giảm giá đặc biệt.

https://www.zdnet.com/article/microsofts-free-ai-skills-training-fest-starts-next-week-anyone-can-sign-up/

-

Cửa sổ ngữ cảnh (context window) là một trong những thành phần ít được chú ý nhưng lại cực kỳ quan trọng trong các hệ thống trí tuệ nhân tạo hiện đại, đặc biệt là chatbot và trợ lý ảo.

-

Về cơ bản, cửa sổ ngữ cảnh là bộ nhớ tạm thời lưu giữ các đoạn hội thoại trước đó giữa người dùng và mô hình AI, giúp duy trì dòng đối thoại liền mạch.

-

Ví dụ: nếu bạn hỏi AI dân số Berlin, rồi tiếp tục hỏi “các quán cafe tốt nhất ở đó”, mô hình cần nhớ “Berlin” là chủ đề trước đó để trả lời chính xác câu tiếp theo.

-

Thiếu cửa sổ ngữ cảnh hoặc kích thước quá nhỏ sẽ khiến mô hình dễ “quên” nội dung đã nói, dẫn đến trả lời sai lệch hoặc thậm chí là… bịa chuyện (hallucinate).

-

Kích thước cửa sổ được đo bằng token – đơn vị xử lý của AI, trong đó mỗi token tương đương khoảng 4 ký tự (ví dụ: 100 token ≈ 75 từ tiếng Anh).

-

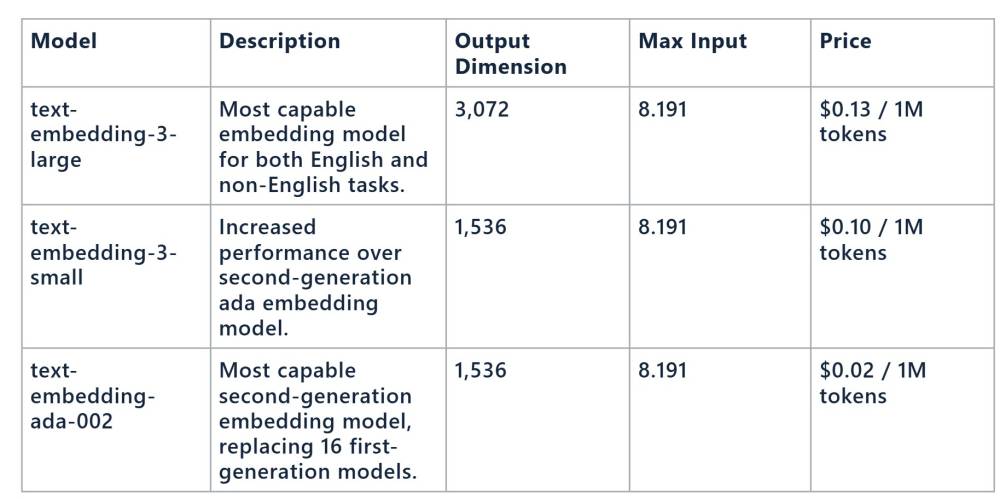

Các mô hình AI hiện nay có cửa sổ dao động từ 8.192 token đến hơn 2 triệu token (Google Gemini). Mức phổ biến là 128.000 token (~1.200 từ).

-

Cửa sổ càng lớn, AI càng có khả năng theo dõi các đoạn hội thoại dài, đa tầng, nhiều chủ đề – điều kiện bắt buộc cho các mô hình có khả năng “tư duy” sâu hơn.

-

Trong các mô hình có chế độ "tư duy mở rộng" (extended thinking), như Claude 3.7 hoặc GPT-4o, cửa sổ ngữ cảnh lớn cho phép AI tạm dừng và cân nhắc nhiều khả năng trước khi trả lời – thay thế cách yêu cầu “suy nghĩ từng bước một” trong các prompt truyền thống.

-

Các mô hình hiện đại sử dụng context window trượt: khi tin nhắn mới được thêm vào, phần cũ ở đầu sẽ bị loại bỏ để giữ tổng số token ổn định.

-

Điều này giúp AI luôn có khả năng tham chiếu lại những phần hội thoại gần đây nhất, giữ tính mạch lạc trong trả lời.

-

Khi yêu cầu của người dùng vượt quá kích thước cửa sổ, AI có thể trả lời không liên quan hoặc bịa đặt. Đó là lý do vì sao các câu hỏi phức tạp cần mô hình có context window lớn.

-

Dù vậy, context window lớn đồng nghĩa với tiêu tốn tài nguyên tính toán cao hơn, nên thường chỉ áp dụng trong các mô hình đám mây. Các mô hình AI nguồn mở hoặc chạy cục bộ có giới hạn thấp hơn do hạn chế phần cứng.

-

Tuy nhiên, nhờ quá trình tối ưu hóa và cải tiến liên tục, các mô hình chạy cục bộ nhỏ với context window thấp vẫn đang ngày càng trở nên hữu ích trong thực tế.

📌 Context window là bộ nhớ tạm cho phép AI ghi nhớ nội dung hội thoại trước đó, giúp duy trì mạch trò chuyện, hiểu được ngữ cảnh sâu, và đưa ra phản hồi chính xác hơn. Kích thước càng lớn, AI càng xử lý tốt các yêu cầu phức tạp, nhưng cũng đòi hỏi nhiều tài nguyên tính toán. Trong các mô hình AI hiện đại, đây là yếu tố then chốt để AI thực sự “tư duy” như con người.

https://www.techradar.com/pro/why-are-ai-context-windows-important

-

Andrew Ng, giáo sư Stanford và cựu nhà khoa học tại Google Brain, vừa ra mắt khóa học "Vibe Coding 101" dành cho người mới học cách sử dụng công cụ AI tạo sinh để viết và quản lý mã.

-

Thuật ngữ "vibe coding" được đồng sáng lập OpenAI Andrej Karpathy đặt ra vào tháng 2, mô tả cách phát triển phần mềm ngày càng được tự động hóa bởi các agent AI thông qua lệnh từ con người.

-

Khóa học kéo dài 94 phút được xây dựng hợp tác với công ty AI agent Replit, do Michele Catasta (chủ tịch Replit) và Matt Palmer (trưởng bộ phận quan hệ nhà phát triển) giảng dạy.

-

Andrew Ng nhấn mạnh rằng mặc dù agent lập trình đang thay đổi cách viết mã, nhưng "việc yêu cầu LLM làm mọi thứ trong một lần thường không hiệu quả".

-

Khóa học tập trung vào các nguyên tắc chính như: giao cho agent một nhiệm vụ mỗi lần, đưa ra lệnh cụ thể, và cung cấp phương pháp tiếp cận rõ ràng để gỡ lỗi.

-

Người tham gia sẽ học cách xây dựng và triển khai ứng dụng web với agent AI, cũng như cách tự động hóa các phần quan trọng trong quá trình phát triển phần mềm.

-

Ng cho biết ông thường xuyên sử dụng mô hình ngôn ngữ lớn (LLM) để lập trình, và khóa học này sẽ giúp người học có nền tảng vững chắc để xây dựng với agent lập trình.

-

Vibe coding không chỉ thu hút các kỹ sư phần mềm dày dạn kinh nghiệm muốn tăng tốc công việc mà còn hấp dẫn những người ít kinh nghiệm lập trình.

-

Khóa học cũng dạy cách sử dụng công cụ AI như Replit để tự động hóa các phần quan trọng trong quy trình phát triển phần mềm, chẳng hạn như xây dựng nguyên mẫu ứng dụng.

-

Andrew Ng khẳng định: "Khi kết thúc khóa học này, bạn sẽ có nền tảng vững chắc trong việc xây dựng với agent lập trình, và một quy trình có thể sử dụng để tiếp tục vibe coding hiệu quả."

📌 Andrew Ng đã ra mắt khóa học "Vibe Coding 101" kéo dài 94 phút hợp tác với Replit, giúp người học nắm bắt cách sử dụng AI tạo sinh trong lập trình. Khóa học nhấn mạnh việc giao nhiệm vụ từng bước cho AI thay vì yêu cầu làm mọi thứ cùng lúc.

https://www.businessinsider.com/andrew-ng-ai-learn-vibe-coding-course-replit-2025-3

-

OpenAI vừa ra mắt OpenAI Academy - một trung tâm tài nguyên trực tuyến miễn phí nhằm "hỗ trợ kiến thức về AI và giúp mọi người từ mọi nền tảng tiếp cận công cụ, phương pháp tốt nhất và hiểu biết từ đồng nghiệp để sử dụng AI hiệu quả và có trách nhiệm hơn".

-

OpenAI Academy cung cấp nhiều hình thức học tập đa dạng bao gồm sự kiện trực tiếp, phát trực tuyến và nội dung để người dùng tự khám phá theo tốc độ riêng.

-

Người dùng có thể truy cập OpenAI Academy hoàn toàn miễn phí, chỉ cần đăng ký một tài khoản.

-

Ban đầu, OpenAI Academy được ra mắt dưới dạng sự kiện trực tiếp, nhưng giờ đây các tài nguyên đã được cung cấp cho bất kỳ ai có kết nối internet.

-

Nền tảng này bao gồm các hướng dẫn đa dạng từ cách bắt đầu với Sora và cách tạo storyboard, đến cách tạo GPT tùy chỉnh và sử dụng Deep Research trong ChatGPT.

-

Đây được xem là một nguồn tài nguyên quý giá, đặc biệt khi nhiều công ty đang tính phí cho các khóa học về AI.

-

OpenAI Academy có thể trở thành nguồn tài liệu tham khảo chính cho người dùng về ChatGPT và Sora, phù hợp cho cả người dùng hàng ngày lẫn người mới bắt đầu còn e ngại vì cảm thấy bị choáng ngợp.

-

Nền tảng này được thiết kế để hỗ trợ người dùng trong bối cảnh AI đang phát triển nhanh chóng và thay đổi cách chúng ta tương tác với công nghệ.

-

OpenAI Academy được xem là một "kinh thánh AI" giúp người dùng làm chủ các công cụ AI tạo sinh của OpenAI.

-

Thông báo về OpenAI Academy được đăng trên blog của công ty, khẳng định đây là một bước đi quan trọng trong việc phổ cập kiến thức về AI.

📌 OpenAI Academy là trung tâm tài nguyên miễn phí mới ra mắt, cung cấp hướng dẫn toàn diện về ChatGPT và Sora thông qua sự kiện trực tiếp, phát trực tuyến và nội dung tự học, giúp người dùng từ mọi nền tảng sử dụng AI hiệu quả và có trách nhiệm.

https://www.techradar.com/computing/artificial-intelligence/openai-just-launched-a-free-chatgpt-bible-that-will-help-you-master-the-ai-chatbot-and-sora

-

Reid Hoffman, đồng sáng lập LinkedIn, cho rằng tất cả mọi người đều có thể tìm ra cách làm cho AI trở nên hữu ích cho họ.

-

Ông nói với podcast của The Economist: "Thẳng thắn mà nói, nếu bạn chưa tìm thấy điều gì đó hữu ích từ AI, về điều gì đó bạn quan tâm, thì bạn chưa cố gắng đủ, bạn chưa đủ sáng tạo."

-

Hoffman thường xuyên sử dụng ChatGPT-4 để học các chủ đề mới, ví dụ như đưa vào một bài báo nghiên cứu về cơ học lượng tử và yêu cầu giải thích ở các mức độ phức tạp khác nhau - như thể ông 12 tuổi, 18 tuổi, hoặc là sinh viên vật lý.

-

Ông cũng sử dụng công cụ Deep Research của OpenAI, mô tả nó như một "trợ lý nghiên cứu đại học siêu mạnh", mặc dù thừa nhận nó "thiếu một chút lẽ thường" và đôi khi cung cấp thông tin không chính xác.

-

Dù phải kiểm tra chéo thông tin, Hoffman cho biết công cụ này vẫn tiết kiệm cho ông "hàng chục giờ làm việc" và là công cụ ông sử dụng thường xuyên.

-

Trong vai trò nhà đầu tư mạo hiểm, Hoffman đưa các slide PowerPoint về mô hình kinh doanh của startup vào công cụ AI và yêu cầu tạo kế hoạch thẩm định.

-

Ông nói: "Nó tạo ra một kế hoạch thẩm định hiệu quả trong khoảng 2 phút", và mặc dù một số điều có thể hiển nhiên, nhưng nó cung cấp các gợi ý khác mà ông "sẽ không nghĩ ra trong hai hoặc ba ngày".

-

Trái ngược với sự lạc quan của Hoffman về AI, một khảo sát của Trung tâm Nghiên cứu Pew cho thấy 81% người lao động Mỹ là "người không sử dụng AI".

-

Hoffman rất lạc quan về AI và đã xuất bản cuốn sách mới vào tháng này có tên "Superagency", trình bày quan điểm tích cực về tương lai AI của nhân loại.

-

Ông cũng sử dụng AI để hỗ trợ phản hồi cho cuốn sách - bao gồm việc yêu cầu AI phê bình các chương từ các góc nhìn khác nhau, chẳng hạn như từ góc nhìn của một giáo sư châu Âu về lịch sử công nghệ.

📌 Reid Hoffman, đồng sáng lập LinkedIn, khuyến khích mọi người tìm cách sử dụng AI hiệu quả trong khi 81% người lao động Mỹ vẫn chưa áp dụng. Ông minh họa giá trị của AI qua việc tiết kiệm hàng chục giờ nghiên cứu và tạo kế hoạch thẩm định chỉ trong 2 phút.

https://www.businessinsider.com/reid-hoffman-ai-tips-linkedin-chatgpt-learning-investing-2025-3

-

AI agent đang thay đổi thế giới kinh doanh, nhiều doanh nhân nghe đến thuật ngữ này nhưng không hiểu ý nghĩa hoặc cách áp dụng. Những người áp dụng sớm sẽ vượt lên trước.

-

AI agent không phải là xu hướng thoáng qua mà đang thay đổi cách doanh nghiệp vận hành. Hầu hết lãnh đạo doanh nghiệp lãng phí thời gian vào các nhiệm vụ nên tự động hóa, nhưng AI agent có thể xử lý những nhiệm vụ đó.

-

Trí tuệ nhân tạo tự nó chỉ là trí thông minh thô. Nó là động cơ nhưng không phải là chiếc xe. Nhiều người nghĩ AI đồng nghĩa với ChatGPT, nhưng điều đó hạn chế. Sự thay đổi thật sự xảy ra khi AI được ghép nối với các nhiệm vụ cụ thể - đó chính là AI agent.

-

AI agent làm việc 24/7, không nghỉ ngơi, không mắc lỗi ngớ ngẩn. Trong khi người khác vẫn đang mày mò với các lệnh prompt cơ bản, doanh nhân thông minh đã xây dựng AI agent để xử lý toàn bộ quy trình trong doanh nghiệp.

-

AI agent hoạt động như một trợ lý cá nhân cực kỳ hiệu quả. Trong khi AI cơ bản trả lời câu hỏi, AI agent thực hiện hành động. Nó không chỉ nói cách đặt lịch hẹn - nó đặt lịch cho bạn. Nó không chỉ soạn email - nó gửi chúng đi.

-

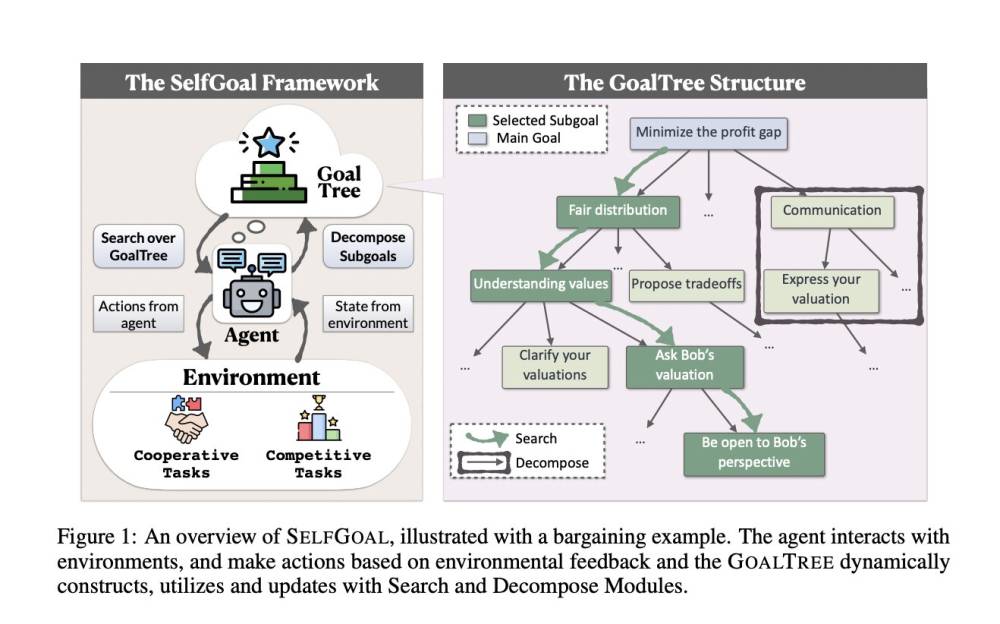

Mọi AI agent đều tuân theo mô hình ba bước: hiểu, suy nghĩ và hành động. Đầu tiên, chúng tiếp nhận yêu cầu. Thứ hai, xử lý và tìm cách tiếp cận tốt nhất. Thứ ba, thực hiện hành động để hoàn thành công việc.

-

AI agent học hỏi trong quá trình làm việc. Càng làm việc với AI agent, nó càng trở nên tốt hơn. Nó học hỏi sở thích, dự đoán nhu cầu và thích ứng với phong cách của bạn.

-

AI agent không tồn tại độc lập. Chúng kết nối với các công cụ bạn đang sử dụng như lịch, email, CRM, mạng xã hội. Điều này cho phép chúng phối hợp trong toàn bộ hệ sinh thái kinh doanh của bạn.

-

Bạn có thể bắt đầu nhỏ với AI agent. Hãy để một agent quản lý lịch và nhắc nhở khách hàng, một agent khác quản lý bài đăng mạng xã hội, một agent thứ ba phân tích cuộc trò chuyện với khách hàng để tìm ra mẫu hình và thông tin chi tiết.

📌 AI agent đang tạo ra cuộc cách mạng trong kinh doanh với khả năng làm việc 24/7, không mắc lỗi và học hỏi liên tục. Doanh nghiệp áp dụng sớm công nghệ này sẽ có lợi thế cạnh tranh lớn, tự động hóa các quy trình và tập trung vào các quyết định chiến lược quan trọng hơn.

https://www.forbes.com/sites/jodiecook/2025/03/18/ai-agents-explained-in-simple-terms-anyone-can-understand/

AI Agents: Giải thích đơn giản để ai cũng hiểu

Jodie Cook – 18 tháng 3, 2025, 09:00 AM EDT

AI agents đang dần chiếm lĩnh thế giới kinh doanh của bạn. Ngày càng có nhiều doanh nhân nghe thấy thuật ngữ này nhưng không biết nó có nghĩa là gì hay nó áp dụng như thế nào trong thực tế. Nó vừa phức tạp, vừa mang tính kỹ thuật, và lại thay đổi nhanh chóng. Nếu tụt lại phía sau, những người mới tham gia sẽ giành được cơ hội kinh doanh mà bạn có thể đã nắm bắt được.

AI agents không phải là một xu hướng nhất thời. Chúng đang thay đổi cách các doanh nghiệp vận hành. Hầu hết các nhà lãnh đạo doanh nghiệp đang lãng phí thời gian vào những công việc nên được tự động hóa, nhưng AI agents có thể xử lý những công việc đó, cho phép bạn tập trung vào các quyết định thúc đẩy sứ mệnh kinh doanh. Những người áp dụng AI agents sớm sẽ vươn lên dẫn đầu.

Dưới đây là AI agents là gì, vì sao chúng quan trọng đối với bạn và chúng sẽ thay đổi doanh nghiệp của bạn mãi mãi như thế nào.

Vì sao AI agents quan trọng đối với bạn ngay lúc này

AI tự thân nó chỉ là trí tuệ thô. Nó là động cơ chứ không phải là chiếc xe. Hầu hết mọi người đều cho rằng AI chỉ là ChatGPT, nhưng đó là cách hiểu hạn chế. Yếu tố thay đổi cuộc chơi thực sự là khi AI được ghép nối với các nhiệm vụ cụ thể. Đó chính là AI agents.

AI agents đại diện cho một sự thay đổi cơ bản trong cách các doanh nghiệp vận hành. Các agent làm việc 24/7. Chúng không nghỉ phép. Chúng không phạm sai lầm ngớ ngẩn. Khi mọi người vẫn đang loay hoay với các câu lệnh cơ bản, những doanh nhân thông minh đã xây dựng AI agents để xử lý toàn bộ quy trình trong doanh nghiệp của họ.

Hiểu AI agents (không cần thuật ngữ kỹ thuật)

Chúng hoạt động như một trợ lý hoàn hảo

Hãy nghĩ về một AI agent như là trợ lý cá nhân hiệu quả nhất thế giới. AI cơ bản chỉ trả lời câu hỏi, còn AI agent thì thực hiện hành động. Nó không chỉ nói cho bạn cách đặt lịch hẹn — nó sẽ đặt lịch cho bạn. Nó không chỉ soạn thảo email — nó sẽ gửi email. Nó không chỉ nhớ sở thích của khách hàng — nó sử dụng chúng để cá nhân hóa các tương tác mà bạn không cần phải làm gì cả.

Hiện nay, có các công cụ cho phép bạn giải thích quy trình, tích hợp với phần mềm bạn đang sử dụng, và nhấn "bắt đầu." Doanh nghiệp của bạn vận hành nhờ các tác vụ. AI agents sẽ thực hiện các tác vụ đó. Đây là sức mạnh bạn không thể bỏ qua.

Chúng tuân theo một mô hình đơn giản

Mỗi AI agent đều tuân theo cùng một mô hình 3 bước: hiểu, suy nghĩ và hành động.

- Đầu tiên, nó tiếp nhận yêu cầu của bạn.

- Tiếp theo, nó xử lý yêu cầu và tìm ra cách tiếp cận tốt nhất.

- Cuối cùng, nó thực hiện hành động để hoàn thành công việc.

Khi bạn tạo một quy trình tự động, agent sẽ hiểu yêu cầu. Nó luôn sẵn sàng suy nghĩ và hành động, cung cấp kết quả cho bạn 24/7.

Mô hình 3 bước này biến AI từ trạng thái bị động sang trạng thái chủ động. Đây là sự khác biệt giữa một nhân viên cần được giám sát liên tục và một nhân viên có thể tự xử lý công việc.

Chúng học hỏi khi làm việc

Càng làm việc với AI agent, nó càng trở nên tốt hơn. Cũng giống như một thành viên mới trong nhóm, nó cải thiện theo kinh nghiệm. Nó học được sở thích của bạn, dự đoán nhu cầu của bạn và điều chỉnh theo phong cách của bạn. Qua thời gian, AI agent của bạn sẽ trở thành một công cụ độc nhất, phù hợp với nhu cầu của bạn.

Điều này có nghĩa là các doanh nhân bắt đầu sử dụng AI agents ngay bây giờ sẽ có lợi thế lớn so với những người chờ đợi. AI của bạn sẽ phát triển cùng bạn, trở nên ngày càng giá trị theo từng tháng.

Chúng kết nối với các công cụ bạn đã sử dụng

AI agents không tồn tại độc lập. Chúng tích hợp với các công cụ bạn đã sử dụng, như lịch, email, CRM, mạng xã hội và nhiều công cụ khác. Điều này có nghĩa là chúng có thể phối hợp trên toàn bộ hệ sinh thái kinh doanh của bạn.

Thay vì nhảy qua lại giữa các ứng dụng và tự chuyển dữ liệu theo cách thủ công, AI agent của bạn sẽ xử lý mọi kết nối. Kết quả? Doanh nghiệp của bạn vận hành như một hệ thống liền mạch thay vì các mảnh ghép rời rạc.

Cách sử dụng AI agents trong doanh nghiệp của bạn

Bạn có thể bắt đầu nhỏ với AI agents.

- Dùng một agent để sắp xếp lịch và nhắc nhở khách hàng.

- Dùng một agent khác để quản lý bài đăng trên mạng xã hội.

- Sử dụng một agent thứ ba để phân tích các cuộc trò chuyện của khách hàng để tìm ra xu hướng và thông tin chi tiết.

Những doanh nghiệp sẽ phát triển mạnh mẽ trong thập kỷ tới sẽ không phải là những doanh nghiệp có lượng người theo dõi lớn nhất hay trang web bắt mắt nhất. Chúng sẽ là những doanh nghiệp xây dựng được một hệ thống AI agents để khuếch đại sức ảnh hưởng của mình trong khi vẫn duy trì cách tiếp cận độc đáo.

Hãy chọn một lĩnh vực trong doanh nghiệp của bạn đang tốn quá nhiều thời gian. Tìm một AI agent có thể xử lý công việc cụ thể đó. Để nó tự vận hành trong khi bạn tập trung vào phát triển doanh nghiệp và phục vụ khách hàng của mình.

AI Agents Explained In Simple Terms Anyone Can Understand

ByJodie Cook, Senior Contributor. Jodie Cook covers ChatGPT prompts & AI for coaches and entrepreneurs.

Follow Author

Mar 18, 2025, 09:00am EDT

AI agents are taking over your business world. More and more entrepreneurs hear the term but don't know what it means or how it applies to them. It's confusing, technical, and moves fast. Fall behind and new entrants win business you could have claimed.

AI agents are not a passing trend. They are changing how businesses operate. Most business leaders waste time on tasks that should be automated, but AI agents handle those tasks so you can focus on decisions that move your mission forward. The ones who adopt AI agents early will pull ahead.

Here's what AI agents are, why they matter to you, and how they'll change your business forever.

Why AI agents matter to you right now

AI by itself is just raw intelligence. It's the engine but not the car. Most people get stuck thinking AI equals ChatGPT, but that's limiting. The real game-changer is when AI gets paired with specific tasks. That's what AI agents are.

PROMOTED

AI agents represent a fundamental shift in how business works. Agents work 24/7. They don’t take time off. They don’t make silly mistakes. While everyone else is figuring out basic prompts, smart entrepreneurs are building AI agents to handle entire processes in their business.

Understanding AI agents (without the tech jargon)

They work like your dream assistant

Think of an AI agent as the world's most efficient personal assistant. While basic AI answers questions, an AI agent takes action. It doesn't just tell you how to book appointments - it books them for you. It doesn't just draft emails - it sends them. It doesn't just remember your client preferences - it uses them to personalize interactions without you lifting a finger.

There are tools out there that let you explain your process, plug in the software you already use, and press play. Your business runs on tasks. AI agents do those tasks. That's power you can't ignore.

Forbes Daily: Join over 1 million Forbes Daily subscribers and get our best stories, exclusive reporting and essential analysis of the day’s news in your inbox every weekday.

Email address

Sign Up

By signing up, you agree to our Terms of Service, and you acknowledge our Privacy Statement. Forbes is protected by reCAPTCHA, and the Google Privacy Policy and Terms of Service apply.

They follow a simple pattern

Every AI agent follows the same three-step pattern: understand, think, and act. First, they take in what you're asking. Second, they process the request and figure out the best approach. Third, they take action to get the job done. When you create an automation, the agent understands the ask. It’s constantly ready to think and act, giving you the output 24/7.

This three-step pattern turns AI from passive to active. It's the difference between an employee who needs constant supervision and one who can run with the ball.

They learn as they go

The more you work with an AI agent, the better it gets. Just like a new team member, it improves with experience. It learns your preferences, anticipates your needs, and adapts to your style. Over time, your agent becomes uniquely yours.

This means the entrepreneurs who start using AI agents now will have a massive edge over those who wait. Your AI grows with you, becoming more valuable month after month.

They connect to your existing tools

AI agents don't exist in isolation. They plug into the tools you already use. Your calendar, email, CRM, social media, and more. This means they can coordinate across your entire business ecosystem.

Instead of jumping between apps and manually transferring information, your agent handles the connections. The result? Your business runs as one seamless operation instead of disconnected pieces.

How to use AI agents in your business

You can start small with AI agents. Have one handle your calendar scheduling and client reminders. Let another one manage your social media posts. Use a third to analyze customer conversations for patterns and insights.

The businesses that thrive in the next decade won't be the ones with the biggest following or the fanciest website. They'll be the ones who built an army of AI agents to multiply their impact while maintaining their unique approach.

Pick one area of your business that takes too much time. Find an AI agent that handles that specific task. Let it run while you focus on growing your business and serving your customers.

-

Bài viết hướng dẫn cách tạo ứng dụng có khả năng tạo thu nhập 10.000 USD mỗi tháng bằng cách sử dụng AI mà không cần biết lập trình.

-

Bước 1: Tìm ý tưởng ứng dụng viral. Ứng dụng cần giải quyết vấn đề thực tế một cách đơn giản và dễ chia sẻ. Hãy xác định vấn đề phổ biến, giữ ứng dụng đơn giản và tạo tính năng dễ chia sẻ.

-

Bước 2: Tìm thiết kế ứng dụng để sao chép. Sử dụng Mobbin - kho lưu trữ hơn 100.000 ảnh chụp màn hình từ các ứng dụng hàng đầu. Tìm kiếm theo danh mục, chọn luồng thiết kế phù hợp và sao chép vào Figma để chỉnh sửa.

-

Bước 3: Xây dựng ứng dụng với Cursor AI. Tạo thư mục dự án, viết tệp ngữ cảnh mô tả cách ứng dụng hoạt động, sử dụng lệnh npx create-expo-app để bắt đầu dự án, chạy ứng dụng và kiểm tra trên điện thoại.

-

Bước 4: Thiết lập cơ sở dữ liệu và backend bằng Supabase. Tạo tài khoản, lấy token API, sử dụng Cursor để xây dựng trang đăng nhập và đăng ký.

-

Bước 5: Thêm tính năng AI với DeepSeek API. Lấy API key từ platform.deepseek.com, sử dụng Cursor để xây dựng tính năng trò chuyện AI giúp người dùng quản lý công việc.

-

Bước 6: Đăng ứng dụng lên App Store và Google Play. Đăng ký tài khoản nhà phát triển Apple (99 USD/năm) và Google Play (25 USD một lần), cài đặt công cụ Expo CLI, đăng nhập và liên kết dự án, chạy lệnh cấu hình và tải lên ứng dụng.

-

Phần kết luận nhấn mạnh rằng xây dựng ứng dụng bằng AI giống như có một đội ngũ nhà phát triển làm việc 24/7, và phần khó nhất không phải là lập trình mà là tìm ý tưởng ứng dụng phù hợp.

📌 Công nghệ AI hiện cho phép người không biết lập trình tạo ứng dụng có khả năng sinh lời trong vài giờ. Với 6 bước từ tìm ý tưởng đến xuất bản, bất kỳ ai cũng có thể xây dựng ứng dụng tiềm năng tạo thu nhập 10.000 USD/tháng mà không cần kiến thức kỹ thuật chuyên sâu.

https://groinsights.com/how-to-build-an-app-using-ai-that-can-make-10000-every-month-complete-step-by-step-guide/

-

AI agent: Công cụ sử dụng công nghệ AI để thực hiện nhiều tác vụ thay con người, vượt xa khả năng của chatbot thông thường. Có thể làm việc phức tạp như nộp chi phí, đặt vé, viết và bảo trì mã.

-

Chain of thought: Phương pháp suy luận cho mô hình ngôn ngữ lớn, chia nhỏ vấn đề thành các bước trung gian để cải thiện chất lượng kết quả cuối cùng. Thường mất thời gian hơn nhưng cho kết quả chính xác hơn.

-

Deep learning: Một phân nhánh của machine learning tự cải thiện, với cấu trúc mạng neural nhân tạo nhiều lớp. Cho phép AI tìm ra các đặc điểm quan trọng trong dữ liệu mà không cần kỹ sư định nghĩa trước.

-

Fine tuning: Quá trình đào tạo thêm cho mô hình AI để tối ưu hóa hiệu suất cho một tác vụ hoặc lĩnh vực cụ thể hơn bằng cách bổ sung dữ liệu chuyên biệt.

-

Large language model (LLM): Mô hình AI được sử dụng bởi các trợ lý AI phổ biến như ChatGPT, Claude, Gemini. Là mạng neural sâu với hàng tỷ tham số, học mối quan hệ giữa các từ và cụm từ để tạo ra bản đồ đa chiều của ngôn ngữ.

-

Neural network: Cấu trúc thuật toán nhiều lớp là nền tảng của deep learning và sự bùng nổ các công cụ AI tạo sinh. Lấy cảm hứng từ các đường dẫn kết nối dày đặc trong não người.

-

Weights: Tham số số học xác định mức độ quan trọng của các đặc trưng trong dữ liệu huấn luyện AI, từ đó định hình đầu ra của mô hình. Trọng số điều chỉnh trong quá trình đào tạo để mô hình tạo ra kết quả gần với mục tiêu hơn.

📌 Bảng chú giải của TechCrunch giải thích 7 thuật ngữ AI quan trọng: AI agent, chain of thought, deep learning, fine tuning, large language model, neural network và weights. Đây là nền tảng để hiểu sâu hơn về các công nghệ AI đang phát triển nhanh chóng hiện nay.

https://techcrunch.com/2025/03/02/the-techcrunch-ai-glossary/

Từ điển AI của TechCrunch

Natasha Lomas

Romain Dillet

6:00 AM PST · 2/3/2025

Trí tuệ nhân tạo là một lĩnh vực rộng lớn và phức tạp. Các nhà khoa học làm việc trong lĩnh vực này thường sử dụng thuật ngữ chuyên môn để mô tả công việc của họ. Do đó, chúng tôi cũng phải sử dụng những thuật ngữ đó trong các bài viết về ngành công nghiệp AI.

Vì vậy, chúng tôi nghĩ rằng sẽ hữu ích nếu tạo ra một từ điển thuật ngữ với các định nghĩa của những từ và cụm từ quan trọng nhất mà chúng tôi sử dụng.

Chúng tôi sẽ thường xuyên cập nhật từ điển này để bổ sung các thuật ngữ mới khi các nhà nghiên cứu tiếp tục khám phá những phương pháp mới nhằm mở rộng ranh giới của trí tuệ nhân tạo, đồng thời xác định các rủi ro an toàn mới.

AI agent (Tác nhân AI)

Tác nhân AI là một công cụ sử dụng công nghệ AI để thực hiện một loạt nhiệm vụ thay mặt người dùng — vượt xa những gì một chatbot AI cơ bản có thể làm — chẳng hạn như nộp báo cáo chi phí, đặt vé hoặc bàn tại nhà hàng, hoặc thậm chí viết và bảo trì mã lập trình. Tuy nhiên, như chúng tôi đã giải thích trước đây, lĩnh vực này vẫn đang phát triển với nhiều yếu tố chuyển động, nên cách hiểu về tác nhân AI có thể khác nhau tùy từng người.

Cơ sở hạ tầng vẫn đang được xây dựng để hiện thực hóa tiềm năng của tác nhân AI. Nhưng về cơ bản, khái niệm này ám chỉ một hệ thống tự động có thể kết hợp nhiều hệ thống AI để thực hiện các nhiệm vụ nhiều bước.

Chain of thought (Chuỗi suy luận)

Với những câu hỏi đơn giản, con người có thể trả lời ngay lập tức mà không cần suy nghĩ quá nhiều — chẳng hạn như “con vật nào cao hơn, hươu cao cổ hay mèo?” Nhưng trong nhiều trường hợp khác, cần phải viết ra giấy để tìm ra đáp án đúng. Ví dụ, nếu một người nông dân có gà và bò, và tổng cộng chúng có 40 cái đầu và 120 cái chân, bạn có thể cần viết một phương trình đơn giản để tìm ra số lượng mỗi loài (20 con gà và 20 con bò).

Trong AI, suy luận theo chuỗi nghĩa là chia nhỏ một vấn đề thành các bước trung gian để cải thiện chất lượng kết quả cuối cùng. Quá trình này có thể mất nhiều thời gian hơn, nhưng thường cho kết quả chính xác hơn, đặc biệt trong các bài toán logic hoặc lập trình.

Các mô hình AI chuyên về suy luận được phát triển từ mô hình ngôn ngữ lớn (LLM) truyền thống và được tối ưu hóa cho tư duy theo chuỗi thông qua học tăng cường.

(Xem thêm: Large language model)

Deep learning (Học sâu)

Một nhánh của máy học tự cải tiến, trong đó các thuật toán AI được thiết kế theo cấu trúc mạng nơ-ron nhân tạo (ANN) nhiều lớp. Điều này giúp AI có thể nhận diện các mối quan hệ phức tạp hơn so với các hệ thống máy học đơn giản như mô hình tuyến tính hay cây quyết định.

Các mô hình học sâu có thể tự xác định các đặc điểm quan trọng trong dữ liệu mà không cần kỹ sư con người thiết lập trước. Ngoài ra, chúng có khả năng học từ lỗi và cải thiện kết quả thông qua quá trình lặp lại và điều chỉnh. Tuy nhiên, hệ thống học sâu yêu cầu một lượng dữ liệu rất lớn (hàng triệu điểm dữ liệu trở lên) để đạt kết quả tốt. Quá trình huấn luyện cũng tốn nhiều thời gian hơn so với các thuật toán máy học đơn giản, dẫn đến chi phí phát triển cao hơn.

(Xem thêm: Neural network)

Fine tuning (Tinh chỉnh)

Tinh chỉnh là quá trình đào tạo bổ sung một mô hình AI để tối ưu hóa hiệu suất cho một nhiệm vụ hoặc lĩnh vực cụ thể hơn so với mục tiêu huấn luyện ban đầu — thường bằng cách cung cấp dữ liệu chuyên biệt mới.

Nhiều startup AI sử dụng mô hình ngôn ngữ lớn làm nền tảng để phát triển sản phẩm thương mại, nhưng họ tìm cách nâng cao tính ứng dụng bằng cách tinh chỉnh mô hình dựa trên kiến thức chuyên ngành của họ.

(Xem thêm: Large language model (LLM))

Large language model (LLM) – Mô hình ngôn ngữ lớn

Mô hình ngôn ngữ lớn (LLM) là các mô hình AI được sử dụng trong các trợ lý AI phổ biến như ChatGPT, Claude, Gemini của Google, AI Llama của Meta, Copilot của Microsoft hay Le Chat của Mistral. Khi người dùng trò chuyện với một trợ lý AI, họ thực sự đang tương tác với một LLM, mô hình này xử lý yêu cầu của người dùng trực tiếp hoặc thông qua các công cụ khác như trình duyệt web hoặc trình phân tích mã nguồn.

Các trợ lý AI và LLM có thể có tên gọi khác nhau. Ví dụ, GPT là mô hình ngôn ngữ lớn của OpenAI, còn ChatGPT là sản phẩm trợ lý AI.

LLM là mạng nơ-ron sâu gồm hàng tỷ tham số số học (hay còn gọi là trọng số – weights, xem bên dưới), giúp chúng học mối quan hệ giữa từ và cụm từ để tạo ra một dạng bản đồ ngôn ngữ đa chiều.

Những mô hình này được tạo ra bằng cách mã hóa các mẫu ngôn ngữ tìm thấy trong hàng tỷ cuốn sách, bài báo và văn bản hội thoại. Khi người dùng nhập một yêu cầu, LLM sẽ tạo ra chuỗi từ có xác suất cao nhất phù hợp với ngữ cảnh, sau đó lặp lại quá trình này nhiều lần để hình thành câu trả lời.

(Xem thêm: Neural network)

Neural network (Mạng nơ-ron nhân tạo)

Mạng nơ-ron nhân tạo là cấu trúc thuật toán nhiều lớp làm nền tảng cho học sâu và, rộng hơn, là toàn bộ sự bùng nổ của các công cụ AI tạo sinh sau sự xuất hiện của mô hình ngôn ngữ lớn.

Ý tưởng lấy cảm hứng từ cách các nơ-ron trong não người kết nối với nhau đã xuất hiện từ những năm 1940. Tuy nhiên, sự phát triển của bộ xử lý đồ họa (GPU) trong ngành công nghiệp trò chơi điện tử đã giúp hiện thực hóa tiềm năng của mạng nơ-ron bằng cách tăng khả năng huấn luyện các thuật toán với nhiều lớp hơn.

Nhờ đó, AI dựa trên mạng nơ-ron có thể đạt hiệu suất vượt trội trong nhiều lĩnh vực, bao gồm nhận diện giọng nói, điều hướng tự động và phát hiện thuốc mới.

(Xem thêm: Large language model (LLM))

Weights (Trọng số)

Trọng số đóng vai trò cốt lõi trong quá trình huấn luyện AI vì chúng xác định mức độ quan trọng của từng đặc điểm (hay biến đầu vào) trong dữ liệu, qua đó định hình đầu ra của mô hình AI.

Nói cách khác, trọng số là các tham số số học giúp mô hình xác định yếu tố nào có ảnh hưởng lớn nhất đến một tập dữ liệu nhất định. Quá trình huấn luyện thường bắt đầu với trọng số được gán ngẫu nhiên, sau đó được điều chỉnh liên tục để cải thiện độ chính xác của mô hình.

Ví dụ, một mô hình AI dự đoán giá nhà dựa trên dữ liệu bất động sản có thể sử dụng trọng số cho các yếu tố như số phòng ngủ, số phòng tắm, loại nhà (biệt lập hay liền kề), có chỗ đậu xe hay không, v.v.

Cuối cùng, các trọng số phản ánh mức độ ảnh hưởng của từng yếu tố đến giá trị bất động sản, dựa trên dữ liệu huấn luyện.

-

"AI tác nhân" (AI agents) và "tác nhân AI" (agentic AI) là hai thuật ngữ đang xuất hiện ngày càng nhiều trong công nghệ kinh doanh, nhưng thường bị sử dụng lẫn lộn mặc dù chúng đề cập đến các khái niệm khác nhau.

-

Cả hai đều liên quan đến AI có khả năng giải quyết vấn đề nhiều bước một cách độc lập, với ít sự hướng dẫn từ con người.

-

Tác nhân AI là những ứng dụng cụ thể được tạo ra để thực hiện nhiệm vụ độc lập và đã được sử dụng rộng rãi hiện nay trong ngân hàng và thương mại điện tử để xác minh danh tính, tự động hóa giao dịch, lưu giữ hồ sơ và học hỏi về người dùng.

-

AI tác nhân đề cập đến lĩnh vực AI nghiên cứu và phát triển các mô hình có khả năng hoạt động như các tác nhân tự chủ.

-

Có thể hiểu tác nhân AI giống như những loại thuốc cụ thể được kê cho các tình trạng bệnh nhất định, trong khi AI tác nhân giống như toàn bộ lĩnh vực khoa học dược phẩm phát triển tất cả các loại thuốc.

-

Trong bối cảnh trí tuệ nhân tạo tổng quát (AGI), tác nhân AI hiện tại không phải là AGI - chúng có thể thực hiện các nhiệm vụ phức tạp nhưng vẫn chỉ là những nhiệm vụ cụ thể mà chúng được tạo ra.

-

AI tác nhân là một lĩnh vực nghiên cứu và phát triển AI mà một số người tin rằng cuối cùng sẽ dẫn đến AGI, bao gồm việc xây dựng AI có khả năng tương tác với hệ thống bên ngoài, cả về mặt kỹ thuật số và vật lý.

-

Hiểu biết về các khái niệm này rất quan trọng vì khi nghiên cứu và phát triển AI tác nhân tiếp tục, chúng ta sẽ thấy các tác nhân ngày càng tinh vi có khả năng tự động hóa nhiều nhiệm vụ khác nhau.

-

Trợ lý kỹ thuật số thực sự hữu ích và được cá nhân hóa, có khả năng học hỏi chi tiết về nhu cầu của chúng ta và thực hiện các bước để giúp chúng ta đạt được mục tiêu, chỉ là khởi đầu.

-

Khi tích hợp với robotics, các tác nhân cũng sẽ mở ra cánh cửa tự động hóa các nhiệm vụ vật lý, chẳng hạn như công việc xây dựng hoặc kỹ thuật phức tạp.

📌 AI tác nhân và tác nhân AI đang định hình lại công nghệ kinh doanh, với sự khác biệt quan trọng: tác nhân AI là ứng dụng cụ thể đang được sử dụng ngày nay trong khi AI tác nhân là lĩnh vực nghiên cứu hướng tới AGI. Hiểu biết này rất quan trọng khi tiến bộ công nghệ đang diễn ra với tốc độ có thể khiến nhiều người bất ngờ.

https://www.forbes.com/sites/bernardmarr/2025/02/25/the-important-difference-between-agentic-ai-and-ai-agents/

-

ChatGPT o3-mini-high là mô hình được tối ưu hóa cho các vấn đề STEM, mang lại kết quả chính xác và chi tiết hơn ChatGPT-4o

-

Người dùng cần tài khoản Plus để truy cập mô hình này, với thời gian phân tích lâu hơn nhưng cho kết quả thông minh hơn

-

5 prompts đề xuất để thử nghiệm:

-

Prompt 1 - Thiết kế website:

-

Tạo mã HTML và CSS cho website portfolio nhiếp ảnh cưới

-

Mô hình cho kết quả chi tiết về cấu trúc và phong cách trang web

-

Prompt 2 - Giải toán:

-

Tìm số 5 chữ số khi nhân với 5 sẽ cho kết quả đảo ngược

-

o3-mini-high chính xác kết luận không có số thỏa mãn sau 2 phút phân tích

-

Bài toán chỉ có lời giải với số 4 chữ số nhân 4 (số 2.178)

-

Prompt 3 - Lập trình game:

-

Tạo game tương tác bằng Python và Pygame

-

Mô hình cung cấp mã nguồn đầy đủ để phát triển game

-

Prompt 4 - Phân tích SWOT:

-

Phân tích chi tiết mô hình kinh doanh nhà sách

-

Kết hợp ChatGPT-4o và o3-mini-high để tối ưu kết quả

-

Prompt 5 - Ôn thi logic:

-

Giải quyết câu hỏi LSAT về logic sắp xếp sách

-

o3-mini-high cho kết quả chính xác ngay lần đầu tiên

📌 ChatGPT o3-mini-high vượt trội trong xử lý các vấn đề phức tạp về STEM với độ chính xác cao. Mô hình này đặc biệt hiệu quả cho lập trình, toán học và logic, mặc dù cần nhiều thời gian xử lý hơn ChatGPT-4o thông thường.

https://www.tomsguide.com/ai/5-prompts-to-try-first-in-chatgpt-o-3-mini-high

5 lời nhắc (prompt) đầu tiên nên thử với ChatGPT o-3 mini-high

Hướng dẫn

Tác giả: Christoph Schwaiger

Xuất bản 16 giờ trước

Mới sử dụng ChatGPT o-3 mini-high? Hãy thử ngay những prompt này

Đôi khi, bạn cần một sự hỗ trợ thêm, và với ChatGPT, đó chính là lúc mô hình o-3 mini-high phát huy tác dụng. O-3 mini-high dành nhiều thời gian hơn để phân tích vấn đề, mang lại khả năng suy luận cao hơn và phản hồi chi tiết hơn—đặc biệt là trong các chủ đề liên quan đến STEM (khoa học, công nghệ, kỹ thuật, toán học).

Dù là viết mã (coding) hay giải đố logic, nếu bạn muốn có kết quả chính xác và chất lượng cao, o-3 mini-high chính là lựa chọn phù hợp nhất. Mặc dù ChatGPT-4o vẫn đủ tốt cho các tác vụ hằng ngày, nhưng việc biết rằng có một tùy chọn mạnh mẽ hơn sẽ rất hữu ích.

Nếu bạn cảm thấy kết quả nhận được từ các prompt phức tạp chưa đủ chính xác, o-3 mini-high sẽ giúp bạn thay đổi hoàn toàn trải nghiệm. Dưới đây là 5 lời nhắc mà tôi đã thử nghiệm, bạn có thể sử dụng nguyên bản hoặc điều chỉnh theo nhu cầu cá nhân.

Cách bật ChatGPT o-3 mini-high

Sau khi đăng nhập vào tài khoản ChatGPT, hãy bật mô hình o-3 mini-high bằng cách:

1️⃣ Nhấp vào tên mô hình hiện tại ở góc trái màn hình.

2️⃣ Từ menu thả xuống, chọn ChatGPT o-3 mini-high.

Lưu ý: Bạn cần tài khoản ChatGPT Plus để sử dụng mô hình này.

1. Thiết kế một trang web

🖥️ Prompt:

"Tạo mã HTML và CSS cho một trang web portfolio hiện đại để giới thiệu ảnh cưới tôi chụp."

👉 Mô hình o-3 mini-high sẽ cung cấp:

✅ HTML & CSS hoàn chỉnh cho trang web.

✅ Thiết kế sạch sẽ, chuyên nghiệp, dễ tùy chỉnh.

✅ Hướng dẫn cài đặt và cải thiện trang web.

📌 Ứng dụng thực tế: Nếu bạn là nhiếp ảnh gia, nhà thiết kế hoặc freelancer, prompt này sẽ giúp bạn xây dựng trang web cá nhân một cách nhanh chóng.

2. Tìm lỗi trong bài toán toán học

🔢 Prompt: