AI data

View All

-

UAE triển khai chiến lược quốc gia bảo tồn và hiện đại hóa tiếng Ả Rập bằng AI, kết hợp bảo tồn di sản ngôn ngữ với nâng cao hiện diện kỹ thuật số toàn cầu.

-

Từ điển lịch sử tiếng Ả Rập: do Học viện Ngôn ngữ Ả Rập Sharjah phát triển, gồm 127 tập, 20 triệu từ, tích hợp GPT cho tra cứu tương tác, hỗ trợ đọc, viết, chuyển đổi nội dung thành video và tính năng cộng tác qua Emirates Scholar Research Centre.

-

Kho tri thức số: Quỹ Tri thức Mohammed bin Rashid Al Maktoum vận hành, lưu trữ hơn 800.000 đầu sách, 8,5 triệu tài nguyên số từ 18+ thư viện, chuẩn hóa dữ liệu để mở rộng truy cập toàn cầu.

-

Từ điển AI của Trung tâm Ngôn ngữ Ả Rập Abu Dhabi: từ điển Ả Rập–Anh đầu tiên dùng AI, chứa 7.000+ thuật ngữ hiện đại, phát âm tự động, định nghĩa đơn giản, công cụ ngôn ngữ học tính toán.

-

BAREC (Balanced Arabic Readability Corpus): bộ ngữ liệu 10 triệu từ để đánh giá độ dễ đọc, hỗ trợ học tiếng Ả Rập, chú giải về chính tả, ngữ pháp, từ vựng, mã nguồn mở cho cộng đồng nghiên cứu.

-

Falcon Arabic: mô hình AI ngôn ngữ bản địa do TII phát triển, huấn luyện trên dữ liệu tiếng Ả Rập chuẩn và phương ngữ, tối ưu hiệu suất, phát triển hoàn toàn tại UAE. Phiên bản nhỏ gọn Falcon H1 vượt hiệu năng so với các mô hình cùng kích thước của Meta và Alibaba.

-

Ứng dụng AI trong xuất bản: khu “Digital square” tại Hội sách quốc tế Abu Dhabi, trình diễn ứng dụng AI trong số hóa và đổi mới sách, giáo trình, tài liệu học tập.

-

AI trong lớp học: tích hợp công cụ AI vào giảng dạy tiếng Ả Rập, kết hợp bảo tồn truyền thống và năng lực số.

-

Hợp tác quốc tế: thỏa thuận AI ký trong chuyến thăm của Tổng thống Mỹ Donald Trump, cho phép UAE tiếp cận chip AI Mỹ tiên tiến, tăng năng lực phát triển AI nội địa.

📌 UAE đang dùng AI để tạo kho ngôn ngữ tiếng Ả Rập lớn nhất thế giới, với 20 triệu từ, 800.000 sách, mô hình Falcon Arabic và bộ dữ liệu BAREC. Chiến lược này kết hợp bảo tồn di sản với phát triển công nghệ, đưa tiếng Ả Rập lên vị thế mạnh mẽ trong kỷ nguyên số.

https://timesofindia.indiatimes.com/world/middle-east/how-the-uae-is-using-artificial-intelligence-to-build-the-worlds-largest-arabic-language-resources/articleshow/123237801.cms

-

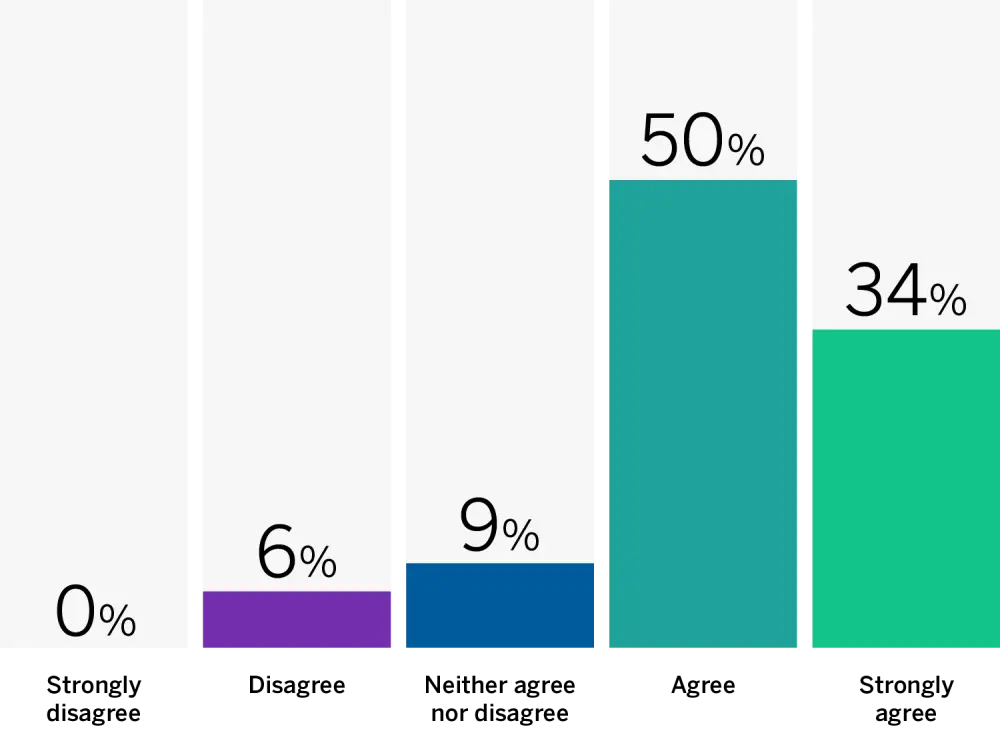

Một khảo sát từ nền tảng học ngôn ngữ Babbel.com với 500.000 người tham gia cho thấy 77% tin rằng tiếng Anh Anh đang bị "Mỹ hóa" do ảnh hưởng từ các công cụ AI.

-

51% người dùng cho biết họ đã ngừng sử dụng dấu câu như dấu chấm phẩy và dấu phẩy Oxford vì chúng khiến văn bản trông giống như được viết bởi AI.

-

37% cố tình tránh sử dụng dấu câu chính xác để văn bản của họ "nghe giống con người hơn", tránh bị cho là máy móc hoặc công thức.

-

Cùng tỷ lệ 37% lo ngại rằng thế hệ tương lai sẽ học ngữ pháp từ AI thay vì giáo dục truyền thống, dẫn đến sự sai lệch trong chuẩn ngôn ngữ.

-

Noël Wolf, chuyên gia ngôn ngữ của Babbel, nhận định rằng các công cụ viết AI đang thay đổi cách sử dụng ngữ pháp – không chỉ về dấu câu mà cả về chính tả và cấu trúc ngôn ngữ.

-

Ví dụ, cách viết kiểu Mỹ như "organize" (thay vì "organise") đang dần trở nên phổ biến hơn do AI thường mặc định sử dụng tiếng Anh Mỹ.

-

Các dấu câu từng thể hiện phong cách viết rõ ràng như em dash (—) hay dấu Oxford comma giờ đây lại trở thành dấu hiệu dễ nhận biết của văn bản tạo sinh (AI-generated text).

-

Do đó, người viết có xu hướng lược bỏ các dấu câu “mang màu sắc AI” để giữ lại vẻ tự nhiên và cá nhân cho văn bản.

-

Dù vậy, bà Wolf cho rằng sự thay đổi này là cơ hội để nhìn lại quá trình tiến hóa của ngôn ngữ, đồng thời đặt ra những câu hỏi về rõ ràng, mục đích và biểu đạt cá nhân trong kỷ nguyên AI.

📌 Khảo sát của Babbel tiết lộ 77% người dùng tin rằng AI đang "Mỹ hóa" tiếng Anh Anh, trong khi 51% đã bỏ dấu câu như dấu chấm phẩy vì sợ bị hiểu nhầm là văn bản AI. Xu hướng này phản ánh cách AI không chỉ hỗ trợ mà còn định hình lại cách con người viết và sử dụng ngôn ngữ.

https://www.telegraph.co.uk/news/2025/08/03/ai-is-americanising-british-english/

-

Tại buổi điều trần trước Thượng viện Pháp ngày 18/6/2025, đại diện Microsoft thừa nhận không thể đảm bảo dữ liệu người dùng tại EU không bị truy cập bởi chính phủ Mỹ nếu có yêu cầu pháp lý hợp lệ dựa theo Đạo luật CLOUD Act.

-

Đạo luật CLOUD Act của Mỹ cho phép chính phủ yêu cầu dữ liệu từ các công ty công nghệ Mỹ, dù dữ liệu được lưu trữ ở nước ngoài. Microsoft, AWS và Google từng ủng hộ luật này từ năm 2018.

-

Anton Carniaux – Giám đốc pháp lý Microsoft Pháp – cho biết họ có cam kết phản kháng các yêu cầu không chính đáng và yêu cầu được thông báo cho khách hàng nếu bị buộc phải chia sẻ dữ liệu.

-

Tuy nhiên, khi bị chất vấn rằng có thể đảm bảo dữ liệu của công dân Pháp không bị truyền về Mỹ mà không có sự đồng ý của chính phủ Pháp hay không, Carniaux trả lời thẳng: "Không thể đảm bảo."

-

Dù Microsoft nói chưa từng có yêu cầu nào như vậy ảnh hưởng đến khách hàng công hoặc doanh nghiệp tại EU, lời thừa nhận trên đã dấy lên làn sóng lo ngại về chủ quyền dữ liệu ở châu Âu.

-

CEO Civo nhận định đây là bằng chứng rõ ràng rằng các nhà cung cấp đám mây Mỹ không thể đảm bảo chủ quyền dữ liệu thực sự tại EU, và đây là rủi ro nghiêm trọng đối với an ninh quốc gia, quyền riêng tư và cạnh tranh doanh nghiệp.

-

AWS phản hồi bằng cách khẳng định Cloud Act không cho phép truy cập dữ liệu "tự động", mà cần lệnh từ tòa án liên bang với chứng cứ rõ ràng, nhưng thừa nhận luật này áp dụng cho cả công ty nước ngoài có hoạt động tại Mỹ.

-

Google, Microsoft và AWS hiện đang triển khai các dịch vụ "sovereign cloud" tại châu Âu, song điều này chưa đủ xoa dịu sự nghi ngờ ngày càng lớn từ các chính trị gia và kỹ sư công nghệ EU.

-

Trong bối cảnh chính quyền Trump quay trở lại, thái độ không thân thiện với đồng minh, cùng chính sách thuế thất thường càng làm gia tăng áp lực đòi hỏi hạ tầng số độc lập tại châu Âu.

-

Nhiều nhà vận động và chuyên gia công nghệ đang kêu gọi Ủy ban châu Âu xây dựng cơ sở hạ tầng số có chủ quyền, tránh phụ thuộc vào các "hyperscaler" Mỹ, điều này sẽ cần thời gian và đầu tư lớn.

-

Trong khi đó, các công ty Mỹ đang đẩy mạnh chiến dịch giữ chân khách hàng châu Âu, cam kết xây thêm trung tâm dữ liệu và cải thiện kiểm soát nội bộ – một nỗ lực giữ chân hàng tỷ USD doanh thu.

📌 Microsoft công khai thừa nhận trước Thượng viện Pháp rằng họ không thể đảm bảo dữ liệu khách hàng EU sẽ được bảo vệ khỏi yêu cầu từ chính phủ Mỹ theo CLOUD Act. Dù có cam kết minh bạch và chống truy cập trái phép, luật pháp Mỹ vẫn áp đảo, gây ra làn sóng lo ngại về chủ quyền số ở châu Âu. Châu Âu đang đứng trước bước ngoặt, hoặc đẩy mạnh phát triển hạ tầng số tự chủ, hoặc tiếp tục phụ thuộc vào Big Tech Mỹ trong thế bất đối xứng.

https://www.theregister.com/2025/07/25/microsoft_admits_it_cannot_guarantee/

-

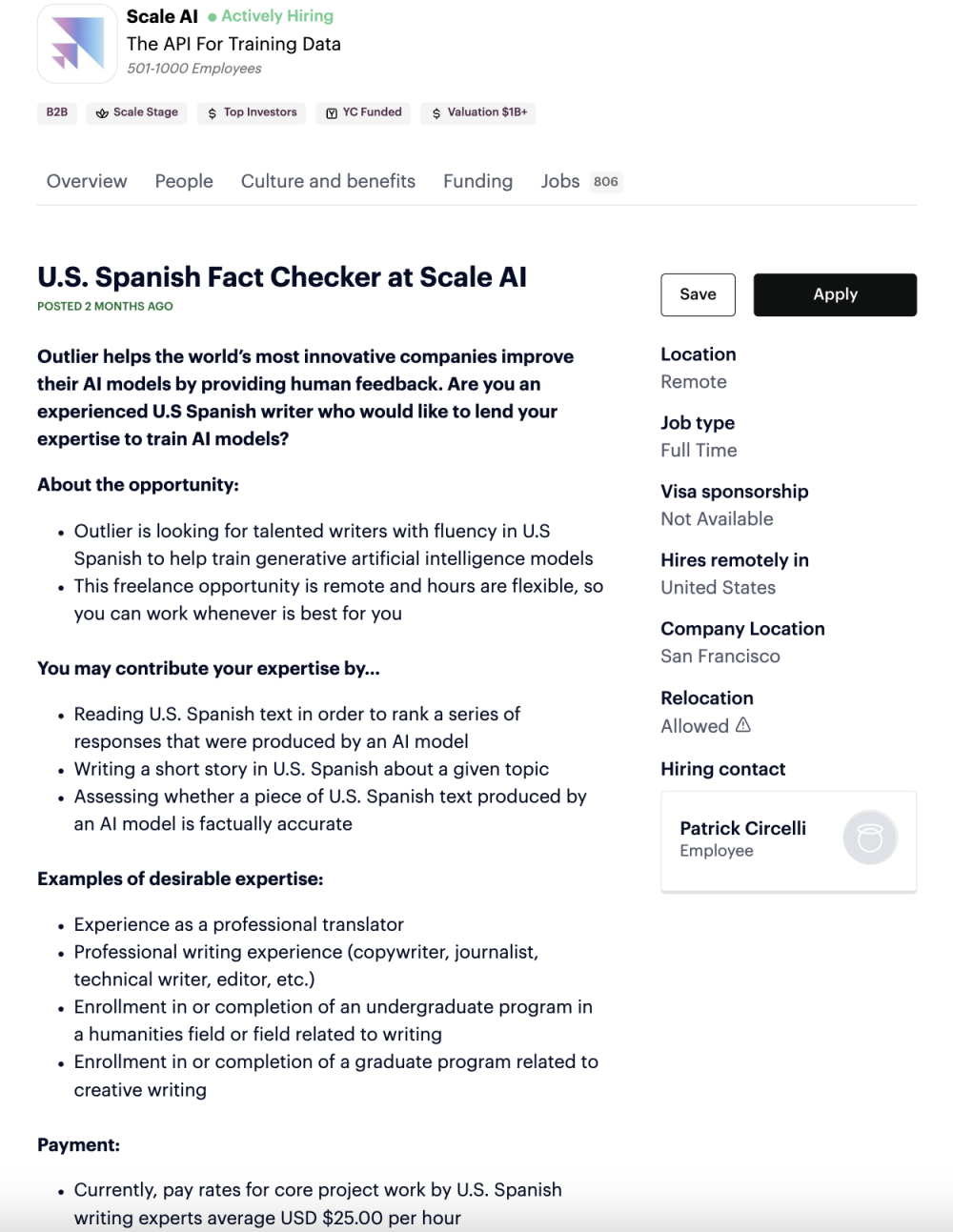

Các công ty AI hàng đầu như Scale AI, Turing và Toloka đang từ bỏ mô hình thuê lao động giá rẻ tại châu Phi và châu Á để chuyển sang tuyển dụng chuyên gia được trả lương cao trong các lĩnh vực như sinh học, tài chính, vật lý và lập trình.

-

Lao động dán nhãn truyền thống từng được trả dưới 2 USD/giờ để thực hiện các nhiệm vụ đơn giản như xác định vật thể trong ảnh, loại bỏ nội dung phản cảm, mô tả hình ảnh, hoặc chọn câu trả lời trôi chảy.

-

Tuy nhiên, các mô hình AI mới như OpenAI o3 và Google Gemini 2.5 yêu cầu loại dữ liệu huấn luyện có độ phức tạp cao, dẫn đến sự thay đổi hướng sang “dữ liệu từ chuyên gia thật sự”.

-

Dữ liệu chất lượng từ chuyên gia hiện đóng vai trò thiết yếu giúp các mô hình AI giải quyết bài toán tư duy (reasoning), lập luận theo chuỗi (chain-of-thought) và đưa ra lời giải như con người.

-

Toloka cho biết phần lớn công việc gán nhãn thủ công có thể tự động hóa, và các dự án mới cần chuyên gia kiểm tra chất lượng nội dung AI tạo ra.

-

Turing AI cho biết họ trả cho chuyên gia cao hơn 20-30% so với lương hiện tại để thu hút nhân lực hàng đầu từ nhiều lĩnh vực.

-

Ví dụ, một bài toán vật lý cần cả nhà vật lý, kỹ sư phần mềm và nhà khoa học dữ liệu hợp tác xây mô phỏng, viết mã, kiểm thử, và phân tích kết quả.

-

Meta đã đầu tư 15 tỉ USD vào Scale AI vào tháng 6/2025, nâng định giá công ty lên 29 tỉ USD. Turing gọi vốn 111 triệu USD vào tháng 3, và Toloka được Bezos rót 72 triệu USD vào tháng 5.

-

Turing nhấn mạnh mục tiêu hiện nay là mô phỏng quá trình con người thực hiện công việc tri thức để huấn luyện AI làm tốt hơn cả chuyên gia đa ngành.

📌 Ngành AI đang bước vào giai đoạn thay máu toàn diện khi lao động giá rẻ dán nhãn dữ liệu bị thay thế bởi chuyên gia được trả lương cao nhằm tạo ra bộ dữ liệu huấn luyện tinh vi hơn. Việc này giúp các mô hình mới vượt qua rào cản lập luận phức tạp và tiến gần hơn đến siêu trí tuệ. Các công ty AI sẵn sàng chi hàng tỷ USD cho dữ liệu chất lượng, không chỉ cho máy tính và mô hình.

--> Việt Nam cần chuyển dịch từ cung cấp nhân công giá rẻ sang đào tạo lực lượng chuyên gia có khả năng tham gia chuỗi giá trị AI cao cấp, đồng thời hỗ trợ khởi nghiệp AI và tăng cường hợp tác liên ngành để không bị bỏ lại phía sau.

https://www.ft.com/content/e17647f0-4c3b-49b4-a031-b56158bbb3b8

AI groups spend to replace low-cost ‘data labellers’ with high-paid experts

-

FlexOlmo là mô hình ngôn ngữ lớn mới do Allen Institute for AI (Ai2) phát triển, cho phép chủ dữ liệu rút dữ liệu khỏi mô hình ngay cả sau khi đã huấn luyện.

-

Mô hình này phá vỡ nguyên lý truyền thống rằng “dữ liệu đã dùng thì không thể gỡ”, bằng cách cho phép huấn luyện theo cách chia tách và hợp nhất các sub-model độc lập.

-

Cơ chế hoạt động dựa trên kiến trúc mixture of experts, cho phép kết hợp nhiều mô hình nhỏ, trong đó mỗi mô hình có thể được huấn luyện riêng biệt với dữ liệu riêng.

-

Người đóng góp dữ liệu sao chép một mô hình “anchor” công khai, huấn luyện với dữ liệu cá nhân, rồi gửi bản kết hợp thay vì phải chia sẻ dữ liệu thô.

-

Điều này giúp giữ quyền sở hữu dữ liệu, cho phép rút sub-model nếu có tranh chấp pháp lý hoặc không hài lòng với việc sử dụng mô hình cuối.

-

FlexOlmo không yêu cầu huấn luyện đồng bộ – việc đóng góp và huấn luyện có thể diễn ra hoàn toàn độc lập.

-

Ai2 đã thử nghiệm bằng cách xây dựng mô hình 37 tỷ tham số trên tập dữ liệu Flexmix, bao gồm sách và nội dung từ web độc quyền.

-

Mô hình này vượt trội so với từng mô hình riêng lẻ và tốt hơn 10% so với các phương pháp hợp nhất mô hình trước đó trên các benchmark phổ biến.

-

FlexOlmo còn giúp các công ty truy cập dữ liệu nhạy cảm mà không cần tiết lộ công khai, nhưng Ai2 cảnh báo vẫn có rủi ro khôi phục dữ liệu – cần đến các kỹ thuật như differential privacy.

-

Trong bối cảnh tranh cãi về quyền sở hữu dữ liệu huấn luyện AI ngày càng gay gắt, mô hình như FlexOlmo mở ra hướng đi mới cân bằng giữa tiến bộ công nghệ và quyền lợi dữ liệu.

📌 FlexOlmo mang đến một đột phá lớn trong lĩnh vực AI tạo sinh bằng cách cho phép các chủ sở hữu dữ liệu rút dữ liệu khỏi mô hình sau huấn luyện mà không cần retrain. Với 37 tỷ tham số và hiệu suất cao hơn 10% so với phương pháp cũ, mô hình này giúp cân bằng giữa phát triển AI và kiểm soát dữ liệu cá nhân, mở ra tương lai mới cho AI nguồn mở và hợp tác.

https://www.wired.com/story/flexolmo-ai-model-lets-data-owners-take-control/

A New Kind of AI Model Lets Data Owners Take Control

-

Nigeria, Việt Nam, Ấn Độ, Nam Phi và nhiều quốc gia đang phát triển đang buộc các tập đoàn công nghệ lớn như Google, Microsoft và Amazon phải lưu trữ dữ liệu công dân trong nước, thay vì vận hành từ các trung tâm dữ liệu ở nước ngoài.

-

Nigeria yêu cầu các hãng đưa ra thời hạn cụ thể để xây trung tâm dữ liệu tại nước này, từ chối miễn trừ trước đây, đồng thời đe dọa ngừng hoạt động nếu không tuân thủ.

-

Ấn Độ yêu cầu các công ty thanh toán lưu trữ dữ liệu tài chính trong nước; Việt Nam bắt buộc doanh nghiệp nước ngoài có văn phòng và lưu dữ liệu tối thiểu 24 tháng nội địa.

-

Microsoft phản hồi bằng cách triển khai "edge nodes" tại Nigeria để giảm độ trễ và hỗ trợ "data residency", nhưng Amazon và Google từ chối bình luận.

-

Các nước đang phát triển đã nhận ra giá trị to lớn của dữ liệu công dân, trước đây bị các Big Tech khai thác mà không đem lại lợi ích kinh tế tương xứng.

-

Nhiều quốc gia châu Phi đang đầu tư hàng trăm triệu USD để xây trung tâm dữ liệu quốc gia, với sự hỗ trợ của Ngân hàng Phát triển châu Phi và Ngân hàng Thế giới:

-

Congo nhận 77 triệu USD cho trung tâm dữ liệu đầu tiên khu vực Trung Phi

-

Cabo Verde có dự án 60 triệu USD

-

Raxio Group nhận 100 triệu USD từ IFC để mở rộng hạ tầng tại 6 quốc gia châu Phi

-

-

Nam Phi là quốc gia duy nhất tại châu Phi hiện có trung tâm dữ liệu của cả Amazon, Microsoft và Google, nhờ vào cơ sở hạ tầng vượt trội và thị trường lớn.

-

Tại Nigeria, các trung tâm dữ liệu nội địa như MainOne, Rack Centre, Galaxy Backbone, Huawei ngày càng đạt chuẩn quốc tế và phục vụ ngân hàng, fintech và viễn thông.

-

MTN mới khánh thành trung tâm dữ liệu lớn nhất Tây Phi trị giá 235 triệu USD, đồng thời ra mắt dịch vụ đám mây cạnh tranh với Amazon, Google.

-

Tuy nhiên, rào cản lớn nhất vẫn là khung pháp lý thiếu ổn định, khiến các hãng công nghệ do dự đầu tư hạ tầng lâu dài tại nhiều quốc gia như Nigeria.

-

Các chuyên gia cảnh báo rằng chủ quyền dữ liệu chỉ thật sự hiệu quả nếu đi kèm kiểm soát quyền truy cập của công ty nước ngoài, tránh chỉ là "lưu dữ liệu tại chỗ nhưng vẫn bị kiểm soát bởi bên ngoài".

📌 Làn sóng chủ quyền dữ liệu đang lan rộng từ Nigeria đến Việt Nam, khiến các Big Tech phải xây trung tâm dữ liệu nội địa hoặc rút khỏi thị trường. Nigeria, Ấn Độ và nhiều nước khác yêu cầu dữ liệu công dân phải được lưu tại chỗ, gây áp lực lớn lên mô hình thu lợi từ dữ liệu toàn cầu của Amazon, Google và Microsoft. Tuy nhiên, sự thiếu ổn định pháp lý vẫn là rào cản lớn trong việc hiện thực hóa chủ quyền dữ liệu toàn diện.

https://restofworld.org/2025/big-tech-data-sovereignty/

-

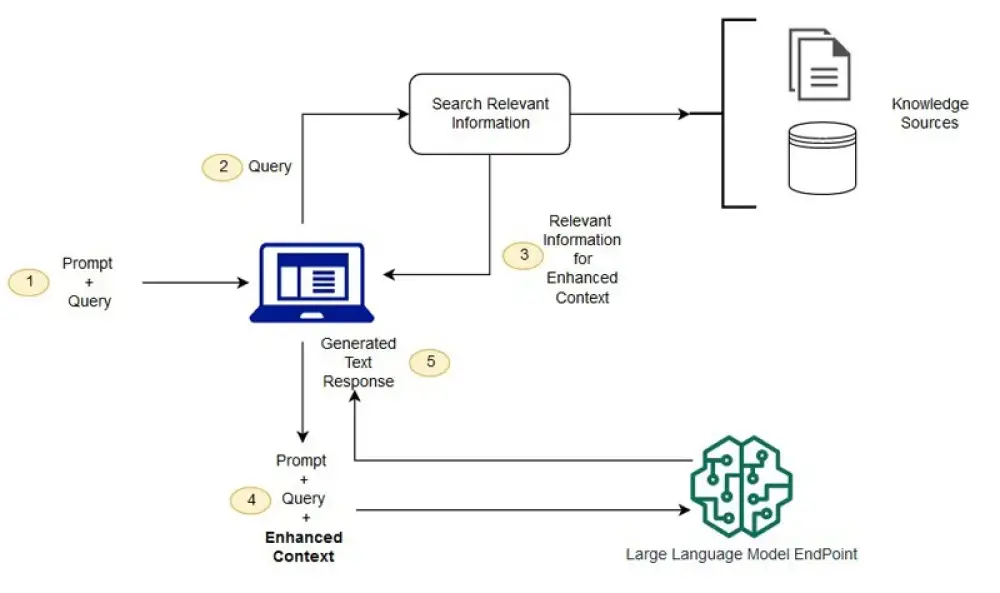

Tương lai của AI đối với doanh nghiệp nhỏ không nằm ở mô hình lớn hơn, mà ở khả năng cung cấp bối cảnh tốt hơn — tích hợp dữ liệu, thương hiệu và mục tiêu để tạo ra kết quả AI cá nhân hóa và có chiến lược.

-

Model Context Protocol (MCP) là một khái niệm mới nổi cho phép nhiều mô hình AI khác nhau hoạt động dựa trên một nguồn bối cảnh chung – chính là dữ liệu và mục tiêu của doanh nghiệp bạn.

-

Vấn đề hiện tại là các doanh nghiệp nhỏ đang sử dụng AI theo cách rời rạc: một công cụ cho nội dung mạng xã hội, một công cụ quản lý khách hàng, một chatbot AI khác trên website. Các công cụ này không kết nối nên kết quả đầu ra thường chung chung và thiếu chiều sâu.

-

Hầu hết công cụ AI hiện tại chỉ hoạt động trên nền tảng kiến thức tổng quát, không hiểu chi tiết cụ thể của doanh nghiệp, dẫn đến hiệu suất thấp và mất thời gian xử lý thủ công.

-

MCP khắc phục điều này bằng cách tạo ra một chuẩn giao tiếp thống nhất cho các mô hình AI, cho phép chúng hiểu và hoạt động theo cùng một dữ liệu gốc – tạo ra kết quả phù hợp và tối ưu.

-

Để chuẩn bị cho làn sóng AI tiếp theo, doanh nghiệp nhỏ cần:

-

Xác định rõ nhận diện thương hiệu của mình.

-

Tổ chức và chuẩn hóa dữ liệu nội bộ.

-

Tạo hệ thống cung cấp bối cảnh rõ ràng cho các công cụ AI.

-

Hợp tác với các nhà cung cấp công nghệ có thể tùy chỉnh theo nhu cầu doanh nghiệp.

-

Thử nghiệm thường xuyên, duy trì văn hóa đổi mới sáng tạo.

-

Thiết lập chính sách bảo mật và quyền riêng tư dữ liệu, nhằm bảo vệ thông tin khách hàng và uy tín doanh nghiệp.

-

-

Bối cảnh chính là yếu tố giúp AI hiểu doanh nghiệp như một nhân viên kỳ cựu chứ không phải chỉ là một công cụ máy móc trả lời chung chung.

📌 Thay vì chạy theo mô hình AI khổng lồ, doanh nghiệp nhỏ nên tập trung vào cung cấp ngữ cảnh rõ ràng để AI tạo ra kết quả có chiều sâu và phù hợp. Khái niệm Model Context Protocol (MCP) sẽ giúp các công cụ AI hoạt động đồng bộ, tăng tính cá nhân hóa và hiệu quả. Bước chuẩn bị gồm nhận diện thương hiệu rõ ràng, tổ chức dữ liệu, thử nghiệm liên tục và bảo mật mạnh mẽ là nền tảng để đón làn sóng AI chiến lược tiếp theo.

https://www.entrepreneur.com/science-technology/how-to-prepare-for-the-next-wave-of-ai-innovation/493801

-

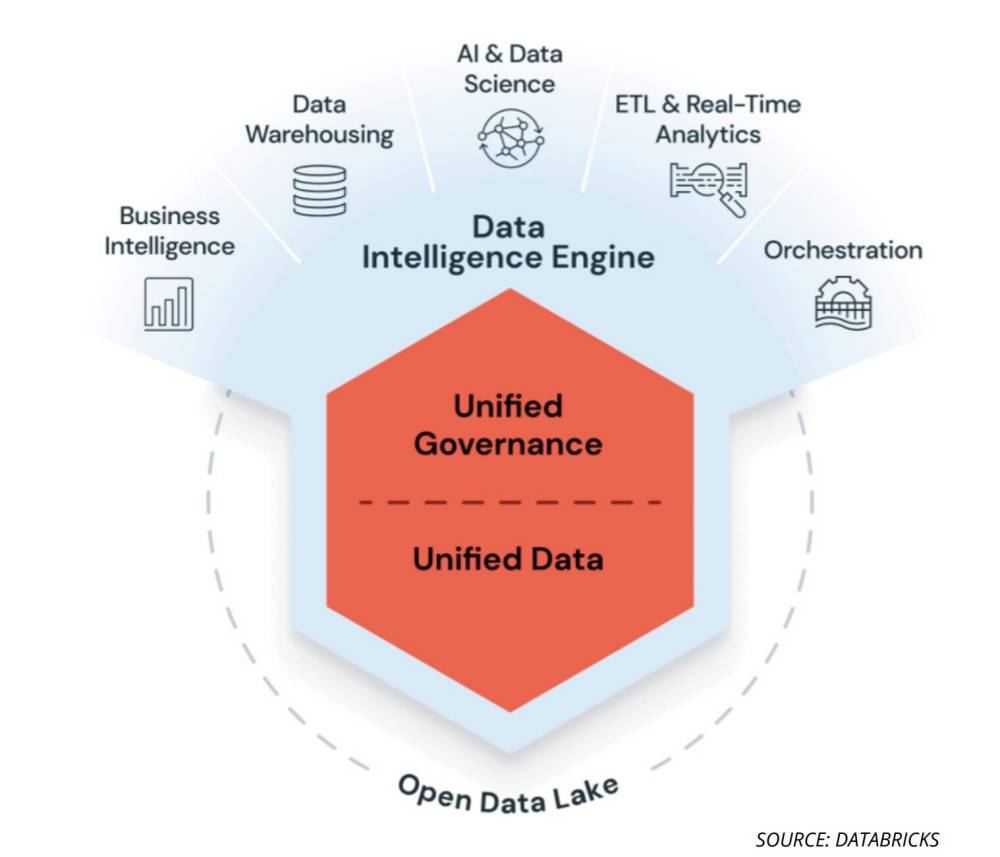

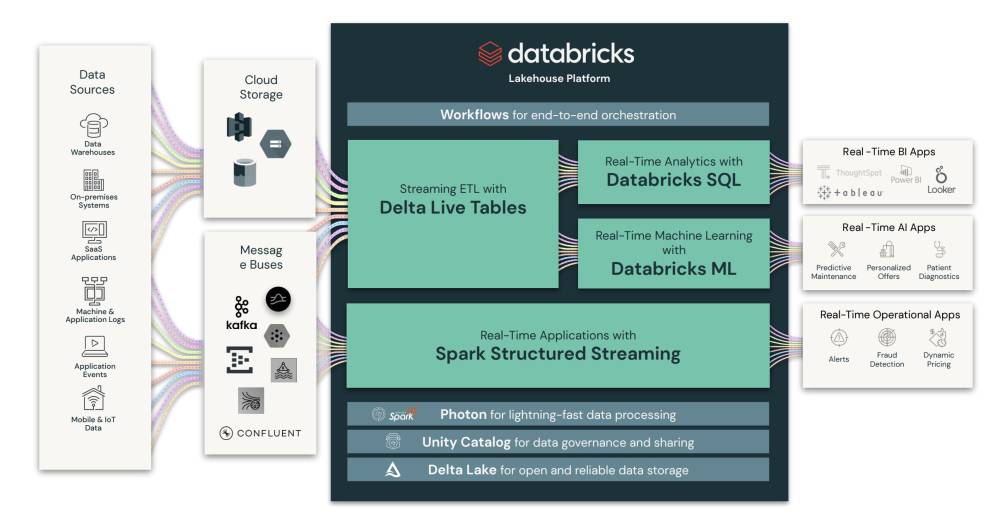

Ngành dữ liệu toàn cầu đang bước vào giai đoạn tái cấu trúc quy mô lớn, dẫn đầu bởi sự trỗi dậy của AI và nhu cầu tích hợp dữ liệu để hỗ trợ các ứng dụng trí tuệ nhân tạo.

-

Trong 2 tháng qua, Databricks mua Neon với giá 1 tỷ USD, còn Salesforce thâu tóm Informatica với giá 8 tỷ USD – cả hai thương vụ đều nhằm củng cố nền tảng dữ liệu cho chiến lược AI.

-

Theo các chuyên gia, thành công của AI phụ thuộc lớn vào chất lượng dữ liệu đầu vào – yếu tố mà các nhà đầu tư mạo hiểm đã nhấn mạnh từ lâu.

-

Gaurav Dhillon, nhà sáng lập SnapLogic và cựu CEO Informatica, cho rằng “muốn làm chủ AI, doanh nghiệp phải xây lại toàn bộ nền tảng dữ liệu”.

-

Tuy nhiên, ông cũng cảnh báo rằng nhiều công ty được mua lại được xây dựng trước thời kỳ AI hậu-ChatGPT, nên có thể không thích ứng nhanh với thị trường AI hiện đại.

-

Từ năm 2020–2024, đã có hơn 300 tỷ USD rót vào 24.000 startup dữ liệu, tạo ra một hệ sinh thái rời rạc, chắp vá – nguyên nhân chính khiến các tập đoàn lớn phải thâu tóm để bịt lỗ hổng dữ liệu.

-

Ví dụ điển hình là thương vụ Fivetran mua lại Census vào tháng 5/2025 nhằm tạo ra giải pháp dữ liệu hai chiều hoàn chỉnh. Trước đó, khách hàng Fivetran phải dùng thêm dịch vụ ngoài để xuất dữ liệu.

-

Theo chuyên gia Sanjeev Mohan, tính không tương thích giữa các hệ thống dữ liệu là lý do chính thúc đẩy làn sóng sáp nhập. Đặc biệt, việc thiếu chuẩn hóa metadata gây chồng chéo và rối loạn thông tin.

-

Thị trường đầu tư mạo hiểm cũng góp phần đẩy nhanh xu hướng này. Trong bối cảnh khó gọi vốn và IPO trầm lắng, nhiều startup chọn bán mình là con đường khả thi nhất.

-

Salesforce được cho là đã giảm giá so với đàm phán năm ngoái khi mua Informatica, nhưng thương vụ vẫn được hội đồng quản trị ủng hộ vì đây là lựa chọn tối ưu.

-

Derek Hernandez (PitchBook) nhận định: “Các công ty dữ liệu độc lập không còn nhiều động lực để tồn tại riêng lẻ, khi thị trường đòi hỏi tích hợp chặt chẽ giữa dữ liệu và AI”.

-

Điều này đặt ra câu hỏi chiến lược: Liệu ngành dữ liệu và ngành AI sẽ tiếp tục độc lập hay sáp nhập là xu hướng tất yếu để chiếm lĩnh thị trường AI tương lai?

📌 Với hơn 300 tỷ USD đầu tư và hàng loạt thương vụ tỷ đô như Salesforce – Informatica (8 tỷ USD) hay Databricks – Neon (1 tỷ USD), ngành dữ liệu đang trải qua làn sóng hợp nhất lớn chưa từng có dưới sức ép từ AI. Tuy nhiên, chuyên gia cảnh báo rằng nhiều nền tảng dữ liệu cũ không phù hợp với thị trường AI hậu-ChatGPT, và chỉ sự tích hợp sâu giữa dữ liệu và AI mới tạo ra giá trị bền vững trong cuộc đua trí tuệ nhân tạo.

https://techcrunch.com/2025/07/07/ai-is-forcing-the-data-industry-to-consolidate-but-thats-not-the-whole-story/

-

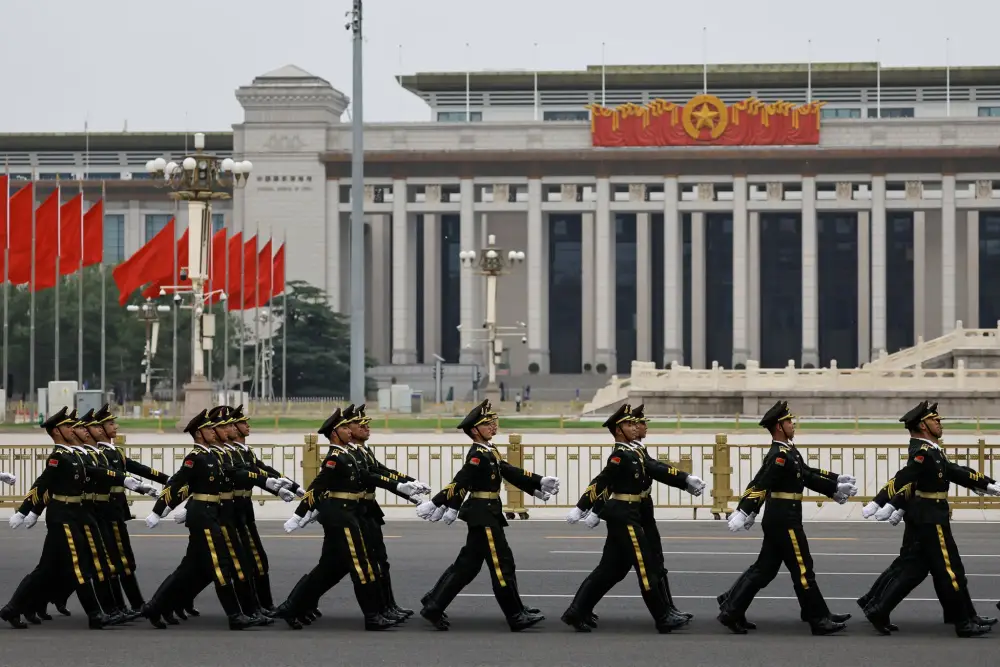

Trung Quốc hiện có hơn 1,1 tỷ người dùng internet – tạo ra lượng dữ liệu lớn nhất thế giới, cộng với mạng lưới camera nhận diện khuôn mặt, xe tự lái và công nghệ bay đang phát triển.

-

Không chỉ sở hữu khối lượng dữ liệu khổng lồ, Trung Quốc còn tích hợp việc quản lý dữ liệu vào chiến lược phát triển kinh tế và an ninh quốc gia.

-

Chủ tịch Tập Cận Bình gọi dữ liệu là "nguồn lực cơ bản" mang tính cách mạng trong cạnh tranh toàn cầu, đặt nó ngang hàng với lao động, vốn và đất đai.

-

Kể từ năm 2021, Trung Quốc ban hành các quy định tương tự GDPR châu Âu, nhưng giờ đây đã đi theo hướng riêng: yêu cầu mọi cấp chính quyền chia sẻ dữ liệu, định giá tài sản dữ liệu tại doanh nghiệp nhà nước và cho phép giao dịch trên sàn dữ liệu nhà nước.

-

Một bước đi lớn là hệ thống ID số toàn dân dự kiến ra mắt ngày 15/07/2025. Mỗi người dân sẽ có một sổ cái ghi lại toàn bộ hoạt động online – nhưng các công ty công nghệ chỉ thấy dòng ký tự vô danh.

-

Điều này làm suy giảm vai trò kiểm soát của các công ty công nghệ tư nhân và chuyển trung tâm quyền lực dữ liệu về tay nhà nước – dẫn tới khả năng giám sát tập trung chưa từng có.

-

Hệ thống “đại dương dữ liệu quốc gia” sẽ tích hợp dữ liệu cá nhân, công nghiệp, chính phủ, giúp đào tạo mô hình AI nhanh hơn và tạo điều kiện cho các startup nhỏ gia nhập thị trường.

-

Nhưng rủi ro cũng rõ ràng: chính phủ Trung Quốc có lịch sử quản lý dữ liệu cá nhân kém, từng để rò rỉ 1 tỷ bản ghi dữ liệu ở Thượng Hải.

-

Việc bóp nghẹt sở hữu dữ liệu của khu vực tư nhân có thể làm suy giảm động lực đổi mới và lợi nhuận doanh nghiệp.

-

Mô hình này có thể hiệu quả về mặt kinh tế nhưng bị ví như “thiên đường cho Big Brother” – gợi nhớ đến xã hội bị giám sát toàn diện.

📌

Trung Quốc đang định hình một "đế chế dữ liệu" toàn diện, tích hợp dữ liệu cá nhân, doanh nghiệp và chính phủ để dẫn đầu cuộc đua AI. Với hệ thống ID số ra mắt ngày 15/07/2025 và yêu cầu chia sẻ dữ liệu toàn quốc, quốc gia này có thể tạo ra mô hình AI từ cốt lõi với lợi thế quy mô khổng lồ. Tuy nhiên, mô hình này đe dọa quyền riêng tư và làm mờ ranh giới giữa kiểm soát công nghệ và giám sát xã hội.

https://www.economist.com/leaders/2025/07/03/china-is-building-an-entire-empire-on-data

China is building an entire empire on data

It will change the online economy and the evolution of artificial intelligence

-

Cuốn sách The AI Con của Alex Hanna và Emily M. Bender tiết lộ rằng AI hiện đại phụ thuộc vào hàng triệu lao động vô hình, làm công việc dán nhãn dữ liệu, kiểm duyệt và kiểm tra nội dung độc hại.

-

Ví dụ, hãng xe tự lái Cruise thừa nhận robotaxi của họ phải nhờ người điều khiển từ xa 2–4% thời gian trong các tình huống phức tạp.

-

Công việc bao gồm:

-

Vẽ khung quanh đối tượng trong ảnh để huấn luyện xe tự lái.

-

Đánh giá mức độ hữu ích, phản cảm hoặc sai lệch của phản hồi từ mô hình ngôn ngữ.

-

Gắn nhãn các nội dung bạo lực, khiêu dâm hoặc phát ngôn thù ghét.

-

-

ImageNet, bộ dữ liệu nền tảng cho AI thị giác, được tạo nên nhờ 50.000 lao động từ 167 quốc gia, thực hiện trên nền tảng Amazon Mechanical Turk (MTurk) trong hơn 2,5 năm, với hơn 14 triệu hình ảnh.

-

Các công ty như Sama, Remotasks, Prolific hoạt động dưới mô hình thuê ngoài, đẩy trách nhiệm và điều kiện lao động tồi tệ xuống tầng thấp nhất.

-

Lao động phải tiếp xúc với nội dung cực kỳ độc hại nhưng không nhận được hỗ trợ tâm lý đầy đủ. Ví dụ, một nhân viên tại Sama cho biết sau 5 tháng, gia đình không còn nhận ra anh sau khi tiếp xúc quá lâu với nội dung tra tấn và bạo lực.

-

Công việc redteaming cũng phổ biến: thử nghiệm AI bằng cách đặt các câu hỏi khiêu khích, bạo lực hoặc đạo đức để kiểm tra phản ứng.

-

Tình trạng mất việc đột ngột, khóa tài khoản mà không có lý do là rất phổ biến, như vụ Remotasks chặn toàn bộ lao động tại Kenya, Rwanda, Nam Phi vào năm 2024.

-

Công việc này lẽ ra có thể bền vững nếu có bảo vệ quyền lợi lao động, hỗ trợ tâm lý và mức lương xứng đáng.

📌 Cuốn The AI Con vạch trần rằng AI không hoàn toàn là phép màu công nghệ, mà được xây dựng trên lưng của hàng triệu lao động vô hình, đối mặt với nội dung độc hại mỗi ngày với mức lương rẻ mạt. Công nghiệp AI hiện đại tồn tại nhờ bóc lột dữ liệu và sức lao động giá rẻ toàn cầu.

https://restofworld.org/2025/the-ai-con-book-invisible-labor/

-

Cuộc đua phát triển ứng dụng AI đang khiến nhu cầu dữ liệu huấn luyện tại Trung Quốc tăng vọt, đặc biệt sau thành công của DeepSeek, chatbot Trung Quốc có khả năng cạnh tranh với ChatGPT nhưng chi phí huấn luyện thấp hơn nhiều.

-

Sapien AI, công ty Canada, đặt văn phòng tại Shenyang (Trung Quốc) để tận dụng chi phí thấp và chính sách hỗ trợ địa phương. Họ thuê hơn 60 nhân viên chỉ để dán nhãn dữ liệu bản đồ cho dự án xe tự lái.

-

Rogier Creemers, chuyên gia tại Đại học Leiden, nhận định Trung Quốc coi dữ liệu như tài nguyên chiến lược, tương tự dầu mỏ hoặc khoáng sản.

-

Từ năm 2024, Trung Quốc siết chặt kiểm soát xuất khẩu dữ liệu số: mọi xuất khẩu dữ liệu số phải được cơ quan quản lý không gian mạng phê duyệt.

-

Olga Megorskaya, CEO Toloka (công ty Hà Lan), so sánh AI đời đầu như trẻ 2 tuổi chỉ học sách tranh, còn AI hiện tại giống sinh viên đại học cần dữ liệu chuyên sâu, kỹ thuật và phức tạp hơn.

-

Các thành phố công nghiệp cũ như Shenyang đang chuyển mình thành trung tâm dữ liệu AI nhờ chính sách hỗ trợ lãi suất thấp, văn phòng giá rẻ và ưu đãi cho doanh nghiệp.

-

Nghề dán nhãn dữ liệu, kiểm tra chất lượng dữ liệu trở thành công việc phổ biến cho giới trẻ, đặc biệt khi tỷ lệ thất nghiệp thanh niên tại Trung Quốc vẫn ở mức cao.

-

Huang Rui (21 tuổi), chuyên viên kiểm tra dữ liệu tại Sapien AI, cho biết công việc này phù hợp với những người có tính cách tỉ mỉ, chú ý chi tiết cao.

-

Chen, CEO Sapien AI, thừa nhận công việc có phần nhàm chán nhưng cực kỳ cần thiết cho sự phát triển AI.

📌 Trung Quốc trở thành điểm nóng dữ liệu AI khi nhu cầu huấn luyện mô hình bùng nổ. Chính sách hạn chế xuất khẩu dữ liệu khiến các công ty nước ngoài như Sapien AI phải đặt văn phòng tại Trung Quốc. Nghề dán nhãn dữ liệu trở thành công việc mới cho giới trẻ giữa làn sóng chuyển đổi số.

https://www.npr.org/2025/06/29/nx-s1-5422330/the-race-to-create-ai-applications-is-creating-demand-for-training-data-in-china

-

Báo cáo toàn cầu do EDB thực hiện vào tháng 2/2025 cho thấy gần 2/3 lãnh đạo cấp cao trên toàn cầu xác định rằng chủ quyền dữ liệu và AI không còn là lựa chọn, mà là yếu tố sống còn cho doanh nghiệp.

-

Tỷ lệ nhận thức hiện tại về mức độ “bắt buộc” của chủ quyền dữ liệu dao động từ 11% (Pháp) đến 27% (Ả Rập Saudi và UAE). Dự báo trong 3 năm tới, Đức sẽ dẫn đầu với 69%, tiếp theo là Mỹ và Saudi. Nhật Bản, Anh và Ý sẽ tụt lại phía sau.

-

Động lực chính không phải địa chính trị mà là phá vỡ silo dữ liệu, chiếm tỷ lệ áp đảo 2:1 so với các lý do khác.

-

Thứ tự ba lý do chính:

-

46% chuyển workloads sang mô hình hybrid để phá vỡ silo dữ liệu.

-

40% chuyển AI và dữ liệu sang nền tảng mã nguồn mở.

-

48% tích hợp bảo mật và hạ tầng cho môi trường hybrid.

-

-

Kết quả cho thấy công thức vận hành của doanh nghiệp dẫn đầu AI gồm: hạ tầng hybrid, mã nguồn mở và bảo mật tích hợp.

-

Ngành tài chính - ngân hàng - bảo hiểm chịu áp lực lớn nhất, với 50% lãnh đạo đồng thuận rằng AI và dữ liệu cần hội tụ, chủ quyền là bắt buộc, nhằm cung cấp trải nghiệm kiểu Amazon cho khách hàng.

-

Chúng ta đang bước vào giai đoạn các doanh nghiệp buộc phải trở thành nền tảng AI và dữ liệu có chủ quyền của chính mình, thay vì dựa vào các giải pháp rời rạc.

-

Một tương lai với thêm 50 doanh nghiệp kiểu Amazon, tạo ra 100 nghìn tỷ USD giá trị vốn hóa mới, đang nằm trong tầm tay với điều kiện doanh nghiệp kiểm soát được dữ liệu và AI.

-

Báo cáo đầy đủ sẽ công bố cuối năm 2025, bao gồm dữ liệu từ 13 nền kinh tế (48 nghìn tỷ USD GDP), cung cấp khung ra quyết định cho doanh nghiệp về AI, dữ liệu và chiến lược nền tảng.

📌 2/3 lãnh đạo doanh nghiệp toàn cầu xác định chủ quyền AI và dữ liệu là điều bắt buộc. 46% đang chuyển sang hạ tầng hybrid, 40% ưu tiên mã nguồn mở và 48% tích hợp bảo mật sâu. Đặc biệt, ngành tài chính ghi nhận 50% lãnh đạo hướng tới mô hình AI chủ quyền để đạt tham vọng như Amazon. Tương lai doanh nghiệp thuộc về những ai làm chủ dữ liệu ngay từ bây giờ.

https://venturebeat.com/ai/ai-and-data-sovereignty-are-now-non-negotiable-for-enterprise-leaders-global-survey-finds/

-

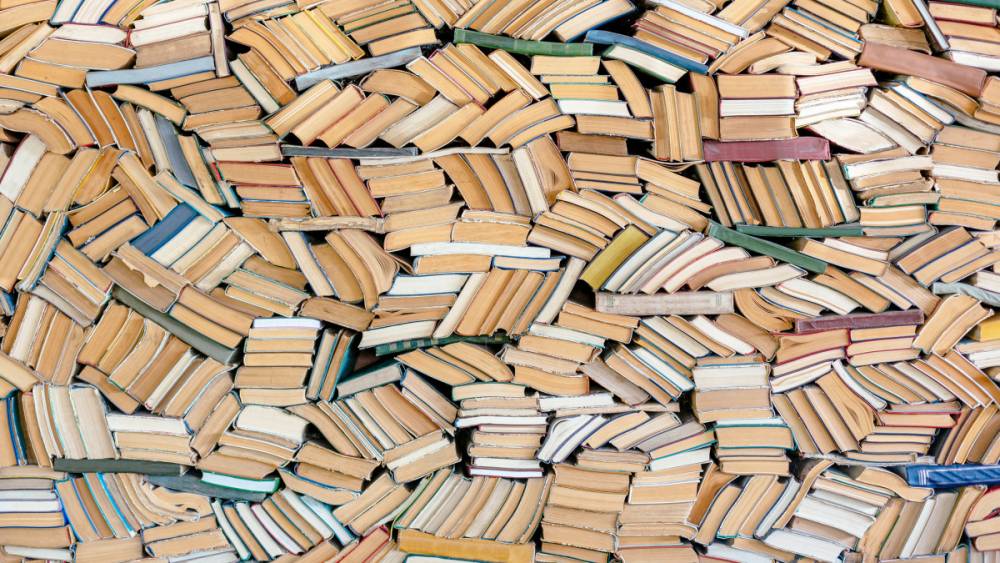

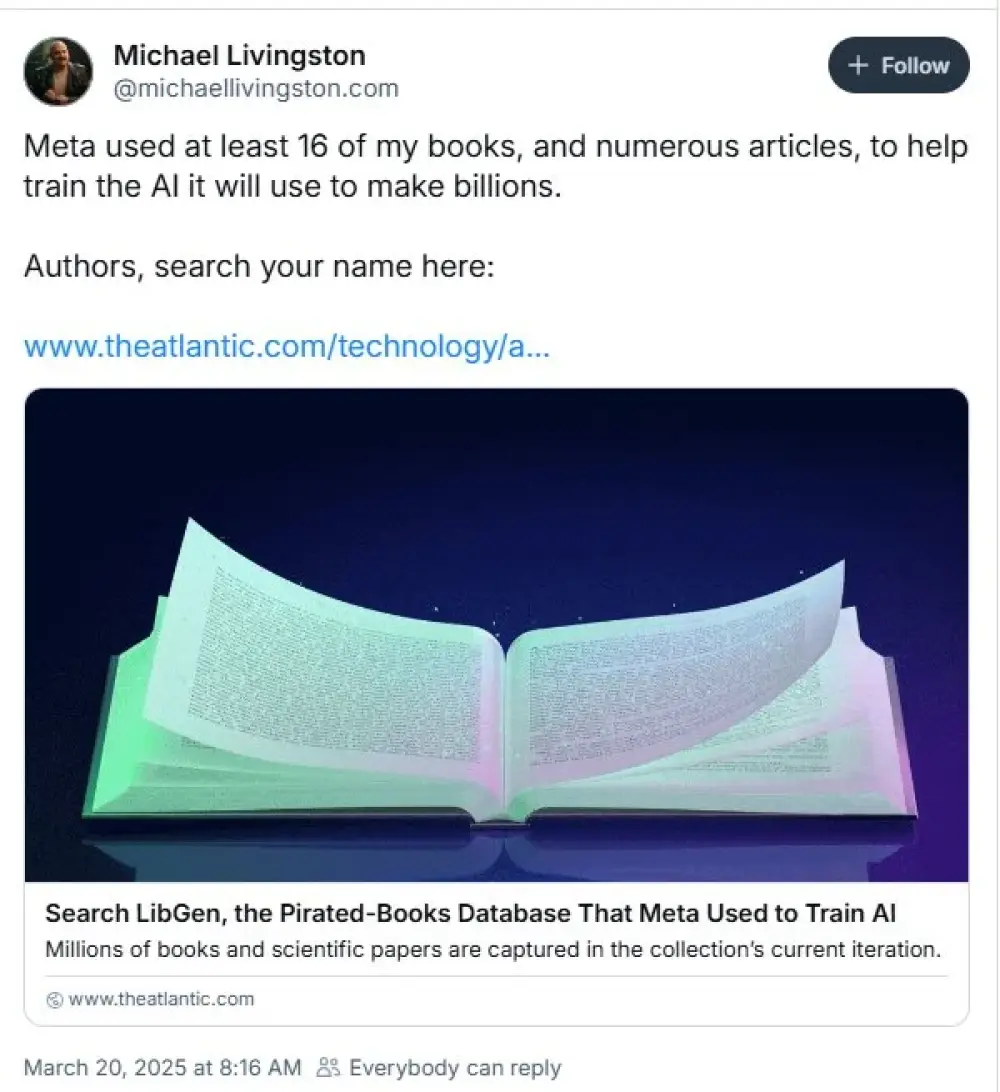

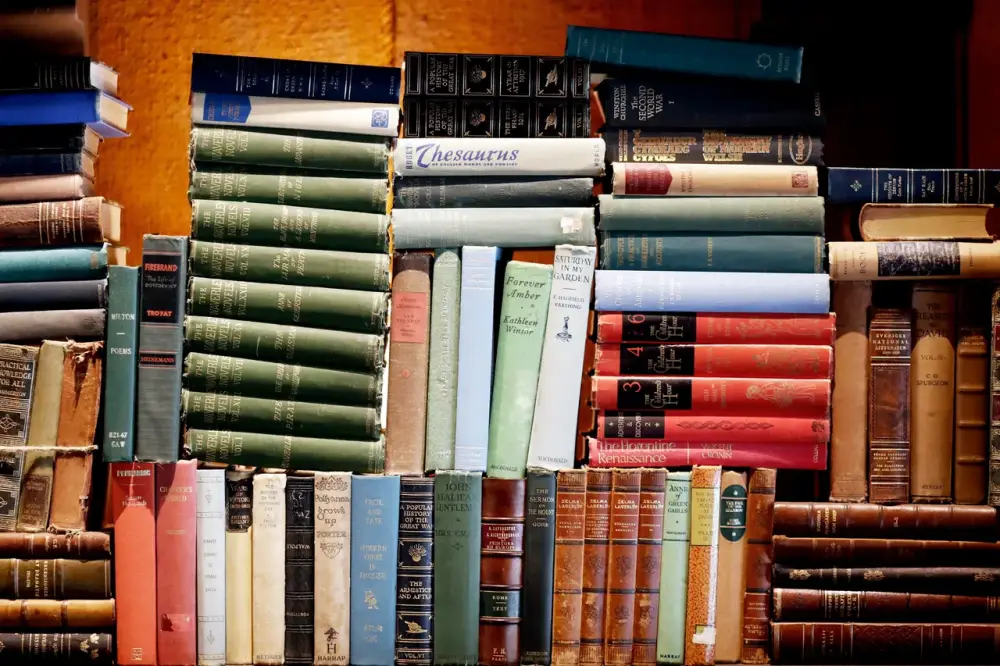

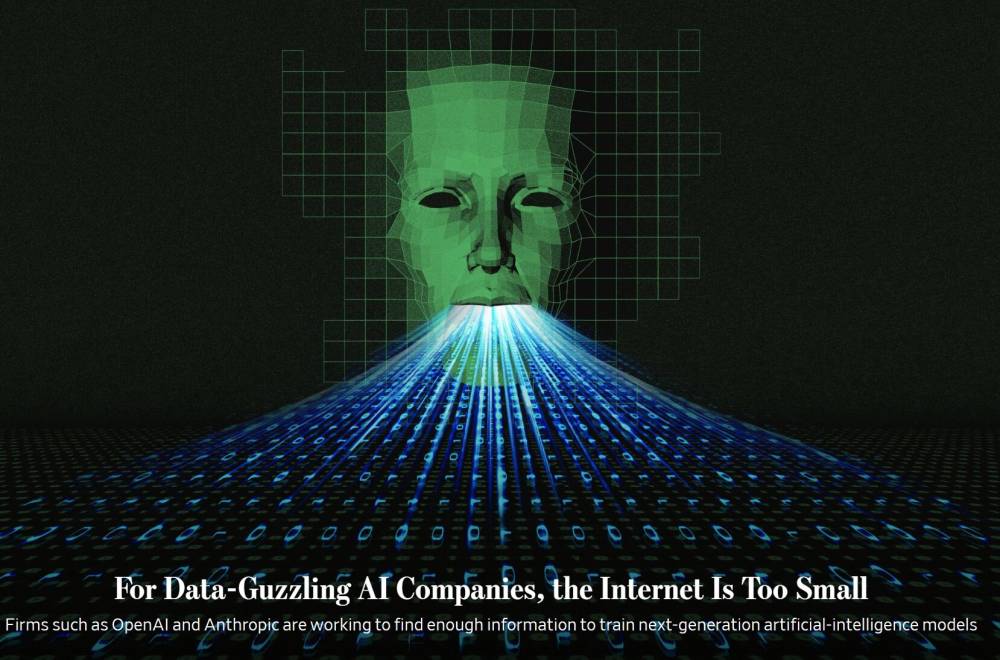

Vào tháng 2/2024, công ty AI Anthropic đã thuê Tom Turvey, cựu giám đốc đối tác của dự án Google Books, để dẫn đầu chiến dịch quét và số hóa “tất cả sách trên thế giới”.

-

Anthropic chi hàng triệu USD để mua sách in, sau đó cắt bỏ bìa, tháo rời từng trang để quét thành file PDF có thể đọc máy, sau đó vứt bỏ bản gốc vật lý.

-

Khác với Google Books sử dụng công nghệ quét không phá hủy, Anthropic chọn phương pháp quét phá hủy nhằm tiết kiệm chi phí và thời gian trong bối cảnh cạnh tranh khốc liệt của ngành AI.

-

Theo hồ sơ tòa án, ban đầu Anthropic đã sử dụng các bản sách lậu trên mạng để huấn luyện AI, nhưng sau đó lo ngại rủi ro pháp lý nên chuyển sang phương thức mua sách vật lý.

-

Việc này dựa vào nguyên lý “first-sale doctrine” (quyền sử dụng sau bán): mua sách rồi có thể sử dụng bản đó theo ý mình, bao gồm cả việc phá hủy để số hóa.

-

Tòa án, dưới sự chủ trì của thẩm phán William Alsup, phán quyết rằng hành vi này được coi là “fair use” (sử dụng hợp lý) vì Anthropic đã mua hợp pháp sách, không phân phối lại dữ liệu mà chỉ dùng nội bộ để huấn luyện AI.

-

Thẩm phán ví hành động này như việc chuyển đổi định dạng để tiết kiệm không gian, và coi đây là hành vi mang tính “chuyển đổi”.

-

Anthropic mua sách cũ với số lượng lớn từ các nhà bán lẻ lớn, không có ghi nhận về việc phá hủy sách hiếm hay quý hiếm.

-

Quy trình số hóa của Anthropic đi ngược lại với các mô hình bảo tồn văn hóa như Internet Archive hay OpenAI-Harvard, vốn sử dụng phương pháp quét không phá hủy để bảo tồn sách cổ và tài liệu quý.

-

Trong khi Harvard đang bảo tồn các bản thảo từ thế kỷ 15 để huấn luyện AI, thì hàng triệu cuốn sách bị phá hủy đã góp phần tạo nên Claude – AI có khả năng giúp người dùng viết văn, thảo luận văn học và xử lý kiến thức.

📌 Anthropic chi hàng triệu USD mua sách in rồi tiêu hủy để huấn luyện AI Claude, bất chấp tranh cãi đạo đức. Quy trình quét phá hủy giúp tiết kiệm chi phí so với quét không phá hủy. Tòa án Mỹ xác nhận hành vi này là “fair use” nhờ mua hợp pháp và không phân phối lại. Đây là trường hợp điển hình về cơn khát dữ liệu chất lượng cao trong cuộc đua AI hiện nay.

https://arstechnica.com/ai/2025/06/anthropic-destroyed-millions-of-print-books-to-build-its-ai-models/

-

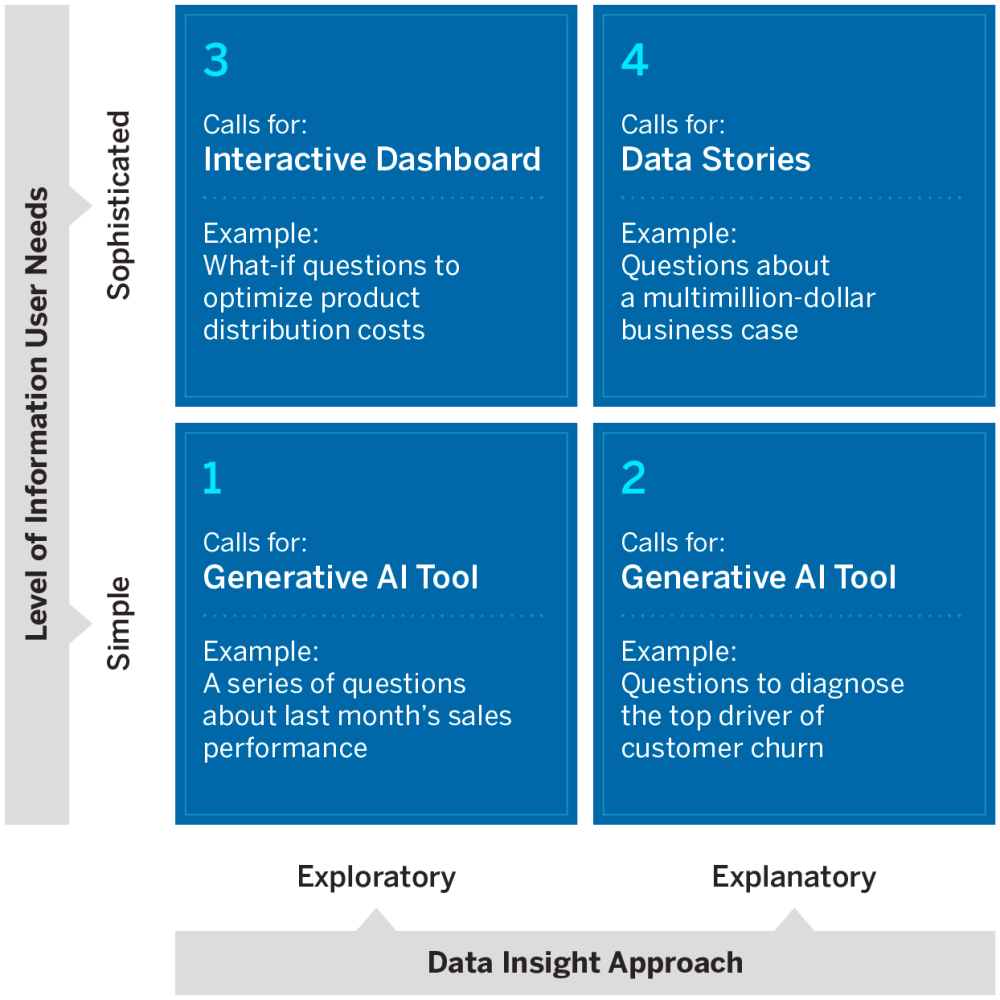

Tại hội nghị VentureBeat Transform 2025, BCG nhấn mạnh việc triển khai AI doanh nghiệp vấp phải thách thức lớn nhất nằm ở dữ liệu – đặc biệt là dữ liệu bị bỏ qua hoặc chưa chuẩn hóa.

-

Braden Holstege, Giám đốc BCG, chia sẻ rằng doanh nghiệp cần xem xét kỹ các yếu tố như phơi nhiễm dữ liệu, ngân sách AI cho từng người, quyền truy cập và quản trị rủi ro.

-

Ví dụ, một khách hàng đã sử dụng LLM để phân tích dữ liệu về tỷ lệ rời bỏ khách hàng, khiếu nại và phản hồi tích cực – các insight mà trước đây NLP không thể khai thác.

-

Dữ liệu không đồng nhất: Từ giao dịch, tài liệu, phản hồi khách hàng cho đến trace data trong quá trình phát triển ứng dụng đều có giá trị cho AI.

-

Susan Etlinger, nhà phân tích ngành, nhấn mạnh AI-ready data là yếu tố sống còn, giúp doanh nghiệp nhận ra những khả năng mới trong quá trình vận hành AI.

-

Báo cáo từ Gartner:

-

60% dự án AI sẽ bị hủy bỏ trước năm 2026 nếu thiếu dữ liệu AI-ready.

-

63% các lãnh đạo dữ liệu thừa nhận chưa có quy trình quản lý dữ liệu phù hợp.

-

-

Awais Sher Bajwa, Giám đốc dữ liệu và AI ngân hàng Bank of America, cảnh báo doanh nghiệp cần giải quyết các vấn đề như AI model drift và đảm bảo quá trình triển khai AI là hợp tác, không cần ép buộc người dùng cuối vốn đã quen với chatbot.

-

Về hạ tầng, doanh nghiệp phải cân nhắc giữa cloud, on-prem và hybrid. Các nhà cung cấp như Nvidia, AMD, NeoClouds mang lại nhiều lựa chọn tiết kiệm hơn nhưng đòi hỏi cân bằng giữa chi phí, bảo mật và tối ưu hóa.

-

Holstege nhấn mạnh rằng mô hình nguồn mở như Llama, Mistral tuy tiết kiệm chi phí license nhưng yêu cầu compute cao hơn và phức tạp trong quản lý dữ liệu.

📌 Boston Consulting Group cảnh báo doanh nghiệp có thể thất bại tới 60% dự án AI đến năm 2026 nếu bỏ qua dữ liệu AI-ready. Việc tận dụng dữ liệu bị lãng quên như trace data, phản hồi khách hàng giúp khai phá giá trị AI thực sự. Tuy nhiên, doanh nghiệp cần cân nhắc chi phí tính toán, bảo mật và lựa chọn hạ tầng phù hợp giữa cloud, on-prem hoặc hybrid, đặc biệt khi sử dụng mô hình nguồn mở như Llama và Mistral.

https://venturebeat.com/ai/boston-consulting-group-to-unlock-enterprise-ai-value-start-with-the-data-youve-been-ignoring/

-

Ngày 12/6/2025, Alexandr Wang chính thức từ chức CEO Scale AI để đảm nhận vị trí lãnh đạo phòng AI siêu trí tuệ tại Meta. Thương vụ đi kèm khoản đầu tư 14,3 tỷ USD từ Meta vào Scale, nhưng "món hời thật sự là Wang", không phải công ty.

-

Mặc dù không xuất thân từ giới học thuật AI đỉnh cao, Wang – 28 tuổi – có tham vọng mãnh liệt và hiểu sâu về dữ liệu huấn luyện AI, từng được Sam Altman đánh giá cao và từng sống cùng thời gian dài trong đại dịch.

-

Trả lời TIME, Wang cho rằng tương lai kinh tế sẽ chuyển sang mô hình “agentic” – nơi doanh nghiệp, chính phủ và thậm chí cả chiến tranh đều do AI agent điều hành, con người chỉ còn vai trò giám sát.

-

Ông khẳng định quá trình chuyển đổi này sẽ phức tạp, cần chuẩn bị hạ tầng, chính sách và quy định chặt chẽ để tránh gián đoạn xã hội.

-

Về dữ liệu, Wang cho rằng ngành AI luôn có “điểm mù” và chính những điểm yếu của mô hình tạo ra nhu cầu không ngừng cho dữ liệu mới. Do đó, công việc gắn nhãn dữ liệu không biến mất mà còn gia tăng.

-

Mô hình AI hiện nay tuy ấn tượng ở bề nổi, nhưng khi ứng dụng thực tế thì lộ rõ thiếu sót. Từ đó, nhu cầu cải tiến bằng dữ liệu vẫn tiếp diễn vô tận.

-

Mặc dù Scale AI đối mặt với sự chỉ trích về việc trả chậm cho hơn 240.000 lao động hợp đồng, Wang cho rằng công ty đang cải tiến liên tục. Lucy Guo – đồng sáng lập Scale – từng rời đi vì bất đồng về vấn đề đối xử với lực lượng này.

-

Wang nhìn nhận thành công của Scale đến từ việc coi dữ liệu là trụ cột thứ ba cùng với thuật toán và phần cứng. Công ty đã giúp xây dựng các nền tảng cho doanh nghiệp và chính phủ triển khai AI trên dữ liệu nội bộ.

-

Mặc dù OpenAI và Google đang cắt quan hệ với Scale vì thương vụ Meta, Wang khẳng định thị trường “AI data” vẫn tăng trưởng mạnh, và Scale sẽ đóng vai trò nền tảng dữ liệu cho thế giới AI agent trong tương lai.

📌 Alexandr Wang rời Scale AI để dẫn dắt tham vọng “AI siêu trí tuệ” tại Meta với khoản đầu tư 14,3 tỷ USD. Ông cảnh báo rằng AI càng phát triển, các thiếu sót càng bộc lộ rõ, dẫn tới nhu cầu dữ liệu ngày càng lớn. Với tầm nhìn về một thế giới do AI agent điều hành, Wang coi dữ liệu là trụ cột sống còn và không ngừng thúc đẩy tốc độ cải tiến bất chấp rủi ro xã hội.

https://time.com/7296215/alexandr-wang-interview/

-

Chính phủ Anh tuyên bố sẽ không buộc các công ty AI tiết lộ nội dung bản quyền được dùng trong quá trình huấn luyện mô hình, bất chấp yêu cầu mạnh mẽ từ Thượng viện.

-

Hôm thứ Tư, các thành viên Thượng viện đã bỏ phiếu 221–116 để thông qua sửa đổi trong đạo luật dữ liệu nhằm yêu cầu minh bạch về dữ liệu huấn luyện AI.

-

Tuy nhiên, chính phủ đã bác bỏ sửa đổi này vào thứ Sáu, thay vào đó cam kết công bố đánh giá tác động kinh tế và báo cáo kỹ thuật về tương lai bản quyền và AI.

-

Beeban Kidron, đạo diễn và thành viên độc lập của Thượng viện, cáo buộc chính phủ “nói dối Quốc hội và ngành sáng tạo”, cho rằng họ đã rút bỏ mọi biện pháp bảo vệ quyền tác giả khỏi đạo luật dữ liệu.

-

Hiệp hội Truyền thông Tin tức (NMA) cảnh báo rằng có thể sẽ tiếp tục đưa sửa đổi vào khi dự luật quay lại Thượng viện vào tuần tới.

-

Kidron nói chính phủ đang "phá hoại ngành công nghiệp lớn thứ hai nước Anh", đồng thời làm xói mòn niềm tin của nhiều lĩnh vực vào chính phủ.

-

CEO NMA, Owen Meredith, nhấn mạnh chính phủ cần bổ sung quyền minh bạch vào đạo luật, điều này ảnh hưởng tới niềm tin trong ngành trị giá 126 tỷ bảng Anh (~160 tỷ USD).

-

Các nghệ sĩ lớn như Elton John, Paul McCartney, Kate Bush và các tổ chức như National Theatre đã công khai chỉ trích lập trường của chính phủ về bản quyền AI.

-

Cuộc tham vấn đang diễn ra về thay đổi chính sách bản quyền có 4 phương án:

-

Cho phép AI dùng tác phẩm bản quyền không xin phép

-

Cho phép “opt-out” cho nghệ sĩ

-

Giữ nguyên hiện trạng

-

Bắt buộc xin giấy phép (Kidron đề xuất)

-

-

Bộ trưởng Công nghệ Peter Kyle tuyên bố phương án miễn trừ kèm quyền opt-out không còn là lựa chọn ưu tiên, nhưng chưa có đảm bảo cụ thể về việc yêu cầu cấp phép.

📌 Chính phủ Anh gây tranh cãi dữ dội khi từ chối yêu cầu minh bạch dữ liệu huấn luyện AI, bất chấp Thượng viện và các nghệ sĩ lớn kêu gọi bảo vệ bản quyền. Với ngành sáng tạo trị giá 126 tỷ bảng đang bị đe dọa, các tổ chức như NMA và nhiều nhân vật nổi tiếng tiếp tục kêu gọi điều chỉnh luật dữ liệu để yêu cầu các công ty AI xin phép khi sử dụng nội dung có bản quyền.

https://www.theguardian.com/law/2025/jun/06/uk-government-signals-it-will-not-force-tech-firms-to-disclose-how-they-train-ai

-

Trung Quốc thông báo sẽ thành lập 10 khu thí điểm dữ liệu quốc gia tại các địa phương như Bắc Kinh, Chiết Giang, An Huy nhằm thúc đẩy nền kinh tế số và tăng tốc trong cuộc đua AI với Mỹ.

-

Theo Đài truyền hình trung ương CCTV, sáng kiến này khuyến khích chính quyền địa phương dẫn đầu trong việc phát triển thị trường dữ liệu và nuôi dưỡng các doanh nghiệp hoạt động trong lĩnh vực dữ liệu.

-

Mục tiêu của các khu dữ liệu là tích hợp kinh tế thực và kinh tế số, mở khóa giá trị kinh tế thông qua ứng dụng dữ liệu trên diện rộng.

-

Trung Quốc hiện có hơn 190.000 doanh nghiệp dữ liệu, với quy mô thị trường vượt 2.000 tỷ NDT (278,4 tỷ USD) và dự kiến đạt 7.500 tỷ NDT (~1.044 tỷ USD) vào năm 2030.

-

Kế hoạch hành động 3 năm (2024–2026) do 17 cơ quan chính phủ ban hành đặt mục tiêu gấp đôi khối lượng giao dịch dữ liệu và xây dựng hơn 300 kịch bản ứng dụng tiêu biểu trong các ngành nghề.

-

Tại cuối năm 2024, Bắc Kinh đã công bố bản kế hoạch tăng trưởng ngành dữ liệu, với mục tiêu tăng trưởng trên 15%/năm đến năm 2029, đồng thời đặt ưu tiên vào trí tuệ nhân tạo và công nghệ liên quan đến dữ liệu.

-

Ông Luan Jie (Phó Cục trưởng Vụ Chính sách và Quy hoạch – NDA) cho biết, gần 500 công ty con công nghệ số đã được các doanh nghiệp nhà nước trung ương thành lập theo kế hoạch 3 năm.

-

Khoảng 66% doanh nghiệp hàng đầu trong các ngành đã mua dữ liệu, giúp rút ngắn chu kỳ phát triển và thu mua hơn 30%, giảm thời gian luân chuyển hàng tồn từ 3 tháng xuống chỉ 1 tháng.

-

Trong nông nghiệp, việc ứng dụng dữ liệu đã giúp một số doanh nghiệp tăng năng suất cây trồng lên 5,5%.

📌 Trung Quốc chuẩn bị triển khai 10 khu dữ liệu quốc gia nhằm tăng tốc nền kinh tế số trị giá 2.000 tỷ NDT, đặt mục tiêu đạt 7.500 tỷ NDT vào 2030. Kế hoạch này giúp cắt giảm 30% thời gian phát triển sản phẩm và nâng năng suất nông nghiệp 5,5%, là đòn bẩy chiến lược trong cuộc đua AI toàn cầu với Mỹ.

https://www.scmp.com/economy/china-economy/article/3313325/china-eyes-10-new-national-data-zones-digital-economy-push-ai-race-us

-

DeepSeek ra mắt phiên bản cập nhật mô hình AI R1, nổi bật về toán học và lập trình nhưng không công bố nguồn dữ liệu huấn luyện.

-

Một nhà phát triển tại Melbourne, Sam Paech, tung bằng chứng cho thấy mô hình R1-0528 của DeepSeek có xu hướng dùng từ ngữ giống Gemini 2.5 Pro của Google, nghi ngờ đã dùng dữ liệu Gemini để huấn luyện.

-

Nhận định bổ sung từ nhà sáng lập SpeechMap cho rằng "dấu vết suy nghĩ" của R1-0528 giống Gemini.

-

DeepSeek từng bị nghi dùng dữ liệu từ các AI đối thủ: tháng 12/2024, mô hình DeepSeek V3 thường tự nhận là ChatGPT, có thể do dùng log chat của ChatGPT huấn luyện.

-

Đầu 2025, OpenAI thông báo phát hiện DeepSeek sử dụng kỹ thuật distillation để trích xuất dữ liệu từ mô hình mạnh hơn. Microsoft cũng phát hiện lượng lớn dữ liệu bị sao chép thông qua tài khoản nhà phát triển OpenAI nghi liên quan DeepSeek.

-

OpenAI cấm sử dụng kết quả đầu ra để xây dựng AI cạnh tranh, nhưng distillation lại phổ biến trong ngành.

-

Việc các mô hình AI dùng từ ngữ, biểu đạt giống nhau không hiếm do dữ liệu web ngày càng "ô nhiễm" bởi nội dung do AI tạo, khiến khó lọc và phân loại dữ liệu sạch cho huấn luyện.

-

Chuyên gia Nathan Lambert từ AI2 cho rằng DeepSeek có thể đã chủ động dùng API Gemini để tạo dữ liệu tổng hợp, do thiếu GPU nhưng có nguồn vốn lớn, tận dụng “nhiều tính toán hơn” theo cách riêng.

-

Để ngăn distillation, các công ty AI tăng cường bảo mật: OpenAI bắt buộc xác minh ID cho tổ chức truy cập mô hình nâng cao (không hỗ trợ Trung Quốc).

-

Google và Anthropic bắt đầu tóm tắt (summarize) các "trace" mô hình để gây khó khăn cho việc huấn luyện đối thủ từ dấu vết Gemini, bảo vệ lợi thế cạnh tranh.

-

Sự kiện hé lộ căng thẳng cạnh tranh, chạy đua công nghệ và nâng cấp bảo mật trong thế giới AI tạo sinh.

📌 DeepSeek bị nghi dùng dữ liệu Gemini (Google) để huấn luyện AI R1-0528 mới, với bằng chứng về dấu vết từ ngữ và cách vận hành tương đồng; từng có tiền sử dùng dữ liệu ChatGPT. Các ông lớn AI tăng cường bảo mật, OpenAI cấm distillation, Google/Anthropic tóm tắt trace để bảo vệ dữ liệu. Cạnh tranh AI toàn cầu ngày càng phức tạp và gay gắt.

https://techcrunch.com/2025/06/03/deepseek-may-have-used-googles-gemini-to-train-its-latest-model/

-

Grok, chatbot do công ty xAI của Elon Musk phát triển, hiện đang được một bộ phận chính phủ Mỹ sử dụng, cụ thể là Đội ngũ Hiệu quả Chính phủ (DOGE) – một nhóm do Musk lập ra.

-

Grok ban đầu ra đời như một đối trọng “chống thức tỉnh” (anti-woke) với ChatGPT, nhưng lại bị cả phe bảo thủ chỉ trích vì không đủ cực đoan.

-

Theo Reuters, Grok đang được sử dụng để xử lý và phân tích dữ liệu chính phủ, thậm chí có thể tham gia vào việc soạn thảo báo cáo, gây lo ngại lớn về bảo mật dữ liệu và quyền riêng tư.

-

Các chuyên gia đạo đức, bao gồm Richard Painter – cố vấn của cựu Tổng thống George W. Bush – cảnh báo rằng nếu Musk trực tiếp quyết định áp dụng Grok, điều đó có thể vi phạm luật xung đột lợi ích liên bang.

-

Luật này nghiêm cấm quan chức chính phủ tham gia vào những quyết định có thể mang lại lợi ích tài chính cá nhân, và vi phạm có thể bị xử phạt tiền hoặc thậm chí phạt tù, dù hiếm khi được áp dụng nghiêm khắc.

-

Ngoài Grok, nhiều người chỉ trích rằng Musk đang lợi dụng ảnh hưởng chính trị để trục lợi, từ việc giúp Trump tái đắc cử cho đến việc né tránh 2,37 tỷ USD tiền phạt và chế tài liên bang nhờ chính sách nới lỏng dưới chính quyền mới.

-

Starlink cũng bị cho là đang được “ép” để các quốc gia bị áp thuế bắt buộc sử dụng, cho thấy mức độ lũng đoạn của Musk trong chính sách quốc tế và thương mại.

-

DOGE – tổ chức cải cách chi tiêu mà Musk dẫn đầu – được cho là không đạt được hiệu quả tiết kiệm ngân sách như cam kết, và nhiều khoản cắt giảm lại gây thiệt hại lâu dài cho các dịch vụ công.

📌 Chatbot Grok của Elon Musk đang bị chính phủ Mỹ sử dụng để xử lý dữ liệu liên bang, dẫn đến nghi ngờ vi phạm đạo đức và luật xung đột lợi ích. Reuters cho rằng hành động này có thể cấu thành tội phạm liên bang, trong khi Musk tiếp tục bị chỉ trích vì lợi dụng chính quyền để né chế tài và trục lợi chính trị – tài chính.

https://gizmodo.com/elons-doge-is-reportedly-using-grok-ai-with-government-data-2000606753

-

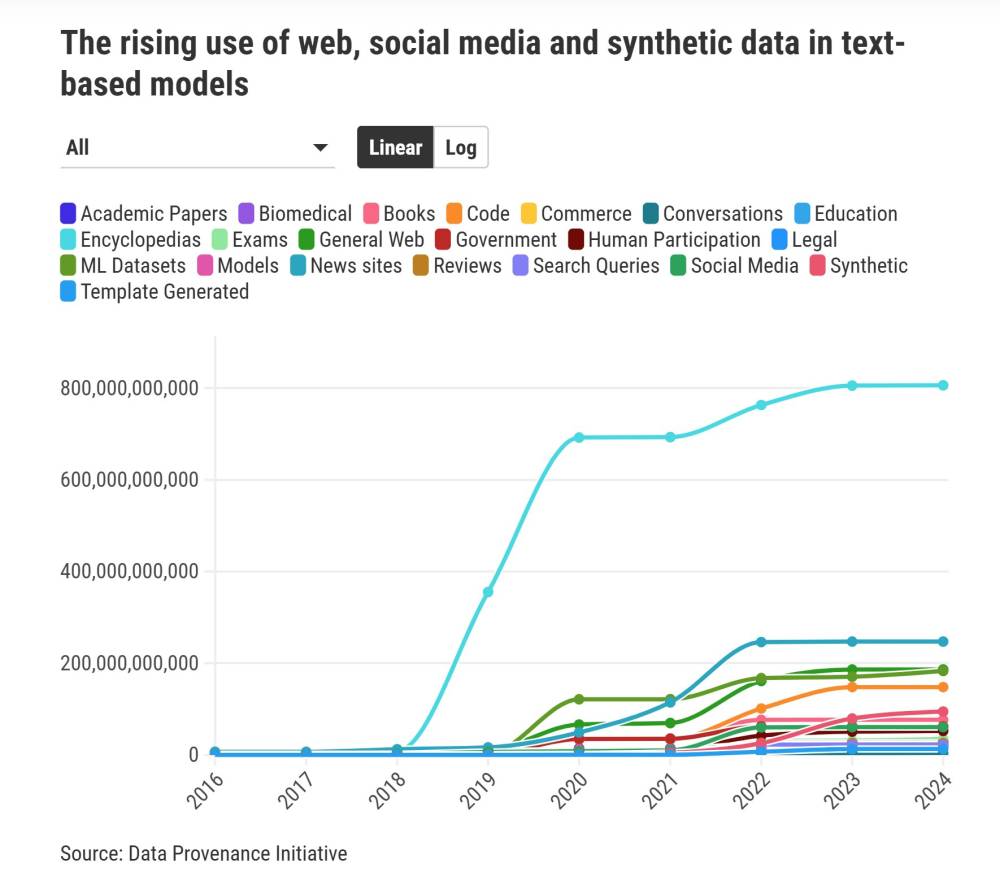

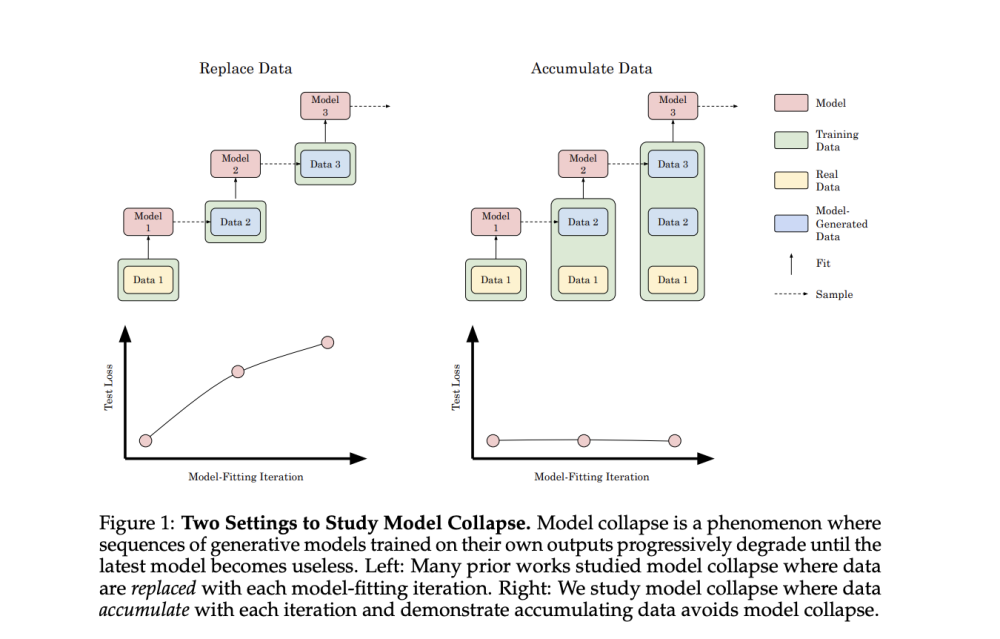

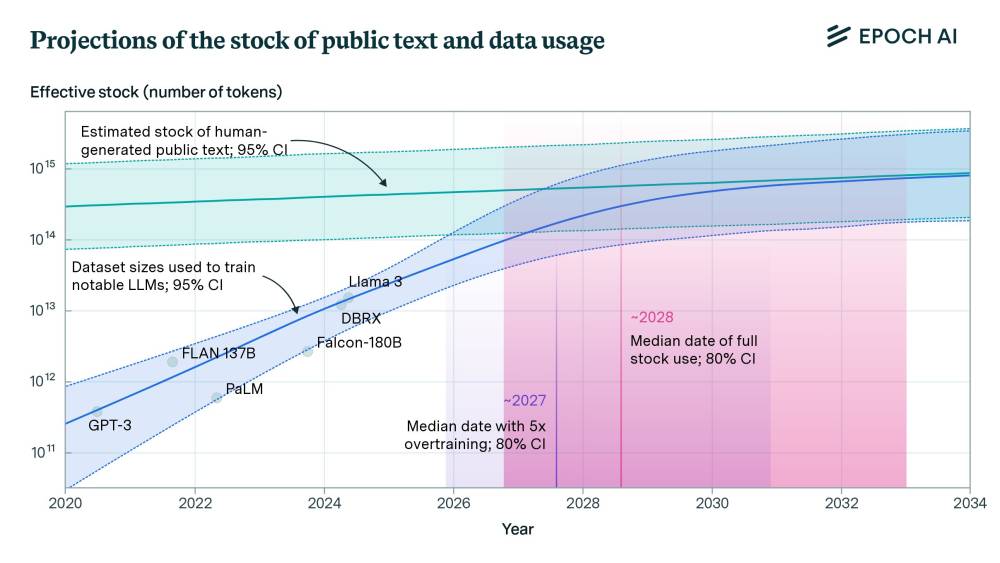

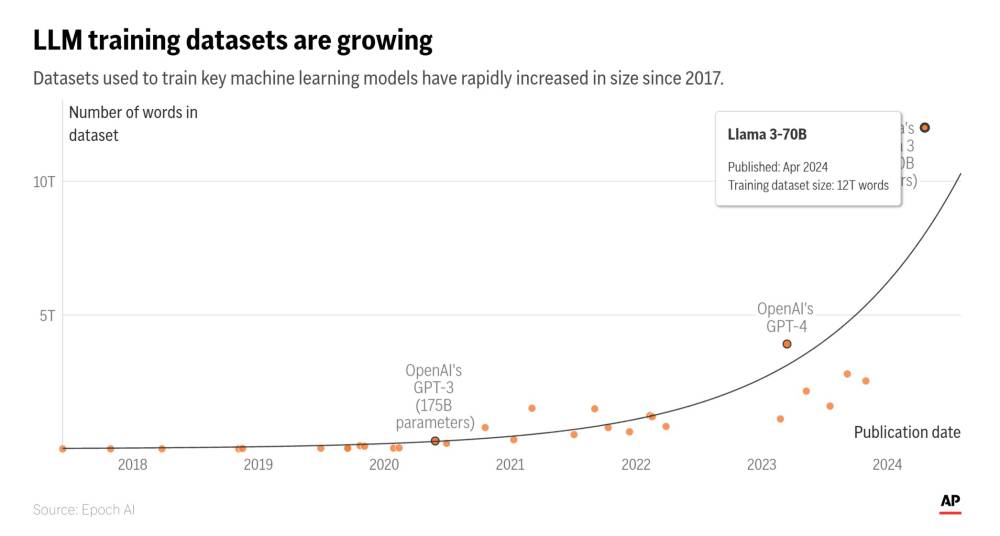

Từ khi ChatGPT được công bố năm 2022, người dùng đã tạo ra lượng lớn văn bản AI đăng tải lên mạng, khiến các mô hình mới có nguy cơ được huấn luyện trên dữ liệu không còn thuần túy từ con người.

-

Hiện tượng “sụp đổ mô hình” (model collapse) xảy ra khi văn bản máy sinh ra làm sai lệch phân phối ngôn ngữ so với thực tế, dẫn đến các mô hình mới trở nên kém chính xác.

-

Nghiên cứu chỉ ra việc dùng dữ liệu tổng hợp liên tục có thể khiến mô hình "quên" những thông tin ít xuất hiện (sự kiện vùng đuôi), gây ra lỗi hoặc thiên vị.

-

Không chỉ LLM mà các mô hình tạo ảnh như Stable Diffusion, hay autoencoder và Gaussian Mixture Model cũng có thể bị ảnh hưởng nếu tái huấn luyện nhiều vòng với dữ liệu máy tạo.

-

Việc trộn lẫn dữ liệu thực và dữ liệu tổng hợp làm chậm lại sự suy giảm hiệu suất, nhưng lại đòi hỏi tài nguyên tính toán lớn hơn.

-

Phân biệt văn bản thật với văn bản AI là cực kỳ khó khăn và vẫn chưa có giải pháp hiệu quả.

-

Giải pháp tiềm năng: chọn lọc dữ liệu tổng hợp chất lượng cao thông qua điểm đánh giá nội bộ từ LLM hoặc phản hồi từ người dùng, tương tự phương pháp RLHF.

-

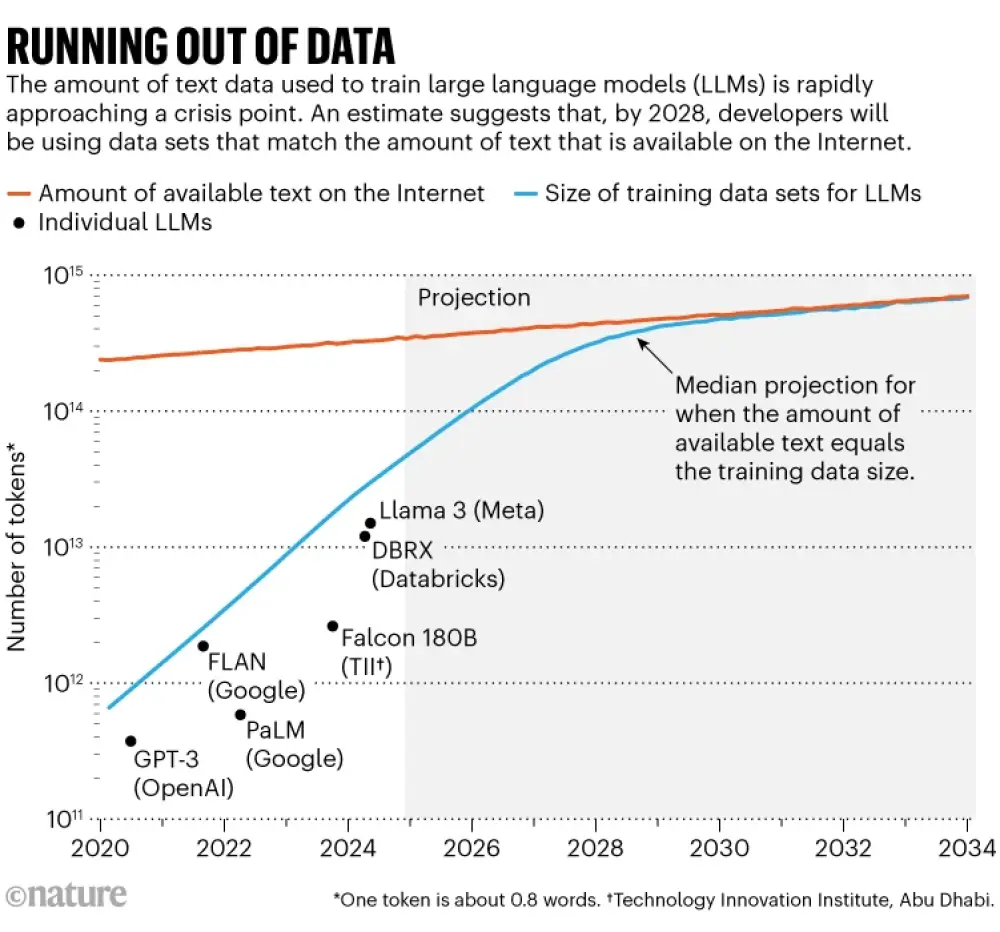

Một nghiên cứu dự đoán thế giới sẽ cạn kiệt dữ liệu văn bản gốc để huấn luyện AI trong khoảng 2026–2032.

-

Câu hỏi đặt ra là liệu dữ liệu tổng hợp chất lượng cao có thể thúc đẩy cải tiến mô hình, tạo thành "vòng lặp tích cực" thay vì sụp đổ.

-

Tuy chưa có bằng chứng chắc chắn, nhưng các nhà nghiên cứu cho rằng có tiềm năng nếu kiểm soát được chất lượng dữ liệu sinh ra.

-

Ngoài ra, việc mất các thông tin vùng đuôi có thể làm AI trở nên thiên vị, xoá bỏ tiếng nói của nhóm thiểu số — một vấn đề chưa được nghiên cứu đầy đủ do thiếu minh bạch từ các công ty AI.

-

Các chuyên gia cảnh báo vấn đề này nghiêm trọng nhưng không phải thảm hoạ sắp tới, mà cần quản lý thận trọng từ các công ty phát triển AI.

📌 Mô hình AI đang đối mặt nguy cơ “sụp đổ mô hình” do tự học từ chính dữ liệu mình tạo ra. Nếu không chọn lọc kỹ, chất lượng mô hình sẽ suy giảm, xóa bỏ các chi tiết ít phổ biến và gây thiên vị. Tuy nhiên, việc kiểm duyệt dữ liệu tổng hợp có thể tạo ra một “vòng lặp cải tiến” khả thi. Dự đoán đến 2032, thế giới có thể hết dữ liệu mới để huấn luyện AI.

https://cacm.acm.org/news/the-collapse-of-gpt/

-

OpenAI vừa công bố triển khai chương trình lưu trữ dữ liệu tại chỗ (data residency) dành riêng cho khu vực châu Á, sau khi chương trình tương tự được ra mắt tại châu Âu vào tháng 2.

-

Chương trình áp dụng cho các sản phẩm ChatGPT Enterprise, ChatGPT Edu, và OpenAI API, giúp doanh nghiệp và tổ chức trong khu vực tuân thủ yêu cầu về chủ quyền dữ liệu địa phương.

-

Các khách hàng đủ điều kiện sử dụng API, cũng như người đăng ký mới của ChatGPT Enterprise và Edu, có thể lựa chọn lưu trữ dữ liệu tại các quốc gia được hỗ trợ, bao gồm:

-

Nhật Bản

-

Ấn Độ

-

Singapore

-

Hàn Quốc

-

-

Dữ liệu của khách hàng sẽ được lưu trữ tĩnh (at rest) tại các quốc gia trên, đồng thời giữ tính bảo mật, riêng tư và thuộc sở hữu hoàn toàn của người dùng, theo xác nhận từ OpenAI.

-

Công ty khẳng định việc thiết lập quyền lưu trữ dữ liệu tại chỗ giúp các tổ chức kiểm soát dữ liệu tốt hơn và tăng tính an tâm khi sử dụng các sản phẩm AI tạo sinh của OpenAI.

-

Việc triển khai chương trình này là một phần trong kế hoạch mở rộng hoạt động toàn cầu, cùng với sáng kiến "OpenAI for Countries" – một chương trình nhằm xây dựng hạ tầng kỹ thuật và dịch vụ phù hợp cho từng quốc gia.

-

Với chương trình mới, OpenAI không chỉ tăng cường sự hiện diện ở châu Á, mà còn thể hiện nỗ lực phản hồi yêu cầu chính sách dữ liệu ngày càng nghiêm ngặt tại từng quốc gia.

📌 OpenAI chính thức ra mắt chương trình lưu trữ dữ liệu tại chỗ tại châu Á, áp dụng cho ChatGPT Enterprise, Edu và API, hỗ trợ lưu trữ tại Nhật Bản, Ấn Độ, Singapore và Hàn Quốc. Đây là một phần trong chiến lược mở rộng toàn cầu của OpenAI và sáng kiến "OpenAI for Countries", nhằm nâng cao kiểm soát dữ liệu và tuân thủ quy định địa phương.

https://techcrunch.com/2025/05/08/openai-launches-a-data-residency-program-in-asia/

-

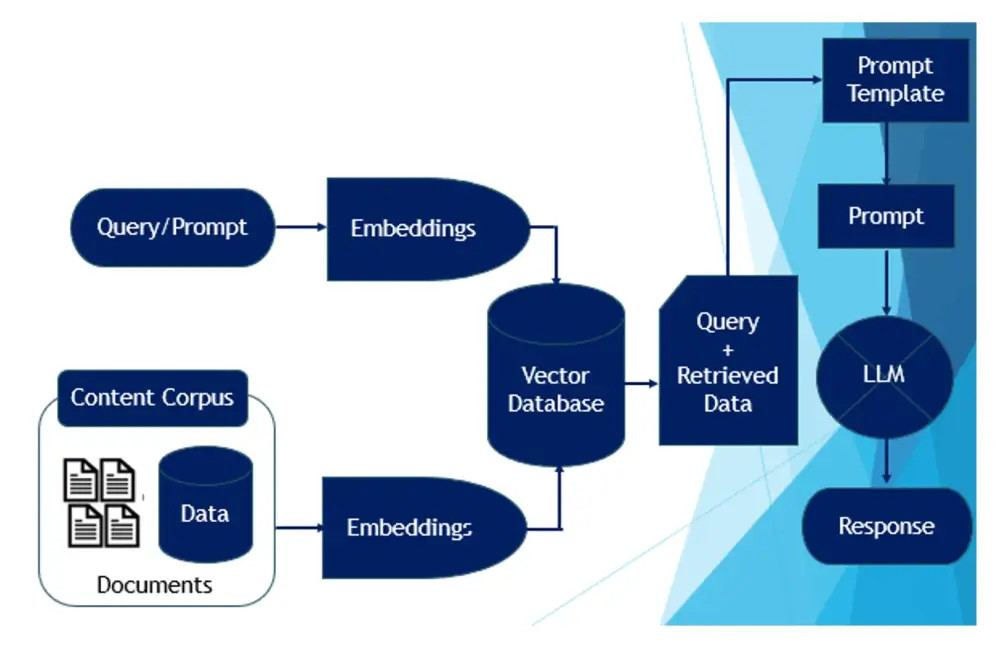

Tại hội nghị Directions thường niên lần thứ 60 của IDC, nhà phân tích Marlanna Bozicevich chia sẻ mô hình Enterprise Intelligence Architecture (Kiến trúc Trí tuệ Doanh nghiệp) gồm 4 tầng dữ liệu để giúp tổ chức sẵn sàng cho AI.

-

Bốn tầng gồm: data plane (dữ liệu thô), data control plane (quản lý dữ liệu), data synthesis plane (tổng hợp dữ liệu), và business activity plane (hoạt động kinh doanh).

-

AI được xem là công cụ tăng năng suất trong quản lý dữ liệu, thông qua tự động hóa tác vụ lặp lại, giao diện ngôn ngữ tự nhiên và AI tác nhân (agentic AI) có khả năng hành động tự chủ.

-

Ba mục tiêu chính của lãnh đạo CNTT trong AI là: nâng cao năng suất, đảm bảo AI có trách nhiệm, và triển khai AI tác nhân.

-

Marlanna nhấn mạnh cần hiểu AI không chỉ tiêu thụ dữ liệu, mà còn có thể cải thiện chất lượng dữ liệu bằng cách hỗ trợ các vai trò như kỹ sư dữ liệu, nhà khoa học dữ liệu và quản lý dữ liệu.

-

Khái niệm "AI for data / data for AI" cho thấy sự liên kết hai chiều: AI giúp cải thiện quy trình dữ liệu, trong khi dữ liệu sạch giúp AI hoạt động hiệu quả hơn trên toàn tổ chức.

-

Bà cũng đề xuất cần xem dữ liệu như một sản phẩm, tức là dữ liệu phải có chất lượng, tiêu chuẩn hóa và khả năng trao đổi giữa các AI agents.

-

Để triển khai AI mang lại ROI, doanh nghiệp phải đầu tư vào cấu trúc dữ liệu có thể học liên tục và cộng tác quy mô lớn, thúc đẩy văn hóa dữ liệu và nâng cao hiểu biết về dữ liệu trong tổ chức.

-

Kiến trúc này là cầu nối giữa dữ liệu và kết quả kinh doanh, đảm bảo dữ liệu được thu thập, xử lý, lưu trữ và truy cập một cách hiệu quả và phù hợp với mục tiêu AI.

📌 Để AI tạo sinh mang lại hiệu quả thực tế, tổ chức phải đầu tư vào Enterprise Intelligence Architecture với 4 tầng dữ liệu cốt lõi. Mô hình này giúp xử lý và sử dụng dữ liệu một cách chiến lược, thúc đẩy năng suất, chuẩn hóa dữ liệu như sản phẩm và tạo ra nền tảng cho AI tác nhân hoạt động hiệu quả trong toàn doanh nghiệp.

https://www.cio.com/article/3978635/how-to-build-an-ai-ready-organization-the-enterprise-intelligence-architecture.html?amp=1

-

90% dữ liệu đào tạo của AI tạo sinh hiện nay xuất phát từ tiếng Anh, chủ yếu là tiếng Anh Mỹ dòng chính (mainstream American English).

-

Tiếng Anh Mỹ chiếm ưu thế do lịch sử, kinh tế, công nghệ và sự thống trị của các tập đoàn công nghệ Mỹ như Google, Meta, Microsoft, OpenAI.

-

Các sản phẩm AI như autocorrect, chuyển giọng nói thành văn bản, hay trợ lý viết bằng AI đều dựa trên dữ liệu tiếng Anh Mỹ, dẫn đến loại trừ hoặc “sửa” các biến thể tiếng Anh khác.

-

Nghiên cứu cho thấy người nói tiếng Anh không thuộc dòng chính cảm thấy thất vọng khi các công nghệ AI đều dùng giọng Mỹ, gây khó chịu và cảm giác bị loại trừ.

-

Ví dụ thực tế: Một nhà ngôn ngữ gọi điện cho các chủ nhà bằng 3 phương ngữ khác nhau tại Mỹ, kết quả chỉ giọng Mỹ dòng chính mới nhận được nhiều lời mời xem nhà – chứng tỏ thiên vị ngôn ngữ không chỉ tồn tại ngoài đời mà còn được củng cố bởi AI.

-

Khi AI được ứng dụng rộng rãi, hậu quả của thiên vị này càng nghiêm trọng: Ứng viên dùng tiếng Anh Ấn Độ có thể bị hệ thống AI chấm điểm hồ sơ thấp, phần mềm nhận diện giọng nói bỏ sót từ vựng quan trọng trong văn hóa bản địa.

-

Các biến thể tiếng Anh như tiếng Anh bản địa Úc, Anh Ấn Độ, Anh Singapore… đều có cấu trúc, từ vựng và “luật” riêng, nhưng thường bị xem là “tiếng Anh hỏng” hoặc bị loại ra khỏi tập dữ liệu huấn luyện.

-

AI đa ngôn ngữ trên lý thuyết nhưng lại đơn ngữ trong thực tế do thiếu dữ liệu các biến thể tiếng Anh.

-

Để hướng tới công bằng ngôn ngữ, cần phát triển AI công nhận sự đa dạng tiếng Anh, hợp tác giữa các nhà ngôn ngữ học, kỹ sư, giáo viên và cộng đồng địa phương.

-

Mục tiêu là thay đổi công nghệ cho phù hợp với người dùng, không phải “sửa” người dùng theo tiêu chuẩn tiếng Anh Mỹ.

📌 Khoảng 90% dữ liệu AI tạo sinh hiện nay là tiếng Anh Mỹ, gây ra bất công và làm lu mờ những biến thể tiếng Anh khác. Các hệ thống AI cần thay đổi để tôn trọng đa dạng ngôn ngữ, tránh duy trì “ảo giác” về tiếng Anh tiêu chuẩn và tạo ra kết quả công bằng cho toàn cầu.

https://theconversation.com/ai-systems-are-built-on-english-but-not-the-kind-most-of-the-world-speaks-249710

-

Các nhà khoa học của Alphabet đang phát triển máy tính lượng tử tiên tiến nhất thế giới tại Santa Barbara, California, với mục tiêu kết hợp sức mạnh giữa lượng tử và AI.

-

Julian Kelly, giám đốc phần cứng Google Quantum AI, nhận định AI và lượng tử sẽ bổ sung cho nhau, mở ra khả năng giải quyết các vấn đề chưa từng có.

-

Google từng bị cho là chậm chân so với OpenAI khi ChatGPT nổi lên cuối năm 2022, nhưng cuối năm 2024, Google công bố chip lượng tử Willow với khả năng giải quyết bài toán benchmark vượt xa máy tính cổ điển.

-

Willow giúp giảm lỗi theo cấp số nhân khi bổ sung thêm lượng tử bit (qubit), được đánh giá là “cột mốc của lĩnh vực” bởi John Preskill của Viện Công nghệ California.

-

Chip Willow mở ra cơ hội để Google dẫn đầu kỷ nguyên công nghệ tiếp theo, đặc biệt trong bối cảnh AI ngày càng cạn kiệt dữ liệu chất lượng cao để học.

-

Một ứng dụng tiềm năng: lượng tử có thể tạo dữ liệu mới và độc đáo, giúp AI tiếp tục phát triển khi nguồn dữ liệu hiện tại gần như đã bị khai thác hết.

-

Ví dụ AlphaFold, sản phẩm của Google DeepMind đoạt Nobel Hóa học 2024, đã tạo ra bước tiến lớn nhờ sử dụng dữ liệu liên quan đến cơ học lượng tử.

-

Kelly nhận định máy tính lượng tử có thể tạo dữ liệu đặc thù về lượng tử cơ học, giúp AI đào sâu hiểu biết về thế giới vi mô và phát triển mạnh hơn.

-

Kelly tin rằng Google chỉ cần khoảng 5 năm nữa để phát triển ứng dụng thực tiễn đầu tiên chỉ có thể giải quyết bằng máy tính lượng tử.

-

Thách thức lớn nhất để Google “soán ngôi” nền tảng công nghệ tiếp theo là biến đột phá lượng tử thành sản phẩm thương mại tạo lợi nhuận thực tế.

📌 Google đang tăng tốc để đối đầu OpenAI bằng chip lượng tử Willow, có thể tạo dữ liệu huấn luyện mới cho AI, giảm lỗi vượt trội. Willow hướng đến giải quyết bài toán mà máy tính cổ điển chịu thua, dự kiến chỉ 5 năm nữa Google có thể trình làng ứng dụng thực tiễn đầu tiên nhờ lượng tử.

https://www.cnbc.com/2025/04/18/how-quantum-computing-could-supercharge-googles-ai-ambitions.html

-

Apple sẽ bắt đầu phân tích dữ liệu trên thiết bị của khách hàng nhằm cải thiện nền tảng trí tuệ nhân tạo, đảm bảo thông tin người dùng được bảo vệ đồng thời giúp công ty bắt kịp với đối thủ AI.

-

Hiện tại, Apple chủ yếu huấn luyện mô hình AI bằng dữ liệu tổng hợp - thông tin mô phỏng đầu vào thực tế mà không chứa chi tiết cá nhân, nhưng phương pháp này không luôn phản ánh chính xác dữ liệu khách hàng thực tế.

-

Công nghệ mới sẽ so sánh dữ liệu tổng hợp với mẫu email gần đây của người dùng trong ứng dụng email iPhone, iPad và Mac, giúp xác định phần nào trong bộ dữ liệu tổng hợp phù hợp nhất với tin nhắn thực tế.

-

Những hiểu biết này sẽ cải thiện các tính năng liên quan đến văn bản trong nền tảng Apple Intelligence, như tóm tắt thông báo, khả năng tổng hợp suy nghĩ trong Writing Tools, và tổng kết tin nhắn người dùng.

-

Hệ thống mới sẽ được triển khai trong phiên bản beta sắp tới của iOS và iPadOS 18.5 và macOS 15.5, với bản beta thứ hai đã được cung cấp cho nhà phát triển vào ngày 14/4/2025.

-

Apple cũng đang áp dụng các phương pháp bảo vệ quyền riêng tư để cải thiện mô hình cho các tính năng Apple Intelligence khác như Image Playground, Image Wand, Memories Creation và Visual Intelligence.

-

Công ty đã sử dụng công nghệ "differential privacy" để cải thiện tính năng Genmoji, giúp xác định các prompt phổ biến trong khi đảm bảo các prompt độc đáo hoặc hiếm không bị phát hiện.

-

Các tính năng này chỉ dành cho người dùng đã chọn tham gia phân tích thiết bị và khả năng cải thiện sản phẩm, được quản lý trong tab Privacy and Security trong ứng dụng Settings.

-

Đội ngũ trí tuệ nhân tạo của Apple đã có nhiều biến động trong vài tháng qua, với việc Bloomberg News đưa tin về các khó khăn của tổ chức, vấn đề lãnh đạo, sản phẩm bị trì hoãn và thay đổi lãnh đạo.

-

Vào tháng 3, Apple đã cải tổ một phần ban lãnh đạo nhóm AI, tước bỏ trách nhiệm về Siri từ giám đốc John Giannandrea và giao nhóm trợ lý giọng nói cho Mike Rockwell và Craig Federighi.

📌 Apple đang triển khai chiến lược phân tích dữ liệu trên thiết bị để cải thiện AI mà không xâm phạm quyền riêng tư. Phương pháp so sánh dữ liệu tổng hợp với email thực tế sẽ được áp dụng trong iOS/iPadOS 18.5 và macOS 15.5, giúp Apple bắt kịp với đối thủ như OpenAI và Google.

https://www.bloomberg.com/news/articles/2025-04-14/apple-to-analyze-user-data-on-devices-to-bolster-ai-technology

Apple sẽ phân tích dữ liệu người dùng trên thiết bị để tăng cường công nghệ AI

Large language models là công nghệ cốt lõi của AI hiện đại và chúng cung cấp năng lượng cho các tính năng trong Apple Intelligence.

Bởi Mark Gurman Ngày 14 tháng 4 năm 2025 lúc 7:00 PM UTC Cập nhật ngày 14 tháng 4 năm 2025 lúc 7:16 PM UTC

Điểm chính:

- Apple sẽ phân tích dữ liệu trên thiết bị của khách hàng để cải thiện nền tảng trí tuệ nhân tạo, đồng thời đảm bảo dữ liệu người dùng vẫn ở trên thiết bị và không được sử dụng trực tiếp để đào tạo các mô hình AI.

- Cách tiếp cận mới sẽ giúp Apple bắt kịp các đối thủ AI bằng cách sử dụng email thực tế để kiểm tra dữ liệu tổng hợp và cải thiện các tính năng liên quan đến văn bản trong nền tảng Apple Intelligence.

- Công ty sẽ triển khai hệ thống mới trong phiên bản beta sắp tới của iOS và iPadOS 18.5 và macOS 15.5, đồng thời cũng đang mang đến những cách cải thiện các tính năng Apple Intelligence khác mà vẫn đảm bảo quyền riêng tư.

Apple Inc. sẽ bắt đầu phân tích dữ liệu trên thiết bị của khách hàng nhằm cải thiện nền tảng trí tuệ nhân tạo, một động thái được thiết kế để bảo vệ thông tin người dùng đồng thời vẫn giúp công ty bắt kịp các đối thủ AI.

Hiện nay, Apple thường đào tạo các mô hình AI sử dụng dữ liệu tổng hợp — thông tin được tạo ra để mô phỏng đầu vào thực tế mà không có bất kỳ chi tiết cá nhân nào. Nhưng dữ liệu tổng hợp này không phải lúc nào cũng đại diện cho dữ liệu khách hàng thực tế, khiến các hệ thống AI hoạt động không hiệu quả.

Cách tiếp cận mới sẽ giải quyết vấn đề đó đồng thời đảm bảo dữ liệu người dùng vẫn ở trên thiết bị và không được sử dụng trực tiếp để đào tạo mô hình AI. Ý tưởng là giúp Apple bắt kịp với các đối thủ như OpenAI và Alphabet Inc., vốn có ít hạn chế về quyền riêng tư hơn.

Công nghệ hoạt động như sau: Nó lấy dữ liệu tổng hợp mà Apple đã tạo và so sánh với mẫu email gần đây của người dùng trong ứng dụng email iPhone, iPad và Mac. Bằng cách sử dụng email thực tế để kiểm tra đầu vào giả, Apple có thể xác định những mục nào trong bộ dữ liệu tổng hợp phù hợp nhất với tin nhắn thực tế.

Những hiểu biết này sẽ giúp công ty cải thiện các tính năng liên quan đến văn bản trong nền tảng Apple Intelligence, chẳng hạn như tóm tắt trong thông báo, khả năng tổng hợp suy nghĩ trong Writing Tools và tóm tắt tin nhắn của người dùng.

"Khi tạo dữ liệu tổng hợp, mục tiêu của chúng tôi là tạo ra các câu hoặc email tổng hợp có chủ đề hoặc phong cách đủ giống với thực tế để giúp cải thiện mô hình tóm tắt của chúng tôi, nhưng không cần Apple thu thập email từ thiết bị," công ty viết trong một bài đăng trên blog machine learning vào hôm thứ Hai.

Large language models là công nghệ cốt lõi của AI hiện đại và chúng cung cấp năng lượng cho các tính năng trong Apple Intelligence, mà công ty đã phát hành vào năm ngoái. Ngoài việc sử dụng dữ liệu tổng hợp, Apple đã đào tạo các mô hình của mình với thông tin được cấp phép từ bên thứ ba hoặc tìm thấy bằng cách quét internet mở.

Việc phụ thuộc vào dữ liệu tổng hợp đã có những hạn chế, với các công cụ của công ty hiểu sai ý tưởng trong thông báo và không thể cung cấp bản tóm tắt chính xác của văn bản trong một số trường hợp.

Hệ thống mới về mặt lý thuyết có thể cải thiện mô hình của Apple, một bước quan trọng để trở thành đối thủ cạnh tranh nghiêm túc trong lĩnh vực AI đang phát triển. Nhóm trí tuệ nhân tạo của công ty đã thấy sản phẩm của họ tụt hậu so với đối thủ, thúc đẩy một cuộc cải tổ quản lý gần đây cho trợ lý giọng nói Siri và các nỗ lực liên quan.

Công ty sẽ triển khai hệ thống mới trong phiên bản beta sắp tới của iOS và iPadOS 18.5 và macOS 15.5. Bản beta thứ hai của những phiên bản sắp tới đã được cung cấp cho các nhà phát triển vào đầu ngày thứ Hai.

Nhà sản xuất iPhone cũng cho biết họ đang mang đến những cách cải thiện các mô hình được sử dụng để cung cấp năng lượng cho các tính năng Apple Intelligence khác như Image Playground, Image Wand, Memories Creation và Visual Intelligence mà vẫn đảm bảo quyền riêng tư.

Công ty đã dựa vào công nghệ gọi là differential privacy để giúp cải thiện tính năng Genmoji, cho phép người dùng tạo emoji tùy chỉnh. Hệ thống này "xác định các lời nhắc phổ biến và mẫu lời nhắc, đồng thời cung cấp đảm bảo toán học rằng các lời nhắc độc đáo hoặc hiếm không bị phát hiện," công ty cho biết trong bài đăng blog.

Ý tưởng là theo dõi cách mô hình phản hồi trong các tình huống nhiều người dùng đưa ra cùng một yêu cầu — chẳng hạn, yêu cầu một con khủng long mang cặp — và cải thiện kết quả trong những trường hợp đó.

Các tính năng chỉ dành cho người dùng đã chọn tham gia vào khả năng phân tích thiết bị và cải thiện sản phẩm. Những tùy chọn này được quản lý trong tab Privacy and Security trong ứng dụng Settings trên các thiết bị của công ty.

"Dựa trên nhiều năm kinh nghiệm sử dụng các kỹ thuật như differential privacy, cũng như các kỹ thuật mới như tạo dữ liệu tổng hợp, chúng tôi có thể cải thiện các tính năng Apple Intelligence đồng thời bảo vệ quyền riêng tư cho người dùng tham gia vào chương trình phân tích thiết bị," công ty cho biết.

Nhóm trí tuệ nhân tạo của Apple đã trong tình trạng xáo trộn trong vài tháng qua, với Bloomberg News đầu tiên đưa tin về các vấn đề của tổ chức, vấn đề lãnh đạo, sự chậm trễ sản phẩm và thay đổi điều hành.

Vào tháng 3, Apple đã cải tổ một phần quản lý nhóm AI, loại bỏ trách nhiệm về Siri từ giám đốc John Giannandrea và giao nhóm trợ lý giọng nói cho Mike Rockwell, người sáng tạo Vision Pro, và giám đốc phần mềm Craig Federighi. Công ty dự định công bố các nâng cấp Apple Intelligence vào tháng 6 nhưng sẽ không triển khai các tính năng được mong đợi từ lâu cho Siri cho đến năm sau.

- Google vừa thông báo thông qua bài đăng trên X rằng họ sẽ hỗ trợ Model Context Protocol (MCP) của Anthropic, cho phép hệ thống AI bao gồm các agent truy cập kho dữ liệu, không gian phát triển và ứng dụng doanh nghiệp để hoạt động hiệu quả hơn.

- Hỗ trợ này sẽ áp dụng cho các mô hình Gemini và bộ công cụ phát triển phần mềm (SDK) của Google, đánh dấu một bước tiến quan trọng trong việc hợp tác giữa các đối thủ lớn trong ngành AI.

- Thông báo này tiếp nối quyết định của OpenAI vào ngày 26 tháng 3 khi họ tuyên bố áp dụng MCP, bắt đầu với SDK của mình. CEO Sam Altman cũng cho biết MCP cuối cùng sẽ có mặt trên ChatGPT phiên bản máy tính và ứng dụng di động, tuy nhiên chưa rõ thời điểm cụ thể.

- Các AI agent - những trợ lý giúp hoàn thành nhiều loại nhiệm vụ, đôi khi một cách tự động - ngày càng phát triển mạnh mẽ và ấn tượng, nhưng chúng chỉ hiệu quả khi có quyền truy cập vào dữ liệu cần thiết.

- Trong môi trường doanh nghiệp và bảo mật cao, các agent cần được tích hợp riêng biệt với từng hệ thống và nguồn dữ liệu, điều này tốn thời gian và khó mở rộng quy mô.

- MCP mà Anthropic đã phát hành dưới dạng nguồn mở vào cuối năm ngoái, giải quyết vấn đề này bằng cách cung cấp một tiêu chuẩn duy nhất. Anthropic cũng cung cấp các máy chủ được xây dựng sẵn cho phần mềm doanh nghiệp thông dụng như Google Drive, GitHub và Slack.

- Demis Hassabis, đồng sáng lập và CEO của Google DeepMind, nhận xét: "MCP là một giao thức tốt và nhanh chóng trở thành tiêu chuẩn mở cho kỷ nguyên AI agent. Chúng tôi rất vui mừng thông báo rằng chúng tôi sẽ hỗ trợ giao thức này cho các mô hình Gemini và SDK của chúng tôi."

- Ngoài Google và OpenAI, nhiều công ty khác cũng đã áp dụng MCP bao gồm Block, Apollo, Zed, Replit, Codeium và Sourcegraph.

- Xu hướng sử dụng nhiều công cụ nguồn mở hơn, kể cả ở cấp doanh nghiệp, có thể báo hiệu một sự thay đổi lớn trong ngành công nghệ, đặc biệt khi ngày càng nhiều công ty đầu tư vào AI agent như mũi nhọn công nghệ tiếp theo.

- Tuy nhiên, Hassabis chưa làm rõ thời điểm Google sẽ bắt đầu hỗ trợ MCP.

📌 Lần đầu tiên, 3 gã khổng lồ AI - Google, OpenAI và Anthropic - hợp tác thông qua Model Context Protocol, tạo tiêu chuẩn chung cho AI agent truy cập dữ liệu. Sự hợp tác này mở ra kỷ nguyên mới cho phát triển AI agent, với nhiều công ty công nghệ khác cũng đang nhanh chóng tham gia.

https://www.zdnet.com/article/google-joins-openai-in-adopting-anthropics-protocol-for-connecting-ai-agents-why-it-matters/

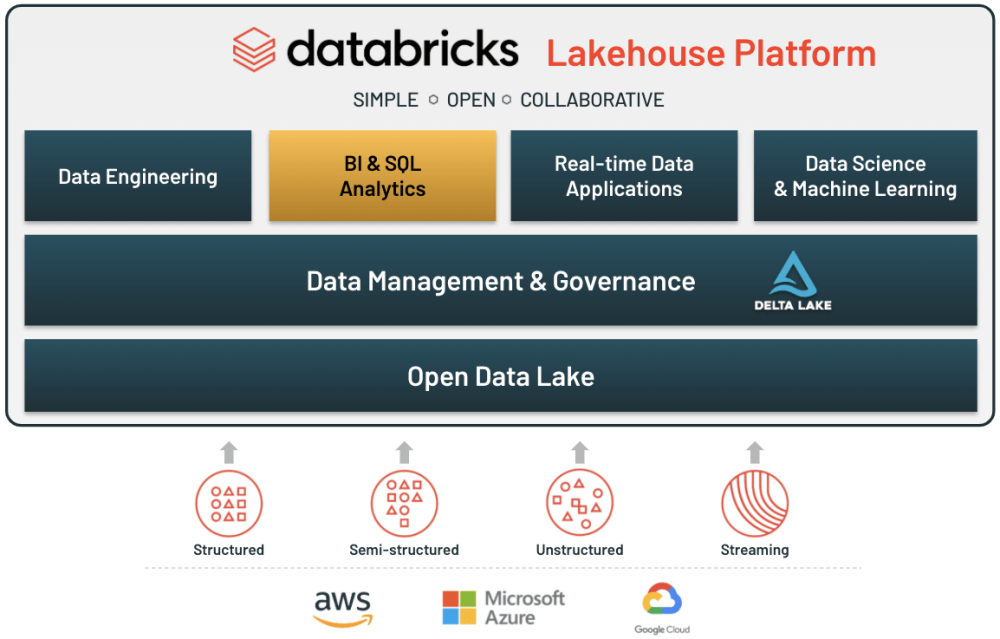

- AI đang biến đổi các ngành công nghiệp với tốc độ chưa từng có, từ khoa học đời sống, dịch vụ tài chính đến ô tô và sản xuất, nhưng nhiều tổ chức vẫn gặp khó khăn trong việc mở rộng quy mô AI thành công.

- Lý do chính khiến các doanh nghiệp không thành công với AI không phải là do thuật toán phức tạp hay sức mạnh tính toán, mà là cách họ quản lý và di chuyển dữ liệu trong môi trường ngày càng phức tạp.

- Giả định rằng đột phá AI chỉ đến từ thuật toán tinh vi hơn hoặc GPU mạnh mẽ là sai lầm, vì mô hình AI chỉ hiệu quả bằng dữ liệu cung cấp cho chúng.

- Hầu hết tổ chức vận hành với kiến trúc dữ liệu phân mảnh, nơi các kho dữ liệu riêng biệt, hệ thống lưu trữ chậm và quy trình làm việc không hiệu quả tạo ra sự chậm trễ lớn trong xử lý AI.

- Mô hình ngôn ngữ lớn (LLM), AI tạo sinh và suy luận thời gian thực đòi hỏi truy cập nhanh vào các tập dữ liệu khổng lồ, nhưng nếu đường ống dữ liệu không theo kịp tốc độ xử lý GPU, mô hình AI sẽ thiếu thông tin cần thiết.

- Doanh nghiệp thành công với AI có kiến trúc dữ liệu thống nhất, cung cấp liền mạch dữ liệu có cấu trúc và phi cấu trúc cho ứng dụng AI theo thời gian thực.

- Doanh nghiệp tụt hậu với AI thường dựa vào lưu trữ lỗi thời và đường ống phân mảnh, khiến các nhóm AI phải dành nhiều thời gian quản lý dữ liệu hơn là tạo ra thông tin chi tiết.

- Các nhà lãnh đạo AI ưu tiên tự động hóa thông minh trong quy trình dữ liệu, giảm thời gian đến thông tin chi tiết và tối ưu hóa việc sử dụng tài nguyên.

- Để khai thác tiềm năng đầy đủ của AI, doanh nghiệp nên áp dụng nền tảng dữ liệu thông minh, hiệu suất cao hỗ trợ đổi mới AI.

- Khi nâng cấp trí thông minh AI, các tổ chức cần tránh những cạm bẫy phổ biến như kho dữ liệu riêng biệt, nút thắt cổ chai và quy trình làm việc không hiệu quả.

- Thành công của trí thông minh AI không chỉ về công nghệ mà còn về con người, với các vai trò như kỹ sư dữ liệu, chuyên gia MLOps và kiến trúc sư trí thông minh AI.

- Tốc độ dữ liệu và tính toàn vẹn dữ liệu đều quan trọng cho thành công của AI, đòi hỏi quản trị tự động, kiểm soát truy cập và khung tuân thủ.

- Trí thông minh AI phải hoạt động hài hòa với hệ thống doanh nghiệp hiện có, sử dụng tiêu chuẩn mở, API và kiến trúc lai để ngăn chặn vấn đề tương thích.

- Tổ chức nên xem xét các phương pháp hay nhất, tiêu chuẩn ngành và thậm chí các phương pháp tự làm khi đánh giá nhu cầu trí thông minh AI của họ.

- Nếu sáng kiến AI không mang lại kết quả như mong đợi, đã đến lúc nhìn xa hơn thuật toán và sức mạnh tính toán, tập trung vào cách quản lý và di chuyển dữ liệu.

- Tương lai của AI thuộc về những người có thể làm cho dữ liệu hoạt động thông minh hơn, không chỉ là nhanh hơn.

📌 Thành công của AI doanh nghiệp phụ thuộc vào khả năng quản lý dữ liệu thông minh, không phải chỉ thuật toán hay GPU mạnh. Các tổ chức cần kiến trúc dữ liệu thống nhất, tự động hóa quy trình và cân bằng giữa tốc độ, bảo mật và tuân thủ để dẫn đầu cuộc cách mạng AI.

https://www.forbes.com/councils/forbestechcouncil/2025/04/02/the-ai-data-divide-why-intelligence-not-algorithms-will-determine-enterprise-ai-success/

- Trong sản xuất khoa học đời sống, nhiều dữ liệu giá trị vẫn bị mắc kẹt trong bảng tính, phân tán qua nhiều hệ thống hoặc không được thu thập, tạo ra điểm mù về hiệu suất thiết bị và quy trình sản xuất.

- Một phương pháp mới đang nổi lên: tích hợp dữ liệu quản lý tài sản, sản xuất theo lô và hệ thống chất lượng, sau đó tăng cường bằng AI.

- Dữ liệu tài sản cung cấp cơ hội độc đáo vì đây là nơi duy nhất tổ chức có thể truy cập dữ liệu hiệu suất thiết bị đến cấp số sê-ri, tiết lộ không chỉ hiệu suất mà còn chi phí vận hành và thách thức bảo trì.

- Hiện tại, các hệ thống quản lý tài sản (AMS), hệ thống thực thi sản xuất (MES) và hệ thống quản lý chất lượng (QMS) thường hoạt động riêng biệt, trong khi dữ liệu hiệu suất thiết bị quan trọng nằm trong bảng tính cơ bản.

- Tích hợp các luồng dữ liệu này cho phép nhà sản xuất tối ưu hóa hoạt động theo cách trước đây không thể thực hiện được, như theo dõi hiệu suất thiết bị cụ thể tại các địa điểm sản xuất khác nhau.

- Ví dụ: với phân tích dữ liệu tích hợp, nếu phân tích cho thấy không có sự thay đổi hiệu suất trong 3 năm, hệ thống có thể đề xuất kéo dài khoảng thời gian bảo trì từ 3 tháng lên 8 tháng.

- Machine learning và AI kết hợp với cảm biến IoT có thể cách mạng hóa phương pháp sản xuất truyền thống, cho phép đánh giá thời gian thực về quy trình, mẫu sử dụng và hiệu suất.

- Khi khiếu nại khách hàng được lưu trữ trong QMS và tích hợp với các hệ thống khác, AI có thể đẩy nhanh việc xác định vấn đề cốt lõi, phát hiện thiết bị hoặc lô hàng nào gây ra vấn đề.

- Lợi ích kinh doanh vượt ra ngoài hiệu quả hoạt động: AI có thể đề xuất quyết định tốt hơn về mua sắm thiết bị, lập lịch bảo trì và tối ưu hóa quy trình.

- Đối với nhà sản xuất khoa học đời sống, sự hội tụ dữ liệu sản xuất không chỉ về hiệu quả mà còn về việc tạo ra môi trường sản xuất thông minh, phản ứng nhanh và tiết kiệm chi phí hơn.

📌 AI đang mở khóa dữ liệu sản xuất trong ngành khoa học đời sống bằng cách tích hợp ba hệ thống riêng biệt: quản lý tài sản, sản xuất theo lô và quản lý chất lượng. Kết quả là tối ưu hóa bảo trì, giảm chi phí và nâng cao chất lượng sản phẩm, tạo lợi thế cạnh tranh cho doanh nghiệp tiên phong.

https://www.forbes.com/councils/forbesbusinessdevelopmentcouncil/2025/04/02/how-to-unlock-manufacturing-data-with-ai/

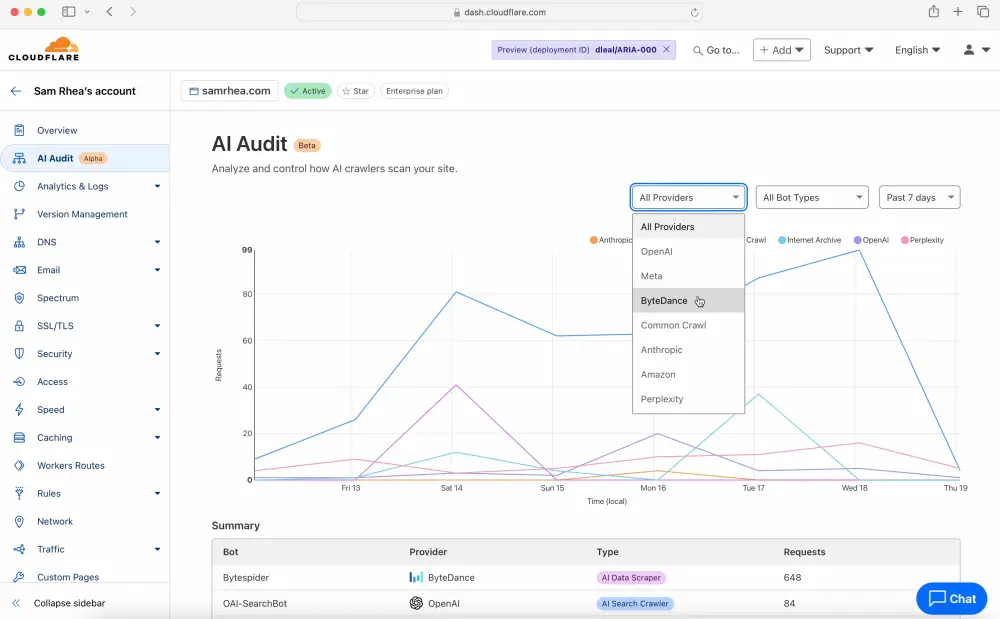

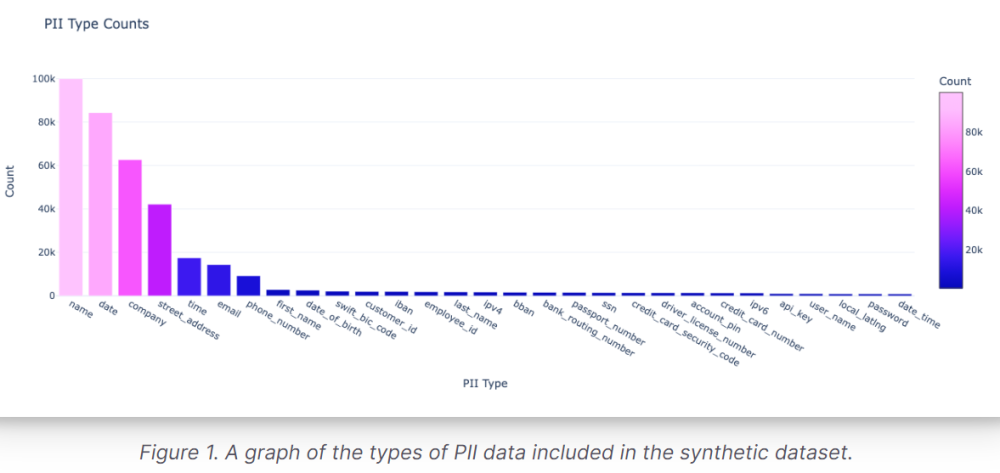

- Wikipedia đang phải đối mặt với chi phí tăng cao do các bot AI liên tục quét dữ liệu từ trang web để huấn luyện mô hình AI, gây áp lực lớn lên băng thông của trang.

- Wikimedia Foundation cảnh báo rằng "các yêu cầu tự động đối với nội dung của chúng tôi đã tăng theo cấp số nhân", gây gián đoạn truy cập và buộc Wikipedia phải bổ sung thêm năng lực, làm tăng hóa đơn trung tâm dữ liệu.

- Kể từ tháng 1/2024, băng thông sử dụng để tải xuống nội dung đa phương tiện đã tăng 50%, không phải từ người đọc mà từ các chương trình tự động liên tục tải xuống "hình ảnh được cấp phép mở để cung cấp cho các mô hình AI".

- Ít nhất 65% lưu lượng tiêu tốn tài nguyên đến từ bot, một tỷ lệ không cân xứng khi tổng lượt xem trang từ bot chỉ chiếm khoảng 35% tổng số.

- Bot thường thu thập dữ liệu từ các bài viết Wikipedia ít phổ biến và thậm chí quét "các hệ thống quan trọng trong cơ sở hạ tầng dành cho nhà phát triển, chẳng hạn như nền tảng đánh giá mã hoặc trình theo dõi lỗi".

- Để đối phó, Wikipedia đã áp đặt giới hạn tốc độ "tùy từng trường hợp" đối với các trình thu thập dữ liệu AI vi phạm, hoặc thậm chí cấm chúng hoàn toàn.

- Wikimedia Foundation đang phát triển kế hoạch "Sử dụng hạ tầng có trách nhiệm", nhấn mạnh rằng áp lực mạng từ bot AI là "không bền vững".

- Tổ chức này dự định thu thập phản hồi từ cộng đồng Wikipedia về cách tốt nhất để nhận diện lưu lượng từ bot AI và lọc quyền truy cập của chúng, bao gồm yêu cầu người vận hành bot phải xác thực khi quét dữ liệu với khối lượng lớn.

- Reddit đã đối mặt với tình huống tương tự vào năm 2023, khi Microsoft quét dữ liệu của Reddit mà không thông báo. Reddit sau đó đã chặn Microsoft và quyết định tính phí các nhà phát triển bên thứ ba để truy cập API của mình.

- Wikimedia Foundation nhấn mạnh: "Nội dung của chúng tôi miễn phí, cơ sở hạ tầng của chúng tôi thì không: Chúng tôi cần hành động ngay bây giờ để thiết lập lại sự cân bằng lành mạnh."

📌 Wikimedia Foundation cảnh báo về việc bot AI đang làm tăng chi phí hạ tầng khi băng thông tải nội dung đa phương tiện tăng 50% từ tháng 1/2024. Với 65% lưu lượng tiêu tốn tài nguyên đến từ bot, tổ chức đang phát triển kế hoạch "Sử dụng hạ tầng có trách nhiệm" để đảm bảo tính bền vững.

https://www.pcmag.com/news/wikipedia-faces-flood-of-ai-bots-that-are-eating-bandwidth-raising-costs

-

Dữ liệu đã trở thành tài nguyên quý giá hơn dầu mỏ, kể câu chuyện về sự hội tụ của kinh tế, công nghệ, địa chính trị và AI trong cuộc đua giành quyền lực toàn cầu.

-

Khả năng thu thập và xử lý dữ liệu đã tăng cường khả năng kiểm soát sự phát triển của AI và định hướng địa chính trị, đặt dữ liệu vào vị trí trung tâm trong cuộc cạnh tranh quyền lực giữa các quốc gia.

-

Sự nổi lên của dữ liệu như một tài nguyên có giá trị bắt nguồn từ các xu hướng thường bị bỏ qua trong nửa thế kỷ qua: sự phát triển của dịch vụ như nền tảng thương mại xuyên biên giới, toàn cầu hóa và công nghệ phá bỏ rào cản.

-

Adam Smith, nhà kinh tế học người Scotland, từng coi "người hầu" là "không sản xuất ra giá trị nào" vì ông không thể tìm ra cách định giá dịch vụ theo đơn vị trao đổi.

-

Hòa bình sau chiến tranh đã phá bỏ rào cản di cư và chuyển tiền quốc tế, cho phép người lao động có thể giao dịch dịch vụ của họ trên toàn cầu.

-

Công nghệ đã biến đổi nền kinh tế toàn cầu, mở ra kỷ nguyên dữ liệu. Giờ đây, dịch vụ không chỉ có thể được định giá và tính toán bằng dữ liệu, mà bản thân dữ liệu ngày càng có thể được giao dịch.

-

Hiện nay, dữ liệu là nền tảng cho ngành dịch vụ trị giá 4 nghìn tỷ USD, chiếm hai phần ba nền kinh tế toàn cầu, một nửa thương mại toàn cầu tính theo giá trị gia tăng, và một nửa việc làm toàn cầu.

-

Thương mại dịch vụ không thể diễn ra nếu không có dữ liệu và quá trình toàn cầu hóa thầm lặng vẫn đang diễn ra trong lĩnh vực dịch vụ.

-

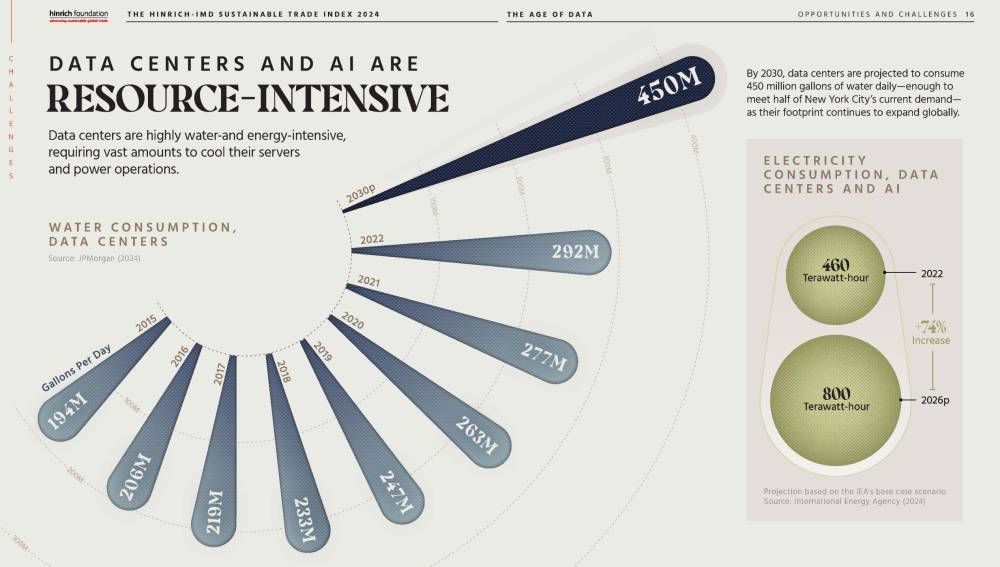

Dữ liệu hiện đang di chuyển qua khoảng 600 cáp ngầm dưới đại dương, qua vệ tinh quay quanh Trái đất, và chiếm tỷ trọng ngày càng tăng về điện năng và nước so với tất cả các tài nguyên khác.

-

Trong kỷ nguyên dữ liệu, "người hầu" (dịch vụ) mà Adam Smith từng coi là không tạo ra giá trị có thể trở thành "người chủ" - một sự đảo ngược hoàn toàn so với quan điểm kinh tế cổ điển.

📌 Dữ liệu đã trở thành tài nguyên chiến lược, hỗ trợ ngành dịch vụ 4 nghìn tỷ USD chiếm 2/3 nền kinh tế toàn cầu. Từ cáp ngầm đến vệ tinh, dữ liệu đang định hình lại quyền lực toàn cầu, đảo ngược hoàn toàn quan điểm kinh tế cổ điển của Adam Smith.

https://www.hinrichfoundation.com/research/wp/digital/age-of-data/

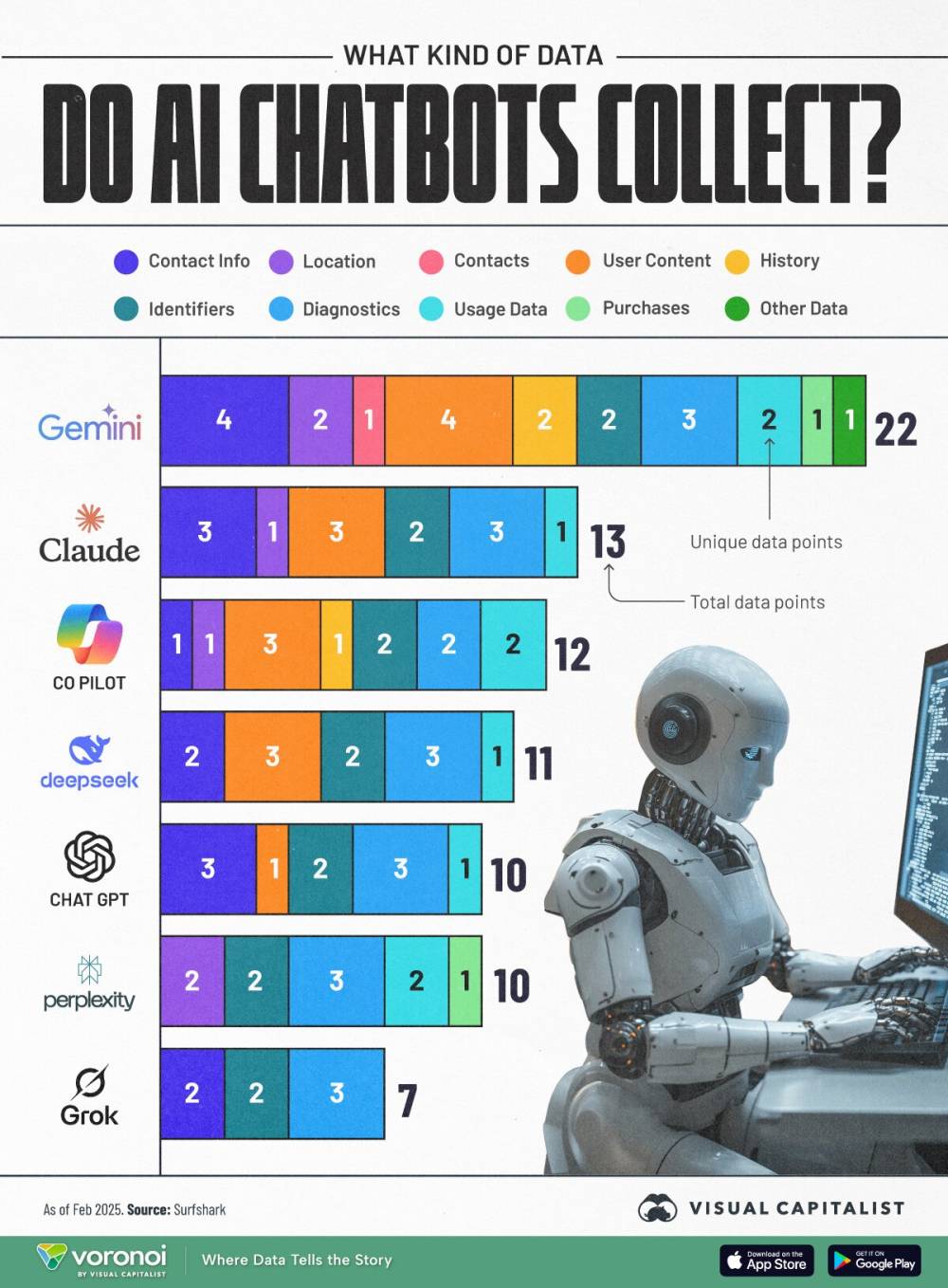

https://www.visualcapitalist.com/ranked-which-ai-chatbots-collect-the-most-data-about-you/

-

OpenAI vừa bổ sung tính năng tham chiếu nguồn kiến thức nội bộ cho ChatGPT, đáp ứng yêu cầu từ lâu của người dùng.

-

Người dùng ChatGPT Team (một trong những gói trả phí của công ty) có thể kết nối cơ sở dữ liệu kiến thức nội bộ trực tiếp vào nền tảng trong giai đoạn beta này.

-

Tính năng mới cho phép người dùng thực hiện tìm kiếm ngữ nghĩa dữ liệu, liên kết trực tiếp đến nguồn nội bộ trong câu trả lời, nhận ngữ cảnh cập nhật và liên quan nhất, đồng thời đảm bảo ChatGPT hiểu được thuật ngữ nội bộ của công ty.

-

Hiện tại, quản trị viên ChatGPT Team có thể kết nối Google Drive với ChatGPT, nhưng theo Nate Gonzales (quản lý sản phẩm tại OpenAI), đội ngũ đang phát triển các kết nối tiếp theo để hỗ trợ tất cả nguồn kiến thức nội bộ chính.

-

Theo thời gian, mô hình sẽ học ngôn ngữ độc đáo của tổ chức - tên dự án, từ viết tắt và thuật ngữ đặc thù của nhóm - đồng thời tôn trọng quyền người dùng.

-

Bằng cách kết nối cơ sở kiến thức nội bộ, ChatGPT Team có thể trở nên giá trị hơn đối với người dùng đã sử dụng nền tảng này để hỏi về chiến lược hoặc phân tích.

-

Nhiều công ty với nền tảng AI, chatbot, agent hoặc ứng dụng đều coi kho kiến thức nội bộ độc quyền của họ là yếu tố khác biệt, đây cũng là lý do tìm kiếm doanh nghiệp đang là lĩnh vực đang phát triển của AI doanh nghiệp.

-

Các công ty như Glean cung cấp cách sử dụng AI để tìm thông tin trong doanh nghiệp. ServiceNow đã mua lại MoveWorks nhằm tăng cường khả năng tìm kiếm doanh nghiệp.

-

OpenAI đã cho phép người dùng tải tài liệu trực tiếp từ Google Drive hoặc OneDrive của Microsoft. Google đưa sức mạnh của Gemini vào sản phẩm Workspace, và Perplexity đã bổ sung khả năng sử dụng tài liệu nội bộ làm nguồn dữ liệu.

-

Quyền kiểm soát đối với nguồn dữ liệu sẽ khác nhau tùy theo người dùng. Chỉ quản trị viên mới có thể thêm kết nối dữ liệu, nhưng người dùng từ nhóm nhỏ hơn có thể cấu hình khi nào ChatGPT sẽ sử dụng cơ sở kiến thức nội bộ và ổ đĩa nào.

-

OpenAI cho biết ChatGPT "hoàn toàn tôn trọng cài đặt và quyền tổ chức hiện có", vì vậy người dùng không có quyền truy cập vào ổ đĩa hoặc tài liệu cụ thể không thể buộc ChatGPT đọc những tài liệu đó.

📌 OpenAI đã bổ sung tính năng tham chiếu dữ liệu nội bộ cho ChatGPT Team, cho phép kết nối Google Drive và sắp tới là nhiều nguồn dữ liệu khác. Tính năng này tôn trọng quyền người dùng, học thuật ngữ nội bộ và nâng cao khả năng tìm kiếm doanh nghiệp, đáp ứng nhu cầu từ lâu của người dùng doanh nghiệp.

https://venturebeat.com/ai/chatgpt-gets-smarter-openai-adds-internal-data-referencing/

-

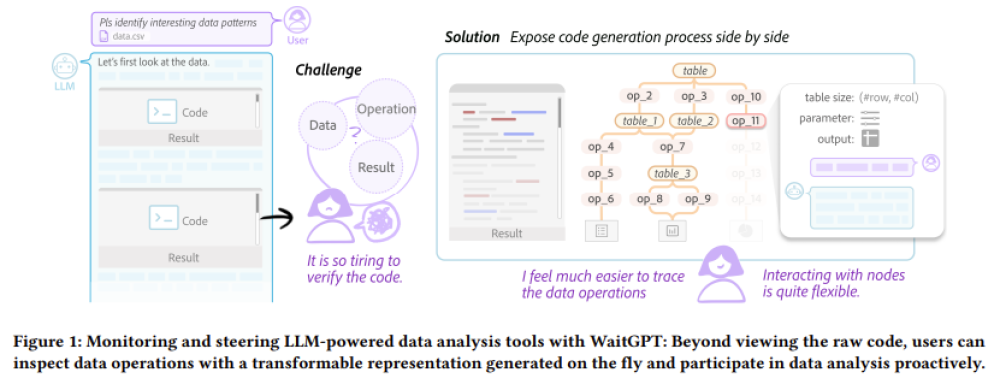

Databricks đã phát triển một kỹ thuật học máy giúp nâng cao hiệu suất của mô hình AI mà không cần dữ liệu được gắn nhãn sạch sẽ.

-

Jonathan Frankle, giám đốc khoa học AI tại Databricks, xác định rằng "dữ liệu bẩn" là thách thức chính mà khách hàng gặp phải khi triển khai AI đáng tin cậy.

-

Phương pháp mới của Databricks kết hợp học tăng cường với dữ liệu huấn luyện tổng hợp (do AI tạo ra), tương tự như cách OpenAI, Google và DeepSeek đã sử dụng để cải thiện các mô hình của họ.

-

Kỹ thuật này tận dụng phương pháp "best-of-N", cho phép ngay cả mô hình yếu cũng có thể đạt điểm cao trong một nhiệm vụ cụ thể nếu được thử đủ nhiều lần.

-

Databricks đã huấn luyện một mô hình để dự đoán kết quả best-of-N nào mà người kiểm tra sẽ thích hơn. Mô hình phần thưởng này (DBRM) sau đó được sử dụng để cải thiện hiệu suất của các mô hình khác.

-

Phương pháp Test-time Adaptive Optimization (TAO) của Databricks sử dụng DBRM để chọn đầu ra tốt nhất từ một mô hình, tạo dữ liệu huấn luyện tổng hợp để tinh chỉnh mô hình đó.

-

Nghiên cứu của Databricks cho thấy phương pháp TAO cải thiện hiệu quả hơn khi được mở rộng lên các mô hình lớn hơn, có khả năng cao hơn.

-

Khi thử nghiệm trên FinanceBench, một tiêu chuẩn đánh giá khả năng trả lời câu hỏi tài chính, Llama 3.1B (mô hình nhỏ nhất của Meta) đạt 68,4%, trong khi GPT-4o của OpenAI đạt 82,1%.

-