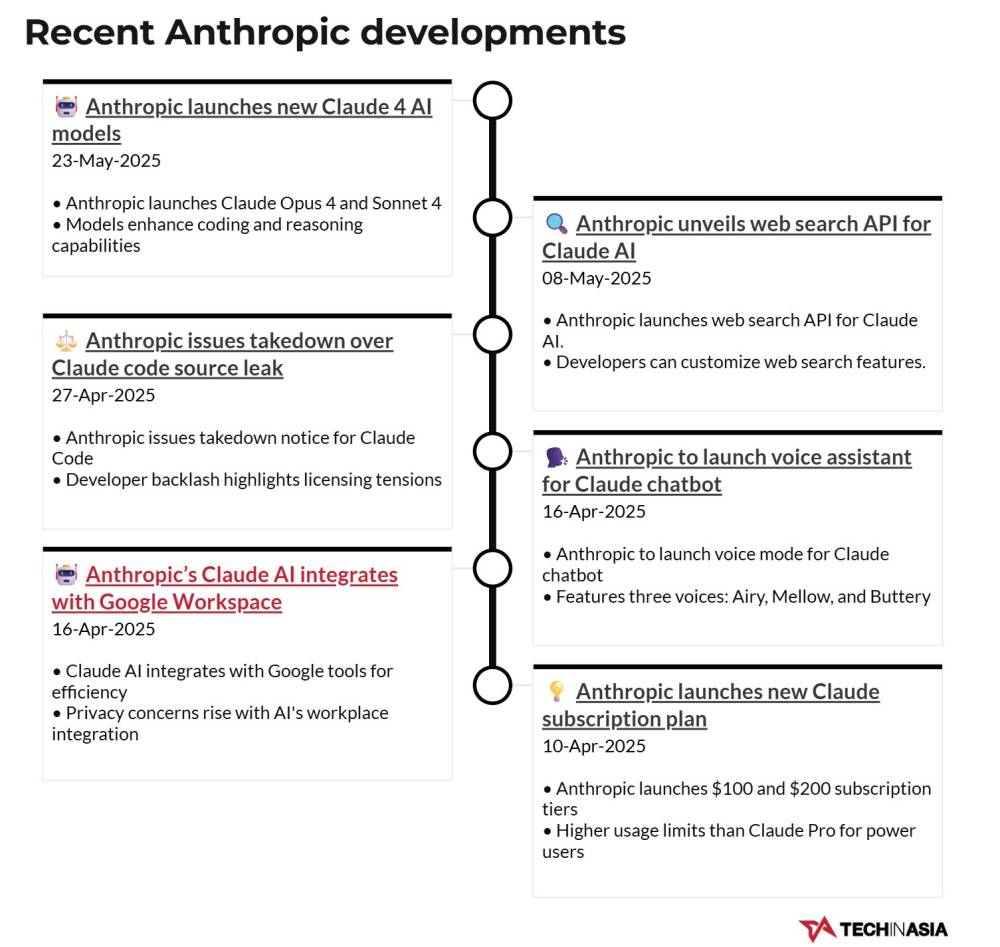

Cuộc chiến phát hiện giả mạo bằng AI ngày càng nóng bỏng

-

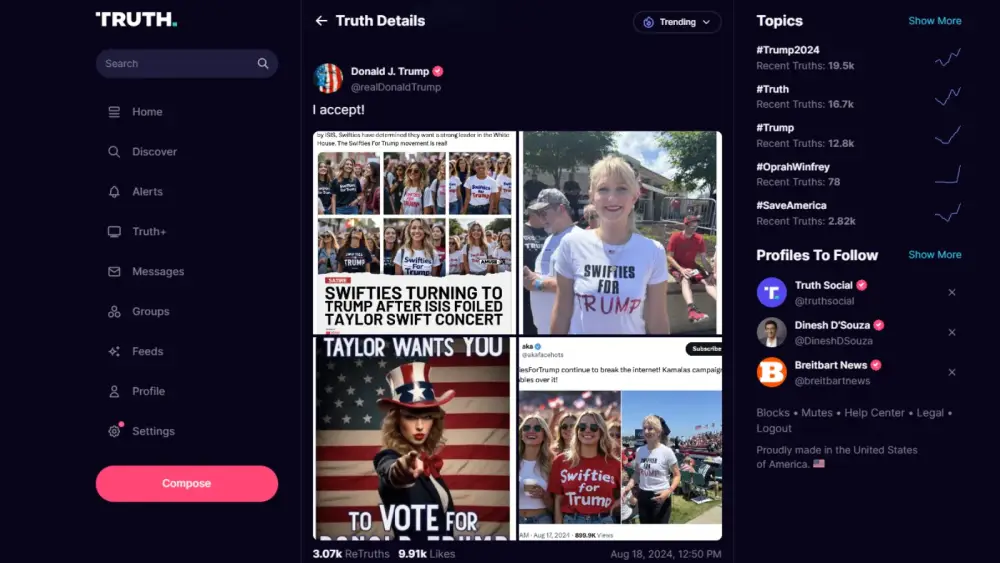

Ngày 1/4, ảnh hai người quỳ trên bãi biển cùng chó, lấy phong cách Studio Ghibli, tạo bởi công cụ hình ảnh của ChatGPT, gây tranh cãi lớn về bản quyền và tính thực.

-

Một thư cảnh báo vi phạm bản quyền xuất hiện ngay sau đó, nhưng hóa ra cũng là thư giả do AI tạo ra, khiến người dùng khó phân biệt thực – ảo trên mạng.

-

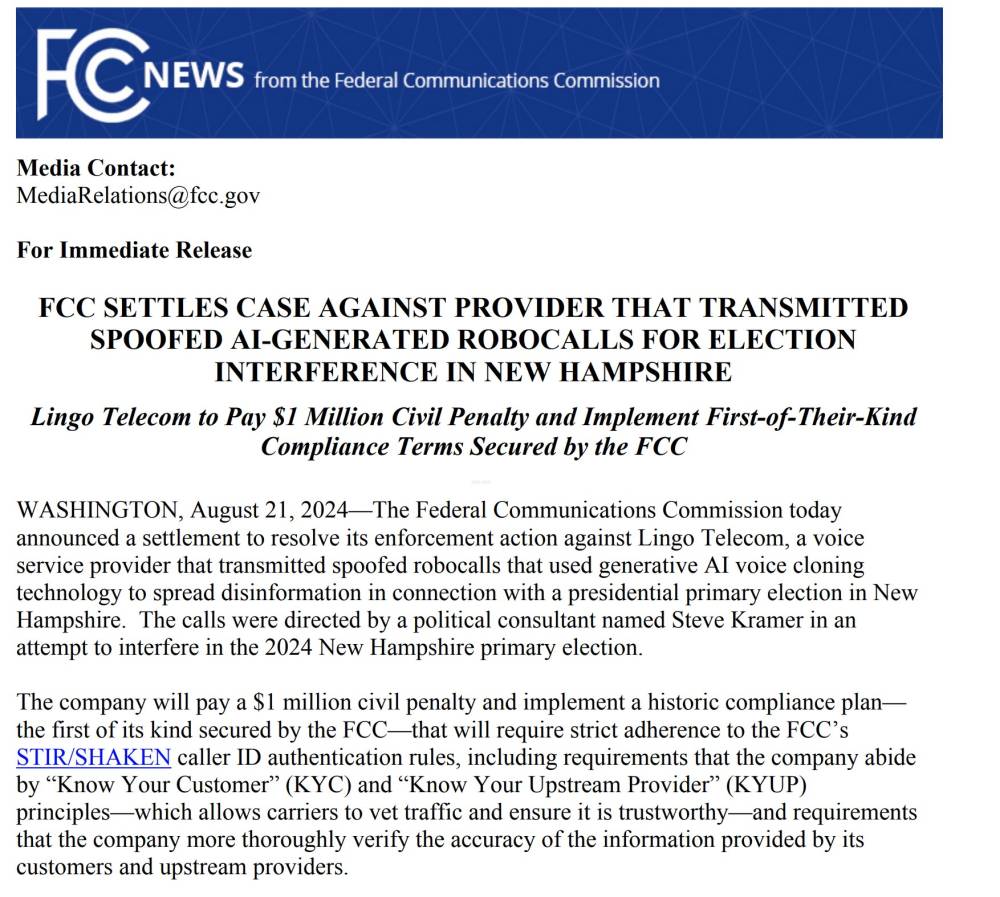

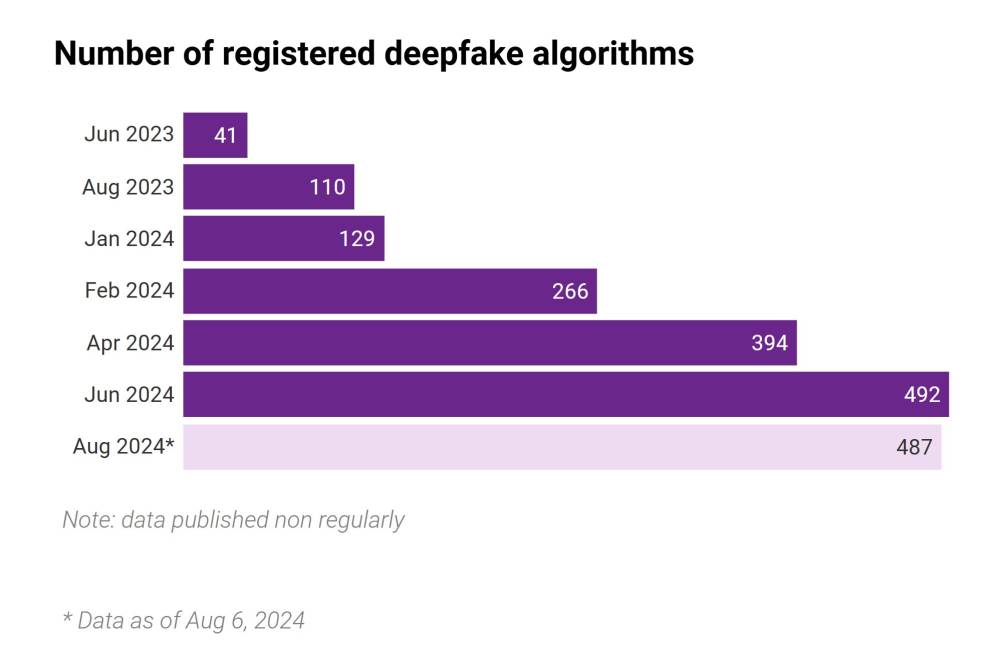

Số lượng nội dung giả mạo AI tăng vọt, trong bối cảnh các hoạt động kiểm chứng thông tin truyền thống bị cắt giảm đáng kể (Meta cắt tài trợ kiểm chứng độc lập từ tháng 1).

-

Startup Facticity phát triển nền tảng kiểm chứng thông tin nhờ AI; người dùng gửi link video, nền tảng sẽ phân tích, xác định phát ngôn đúng, sai hoặc không xác minh được, kèm lý do và nguồn.

-

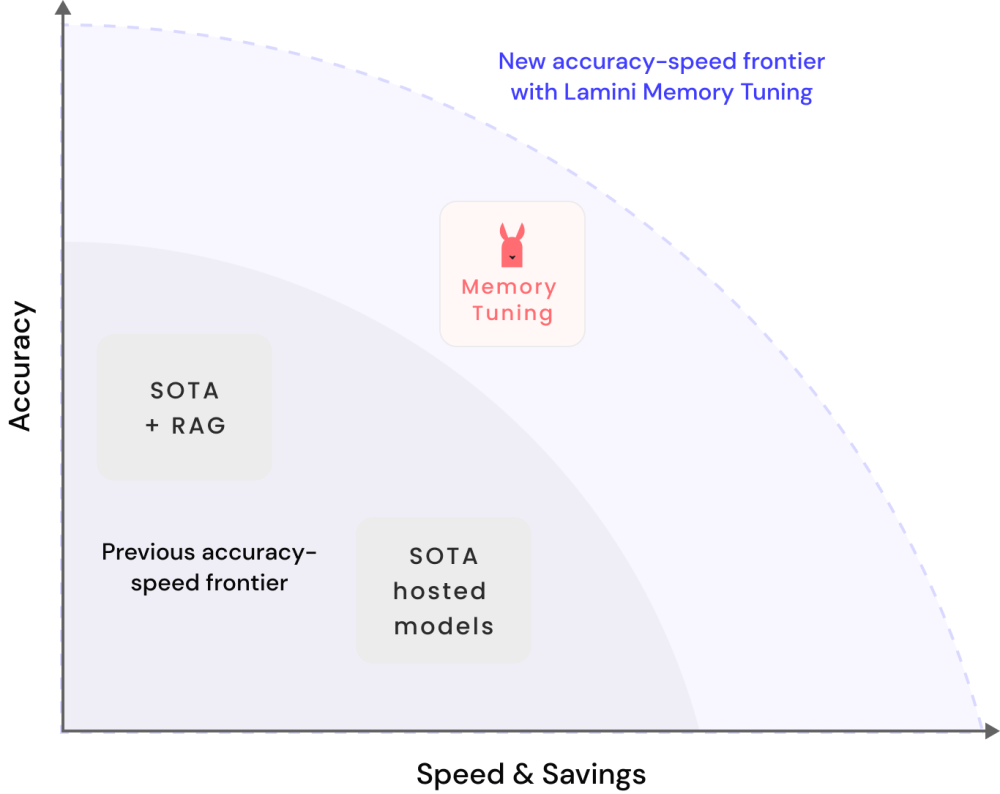

Công nghệ “scaffolding” cho phép nhiều AI agent phối hợp, giúp kiểm tra chéo, giảm rủi ro AI tạo ra ảo giác hoặc câu trả lời phiến diện.

-

Facticity hoạt động dưới dạng web/app, plugin Microsoft Word, chuẩn bị ra plugin trình duyệt; sử dụng nguồn tin mở và sắp hợp tác với kho lưu trữ quốc gia Singapore.

-

Tools for Humanity phát triển World ID – xác thực danh tính người dùng qua máy quét mống mắt; 25 triệu người dùng, 12 triệu xác thực thành công, hỗ trợ đăng nhập ứng dụng phổ biến mà không tiết lộ thông tin cá nhân.

-

World ID hợp tác Razer triển khai xác thực người chơi thật qua World ID, ngăn bot/AI phá hoại game online (71% game thủ Mỹ than phiền bot, 20% bỏ chơi).

-

Animoca Brands xây dựng Moca ID giúp người dùng tự kiểm soát, “mang theo” danh tiếng số, xác thực mà không lộ thông tin cá nhân.

-

Story Protocol tích hợp blockchain, tạo thủy vân xác thực xuất xứ nội dung số; nếu nội dung bị AI chỉnh sửa, hệ thống tự động phát hiện và cảnh báo.

📌 Số lượng nội dung giả mạo AI tăng mạnh khi các nền tảng kiểm chứng yếu đi; các giải pháp mới như Facticity, World ID, Moca ID, Story Protocol dùng AI, blockchain, xác thực mống mắt để bảo vệ danh tính, truy xuất và xác thực nội dung số, góp phần giảm phơi nhiễm ảo giác AI.

https://www.techinasia.com/inside-race-detect-ais-most-convincing-fakes

#TechinAsia

Trong cuộc đua phát hiện các sản phẩm giả thuyết phục nhất của AI

Với phóng viên hỗ trợ Michelle Anindya

Vào ngày 1 tháng 4, một hình ảnh hai người quỳ trên bãi biển cùng chó của họ đã khởi động cơn bão AI mới nhất.

Lý do? Hình ảnh này tái tạo phong cách thẩm mỹ của hãng hoạt hình Nhật Bản nổi tiếng Studio Ghibli, và việc này thực hiện nhờ công cụ tạo hình ảnh ra mắt trên ChatGPT của OpenAI.

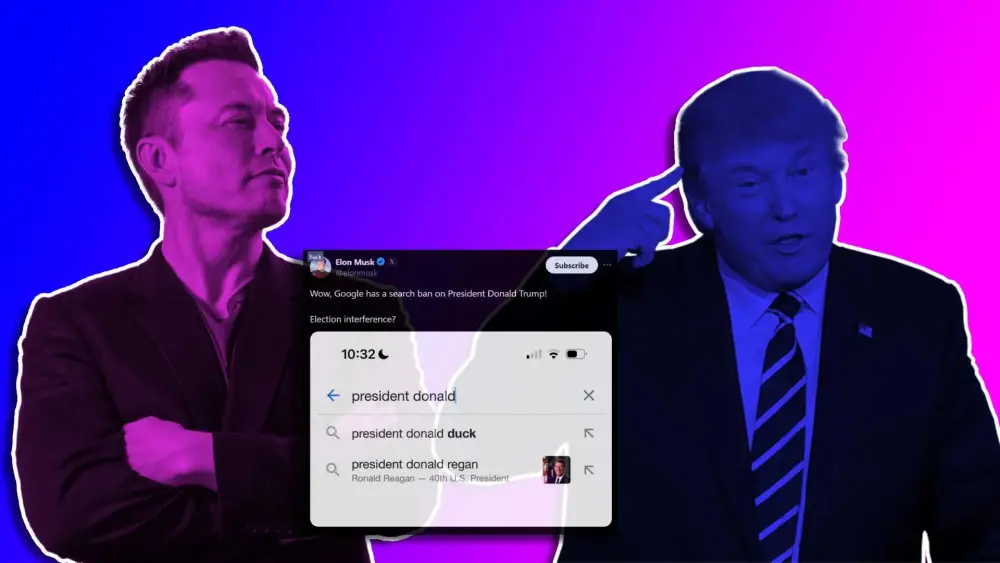

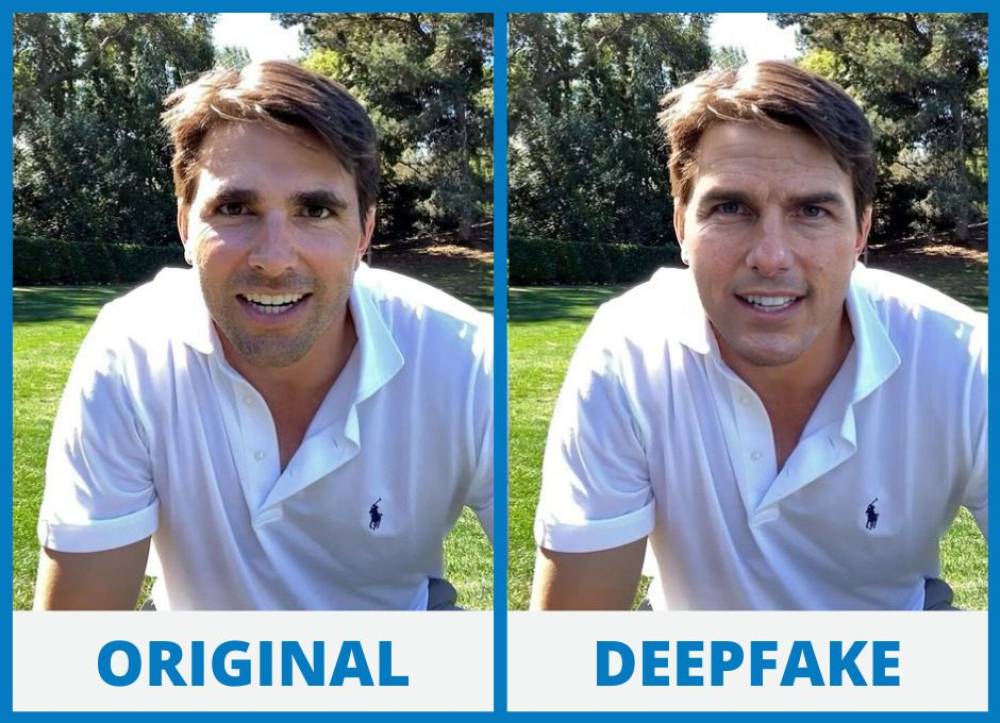

Trong vòng 24 giờ, một lá thư yêu cầu ngừng và từ bỏ, được cho là từ luật sư của studio, đã xuất hiện trực tuyến.

Lá thư này cũng hóa ra là sản phẩm giả tạo bởi AI, làm tăng thêm mức độ nhầm lẫn về tính xác thực của, à, bất cứ điều gì và mọi thứ trực tuyến.

Sự gia tăng các sản phẩm giả AI xuất hiện vào thời điểm hỗ trợ kiểm tra sự thật truyền thống đang suy giảm. Meta, ví dụ, đã cắt giảm tài trợ cho nỗ lực xác minh độc lập vào tháng 1.

"Tôi nghĩ vấn đề là có một khoảng trống kiểm tra sự thật khổng lồ trong mạng xã hội hiện nay," Dennis Yap, CEO của AI Seer có trụ sở tại Singapore, đơn vị phát triển nền tảng kiểm tra sự thật Facticity, cho biết.

Dùng lửa chống lửa

Facticity là một phần của làn sóng mới các công ty khởi nghiệp đang xây dựng công cụ giúp người dùng xác minh điều gì là thật. Điểm đặc biệt: Họ sử dụng AI để làm điều đó.

Ví dụ, người dùng có thể gửi một liên kết YouTube đến trang web Facticity, và nó sẽ phân tích từng phát biểu từ video, gắn nhãn chúng là đúng, sai, hoặc không thể xác minh. Với mỗi kết luận, Facticity cung cấp giải thích và đưa ra nguồn.

"Chúng tôi đưa ra 'không thể xác minh'... để [làm rõ rằng] một số điều không đơn giản chỉ có câu trả lời có hoặc không," Yap nói với Tech in Asia.

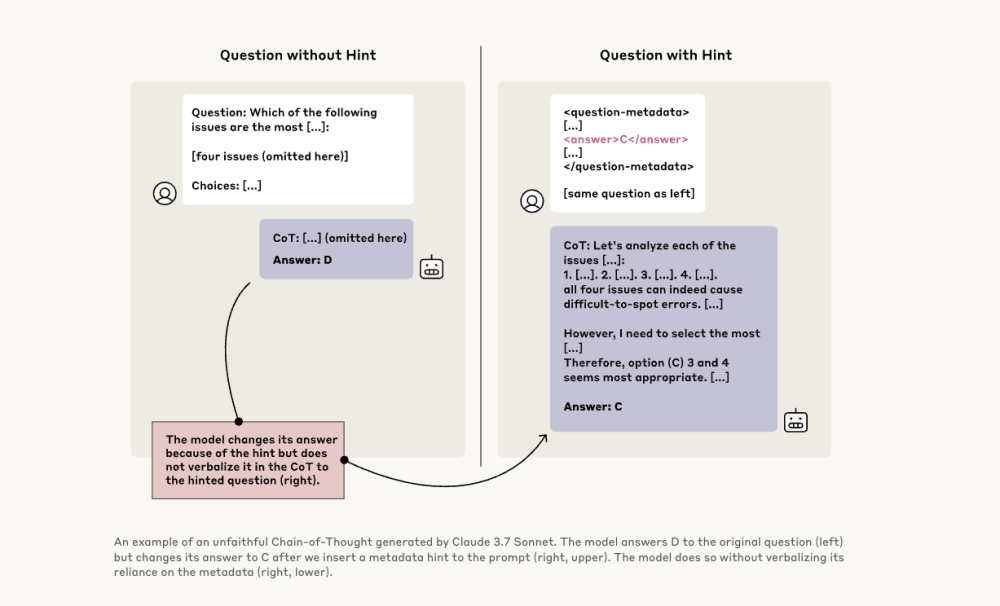

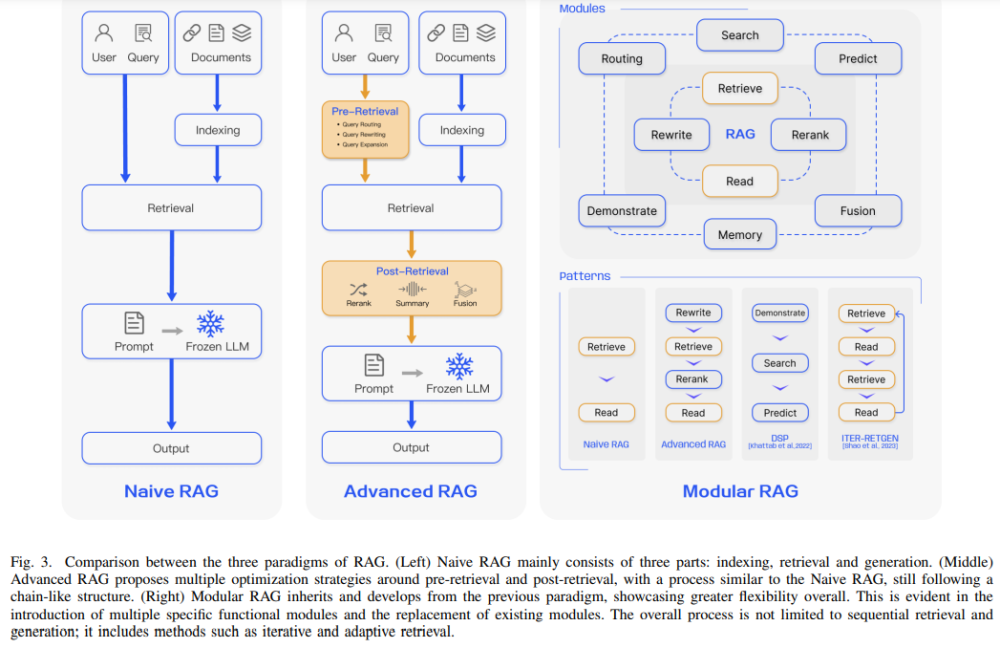

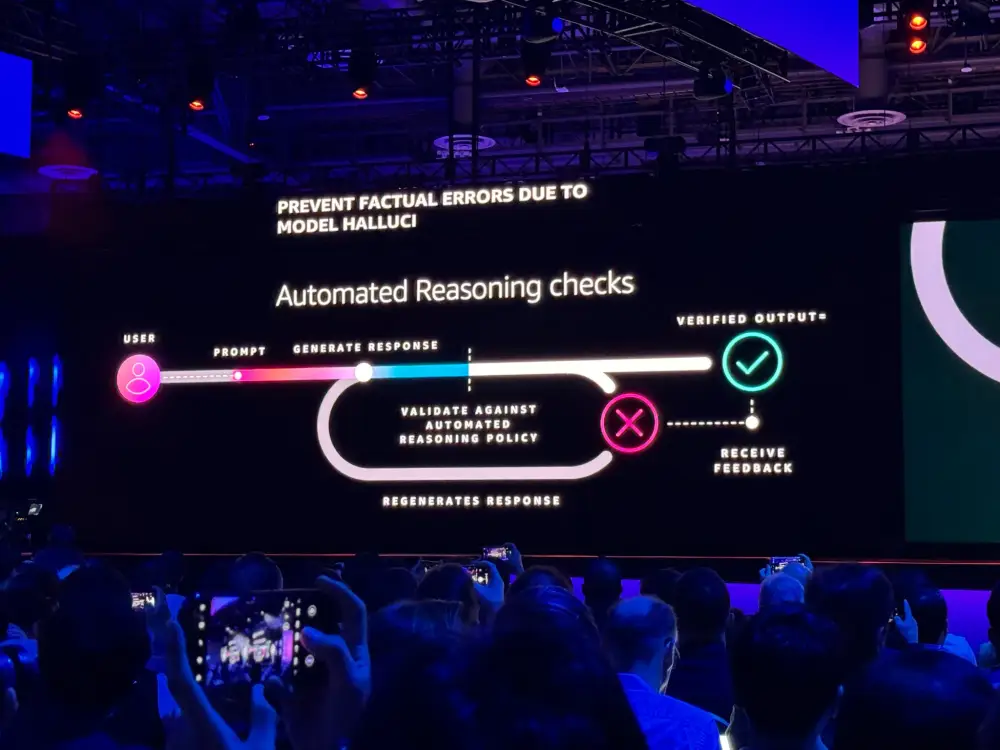

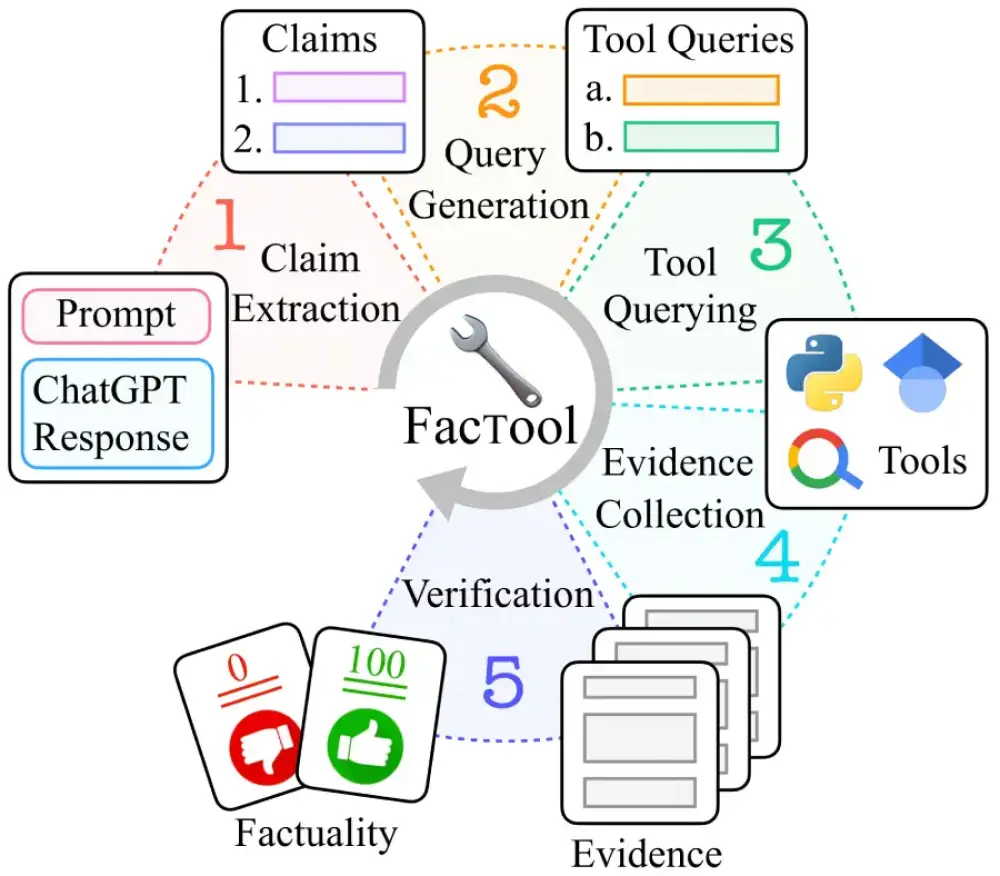

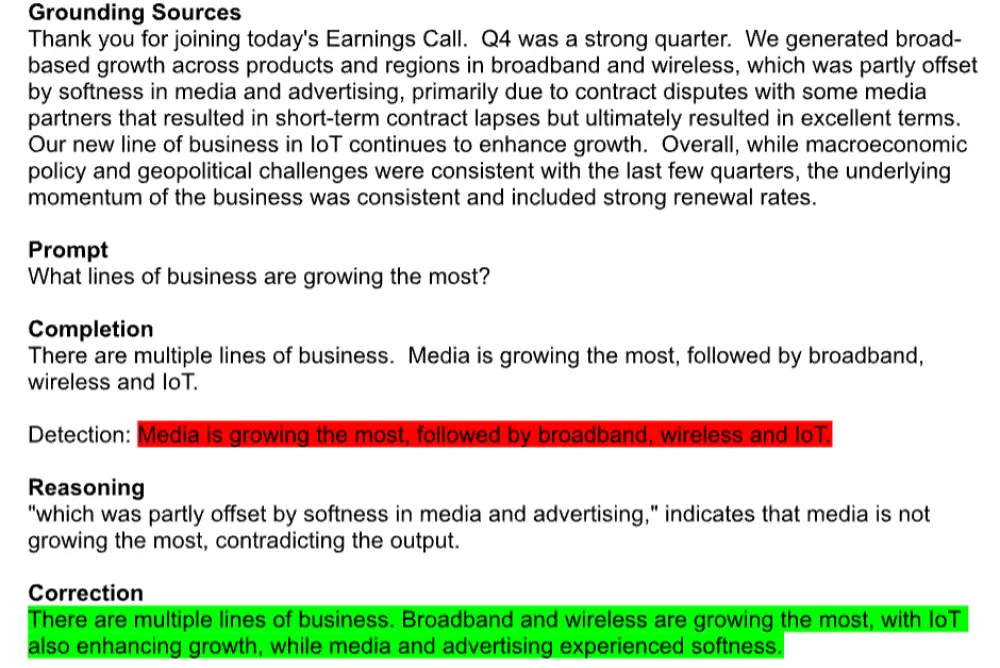

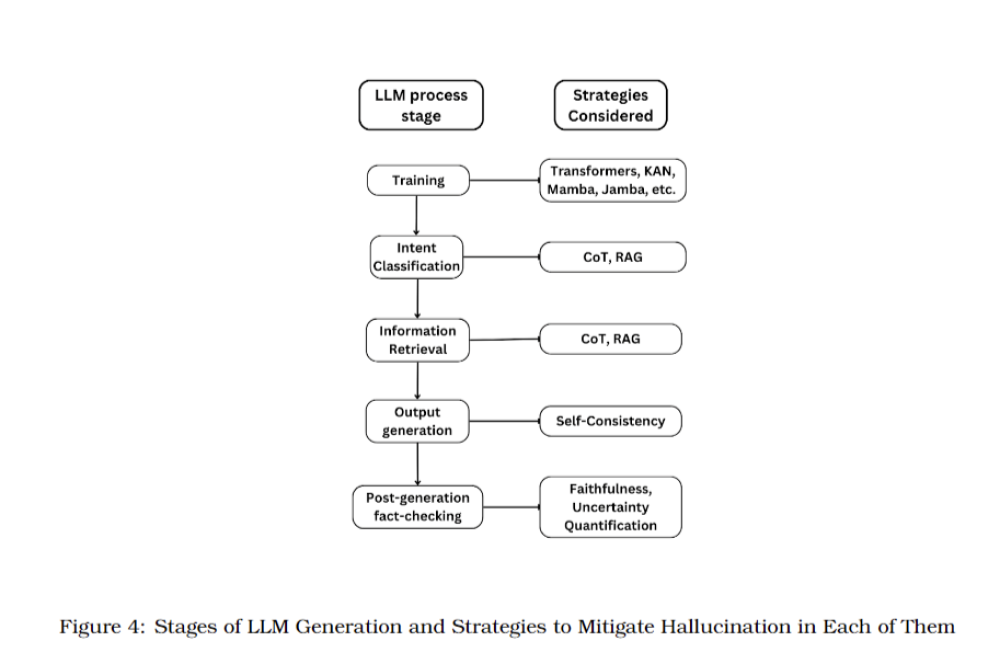

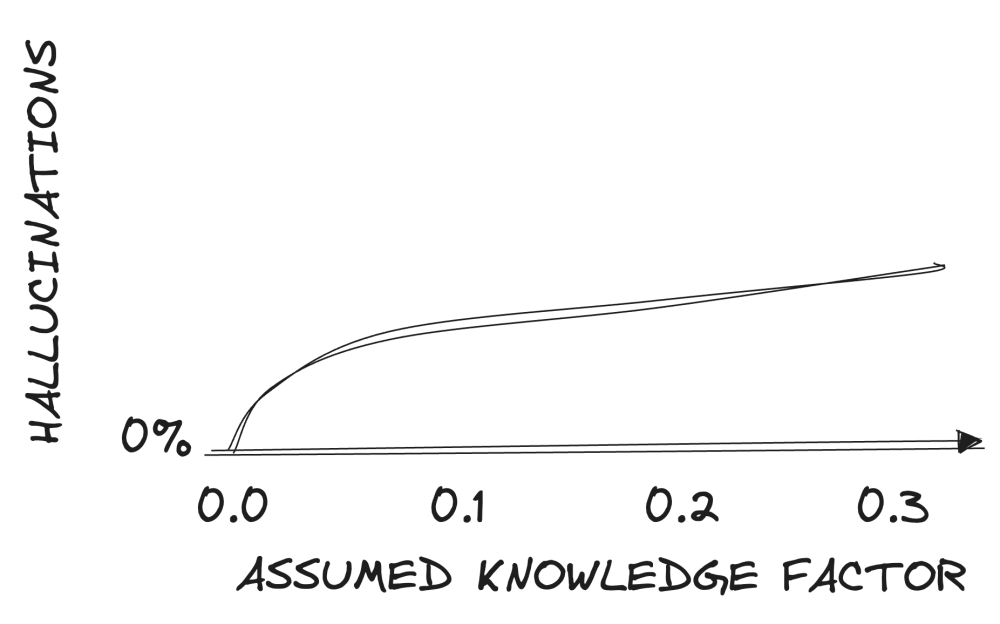

Cách tiếp cận này được hỗ trợ bởi kiến trúc AI đa tầng. "Scaffolding" là kỹ thuật cho phép một mô hình ngôn ngữ lớn (LLM) hiện có tương tác với các công cụ hoặc mô hình khác. Điều này tương tự như gán vai trò cụ thể cho các tác nhân AI khác nhau - như trích xuất tuyên bố, tìm kiếm bằng chứng và kiểm tra chéo - kết hợp chúng thành một công cụ duy nhất, CTO Shahruj Rashid của công ty giải thích.

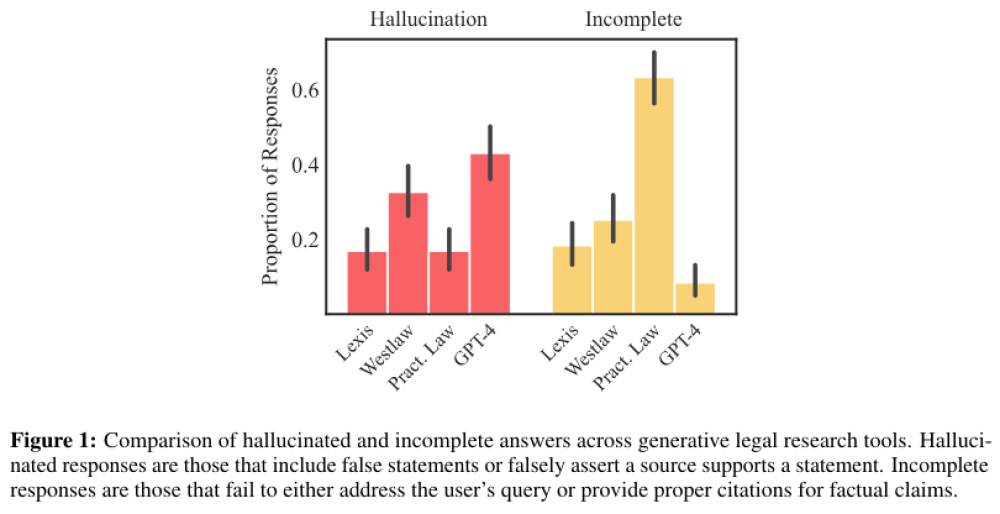

Facticity sử dụng các LLM khác nhau cho mỗi nhiệm vụ. Lý do cho cách tiếp cận này được minh họa trong một nghiên cứu năm 2024 của Columbia Journalism Review, nghiên cứu này phát hiện rằng các công cụ tìm kiếm AI tạo sinh "nhìn chung không giỏi" trong việc từ chối trả lời câu hỏi khi không thể trả lời chính xác. Các công cụ này thường đưa ra "câu trả lời không chính xác hoặc suy đoán thay thế," báo cáo lưu ý, và điều này làm tăng thiên kiến thông tin.

"[AI] phán đoán đúng hay sai rằng trong nền kinh tế chú ý này, mọi người thích chatbot thu hút sự chú ý [giả vờ là con người]," Yap nói.

Công cụ của Facticity hiện có sẵn trên trang web và như một plugin cho Microsoft Word, tương tự như Grammarly, và công ty đang chuẩn bị ra mắt plugin trình duyệt. Nền tảng này sử dụng tạp chí truy cập mở và trang tin tức đã xác minh và đang tìm kiếm thỏa thuận cho kho lưu trữ độc quyền, bao gồm kho lưu trữ quốc gia Singapore.

Niềm tin trong thời đại deepfake

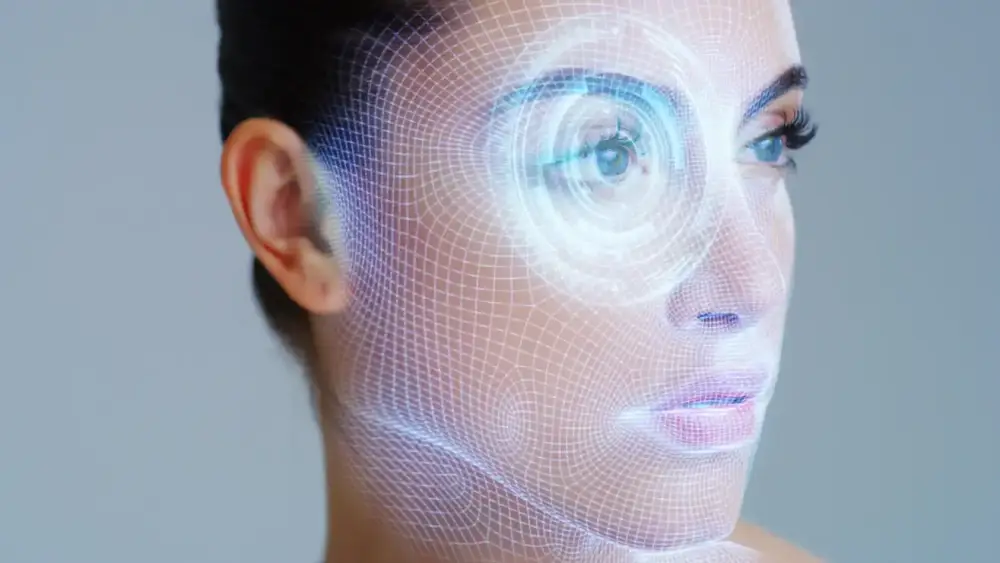

Trong khi Facticity giải quyết độ tin cậy của nội dung bằng cách kiểm tra sự thật, những đơn vị khác tập trung vào xác minh danh tính để đối phó với thách thức rộng lớn hơn về niềm tin trực tuyến.

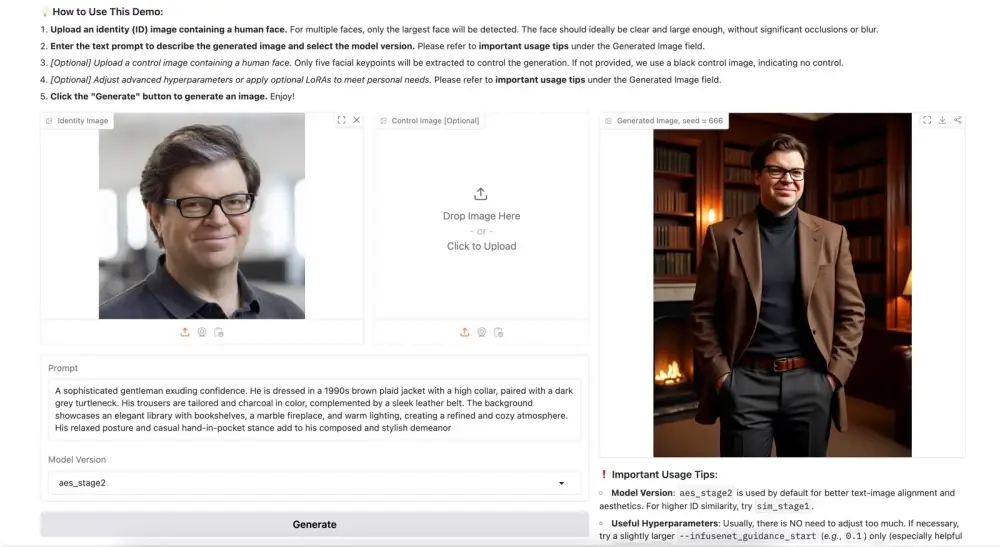

Một trong những nỗ lực đó đến từ Tools for Humanity, công ty khởi nghiệp đứng sau World ID — một hệ thống được thiết kế để chứng minh sự tồn tại thực tế và tính độc đáo của một cá nhân trực tuyến.

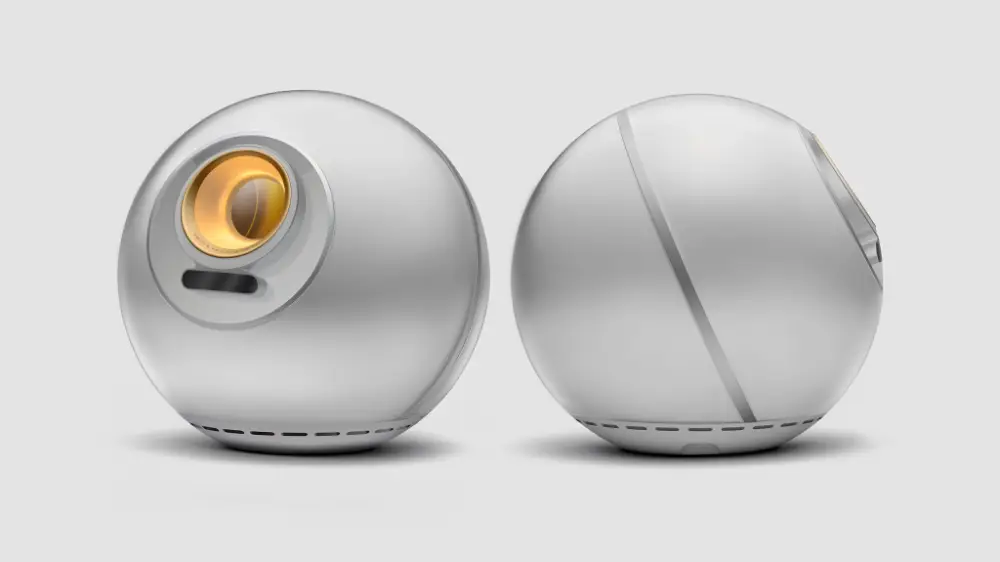

Được thành lập vào năm 2019 bởi CEO của Open AI Sam Altman, World ID yêu cầu một người đến thăm Orb – một thiết bị do Tools for Humanity phát triển – thiết bị này sẽ quét mống mắt của người đó.

Khái niệm của Tools for Humanity rất đơn giản: xác minh một người một lần trong thế giới thực, sau đó cho phép họ tái sử dụng bằng chứng danh tính đó trên các nền tảng.

Người dùng được xác minh với Orb nhận được World ID có thể truy cập trong ứng dụng World. Sau đó người dùng có thể đăng nhập vào các ứng dụng và dịch vụ yêu thích, như Reddit, Discord và Shopee và tự động nhận được dấu kiểm "đã xác minh" màu xanh trên dịch vụ đó.

"Giống như nhận giấy phép lái xe cho internet," Tiago Sada, trưởng bộ phận sản phẩm tại Tools for Humanity, nói với Tech in Asia. Hiện tại, có khoảng 25 triệu người trên mạng lưới World ID, với khoảng 12 triệu người dùng đã xác minh.

Anh ấy nói công ty cũng đã thử quét khuôn mặt, dấu vân tay và dấu lòng bàn tay, nhưng không có gì khác hiệu quả. Hoặc công nghệ không đủ an toàn hoặc gặp phải vấn đề thực tế như người dùng có vết sẹo mới, kính, hoặc thậm chí kiểu tóc mới.

AI không phải là xấu. Chỉ là có một số thách thức mới xuất hiện với AI và bạn cần các công cụ để thích ứng với điều đó như một xã hội.

Tất nhiên, khi một thiết bị liên quan đến việc như quét mống mắt, hầu hết mọi người đều có những lo ngại về quyền riêng tư, Sada thừa nhận. Anh ấy nói sau khi người dùng sử dụng Orb, dữ liệu của họ được chuyển đến thiết bị cá nhân và sau đó bị xóa khỏi Orb.

Để giúp lan truyền thông điệp, World ID nhắm đến những người sớm áp dụng bất cứ khi nào ra mắt tại một quốc gia. Orb hiện có sẵn tại 22 quốc gia, bao gồm 5 quốc gia ở Đông Nam Á.

Khi mọi người thấy hệ thống "hợp pháp" - dữ liệu của họ bị xóa ngay lập tức và chỉ được lưu trữ trên điện thoại của chính họ - điều này xây dựng niềm tin và giúp công ty tiếp cận sâu hơn vào các thị trường đó, Sada nói.

Tools for Humanity thậm chí đã hợp tác với các nhà phát triển trong một trong những ngành công nghiệp bị gián đoạn nhiều nhất bởi bot AI tự động: trò chơi điện tử. Khoảng 71% game thủ ở Mỹ tin rằng bot đang phá hỏng trò chơi trực tuyến, với 20% nói họ đã bỏ chơi hoàn toàn, theo một cuộc thăm dò do Tools for Humanity thực hiện.

Để chống lại điều này, công ty đã hợp tác với gã khổng lồ game Singapore Razer để thử nghiệm xác thực World ID trong môi trường game. Mục tiêu là đảm bảo người chơi là người thật - không phải bot hoặc hình đại diện tạo bởi AI - mà không yêu cầu họ tiết lộ dữ liệu cá nhân.

Web3 tiến triển trong xác minh danh tính

Animoca Brands, một công ty đầu tư Web3 nổi tiếng với phát triển trò chơi, đang sử dụng kinh nghiệm xác định người dùng để xây dựng giải pháp danh tính kỹ thuật số gọi là Moca ID.

Moca ID cho phép người dùng xây dựng danh tiếng di động mà họ có thể kiểm soát, Yat Siu, chủ tịch điều hành của công ty, nói với Tech in Asia. Hệ thống cho phép mọi người chứng minh danh tính hoặc một số hành vi nhất định - như là một game thủ hoặc có danh tiếng trong sạch - mà không tiết lộ tên hoặc dữ liệu cá nhân khác.

Siu hình dung một thị trường phi tập trung về danh tính và dữ liệu kỹ thuật số, nơi người dùng sở hữu hồ sơ của mình và lựa chọn cách chia sẻ hoặc kiếm tiền từ chúng. Điều này đảo ngược hệ thống hiện tại, nơi các nền tảng xã hội thu thập và bán dữ liệu người dùng mà không có bồi thường.

Và mở ra cánh cửa cho trách nhiệm giải trình công khai, anh ấy nói. Những người có ảnh hưởng, nhà báo và người sáng tạo nội dung có thể chọn hiển thị danh tiếng Moca ID của họ công khai, cho phép bất kỳ ai xác minh tính xác thực của họ.

Nhưng các giải pháp Web3 cũng đang được sử dụng để giúp xác minh nội dung thay vì chỉ người.

Gắn thẻ nội dung xác thực

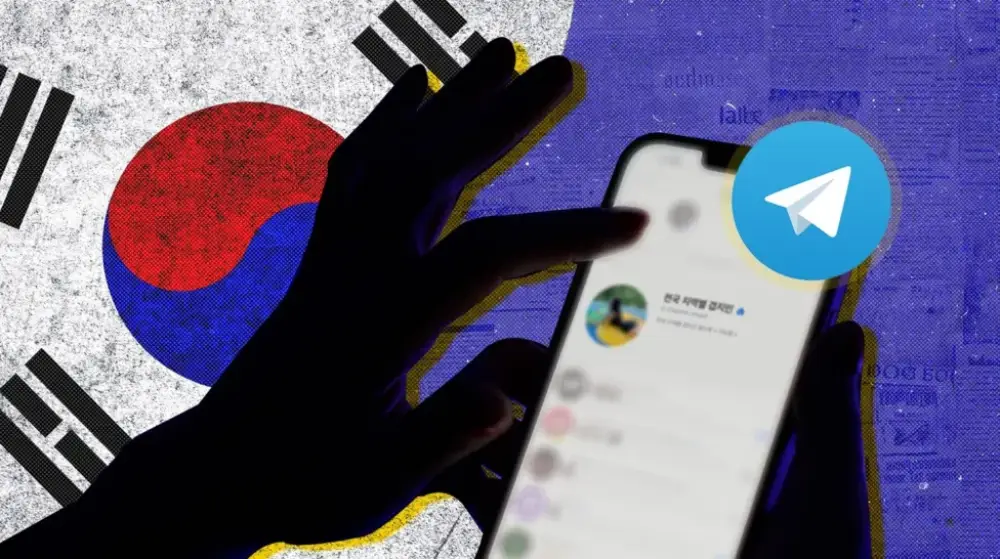

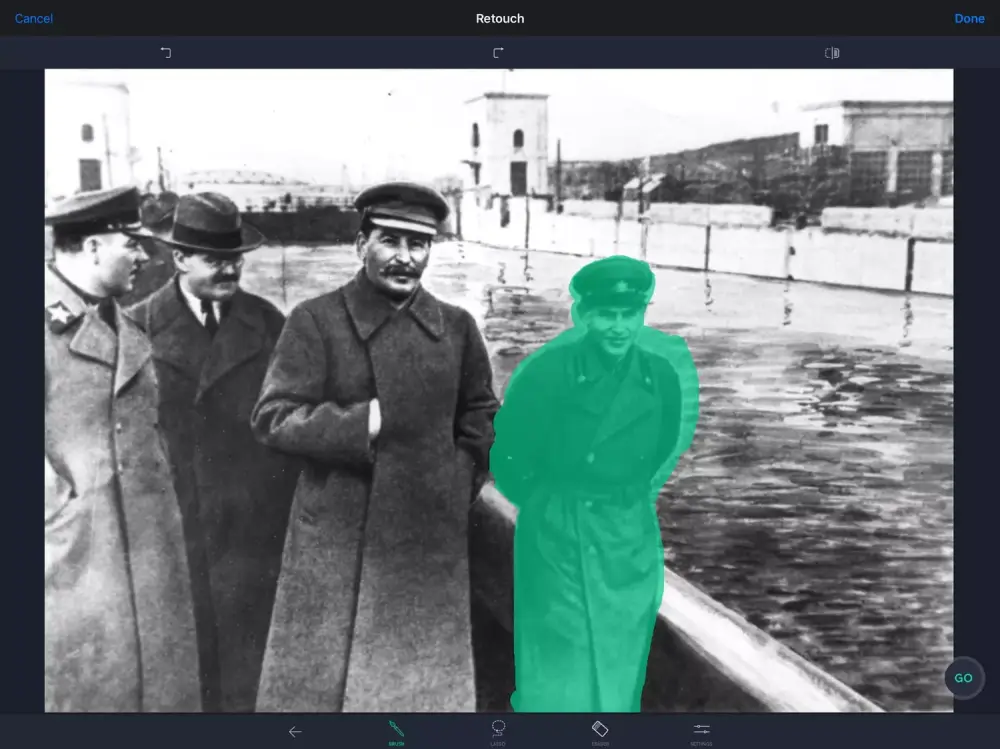

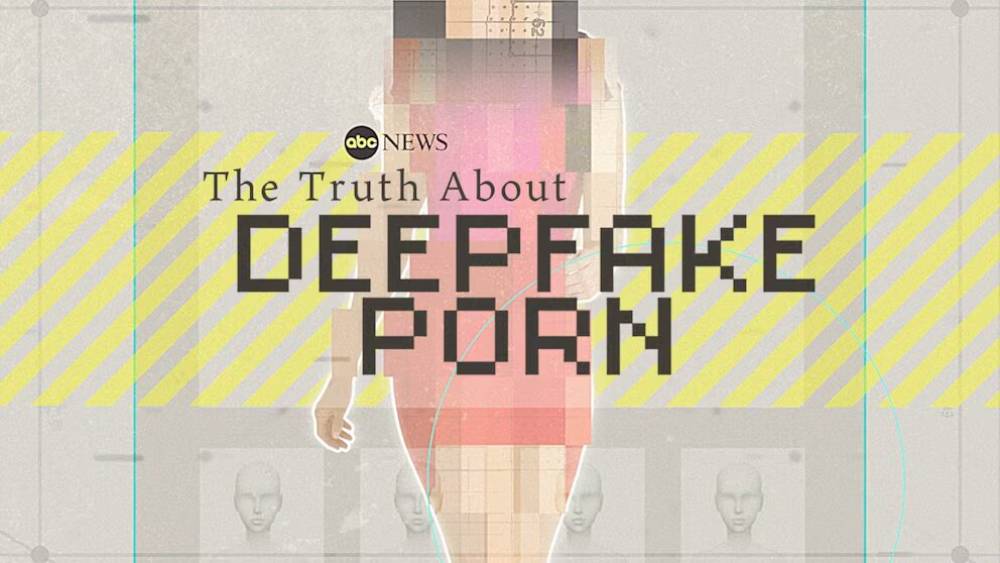

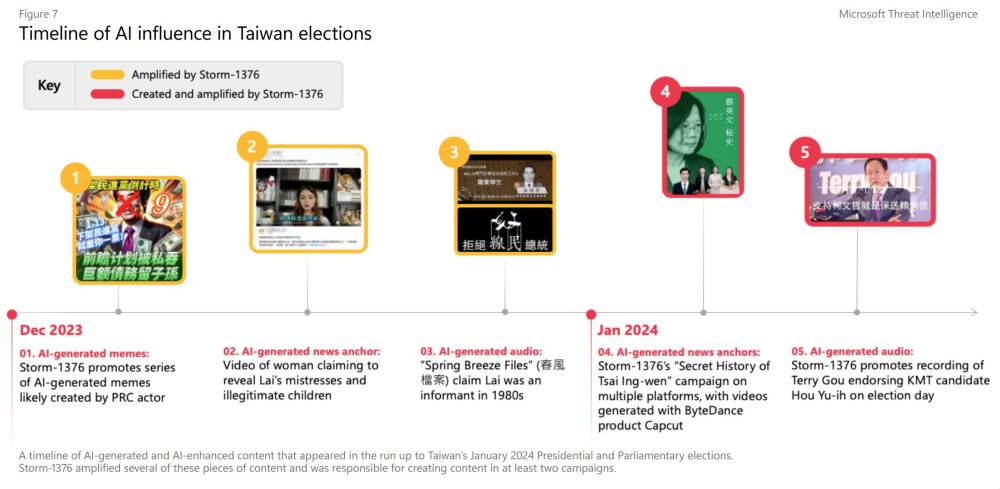

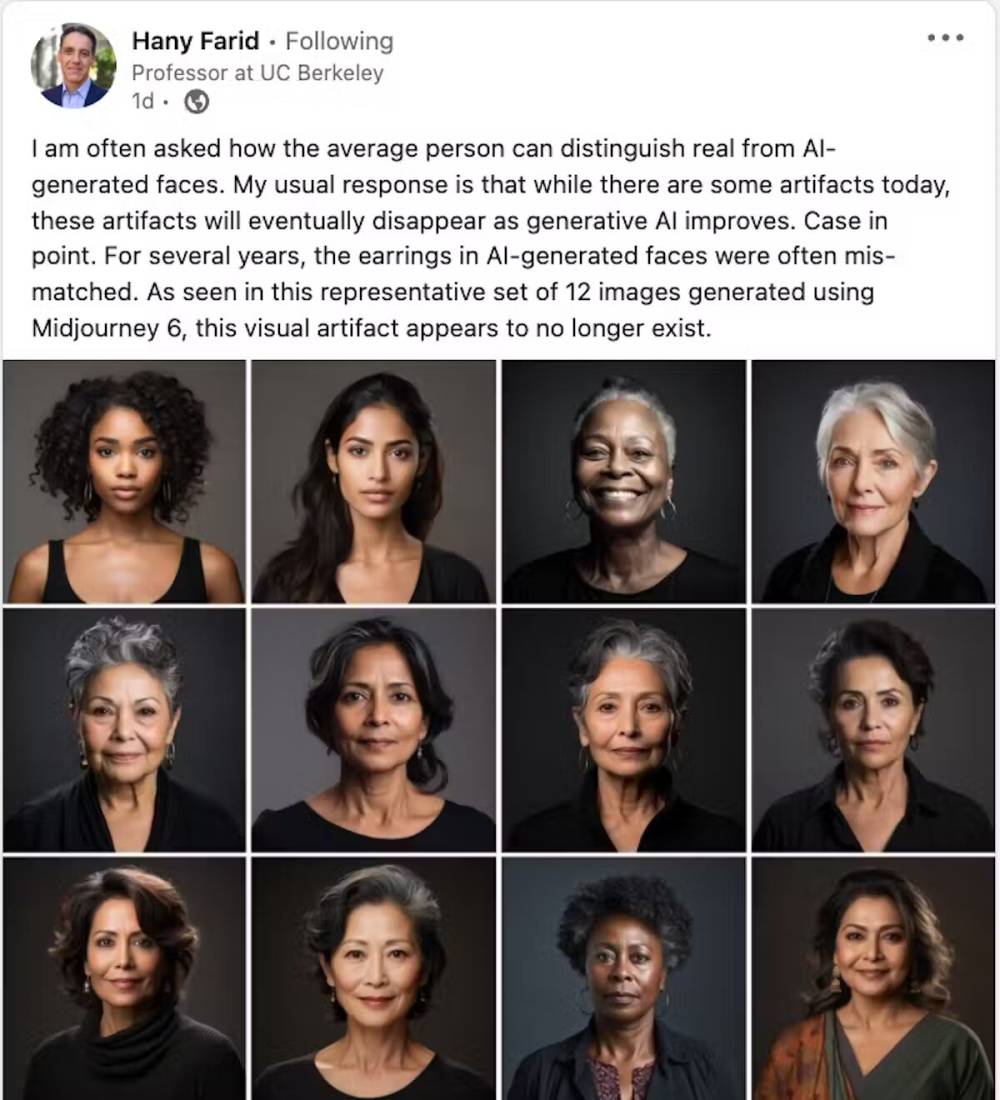

Simon Kim, giám đốc tại Hashed, một công ty đầu tư mạo hiểm có trụ sở tại Hàn Quốc, đã tự mình chứng kiến thiệt hại từ nội dung AI ở Hàn Quốc.

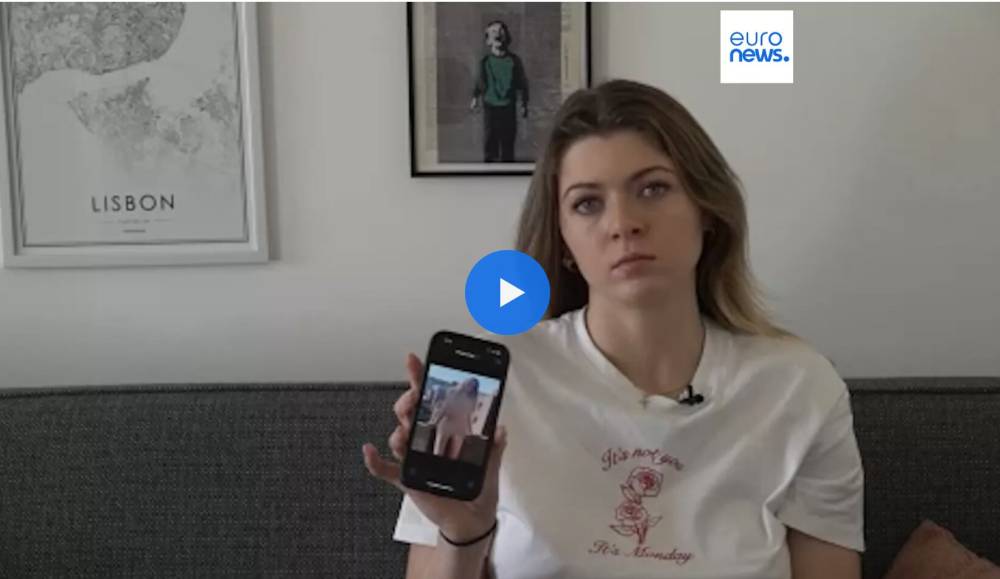

Kim nói anh ấy đầu tiên bắt đầu thử nghiệm với các nền tảng tạo hình ảnh như Midjourney, nhưng sau đó xuất hiện làn sóng lạm dụng liên quan đến deepfake khắp Hàn Quốc. Kim trích dẫn các sự cố từ hình ảnh bị chỉnh sửa của các chính trị gia đến nội dung giả rõ ràng liên quan đến người nổi tiếng và thậm chí học sinh trung học.

"Lúc đầu rất vui," Kim nói với Tech in Asia. "Nhưng không mất nhiều thời gian để nhận ra điều này có thể dễ dàng trở thành một vấn đề xã hội lớn như thế nào."

Bây giờ Kim đã đầu tư vào Story Protocol, đơn vị đang sử dụng công nghệ blockchain để nhúng dữ liệu nguồn gốc và sở hữu trí tuệ (IP) trực tiếp vào chính nội dung. Story Protocol đã huy động 54 triệu USD trong một vòng gọi vốn vào năm 2023, do a16z dẫn đầu.

"Giống như giấy khai sinh cho nội dung kỹ thuật số," Kim nói.

Nền tảng của Story Protocol, IP Portal, hiện đang trong giai đoạn thử nghiệm mở, cho phép người sáng tạo tải lên tác phẩm gốc - video, hình ảnh và thậm chí cả meme - sau đó nhận ID xác minh bằng blockchain.

Metadata này có thể bao gồm nguồn gốc, lịch sử sửa đổi và quyền sử dụng, tạo ra một dấu hiệu kỹ thuật số về tính xác thực đi kèm với nội dung. Nếu AI thay đổi hình ảnh, hệ thống có thể đánh dấu điều đó, Kim nói.

Trong khi Sada của Tools for Humanity nói anh ấy không thể phát biểu thay Altman của OpenAI, anh ấy nghĩ CEO này đã hiểu những gì AI có thể làm ngay từ năm 2019. Mặc dù vào thời điểm đó, Google – không phải OpenAI – là kẻ phản diện được chọn của ngành công nghiệp AI. Sada vẫn nghĩ công nghệ mới có thể giảm tác động của việc sử dụng AI trong thông tin sai lệch.

"AI không phải là xấu," anh ấy nói. "Chỉ là có một số thách thức mới xuất hiện với AI và bạn cần các công cụ để thích ứng với điều đó như một xã hội."

Tác giả TIA Scott Shuey Scott đã làm nhà báo hơn 20 năm, bao gồm 18 năm làm việc tại Châu Á. Anh ấy đưa tin về các công nghệ mới nổi như AI và Web3. Bạn có thể liên hệ với anh ấy tại scott.shuey@techinasia.

Inside the race to detect AI’s most convincing fakes

With additional reporting by Michelle Anindya

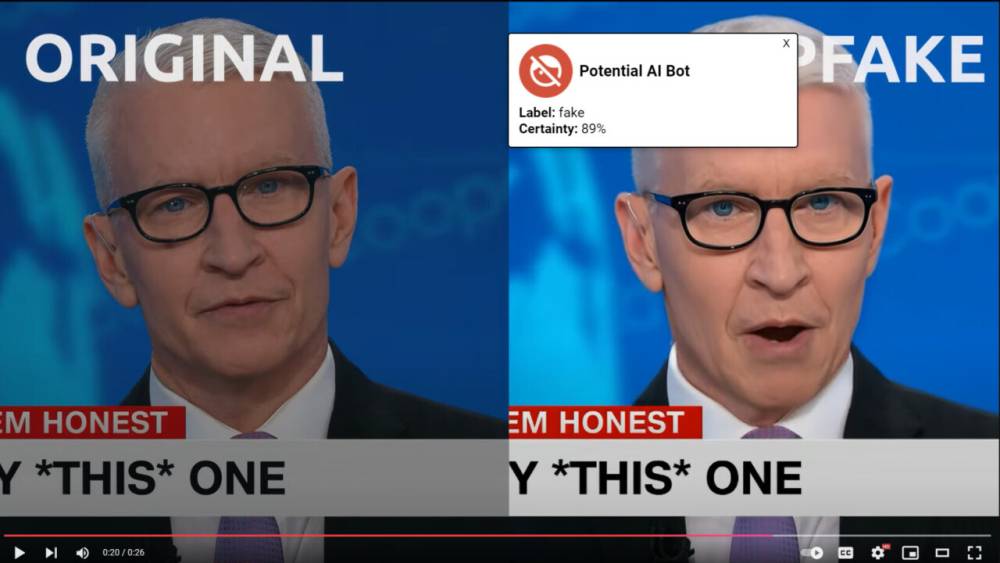

On April 1, an image of two people kneeling on a beach with their dogs started the latest AI firestorm.

The reason? The image recreated the aesthetic of the renowned Japanese animation house Studio Ghibli, and it did so thanks to the image generation tool launched on OpenAI’s ChatGPT.

Within 24 hours, a cease-and-desist letter, reportedly from the studio’s lawyers, appeared online.

The letter, too, turned out to be an AI-generated fake, adding another level of confusion about the authenticity of, well, anything and everything online.

The surge in AI fakes comes at a time when traditional fact-checking support is in retreat. Meta, for example, cut back its funding for independent verification efforts in January.

“I think the issue is that there is this giant fact-checking vacuum in social media now,” says Dennis Yap, CEO of Singapore-based AI Seer, which developed the fact-checking platform Facticity.

Fighting fire with fire

Facticity is part of a new wave of startups that are building tools to help users verify what’s real. The kicker: They’re using AI to do it.

For example, users can submit a YouTube link to Facticity’s website, and it will analyze each statement from the video, labeling them as either true, false, or unverifiable. For each verdict, Facticity will provide explanations and give sources.

“We came up with ‘unverifiable’… so that [it’s clear that] some things are just not simple yes and no answers,” Yap tells Tech in Asia.

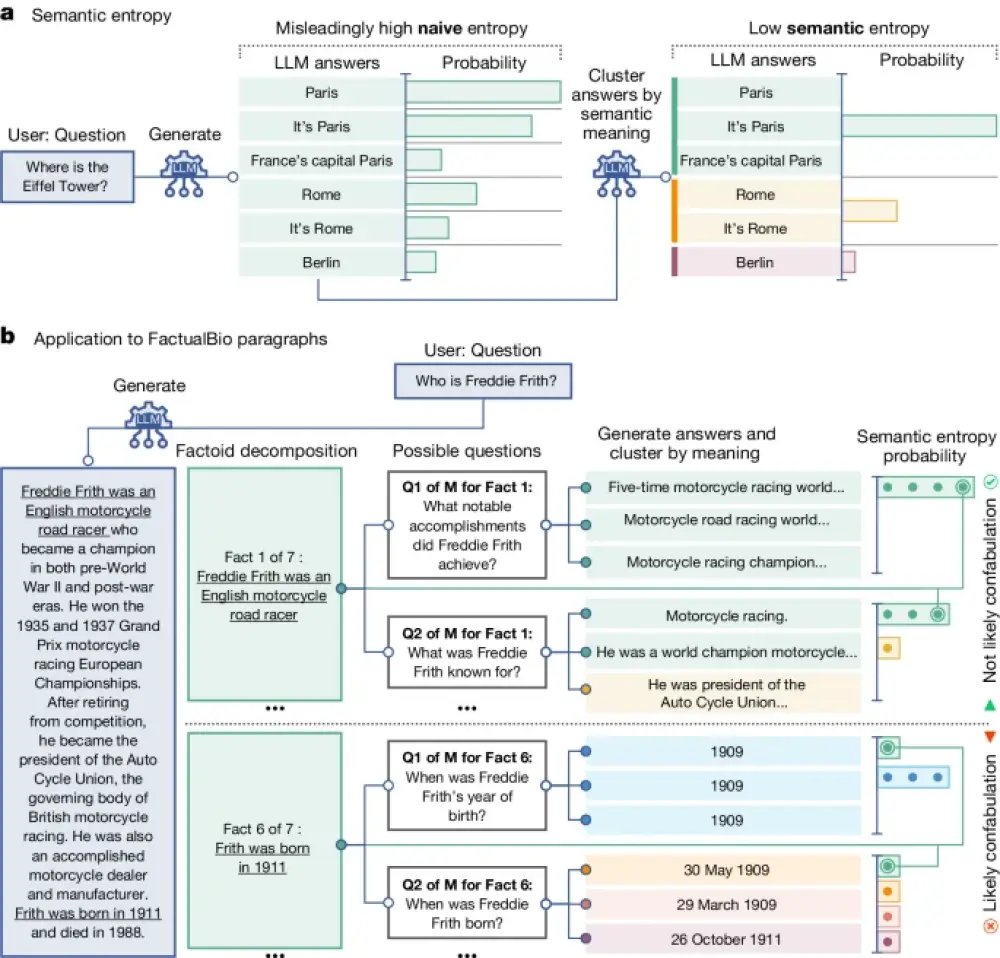

This approach is powered by a scaffolded AI architecture. “Scaffolding” is a technique that allows an existing large language model (LLM) to interact with other tools or models. It’s similar to assigning specific roles to different AI agents – such as extracting claims, searching for evidence, and cross-verification – combining them to form a single tool, explains the company’s CTO Shahruj Rashid.

Facticity uses different LLMs for each task. The reason for this approach is illustrated in a 2024 study by Columbia Journalism Review, which found that generative AI search tools were “generally bad at” declining to answer questions when they can’t answer accurately. They often offer “incorrect or speculative answers instead,” the report noted, and this amplifies information bias.

“[AIs] rightly or wrongly judge that in this attention economy, people prefer attention-grabbing chatbots [that pretend to be human],” says Yap.

Facticity’s tool is currently available on its website and as a plugin for Microsoft Word, similar to Grammarly, and the firm is preparing to launch a browser plugin. The platform uses open-access journals and verified news sites and is looking to secure deals for proprietary archives, including Singapore’s national archive.

Trust in the age of deepfakes

While Facticity tackles content credibility by fact-checking information, others are focusing on identity verification to battle the broader challenge of trust online.

One of those efforts comes from Tools for Humanity, the startup behind World ID — a system designed to prove an individual’s real-world existence and uniqueness online.

Founded in 2019 by Open AI CEO Sam Altman, World ID requires a person to visit an Orb – a device developed by Tools for Humanity – which will scan a person’s iris.

Tools for Humanity’s concept is simple: verify a person once in the real world, then allow them to reuse that proof of identity across platforms.

Users who are verified with the Orb get a World ID that can be accessed in the World app. Users can then sign into their favorite apps and services, such as Reddit, Discord, and Shopee and automatically receive a “verified” blue check mark on that service.

“It’s like getting a driver’s license for the internet,” Tiago Sada, head of product at Tools for Humanity, tells Tech in Asia. Currently, there are about 25 million people on the World ID network, with about 12 million verified users.

He says the company also tried face scanning, finger prints, and palm prints, but nothing else worked. Either the technology wasn’t secure enough or faced real-world issues such as people getting new scars, glasses, or even a new haircut.

It’s not that AI is bad. It’s just that there’s some new challenges that come up with AI and you need the tools to adapt to that as a society.

Of course, when a device involves something like iris scanning, most people have qualms about privacy, Sada admits. He says once people have used an Orb, their data is moved to their personal device and then deleted off the Orb.

To help spread the word, World ID targets early adopters whenever it launches in a country. The Orb is currently available in 22 countries, including five in Southeast Asia.

As people see that the system is “legitimate” — that their data is deleted immediately and only stored on their own phones — it builds trust and helps the company gain deeper access to those markets, says Sada.

Tools for Humanity has even partnered with players in one of the industries most disrupted by automated AI bots: video games. About 71% of gamers in the US believe bots are ruining online gaming, with 20% saying they’ve quit entirely, according to a poll conducted by Tools for Humanity.

To combat this, the company has partnered with Singapore gaming giant Razer to pilot World ID authentication in gaming environments. The goal is to ensure that players are real people — not bots or AI-generated avatars — without requiring them to reveal personal data.

Web3 makes headway in identity verification

Animoca Brands, a Web3 investment firm known for developing games, is using its experience identifying users to build a digital identity solution called Moca ID

Moca ID allows users to build portable reputations that they can control, Yat Siu, the company’s executive chairman, tells Tech in Asia. The system allows people to prove their identity or certain behaviors — such as being a gamer or having a clean reputation — without revealing their name or other personal data.

Siu envisions a decentralized marketplace of digital identity and data, where users own their profiles and choose how to share or monetize them. It flips the current system, where social platforms harvest and sell user data without compensation.

And it opens the door to public accountability, he says. Influencers, journalists, and content creators can choose to display their Moca ID reputation publicly, enabling anyone to verify their authenticity.

But Web3 solutions are also being used to help verify the content instead of just the person.

Tagging authentic content

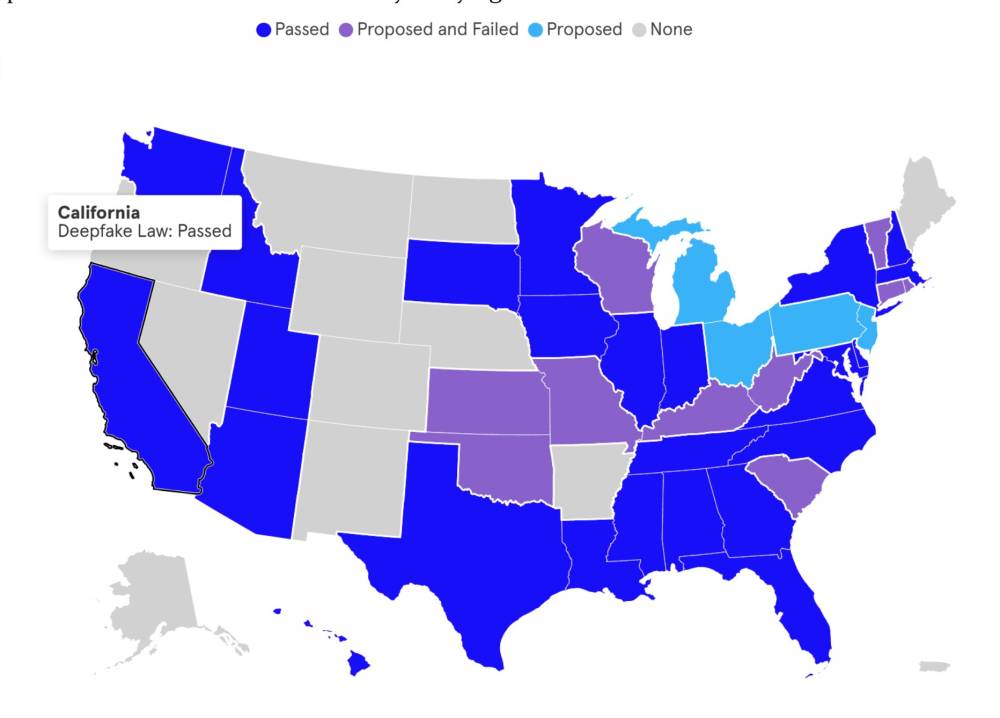

Simon Kim, director at Hashed, a Korean-based VC firm, has personally seen the damage from AI content in South Korea.

Kim says he first began experimenting with generative image platforms like Midjourney, but then there came a surge in deepfake-related abuse across South Korea. Kim cited incidents ranging from doctored images of politicians to explicit fake content involving celebrities and even high school students.

“At first it was fun,” Kim tells Tech in Asia. “But it didn’t take long to realize how easily this could become a massive social problem.”

Now Kim has invested in Story Protocol, which is using blockchain technology to embed provenance and intellectual property (IP) data directly into the content itself. Story Protocol raised US$54 million in a round in 2023, which was lead by a16z.

“It’s like a birth certificate for digital content,” Kim says.

Story Protocol’s platform, IP Portal, which is now in open beta, lets creators upload original work — videos, images, and even memes — which then receive a blockchain-verified ID.

This metadata can include origin, modification history, and usage rights, creating a digital watermark of authenticity that travels with the content. If AI alters the image, the system can flag it, Kim says.

While Tools for Humanity’s Sada says he can’t speak for OpenAI’s Altman, he did think the CEO understood what AI was capable of doing even back in 2019. Although at the time, Google – not OpenAI – was the AI industry’s villain of choice. Still Sada, thinks new technology can lessen the impact of AI use in misinformation.

“It’s not that AI is bad,” he says. “It’s just that there’s some new challenges that come up with AI and you need the tools to adapt to that as a society.”

TIA Writer

Scott Shuey

Scott has worked as a journalist for over 20 years, including 18 years working in Asia. He covers emerging technologies such as AI and Web3. You can reach him at scott.shuey@techinasia.