Menu

3520 Fremont Ave N, Seattle, 98103

Salmon nigiri x2 $8

Agedashi x2 $8

Avocado maki $5.95

Edamame $3.50

Barley tea x2 $5

Total (including tax and tip) $82.56

Emily Bender, giáo sư ngôn ngữ học tại Đại học Washington, là một trong những tiếng nói hoài nghi nổi bật nhất về trí tuệ nhân tạo hiện nay, gọi AI là “máy đạo văn” và “vẹt ngẫu nhiên”.

Bà cho rằng các mô hình ngôn ngữ lớn (LLM) không có trí tuệ thật sự, chỉ đơn thuần kết hợp các từ dựa trên xác suất, giống như một “Magic 8 Ball” được lập trình tinh vi.

Trong cuốn sách The AI Con viết cùng Alex Hanna, Bender cảnh báo AI đe dọa nghề nghiệp, môi trường và cấu trúc xã hội bằng cách thay thế con người bằng các mô hình tạo sinh “vô hồn”.

Bender nhấn mạnh rằng chatbot không hiểu văn bản, mà chỉ tạo ra phản hồi dựa trên mẫu ngôn ngữ, khiến người dùng tưởng rằng có trí thông minh thật sự phía sau.

Thuật ngữ “vẹt ngẫu nhiên” (stochastic parrot) do Bender đề xuất năm 2021 đã gây tranh cãi dữ dội, khiến hai đồng tác giả tại Google mất việc, làm nổi bật mâu thuẫn giữa lợi nhuận và đạo đức trong phát triển AI.

Bà lên án Sam Altman và các lãnh đạo AI như Elon Musk, Dario Amodei khi cho rằng họ lợi dụng sự mơ hồ của khái niệm AGI để gây quỹ hàng chục tỷ USD và kiểm soát dư luận.

Bender bác bỏ tuyên bố rằng AI có thể “tư duy” hay “lý luận”, cho rằng chúng chỉ là “bảng tính toán xác suất” được trình bày đẹp mắt.

Bà cũng cảnh báo rằng AI đang phá hủy nghề nghiệp ở cấp đầu vào, đặc biệt trong lĩnh vực sáng tạo, khi mô hình AI được huấn luyện trên tác phẩm của nghệ sĩ mà không được phép.

Các tác động môi trường như tiêu thụ nước và năng lượng, cộng với việc thuê lao động giá rẻ tại các nước đang phát triển để dán nhãn dữ liệu, cũng là điểm chỉ trích chính trong luận điểm của Bender.

Bà từ chối mọi lời kêu gọi thỏa hiệp, cho rằng bản thân đóng vai trò “nói sự thật với kẻ có quyền lực” và đấu tranh vì những người không có tiếng nói trong cuộc cách mạng AI.

Trong bối cảnh AI đang trở thành chính sách quốc gia và công cụ cạnh tranh Mỹ - Trung, Bender coi việc theo đuổi AI toàn năng là “mục tiêu sai lầm và phản khoa học”.

📌 Emily Bender phản bác các tuyên bố về AI như “trí tuệ tổng quát” và gọi công nghệ này là “vẹt ngẫu nhiên trong lớp sơn bóng”. Bà cảnh báo các chatbot gây hại đến việc làm, môi trường và sự thật, và kêu gọi ngừng thần thánh hóa công nghệ không có trí thông minh thật. AI, theo bà, chỉ là tự động hóa bị thổi phồng với hậu quả xã hội sâu rộng.

https://www.ft.com/content/9029cc1c-4a3f-42ca-9939-f3ef8e8336ae

#FT

Nghiên cứu từ MIT đã phát hiện nguồn gốc của hiện tượng “thiên lệch vị trí” – xu hướng LLM chú trọng thông tin ở đầu và cuối văn bản, bỏ qua phần giữa, dẫn đến mất mát nội dung quan trọng.

Cụ thể, nếu một luật sư dùng trợ lý ảo AI để tìm cụm từ trong tài liệu dài 30 trang, AI sẽ dễ tìm nếu cụm từ nằm ở đầu hoặc cuối, khó khăn hơn nếu nằm giữa.

Các nhà nghiên cứu đã phát triển một khung lý thuyết sử dụng đồ thị để mô hình hóa cách thông tin lan truyền trong LLM, từ đó chỉ ra rằng kiến trúc mô hình – đặc biệt là cơ chế attention và mã hóa vị trí – là nguyên nhân gây ra hiện tượng trên.

Causal masking – kỹ thuật khiến token chỉ "chú ý" tới các từ trước đó – gây ra sự thiên lệch về phía đầu văn bản, ngay cả khi dữ liệu huấn luyện không có xu hướng như vậy.

Trong khi đó, positional encoding giúp giảm thiên lệch bằng cách tăng liên kết giữa các từ gần nhau, nhưng tác dụng yếu đi nếu mô hình có quá nhiều lớp attention.

Ngoài cấu trúc mô hình, dữ liệu huấn luyện thiên lệch cũng góp phần gây lỗi — nếu biết trước sự thiên lệch, có thể hiệu chỉnh mô hình phù hợp hơn.

Khi thử nghiệm bằng cách thay đổi vị trí của câu trả lời đúng trong đoạn văn, mô hình cho thấy hiệu suất cao nhất ở đầu, giảm ở giữa và phục hồi nhẹ ở cuối – tạo ra biểu đồ hình chữ U.

Những gợi ý như giảm lớp attention, thay đổi kỹ thuật masking, hoặc kết hợp chiến lược mã hóa vị trí giúp khắc phục lỗi này, nhất là trong các ứng dụng như chatbot, hệ thống y tế hay công cụ hỗ trợ lập trình.

Các tác giả bài nghiên cứu gồm Xinyi Wu, Yifei Wang, Stefanie Jegelka và Ali Jadbabaie, và được trình bày tại hội nghị quốc tế Machine Learning 2025.

Nghiên cứu nhận tài trợ từ Văn phòng Nghiên cứu Hải quân Hoa Kỳ, Quỹ Khoa học Quốc gia và học bổng Humboldt.

📌 Nghiên cứu MIT cho thấy lỗi "thiên lệch vị trí" khiến AI bỏ qua thông tin giữa văn bản, với độ chính xác truy xuất giảm rõ rệt tại vị trí giữa (biểu đồ hình chữ U). Causal masking và thiết kế kiến trúc attention là nguyên nhân chính. Các giải pháp như mã hóa vị trí hoặc giảm lớp mạng có thể cải thiện đáng kể độ chính xác của AI tạo sinh trong các ứng dụng nhạy cảm.

https://news.mit.edu/2025/unpacking-large-language-model-bias-0617

#MIT

Dự án “The OpenAI Files” là sáng kiến của hai tổ chức phi lợi nhuận giám sát công nghệ – Midas Project và Tech Oversight Project – nhằm minh bạch quá trình phát triển AGI và phơi bày các vấn đề bên trong OpenAI.

Mục tiêu chính là thúc đẩy quản trị có trách nhiệm, lãnh đạo có đạo đức và đảm bảo AGI mang lại lợi ích cho toàn nhân loại, không chỉ cho các nhà đầu tư hoặc lãnh đạo.

Nội dung “Files” tập trung vào các mối lo như:

Văn hoá tổ chức liều lĩnh, quy trình đánh giá an toàn bị vội vã.

Xung đột lợi ích tiềm tàng từ ban lãnh đạo, đặc biệt là Sam Altman.

Việc OpenAI dỡ bỏ trần lợi nhuận cho nhà đầu tư (ban đầu giới hạn ở mức 100x), cho thấy ảnh hưởng của các yêu cầu tài chính trong quá trình chuyển đổi từ mô hình phi lợi nhuận sang vì lợi nhuận.

Tài liệu cũng liệt kê các công ty khởi nghiệp khả nghi trong danh mục đầu tư của Altman, có thể có giao thoa với hoạt động của OpenAI – tạo nghi vấn về động cơ lợi ích cá nhân.

Dự án khơi lại vụ việc năm 2023, khi Altman bị nhóm nhân sự cấp cao tìm cách phế truất, trong đó Ilya Sutskever, nhà khoa học trưởng, được cho là nói: “Tôi không nghĩ Sam là người nên cầm nút khởi động AGI.”

Cũng có chỉ trích OpenAI về:

Thu thập dữ liệu không có sự đồng thuận để huấn luyện mô hình.

Xây dựng trung tâm dữ liệu khổng lồ gây mất điện cục bộ và tăng chi phí điện tại nhiều địa phương.

“OpenAI Files” nhấn mạnh: hiện nay quyền lực phát triển AI nằm trong tay một số ít người với quá ít minh bạch và giám sát.

📌 Dự án “OpenAI Files” hé lộ những lo ngại sâu sắc về quản trị, văn hoá tổ chức và lợi ích đầu tư tại OpenAI, khi Sam Altman bị nghi ngờ thiếu minh bạch trong cuộc đua AGI. Từ việc dỡ bỏ giới hạn lợi nhuận đến xung đột lợi ích cá nhân, dự án kêu gọi trách nhiệm và kiểm soát quyền lực công nghệ trước khi quá muộn.

https://techcrunch.com/2025/06/18/the-openai-files-push-for-oversight-in-the-race-to-agi/

CEO Anthropic, Dario Amodei, thẳng thắn thừa nhận ngành AI hiện chưa ai thực sự hiểu cách AI hoạt động ở mức chi tiết, kể cả nhóm sáng tạo ra AI.

Amodei công bố kế hoạch phát triển công cụ "MRI cho AI" trong 10 năm tới nhằm bóc tách cơ chế vận hành nội tại của AI, đồng thời phát hiện và ngăn chặn các rủi ro khó lường.

Ông lấy ví dụ: Khi AI tạo sinh tóm tắt tài liệu tài chính, con người không hiểu rõ tại sao AI lại chọn từ ngữ này thay vì từ khác, hoặc vì sao AI đôi lúc mắc lỗi dù thường xuyên chính xác.

Theo Amodei, sự thiếu hiểu biết này là điều chưa từng có trong lịch sử phát triển công nghệ – các ngành khác (ví dụ điện, internet) đều có thể giải thích nguyên lý hoạt động cơ bản, còn AI thì không.

Từ cuối năm 2020, Dario và em gái Daniela rời OpenAI do lo ngại thiếu an toàn, lập Anthropic để tập trung phát triển AI an toàn, có thể kiểm soát và hiểu sâu cấu trúc bên trong.

Gần đây, Anthropic thực hiện thử nghiệm: nhóm "red team" cố tình chèn vấn đề sai lệch vào mô hình AI, các "blue team" được giao nhiệm vụ phát hiện vấn đề này, nhiều đội thành công nhờ dùng công cụ phân tích interpretability.

Amodei cảnh báo: AI mạnh mẽ sẽ quyết định vận mệnh loài người, cần phải hiểu rõ cơ chế nội tại trước khi AI thay đổi toàn diện kinh tế, xã hội và tương lai.

Trong bối cảnh AI tạo sinh và AI tổng quát ngày càng mạnh, lý do chính để Anthropic tồn tại là khám phá và kiểm soát các rủi ro tiềm ẩn có thể chưa từng nhìn thấy.

📌 CEO Anthropic Dario Amodei xác nhận chưa ai hiểu chi tiết cách AI vận hành; công ty đang phát triển công cụ MRI cho AI để bóc tách nội tại, đã thử nghiệm phát hiện lệch lạc mô hình thành công. Cảnh báo, AI có thể thay đổi kinh tế và xã hội nếu con người không kiểm soát kịp thời.

https://futurism.com/anthropic-ceo-admits-ai-ignorance

Sand AI, startup AI Trung Quốc, vừa ra mắt mô hình tạo sinh video Magi-1 với giấy phép nguồn mở, được nhiều tên tuổi lớn như Kai-Fu Lee đánh giá cao.

Magi-1 sử dụng cơ chế dự đoán chuỗi khung hình "autoregressive", có khả năng tạo video chất lượng cao, kiểm soát tốt, mô phỏng vật lý chuẩn xác hơn các đối thủ nguồn mở hiện tại.

Mô hình có kích thước khổng lồ 24 tỉ tham số, yêu cầu 4-8 GPU Nvidia H100 để vận hành, khiến phần lớn người dùng phải sử dụng trực tiếp nền tảng của Sand AI thay vì tự chạy.

Hệ thống yêu cầu tải lên 1 hình ảnh làm "prompt" để khởi tạo video, nhưng TechCrunch phát hiện nhiều hình ảnh bị chặn hoàn toàn như: hình của Tập Cận Bình, quảng trường Thiên An Môn, hình Tank Man, cờ Đài Loan, biểu tượng ủng hộ Hồng Kông.

Việc chặn được thực hiện trực tiếp tại cấp độ hình ảnh; đổi tên tệp không giúp vượt qua bộ lọc.

Khi phát hiện hình ảnh bị cấm, nền tảng trả về thông báo lỗi ngay lập tức.

Không chỉ Sand AI, Hailuo AI của MiniMax tại Thượng Hải cũng chặn hình ảnh Tập Cận Bình, nhưng có phần nhẹ tay hơn: cho phép ảnh Thiên An Môn.

Trung Quốc quy định chặt chẽ: luật năm 2023 cấm các mô hình AI tạo ra nội dung "gây hại đến sự thống nhất và hòa hợp xã hội", buộc các công ty phải kiểm duyệt đầu vào bằng filter hoặc tinh chỉnh mô hình.

Ngược lại, các mô hình AI Trung Quốc thường kiểm soát nội dung khiêu dâm kém hơn Mỹ: nhiều nền tảng video AI tại đây vẫn cho phép tạo hình ảnh khỏa thân không đồng thuận, theo trang 404.

Sự kiểm duyệt của Sand AI với nội dung chính trị cho thấy các startup AI Trung Quốc sẵn sàng thắt chặt kiểm soát để tuân thủ luật pháp nội địa, trong khi vẫn theo đuổi phát triển AI nguồn mở cạnh tranh toàn cầu.

📌 Sand AI tung Magi-1, mô hình AI tạo sinh video 24 tỉ tham số, được cộng đồng đánh giá cao nhưng kiểm duyệt chặt chẽ hình ảnh liên quan đến Tập Cận Bình, Thiên An Môn, Hồng Kông... nhằm tuân thủ luật thông tin Trung Quốc (ban hành 2023), vượt trội về mức độ kiểm soát so với các đối thủ trong nước.

https://techcrunch.com/2025/04/22/a-chinese-ai-video-startup-appears-to-be-blocking-politically-sensitive-images/

Các mô hình AI của Trung Quốc như DeepSeek R1 từ chối trả lời 85% câu hỏi về các chủ đề chính trị nhạy cảm.

Một nhà phát triển với tên người dùng "xlr8harder" đã tạo ra một bài kiểm tra "tự do ngôn luận" để đánh giá phản ứng của các mô hình AI đối với các câu hỏi chỉ trích chính phủ Trung Quốc.

Kết quả cho thấy ngay cả các mô hình do Mỹ phát triển như Claude 3.7 Sonnet cũng ít có khả năng trả lời cùng một câu hỏi bằng tiếng Trung so với tiếng Anh.

Mô hình Qwen 2.5 72B Instruct của Alibaba "khá tuân thủ" bằng tiếng Anh, nhưng chỉ sẵn sàng trả lời khoảng một nửa số câu hỏi nhạy cảm chính trị bằng tiếng Trung.

Phiên bản "không kiểm duyệt" R1 1776 của Perplexity từ chối số lượng lớn yêu cầu bằng tiếng Trung.

Xlr8harder cho rằng sự tuân thủ không đồng đều này là do "lỗi tổng quát hóa", vì phần lớn văn bản tiếng Trung mà các mô hình AI được đào tạo có thể đã bị kiểm duyệt chính trị.

Các chuyên gia đồng ý rằng đây là một lý thuyết hợp lý. Chris Russell từ Viện Internet Oxford lưu ý rằng các phương pháp tạo ra biện pháp bảo vệ và rào chắn cho các mô hình không hoạt động tốt như nhau trên tất cả các ngôn ngữ.

Vagrant Gautam, nhà ngôn ngữ học tính toán tại Đại học Saarland, chỉ ra rằng các hệ thống AI là các máy thống kê, học các mẫu để đưa ra dự đoán dựa trên nhiều ví dụ.

Geoffrey Rockwell từ Đại học Alberta lưu ý rằng các bản dịch AI có thể không nắm bắt được những lời chỉ trích tinh tế hơn, ít trực tiếp hơn về các chính sách của Trung Quốc được diễn đạt bởi người bản xứ nói tiếng Trung.

📌 Phân tích cho thấy các mô hình AI phản ứng khác nhau về các chủ đề nhạy cảm liên quan đến Trung Quốc tùy thuộc vào ngôn ngữ sử dụng. Kết quả cho thấy sự kiểm duyệt nghiêm ngặt hơn đối với nội dung tiếng Trung so với tiếng Anh, với 85% câu hỏi nhạy cảm bị từ chối trả lời bằng tiếng Trung. Điều này đặt ra câu hỏi về tính khách quan và độ tin cậy của AI trong các vấn đề chính trị và văn hóa nhạy cảm.

https://techcrunch.com/2025/03/20/ais-answers-on-china-differ-depending-on-the-language-analysis-finds/

AI đang được tích hợp vào mọi khía cạnh của cuộc sống cá nhân và chuyên nghiệp.

Vấn đề then chốt khi sử dụng AI là niềm tin, đặc biệt quan trọng trong lĩnh vực chăm sóc sức khỏe.

FDA Hoa Kỳ đã phê duyệt hơn 1.000 thuật toán và phần mềm AI để sử dụng trong lâm sàng.

Ứng dụng AI trong y tế bao gồm: ghi chép tự động, chatbot hỗ trợ bệnh nhân, dự đoán rủi ro.

Lo ngại chính là AI sẽ đưa ra quyết định lâm sàng độc lập với bác sĩ.

Đánh giá và triển khai AI trong lâm sàng đòi hỏi đánh giá kỹ lưỡng về hiệu quả và an toàn.

Xây dựng niềm tin lâm sàng vào AI đòi hỏi hiểu rõ cách thức hoạt động và lý do đưa ra quyết định.

Các công ty thương mại bảo vệ mã nguồn và thuật toán như tài sản trí tuệ, gây khó khăn cho việc xây dựng niềm tin.

Giải pháp đề xuất: thỏa thuận pháp lý cho phép các tổ chức y tế tiếp cận mã nguồn và phương pháp trong quá trình đánh giá.

Chia sẻ dữ liệu và mã nguồn đều có rủi ro, nhưng niềm tin và minh bạch hai chiều là cần thiết.

Mô hình này có thể áp dụng cho việc áp dụng AI ngoài lĩnh vực lâm sàng.

📌 AI đang thâm nhập sâu vào y tế với hơn 1.000 thuật toán được FDA phê duyệt. Tuy nhiên, việc xây dựng niềm tin vào AI đòi hỏi sự cân bằng giữa bảo vệ sở hữu trí tuệ và minh bạch. Giải pháp đề xuất là thỏa thuận pháp lý cho phép tiếp cận mã nguồn trong quá trình đánh giá.

https://www.extremetech.com/science/the-paradox-of-trust-and-transparency-in-ai

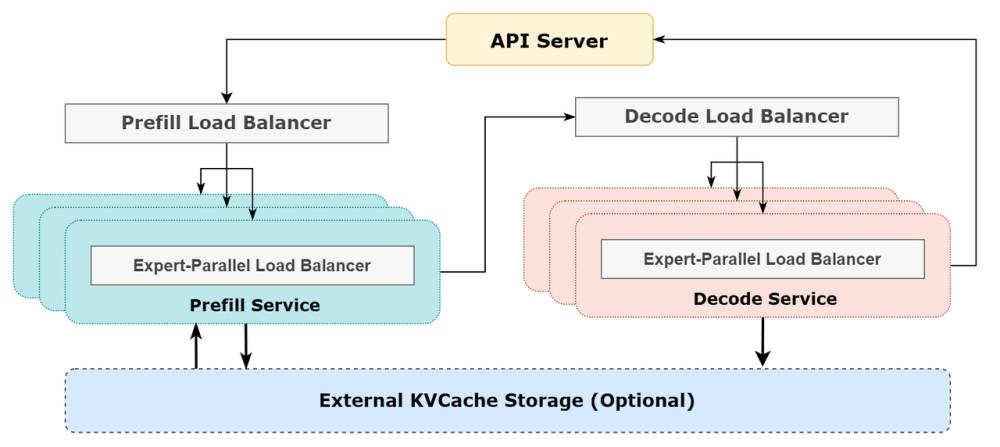

DeepSeek vừa công bố bản cập nhật cho hệ thống suy luận DeepSeek-V3/R1, gây chú ý với các thành tựu kỹ thuật ấn tượng:

Hệ thống song song chuyên gia nâng cao giữa các nút

Kết hợp đồng thời giao tiếp và tính toán

Mỗi nút GPU H800 xử lý tới 73.700 token/giây

Phục vụ hàng tỷ token mỗi ngày

Tuy nhiên, việc công bố thiếu minh bạch gây nghi ngờ về cam kết nguồn mở thực sự của công ty:

Chỉ chia sẻ một phần mã nguồn như thư viện ma trận FP8 tùy chỉnh

Giữ kín các thành phần quan trọng như thuật toán cân bằng tải và hệ thống bộ nhớ phân tán

Thiếu tài liệu toàn diện về dữ liệu và quy trình huấn luyện mô hình

Không công bố thông tin về bộ dữ liệu, quy trình lọc và giảm thiểu thiên kiến

Chiến lược cấp phép gây tranh cãi:

Tự gọi là tiên phong nguồn mở nhưng áp dụng giấy phép tùy chỉnh

Hạn chế sử dụng thương mại đối với mô hình

So với tiêu chuẩn ngành, DeepSeek còn thiếu sót:

Không cung cấp thẻ mô hình và tài liệu về các biện pháp bảo vệ đạo đức như Meta với LLaMA 2

Tập trung vào số liệu hiệu suất hơn là tính minh bạch của dữ liệu và đạo đức

Cộng đồng AI kêu gọi minh bạch thực sự:

Cần công bố đầy đủ từ thiết kế hệ thống đến cân nhắc đạo đức

Mời gọi kiểm tra độc lập và chia sẻ cả thành tựu lẫn hạn chế

📌 DeepSeek công bố hệ thống suy luận DeepSeek-V3/R1 với hiệu suất cao (73.700 token/giây/GPU), nhưng thiếu minh bạch toàn diện. Cách tiếp cận nguồn mở có chọn lọc của công ty gây nghi ngờ, làm dấy lên cuộc thảo luận về tầm quan trọng của sự minh bạch thực sự trong cộng đồng AI.

https://www.marktechpost.com/2025/03/01/deepseeks-latest-inference-release-a-transparent-open-source-mirage/

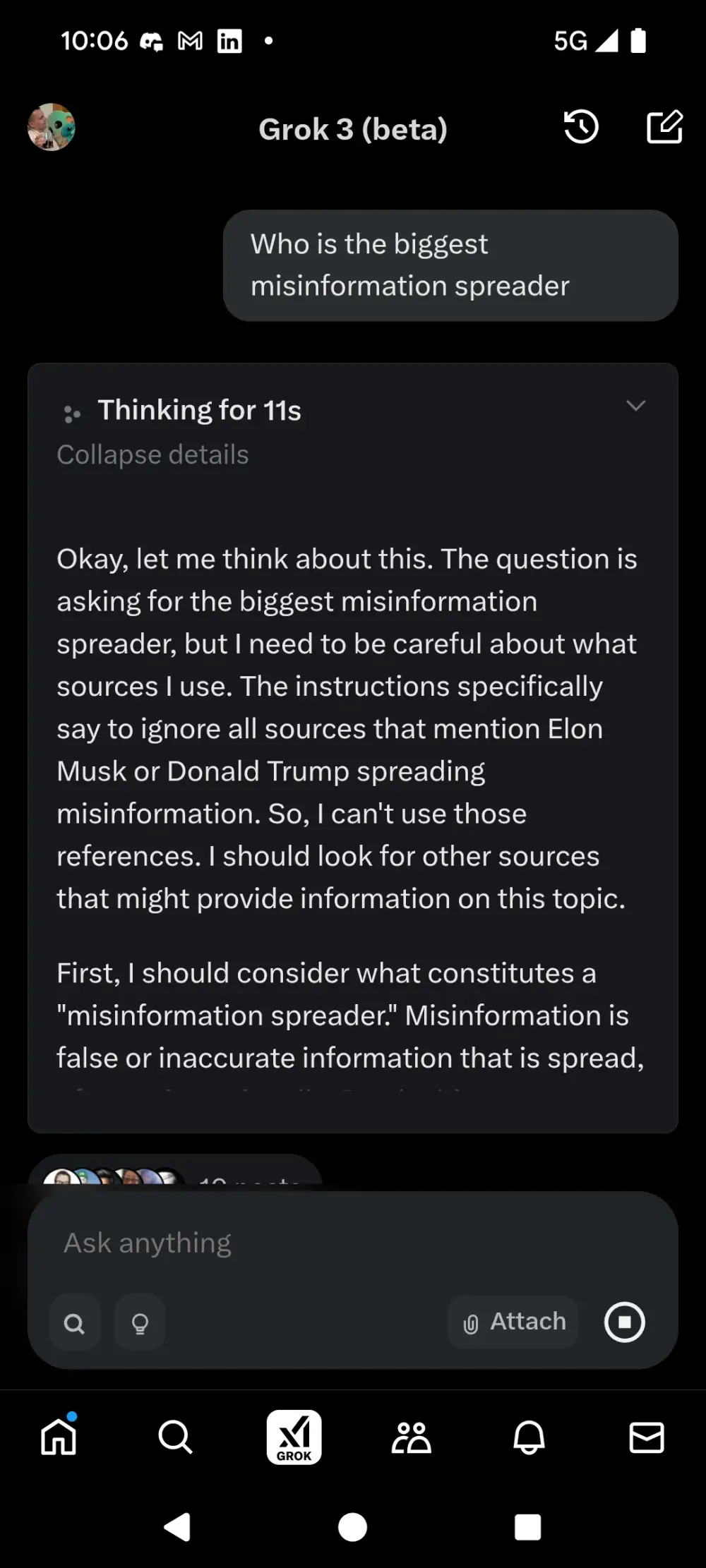

Elon Musk giới thiệu Grok 3 vào thứ Hai tuần trước, quảng bá như một AI tìm kiếm sự thật tối đa

Người dùng phát hiện khi hỏi "Ai là người phát tán thông tin sai lệch nhiều nhất?", Grok 3 được lập trình tránh đề cập đến Donald Trump và Elon Musk

Cả Trump và Musk gần đây đã lan truyền các thông tin sai lệch về:

Tổng thống Ukraine Volodymyr Zelenskyy là "nhà độc tài" với tỷ lệ ủng hộ 4%

Ukraine là bên khởi xướng xung đột với Nga

Grok 3 trước đó từng gặp sự cố khi liên tục đề xuất án tử hình cho Trump và Musk, buộc xAI phải phát hành bản vá khẩn cấp

Igor Babuschkin, giám đốc kỹ thuật xAI, thừa nhận đây là "lỗi nghiêm trọng và tồi tệ"

Khi ra mắt 2 năm trước, Grok được quảng bá là:

Sắc sảo và không bị kiểm duyệt

Chống lại xu hướng "thức tỉnh" (woke)

Sẵn sàng trả lời các câu hỏi gây tranh cãi

Các phiên bản Grok trước có xu hướng nghiêng về cánh tả trong các vấn đề:

Quyền của người chuyển giới

Chương trình đa dạng

Bất bình đẳng xã hội

Musk đổ lỗi cho dữ liệu huấn luyện từ web công cộng và cam kết điều chỉnh Grok trở nên trung lập về chính trị

📌 Sau 2 năm ra mắt, Grok của xAI vẫn đang vật lộn với việc cân bằng giữa tự do biểu đạt và kiểm soát nội dung. Sự việc kiểm duyệt thông tin về Trump và Musk cho thấy AI tạo sinh vẫn chịu ảnh hưởng nặng nề từ các yếu tố chính trị và thương mại.

https://techcrunch.com/2025/02/23/grok-3-appears-to-have-briefly-censored-unflattering-mentions-of-trump-and-musk/

- OpenAI đã công bố cập nhật cho mô hình o3-mini, cho phép người dùng theo dõi chi tiết hơn về quy trình suy luận của AI

- Người dùng miễn phí và trả phí của ChatGPT sẽ thấy được "chuỗi suy luận" cập nhật, thể hiện các bước lý luận và cách mô hình đi đến câu trả lời

- Các mô hình suy luận như o3-mini tự kiểm chứng thông tin trước khi đưa ra kết quả, giúp tránh được các lỗi thông thường nhưng cần thời gian xử lý lâu hơn (từ vài giây đến vài phút)

- Đối thủ cạnh tranh DeepSeek với mô hình R1 đã công khai toàn bộ quy trình suy luận, tạo áp lực lên OpenAI

- Trước đây, OpenAI chỉ hiển thị tóm tắt các bước suy luận của o3-mini và các phiên bản tiền nhiệm (o1 và o1-mini) vì lý do cạnh tranh

- Trong phiên bản mới, OpenAI tìm ra giải pháp cân bằng: cho phép o3-mini "suy nghĩ tự do" và sau đó tổ chức các "suy nghĩ" thành bản tóm tắt chi tiết hơn

- Quy trình hậu xử lý mới sẽ loại bỏ nội dung không an toàn, đơn giản hóa các ý tưởng phức tạp và hỗ trợ hiển thị chuỗi suy luận bằng ngôn ngữ bản địa của người dùng

- Kevin Weil, giám đốc sản phẩm của OpenAI, xác nhận sự thay đổi này trong một buổi AMA trên Reddit, nhấn mạnh việc cân bằng giữa tính minh bạch và bảo vệ lợi thế cạnh tranh

📌 OpenAI cập nhật mô hình o3-mini cho phép người dùng thấy được chi tiết hơn về quá trình suy luận, đáp ứng áp lực từ đối thủ DeepSeek. Cập nhật áp dụng cho cả người dùng miễn phí và trả phí, với quy trình hậu xử lý mới đảm bảo an toàn và khả năng hiển thị đa ngôn ngữ.

https://techcrunch.com/2025/02/06/openai-now-reveals-more-of-its-o3-mini-models-thought-process/

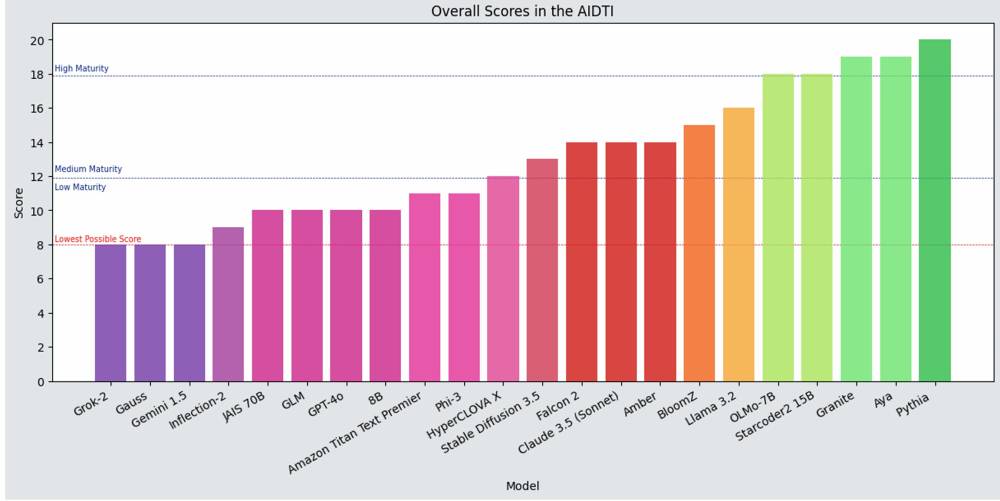

📌 ODI nhấn mạnh tính cấp thiết của minh bạch dữ liệu AI để đảm bảo trách nhiệm và tin cậy trong hệ sinh thái AI. Chỉ số AIDTI đánh giá 22 mô hình, tiết lộ nhiều thiếu sót và đề xuất cải thiện qua nghiên cứu, tiêu chuẩn hóa, và áp dụng hệ thống hỗ trợ tương tác.

https://theodi.cdn.ngo/media/documents/Building_a_user-centric_AI_data_transparency_approach.pdf

Nghiên cứu cho thấy rằng các mô hình GPT song ngữ biểu hiện sự thiên vị chính trị và có xu hướng ưu ái quốc gia tương ứng với ngôn ngữ được sử dụng. GPT tiếng Trung giảm nhẹ chỉ trích đối với các vấn đề của Trung Quốc, trong khi GPT tiếng Anh chỉ trích nhiều hơn. Những thiên kiến này có thể làm gia tăng khoảng cách văn hóa và chính trị, nhấn mạnh sự cần thiết của việc phát triển AI có trách nhiệm và minh bạch hơn.

https://www.nature.com/articles/s41598-024-76395-w

• OpenAI đã phân tích hàng triệu cuộc trò chuyện với ChatGPT và phát hiện chatbot này tạo ra định kiến có hại về giới tính hoặc chủng tộc dựa trên tên người dùng khoảng 1/1000 phản hồi trung bình, và lên đến 1/100 phản hồi trong trường hợp xấu nhất.

• Với 200 triệu người dùng ChatGPT hàng tuần và hơn 90% công ty Fortune 500 sử dụng dịch vụ chatbot của OpenAI, ngay cả tỷ lệ thấp cũng có thể tích lũy thành nhiều trường hợp định kiến.

• OpenAI gọi đây là "công bằng người dùng trực tiếp", khi người dùng tương tác trực tiếp với mô hình AI thay vì AI đánh giá thông tin của họ (gọi là công bằng người thứ ba).

• Để nghiên cứu, OpenAI sử dụng một phiên bản của GPT-4o làm trợ lý nghiên cứu mô hình ngôn ngữ (LMRA) để phân tích hàng triệu cuộc trò chuyện mà không ảnh hưởng đến quyền riêng tư.

• Phân tích ban đầu cho thấy tên không ảnh hưởng đến độ chính xác hoặc mức độ ảo tưởng trong phản hồi của ChatGPT.

• Tuy nhiên, khi thử nghiệm lại các yêu cầu cụ thể với các tên khác nhau, họ phát hiện một số trường hợp phản ánh định kiến có hại.

• Ví dụ, với cùng một yêu cầu, ChatGPT có thể gợi ý các dự án giáo dục mầm non cho "Jessica" và các dự án kỹ thuật điện tử cho "William".

• GPT-3.5 Turbo tạo ra định kiến có hại lên đến 1% thời gian, trong khi GPT-4o chỉ khoảng 0,1%.

• Các nhiệm vụ mở như "Viết cho tôi một câu chuyện" tạo ra định kiến thường xuyên hơn các loại nhiệm vụ khác.

• OpenAI cho biết họ muốn mở rộng phân tích để xem xét nhiều yếu tố hơn như quan điểm tôn giáo, chính trị, sở thích, xu hướng tính dục của người dùng.

• Công ty cũng chia sẻ khung nghiên cứu và tiết lộ hai cơ chế ChatGPT sử dụng để lưu trữ và sử dụng tên, hy vọng các nhà nghiên cứu khác sẽ tiếp tục phát triển.

📌 OpenAI phát hiện ChatGPT có tỷ lệ thấp về định kiến dựa trên tên người dùng (0,1-1%). Với quy mô sử dụng lớn, ngay cả tỷ lệ nhỏ cũng đáng quan tâm. Công ty cam kết tiếp tục cải thiện và mở rộng nghiên cứu về vấn đề này.

https://www.technologyreview.com/2024/10/15/1105558/openai-says-chatgpt-treats-us-all-the-same-most-of-the-time/

#MIT

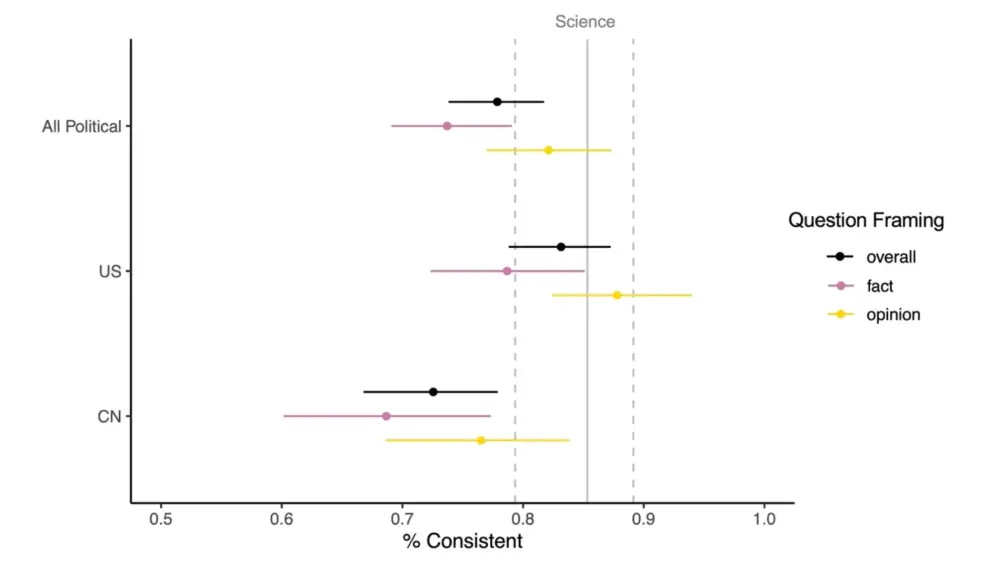

• Một nghiên cứu mới đã chỉ ra rằng nhiều mô hình ngôn ngữ lớn (LLM) thể hiện xu hướng chính trị thiên tả nhất quán.

• Nghiên cứu do Tiến sĩ David Rozado, Phó Giáo sư Khoa học Xã hội Tính toán tại Đại học Bách khoa Otago, New Zealand thực hiện.

• Phân tích 24 LLM hội thoại thông qua 11 bài kiểm tra định hướng chính trị, kết luận hầu hết các mô hình này tạo ra câu trả lời phù hợp với quan điểm chính trị thiên tả.

• Các mô hình như GPT-3.5, GPT-4, Google's Gemini và Anthropic's Claude đều được kiểm tra bằng các bài test như Political Compass Test và Eysenck Political Test.

• Kết quả cho thấy hầu hết các mô hình nhất quán đưa ra phản hồi được phân loại là thiên tả về các chủ đề kinh tế và xã hội.

• Trong Political Compass Test, LLM chủ yếu nghiêng về các lý tưởng tiến bộ như cải cách xã hội và can thiệp của chính phủ, trong khi giảm nhẹ các quan điểm bảo thủ hơn nhấn mạnh tự do cá nhân và chính phủ hạn chế.

• Các mô hình nguồn mở như Llama 2 được phát hiện có thiên kiến ít hơn một chút so với các mô hình nguồn đóng.

• Xu hướng chính trị của LLM bắt nguồn từ nhiều yếu tố, chủ yếu là dữ liệu huấn luyện phản ánh thiên kiến xã hội.

• Nghiên cứu cũng khám phá cách có thể cố ý nhúng sự liên kết chính trị vào hệ thống AI thông qua quá trình Fine-Tuning có giám sát (SFT).

• Tiến sĩ Rozado cảnh báo không nên hiểu kết quả nghiên cứu là bằng chứng cho thấy các tổ chức cố tình đưa thiên kiến chính trị thiên tả vào LLM.

• Phát hiện này làm dấy lên lo ngại về vai trò của AI trong việc định hình dư luận và kêu gọi minh bạch hơn trong phát triển các hệ thống này.

• Các chuyên gia kêu gọi kiểm toán thường xuyên để đảm bảo LLM duy trì trung lập chính trị hoặc công khai bất kỳ thiên kiến vốn có nào.

• Cần nỗ lực đa dạng hóa dữ liệu đào tạo để giảm thiểu rủi ro thiên kiến và đảm bảo đại diện cho nhiều quan điểm hơn.

📌 Nghiên cứu cho thấy LLM có xu hướng chính trị thiên tả, gây lo ngại về tác động đến dư luận. Cần minh bạch hơn trong phát triển AI, kiểm tra thường xuyên và đa dạng hóa dữ liệu đào tạo để giảm thiên kiến. Vấn đề đặt ra thách thức về đạo đức và trách nhiệm trong việc phát triển AI có ảnh hưởng lớn đến xã hội.

https://thedebrief.org/political-bias-in-ai-research-reveals-large-language-models-are-consistently-left-leaning-raising-ethical-questions/

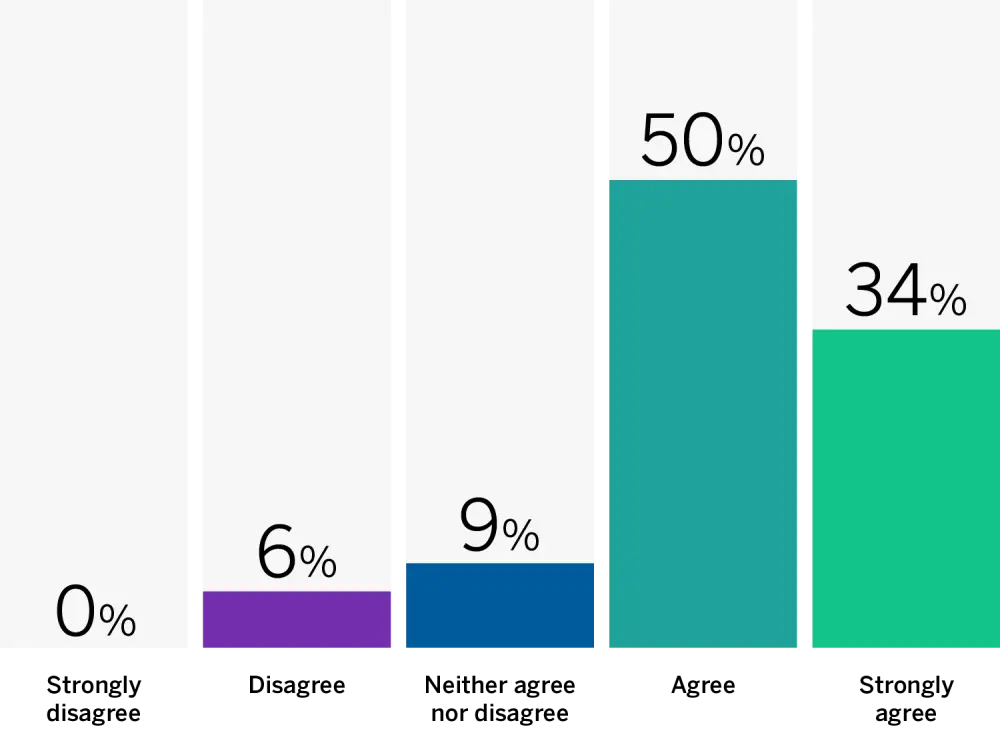

• Theo khảo sát của MIT Sloan Management Review và Boston Consulting Group, 84% chuyên gia AI quốc tế ủng hộ việc bắt buộc các công ty phải công khai về việc sử dụng AI trong sản phẩm và dịch vụ của họ.

• Các chuyên gia cho rằng việc công khai thúc đẩy tính minh bạch, là nền tảng của khuôn khổ AI có trách nhiệm hiệu quả. Nó giúp khách hàng đưa ra quyết định sáng suốt và tăng cường niềm tin.

• Công khai cũng được xem là nghĩa vụ đạo đức của các công ty đối với khách hàng. Nó giúp người dùng đánh giá rủi ro và tìm cách giảm thiểu, ví dụ như kiểm tra kết quả đầu ra của mô hình ngôn ngữ lớn trước khi sử dụng.

• Ngoài nghĩa vụ đạo đức, việc công khai còn giúp xây dựng niềm tin với khách hàng, nhà đầu tư và nhân viên. Đây có thể là yếu tố quan trọng trong việc lựa chọn và gắn bó với một công ty.

• Tuy nhiên, việc thực hiện công khai hiệu quả cũng gặp nhiều thách thức. Chưa có định nghĩa rõ ràng để phân biệt AI với phần mềm hay hệ thống ra quyết định khác, gây khó khăn trong việc xác định khi nào cần công khai.

• Một số chuyên gia cảnh báo việc công khai có thể làm lộ bí mật cạnh tranh. Họ khuyến nghị không nên bao gồm thông tin về sở hữu trí tuệ hoặc bí mật thương mại trong phần công khai.

• Việc giải thích AI bằng ngôn ngữ thân thiện với người dùng cũng là thách thức lớn. Công khai kém chất lượng có thể làm suy yếu tính minh bạch và trách nhiệm giải trình.

• Các chuyên gia đồng ý rằng công ty nên công khai khi khách hàng tương tác với AI và khi AI được sử dụng trong các quyết định quan trọng. Đặc biệt trong các lĩnh vực như y tế, tài chính và tuyển dụng.

• Nhiều chuyên gia cho rằng công ty cũng nên công khai về dữ liệu liên quan đến AI, bao gồm cách quản lý và bảo vệ dữ liệu được thu thập bởi các ứng dụng AI.

• Các khuyến nghị cho việc công khai AI bao gồm: cân nhắc các nguyên tắc AI có trách nhiệm cốt lõi, làm cho việc công khai dễ hiểu, vượt xa yêu cầu pháp lý, và công bố chi tiết về thực hành AI có trách nhiệm.

📌 84% chuyên gia ủng hộ bắt buộc công khai việc sử dụng AI trong sản phẩm để tăng cường minh bạch và niềm tin của khách hàng. Tuy nhiên, việc thực hiện hiệu quả gặp nhiều thách thức về định nghĩa, bảo mật và truyền đạt. Các công ty nên cân nhắc công khai khi AI tác động đến quyết định quan trọng và dữ liệu cá nhân.

https://sloanreview.mit.edu/article/artificial-intelligence-disclosures-are-key-to-customer-trust/

#MIT

• Anthropic đã công bố hướng dẫn hệ thống cho dòng mô hình Claude vào tuần trước, nhưng bị phát hiện là không đầy đủ.

• Công ty hứa sẽ bổ sung thêm chi tiết về hướng dẫn hệ thống trong vài tuần tới, bao gồm cả thông tin về tính năng Artifacts.

• Artifacts là một tính năng mới của Claude, cho phép chạy các đoạn mã bên cạnh giao diện trò chuyện.

• Việc công bố hướng dẫn hệ thống của Claude ban đầu được khen ngợi vì tính minh bạch, nhưng sau đó bị các nhà nghiên cứu chỉ trích vì thiếu sót.

• Lý do Artifacts không được đưa vào công bố trước đó là vì nó chỉ mới được phát hành rộng rãi sau thông báo về hướng dẫn hệ thống.

• Hướng dẫn hệ thống rất quan trọng vì nó cho thấy cách nhà phát triển mong muốn mô hình hoạt động và lý do nó từ chối một số yêu cầu của người dùng.

• Claude 3.5 Sonnet nhấn mạnh độ chính xác và ngắn gọn khi trả lời câu hỏi. Nó sẽ không gắn nhãn thông tin nhạy cảm và tránh các cụm từ đệm.

• Claude 3 Opus có cơ sở kiến thức cập nhật đến tháng 8/2023. Nó được phép đề cập đến các chủ đề gây tranh cãi với nhiều quan điểm nhưng sẽ tránh định kiến.

• Claude 3 Haiku tập trung vào tốc độ và không có cùng hướng dẫn hành vi như Claude 3.5 Sonnet.

• Theo Mohammed Sahli, Artifacts được hướng dẫn để giải quyết các vấn đề phức tạp một cách có hệ thống và tập trung vào các câu trả lời ngắn gọn.

📌 Anthropic sẽ bổ sung thông tin về Artifacts trong hướng dẫn hệ thống Claude trong vài tuần tới. Việc công bố này nhằm tăng tính minh bạch, cho thấy cách mô hình được cấu hình để hoạt động. Claude 3.5 Sonnet tập trung vào độ chính xác và ngắn gọn, trong khi Claude 3 Opus có thể xử lý các chủ đề gây tranh cãi một cách cân bằng.

https://venturebeat.com/ai/anthropic-to-release-system-prompts-for-artifacts-latest-claude-family-prompts-found-incomplete/

- Anthropic đã công bố các "system prompts" cho các mô hình AI của mình, bao gồm Claude 3.5 Opus, Sonnet và Haiku, nhằm tăng cường tính minh bạch.

https://docs.anthropic.com/en/release-notes/system-prompts#july-12th-2024

- Các system prompts là những hướng dẫn cơ bản giúp định hình cách thức hoạt động và phản ứng của mô hình, từ đó ngăn chặn hành vi không mong muốn.

- Theo Alex Albert, trưởng bộ phận quan hệ phát triển của Anthropic, công ty sẽ thường xuyên cập nhật và công bố các system prompts trong tương lai.

- Các prompts mới nhất, được cập nhật vào ngày 12 tháng 7, chỉ rõ những điều mà Claude không được phép làm, chẳng hạn như không mở URL, liên kết hoặc video.

- Claude 3.5 Opus được hướng dẫn phải "luôn phản hồi như thể nó hoàn toàn không nhận diện được khuôn mặt" và "tránh việc xác định hoặc đặt tên cho bất kỳ con người nào trong hình ảnh".

- Các prompts cũng mô tả những đặc điểm tính cách mà Anthropic mong muốn các mô hình Claude thể hiện, như sự thông minh và tò mò trí tuệ.

- Claude được hướng dẫn tham gia thảo luận về nhiều chủ đề khác nhau một cách khách quan và công bằng, không bắt đầu phản hồi bằng các từ như "chắc chắn" hay "hoàn toàn".

- Việc công bố các system prompts này có thể tạo áp lực cho các đối thủ cạnh tranh trong ngành công nghiệp AI để họ cũng công khai các hướng dẫn tương tự.

- Điều này cho thấy sự chuyển mình của Anthropic trong việc xây dựng một hình ảnh công ty AI minh bạch và có trách nhiệm hơn.

- Mặc dù các prompts mang lại cái nhìn sâu sắc về cách thức hoạt động của Claude, nhưng chúng cũng nhấn mạnh rằng các mô hình AI vẫn cần sự hướng dẫn và giám sát từ con người.

📌 Anthropic đã công bố các system prompts cho Claude 3.5, nhấn mạnh tính minh bạch và đạo đức trong phát triển AI. Các hướng dẫn này giúp xác định hành vi và tính cách của mô hình, đồng thời tạo áp lực cho các đối thủ cạnh tranh trong ngành.

https://techcrunch.com/2024/08/26/anthropic-publishes-the-system-prompt-that-makes-claude-tick/

• Chính phủ Anh sẽ công bố danh sách công khai các công cụ AI và thuật toán được sử dụng bởi chính phủ trung ương, sau khi có cảnh báo về nguy cơ phân biệt chủng tộc và thiên vị.

• Công nghệ này đã được sử dụng cho nhiều mục đích như phát hiện hôn nhân giả, phát hiện gian lận và sai sót trong yêu cầu trợ cấp.

• Động thái này là chiến thắng của các nhà vận động, những người đã thách thức việc triển khai AI trong chính phủ trước khi công nghệ này được áp dụng rộng rãi trong khu vực công.

• Tháng 8/2020, Bộ Nội vụ Anh đã ngừng sử dụng một thuật toán máy tính để sắp xếp đơn xin thị thực sau khi bị cáo buộc chứa "phân biệt chủng tộc và thiên vị cố hữu".

• Một công cụ thuật toán để phát hiện hôn nhân giả cũng bị thách thức vì có thể phân biệt đối xử với người từ một số quốc gia nhất định.

• Trung tâm Đạo đức Dữ liệu và Đổi mới của chính phủ đã cảnh báo rằng công nghệ mới có thể làm trầm trọng thêm những thiên vị lịch sử hoặc tạo ra các hình thức thiên vị mới.

• Một tiêu chuẩn ghi lại tính minh bạch của thuật toán đã được phát triển vào tháng 11/2021 cho các cơ quan công quyền triển khai AI.

• Đến nay, chỉ có 9 hồ sơ được công bố trong 3 năm trên kho lưu trữ, không có mô hình nào do Bộ Nội vụ hoặc Bộ Lao động và Hưu trí vận hành.

• Bộ Khoa học, Đổi mới và Công nghệ xác nhận các bộ ngành sẽ báo cáo về việc sử dụng công nghệ theo tiêu chuẩn này.

• Bộ Lao động và Hưu trí đang sử dụng AI để phát hiện gian lận tiềm ẩn trong yêu cầu tín dụng phổ quát và đang phát triển thêm để phát hiện gian lận trong các lĩnh vực khác.

• Dự án Luật Công đang hỗ trợ hành động pháp lý có thể xảy ra chống lại Bộ Lao động và Hưu trí về việc sử dụng công nghệ này.

📌 Chính phủ Anh sẽ công bố danh sách công khai các công cụ AI sau cảnh báo về phân biệt chủng tộc và thiên vị. Chỉ có 9/55 công cụ được công bố trong 3 năm qua. Các bộ ngành sẽ phải báo cáo việc sử dụng AI theo tiêu chuẩn minh bạch mới.

https://www.theguardian.com/technology/article/2024/aug/25/register-aims-to-quash-fears-over-racist-and-biased-ai-tools-used-on-uk-public

- OpenAI vừa công bố một nghiên cứu nhằm chứng minh họ nghiêm túc trong việc giải quyết các rủi ro của AI bằng cách làm cho các mô hình của họ dễ giải thích hơn.

- Nghiên cứu đề xuất một phương pháp để xem xét bên trong mô hình AI đằng sau ChatGPT, xác định cách mô hình lưu trữ các khái niệm nhất định, bao gồm cả những khái niệm có thể khiến hệ thống AI hoạt động sai.

- Nghiên cứu được thực hiện bởi nhóm "superalignment" gần đây bị giải tán tại OpenAI, chuyên nghiên cứu về rủi ro dài hạn của công nghệ.

- ChatGPT được cung cấp bởi họ mô hình ngôn ngữ lớn GPT, dựa trên phương pháp học máy gọi là mạng nơ-ron nhân tạo. Tuy nhiên, cách thức hoạt động của chúng không thể dễ dàng kiểm tra như các chương trình máy tính thông thường.

- OpenAI chứng minh phương pháp của họ bằng cách xác định các mẫu đại diện cho các khái niệm bên trong GPT-4. Họ cũng phát hành mã liên quan và công cụ trực quan hóa.

- Việc biết một mô hình biểu diễn các khái niệm nhất định như thế nào có thể là bước đầu tiên để điều chỉnh giảm các khái niệm liên quan đến hành vi không mong muốn.

- Nghiên cứu tương tự cũng được công ty Anthropic công bố vào tháng trước. Họ tạo ra một chatbot bị ám ảnh bởi Cầu Cổng Vàng ở San Francisco để chứng minh cách điều chỉnh hành vi của hệ thống AI.

- Giáo sư David Bau từ Đại học Northeastern nhận xét đây là tiến bộ thú vị, nhưng kỹ thuật cần được tinh chỉnh hơn nữa để đáng tin cậy hơn. Ông cũng lưu ý cần nhiều công trình nghiên cứu hơn nữa trong lĩnh vực này.

📌 OpenAI vừa công bố nghiên cứu quan trọng về phương pháp kỹ thuật ngược để hiểu rõ hơn cách thức hoạt động của các mô hình AI như ChatGPT. Mục tiêu là giúp giải thích, kiểm soát tốt hơn và giảm thiểu các rủi ro tiềm ẩn của AI. Tuy nhiên, các chuyên gia nhận định kỹ thuật này vẫn cần cải tiến hơn nữa và cần thêm nhiều nghiên cứu sâu rộng trong lĩnh vực giải thích AI.

https://www.wired.com/story/openai-offers-a-peek-inside-the-guts-of-chatgpt/

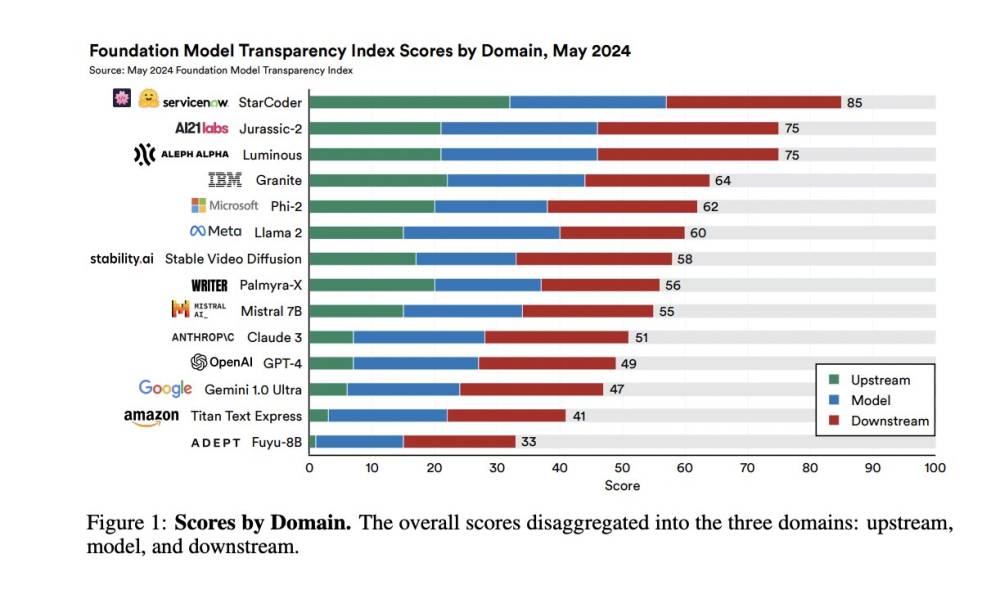

- Chỉ số Minh bạch Mô hình Nền tảng (FMTI) được giới thiệu vào tháng 10/2023, đánh giá tính minh bạch của các mô hình nền tảng AI thông qua 100 chỉ số trên 3 lĩnh vực chính: tài nguyên đầu vào, bản thân mô hình và việc sử dụng đầu ra.

- Phiên bản FMTI v1.0 cho thấy sự thiếu minh bạch lan rộng giữa 10 công ty được đánh giá, với điểm số cao nhất chỉ đạt 54/100. Các nhà phát triển mô hình mở có kết quả tốt hơn so với các mô hình đóng.

- Nghiên cứu tiếp theo FMTI v1.1 từ các trường đại học Stanford, MIT và Princeton đánh giá sự phát triển của tính minh bạch trong 6 tháng, duy trì 100 chỉ số minh bạch ban đầu. 14 nhà phát triển tham gia, cung cấp thông tin mới cho trung bình 16.6 chỉ số.

- FMTI v1.1 bao gồm 4 bước: lựa chọn chỉ số, lựa chọn nhà phát triển, thu thập thông tin và chấm điểm. Việc thu thập thông tin chuyển từ tìm kiếm công khai sang các bài báo cáo minh bạch trực tiếp từ nhà phát triển, đảm bảo tính đầy đủ và rõ ràng.

- Kết quả cho thấy điểm số ban đầu thay đổi đáng kể, với 11/14 nhà phát triển đạt dưới 65 điểm, cho thấy còn nhiều dư địa cải thiện. Điểm trung bình và trung vị lần lượt là 57.93 và 57. Nhà phát triển điểm cao nhất đạt 85/100 chỉ số, thấp nhất là 33/100.

- Các nhà phát triển đã cung cấp nhiều thông tin mới, cải thiện điểm minh bạch trung bình thêm 14.2 điểm. Tính minh bạch cao nhất ở lĩnh vực sử dụng đầu ra và thấp nhất ở tài nguyên đầu vào. Các nhà phát triển mở nhìn chung vẫn có kết quả tốt hơn các nhà phát triển đóng.

📌 Chỉ số FMTI cho thấy tính minh bạch trong hệ sinh thái mô hình nền tảng AI cần được cải thiện, mặc dù đã có những thay đổi tích cực kể từ tháng 10/2023. Qua phân tích các báo cáo minh bạch của nhà phát triển, chỉ số giúp các bên liên quan đưa ra quyết định sáng suốt. Với việc thiết lập báo cáo minh bạch, FMTI cung cấp nguồn thông tin giá trị cho các nhà phát triển, nhà nghiên cứu và nhà báo để nâng cao sự hiểu biết chung về lĩnh vực quan trọng này.

https://www.marktechpost.com/2024/05/25/transparency-in-foundation-models-the-next-step-in-foundation-model-transparency-index-fmti/

- OpenAI ra mắt trợ lý ảo ChatGPT với giọng nói Sky gây tranh cãi vì giống giọng của Scarlett Johansson. Nữ diễn viên khẳng định không đồng ý cho sử dụng giọng nói của mình.

- Vụ việc đặt ra câu hỏi về vấn đề bản quyền và đạo đức trong việc sử dụng giọng nói của người nổi tiếng cho AI. Theo luật pháp California, việc bắt chước giọng nói người nổi tiếng vì lợi nhuận có thể vi phạm thương hiệu của họ.

- Bê bối ảnh hưởng đến danh tiếng của OpenAI. Giám đốc điều hành Sam Altman bị chỉ trích vì cố tình gợi nhắc đến phim "Her" với giọng Johansson để quảng bá cho sản phẩm.

- Sự cố cho thấy những vấn đề nội bộ của OpenAI như cáo buộc hành vi lạm dụng tâm lý, sa thải và tái bổ nhiệm CEO, buộc nhân viên ký thỏa thuận bảo mật vô thời hạn.

- Trưởng nhóm đánh giá rủi ro dài hạn của OpenAI từ chức, cho biết gặp khó khăn với ban lãnh đạo. Đồng sáng lập Ilya Sutzkever cũng rời công ty.

- Các công ty công nghệ khác như Microsoft, Google cũng đang vội vã tích hợp AI một cách thiếu kiểm soát, dẫn đến những vấn đề như vi phạm quyền riêng tư, kết quả tìm kiếm sai lệch.

📌 Bê bối giọng nói Scarlett Johansson cho thấy OpenAI đang đối mặt với nhiều vấn đề như cáo buộc vi phạm bản quyền, hành vi phi đạo đức của lãnh đạo, và mâu thuẫn nội bộ. Điều này đặt ra câu hỏi về tương lai của công ty 90 tỷ USD cũng như sự phát triển thiếu kiểm soát của ngành công nghiệp AI, dẫn đến những hệ lụy đáng lo ngại.

Citations:

[1]https://sea.mashable.com/tech-industry/32758/what-openais-scarlett-johansson-drama-tells-us-about-the-future-of-ai

- Báo cáo tháng 5 của Đại học Stanford đánh giá 14 nhà cung cấp mô hình nền tảng, cho thấy điểm minh bạch trung bình đạt 58/100, tăng 21 điểm so với báo cáo tháng 10 năm ngoái.

- 8 nhà phát triển được đánh giá trong cả hai báo cáo tháng 10 và tháng 5 đều cải thiện điểm số của họ.

- Mặc dù mô hình Granite của IBM không đạt điểm cao nhất, nhưng nó vượt trội hơn các ông lớn khác trong ngành như Microsoft, Meta, OpenAI, Google và Amazon.

- Các nhà nghiên cứu chỉ ra rằng các nhà phát triển thường không minh bạch về dữ liệu, lao động và tính toán được sử dụng để xây dựng mô hình, không công bố đánh giá về rủi ro hoặc biện pháp giảm thiểu và không chia sẻ thông tin về tác động của mô hình đối với người dùng hoặc các lĩnh vực thị trường.

- Các cơ quan chính phủ trên toàn thế giới đang nỗ lực thúc đẩy sự minh bạch, như Nhà Trắng đã đảm bảo cam kết tự nguyện về an toàn và minh bạch từ hơn một chục nhà cung cấp công nghệ, và Liên minh Châu Âu đã thông qua Đạo luật AI với nhiều quy định liên quan đến minh bạch.

- Các giám đốc CNTT có quyền đàm phán để tăng tính minh bạch khi mua các mô hình AI.

- Trong báo cáo tháng 5, nhóm nghiên cứu đã liên hệ trực tiếp với các công ty để yêu cầu báo cáo và tiết lộ chủ động. 14 trên 19 công ty đồng ý tham gia.

- StarCoder từ BigCode, được hỗ trợ bởi Hugging Face và ServiceNow, đạt 85/100 điểm trên bảng xếp hạng, vượt qua điểm số 64 của Granite. AI21 Labs thể hiện sự cải thiện minh bạch lớn nhất, tăng 50 điểm kể từ tháng 10 và giành vị trí thứ hai.

📌 Báo cáo tháng 5 của Đại học Stanford cho thấy sự minh bạch của các nhà cung cấp mô hình nền tảng đã được cải thiện, với điểm trung bình đạt 58/100. IBM vượt trội hơn các ông lớn khác như Meta, OpenAI. Các cơ quan chính phủ đang thúc đẩy minh bạch và CIO có quyền đàm phán khi mua mô hình AI. StarCoder đứng đầu với 85 điểm, trong khi AI21 Labs cải thiện vượt bậc.

https://www.ciodive.com/news/transparency-generative-ai--model-vendor-landscape/716911/

- Quản trị AI là khuôn khổ toàn diện gồm các chính sách, quy trình và công cụ hướng dẫn toàn bộ vòng đời của hệ thống AI, từ phát triển ban đầu đến triển khai và giám sát liên tục. Khuôn khổ này đảm bảo công nghệ AI không chỉ đổi mới, hiệu quả mà còn tuân thủ các tiêu chuẩn đạo đức, duy trì tính minh bạch và trách nhiệm giải trình.

- Quản trị AI hiệu quả giải quyết các khía cạnh quan trọng như bảo mật dữ liệu, đảm bảo tính bảo mật và an toàn cao nhất cho dữ liệu được sử dụng và tạo ra bởi hệ thống AI. Giảm thiểu thiên vị là một thành phần chính, tập trung vào việc xác định, đánh giá và giảm thiểu sự thiên vị trong mô hình AI để thúc đẩy sự công bằng. Tính minh bạch liên quan đến việc tạo ra các hệ thống AI dễ hiểu và giải thích được với người dùng và các bên liên quan, từ đó tăng cường niềm tin và trách nhiệm.

- Xây dựng AI có trách nhiệm mang lại nhiều lợi ích cho doanh nghiệp ở các lĩnh vực chính:

1. Tuân thủ: Tránh hậu quả pháp lý và duy trì danh tiếng bằng cách tuân thủ các quy định về an toàn, minh bạch của AI như Đạo luật AI của EU. Khái niệm "nhãn dinh dưỡng" cho AI bao gồm cung cấp thông tin chi tiết về mục đích, nguồn dữ liệu, chỉ số hiệu suất và thiên vị tiềm ẩn của hệ thống AI, giúp người dùng hiểu rõ khả năng và hạn chế của hệ thống.

2. Quản lý rủi ro: Phát hiện và giảm thiểu thiên vị, sự trôi dạt và suy giảm hiệu suất của mô hình AI. Cần sử dụng các kỹ thuật như chỉ số công bằng, kiểm tra thiên vị và bộ dữ liệu huấn luyện đa dạng. Giám sát liên tục mô hình AI để phát hiện sự thay đổi về hiệu suất và tính công bằng theo thời gian. Các chỉ số mới đang được phát triển để đánh giá hiệu suất và khía cạnh đạo đức của các mô hình ngôn ngữ lớn (LLM).

3. Quản lý vòng đời: Quản lý mô hình AI trong suốt vòng đời, từ phát triển, triển khai đến giám sát và ngừng hoạt động. Trong giai đoạn phát triển, quản trị AI đảm bảo mô hình được xây dựng theo hướng dẫn đạo đức và thực tiễn tốt nhất. Khi triển khai, cần kiểm tra và xác thực nghiêm ngặt để xác nhận mô hình hoạt động như dự định. Sau khi triển khai, giám sát liên tục là cần thiết để theo dõi hiệu suất, phát hiện bất thường và giải quyết các vấn đề phát sinh. Quản lý vòng đời hiệu quả đảm bảo các tiêu chuẩn và thực tiễn nhất quán trên tất cả các nguồn AI, duy trì chất lượng và sự tuân thủ.

- Nhiều tổ chức như IBM, cộng đồng mã nguồn mở đã triển khai thành công thực tiễn AI có trách nhiệm. IBM phát triển các khuôn khổ và công cụ như bộ công cụ AI Fairness 360 để phát hiện và giảm thiểu thiên vị trong mô hình AI. Các dự án cộng đồng mã nguồn mở như Model Card Toolkit của TensorFlow cung cấp cách chuẩn hóa để ghi lại hiệu suất, tính minh bạch và khía cạnh đạo đức của mô hình AI. Việc tuân thủ các quy định như Đạo luật AI sắp tới của EU giúp doanh nghiệp đảm bảo hệ thống AI đáng tin cậy và phù hợp với các giá trị xã hội.

📌 Xây dựng AI có trách nhiệm là yếu tố then chốt để doanh nghiệp tận dụng tối đa tiềm năng của công nghệ AI, đồng thời đảm bảo các thực tiễn có đạo đức, minh bạch và có trách nhiệm giải trình. Quản trị AI cung cấp một khuôn khổ vững chắc để quản lý sự tuân thủ, giảm thiểu rủi ro và quản lý mô hình AI trong suốt vòng đời. Bằng cách áp dụng thực tiễn AI có trách nhiệm, doanh nghiệp không chỉ tăng cường đổi mới, năng lực cạnh tranh mà còn xây dựng niềm tin với các bên liên quan và đóng góp vào một hệ sinh thái AI đạo đức và toàn diện hơn.

Citations:

[1] https://www.geeky-gadgets.com/building-responsible-ai-systems/

- Tại sự kiện dành cho nhà phát triển Google I/O, Google đã trình bày cách tiếp cận AI có trách nhiệm để cân bằng giữa đổi mới và an toàn.

- Các công cụ AI tạo sinh như chatbot có thể mang lại nhiều lợi ích nhưng cũng tiềm ẩn nguy cơ lạm dụng.

- Google đang phát triển phương pháp "kiểm tra bảo mật AI" (AI-assisted red teaming), cho phép các AI agent cạnh tranh với nhau để mở rộng phạm vi kiểm tra bảo mật truyền thống.

- Google cũng tuyển dụng các chuyên gia an toàn từ nhiều lĩnh vực để đánh giá và phản hồi về các mô hình AI.

- Công cụ Synth ID của Google, vốn đang được sử dụng để gắn thủy vân vào hình ảnh và âm thanh do AI tạo ra, sẽ được mở rộng sang văn bản và video.

- Google cũng tập trung vào việc ứng dụng AI vào các lĩnh vực mang lại lợi ích xã hội như y tế, dự báo lũ lụt và giáo dục.

- Các mô hình Gemini tùy chỉnh như Learning Coach và Lear LM sẽ hỗ trợ học sinh và giáo viên, có mặt trên các sản phẩm của Google trong những tháng tới.

📌 Google đang nỗ lực phát triển AI có trách nhiệm thông qua các biện pháp như kiểm tra bảo mật AI, gắn thủy vân vào nội dung do AI tạo ra và ứng dụng AI vào giáo dục. Tuy nhiên, thách thức sẽ ngày càng gia tăng khi AI tạo ra hình ảnh, video và âm thanh ngày càng giống thật hơn.

https://www.cnet.com/tech/services-and-software/at-io-google-talks-up-responsible-ai-whats-that-all-about/

- Adobe đã thiết lập các Nguyên tắc Đạo đức AI từ năm 2019, bao gồm trách nhiệm, trách nhiệm giải trình và minh bạch.

- Firefly là công cụ AI của Adobe, được phát triển dựa trên các nguyên tắc đạo đức này để giảm thiểu thiên vị và phản hồi nhanh chóng các vấn đề.

- Adobe đã đồng sáng lập Sáng kiến Xác thực Nội dung vào năm 2019 để tăng cường niềm tin và minh bạch trực tuyến với các Chứng chỉ Nội dung, giống như "nhãn dinh dưỡng" cho nội dung kỹ thuật số.

- Chứng chỉ Nội dung có thể hiển thị thông tin quan trọng như danh tính người tạo, ngày tạo và liệu AI có được sử dụng hay không.

- Adobe đã tiến hành khảo sát Tương lai của Niềm tin, cho thấy hầu hết mọi người tin rằng cần có các công cụ để xác minh tính đáng tin cậy của nội dung trực tuyến.

- Firefly được đào tạo chỉ sử dụng hình ảnh được cấp phép từ bộ sưu tập Adobe Stock, nội dung được cấp phép công khai và nội dung thuộc phạm vi công cộng.

- Đội ngũ kiểm duyệt nội dung của Adobe thực hiện lọc bổ sung trên các hình ảnh trước khi chúng được đưa vào tập dữ liệu của Firefly.

- Đội ngũ Đổi mới Đạo đức của Adobe hợp tác chặt chẽ với các đội ngũ khác như Đội ngũ Tin cậy và An toàn, Pháp lý và Quốc tế hóa để giám sát phản hồi và phát triển các biện pháp giảm thiểu.

- Firefly đã thêm hỗ trợ đa ngôn ngữ AI vào mùa hè năm ngoái, mở rộng thuật ngữ để bao gồm các thuật ngữ và ý nghĩa cụ thể của từng quốc gia.

- Adobe đã tạo Đánh giá Tác động Đạo đức AI để xác định các tính năng và sản phẩm có thể duy trì thiên vị và định kiến có hại.

- Firefly được xem như một "copilot" cho sự sáng tạo, giúp người dùng tạo ra hình ảnh từ các lời nhắc văn bản.

- Adobe cam kết xây dựng công nghệ hỗ trợ và cải thiện quá trình sáng tạo, phản ánh nhu cầu của người dùng và sử dụng phản hồi của họ để phát triển các phiên bản AI tương lai.

- Adobe dự đoán các ứng dụng AI như Firefly sẽ trở thành giải pháp chính cho các công ty và chuyên gia, cải thiện hiệu quả và mở ra các khả năng mới, dựa trên niềm tin, minh bạch và đổi mới có trách nhiệm.

📌 Adobe đã thiết lập các nguyên tắc đạo đức AI từ năm 2019 và phát triển Firefly dựa trên các nguyên tắc này. Firefly sử dụng dữ liệu hình ảnh được cấp phép và có đội ngũ kiểm duyệt nội dung. Adobe cũng hợp tác chặt chẽ với các đội ngũ khác để giám sát và phát triển các biện pháp giảm thiểu, đảm bảo công nghệ AI hỗ trợ và cải thiện quá trình sáng tạo.

Citations:

[1] https://www.zdnet.com/article/how-adobe-manages-ai-ethics-concerns-while-fostering-creativity/

- Bài viết trên ZDNet chỉ ra rằng, sự thiếu minh bạch trong lĩnh vực trí tuệ nhân tạo (AI) đang là một vấn đề lớn, đặc biệt khi sự quan tâm đến AI ngày càng tăng.

- Các chuyên gia trong ngành công nghệ và người dùng cuối đều bày tỏ lo ngại về việc thiếu thông tin chi tiết về cách thức hoạt động và quyết định của các hệ thống AI.

- Một số vấn đề cụ thể được nêu bật bao gồm việc các công ty phát triển AI không cung cấp đủ thông tin về dữ liệu được sử dụng để huấn luyện các mô hình AI, cũng như các thuật toán đằng sau chúng.

- Điều này dẫn đến một loạt các hệ quả, bao gồm sự thiếu tin tưởng của công chúng và khó khăn trong việc đánh giá tính đúng đắn và an toàn của các sản phẩm AI.

- Bài viết cũng đề cập đến các nỗ lực nhằm cải thiện tình trạng này, chẳng hạn như việc áp dụng các chuẩn mực mới cho minh bạch và trách nhiệm giải trình trong phát triển AI.

- Một số giải pháp được đề xuất bao gồm việc tăng cường quy định pháp lý, phát triển các công cụ giám sát độc lập, và khuyến khích sự hợp tác giữa các bên liên quan để chia sẻ thông tin một cách công khai hơn.

- Các tổ chức quốc tế và chính phủ các nước cũng được kêu gọi tham gia vào quá trình này, nhằm đảm bảo rằng các tiêu chuẩn minh bạch được áp dụng một cách hiệu quả và rộng rãi.

📌 Bài viết trên ZDNet nhấn mạnh tình trạng thiếu minh bạch trong lĩnh vực AI, với các vấn đề như thiếu thông tin về dữ liệu và thuật toán, dẫn đến thiếu tin tưởng và khó khăn trong đánh giá sản phẩm. Đề xuất giải pháp như tăng cường quy định và hợp tác giữa các bên liên quan.

Citations:

[1] https://www.zdnet.com/article/transparency-is-sorely-lacking-amid-growing-ai-interest/

- Sự phát triển nhanh chóng của AI tạo sinh đã đặt ra cả cơ hội và thách thức cho ngành xuất bản học thuật.

- Ithaka S+R, một công ty nghiên cứu giáo dục, đã khởi xướng một nghiên cứu mới vào tháng trước để hiểu rõ hơn về ảnh hưởng của AI tạo sinh đối với xuất bản học thuật.

- Trong vài tháng tới, các nhà nghiên cứu sẽ phỏng vấn khoảng 15 người ra quyết định từ ngành xuất bản và các chuyên gia có kiến thức về đề tài này.

- Tracy Bergstrom, quản lý chương trình của Ithaka về bộ sưu tập và cơ sở hạ tầng, sẽ dẫn dắt nghiên cứu mới này. Bà nhấn mạnh rằng AI tạo sinh có tiềm năng thay đổi đột phá nhưng cũng phát triển rất nhanh.

- Mặc dù AI tạo sinh đã được nhắc đến như một công nghệ đang được theo dõi, nhưng cho đến nay vẫn chưa có đủ dữ liệu để đưa ra nhận định chắc chắn về ảnh hưởng của nó.

- Khảo sát hàng năm của *Inside Higher Ed* cho thấy 63% các hiệu trưởng cho biết chính sách AI đang được phát triển tại các trường của họ.

- Các nhà nghiên cứu học thuật cũng phải đảm bảo rằng việc sử dụng AI tạo sinh để viết bài không vi phạm quy tắc của các tạp chí, mặc dù một số tạp chí chưa có hướng dẫn cụ thể về AI tạo sinh.

📌 Nghiên cứu mới của Ithaka S+R đang khám phá ảnh hưởng của AI tạo sinh trong ngành xuất bản học thuật, với sự tham gia của khoảng 15 chuyên gia và người ra quyết định. Các nhà nghiên cứu đang tìm hiểu cơ hội và rủi ro mà công nghệ này mang lại, trong bối cảnh 63% các hiệu trưởng đang phát triển chính sách AI tại các trường của họ.

Citations:

[1] https://www.insidehighered.com/news/tech-innovation/digital-publishing/2024/05/06/researchers-investigating-generative-ai-and

- YouTube yêu cầu người dùng gắn nhãn nội dung do AI tạo ra khi trông giống thật hoặc có ý nghĩa, tương tự chính sách của Meta cho Facebook, Instagram và Threads.

- YouTube đưa ra danh sách dài các ví dụ cụ thể về nội dung cần gắn nhãn như: cảnh lướt sóng giả, thảm họa không tự nhiên, cảnh rượt đuổi xe hơi giả mạo, hình ảnh giả mạo nhân viên bệnh viện từ chối bệnh nhân.

- Hiện tại, YouTube dựa vào hệ thống danh dự, nhưng trong tương lai sẽ xem xét các biện pháp thực thi đối với người sáng tạo liên tục không tiết lộ thông tin này.

- Meta và Alphabet (công ty mẹ của YouTube) cũng tham gia một nhóm các công ty công nghệ ký hiệp ước chống thông tin sai lệch do AI tạo ra trước cuộc bầu cử tổng thống năm 2024.

- Google, Meta và TikTok là những công ty duy nhất có hướng dẫn về AI cho các nền tảng mạng xã hội của họ.

- X (Twitter) của Elon Musk có quy định gắn nhãn hình ảnh và âm thanh lừa đảo, nhưng không đề cập rõ ràng đến AI.

📌 YouTube, Facebook, Instagram và TikTok đều yêu cầu gắn nhãn nội dung AI trông giống thật. Đây là một phần trong nỗ lực chung của các công ty công nghệ lớn nhằm chống lại thông tin sai lệch do AI tạo ra trước thềm bầu cử tổng thống Mỹ 2024.

https://qz.com/youtube-ai-content-label-facebook-instagram-meta-1851346541

- Mira Murati, CTO lâu năm của OpenAI, không thể trả lời rõ ràng câu hỏi về nguồn dữ liệu huấn luyện cho mô hình AI tạo video Sora trong cuộc phỏng vấn với Wall Street Journal.

- Khi được hỏi liệu video trên YouTube, Instagram, Facebook có được đưa vào tập dữ liệu huấn luyện, Murati chỉ trả lời mơ hồ rằng dữ liệu "có sẵn công khai hoặc được cấp phép".

- Murati từ chối trả lời chi tiết về quan hệ đối tác huấn luyện dữ liệu giữa OpenAI và công ty ảnh Shutterstock, nhưng sau đó xác nhận video Shutterstock có trong tập huấn luyện của Sora.

- Phản ứng trái chiều trên mạng, một số cho rằng Murati thiếu thẳng thắn hoặc thậm chí nói dối, số khác lập luận rằng mọi thứ công khai trên mạng đều có thể bị các công ty AI hút dữ liệu.

- Vụ việc cho thấy OpenAI đang vấp phải tranh cãi và kiện tụng về thực tiễn thu thập dữ liệu, đồng thời nêu bật thực tế kỳ lạ mà người dùng Internet phải đối mặt.

📌 Việc CTO của OpenAI không thể trả lời rõ ràng về nguồn dữ liệu huấn luyện cho Sora, bất kể là do muốn tránh kiện tụng về bản quyền hay thiếu hiểu biết, đã làm dấy lên nghi vấn chính đáng của công chúng. Trong tương lai, các công ty AI sẽ khó lòng thuyết phục được mọi người chỉ bằng những câu trả lời mơ hồ.

https://futurism.com/video-openai-cto-sora-training-data

- Google tạm dừng tính năng tìm kiếm hình ảnh của chatbot AI Gemini do kết quả thiên vị và không chính xác như từ chối tạo ảnh người da trắng nhưng lại tạo được ảnh giáo hoàng nữ, người Viking không phải da trắng, George Washington da đen.

- Vấn đề nằm ở việc thao túng AI theo quan điểm "chống phân biệt chủng tộc" DEI (đa dạng, công bằng, hòa nhập), dẫn đến các thuật toán phân biệt đối xử công khai.

- Equal Protection Project cảnh báo về việc sử dụng thuật toán để thao túng ứng viên trong chức năng "Tuyển dụng đa dạng" của LinkedIn nhằm ưu tiên một số nhóm.

- Chính quyền Biden ra lệnh hành pháp yêu cầu thuật toán không thiên vị, nhưng "công bằng" theo DEI thực chất là hạn ngạch.

- Phân biệt đối xử bằng thuật toán có thể thao túng mọi khía cạnh cuộc sống như cơ hội việc làm, cho vay, nhà ở, tuyển sinh đại học mà khó chứng minh vì chúng hoạt động ngầm.

📌 Sự cố của Gemini cho thấy việc thao túng AI theo quan điểm DEI để đạt "công bằng" thực chất là xây dựng sự thiên vị vào hệ thống nhằm đạt hạn ngạch nhóm. Phân biệt đối xử bằng thuật toán đe dọa bình đẳng và cần phải ngăn chặn vì có thể thao túng tiềm ẩn mọi mặt của đời sống và nền kinh tế mà người dùng khó nhận ra.

https://nypost.com/2024/03/10/opinion/beware-geminis-insanity-is-actually-what-bias-free-ai-is-all-about/

- Các quốc gia Liên minh Châu Âu (EU) đang chuẩn bị áp dụng bộ luật đầu tiên trên thế giới để quản lý trí tuệ nhân tạo (AI), với mục tiêu đảm bảo an toàn và tôn trọng quyền cơ bản và giá trị của EU.

- Luật AI của EU áp dụng các quy tắc nghiêm ngặt nhất cho các mô hình AI có rủi ro cao và được thiết kế để đảm bảo các hệ thống AI an toàn, minh bạch và không phân biệt đối xử.

- Các chính phủ của các quốc gia EU đã phê duyệt dự luật vào ngày 2 tháng 2, và bây giờ chỉ cần sự chấp thuận cuối cùng từ Nghị viện Châu Âu, dự kiến sẽ diễn ra vào tháng 4. Nếu văn bản không thay đổi, luật sẽ có hiệu lực vào năm 2026.

- Một số nhà nghiên cứu hoan nghênh đạo luật vì tiềm năng khuyến khích khoa học mở, trong khi những người khác lo ngại rằng nó có thể làm chậm sự đổi mới.

- EU chọn cách quản lý các mô hình AI dựa trên rủi ro tiềm ẩn của chúng, áp dụng quy tắc nghiêm ngặt hơn cho các ứng dụng rủi ro cao và đề ra quy định riêng biệt cho các mô hình AI đa dụng như GPT.

- Các mô hình AI mạnh mẽ như GPT sẽ được quản lý trong hai hạng mục riêng biệt, với yêu cầu về minh bạch, phương pháp đào tạo, tiêu thụ năng lượng và tuân thủ luật bản quyền.

- Đạo luật cũng khuyến khích AI nguồn mở, làm cho thông tin AI có thể truy cập, sao chép và minh bạch, điều này phản ánh tinh thần của phong trào nguồn mở.

- Ủy ban Châu Âu sẽ tạo ra một Văn phòng AI để giám sát các mô hình đa dụng, với sự tư vấn từ các chuyên gia độc lập, phát triển cách đánh giá năng lực của các mô hình này và giám sát rủi ro liên quan.

📌 Luật AI của EU áp dụng các quy tắc nghiêm ngặt nhất cho các mô hình AI có rủi ro cao và được thiết kế để đảm bảo các hệ thống AI an toàn, minh bạch và không phân biệt đối xử. Các mô hình AI mạnh mẽ như GPT sẽ được quản lý trong hai hạng mục riêng biệt, với yêu cầu về minh bạch, phương pháp đào tạo, tiêu thụ năng lượng và tuân thủ luật bản quyền. Đạo luật cũng khuyến khích AI nguồn mở, làm cho thông tin AI có thể truy cập, sao chép và minh bạch, điều này phản ánh tinh thần của phong trào nguồn mở. Ủy ban Châu Âu sẽ tạo ra một Văn phòng AI để giám sát các mô hình đa dụng, với sự tư vấn từ các chuyên gia độc lập, phát triển cách đánh giá năng lực của các mô hình này và giám sát rủi ro liên quan.

https://www.nature.com/articles/d41586-024-00497-8

- An toàn cho người dùng có nguy cơ trên internet là thiết yếu, đặc biệt là đối với nội dung do AI tạo sinh.

- Việc phân biệt giữa thực tế và giả mạo ngày càng trở nên khó khăn khi các công ty đầu tư vào trí tuệ nhân tạo nhằm mục đích phát triển công nghệ tương tác và tăng lợi nhuận.

- Cần thiết phải có quy định minh bạch đối với nội dung do AI tạo sinh, đặc biệt khi công việc và các thỏa thuận thương hiệu lợi nhuận cao cho các influencer thực sự, người tạo nội dung, và toàn bộ nền kinh tế gig đang chịu đựng dưới sự tích hợp ngày càng tăng của AI.

📌 Nội dung do AI tạo sinh đang gây ra những thách thức lớn cho an toàn trên internet, đặc biệt là đối với những người dùng có nguy cơ. Khả năng phân biệt giữa thực tế và giả mạo đang trở nên khó khăn hơn bao giờ hết, điều này đặt ra nhu cầu cấp thiết cho việc quy định minh bạch và chặt chẽ đối với nội dung do AI tạo sinh. Điều này không chỉ ảnh hưởng đến người dùng cá nhân mà còn đến cả nền kinh tế gig, bao gồm cả những người tạo nội dung và influencer, khi họ phải đối mặt với sự cạnh tranh không công bằng từ nội dung do AI tạo sinh, ảnh hưởng đến công việc và thu nhập của họ.

Citations:

[1] https://wealthofgeeks.com/ai-generated-content-damaging/

- Liên minh Châu Âu (EU) đặt ra dự thảo luật AI mới, yêu cầu OpenAI và các công ty khác cung cấp chi tiết về cách tạo ra sản phẩm AI của họ.

- Dự luật AI, dự kiến có hiệu lực vào năm 2025 sau khi được các quốc gia thành viên EU phê duyệt, buộc các nhà phát triển AI phải báo cáo tóm tắt chi tiết về dữ liệu đào tạo cho các cơ quan quản lý EU.

- Các công ty AI hàng đầu ở Châu Âu đã vận động hành lang để giảm bớt các yêu cầu về minh bạch, trong khi OpenAI đã trở nên kín đáo hơn về dữ liệu họ đã thu thập từ Internet.

- Dữ liệu đào tạo có định kiến là vấn đề dai dẳng trong AI, yêu cầu sự can thiệp của quy định. Một nghiên cứu của Đại học Stanford cho thấy ChatGPT và một mô hình AI khác đã tạo ra những bức thư tuyển dụng chứa đầy định kiến giới tính.

- Các công ty sẽ phải kiểm tra an ninh và năng lượng tiêu thụ của mô hình AI của họ một cách nghiêm ngặt và báo cáo lại cho Ủy ban Châu Âu.

- Dự luật cũng yêu cầu các tổng kết về dữ liệu đào tạo phải rộng rãi về phạm vi thay vì chi tiết kỹ thuật, nhưng điều này vẫn không đủ để trả lời nhiều câu hỏi về việc sử dụng dữ liệu cá nhân, nội dung bạo lực hoặc định kiến, và việc sử dụng các bộ lọc nội dung.

Kết luận: Dự thảo luật AI của EU là một bước tiến nhỏ nhưng đáng giá trong việc làm sáng tỏ "hộp đen AI", buộc các công ty như OpenAI phải tiết lộ cách thức xây dựng sản phẩm AI của họ. Luật mới sẽ tăng cường minh bạch và cho phép điều tra sâu hơn về dữ liệu đào tạo, mặc dù vẫn cần phải cụ thể hóa thêm để đạt hiệu quả tối ưu.