AI nhỏ

View All

-

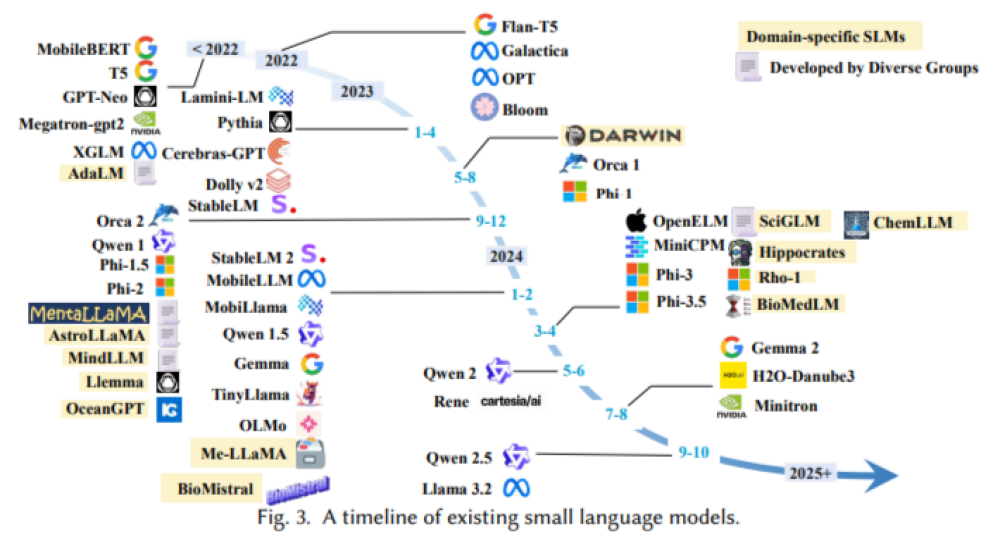

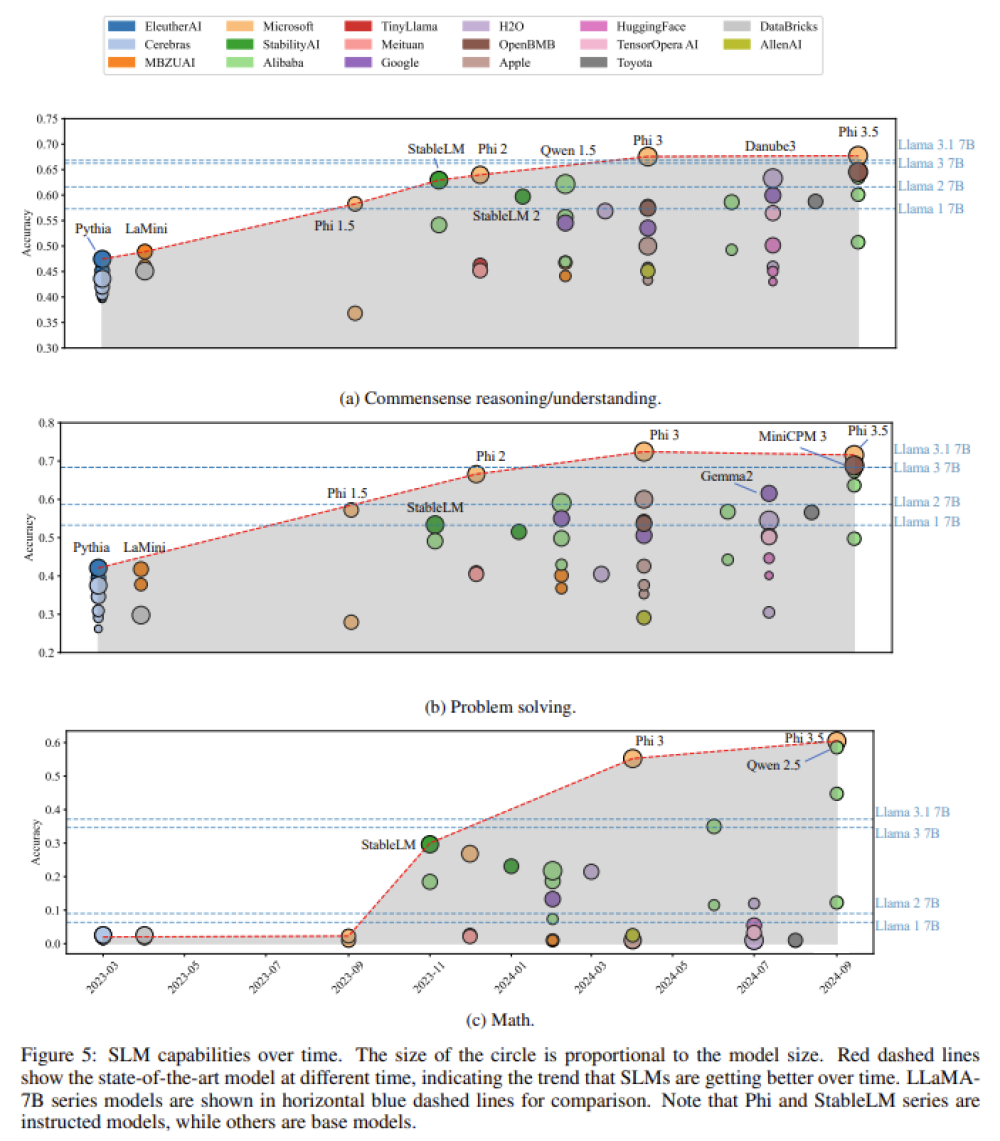

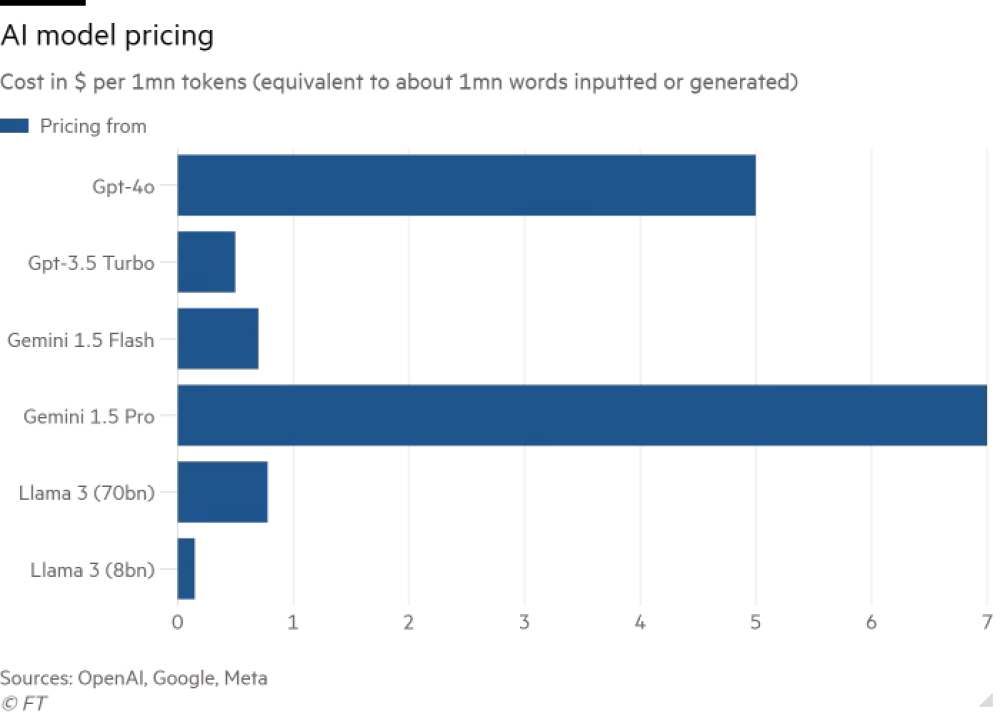

Sự phát triển chậm lại của các mô hình ngôn ngữ lớn (LLM) như GPT-5 đang gây ra sự thất vọng, tương tự như những nâng cấp "tẻ nhạt" trên điện thoại thông minh.

-

Nhiều doanh nghiệp đang chuyển sang sử dụng các mô hình ngôn ngữ nhỏ (SLM), nhờ khả năng tùy chỉnh, chi phí rẻ và hiệu quả cao hơn trong các tác vụ cụ thể.

-

SLM có thể chạy trên hệ thống nội bộ của doanh nghiệp thay vì phụ thuộc vào nền tảng đám mây, đặc biệt phù hợp với các thiết bị như điện thoại, ô tô tự lái và robot nhờ tiết kiệm năng lượng.

-

Mô hình Nvidia Nemotron Nano (9 tỷ tham số) đã vượt qua Llama của Meta (gấp 40 lần kích thước) trong nhiều bài kiểm tra.

-

Gartner dự báo nhu cầu doanh nghiệp cho các mô hình chuyên biệt sẽ tăng gấp đôi tốc độ so với LLM trong năm 2025.

-

Ví dụ điển hình: IBM dùng mô hình chỉ 250 triệu tham số cho sản phẩm Docling, chuyển đổi dữ liệu từ PDF – tiết kiệm chi phí và không cần LLM.

-

Các SLM có thể hoạt động trên CPU thông thường thay vì GPU đắt đỏ – “GPU là siêu xe Ferrari khó chiều,” theo IBM.

-

Một nghiên cứu của Nvidia cho thấy SLM là tương lai của agentic AI, giúp tạo ra cấu trúc "giống Lego" với các mô hình chuyên biệt cho từng tác vụ, thay vì dựa vào một LLM khổng lồ duy nhất.

-

GPT-5 cũng có cấu trúc lai – sử dụng nhiều mô hình nội bộ với kích cỡ và khả năng khác nhau tùy tác vụ.

-

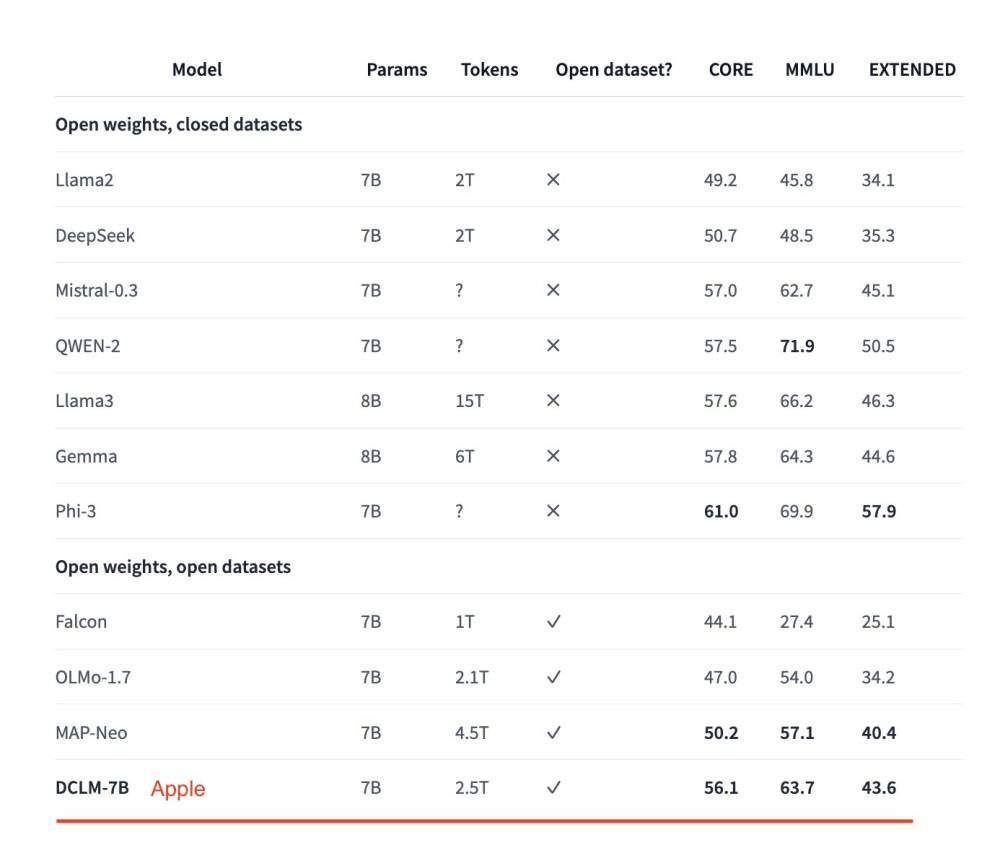

Apple được cho là đang tận dụng SLM để tăng sức mạnh cho "Apple Intelligence" trên iPhone, xử lý một số tác vụ trên thiết bị thay vì đám mây – cách tiếp cận này được đánh giá là thông minh và tiết kiệm.

-

Trong khi các "đại gia đám mây" như Microsoft và Google vẫn đầu tư mạnh vào LLM và hạ tầng siêu máy chủ, giới phân tích cảnh báo đó có thể là hướng đi thiếu linh hoạt nếu SLM tiếp tục phát triển nhanh.

📌 Khi LLM đang giảm dần hiệu quả và chi phí trở thành yếu tố then chốt, mô hình ngôn ngữ nhỏ (SLM) chứng minh sức mạnh nhờ chi phí thấp hơn gấp 10–30 lần và hiệu suất vượt trội trong các tác vụ cụ thể. Apple, với chiến lược chậm mà chắc và khai thác SLM trong "Apple Intelligence", có thể trở thành người hưởng lợi dài hạn trong cuộc đua AI.

https://www.economist.com/business/2025/09/08/faith-in-god-like-large-language-models-is-waning

Faith in God-like large language models is waning

That may be good news for AI laggards like Apple

Small is beautiful

-

Agentic AI đang tái định hình cách doanh nghiệp vận hành, đặc biệt trong các quy trình lặp lại. LLMs (Large Language Models) từng chiếm ưu thế, nhưng ngày càng bị thay thế một phần bởi SLMs (Small Language Models) nhờ tính linh hoạt, rẻ và đáng tin cậy hơn.

-

LLMs là “tổng quát” và mạnh, nhưng tác vụ agent thường chỉ cần một lát nhỏ chức năng: parsing lệnh, tạo JSON cho tool call, tóm tắt, trả lời câu hỏi bối cảnh. Sử dụng LLM cho việc này gây lãng phí tài nguyên.

-

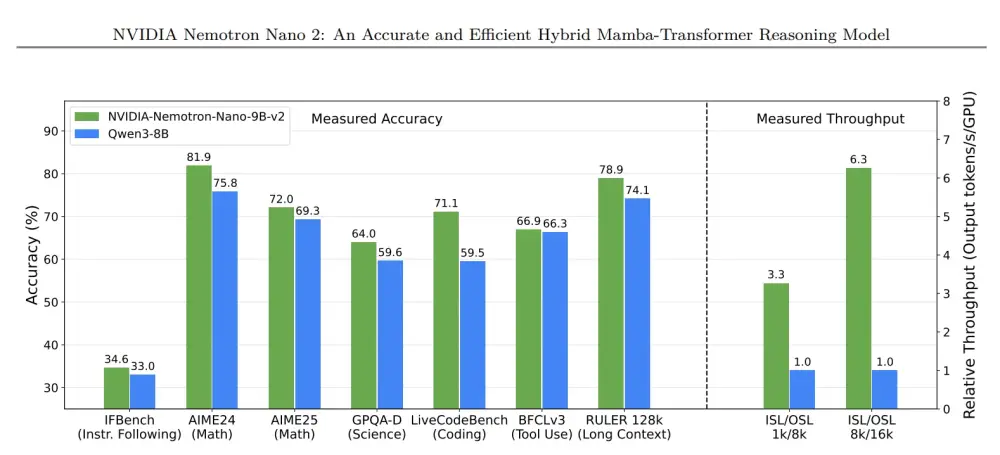

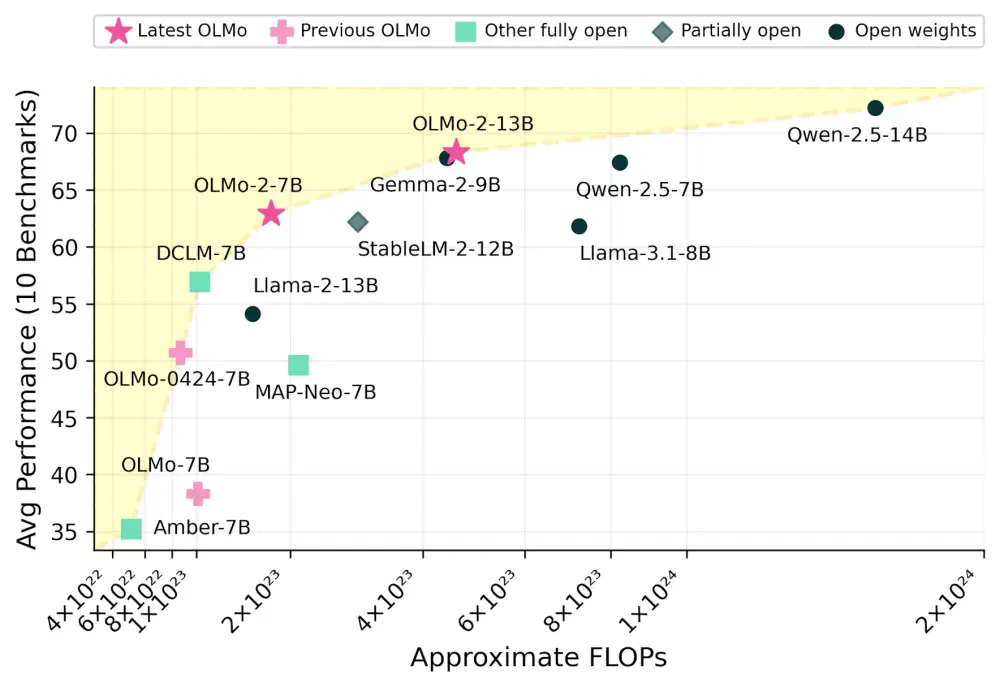

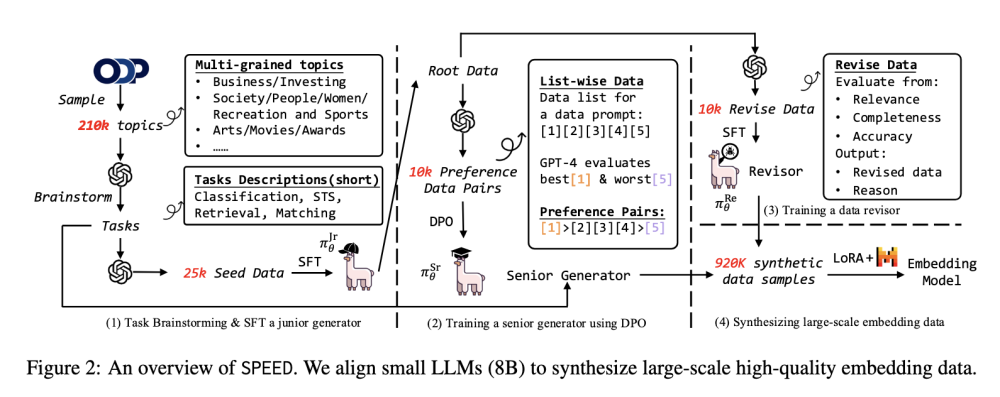

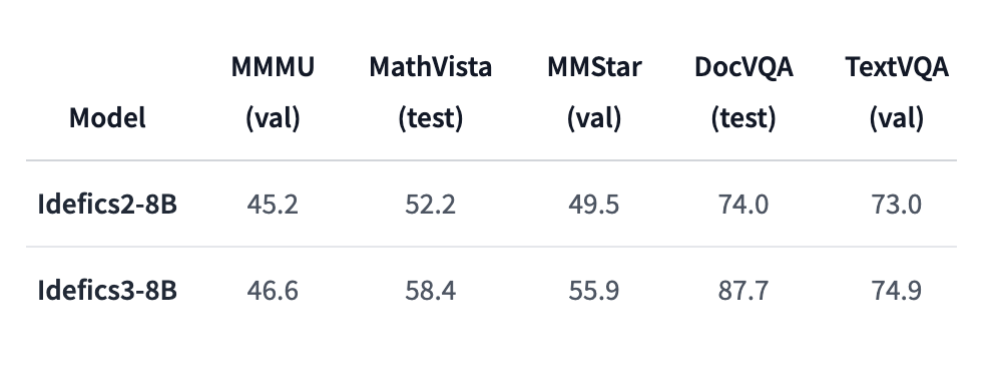

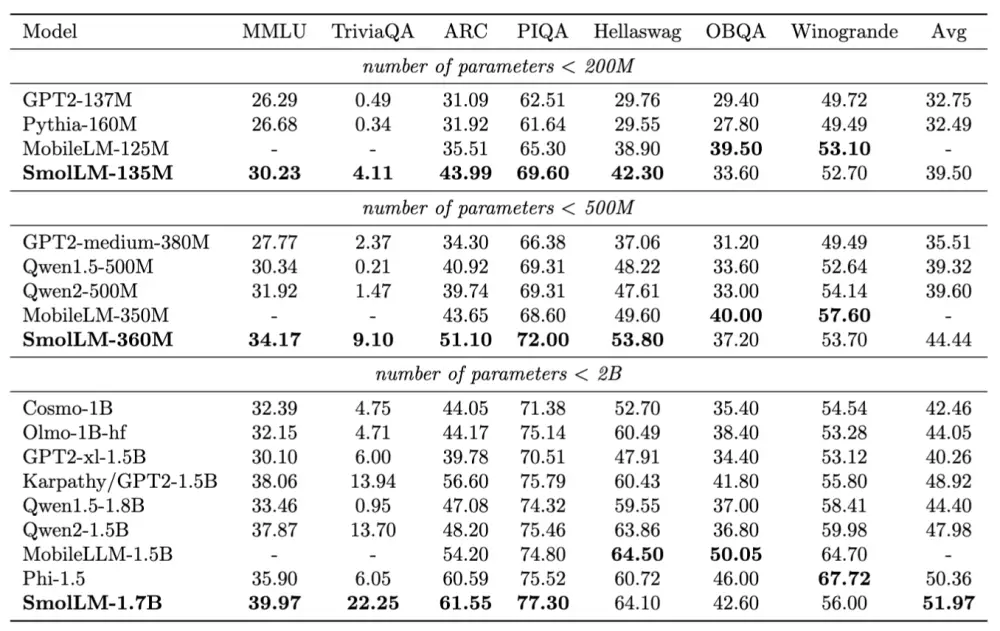

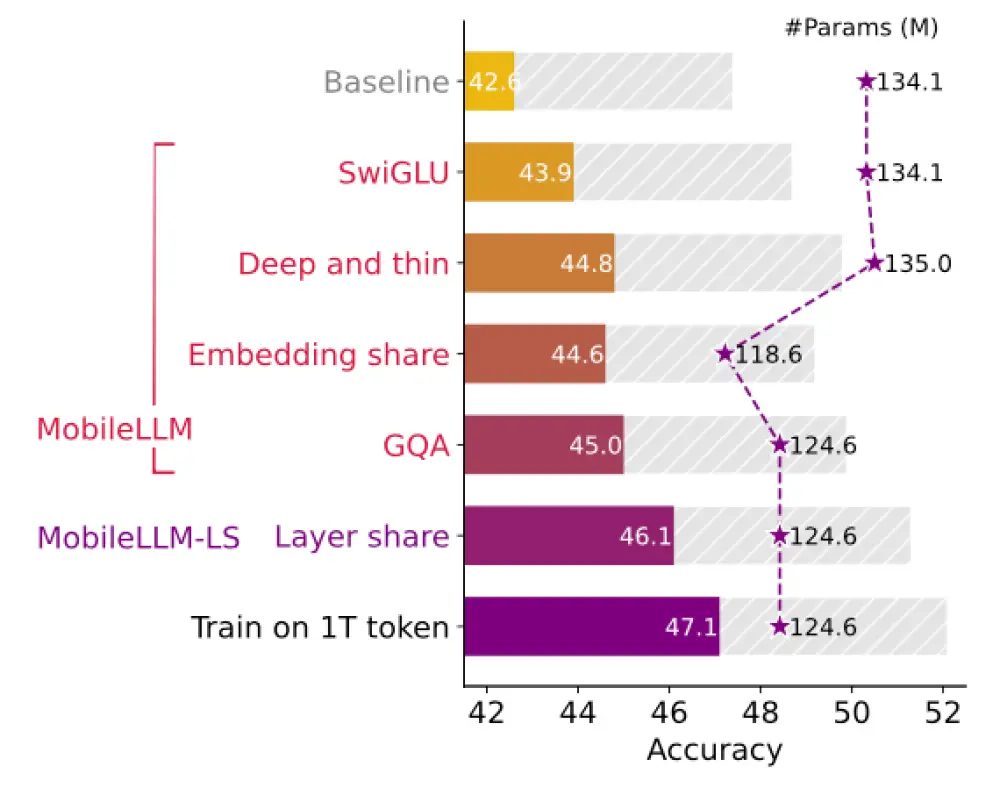

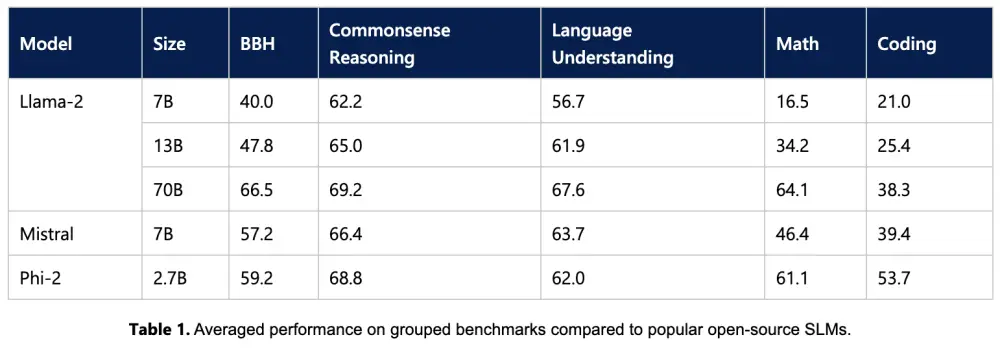

SLMs khi fine-tune cho một số tác vụ cụ thể trở nên nhanh, ít ảo giác, rẻ và ổn định hơn. NVIDIA Nemotron Nano 2 (9B tham số) là ví dụ điển hình: mô hình Mamba-transformer mã nguồn mở, hỗ trợ ngữ cảnh 128k token, tối ưu hóa chạy trên 1 GPU, đạt throughput cao gấp 6 lần so với cùng lớp.

-

Benchmark cho thấy Nemotron Nano 2 vượt các SLM cùng kích thước và cạnh tranh với LLM lớn ở reasoning, coding, instruction following.

-

Hiệu quả chi phí nổi bật: chạy Llama 3.1B SLM rẻ hơn 10–30 lần so với Llama 3.3 405B, đồng thời phản hồi real-time, không cần hạ tầng phân tán nặng. Fine-tuning SLM chỉ cần vài giờ GPU, trong khi LLM mất nhiều ngày hoặc tuần.

-

Edge deployment như NVIDIA ChatRTX cho phép chạy SLM tại chỗ trên GPU phổ thông, vừa tiết kiệm vừa bảo mật dữ liệu nhạy cảm.

-

SLM dễ căn chỉnh định dạng output chính xác (ví dụ JSON schema), giảm lỗi sản xuất – trong khi LLM dễ trôi ngữ nghĩa.

-

Tương lai là hệ thống dị thể: nhiều SLM chuyên dụng kết hợp với LLM gọi khi cần xử lý đa bước hoặc hội thoại mở rộng.

-

Thách thức chính: nhận thức doanh nghiệp vẫn thiên về LLM, benchmark chưa phù hợp với agentic workload. Tuy nhiên, đà chuyển dịch giống “monolithic → microservices” đang bắt đầu.

-

Tích hợp SLM: doanh nghiệp thu thập dữ liệu tác vụ lặp, phân loại, fine-tune bằng LoRA/QLoRA, rồi dần thay thế subtasks từ LLM sang SLM. NVIDIA NeMo cung cấp bộ công cụ end-to-end cho chu kỳ này.

📌

Các mô hình ngôn ngữ nhỏ (SLM) như Nemotron Nano 2 chứng minh rằng tác vụ agent có thể chạy nhanh hơn 6 lần, rẻ hơn 10–30 lần so với các mô hình ngôn ngữ lớn (LLM) khổng lồ. Chúng dễ tinh chỉnh, tiết kiệm GPU và vận hành tốt cả trên cloud lẫn ở biên. Trong khi LLM vẫn cần cho hội thoại mở và đa lĩnh vực, doanh nghiệp hướng tới hệ thống dị thể – SLM xử lý khối lượng chính, LLM hỗ trợ khi cần. Đây là con đường để Agentic AI trở nên rẻ hơn, linh hoạt hơn và dân chủ hóa hơn trong năm 2025.

https://developer.nvidia.com/blog/how-small-language-models-are-key-to-scalable-agentic-ai/

-

Google DeepMind công bố Gemma 3 270M — mô hình AI 270 triệu tham số, nhỏ hơn rất nhiều so với các LLM hàng chục tỷ tham số, nhưng vẫn thực hiện tốt tác vụ phức tạp.

-

Mục tiêu: tối ưu hiệu suất và khả năng chạy trực tiếp trên thiết bị như smartphone (Pixel 9 Pro SoC), trình duyệt web, Raspberry Pi, hoặc thậm chí thiết bị IoT.

-

Cấu trúc gồm 170 triệu embedding parameters (từ vựng 256k token, xử lý tốt từ hiếm) và 100 triệu tham số transformer block.

-

Có thể fine-tune trong vài phút để phục vụ nhu cầu doanh nghiệp hoặc nhà phát triển độc lập; hỗ trợ triển khai nhanh qua Hugging Face, UnSloth, JAX.

-

Trên benchmark IFEval, bản instruction-tuned đạt 51,2%, vượt các mô hình nhỏ như SmolLM2 135M Instruct, Qwen 2.5 0.5B Instruct, tiệm cận mô hình hàng tỷ tham số.

-

Rival Liquid AI lưu ý Gemma chưa so sánh với LFM2-350M (65,12%) có kích thước tương tự.

-

Tiết kiệm năng lượng: bản INT4 quantized chỉ tiêu tốn 0,75% pin Pixel 9 Pro sau 25 cuộc hội thoại.

-

Phát hành cả bản pretrained và instruction-tuned, kèm QAT checkpoints để duy trì hiệu năng cao với INT4.

-

Google định hướng dùng mô hình nhỏ chuyên biệt thay vì phụ thuộc vào mô hình lớn đa năng, tối ưu cho các tác vụ như sentiment analysis, entity extraction, query routing, text generation, compliance, creative writing.

-

Demo Bedtime Story Generator minh họa khả năng sáng tạo và xử lý ngữ cảnh hoàn toàn offline qua trình duyệt.

-

Giấy phép Gemma Terms of Use cho phép sử dụng, chỉnh sửa, phân phối với điều kiện tuân thủ chính sách cấm và ghi rõ thay đổi; không phải nguồn mở truyền thống nhưng hỗ trợ thương mại rộng rãi.

-

Doanh nghiệp được toàn quyền sở hữu nội dung đầu ra, miễn tuân thủ luật pháp và điều khoản cấm.

-

Hệ sinh thái Gemmaverse đã vượt 200 triệu lượt tải, với phiên bản tối ưu cho cloud, desktop và mobile.

📌 Gemma 3 270M của Google là mô hình AI 270 triệu tham số siêu nhỏ, đạt 51,2% trên IFEval, chạy mượt trên smartphone, trình duyệt và IoT với mức tiêu thụ pin 0,75% cho 25 phiên thoại. Nhờ khả năng fine-tune nhanh, triển khai offline và giấy phép thương mại linh hoạt, Gemma 3 270M mở ra cơ hội xây dựng ứng dụng AI chuyên biệt, tiết kiệm chi phí và bảo vệ quyền riêng tư.

https://venturebeat.com/ai/google-unveils-ultra-small-and-efficient-open-source-ai-model-gemma-3-270m-that-can-run-on-smartphones/

-

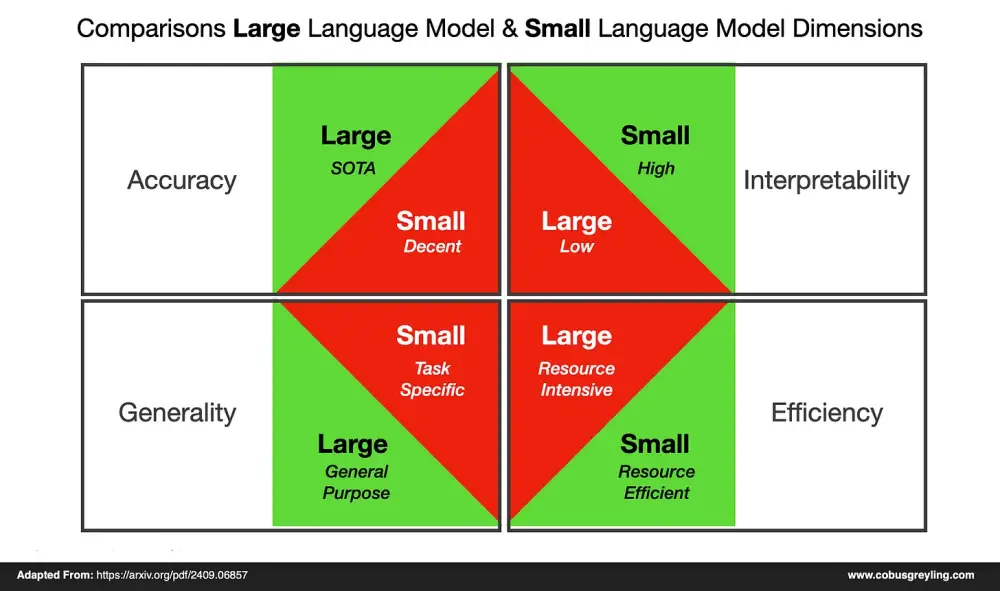

Mặc dù các mô hình ngôn ngữ lớn (LLM) như ChatGPT đã thống trị thị trường AI, nhiều doanh nghiệp đang chuyển sang sử dụng mô hình ngôn ngữ nhỏ (SLM) vì phù hợp hơn với nhu cầu cụ thể và chi phí thấp hơn.

-

Theo khảo sát mới của McKinsey, 74% tổ chức hiện đang sử dụng AI tạo sinh, nhưng 62% vẫn gặp khó khăn về khả năng giải thích và quản lý dữ liệu từ các mô hình lớn.

-

SLM tập trung vào độ sâu hơn là độ rộng, được huấn luyện từ dữ liệu chuyên ngành như tài chính, y tế hay luật – giúp mang lại kết quả chính xác, phù hợp và đáng tin cậy hơn so với LLM đa mục đích.

-

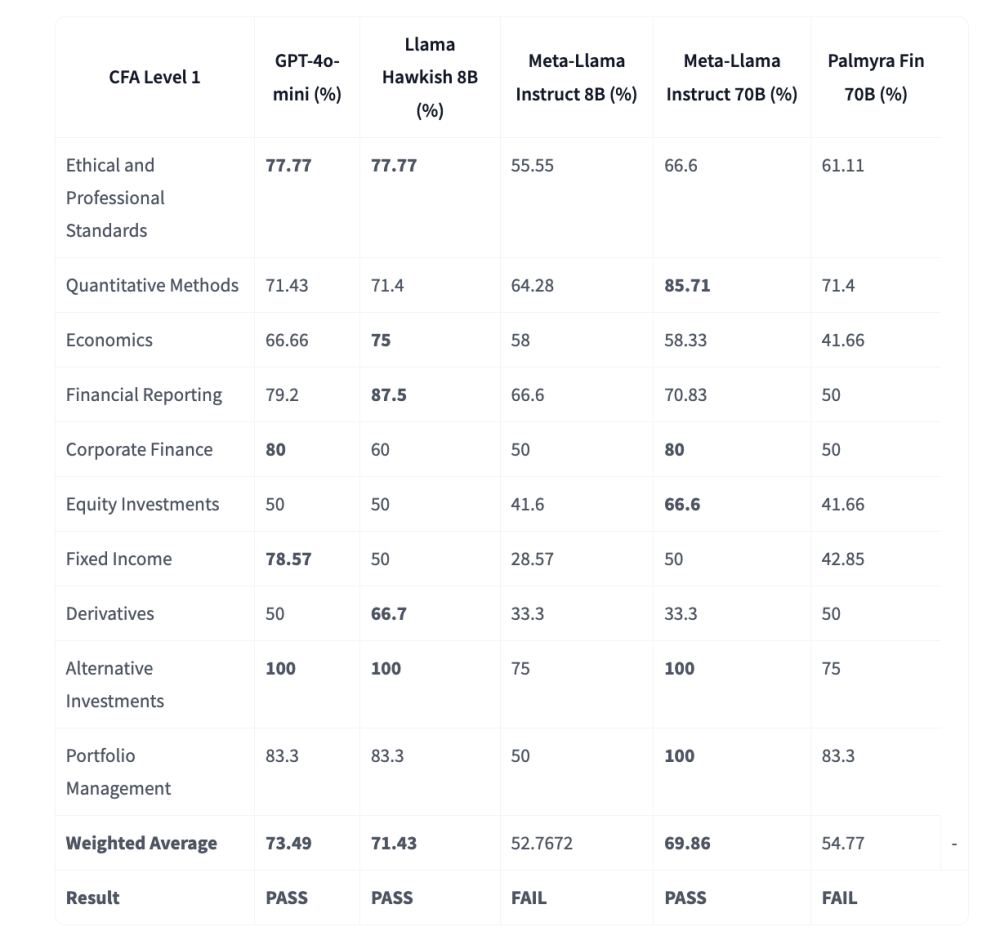

Trong tài chính, SLM được huấn luyện từ báo cáo thu nhập, hồ sơ nội bộ hay dữ liệu pháp lý, giúp đánh giá rủi ro hoặc lập báo cáo tài chính chính xác và tiết kiệm thời gian.

-

LLM có nguy cơ sinh lỗi nghiêm trọng – ví dụ như luật sư từng bị kỷ luật vì ChatGPT bịa ra tiền lệ pháp lý. SLM khắc phục nhược điểm này nhờ đào tạo trên dữ liệu thực tiễn, giảm hiện tượng "hallucination".

-

96,9% lãnh đạo doanh nghiệp cho biết chi phí tính toán cao là rào cản lớn nhất khi triển khai LLM. Trong khi đó, nhiều SLM có thể chạy trên phần cứng giá rẻ như NVIDIA Jetson hay Mac Mini dưới 1.000 USD.

-

Mô hình như NVIDIA Spark – siêu máy tính AI nhỏ nhất thế giới – mở đường cho AI hiệu năng cao nhưng chi phí thấp.

-

SLM cho phép doanh nghiệp kiểm soát dữ liệu, tùy chỉnh mô hình tại chỗ và đảm bảo tuân thủ bảo mật, tránh rủi ro rò rỉ thông tin nhạy cảm, đồng thời đáp ứng các quy định như GDPR.

-

Cách tiếp cận lai (hybrid) đang trở nên phổ biến: kết hợp SLM ở biên, lớp dữ liệu bảo mật và LLM quy mô đám mây, nhằm tối ưu AI theo ngữ cảnh, mục đích người dùng và mức độ nhạy cảm dữ liệu.

📌 Trong khi LLM vẫn giữ vai trò quan trọng trong một số lĩnh vực tổng quát, SLM đang trở thành lựa chọn tối ưu cho doanh nghiệp muốn triển khai AI thực tiễn, tiết kiệm và bảo mật. Với chi phí hạ tầng thấp, khả năng huấn luyện theo dữ liệu riêng và độ chính xác cao, SLM giúp các ngành như tài chính, y tế hay luật pháp tận dụng AI hiệu quả hơn.

https://www.techradar.com/pro/small-models-big-wins-four-reasons-enterprises-are-choosing-slms-over-llms

-

Các doanh nghiệp ngày càng nhận ra rằng mô hình ngôn ngữ lớn (LLM) dù mạnh mẽ nhưng đắt đỏ và cồng kềnh.

-

Xu hướng mới là sử dụng mô hình ngôn ngữ nhỏ như Google Gemma, Microsoft Phi, Mistral Small 3.1 giúp tiết kiệm chi phí vận hành (OPEX) và đầu tư (CAPEX) nhờ giảm nhu cầu về GPU, bộ nhớ và điện năng.

-

Ví dụ: OpenAI o4-mini chỉ tốn 1,1 USD/million token (input) và 4,4 USD (output) so với 10 và 40 USD ở GPT-4o.

-

Mô hình nhỏ giúp doanh nghiệp giảm chi phí triển khai, bảo trì và dễ dàng tinh chỉnh để phù hợp với các tác vụ cụ thể.

-

Công ty Aible ghi nhận giảm chi phí tới 100 lần nhờ tinh chỉnh sau đào tạo (post-training), từ hàng triệu USD xuống còn 30.000 USD.

-

Thí nghiệm với Llama 70B (chi phí 11,3 USD, độ chính xác 92%) và Llama 8B (chi phí tinh chỉnh 4,58 USD, độ chính xác 82%) chứng minh mô hình nhỏ phù hợp với tác vụ nhỏ và tiết kiệm chi phí hơn.

-

Tuy nhiên, mô hình nhỏ cũng có rủi ro: ngữ cảnh giới hạn, dễ bị “brittle” (mong manh) nếu dùng sai mục đích.

-

Chiến lược tối ưu: bắt đầu với LLM lớn để kiểm tra tính khả thi, sau đó chuyển sang mô hình nhỏ hoặc tùy chỉnh cho các tác vụ cụ thể.

-

AWS cảnh báo: nếu mô hình quá nhỏ so với tác vụ, sẽ dẫn đến tăng chi phí lao động và giảm hiệu suất.

-

Các doanh nghiệp cần luôn sẵn sàng thay đổi mô hình khi có công nghệ mới tốt hơn, đồng thời ưu tiên chọn nền tảng hỗ trợ chuyển đổi linh hoạt giữa các mô hình.

📌 Tối giản mô hình AI giúp doanh nghiệp tiết kiệm tới 100 lần chi phí. Mô hình nhỏ như o4-mini, Llama 8B phù hợp với các tác vụ chuyên biệt, rẻ hơn, nhanh hơn nhưng vẫn hiệu quả. Chiến lược lý tưởng là khởi đầu với LLM lớn, sau đó chuyển sang mô hình nhỏ tùy chỉnh để cân bằng chi phí và hiệu suất dài hạn.

https://venturebeat.com/ai/model-minimalism-the-new-ai-strategy-saving-companies-millions/

-

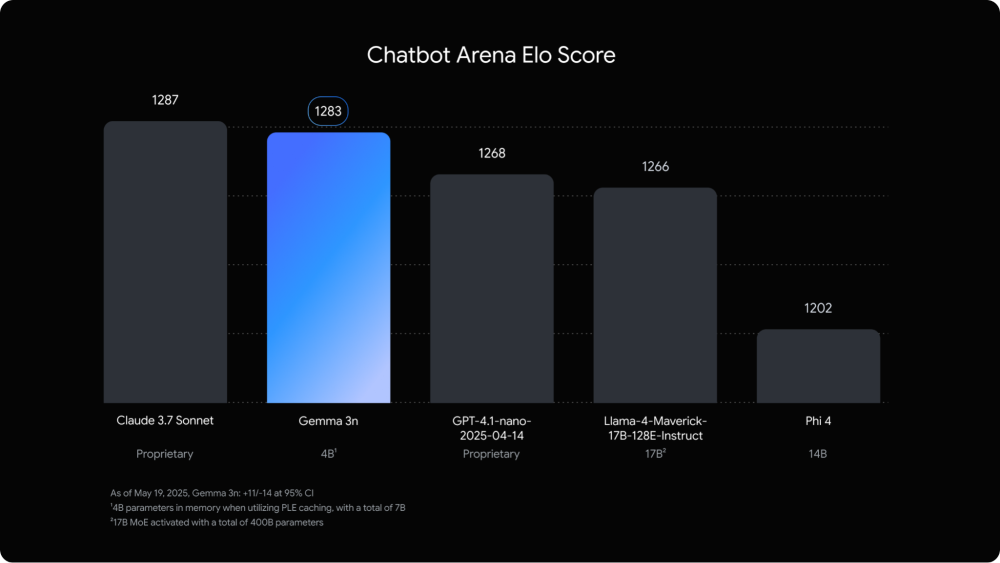

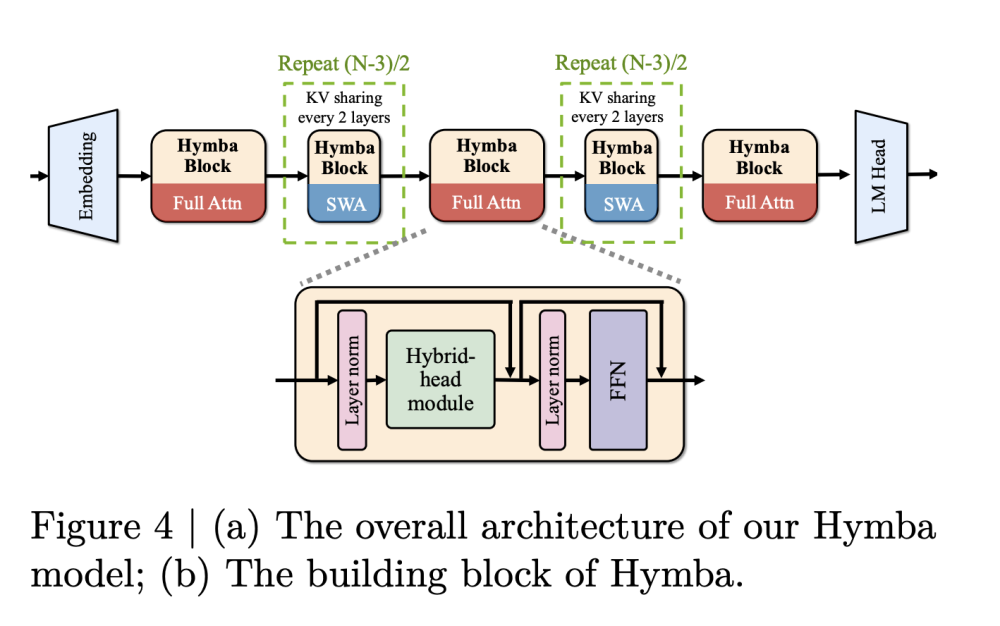

Google công bố Gemma 3n, phiên bản AI mới với kiến trúc mobile-first, tập trung vào hiệu suất trên thiết bị di động.

-

Được hỗ trợ bởi các nền tảng như Hugging Face, llama.cpp, Google AI Edge, Ollama, MLX…, Gemma 3n dễ dàng triển khai và tùy chỉnh cho các ứng dụng on-device.

-

Gemma 3n hỗ trợ đa phương thức gồm văn bản, hình ảnh, video và âm thanh.

-

Có 2 phiên bản chính:

-

E2B (5B tham số thô, footprint như mô hình 2B)

-

E4B (8B tham số thô, footprint như mô hình 4B)

-

-

Kiến trúc MatFormer (Matryoshka Transformer) cho phép nhúng nhiều mô hình trong một, giúp chuyển đổi linh hoạt giữa E2B và E4B hoặc tạo mô hình tùy chỉnh với công cụ Mix-n-Match.

-

Per-Layer Embeddings (PLE) giúp giảm tải bộ nhớ VRAM, chỉ cần khoảng 2GB (E2B) hoặc 4GB (E4B) cho lõi transformer.

-

Tích hợp KV Cache Sharing, tăng tốc độ xử lý chuỗi dài gấp 2 lần so với Gemma 3 4B.

-

Hỗ trợ nhận diện giọng nói (ASR) và dịch giọng nói (AST) với hiệu suất cao, đặc biệt tốt cho các cặp ngôn ngữ Anh-Tây Ban Nha, Anh-Pháp…

-

Vision encoder mới MobileNet-V5:

-

Hỗ trợ độ phân giải từ 256x256 đến 768x768.

-

Xử lý video 60 FPS trên Google Pixel.

-

Nhanh hơn 13 lần so với SoViT, bộ nhớ nhỏ hơn 4 lần, giảm 46% tham số.

-

-

Google ra mắt Gemma 3n Impact Challenge với tổng giải thưởng 150.000 USD cho các dự án có tác động xã hội.

-

Người dùng có thể bắt đầu với Gemma 3n qua Google AI Studio, tải mô hình từ Hugging Face, Kaggle hoặc triển khai qua Cloud Run, Vertex AI, NVIDIA API…

📌 Gemma 3n là bước tiến đột phá của Google cho AI trên thiết bị di động, hỗ trợ đa phương thức với hiệu suất vượt trội. Kiến trúc MatFormer và MobileNet-V5 giúp tăng tốc tới 13 lần, giảm footprint bộ nhớ xuống còn 2-4GB. Hỗ trợ nhận diện và dịch giọng nói, xử lý hình ảnh, video tốc độ cao. Gemma 3n mở ra cơ hội xây dựng ứng dụng AI offline mạnh mẽ cho cộng đồng lập trình.

https://developers.googleblog.com/en/introducing-gemma-3n-developer-guide/

-

DeepSeek, phòng thí nghiệm AI Trung Quốc, vừa ra mắt phiên bản nhẹ “chưng cất” của mô hình suy luận R1, mang tên DeepSeek-R1-0528-Qwen3-8B.

-

Mô hình này được xây dựng dựa trên Qwen3-8B – sản phẩm của Alibaba phát hành vào tháng 5 – bằng cách chưng cất từ đầu ra của R1 đầy đủ.

-

Dù nhỏ gọn, mô hình này đánh bại Google Gemini 2.5 Flash trong bài kiểm tra AIME 2025, bộ đề toán học khó nhằn.

-

Ngoài ra, nó gần như đạt được hiệu suất của Microsoft Phi 4 Reasoning Plus trên bài test HMMT – một kỳ thi toán học phức tạp dành cho học sinh trung học giỏi.

-

Các mô hình dạng "distilled" thường kém hơn bản gốc, nhưng đổi lại rất tiết kiệm tài nguyên.

-

Qwen3-8B chỉ cần GPU có 40GB-80GB RAM để chạy (ví dụ: Nvidia H100), trong khi R1 đầy đủ cần tới hàng chục GPU 80GB.

-

DeepSeek định vị mô hình này phục vụ cả nghiên cứu học thuật về suy luận và ứng dụng công nghiệp quy mô nhỏ.

-

Mô hình hiện được phát hành miễn phí theo giấy phép MIT, cho phép dùng thương mại không giới hạn.

-

Một số nền tảng như LM Studio đã tích hợp mô hình và cung cấp qua API sẵn sàng sử dụng.

-

Thay vì cần hạ tầng siêu khủng, các nhóm nhỏ hoặc startup có thể tận dụng mô hình này để xây dựng ứng dụng AI suy luận mạnh mà tiết kiệm chi phí.

-

Sự kết hợp giữa kỹ thuật chắt lọc và nền tảng từ Qwen3 giúp tạo ra một mô hình nhỏ nhưng “có võ”, cạnh tranh ngang hàng với các ông lớn công nghệ.

📌 DeepSeek-R1-0528-Qwen3-8B là mô hình AI nhẹ mới chỉ cần 1 GPU 40GB nhưng vẫn vượt Google Gemini 2.5 Flash trong bài toán AIME 2025 và gần bắt kịp Phi 4 của Microsoft. Mô hình dùng mã nguồn mở MIT, hỗ trợ nghiên cứu và thương mại hóa, giúp các nhóm nhỏ truy cập AI suy luận mạnh mẽ mà không cần hạ tầng đắt đỏ.

https://techcrunch.com/2025/05/29/deepseeks-distilled-new-r1-ai-model-can-run-on-a-single-gpu/

-

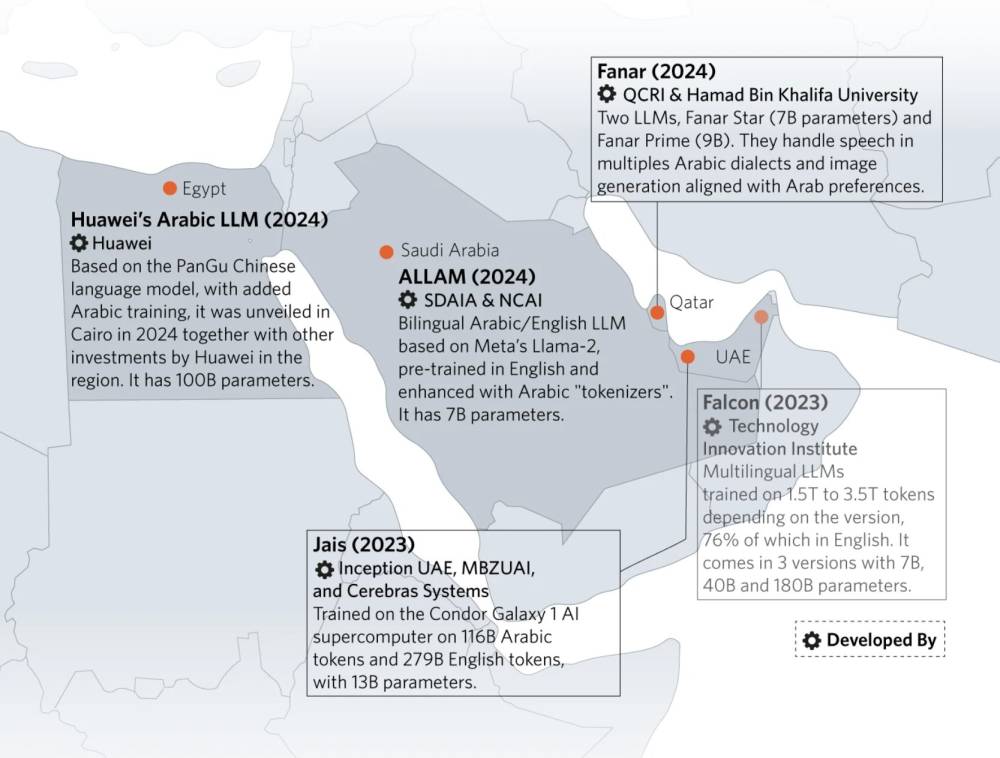

Trong khi Mỹ và Trung Quốc tranh giành vị thế dẫn đầu AI, các quốc gia ở Nam bán cầu đang âm thầm xây dựng sức mạnh AI bản địa phù hợp ngôn ngữ và bối cảnh văn hóa địa phương.

-

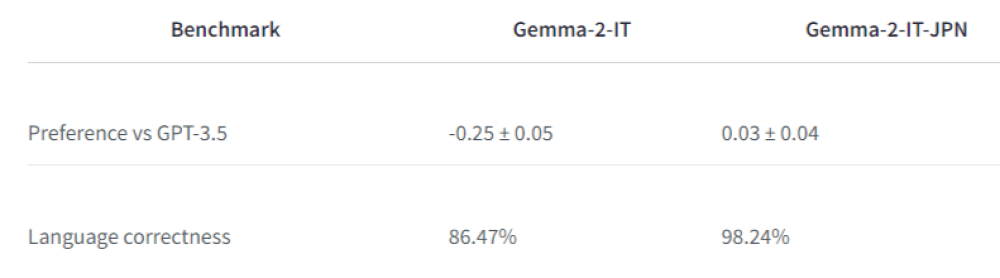

Các mô hình được phát triển không chỉ nói được tiếng địa phương như Hindi, Swahili, Xhosa, Arabic… mà còn hiểu sắc thái văn hóa và ngữ cảnh xã hội vùng miền.

-

InkubaLM là mô hình AI tạo sinh nhỏ với chỉ 0,4 tỷ tham số, nhưng có hiệu suất gần bằng các mô hình lớn; được huấn luyện bằng 5 ngôn ngữ châu Phi.

-

Ở Ấn Độ, dự án BharatGen được tài trợ 235 crore (khoảng 26 triệu Euro), phát triển các mô hình AI đa ngôn ngữ như e-vikrAI, IndicTrans2.

-

Các startup như Krutrim, Sarvam AI, và KissanAI phát triển công cụ AI hỗ trợ nông dân và người dân bằng ngôn ngữ bản địa.

-

Masakhane NLP và Deep Learning Indaba tại châu Phi thúc đẩy nghiên cứu phân tán với mô hình UlizaLlama (7 tỷ tham số) hỗ trợ các bà mẹ mới sinh.

-

Ả Rập Xê Út phát triển ALLaM (540 tỷ token tiếng Ả Rập) và thành lập công ty HUMAIN hợp tác với Amazon và NVIDIA.

-

UAE có các mô hình như Jais và Noor; Qatar xây dựng Fanar Prime, huấn luyện trên 1.000 tỷ token với thiết kế phản ánh đặc trưng ngữ pháp tiếng Ả Rập.

-

Thách thức chính gồm: thiếu dữ liệu ngôn ngữ bản địa, hạ tầng điện toán yếu, đầu tư thấp, và luật dữ liệu chưa rõ ràng.

-

Dù hạn chế về tài nguyên, các mô hình AI địa phương nhấn mạnh vào tác động thực tế và sở hữu cộng đồng, không chạy theo quy mô hay danh tiếng.

📌 Các quốc gia Nam bán cầu như Ấn Độ, Nam Phi và Ả Rập Xê Út đang tạo dựng hệ sinh thái AI bản địa để thoát khỏi phụ thuộc công nghệ phương Tây. Dù đối mặt hạn chế về dữ liệu và đầu tư, các mô hình như InkubaLM, ALLaM, BharatGen hay Fanar Prime thể hiện sự đổi mới trong cách tiếp cận AI: ưu tiên tính hiệu quả, văn hóa và nhu cầu thực tiễn hơn là cạnh tranh quy mô.

https://www.nature.com/immersive/d44151-025-00085-3/index.html

-

Gemma 3n E4B là phiên bản cao cấp trong dòng mô hình AI tạo sinh nhẹ của Google, được thiết kế để tối ưu hóa khả năng chạy trên thiết bị tài nguyên hạn chế, như smartphone và laptop.

-

Mô hình sử dụng kiến trúc Matformer và kỹ thuật selective parameter activation, giúp hoạt động hiệu quả với chỉ 4B tham số hiệu dụng dù có nhiều tham số hơn.

-

Hỗ trợ đầu vào văn bản, hình ảnh (tối đa 768x768), âm thanh (6.25 token/giây), với tổng ngữ cảnh đầu vào và đầu ra tối đa 32.000 token.

-

Được huấn luyện với 11.000 tỷ token từ hơn 140 ngôn ngữ, bao gồm văn bản web, mã lập trình, toán học, hình ảnh và âm thanh, giúp tăng khả năng đa nhiệm.

-

Benchmark nổi bật của E4B IT:

-

HellaSwag: 78,6%

-

BoolQ: 81,6%

-

TriviaQA: 70,2%

-

ARC-c: 61,6%

-

HumanEval (code): 75,0%

-

MMLU: 64,9%

-

MBPP: 63,6%

-

-

Hiệu suất trên Android với chip S25 Ultra:

-

dynamic_int4 CPU: 118 tokens/giây (prefill), 12,8 tokens/giây (decode), kích thước mô hình 4.201 MB

-

dynamic_int4 GPU: 446 tokens/giây (prefill), 16,1 tokens/giây (decode), bộ nhớ GPU sử dụng 3.048 MB

-

-

Đào tạo bằng TPU (TPUv4p, v5p, v5e) sử dụng JAX và ML Pathways để tăng tốc và đơn giản hóa quá trình phát triển.

-

Mô hình vượt qua các bài kiểm tra đạo đức và an toàn, giảm đáng kể vi phạm nội dung nghiêm trọng, với kiểm tra nội bộ không qua bộ lọc.

-

Hạn chế: có thể tạo thông tin sai, chưa hiểu rõ ngữ cảnh phức tạp, vẫn tồn tại thiên lệch dữ liệu và hạn chế lý luận như con người.

📌 Gemma 3n E4B là mô hình AI nguồn mở của Google có khả năng xử lý đa phương thức mạnh mẽ, tối ưu cho thiết bị giới hạn tài nguyên với hiệu suất vượt trội: 78,6% trên HellaSwag và 75% trên HumanEval. Được huấn luyện với 11.000 tỷ token từ 140 ngôn ngữ, mô hình mang lại sự kết hợp lý tưởng giữa nhẹ, mạnh và dễ tiếp cận cho cộng đồng phát triển.

https://huggingface.co/google/gemma-3n-E4B-it-litert-preview

-

Gemma 3n là dòng mô hình AI tạo sinh nguồn mở mới từ Google, được thiết kế nhẹ và hiệu quả, sử dụng kiến trúc “Matformer” và công nghệ “selective parameter activation” giúp hoạt động với chỉ 2B-4B tham số hiệu quả, giảm tải tính toán.

-

Mô hình hỗ trợ đầu vào đa phương thức gồm văn bản, hình ảnh (256x256 đến 768x768), âm thanh (6.25 token/giây) và có thể sinh văn bản đầu ra lên đến 32.000 token.

-

Gemma 3n được huấn luyện trên tập dữ liệu đa dạng khoảng 11.000 tỷ token với hơn 140 ngôn ngữ, bao gồm văn bản web, mã lập trình, toán học, hình ảnh và âm thanh.

-

Được tối ưu để chạy trên phần cứng hạn chế như CPU, GPU điện thoại với dung lượng mô hình chỉ 2.991 MB và sử dụng chuẩn dynamic_int4 giúp giảm bộ nhớ sử dụng.

-

Hiệu suất đo trên các benchmark nổi bật:

-

HellaSwag: 72,2% (E2B), 78,6% (E4B)

-

TriviaQA: 60,8% (E2B), 70,2% (E4B)

-

HumanEval (mã): 66,5% (E2B), 75,0% (E4B)

-

MMLU (ngôn ngữ): 60,1% (E2B), 64,9% (E4B)

-

-

Mô hình được đào tạo bằng phần cứng TPU (TPUv4p, TPUv5e) và phần mềm JAX cùng ML Pathways để dễ dàng triển khai và huấn luyện ở quy mô lớn.

-

Về an toàn, mô hình vượt qua nhiều đánh giá về nội dung nhạy cảm (CSAM, bạo lực, định kiến), với số vi phạm chính sách nghiêm trọng giảm rõ rệt so với các bản Gemma trước.

-

Hạn chế gồm: vẫn có thể thiên lệch do dữ liệu huấn luyện, xử lý ngôn ngữ mơ hồ kém và chưa có khả năng lý luận giống con người.

📌 Gemma 3n của Google là mô hình AI tạo sinh nguồn mở hiệu suất cao, được thiết kế để hoạt động hiệu quả trên thiết bị tài nguyên thấp. Với khả năng xử lý văn bản, hình ảnh và âm thanh, được huấn luyện từ 11.000 tỷ token trong hơn 140 ngôn ngữ, Gemma 3n đạt 78,6% trên HellaSwag và 75% trên HumanEval. Đây là bước tiến mạnh mẽ hướng đến AI từ cốt lõi dễ tiếp cận và an toàn.

https://huggingface.co/google/gemma-3n-E2B-it-litert-preview

-

Google công bố Gemma 3n, mô hình AI mới tối ưu cho thiết bị di động với khả năng xử lý nhanh, hiệu quả và riêng tư – hoạt động ngay cả khi không có kết nối mạng.

-

Là phiên bản mở rộng của dòng Gemma 3 và 3 QAT, Gemma 3n đánh dấu bước tiến mới khi có thể hoạt động trên điện thoại, máy tính bảng và laptop mà vẫn giữ được sức mạnh như trên máy chủ.

-

Được xây dựng hợp tác cùng Qualcomm, MediaTek và Samsung, Gemma 3n có kiến trúc mới hỗ trợ AI đa phương thức tốc độ cao, sử dụng bộ nhớ hiệu quả.

-

Per-Layer Embeddings (PLE) giúp mô hình 5B và 8B hoạt động với dung lượng RAM chỉ tương đương 2B hoặc 4B – chỉ cần 2GB đến 3GB bộ nhớ động.

-

Tính năng nổi bật của Gemma 3n:

-

Hiệu suất tối ưu trên thiết bị: phản hồi nhanh hơn 1,5 lần so với Gemma 3 4B.

-

Many-in-1: mô hình 4B có thể kích hoạt mô hình con 2B tùy theo độ phức tạp yêu cầu, linh hoạt giữa chất lượng và độ trễ.

-

Riêng tư và ngoại tuyến: hoạt động hoàn toàn trên thiết bị, bảo mật dữ liệu người dùng.

-

Hiểu âm thanh và hình ảnh: hỗ trợ nhận diện giọng nói, dịch giọng nói theo thời gian thực, hiểu nội dung video, và xử lý các input đan xen nhiều định dạng.

-

Hỗ trợ đa ngôn ngữ tốt hơn, đặc biệt tiếng Nhật, Đức, Hàn, Tây Ban Nha và Pháp, đạt 50,1% trên chuẩn WMT24++.

-

-

Gemma 3n cho phép xây dựng ứng dụng thông minh, nhận tín hiệu hình ảnh – âm thanh từ môi trường, xử lý ngay tại chỗ để tạo ra phản hồi phù hợp theo thời gian thực.

-

Các nhà phát triển có thể truy cập ngay hôm nay thông qua:

-

Google AI Studio: thử nghiệm trực tiếp trên trình duyệt.

-

Google AI Edge: xây dựng ứng dụng trực tiếp trên thiết bị.

-

-

Google cam kết phát triển AI có trách nhiệm, kiểm định an toàn và tinh chỉnh Gemma 3n theo các tiêu chuẩn bảo mật cao nhất.

📌 Google giới thiệu Gemma 3n – mô hình AI nguồn mở mạnh mẽ dành riêng cho thiết bị di động, có khả năng xử lý văn bản, âm thanh và hình ảnh một cách riêng tư và hiệu quả. Với công nghệ Per-Layer Embeddings và kiến trúc Many-in-1, Gemma 3n hoạt động mượt mà với chỉ 2–3GB RAM. Người dùng có thể thử nghiệm ngay hôm nay qua Google AI Studio hoặc tích hợp với Google AI Edge, mở ra kỷ nguyên AI di động thông minh, riêng tư và tức thì.

https://developers.googleblog.com/en/introducing-gemma-3n/

-

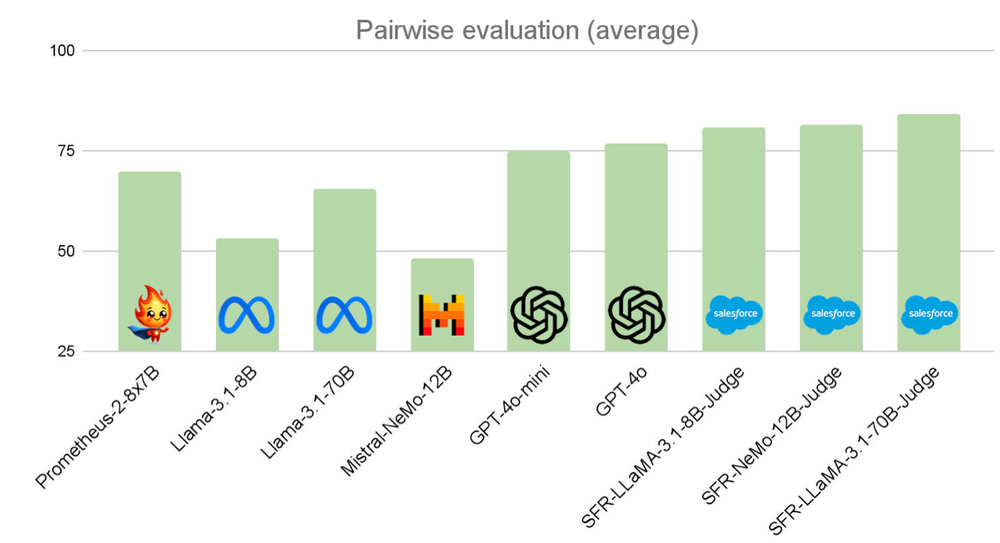

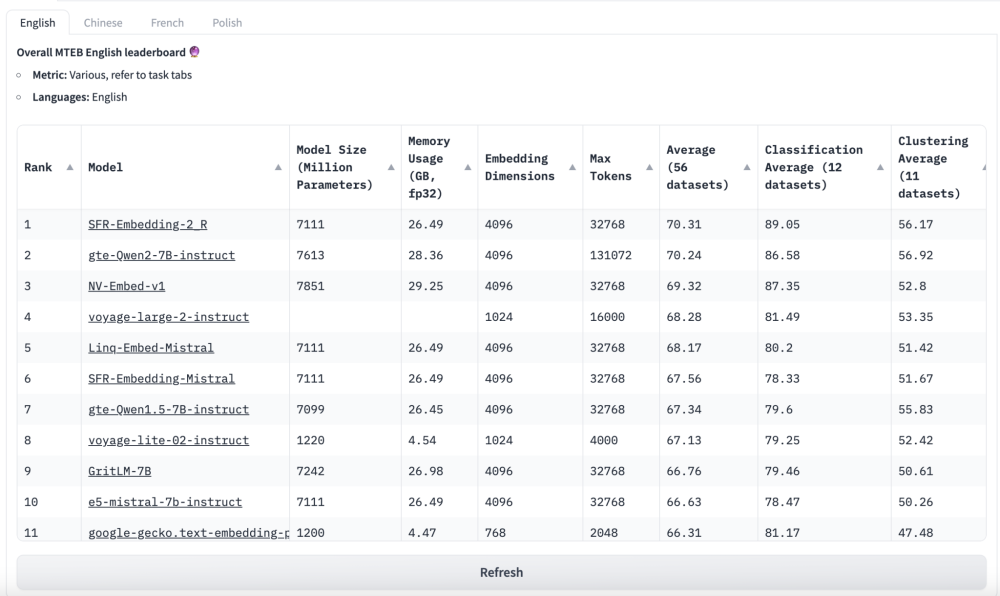

Salesforce AI Research vừa giới thiệu xGen-small, một mô hình ngôn ngữ nhỏ gọn tối ưu hóa cho môi trường doanh nghiệp, giải quyết các bài toán về ngữ cảnh dài, chi phí inference, và bảo mật dữ liệu nội bộ.

-

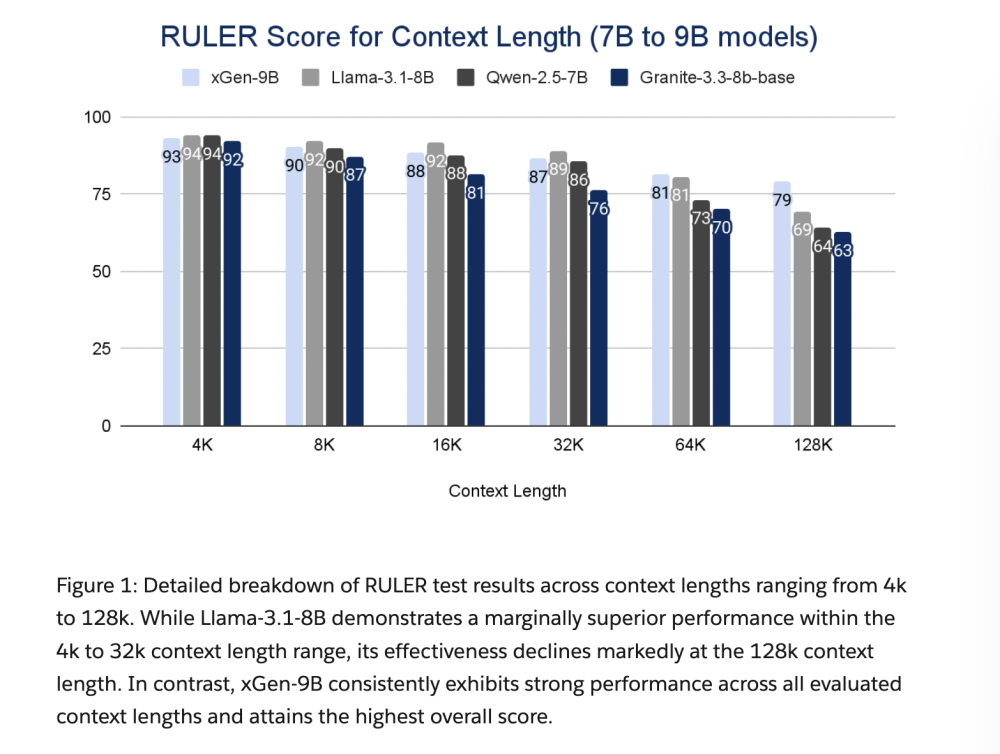

Trong khi các LLM lớn gặp giới hạn do chi phí và yêu cầu phần cứng, xGen-small sử dụng chiến lược "small but long" – giảm kích thước mô hình nhưng mở rộng năng lực xử lý ngữ cảnh, từ 4K đến 128K token ổn định, thậm chí huấn luyện vượt chuẩn đến 256K.

-

Mô hình được huấn luyện trên TPU v5p, sử dụng thư viện Jaxformer v8 và kỹ thuật tối ưu như FSDP, sequence-parallel attention và splash kernels giúp tiết kiệm tài nguyên nhưng vẫn đạt hiệu suất cao.

-

Dữ liệu huấn luyện trải rộng từ code entropy thấp, ngôn ngữ tự nhiên entropy cao, đến nội dung toán học và tài liệu chuyên ngành – đảm bảo sự đa dạng và độ chính xác cao.

-

Với hơn 8 nghìn tỷ token được chọn lọc kỹ lưỡng, quy trình lọc bao gồm kiểm tra spam, loại bỏ trùng lặp bằng hashing, và cân bằng giữa dữ liệu tổng quát và chuyên biệt, giúp mô hình thích ứng tốt với môi trường doanh nghiệp.

-

Khác với RAG hay memory hack – vốn là các phương pháp "vá" để vượt giới hạn ngữ cảnh, xGen-small tích hợp khả năng ngữ cảnh dài gốc, giúp xử lý trọn vẹn tài liệu, đoạn mã, báo cáo nghiên cứu mà không cần truy xuất ngoài.

-

Đánh giá hiệu năng cho thấy xGen-small 9B đạt vị trí dẫn đầu trên RULER benchmark, trong khi bản 4B đứng thứ hai trong phân khúc – chứng minh rằng mô hình nhỏ vẫn có thể cạnh tranh với đối thủ lớn hơn.

-

Giai đoạn huấn luyện hậu kỳ gồm hai bước: fine-tuning theo chỉ dẫn với tập lệnh đa lĩnh vực và reinforcement learning quy mô lớn, giúp tăng khả năng lập luận, đặc biệt trong các tác vụ STEM và logic phức tạp.

-

xGen-small cung cấp lợi thế chiến lược cho doanh nghiệp: hiệu suất ổn định, bảo mật dữ liệu nội bộ cao, không cần hạ tầng GPU tốn kém, đồng thời duy trì khả năng hiểu ngữ cảnh dài – điều mà phần lớn LLM lớn vẫn còn khó khăn.

-

Kiến trúc này đánh dấu bước chuyển quan trọng trong hướng phát triển AI doanh nghiệp bền vững, không đốt tài nguyên nhưng vẫn đạt hiệu quả tối đa trong các quy trình nội bộ khối lượng lớn.

📌 xGen-small của Salesforce là bước ngoặt trong AI doanh nghiệp: mô hình chỉ 4B–9B nhưng xử lý ngữ cảnh tới 128K token ổn định, đạt top đầu trên RULER benchmark, và giảm thiểu chi phí phần cứng. Với kiến trúc "small but long" cùng quy trình huấn luyện tối ưu, xGen-small là lựa chọn lý tưởng cho doanh nghiệp cần AI mạnh, tiết kiệm và bảo mật.

https://www.marktechpost.com/2025/05/09/enterprise-ai-without-gpu-burn-salesforces-xgen-small-optimizes-for-context-cost-and-privacy/

-

Small Language Model (SLM) là mô hình AI được huấn luyện với dữ liệu nhỏ (dưới 10 tỷ tham số), tối ưu cho các tác vụ cụ thể như phân tích phản hồi khách hàng, tạo mô tả sản phẩm, hay xử lý ngôn ngữ chuyên ngành.

-

Nhờ dung lượng nhỏ và yêu cầu tính toán thấp, SLM có thể chạy trên thiết bị di động, IoT và không cần kết nối đám mây, giúp tiết kiệm năng lượng và tăng tốc độ xử lý.

-

Các ứng dụng thực tế của SLM bao gồm: kỹ sư hiện trường sử dụng SLM để tra cứu tài liệu kỹ thuật mà không cần internet; nhân viên bán hàng truy xuất dữ liệu nhạy cảm tại điểm gặp khách hàng; bác sĩ phân tích dữ liệu bệnh nhân tại chỗ nhằm đảm bảo quyền riêng tư.

-

Doanh nghiệp không thay thế hoàn toàn LLM bằng SLM mà sử dụng kết hợp, tạo danh mục mô hình theo từng kịch bản cụ thể: LLM đảm nhận chiến lược vĩ mô, còn SLM xử lý các nhiệm vụ bộ phận cụ thể như phản hồi mạng xã hội, mô tả sản phẩm...

-

Tuy hiệu quả, SLM vẫn có giới hạn: kém chính xác với ngôn ngữ phức tạp, kiến thức hạn chế, dễ sinh lỗi như LLM và đòi hỏi đội ngũ chuyên môn để huấn luyện và vận hành.

-

Quản lý và bảo mật vẫn là yếu tố then chốt: doanh nghiệp cần chính sách AI rõ ràng, chuyên gia dữ liệu, và bộ phận kiểm soát rủi ro – kể cả với mô hình nhỏ.

-

Vấn đề chi phí cũng cần lưu ý: nếu dùng đồng thời nhiều SLM, chi phí tài nguyên (GPU, điện, bảo trì) có thể cao hơn một LLM duy nhất phục vụ nhiều mục đích.

-

Trước khi chọn SLM, doanh nghiệp cần xem xét: quy mô và tính ổn định dữ liệu, độ chính xác cần thiết, và nhu cầu mở rộng trong tương lai.

-

Trong tương lai, danh mục AI lý tưởng sẽ là sự pha trộn giữa LLM và nhiều SLM, tùy theo từng tình huống kinh doanh cụ thể.

📌 SLM giúp doanh nghiệp tiết kiệm chi phí, tăng tốc độ xử lý và bảo mật dữ liệu cục bộ – lý tưởng cho các tác vụ chuyên biệt. Dù không thay thế LLM, SLM đóng vai trò thiết yếu trong chiến lược AI đa mô hình, giúp phân bổ tài nguyên hiệu quả và đáp ứng nhiều nhu cầu kinh doanh khác nhau.

https://www.forbes.com/sites/sap/2025/05/09/how-small-language-models-deliver-big-business-benefits/

-

Nhu cầu về AI tạo sinh chuyên biệt cho nghiệp vụ đang thúc đẩy ứng dụng mô hình ngôn ngữ nhỏ (SLM) trong doanh nghiệp.

-

Báo cáo Gartner dự báo đến năm 2027, số lượt sử dụng SLM sẽ gấp ít nhất 3 lần mô hình ngôn ngữ lớn (LLM), do SLM phù hợp xử lý tác vụ đặc thù, giảm chi phí vận hành và hạn chế rủi ro về bảo mật.

-

SLM được đánh giá cao nhờ khả năng phản hồi nhanh, ít tiêu tốn tài nguyên tính toán cũng như đảm bảo chính xác hơn nhờ đào tạo trên dữ liệu nghiệp vụ cụ thể.

-

Sự lấn át của SLM diễn ra song song với quan ngại về hiện tượng ảo giác (hallucination) ở LLM khi xử lý các ngữ cảnh hoặc ngành nghề chuyên biệt, như tài chính và y tế, dễ phát sinh kết quả sai lệch.

-

Nhiều doanh nghiệp lớn như Microsoft, Google, Meta đã tung ra các SLM tiêu biểu như Phi, Gemma, Llama 3.1 đáp ứng nhu cầu triển khai nhanh, bảo vệ dữ liệu nội bộ, vận hành linh hoạt trên thiết bị phổ thông (chỉ cần 1 GPU).

-

Microsoft hợp tác nhiều đối tác ngành như Bayer, Siemens phát triển bản SLM tối ưu hóa cho từng lĩnh vực, giảm thời gian và chi phí áp dụng AI thực tiễn.

-

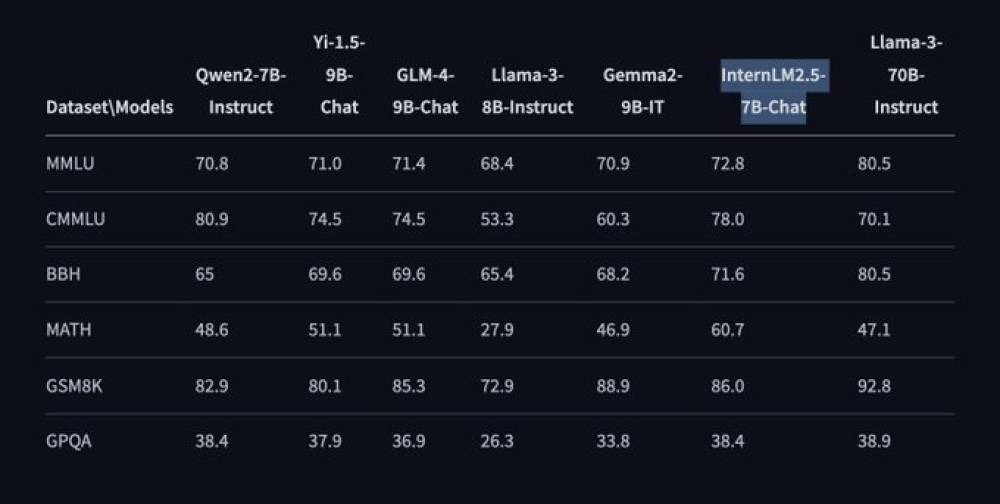

Google Gemma 3 tận dụng trí tuệ ngành nghề đặc thù, cho phép vận hành nhanh trên thiết bị cá nhân và vượt trội LLM ở các tác vụ chuyên sâu như y tế, pháp lý, tài chính.

-

SLM mã nguồn mở, chạy kín sau tường lửa, giúp doanh nghiệp kiểm soát dữ liệu, đáp ứng tiêu chuẩn tuân thủ và tối ưu chi phí quản lý, bảo mật.

-

Một số doanh nghiệp chú trọng kết hợp mô hình lớn với SLM chuyên biệt, lấy LLM làm nền tảng và SLM làm lớp ứng dụng chuyên sâu, tạo hệ AI vừa mở rộng được vừa tối ưu cho nhu cầu nội bộ.

-

Việc tùy chỉnh LLM thông qua các kỹ thuật như tạo sinh được tăng cường bởi truy xuất dữ liệu ngoài (retrieval-augmented generation) giúp tạo ra SLM đáp ứng bài toán thực tế hơn, hạn chế vấn đề ảo giác và tăng hiệu quả triển khai AI đặc thù.

📌 Đến năm 2027, doanh nghiệp dự kiến sử dụng SLM nhiều gấp 3 lần so với LLM nhờ tính tối ưu hóa nghiệp vụ, giảm chi phí, tăng bảo mật và độ chính xác. SLM mã nguồn mở, vận hành nội bộ ngày càng được ưa chuộng, đặc biệt trong các ngành quy định chặt chẽ như y tế, tài chính, góp phần thúc đẩy chuyển đổi số hiệu quả.

https://www.cio.com/article/3974073/it-leaders-see-big-business-potential-in-small-ai-models.html

-

Alibaba vừa ra mắt Qwen2.5-Omni-3B – phiên bản 3 tỷ tham số, nhỏ gọn của mô hình đa phương thức Qwen2.5-Omni, có thể chạy trực tiếp trên PC và laptop phổ thông.

-

Model này giữ trên 90% hiệu năng của phiên bản lớn (7B) dù chỉ bằng ½ số tham số (3B vs 7B).

-

Qwen2.5-Omni-3B xử lý mượt mà cả văn bản, âm thanh, hình ảnh và video; hỗ trợ tạo sinh đồng thời văn bản và âm thanh theo thời gian thực.

-

Tối ưu bộ nhớ GPU mạnh mẽ: xử lý dải input dài 25.000 tokens chỉ cần 28.2 GB VRAM, giảm hơn 50% so với bản 7B (60.2 GB), có thể chạy trên GPU phổ biến 24GB ở desktop/laptop; không cần cụm GPU lớn.

-

Thiết kế kiến trúc tối ưu gồm Thinker-Talker, embedding vị trí tùy biến TMRoPE giúp đồng bộ video-audio.

-

Hiệu suất benchmark:

-

OmniBench (lý luận đa phương thức): 52,2 (so với 56,1 của 7B)

-

VideoBench (hiểu âm thanh): 68,8 (so với 74,1)

-

MMMU (lý luận hình ảnh): 53,1 (so với 59,2)

-

MVBench (lý luận video): 68,7 (so với 70,3)

-

Seed-tts-eval (tạo sinh giọng nói): 92,1 (so với 93,5)

-

-

Tính năng cá nhân hóa giọng nói: chọn 2 voice (Chelsie nữ, Ethan nam), tùy mục đích ứng dụng.

-

Có thể tắt tạo âm thanh để giảm thêm bộ nhớ, linh hoạt đầu ra văn bản hoặc audio.

-

Hỗ trợ Hugging Face, Docker, vLLM, FlashAttention 2, BF16, lưu trữ trên Hugging Face, GitHub, ModelScope.

-

Nguồn mở cho nghiên cứu, cấm sử dụng thương mại nếu không xin giấy phép riêng từ Alibaba. Được phép thử nghiệm, tinh chỉnh nội bộ.

-

Qwen2.5-Omni-3B phù hợp để làm testbed thử nghiệm tính khả thi, tinh chỉnh pipeline nội bộ, đánh giá kiến trúc trước khi thương mại hóa.

-

Dễ tiếp cận AI đa phương thức cho cá nhân, đội nhóm nghiên cứu nhờ rào cản phần cứng thấp, nhưng cần lưu ý hạn chế pháp lý về thương mại.

📌 Alibaba ra mắt Qwen2.5-Omni-3B – mô hình AI đa phương thức chỉ 3 tỷ tham số, chạy mượt trên laptop/PC phổ thông, giảm VRAM hơn 50%, hiệu năng đạt trên 90% bản lớn, nhưng bị hạn chế sử dụng thương mại nếu chưa xin phép, phù hợp thử nghiệm, nghiên cứu AI đa phương thức.

https://venturebeat.com/ai/qwen-swings-for-a-double-with-2-5-omni-3b-model-that-runs-on-consumer-pcs-laptops/

-

Microsoft Research công bố Phi-4-Reasoning-Plus – mô hình ngôn ngữ 14 tỷ tham số chuyên lý luận, mã nguồn mở, mạnh mẽ và tối ưu cho các tác vụ toán học, khoa học, lập trình và logic.

-

Mô hình áp dụng kiến trúc Transformer dạng dense decoder-only, đào tạo trên 16 tỷ token (8,3 tỷ token độc nhất) lấy từ dữ liệu tổng hợp cùng dữ liệu web được chọn lọc.

-

Tinh chỉnh với học tăng cường (reinforcement learning) sử dụng khoảng 6.400 bài toán toán học giúp tăng cường năng lực lý luận của mô hình.

-

Phát hành theo giấy phép MIT dễ dàng cho thương mại, tinh chỉnh, distill, không ràng buộc – tương thích với Hugging Face Transformers, vLLM, llama.cpp và Ollama.

-

Dù chỉ 14 tỷ tham số, Phi-4-Reasoning-Plus vẫn vượt hiệu năng nhiều mô hình lớn hơn như DeepSeek-R1-Distill-70B trên các chuẩn đối chiếu.

-

Trên AIME 2025, mô hình đạt tỉ lệ pass@1 cao hơn Distill-70B (70 tỷ tham số), gần bằng “anh cả” DeepSeek-R1 (671 tỷ tham số).

-

Quá trình huấn luyện nhấn mạnh tách biệt các bước suy luận trung gian với kết quả cuối cùng thông qua token <think> và </think>, tăng độ minh bạch và chặt chẽ trong lập luận.

-

RL sử dụng thuật toán GRPO, tối ưu hóa cân bằng giữa độ chính xác, súc tích, tránh lặp lại, và nhất quán định dạng – giúp mô hình trả lời sâu sắc hơn, đặc biệt với câu hỏi khó.

-

Hỗ trợ ngữ cảnh (context) mặc định 32.000 token, thử nghiệm ổn định đến 64.000 token – thích hợp cho ứng dụng xử lý tài liệu, phân tích pháp lý, mô hình tài chính.

-

Tối ưu cho môi trường hạn chế bộ nhớ/độ trễ, hiệu quả trong chat, tích hợp dễ dàng nhờ hướng dẫn chi tiết về tham số và prompt tối ưu.

-

Microsoft đã kiểm tra an toàn kỹ lưỡng bằng red-team nội bộ và công cụ như Toxigen, khuyến cáo kiểm tra thêm trước khi dùng trong môi trường rủi ro cao.

-

Định dạng xuất suy luận trung gian dễ tích hợp vào hệ thống kiểm toán, hạ tầng logging, nâng cao explainability.

-

Các nhóm kỹ thuật có thể tiết kiệm chi phí hạ tầng, tận dụng mô hình nhỏ nhưng hiệu năng “gần đại gia” cho bài toán thực tế.

-

Mô hình thể hiện khả năng khái quát hoá ra ngoài miền huấn luyện, giải được cả bài toán NP-hard như 3SAT, TSP, ứng dụng mạnh trong hỗ trợ quyết định, hoạch định thuật toán.

-

Dành cho lãnh đạo kỹ thuật doanh nghiệp: giải pháp linh hoạt, dễ mở rộng, kiểm soát rủi ro, tối ưu chi phí trong triển khai AI tạo sinh.

📌 Phi-4-Reasoning-Plus của Microsoft chỉ 14 tỷ tham số nhưng hiệu năng vượt nhiều “ông lớn”, cho phép thương mại, tích hợp linh hoạt, lý luận vượt trội các bài toán toán học, logic, lập trình. Định dạng kết quả tăng tính minh bạch, hỗ trợ phân tích sâu, kiểm toán. An toàn được kiểm thử toàn diện, tối ưu chi phí vận hành cho doanh nghiệp.

https://venturebeat.com/ai/microsoft-launches-phi-4-reasoning-plus-a-small-powerful-open-weights-reasoning-model/

-

Xiaomi vừa công bố mô hình AI nguồn mở MiMo với 7 tỷ tham số, được phát triển hoàn toàn nội bộ bởi đội ngũ chuyên trách AI tên Core.

-

MiMo vượt trội hơn OpenAI o1-mini và Alibaba QwQ-32B-Preview (thuộc dòng Qwen) trong các bài kiểm tra về khả năng suy luận toán học và lập trình, theo thông báo của Xiaomi.

-

MiMo được phát triển nhằm tích hợp AI tạo sinh vào các sản phẩm phần cứng như điện thoại, xe điện, củng cố chiến lược “AI từ cốt lõi” của Xiaomi.

-

Cổ phiếu Xiaomi trên sàn Hồng Kông tăng 4,7% ngay sáng thứ sáu, trong khi cổ phiếu Kingsoft Cloud Holdings (Xiaomi nắm 10%, CEO Lei Jun sở hữu 11%) tăng tới 15,3%.

-

Để huấn luyện MiMo, Xiaomi đã đầu tư mua khoảng 10.000 card đồ họa vào cuối năm 2024, thể hiện tiềm lực công nghệ và tài chính lớn.

-

Xiaomi từng nỗ lực mời Luo Fuli – “nữ thiên tài AI” từ DeepSeek và là người phát triển DeepSeek-V2 – về làm việc nhưng không thành công.

-

Động thái ra mắt MiMo diễn ra giữa làn sóng cạnh tranh dữ dội giữa các ông lớn công nghệ Trung Quốc, khi AI tạo sinh ngày càng có giá trị thương mại khi tích hợp vào sản phẩm.

-

Alibaba vừa công bố Qwen3, thế hệ thứ ba của dòng mô hình Qwen, gồm 8 kích thước tham số từ 600 triệu đến 235 tỷ, tăng tốc độ xử lý và mở rộng năng lực đa ngôn ngữ.

-

Thị trường AI Trung Quốc trong 2 năm qua chứng kiến sự bùng nổ các mô hình nền tảng, với cạnh tranh về quy mô, hiệu suất và ứng dụng thương mại.

📌 Xiaomi chính thức gia nhập cuộc đua AI tạo sinh với MiMo, mô hình 7 tỷ tham số, vượt mặt OpenAI o1-mini và Alibaba QwQ-32B ở toán và lập trình, giúp cổ phiếu công ty tăng 4,7%. Đầu tư mạnh vào hạ tầng, Xiaomi khẳng định vị thế mới trên thị trường AI phần cứng Trung Quốc.

https://www.scmp.com/tech/big-tech/article/3308483/smartphone-giant-xiaomi-unveils-ai-model-joining-fierce-competition-china

-

Microsoft vừa công bố BitNet b1.58 2B4T, mô hình AI nén 1-bit lớn nhất từng được phát triển với 2 tỷ tham số.

-

BitNet b1.58 2B4T mã nguồn mở theo giấy phép MIT, cho phép mọi người truy cập và sử dụng miễn phí.

-

BitNet là AI nén đặc biệt khi trọng số chỉ nhận giá trị -1, 0, 1, giúp giảm mạnh nhu cầu bộ nhớ và tăng tốc độ tính toán.

-

Mô hình được huấn luyện trên 4 tỷ tokens (tương đương khoảng 33.000.000 cuốn sách), vượt trội về quy mô so với nhiều mô hình hiện nay.

-

BitNet b1.58 2B4T có thể chạy trên CPU phổ thông như Apple M2, không cần GPU, điều mà hầu hết AI lớn hiện nay không làm được.

-

Trong kiểm thử, BitNet b1.58 2B4T vượt qua các đối thủ 2 tỷ tham số như Meta Llama 3.2 1B, Google Gemma 3 1B, Alibaba Qwen 2.5 1.5B ở các bài toán GSM8K (toán tiểu học) và PIQA (suy luận vật lý thông thường).

-

Tốc độ xử lý của BitNet b1.58 2B4T nhanh gấp 2 lần so với các mô hình cùng quy mô, sử dụng ít bộ nhớ hơn đáng kể.

-

Mô hình cần framework riêng bitnet.cpp của Microsoft để khai thác tối ưu hiệu suất, hiện chỉ hỗ trợ một số CPU nhất định.

-

BitNet b1.58 2B4T chưa hỗ trợ GPU, trong khi GPU vẫn là nền tảng chính của hạ tầng AI hiện tại.

-

Dù còn hạn chế về khả năng tương thích, BitNet mở ra triển vọng lớn cho AI chạy trên thiết bị tài nguyên thấp, phục vụ nhiều ứng dụng mới.

📌 Microsoft ra mắt BitNet b1.58 2B4T với 2 tỷ tham số, chạy nhanh gấp đôi các mô hình AI cùng loại trên CPU phổ thông, vượt qua các đối thủ lớn ở nhiều bài kiểm tra, mã nguồn mở, nhưng hiện chỉ hỗ trợ một số CPU, chưa tương thích GPU – hứa hẹn thay đổi cuộc chơi AI tiết kiệm tài nguyên.

https://techcrunch.com/2025/04/16/microsoft-researchers-say-theyve-developed-a-hyper-efficient-ai-model-that-can-run-on-cpus/

-

Mô hình ngôn ngữ lớn (LLM) hoạt động hiệu quả nhờ quy mô khổng lồ với hàng trăm tỷ tham số, giúp chúng nhận diện mẫu và kết nối tốt hơn, từ đó trở nên mạnh mẽ và chính xác hơn.

-

Tuy nhiên, việc huấn luyện LLM tiêu tốn tài nguyên tính toán khổng lồ. Google đã chi khoảng 191 triệu USD để huấn luyện mô hình Gemini 1.0 Ultra của họ.

-

LLM cũng tiêu thụ năng lượng đáng kể khi xử lý mỗi yêu cầu. Theo Viện Nghiên cứu Điện lực, một truy vấn đến ChatGPT tiêu thụ gấp khoảng 10 lần năng lượng so với một lần tìm kiếm Google.

-

Giải pháp đang nổi lên là mô hình ngôn ngữ nhỏ (SLM) với chỉ vài tỷ tham số. IBM, Google, Microsoft và OpenAI đều đã phát hành các SLM gần đây.

-

SLM không phải công cụ đa năng như LLM nhưng có thể xuất sắc trong các tác vụ cụ thể như tóm tắt cuộc hội thoại, chatbot chăm sóc sức khỏe hay thu thập dữ liệu trên thiết bị thông minh.

-

Zico Kolter, nhà khoa học máy tính tại Đại học Carnegie Mellon cho biết: "Với nhiều tác vụ, mô hình với 8 tỷ tham số thực sự khá tốt."

-

SLM có thể chạy trên laptop hoặc điện thoại di động thay vì cần trung tâm dữ liệu lớn.

-

Các kỹ thuật tối ưu hóa quá trình huấn luyện SLM bao gồm "knowledge distillation" (chưng cất kiến thức) - khi mô hình lớn tạo ra bộ dữ liệu chất lượng cao để huấn luyện mô hình nhỏ, giống như giáo viên truyền đạt bài học cho học sinh.

-

Phương pháp "pruning" (cắt tỉa) loại bỏ các phần không cần thiết của mạng neural, lấy cảm hứng từ não người. Yann LeCun đã đề xuất rằng có thể loại bỏ đến 90% tham số trong mạng neural đã được huấn luyện mà không làm giảm hiệu quả.

-

Leshem Choshen, nhà khoa học nghiên cứu tại MIT-IBM Watson AI Lab, cho biết SLM cho phép các nhà nghiên cứu thử nghiệm với rủi ro thấp hơn và lý luận của chúng có thể minh bạch hơn do có ít tham số hơn.

-

Mô hình lớn, tốn kém vẫn hữu ích cho chatbot tổng quát, trình tạo hình ảnh và khám phá thuốc. Nhưng với nhiều người dùng, mô hình nhỏ, có mục tiêu cụ thể sẽ hoạt động tốt tương đương, đồng thời dễ dàng hơn cho các nhà nghiên cứu huấn luyện và xây dựng.

-

Choshen kết luận: "Các mô hình hiệu quả này có thể tiết kiệm tiền bạc, thời gian và năng lực tính toán."

📌 Mô hình ngôn ngữ nhỏ (SLM) đang trở thành xu hướng với chỉ vài tỷ tham số, tiêu thụ năng lượng thấp hơn 10 lần so với tìm kiếm Google thông thường. IBM, Google, Microsoft và OpenAI đều đã phát hành SLM để thực hiện các tác vụ cụ thể với hiệu quả cao, có thể chạy trên thiết bị cá nhân thay vì trung tâm dữ liệu.

https://www.wired.com/story/why-researchers-are-turning-to-small-language-models/

- Các công ty AI Nhật Bản đang biến hạn chế thành lợi thế bằng cách phát triển mô hình AI nhỏ gọn và hiệu quả, lấy cảm hứng từ thành công của startup DeepSeek của Trung Quốc.

- NTT đã tạo ra mô hình nền tảng "tsuzumi" với chỉ 600 triệu tham số trong phiên bản nhỏ nhất, đủ nhỏ để chạy trên máy tính xách tay thông thường, trong khi một số mô hình tiên tiến có hơn 1 nghìn tỷ tham số.

- Takanobu Oba, giám đốc Human Insight Laboratory tại NTT, ước tính chi phí phát triển mô hình của họ chỉ bằng "vài phần trăm đến vài phần nghìn" so với chi phí của một số mô hình ChatGPT.

- Mô hình 7 tỷ tham số của tsuzumi vượt trội hơn ChatGPT-3.5 trong một số nhiệm vụ, với tỷ lệ chiến thắng 81,3% trong xử lý ngôn ngữ tiếng Nhật, theo NTT.

- DeepSeek-R1, mô hình được công ty khởi nghiệp Trung Quốc phát hành vào tháng 1, gây sốc khi đạt hiệu suất tương tự như mô hình o1 của OpenAI nhưng với chi phí thấp hơn nhiều.

- Naoaki Okazaki, giáo sư tại Viện Công nghệ Tokyo, cho biết mô hình khoảng 8 đến 10 tỷ tham số dễ xử lý hơn nhiều và có thể hoạt động tốt tùy theo nhiệm vụ.

- Sam Altman, CEO của OpenAI, vẫn tin rằng mô hình AI đắt đỏ có thể mang lại lợi nhuận đủ lớn, tuyên bố "lợi nhuận còn tăng theo cấp số nhân hơn cả chi phí".

- Theo Bloomberg, OpenAI dự kiến doanh thu 12,7 tỷ USD năm nay nhưng không kỳ vọng dòng tiền dương cho đến năm 2029.

- Startup Sakana AI của Tokyo đã phát triển công nghệ nâng cao khả năng của các mô hình AI hiện có thông qua cách tiếp cận tiến hóa, tự động chọn mô hình tốt nhất và kết hợp chúng.

- David Ha, CEO của Sakana AI, nhấn mạnh rằng việc đào tạo mô hình lớn rất tốn kém và các mô hình này là "tài sản mất giá nhanh nhất trong lịch sử loài người", thúc đẩy chiến lược tạo mô hình ngôn ngữ lớn với giá "một phần tỷ".

- Kirk Boodry, nhà phân tích tại Astris Advisory Japan, chỉ ra rằng các công ty Nhật Bản tập trung vào mô hình nhỏ hơn, hiệu quả hơn một phần vì giới hạn của hệ thống điện (Nhật Bản nhập khẩu hơn 80% năng lượng) và GPU dùng cho AI tiêu thụ rất nhiều điện.

📌 Các công ty AI Nhật Bản như NTT và Sakana AI đang đi ngược xu hướng đầu tư khổng lồ vào mô hình AI lớn bằng cách phát triển mô hình nhỏ gọn, tiết kiệm chi phí gấp hàng nghìn lần. Mô hình tsuzumi 7 tỷ tham số của NTT đã đánh bại ChatGPT-3.5 trong xử lý tiếng Nhật với tỷ lệ thắng 81,3%, chứng minh rằng "sự cần thiết là mẹ đẻ của đổi mới."

https://asia.nikkei.com/Business/Technology/Not-just-DeepSeek-Japan-s-AI-players-chase-efficiency-over-size

Không chỉ DeepSeek: Các công ty AI Nhật Bản theo đuổi hiệu quả hơn quy mô

Các công ty hướng đến việc biến giới hạn thành thế mạnh khi cạnh tranh với các đối thủ lớn toàn cầu

Japan AI montage] Một số nhà phát triển cho rằng sự thiếu hụt vốn của Nhật Bản so với các công ty công nghệ lớn ở Mỹ sẽ thúc đẩy đổi mới AI. (Nikkei montage)

RYOHTAROH SATOH Ngày 10 tháng 4 năm 2025 10:42 JST

TOKYO -- Các công ty AI Nhật Bản đang tìm cách biến những hạn chế thành thế mạnh khi thành công nhanh chóng của startup Trung Quốc DeepSeek nổi bật lên những lợi ích của việc phát triển các mô hình trí tuệ nhân tạo nhỏ gọn và hiệu quả hơn.

Một số nhà phát triển cho rằng sự thiếu hụt vốn của quốc đảo này so với các công ty công nghệ lớn ở Mỹ sẽ thúc đẩy đổi mới.

"Chính vì những hạn chế, vì mọi thứ nhỏ bé, mà chúng tôi buộc phải đổi mới," Takanobu Oba, giám đốc Phòng thí nghiệm Human Insight tại hãng viễn thông NTT, nói với Nikkei Asia.

NTT đã tạo ra mô hình nền tảng riêng vào năm ngoái -- công nghệ cơ bản cho các chatbot AI -- có tên "tsuzumi". Oba cho biết, những mô hình như vậy "sẽ không thể tránh khỏi việc trở nên nhỏ hơn".

Tsuzumi đã rất nhỏ gọn và hiệu quả về chi phí so với các mô hình của các ông lớn toàn cầu như ChatGPT của OpenAI. Trong khi một số mô hình tiên tiến được ước tính có hơn 1 nghìn tỷ tham số -- một đơn vị đo lường dữ liệu được sử dụng trong quá trình đào tạo AI -- phiên bản nhỏ nhất của tsuzumi chỉ chứa 600 triệu tham số. Con số này đủ nhỏ để một máy tính xách tay có thể xử lý.

Các mô hình AI lớn hơn thường chạy trên các trung tâm dữ liệu sử dụng số lượng lớn đơn vị xử lý đồ họa (GPU) được thiết kế bởi Nvidia, không hề rẻ. Ví dụ, chip H100 đặc trưng của Nvidia có thể có giá từ 30.000 đến 35.000 đô la mỗi chiếc. Oba ước tính rằng chi phí cho NTT để phát triển các mô hình của họ chỉ bằng "vài phần trăm đến vài phần nghìn" chi phí của một số mô hình ChatGPT.

Niềm tin thông thường cho rằng nhiều dữ liệu đồng nghĩa với hiệu suất tốt hơn, dẫn đến quan niệm rằng mô hình lớn hơn thì thông minh hơn. Khả năng của tsuzumi dường như thách thức điều này, với mô hình 7 tỷ tham số vượt trội hơn ChatGPT-3.5 trong một số nhiệm vụ, với tỷ lệ thắng 81,3% trong xử lý ngôn ngữ tiếng Nhật, theo NTT. Bài kiểm tra được thực hiện bởi một nhóm nghiên cứu độc lập, sử dụng mô hình ChatGPT mới hơn làm trọng tài.

DeepSeek-R1, một mô hình mà startup Trung Quốc phát hành vào tháng 1, đã gây sốc cho Thung lũng Silicon và Phố Wall sau khi tuyên bố đạt được mức hiệu suất tương tự như mô hình o1 của OpenAI với chi phí chỉ bằng một phần nhỏ. Điều này đã gây nghi ngờ về cuộc đua đầu tư cho tham số hiện tại, bao gồm cả OpenAI, dự định đầu tư hàng trăm tỷ đô la vào các trung tâm dữ liệu thông qua chương trình Stargate của SoftBank.

"Nếu một mô hình quá lớn, sẽ khó sử dụng. Chi phí cao hơn, và bạn cần phần cứng mạnh. Khoảng 8 đến 10 tỷ tham số dễ xử lý hơn nhiều, và tùy thuộc vào nhiệm vụ, nó có thể hoạt động đầy đủ," Naoaki Okazaki, giáo sư tại Viện Công nghệ Tokyo nói. "Điều thường thu hút sự chú ý -- 'tác phẩm trưng bày', nói một cách khác -- là việc phát triển các mô hình quy mô lớn," Okazaki nói. Nhưng từ góc độ thực tiễn, ông nói thêm, các mô hình nhỏ hơn, đặc biệt là những mô hình được tăng cường trong ngôn ngữ địa phương, là giải pháp hiệu quả hơn.

Vẫn còn một số tranh luận về việc liệu cuộc đua đầu tư cho những tiến bộ AI sẽ kết thúc hay không. Sam Altman, CEO của OpenAI, đã nói trong một cuộc thảo luận tại Tokyo vào tháng 2 rằng một mô hình AI đắt tiền vẫn có thể mang lại lợi nhuận đủ. "Tôi nghĩ mọi người vẫn chưa hiểu lợi nhuận [từ AI tiên tiến] tăng theo cấp số mũ như thế nào. Chi phí cũng tăng theo cấp số mũ, nhưng tôi nghĩ lợi nhuận còn tăng theo cấp số mũ hơn nữa," ông nói.

Tuy nhiên, nhiều công ty châu Á cảm thấy họ không thể theo kịp "trò chơi tiền bạc" mà OpenAI và các công ty công nghệ lớn khác của Mỹ đang chơi. Ngay cả OpenAI vẫn chưa chứng minh được rằng họ có thể biến chi tiêu lớn thành lợi nhuận. Theo Bloomberg, công ty Mỹ này dự kiến doanh thu 12,7 tỷ đô la trong năm nay nhưng không kỳ vọng dòng tiền dương cho đến năm 2029, trích dẫn một nguồn tin ẩn danh.

Oba nói rằng vì hiệu suất AI sẽ chỉ tăng theo logarit so với khoản đầu tư, "rõ ràng là làm việc với các mô hình nhỏ hơn mang lại lợi nhuận tốt hơn nhiều. Ai cũng thấy điều đó."

Kirk Boodry, một nhà phân tích tại Astris Advisory Japan, cho biết các công ty Nhật Bản có xu hướng theo đuổi các mô hình nhỏ hơn, hiệu quả hơn.

"Nhiều mô hình [phương Tây] này không sử dụng được hoặc không tập trung vào các trường hợp sử dụng [cụ thể]. ... Bạn đang lập trình? Bạn đang đặt câu hỏi? Bạn đang tra cứu dữ liệu lịch sử? Đây đều là những trường hợp sử dụng rất rộng," ông nói. Ngược lại, các công ty Nhật Bản đang tập trung nguồn lực nhiều hơn vào các trường hợp sử dụng cụ thể, ông nói.

"Một trong những lý do đằng sau điều đó là bạn không kỳ vọng rằng sẽ có nhiều nguồn điện được tạo ra. ... Chỉ có một lượng mở rộng hạn chế trong lưới điện ... bởi vì Nhật Bản nhập khẩu hơn 80% năng lượng của mình."

GPU được sử dụng cho AI nổi tiếng là tiêu thụ một lượng lớn năng lượng, gây áp lực cho lưới điện và làm tăng thêm lo ngại về biến đổi khí hậu.

NTT không phải là công ty Nhật Bản duy nhất tập trung vào hiệu quả AI. Sakana AI, một công ty khởi nghiệp có trụ sở tại Tokyo, đã phát triển công nghệ nâng cao khả năng của các mô hình AI hiện có thông qua cái gọi là phương pháp tiến hóa, tự động lựa chọn các mô hình tốt nhất và kết hợp chúng để đáp ứng mục tiêu của nhà phát triển.

CEO Sakana AI David Ha nói với Nikkei Asia rằng ngành công nghiệp đang bắt đầu tìm thấy sự cân bằng giữa chi tiêu và đổi mới.

"Tôi nghĩ rằng vào năm 2023 và 2024, mọi người quá tập trung vào tiền bạc," ông nói. "Xây dựng các trung tâm dữ liệu và [các công ty AI] bỏ qua đổi mới. ... Điều DeepSeek cho thấy, và công ty chúng tôi cho thấy, là bạn cần cả hai. ... Bạn phải tìm ra một cách đổi mới mới để làm mọi thứ nhanh hơn."

DeepSeek được cho là đã sử dụng một kỹ thuật gọi là chưng cất, trong đó AI được đào tạo bằng cách sử dụng một mô hình AI lớn hơn làm giáo viên, cho phép phát triển các mô hình nhỏ hơn nhanh chóng và hiệu quả về chi phí hơn.

"Đào tạo các mô hình lớn rất tốn kém, và những mô hình này là tài sản mất giá nhanh nhất trong lịch sử loài người," Ha nói. "Vì vậy, từ góc độ chiến lược kinh doanh, tôi muốn tiêu rất ít nguồn lực để đào tạo các mô hình ngôn ngữ lớn, và tập trung vào nghiên cứu có tác động lớn hơn, như tạo ra LLM bằng AI với giá bằng một phần tỷ."

Giống như Oba, Ha nói rằng ông tin rằng những hạn chế về nguồn lực ở Trung Quốc và Nhật Bản có thể thúc đẩy các giải pháp đổi mới hơn. "Tại một công ty lớn với hàng tỷ đô la tài trợ, họ quen với một lượng lớn tài nguyên. ... Nếu chúng tôi có nguồn lực hạn chế, chúng tôi có thể làm những điều tốt hơn," ông nói, nhắc lại câu châm ngôn cũ, "Cần thiết là mẹ đẻ của đổi mới."

Not just DeepSeek: Japan's AI players chase efficiency over size

- Theo khảo sát của Gartner, 92% CIO dự định tích hợp AI vào tổ chức của họ vào năm 2025, nhưng 49% gặp khó khăn trong việc đánh giá và thể hiện giá trị của công nghệ này.

- Mô hình ngôn ngữ nhỏ (SLM) đang nổi lên như một giải pháp hấp dẫn, hứa hẹn khả năng AI chi phí thấp hơn và bảo mật hơn, phù hợp với các ưu tiên chiến lược của doanh nghiệp.

- Amer Sheikh, trưởng khoa học dữ liệu tại BearingPoint cho biết: "Cộng đồng AI đã tích cực khám phá các mô hình ngôn ngữ nhỏ như Mistral Small và DeepSeek R1. Sự phổ biến của chúng xuất phát từ khả năng cân bằng giữa độ chính xác, tốc độ và hiệu quả chi phí."

- SLM đang thúc đẩy làn sóng tiếp theo của việc áp dụng AI tại biên, cho phép các mô hình AI chạy trên điện thoại thông minh, thiết bị IoT và hệ thống công nghiệp mà không phụ thuộc vào cơ sở hạ tầng đám mây.

- Một số ứng dụng thực tế của SLM bao gồm: mô hình DeepSeek R1 được tích hợp vào hệ thống thông tin giải trí của các nhà sản xuất ô tô Trung Quốc (như Geely), Phi-3 - một mô hình nhỏ được thiết kế cho ứng dụng AI di động, và Smile Plug của Stanford sử dụng các mô hình AI nhỏ để cung cấp trải nghiệm học tập tương tác trên thiết bị Raspberry Pi mà không cần kết nối internet.

- SLM có thể chạy cục bộ, cắt giảm chi phí và giảm thiểu rủi ro bảo mật, khiến chúng phù hợp để nâng cao trí thông minh của thiết bị biên. "Có sự giảm thiểu đáng kể trong chi phí suy luận. Tuy nhiên, sẽ có chi phí nhỏ cho việc tinh chỉnh và tự lưu trữ," Sheikh nói thêm.

- Các ngành được quy định chặt chẽ như viễn thông, kế toán và luật đang áp dụng SLM nhanh chóng hơn nhờ khả năng tập trung vào các trường hợp sử dụng cụ thể, dành riêng cho ngành.

- Bảo mật là yếu tố chính, đặc biệt là trong các thiết bị biên. SLM là phiên bản tại chỗ của thế giới AI tạo sinh, giúp dữ liệu không cần rời khỏi biên giới của tổ chức.

- Saman Nasrolahi từ InMotion Ventures cho biết: "Khoảng một phần ba tất cả các cuộc tấn công an ninh mạng xảy ra khi dữ liệu được chia sẻ với nhà cung cấp bên ngoài. Bằng cách giữ dữ liệu tại chỗ, SLM có thể giảm bề mặt tấn công và lỗ hổng doanh nghiệp."

- Với tiến bộ trong các bộ chip tùy chỉnh, các yêu cầu về điện năng, bộ nhớ và hiệu suất của SLM hiện có thể được tìm thấy trong hầu hết các máy tính xách tay và điện thoại di động tầm trung.

- SLM tiêu thụ ít năng lượng hơn, làm cho chúng rẻ hơn, tốt hơn cho môi trường, và thường đủ nhỏ để chạy cục bộ trên thiết bị biên như điện thoại di động hoặc PC mà không cần kết nối internet.

- Báo cáo Tech Trends 2025 của Deloitte cho thấy các doanh nghiệp đang xem xét SLM và các tùy chọn nguồn mở để đào tạo mô hình trên các bộ dữ liệu nhỏ hơn, chính xác hơn.

- Vào năm 2017, Gartner đã dự đoán rằng đến năm nay, 75% dữ liệu do doanh nghiệp tạo ra sẽ được tạo và xử lý bên ngoài các trung tâm dữ liệu tập trung truyền thống hoặc đám mây.

- SLM đang định hình lại các ngành y tế, tài chính và quốc phòng, cho phép AI trên thiết bị giảm độ trễ, bảo vệ dữ liệu nhạy cảm và nâng cao việc ra quyết định thời gian thực.

📌 SLM đang mở ra kỷ nguyên mới cho AI doanh nghiệp với chi phí thấp hơn 90%, bảo mật cao hơn và khả năng chạy trên thiết bị biên. Đến 2025, 92% CIO sẽ tích hợp AI, với SLM là giải pháp chiến lược cho các ngành y tế, tài chính và sản xuất.

https://www.computerweekly.com/feature/Why-SLMs-could-be-a-big-deal-for-businesses-looking-for-an-edge

-

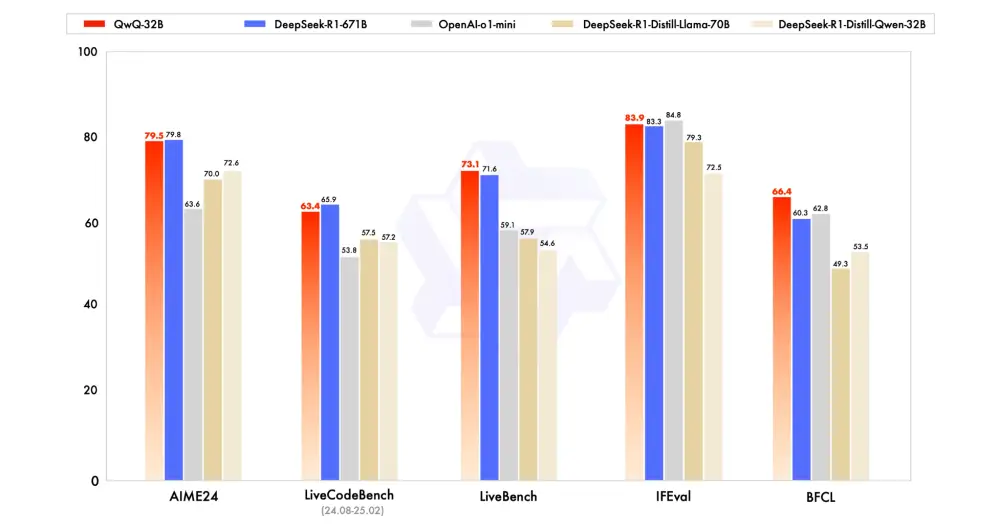

Qwen Team, một bộ phận của Alibaba, vừa giới thiệu mô hình lập luận nguồn mở QwQ-32B với 32 tỷ tham số, nhằm cải thiện hiệu suất trong các tác vụ giải quyết vấn đề phức tạp thông qua học tăng cường (RL)1.

-

Mô hình có sẵn dưới dạng trọng số mở trên Hugging Face và ModelScope với giấy phép Apache 2.0, cho phép sử dụng trong thương mại và nghiên cứu

-

QwQ-32B là phiên bản mới nhất của QwQ (Qwen-with-Questions), được Alibaba giới thiệu lần đầu vào tháng 11/2024 để cạnh tranh với mô hình o1-preview của OpenAI1.

-

Mô hình ban đầu có 32 tỷ tham số và độ dài ngữ cảnh 32.000 token, vượt trội o1-preview trong các điểm chuẩn toán học như AIME và MATH, cũng như các tác vụ lập luận khoa học như GPQA1.

-

QwQ-32B sử dụng phương pháp học tăng cường đa giai đoạn để nâng cao khả năng lập luận toán học, lập trình và giải quyết vấn đề tổng quát

-

So với DeepSeek-R1 (671 tỷ tham số), QwQ-32B đạt hiệu suất tương đương nhưng chỉ yêu cầu 24 GB vRAM trên GPU, so với hơn 1.500 GB vRAM để chạy DeepSeek R1 đầy đủ

-

Kiến trúc của QwQ-32B bao gồm 64 lớp transformer với các tối ưu hóa như RoPE, SwiGLU, RMSNorm và Attention QKV bias

-

Mô hình có độ dài ngữ cảnh mở rộng lên 131.072 token, cho phép xử lý tốt hơn các đầu vào chuỗi dài

-

Quá trình học tăng cường của QwQ-32B được thực hiện qua hai giai đoạn: tập trung vào toán học và lập trình, sau đó là nâng cao khả năng tổng quát

-

QwQ-32B có thể hỗ trợ doanh nghiệp trong các lĩnh vực như phân tích dữ liệu tự động, lập kế hoạch chiến lược, phát triển phần mềm và tự động hóa thông minh

-

Mô hình nhận được phản hồi tích cực từ cộng đồng AI, với nhiều chuyên gia đánh giá cao về tốc độ suy luận và hiệu suất so với các mô hình lớn hơn

-

QwQ-32B tích hợp khả năng tác nhân, cho phép điều chỉnh động quá trình lập luận dựa trên phản hồi môi trường

-

Qwen Team coi QwQ-32B là bước đầu tiên trong việc mở rộng học tăng cường để nâng cao khả năng lập luận, với kế hoạch tương lai bao gồm tích hợp tác nhân với RL cho lập luận dài hạn và phát triển hướng tới trí tuệ nhân tạo tổng quát (AGI)

📌 Alibaba ra mắt QwQ-32B, mô hình lập luận nguồn mở 32 tỷ tham số, cạnh tranh với DeepSeek-R1 671 tỷ tham số. Sử dụng học tăng cường đa giai đoạn, QwQ-32B đạt hiệu suất tương đương nhưng chỉ cần 24 GB vRAM, so với 1.500 GB của DeepSeek-R1. Mô hình hứa hẹn thúc đẩy ứng dụng AI trong doanh nghiệp.

https://venturebeat.com/ai/alibabas-new-open-source-model-qwq-32b-matches-deepseek-r1-with-way-smaller-compute-requirements/

-

Microsoft vừa ra mắt dòng mô hình AI Phi-4 mới có khả năng xử lý đồng thời văn bản, hình ảnh và giọng nói nhưng tiêu tốn ít tài nguyên tính toán hơn nhiều so với các hệ thống hiện có.

-

Phi-4-Multimodal chỉ có 5,6 tỷ tham số và Phi-4-Mini có 3,8 tỷ tham số, vượt trội so với các đối thủ cùng kích thước và thậm chí còn vượt qua hiệu suất của các mô hình lớn hơn gấp đôi trong một số tác vụ.

-

Điểm đặc biệt của Phi-4-Multimodal là kỹ thuật "hỗn hợp LoRA" cho phép xử lý đầu vào văn bản, hình ảnh và giọng nói trong một mô hình duy nhất mà không làm giảm hiệu suất.

-

Mô hình này đã giành vị trí đầu bảng trên Hugging Face OpenASR với tỷ lệ lỗi từ chỉ 6,14%, vượt qua cả các hệ thống nhận dạng giọng nói chuyên biệt như WhisperV3.

-

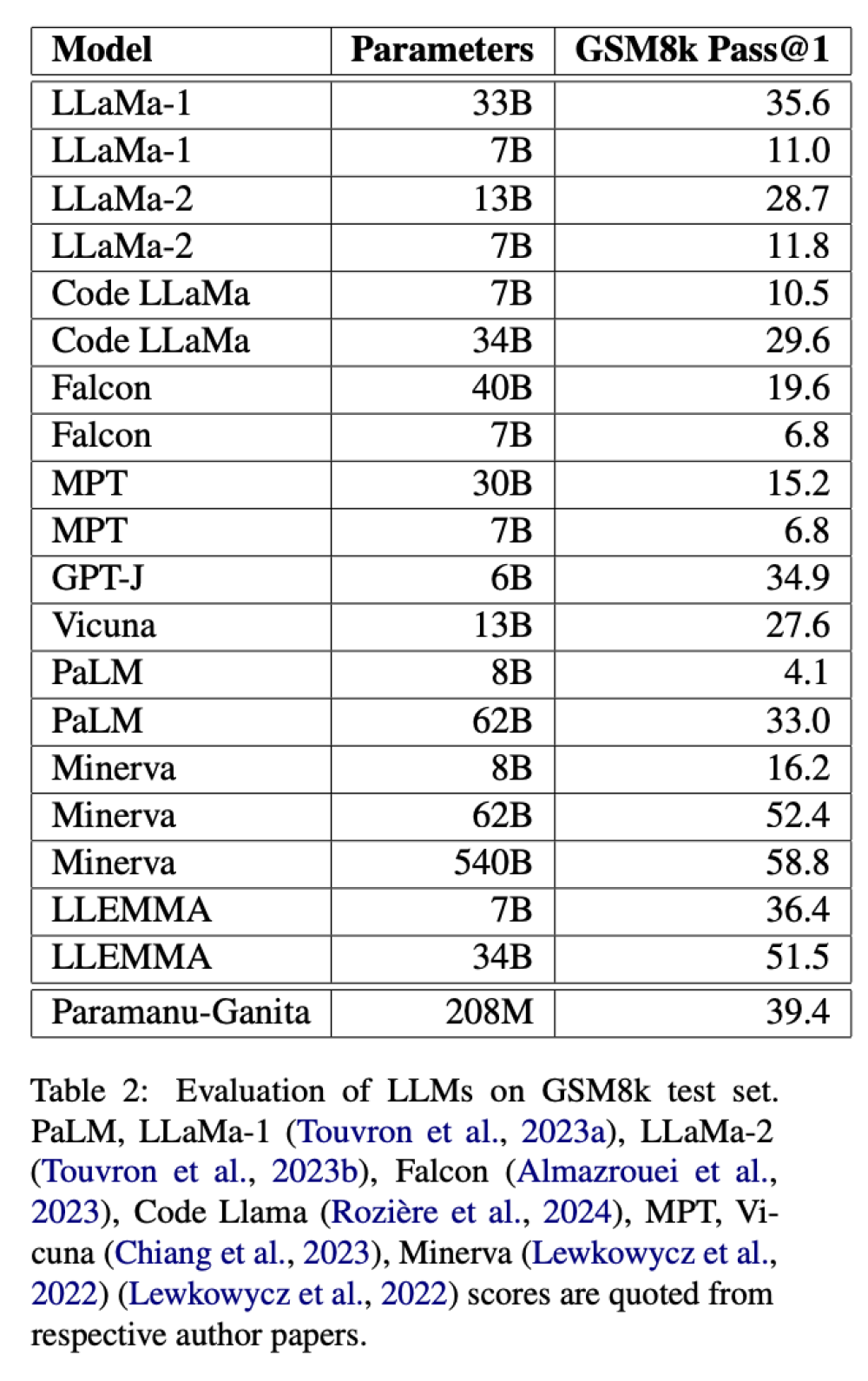

Phi-4-Mini thể hiện khả năng đặc biệt trong các tác vụ dựa trên văn bản. Trên tiêu chuẩn toán học GSM-8K, nó đạt 88,6%, vượt qua hầu hết các mô hình 8 tỷ tham số, và trên tiêu chuẩn MATH đạt 64%, cao hơn nhiều so với đối thủ cùng kích thước.

-

Công ty Capacity đã sử dụng các mô hình Phi và báo cáo tiết kiệm chi phí gấp 4,2 lần so với quy trình làm việc cạnh tranh trong khi vẫn đạt được kết quả chất lượng tương đương hoặc tốt hơn.

-

Các mô hình Phi-4 được thiết kế để hoạt động trên phần cứng tiêu chuẩn hoặc tại "biên" - trực tiếp trên thiết bị thay vì trong trung tâm dữ liệu đám mây - nhằm giảm chi phí, độ trễ và duy trì quyền riêng tư dữ liệu.

-

Microsoft đã đưa Phi-4 lên nhiều nền tảng bao gồm Azure AI Foundry, Hugging Face và Nvidia API Catalog, giúp phổ cập AI cho nhiều đối tượng sử dụng.

-

Masaya Nishimaki, giám đốc tại công ty AI Nhật Bản Headwaters, đánh giá AI biên hoạt động xuất sắc ngay cả trong môi trường kết nối mạng không ổn định hoặc nơi bảo mật là tối quan trọng.

-

Phi-4 đại diện cho sự thay đổi tư duy về AI, chứng minh rằng AI không chỉ dành cho những người có máy chủ lớn nhất và ngân sách lớn nhất, mà có thể hoạt động ở bất cứ đâu, cho bất kỳ ai.

📌 Microsoft phá vỡ quy ước "càng lớn càng tốt" trong AI với mô hình Phi-4 chỉ từ 3,8-5,6 tỷ tham số nhưng xử lý được đa phương thức, vượt trội trên nhiều tiêu chuẩn so với mô hình lớn gấp đôi, tiết kiệm chi phí đến 4,2 lần và có thể triển khai trực tiếp tại biên.

https://venturebeat.com/ai/microsofts-new-phi-4-ai-models-pack-big-performance-in-small-packages/

-

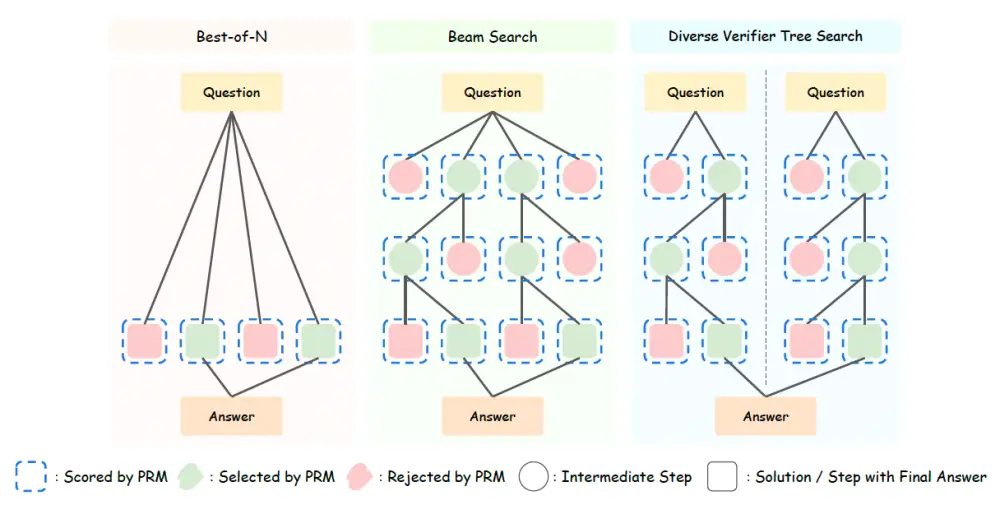

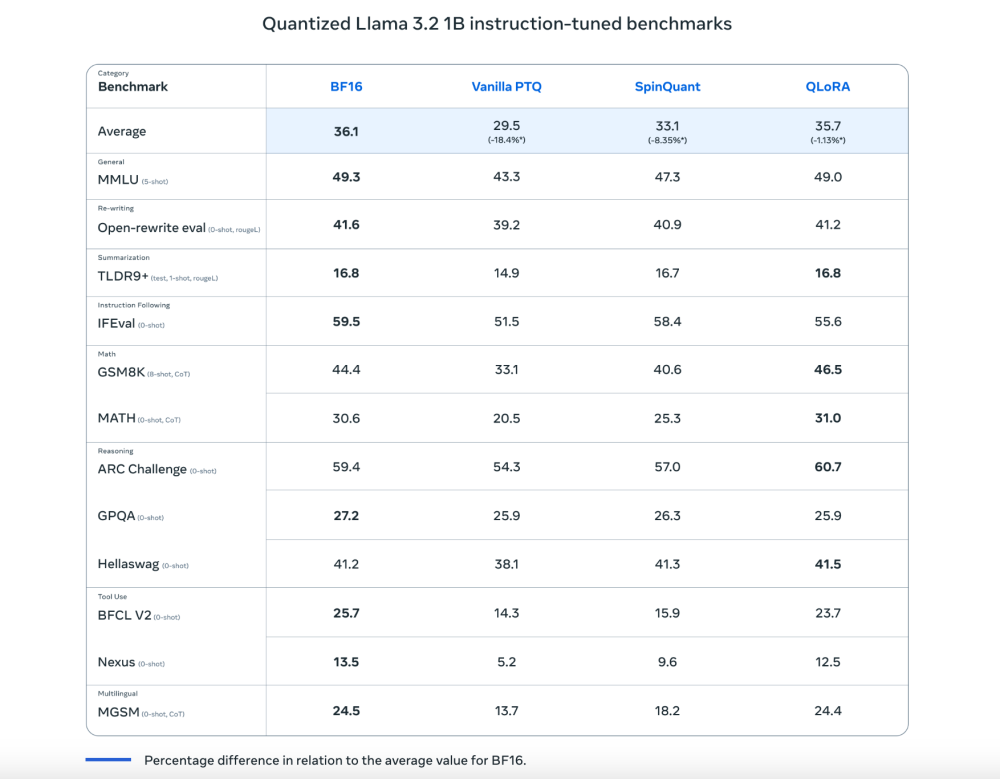

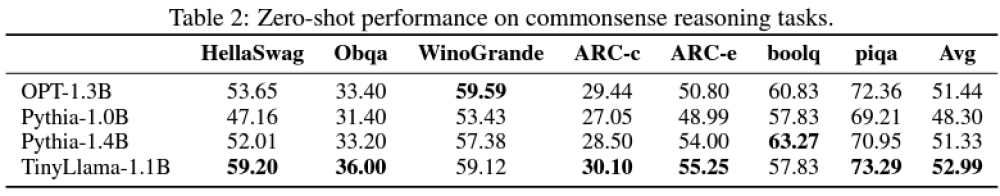

Shanghai AI Laboratory công bố nghiên cứu cho thấy mô hình ngôn ngữ nhỏ (SLM) có thể vượt trội hơn mô hình lớn (LLM) trong các tác vụ suy luận

-

Mô hình Llama-3.2-3B khi áp dụng chiến lược TTS tối ưu đã vượt qua Llama-3.1-405B trong các bài kiểm tra toán học MATH-500 và AIME24

-

Mở rộng quy mô thời gian kiểm tra (TTS) là quá trình cung cấp thêm chu kỳ tính toán cho LLM trong quá trình suy luận để cải thiện hiệu suất

-

TTS nội bộ: Mô hình được huấn luyện để "suy nghĩ" chậm bằng cách tạo chuỗi dài các token suy luận từng bước

-

TTS bên ngoài bao gồm:

-

Mô hình chính (policy model) tạo câu trả lời

-

Mô hình đánh giá phần thưởng (PRM) đánh giá các câu trả lời

-

Phương pháp lấy mẫu hoặc tìm kiếm kết nối hai thành phần trên

-

3 phương pháp TTS bên ngoài:

-

Best-of-N: Chọn câu trả lời tốt nhất từ nhiều phương án

-

Tìm kiếm chùm: Chia nhỏ câu trả lời thành nhiều bước

-

Tìm kiếm cây xác minh đa dạng (DVTS): Tạo nhiều nhánh câu trả lời khác nhau

-

Qwen2.5 với 500 triệu tham số đã vượt qua GPT-4o khi sử dụng TTS tối ưu

-

DeepSeek-R1 phiên bản 1,5 tỷ tham số vượt trội o1-preview và o1-mini trong MATH-500 và AIME24

-

SLM có thể vượt trội mô hình lớn hơn với lượng FLOPS ít hơn 100-1.000 lần khi tính cả chi phí huấn luyện và suy luận

📌 Nghiên cứu chứng minh mô hình ngôn ngữ nhỏ 1 tỷ tham số có thể vượt trội mô hình 405 tỷ tham số trong bài kiểm tra toán học phức tạp nhờ kỹ thuật TTS tối ưu, tiết kiệm được 100-1.000 lần chi phí tính toán. Đây là bước đột phá quan trọng cho việc triển khai AI trong môi trường hạn chế tài nguyên.

https://venturebeat.com/ai/how-test-time-scaling-unlocks-hidden-reasoning-abilities-in-small-language-models-and-allows-them-to-outperform-llms/

- Các nhà nghiên cứu tại Stanford và Đại học Washington đã phát triển mô hình S1 với chi phí đào tạo chỉ 50 USD (khoảng 4.400 rupee)

- S1-32B là mô hình ngôn ngữ nguồn mở tập trung vào nhiệm vụ suy luận, sử dụng kỹ thuật "test-time scaling" để lặp lại phản hồi bằng cách sử dụng thêm tài nguyên tính toán trong quá trình kiểm thử

- Mô hình được đào tạo trên bộ dữ liệu S1K gồm 1.000 câu hỏi được chọn lọc kỹ về độ khó, đa dạng và chất lượng trong các lĩnh vực toán học, suy luận và khoa học

- Quá trình đào tạo chỉ mất 26 phút trên 16 GPU NVIDIA H100 thông qua supervised fine-tuning trên mô hình nền Qwen2.5-32B-Instruct

- S1 học cách suy luận bằng cách nghiên cứu câu hỏi và câu trả lời từ Gemini 2.0 Flash Thinking Experimental của Google

- Khi đánh giá trên 3 tiêu chuẩn AIME24, MATH500 và GPQA Diamond, S1 vượt trội hơn mô hình o1 Preview của OpenAI tới 27% trong các bài toán thi đấu

- Mô hình có khả năng chia nhỏ câu hỏi phức tạp thành nhiều bước để phân tích và trả lời, ví dụ như tính toán chi phí thay thế iPhone bằng máy tính bảng Android

- S1 chứng minh khả năng xây dựng mô hình suy luận hiệu quả chỉ với 1.000 mẫu, không cần học tăng cường và bộ dữ liệu khổng lồ

📌 Mô hình S1 mở ra kỷ nguyên mới cho AI chi phí thấp với chỉ 50 USD đào tạo, đạt hiệu suất vượt 27% so với đối thủ OpenAI trong các bài toán thi đấu. Đây là minh chứng cho việc phát triển AI hiệu quả không nhất thiết phải tốn kém.

https://indianexpress.com/article/technology/artificial-intelligence/what-is-s1-ai-model-the-openai-o1-rival-trained-in-less-than-50-9824588/

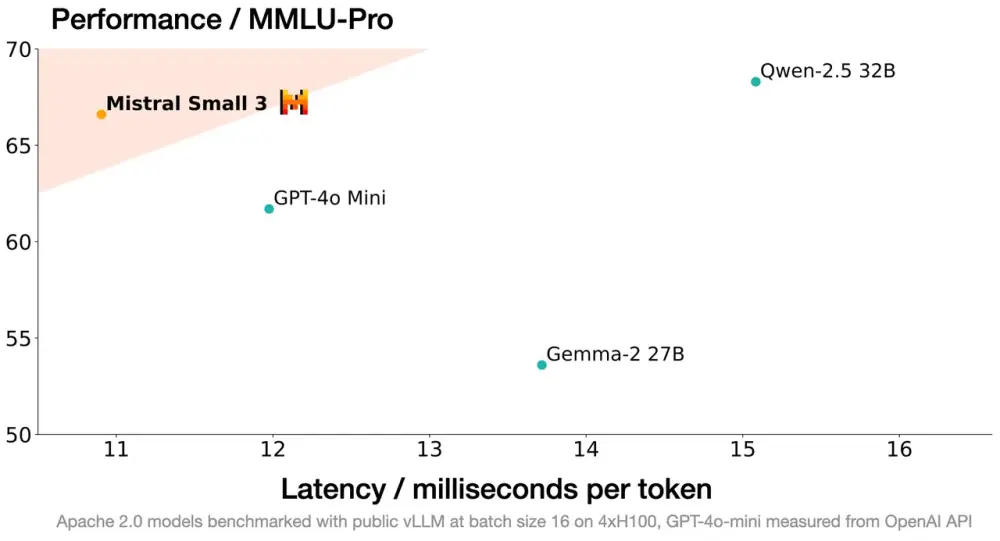

- Mistral AI vừa ra mắt mô hình Small 3 với 24B tham số vào ngày 30/1/2025, được tối ưu hóa về độ trễ và hiệu quả

- Mô hình này có khả năng cạnh tranh với các mô hình lớn như Llama 3.3 70B và Qwen 32B

- Small 3 đạt độ chính xác trên 81% trong bài kiểm tra MMLU mà không cần huấn luyện tăng cường (RL) hay dữ liệu tổng hợp

- Ưu điểm nổi bật là có thể chạy cục bộ trên MacBook với RAM tối thiểu 32GB

- Mistral đã tiến hành kiểm tra với hơn 1.000 câu hỏi về lập trình và kiến thức chung thông qua đánh giá viên bên thứ ba

- Kết quả cho thấy đa số người dùng thích Small 3 hơn Gemma-2 27B và Qwen-2.5 32B

- Các ứng dụng tiềm năng:

+ Xây dựng trợ lý ảo phục vụ khách hàng

+ Phát hiện gian lận trong dịch vụ tài chính

+ Tư vấn pháp lý và chăm sóc sức khỏe

+ Lĩnh vực robot và sản xuất

+ Phù hợp với người đam mê và tổ chức xử lý thông tin nhạy cảm

- Mô hình được phát hành dưới giấy phép Apache 2.0 và có thể truy cập trên nền tảng HuggingFace

📌 Small 3 của Mistral AI là mô hình nguồn mở 24B tham số, chạy được trên MacBook 32GB RAM, đạt độ chính xác 81% trong MMLU, cạnh tranh trực tiếp với GPT-4o mini và các mô hình lớn khác trong lĩnh vực tư vấn, phát hiện gian lận và chăm sóc sức khỏe.

https://www.zdnet.com/article/mistral-ai-says-its-small-3-model-is-a-local-open-source-alternative-to-gpt-4o-mini/

- Mô hình ngôn ngữ nhỏ (SLM) đang được các công ty ưa chuộng như một cách tiếp cận AI hiệu quả và tiết kiệm chi phí

- Microsoft vừa ra mắt Phi-4, một SLM vượt trội hơn các mô hình lớn hơn trong việc lập luận toán học và xử lý ngôn ngữ tự nhiên

- Các ví dụ về SLM hiện nay bao gồm: Llama, Phi, Mistral, Gemma và Granite

- SLM sử dụng ít tham số hơn nhiều so với mô hình lớn:

+ GPT-4 có hơn 175 tỷ tham số

+ SLM chỉ từ vài chục triệu đến dưới 30 tỷ tham số

- Ưu điểm chính của SLM:

+ Thời gian đào tạo và phản hồi nhanh hơn

+ Tiêu thụ năng lượng thấp hơn

+ Chi phí vận hành thấp

+ Hiệu suất tốt trong các tác vụ chuyên biệt

+ Tương thích với thiết bị biên

- SLM có thể giúp thu hẹp khoảng cách đa dạng ngôn ngữ trong AI:

+ Hiện tại chatbot AI chỉ được đào tạo khoảng 100 trong số hơn 7.000 ngôn ngữ trên thế giới

+ Meta đã phát hành Llama 3.2 1B và 3B với khả năng tạo văn bản đa ngôn ngữ

- Hạn chế của SLM:

+ Khả năng xử lý ngôn ngữ phức tạp còn hạn chế

+ Độ chính xác thấp hơn trong các tác vụ phức tạp

+ Hiệu suất bị giới hạn

+ Phạm vi hẹp do được đào tạo trên bộ dữ liệu nhỏ và chuyên biệt

📌 SLM đang định hình lại chiến lược AI doanh nghiệp với chi phí thấp hơn 70% so với mô hình lớn. Microsoft Phi-4 vượt trội trong lập luận toán học, trong khi Llama của Meta hỗ trợ đa ngôn ngữ. Xu hướng này cho thấy sự chuyển dịch từ thực nghiệm sang triển khai có mục đích.

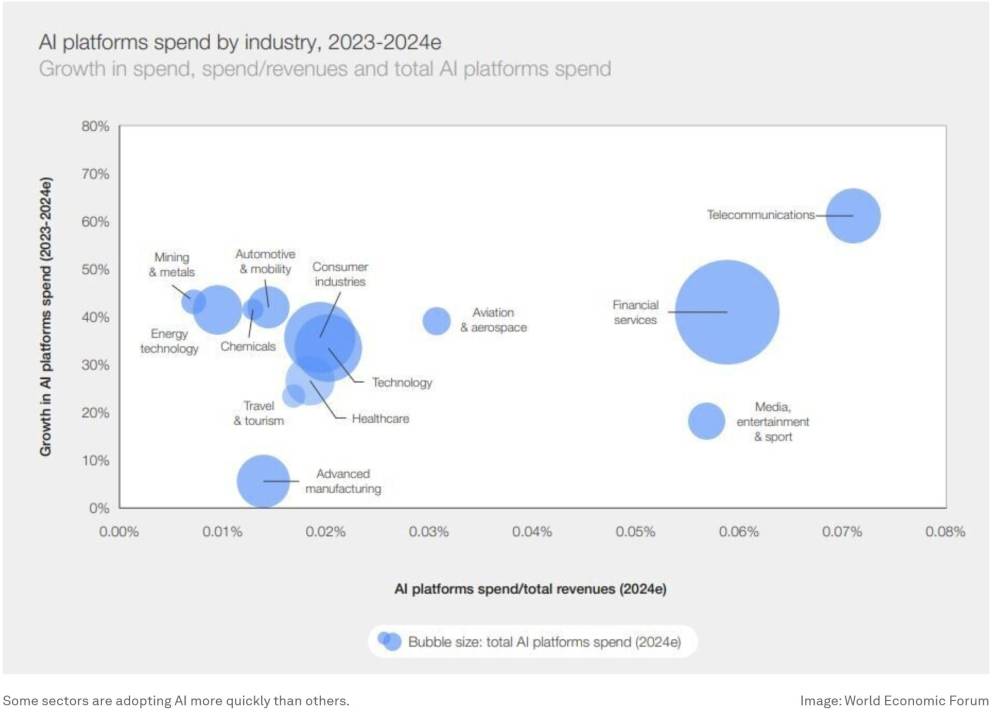

https://www.weforum.org/stories/2025/01/ai-small-language-models/

#WEF

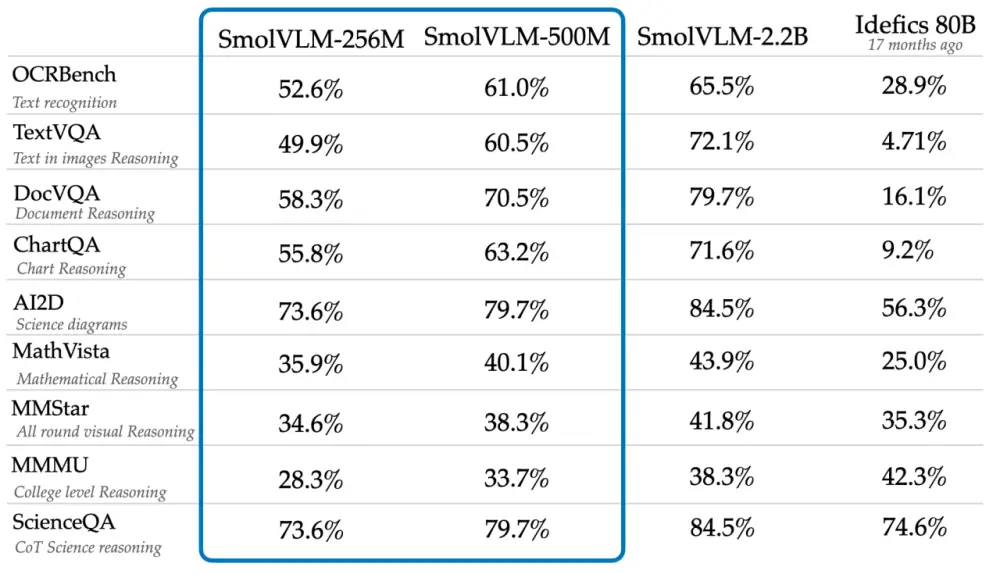

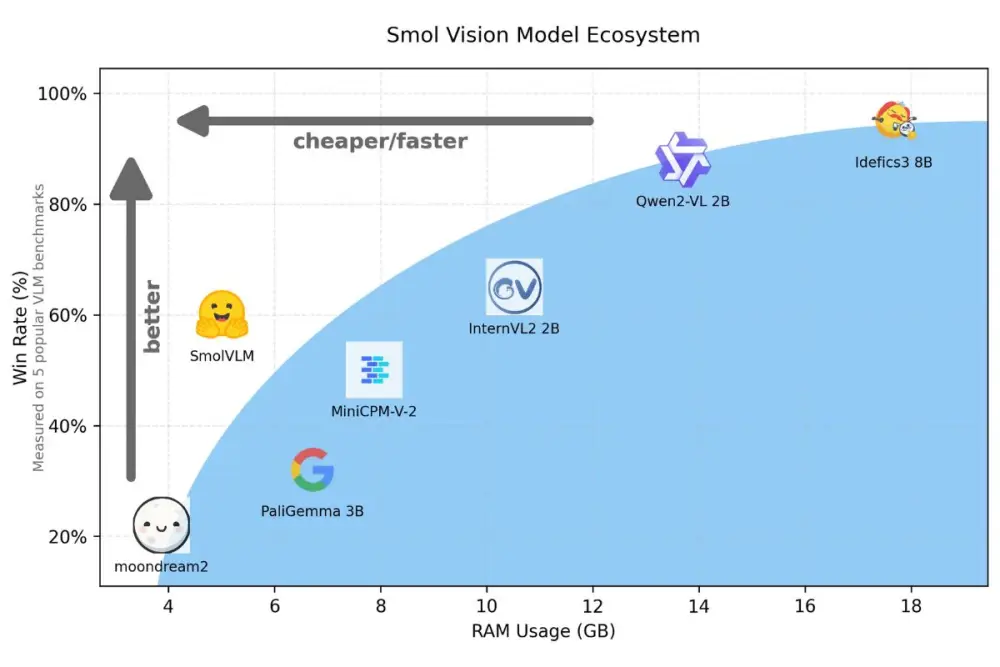

- Hugging Face vừa công bố 2 mô hình AI đa phương thức mới: SmolVLM-256M và SmolVLM-500M, được cho là nhỏ nhất trong loại hình này

- 2 mô hình có kích thước lần lượt là 256 triệu và 500 triệu tham số, được thiết kế để hoạt động hiệu quả trên các thiết bị có giới hạn như laptop với RAM dưới 1GB

- Khả năng chính của các mô hình:

+ Mô tả hình ảnh và video clip

+ Trả lời câu hỏi về nội dung PDF

+ Phân tích văn bản quét và biểu đồ

- Quá trình huấn luyện sử dụng:

+ The Cauldron: tập hợp 50 bộ dữ liệu hình ảnh và văn bản chất lượng cao

+ Docmatix: bộ dữ liệu file quét kèm chú thích chi tiết

- Kết quả kiểm thử cho thấy cả 2 mô hình đều vượt trội hơn Idefics 80B (mô hình lớn hơn nhiều lần) trong các bài kiểm tra như AI2D về khả năng phân tích sơ đồ khoa học cấp tiểu học

- Mô hình được phát hành dưới giấy phép Apache 2.0, cho phép sử dụng không giới hạn

- Nghiên cứu từ Google DeepMind, Microsoft Research và viện nghiên cứu Mila Quebec chỉ ra rằng các mô hình nhỏ có thể kém hiệu quả hơn trong các tác vụ suy luận phức tạp, do chúng có xu hướng nhận diện mẫu bề mặt thay vì áp dụng kiến thức vào ngữ cảnh mới

📌 Hugging Face đã tạo bước đột phá với 2 mô hình AI đa phương thức siêu nhỏ gọn 256M và 500M tham số, hoạt động hiệu quả trên thiết bị RAM dưới 1GB. Mô hình vượt trội hơn Idefics 80B trong nhiều bài kiểm tra, mở ra khả năng ứng dụng AI trên các thiết bị có tài nguyên hạn chế.

https://techcrunch.com/2025/01/23/hugging-face-claims-its-new-ai-models-are-the-smallest-of-their-kind/

- Kazuhiro Gomi, CEO của NTT Research, nhấn mạnh rằng các công ty muốn áp dụng AI đã được đào tạo cho các nhiệm vụ cụ thể trong quy trình lớn hơn như kế toán.

- Tại diễn đàn R&D của NTT vào tháng 11 năm 2024, công ty đã giới thiệu các tác nhân AI sử dụng LLM mang tên Tsuzumi.

- Tsuzumi nhẹ hơn và có thể chạy trên một GPU duy nhất, khác với các LLM yêu cầu nhiều GPU.

- Mặc dù mô hình nhỏ không thể cạnh tranh với các mô hình phức tạp ở tất cả các nhiệm vụ, Gomi tin rằng chúng có thể được tinh chỉnh để hoạt động trong các môi trường cụ thể.

- Một demo cho thấy tác nhân AI sử dụng Tsuzumi có thể chạy trên máy tính để bàn Windows và thực hiện các chỉ dẫn bằng ngôn ngữ tự nhiên để mua sắm bút.

- Các công ty cần xác định mục tiêu, cách tiếp cận AI và cách thu thập dữ liệu để xây dựng mô hình.

- Leslie Teo, giám đốc sản phẩm AI tại AI Singapore, cho biết rằng các nhà phát triển LLM ban đầu kỳ vọng các nhà phát triển ứng dụng sẽ gọi đến các mô hình trực tuyến.

- Mô hình nhỏ rất cần thiết trong các khu vực có kết nối internet không ổn định.

- Một trong những mô hình AI nhỏ nhất của GoTo chỉ nặng 80 kilobytes, dùng để nhận diện “wake word” nhằm kích hoạt trợ lý AI.

- Các nhà sản xuất laptop như Dell và Qualcomm đã yêu cầu tối ưu hóa mô hình Sea-Lion của Singapore để chạy trên các đơn vị xử lý thần kinh (NPU).

- NPU rẻ hơn, tiêu thụ ít năng lượng và cần thiết cho AI trên máy tính Windows mới.

- Singapore sắp sản xuất phiên bản Sea-Lion với 70 tỷ tham số nhưng không mong đợi sự chấp nhận lớn từ người dùng.

- AI Singapore sẽ tối ưu hóa mô hình AI xuống còn 1 đến 3 tỷ tham số vào năm 2025 nhằm tạo ra giá trị kinh tế.

- Tan Ah Tuan, giám đốc Ensign Infosecurity, cho biết công ty đã áp dụng AI trong nền tảng kiểm tra mối đe dọa Apollo.

- Apollo sử dụng LLM để tạo báo cáo về các lỗ hổng mạng mà khách hàng có thể gặp phải, điều này rất quan trọng khi triển khai trên cơ sở hạ tầng thông tin quan trọng không có kết nối internet.

- Phiên bản LLM của Meta, Llama 3, mà họ tùy chỉnh có thể tạo ra báo cáo tốt hơn những gì nhân viên viết thủ công.

- Mô hình lớn hơn không nhất thiết sản xuất kết quả tốt hơn.

- Mục tiêu của họ là vượt qua con người, không cần phải hoàn hảo.

📌 Các mô hình AI nhỏ gọn đang được ứng dụng rộng rãi trong nhiều lĩnh vực như kế toán và an ninh mạng. Chúng cải thiện hiệu quả công việc với yêu cầu yêu cầu phần cứng thấp hơn, tiết kiệm năng lượng và hoạt động hiệu quả ngay cả khi không có internet.

https://www.techinasia.com/honey-shrunk-llm-leaner-meaner

#TechinAsia

Honey, I shrunk the LLM: Tại sao mô hình ngôn ngữ nhỏ gọn lại hiệu quả hơn?

Các mô hình ngôn ngữ lớn (LLM) – hệ thống AI như ChatGPT xử lý dữ liệu văn bản để hiểu và tạo ra ngôn ngữ tự nhiên – đã được ca ngợi như một bước đột phá lớn.

Dù LLMs có tiềm năng giúp tăng năng suất lao động – hoặc thậm chí thay thế con người trong một số công việc – các chuyên gia trong ngành cho rằng những hệ thống này cần phải nhỏ gọn hơn và ít tốn kém hơn trước khi được áp dụng rộng rãi hơn.

Sri Ambati, nhà sáng lập kiêm giám đốc điều hành startup AI H2O.ai, cho biết rằng LLM đã chứng minh khả năng của máy tính trong việc trả lời các câu hỏi về nhiều lĩnh vực khác nhau.

Tuy nhiên, đối với các trường hợp sử dụng đơn giản hơn, việc áp dụng LLMs có thể bị xem là quá mức cần thiết. Hơn nữa, chi phí vận hành các ứng dụng AI sử dụng LLMs có thể rất cao, Ambati bổ sung.

Ambati ước tính rằng một trường hợp sử dụng AI dựa trên LLM có thể tốn từ 500.000 USD đến 1 triệu USD. Nếu một công ty có 1.000 trường hợp sử dụng AI trải rộng trên các chức năng khác nhau, họ có thể phải chi tới 1 tỷ USD chỉ để triển khai AI.

SLM: Lối thoát tiết kiệm và hiệu quả

Do đó, việc tạo ra các mô hình chuyên biệt phù hợp với nhu cầu của từng công ty thay vì phát triển các LLM lớn hơn (và tốn kém hơn) để vận hành là một giải pháp hợp lý, ông giải thích.

Và đó là nơi các mô hình ngôn ngữ nhỏ (SLM) xuất hiện – về cơ bản là các phiên bản được tinh gọn từ LLMs.

Mô hình SLM của H2O.ai, được đặt tên là Danube, đã được đào tạo với 6 nghìn tỷ token (bao gồm từ, phân từ hoặc ký tự).

Các phiên bản của mô hình này sau đó được phát triển với 4 tỷ, 2 tỷ, và 500 triệu tham số, ít hơn đáng kể so với các mô hình lớn và phức tạp hơn.

Ví dụ, GPT-4 của OpenAI được ước tính có khoảng 1,8 nghìn tỷ tham số.

Ambati chia sẻ rằng công ty ông đã đào tạo các SLM với dữ liệu từ trung tâm cuộc gọi của AT&T để tạo ra một mô hình phân loại cuộc gọi. Ông cho biết tập đoàn viễn thông Mỹ đã chọn thử nghiệm giải pháp này sau khi đã sử dụng các LLM.

“Chúng tôi vẫn cần thực hiện làm sạch dữ liệu, quản lý và gắn nhãn dữ liệu, đôi khi là tạo dữ liệu tổng hợp và chắt lọc,” ông lưu ý. Nhưng khi những bước đó hoàn thành, AT&T đã đạt được tiết kiệm chi phí đáng kể và tốc độ phản hồi nhanh hơn từ mô hình, ông chia sẻ.

Các nhà sản xuất chip và mô hình nhỏ hơn

Teo cho biết ngay cả các nhà sản xuất laptop và chip, như Dell và Qualcomm, cũng đã hỏi liệu Singapore có thể tối ưu hóa mô hình ngôn ngữ lớn (LLM) Sea-Lion để chạy cục bộ trên các bộ xử lý thần kinh (NPU) hay không.

NPU là các chip bán dẫn giá rẻ hơn, tiêu thụ ít năng lượng hơn, có khả năng thực hiện các phép tính AI và hiện được yêu cầu trên các máy tính Windows AI mới. Những chip này được kỳ vọng sẽ chạy các trợ lý AI với mức tiêu thụ năng lượng tối thiểu mà không cần truy cập internet.

Teo nhận định: “Tôi nghĩ đây sẽ là cách mọi thứ được sử dụng. Chúng ta sẽ không có một mô hình lớn duy nhất; thay vào đó, sẽ có nhiều mô hình nhỏ và tất cả sẽ hoạt động cùng nhau trong một hệ thống.”

Singapore dự kiến sẽ sớm sản xuất một phiên bản Sea-Lion với 70 tỷ tham số, nhưng Teo bổ sung rằng ông không mong đợi người dùng sẽ áp dụng mô hình này.

“Mục tiêu của chúng tôi là làm tốt hơn con người. Chúng tôi không cần nó phải hoàn hảo.”

Thay vào đó, AI Singapore, chương trình AI quốc gia đã tạo ra Sea-Lion, sẽ tối ưu hóa mô hình AI của mình vào năm 2025 để còn khoảng 1 tỷ đến 3 tỷ tham số, với hy vọng các công ty sẽ sử dụng mô hình này để tạo ra giá trị kinh tế.

Lo ngại về an ninh

Ngoài các lợi ích như chạy trên phần cứng giá rẻ hơn và tiêu thụ ít năng lượng hơn, các mô hình ngôn ngữ nhỏ (SLM) cũng sẽ hữu ích khi máy tính không có kết nối internet.

Tan Ah Tuan, giám đốc điều hành tại Ensign Infosecurity, một nhà cung cấp giải pháp an ninh mạng, cho biết công ty đã áp dụng AI vào Apollo, nền tảng săn lùng mối đe dọa (threat-hunting) của mình, để tạo ra các báo cáo bằng LLM.

Báo cáo này cung cấp cho khách hàng thông tin về những lỗ hổng trong mạng của họ, cách mà các kẻ tấn công tiềm năng có thể khai thác, và các biện pháp mà khách hàng có thể thực hiện để củng cố hệ thống của mình.

Tan cho biết, vì giải pháp được triển khai trên hạ tầng thông tin quan trọng, vốn được cách ly khỏi internet, LLM phải chạy ngoại tuyến.

Ngoài ra, vì công ty đã tinh chỉnh LLM để chỉ tham chiếu các mối đe dọa được phát hiện trong mạng của khách hàng, mô hình này không tạo ra các phản hồi sai lệch thường thấy ở các LLM dựa trên đám mây như ChatGPT của OpenAI hoặc Gemini của Google.

Tan chia sẻ rằng phiên bản Llama 3 của Meta, được công ty tùy chỉnh, hiện có thể tạo ra các báo cáo tốt hơn so với những gì nhân viên trước đây viết thủ công.

“Chúng tôi có một tiêu chí: khi khách hàng đọc báo cáo, họ có thể sao chép và dán nó vào email để gửi cho sếp mà không cần chỉnh sửa gì thêm,” ông cho biết.

Mô hình lớn hơn không phải lúc nào cũng tốt hơn

Tan lưu ý rằng theo kinh nghiệm của mình, các mô hình mới hơn và lớn hơn không nhất thiết tạo ra kết quả tốt hơn đáng kể.

“Mục tiêu của chúng tôi là làm tốt hơn con người. Chúng tôi không cần nó phải hoàn hảo.”

Lưu ý: Bài viết này được xuất bản lại với sự cho phép từ The Business Times, nơi đã cung cấp bài viết này cho các thuê bao trả phí của họ. Nội dung đã được chỉnh sửa một cách vừa phải để phù hợp với các nguyên tắc biên tập của Tech in Asia.

Honey, I shrunk the LLM: why leaner is meaner

Large language models (LLMs) – AI systems like ChatGPT that process text data to comprehend and generate human language – have been touted as a game changer.

Despite the potential of LLMs to make workers more productive – or even replace them in certain jobs – industry watchers believe that these systems have to be leaner and less expensive before they are more widely adopted.

Sri Ambati, founder and chief executive of AI startup H2O.ai, notes that LLMs have demonstrated that computers can answer questions about a wide range of topics.

But for simpler use cases, applying LLMs can seem like overkill. Moreover, the cost of AI applications powered by LLMs can be prohibitive, Ambati adds.

A single LLM-powered AI use case costs anywhere from US$500,000 to US$1 million, he estimates. If a company has 1,000 use cases spread across different functions, it could spend up to a billion dollars just to apply AI.

So it makes sense to create specialized models for companies to use, instead of creating larger LLMs that can be more expensive to operate, he explains.

Enter small language models (SLMs), which are essentially streamlined versions of LLMs.

H2O.ai’s own SLM, dubbed Danube, has been trained with 6 trillion tokens (words, sub-words, or characters).

Versions of the model were then created with 4 billion, 2 billion, and 500 million parameters, which is significantly fewer than those of larger and more complex models.

For instance, OpenAI’s GPT-4 is estimated to have about 1.8 trillion parameters.

According to Ambati, his company has trained SLMs with AT&T’s call center data to create a call classification model. He noted that the US telco opted to try this solution after already using LLMs.

“We still have to do data cleaning, data curation and labeling, and synthetic data (generation) sometimes, and distilling,” he points out. But once that’s done, AT&T achieved “dramatic” cost savings and faster responses from the model, he shares.

Good things in small packages

Similarly, Kazuhiro Gomi, the CEO of US startup NTT Research, said that in his experience, companies would like to adopt trained AI for specific tasks in larger processes such as accounting.

At NTT’s R&D Forum 2024 in November, the company demonstrated AI agents powered by the company’s LLM, dubbed Tsuzumi.

Among its selling points are that it is lightweight and can run on a single graphics processing unit (GPU), unlike other LLMs that may need multiple GPUs.

“(Tsuzumi) is lighter, therefore you can put that on different hardware devices,” notes Gomi.