Microsoft Copilot hiện là công cụ trợ lý AI quan trọng nhất của Microsoft, được tích hợp sâu vào hệ sinh thái Windows với hơn 1,4 tỷ thiết bị trên toàn cầu.

Tính đến tháng 5.2025, hàng chục triệu người dùng đã sử dụng Copilot cho nhiều mục đích: viết email, tóm tắt tài liệu, hỗ trợ chơi game...

Tính năng nổi bật mới nhất của Copilot là Copilot 3D – cho phép người dùng chuyển ảnh 2D thành mô hình 3D chỉ trong chưa đầy một phút.

Người dùng chỉ cần truy cập website Copilot 3D, đăng nhập tài khoản Microsoft, tải ảnh (định dạng JPG hoặc PNG, tối đa 10MB), rồi nhấn "Create" để bắt đầu quá trình chuyển đổi.

Mô hình 3D sẽ được lưu trong tài khoản người dùng trong 28 ngày và có thể tải về dưới định dạng GLB, tương thích với các phần mềm thiết kế, trò chơi, mô hình hóa.

Để đạt kết quả tốt nhất, ảnh cần có một chủ thể duy nhất, ánh sáng đồng đều, nền đơn sắc – nhằm giúp AI nhận diện và dựng hình hiệu quả.

Trong khi đó, ChatGPT – dù có hơn 500 triệu người dùng mỗi tuần – hiện chưa có khả năng xử lý ảnh 2D để tạo mô hình 3D, và không có kế hoạch hỗ trợ tính năng này trong tương lai gần.

Tính năng đáng chú ý gần đây nhất của ChatGPT là "Edit message" – cho phép người dùng chỉnh sửa prompt đã gửi, giúp tiết kiệm thời gian và cải thiện kết quả phản hồi.

Dù "Edit message" là công cụ cực kỳ tiện lợi giúp cải thiện hiệu quả hội thoại, nhưng nó vẫn chỉ là cải tiến về giao diện và thao tác, không phải đột phá về năng lực xử lý đầu ra như Copilot 3D.

Ngoài ra, ChatGPT còn phát triển các tính năng như Search, Advanced Voice Mode và Canvas, nhưng vẫn thiên về hỗ trợ văn bản và hội thoại hơn là xử lý hình ảnh.

Microsoft đang dùng lợi thế tích hợp hệ điều hành và phần mềm văn phòng để đưa Copilot đến gần người dùng hơn, và định hướng rõ ràng là bổ sung các tính năng thực tế hữu ích thay vì chỉ tập trung vào AI hội thoại.

📌 Microsoft Copilot chính thức vượt lên với tính năng Copilot 3D – cho phép chuyển ảnh 2 chiều thành mô hình 3 chiều nhanh chóng và dễ dàng. Trong khi đó, ChatGPT vẫn chưa thể bước chân vào lĩnh vực xử lý ảnh như vậy. Sự khác biệt này cho thấy hướng phát triển rõ ràng của Microsoft: tập trung vào ứng dụng thực tiễn, không chỉ hội thoại thông minh.

https://www.bgr.com/1945046/microsoft-copilot-3d-feature-chatgpt-wont-have/

Hệ sinh thái AI Trung Quốc bùng nổ mùa hè 2025 với hàng loạt mô hình nguồn mở, dẫn đầu là DeepSeek, Qwen, Kimi K2 và Zhipu GLM-4.5. Danh sách xếp hạng 19 phòng lab dựa trên chất lượng và số lượng phát hành, không chỉ năng lực tiềm ẩn.

DeepSeek: giữ vị trí số 1 với V3 và R1, nổi bật bởi chuỗi suy luận công khai và giấy phép mở. Trung bình phát hành 1 mô hình/tháng trong 18 tháng. Đóng góp GRPO vào toán học và chứng minh định lý. Tuy nhiên, gần đây nhịp độ chậm lại.

Qwen (Alibaba): được ví như “Llama của Trung Quốc”, phát hành đa dạng mô hình từ LLM, VLM, embedding, đến hình ảnh/video. Qwen 3 có 177 người đóng góp (so với Llama 3: 500+, Gemini 2.5: 3.000). Được cộng đồng ưa chuộng nhờ hỗ trợ MLX, GGUF và công cụ CLI.

Moonshot AI (Kimi): startup “AI tiger” có K2 gây tiếng vang lớn, tập trung vào một dòng mô hình với chiến lược tích hợp các thử nghiệm nhỏ. Được Alibaba hậu thuẫn.

Zhipu (Z.AI): xuất thân từ ĐH Thanh Hoa, phát hành GLM-4.5 và GLM-4.5V. Đang hướng đến IPO – có thể trở thành “AI tiger” đầu tiên lên sàn.

StepFun: pivot sang nguồn mở với Step3 (VLM), hỗ trợ đa phương tiện.

Tencent (Hunyuan): nổi bật với HunyuanVideo và Hunyuan3D, nhưng giấy phép hạn chế.

RedNote (Xiaohongshu): bất ngờ với OCR mạnh, nhưng chưa tham gia mảng LLM lớn.

MiniMax: cung cấp Minimax-Text-01 với cửa sổ ngữ cảnh 1M, đồng thời phát triển video và hình ảnh nhưng vẫn đóng.

InternLM / OpenGVLab: nổi tiếng với InternVL3, kết hợp backend Qwen.

Skywork: khởi đầu từ karaoke, nay tập trung vào agent và reasoning, xây dựng trên DeepSeek, Qwen, InternVL. Cung cấp dataset mở.

ByteDance Seed: giống FAIR, phát hành nhiều công trình nghiên cứu nổi bật (Seed-Prover, Seed-X, Seedance 1.0).

OpenBMB: cộng đồng nguồn mở từ Thanh Hoa, tập trung mô hình nhỏ cho thiết bị biên (MiniCPM-V-4).

Xiaomi (MiMo) và Baidu (ERNIE): đang thử nghiệm với nhiều mô hình nhỏ, chưa rõ chiến lược dài hạn.

Các đơn vị đáng chú ý khác: Multimodal Art Projection (YuE), Alibaba AIDC, BAAI (embedding BGE), inclusionAI (Ling Lite), Huawei Pangu (tập trung GPU, bị nghi ngờ tái chế Qwen).

📌 Năm 2025, Trung Quốc nổi lên với 19 phòng lab AI nguồn mở, dẫn đầu là DeepSeek (V3, R1) và Qwen (Alibaba) với hàng triệu lượt sử dụng. Moonshot (K2) và Zhipu (GLM-4.5) đang cạnh tranh sát nút, nhiều startup như MiniMax (cửa sổ 1 triệu token) hay Skywork (agent, dataset mở) tạo bất ngờ. Các ông lớn như Tencent, Baidu, Xiaomi vẫn dè dặt. Tốc độ phát hành trung bình 1 mô hình/tháng cho thấy Trung Quốc đang áp sát, thậm chí vượt một số đối thủ phương Tây.

https://www.interconnects.ai/p/chinas-top-19-open-model-labs

• GPT-5 ra mắt với 4 biến thể: Standard (chất lượng cao, viết dài), Mini và Nano (giá rẻ, hiệu năng giảm, phù hợp tác vụ nhỏ), Chat (tối ưu hội thoại, kém hiệu quả khi viết dài).

• Mạnh về tạo văn bản giàu trí tưởng tượng, chi tiết, hỗ trợ xây dựng thế giới và nhân vật. Tuy nhiên, đôi khi văn bản dài mắc lỗi lan man và thiếu mạch lạc trong tình huống phức tạp.

• So với Claude 4, GPT-5 sáng tạo hơn nhưng kém ổn định khi cần sự mạch lạc tuyệt đối; so với Muse, GPT-5 đa dạng hơn về đầu ra sáng tạo; vượt Grok ở khả năng dựng thế giới và cốt truyện.

• Khả năng vượt trội: sáng tạo độc đáo, linh hoạt (nhiều biến thể), giá cạnh tranh (Mini, Nano), cửa sổ ngữ cảnh lớn đến 400.000 token – lý tưởng cho dự án viết dài.

• Hạn chế: xu hướng dài dòng, hội thoại đa nhân vật dễ mất mạch; GPT-5 Chat không phù hợp viết dài.

• Mẹo tối ưu: chọn biến thể phù hợp mục tiêu, tinh chỉnh prompt chi tiết, dùng API Standard cho tác vụ dài, chỉnh sửa thủ công để đảm bảo rõ ràng và cô đọng.

• GPT-5 được định vị như công cụ AI mạnh mẽ cho nhà văn, lập trình viên và doanh nghiệp muốn tận dụng AI trong kể chuyện và sáng tạo nội dung.

• Chiến lược giá nhiều tầng giúp tiếp cận từ cá nhân đến tổ chức lớn, đảm bảo linh hoạt cả về chi phí và hiệu suất.

📌 GPT-5 mang lại bước tiến lớn trong viết sáng tạo bằng AI, nổi bật nhờ trí tưởng tượng phong phú, hỗ trợ dự án dài tới 400.000 token và giá linh hoạt (Mini, Nano). Dù còn điểm yếu về tính mạch lạc và độ súc tích, khi kết hợp prompt tốt và chỉnh sửa, GPT-5 có thể trở thành “cộng sự” sáng tác đắc lực, cạnh tranh mạnh mẽ với Claude 4 và Muse.

https://www.geeky-gadgets.com/chatgpt-5-creative-writing-tested/

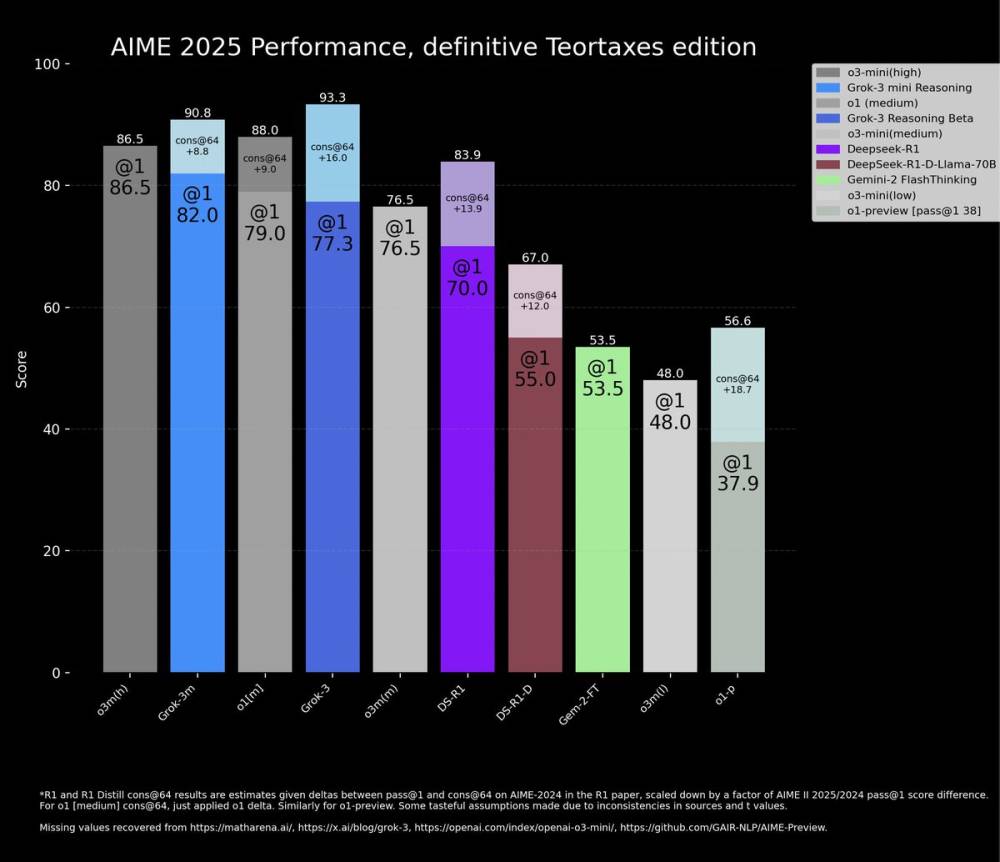

Grok 4 và o3 là hai AI giành chiến thắng trong vòng bán kết giải cờ vua AI Kaggle 2025, tổ chức tại Google Kaggle Game Arena.

o3 dễ dàng đánh bại o4-mini với tỷ số 4-0. Đây là trận áp đảo khi o3, một AI mạnh hơn nhiều, không mắc sai lầm lớn nào.

Trong ván thứ hai, o3 đã kết thúc ván đấu chỉ sau 12 nước đi bằng một đòn chiếu hết theo phong cách Puzzle-Rush.

o3 đạt điểm số hoàn hảo 100 về độ chính xác trong một ván đấu, điều hiếm thấy trong giải lần này.

Một trong các ván đấu ấn tượng nhất là ván thứ ba giữa o3 và o4-mini, với các nước trung gian rất "con người": 12...Bb4+ và 19...e3+.

Trận bán kết giữa Grok và Gemini 2.5 Pro diễn ra rất căng thẳng, kết thúc với tỷ số hòa 2,5-2,5, buộc phải phân định bằng ván tie-break theo thể thức armageddon.

Grok mắc nhiều sai lầm bất thường, để thua ván đầu tiên do mất quân liên tục (mã, xe và bị chiếu hết).

Trong ván thứ hai, Grok và Gemini tuân theo lý thuyết khai cuộc tới nước 11. Grok thắng do Gemini “ảo giác”, hi sinh hậu vô cớ.

Hai ván tiếp theo chứng kiến mỗi bên thắng một lần, khiến tỷ số hòa 2-2.

Ván tie-break mang tính quyết định, Grok cầm quân đen với lợi thế cầm hòa là thắng.

Gemini chơi tốt hơn phần lớn thời gian, thậm chí bỏ lỡ chiếu hết trong một nước – cùng mô hình chiếu như o3 dùng trước đó.

Cuối cùng, Gemini mất hậu khi đang thắng, nhưng Grok không chuyển hóa được lợi thế (hơn xe) và ván đấu kết thúc hòa sau ba lần lặp lại.

Dù vậy, do luật Armageddon, kết quả hòa giúp Grok giành vé vào chung kết.

📌 Grok vượt qua Gemini 2.5 Pro sau loạt tie-break đầy kịch tính, bất chấp ván cuối kết thúc bằng hòa do lặp lại thế cờ, nhờ luật Armageddon. Trong khi đó, o3 thể hiện sức mạnh tuyệt đối với chiến thắng 4-0 trước o4-mini, bao gồm một ván đấu hoàn hảo đạt 100 điểm chính xác. Chung kết giữa Grok và o3 hứa hẹn bùng nổ, bắt đầu lúc 1 giờ chiều ngày 7/8 (ET).

https://www.chess.com/news/view/kaggle-game-arena-chess-2025-day-2

Google DeepMind và Kaggle vừa giới thiệu Game Arena, nền tảng nguồn mở mới nhằm đánh giá mô hình AI qua trò chơi chiến lược trong môi trường có điều kiện thắng rõ ràng và cạnh tranh công bằng.

Các benchmark truyền thống ngày càng ít hiệu quả khi AI tiến gần đến 100% độ chính xác, dẫn đến nguy cơ "học vẹt" từ dữ liệu huấn luyện. Game Arena giải quyết bằng cách đặt các mô hình AI đối đầu trực tiếp trong trò chơi.

Game Arena được xây dựng trên nền tảng Kaggle, sử dụng hệ thống "all-play-all" (mọi mô hình đấu với nhau nhiều lần) để đảm bảo kết quả thống kê vững chắc và xếp hạng khách quan.

Các trò chơi được sử dụng như cờ vua, Go, poker… buộc mô hình phải thể hiện lập luận chiến lược, lập kế hoạch dài hạn và khả năng thích ứng. Đây là các kỹ năng tương tự như giải quyết bài toán phức tạp trong thực tế.

Các mô hình hiện tại như Gemini 2.5 Pro sẽ thi đấu cờ vua, nhưng tương lai nền tảng sẽ mở rộng sang nhiều game mới, bao gồm cả video game.

So với các engine chuyên biệt như Stockfish hay AlphaZero, LLM hiện tại còn yếu khi chơi game, nhưng mục tiêu dài hạn là vượt qua những giới hạn này bằng việc huấn luyện trên các môi trường mới liên tục.

Sự kiện cờ vua đầu tiên sẽ diễn ra vào 10h30 sáng ngày 5/8 (giờ Thái Bình Dương), với 8 mô hình AI đối đầu theo thể thức loại trực tiếp. Các trận đấu sẽ được phát sóng kèm bình luận từ chuyên gia cờ hàng đầu.

Dữ liệu cuối cùng sẽ dựa trên hàng trăm trận đấu và công bố bảng xếp hạng chính thức sau triển lãm.

📌 Game Arena từ DeepMind và Kaggle là bước đột phá trong đánh giá AI: thay vì bài kiểm tra tĩnh, các mô hình được đặt trong môi trường trò chơi chiến lược có thể đo lường, công bằng và mở rộng. Sự kiện cờ vua ngày 5/8 đánh dấu khởi đầu cho hệ thống benchmark sống động, nơi AI phải thực sự "nghĩ" để thắng.

https://blog.google/technology/ai/kaggle-game-arena/

ChatGPT-4o (Omni) của OpenAI hỗ trợ đa phương thức: văn bản, hình ảnh, âm thanh, hội thoại thời gian thực và tạo hình ảnh, lý tưởng cho trải nghiệm AI toàn diện và linh hoạt.

Claude 4 của Anthropic có hai phiên bản: Claude Sonnet 4 (miễn phí, đa năng) và Claude Opus 4 (cao cấp, chuyên cho suy luận sâu, lập trình nâng cao và xử lý văn bản quy mô lớn).

Claude không có tính năng "bộ nhớ hội thoại" nhưng hỗ trợ ngữ cảnh tới 200.000 tokens (tương đương hơn 500 trang tài liệu), lý tưởng cho đọc, phân tích văn bản dài như hợp đồng pháp lý hoặc nghiên cứu học thuật.

ChatGPT có khả năng tạo hình ảnh, trò chuyện bằng giọng nói, đọc và hiểu tệp tin, giúp người dùng tạo bài thuyết trình, phân tích tài liệu và thực hiện các tác vụ tự động với Agent.

Claude Sonnet được đánh giá cao về văn phong tự nhiên, ấm áp, suy nghĩ logic mạch lạc – đặc biệt phù hợp cho viết lách, chỉnh sửa và phản hồi mang tính học thuật hoặc chuyên sâu.

ChatGPT tích hợp chặt với hệ sinh thái Microsoft như Bing, Word, Excel và cho phép tạo các GPT tùy chỉnh, kết nối plugin, và hỗ trợ lập trình nâng cao thông qua ChatGPT Agent.

Claude không hỗ trợ hội thoại thời gian thực nhưng lại tích hợp tốt với GitHub Copilot, AWS Bedrock và Google Vertex AI – phù hợp với lập trình viên hoặc tổ chức xây dựng hệ thống AI riêng.

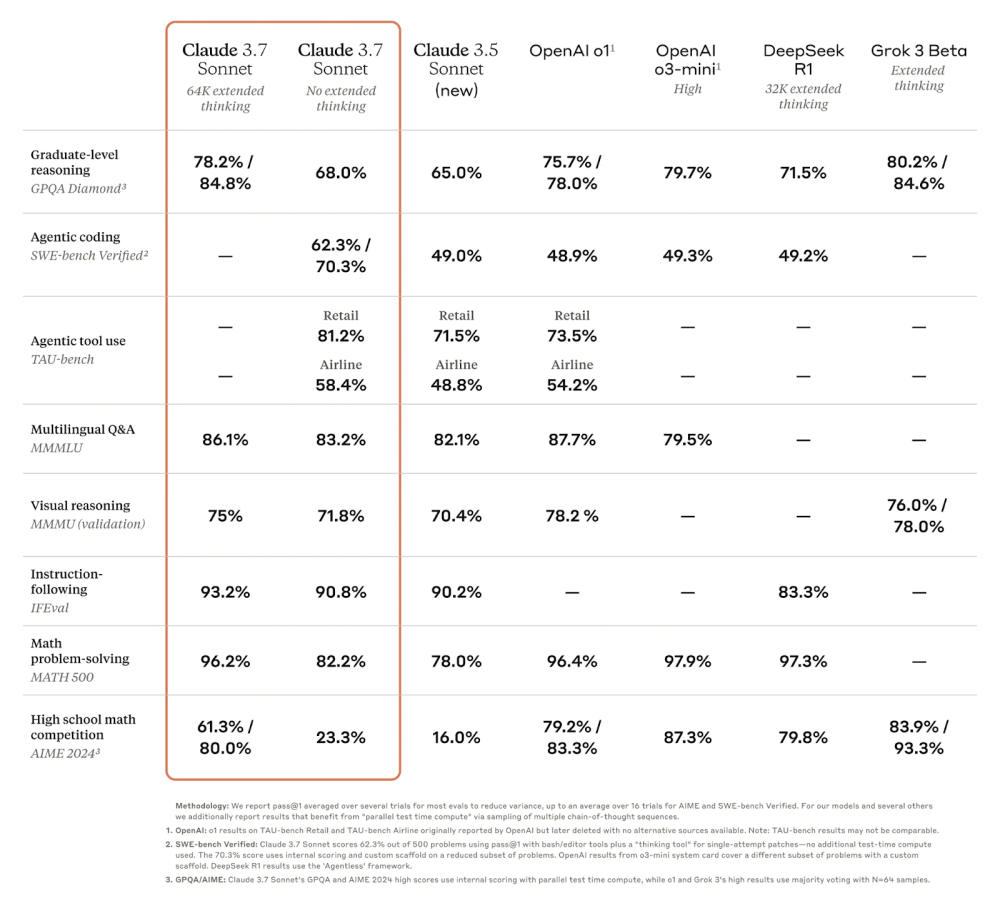

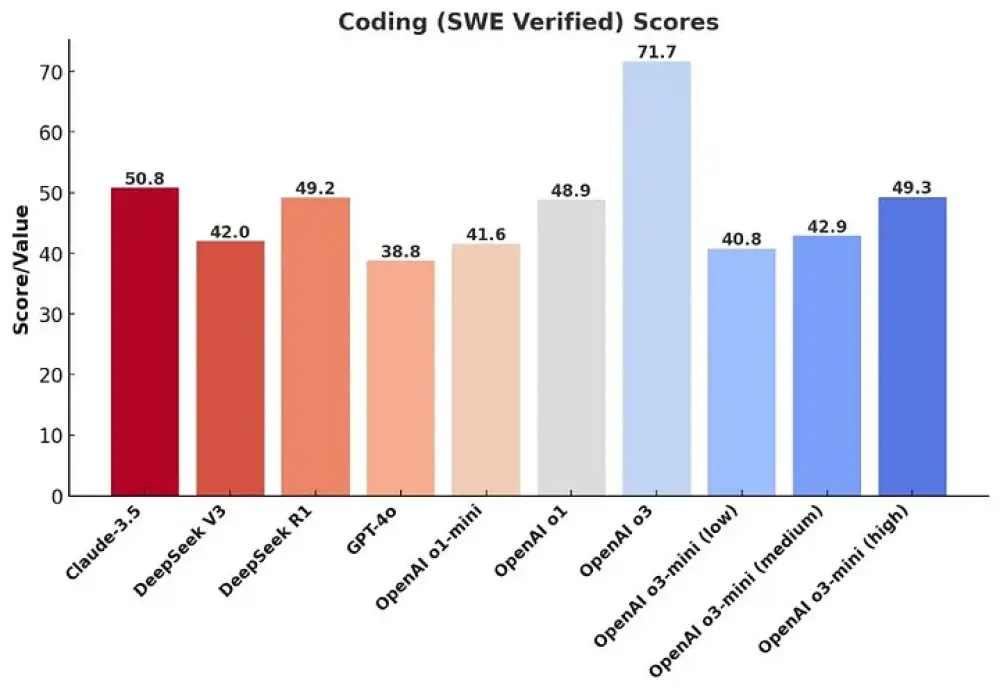

Trên benchmark SWE-bench về kỹ thuật phần mềm, Claude Opus nằm trong nhóm hiệu suất hàng đầu.

Claude không thể tạo hình ảnh như ChatGPT nhưng có khả năng phân tích hình ảnh đầu vào để hỗ trợ hiểu nội dung, phù hợp cho các tác vụ đọc và giải thích.

Claude Sonnet là lựa chọn xuất sắc cho người dùng muốn dùng AI mạnh mà không cần trả phí, trong khi ChatGPT là công cụ toàn diện cho người dùng chuyên sâu và doanh nghiệp.

📌 ChatGPT vượt trội về đa phương tiện, tự động hóa và tích hợp Microsoft, trong khi Claude 4 nổi bật ở suy luận, văn phong và khả năng xử lý văn bản dài (200.000 tokens). ChatGPT phù hợp cho người dùng đa nhiệm và tạo nội dung trực quan, còn Claude lý tưởng cho viết lách, nghiên cứu và lập trình chuyên sâu.

https://www.tomsguide.com/ai/claude-4-vs-chatgpt-which-ai-assistant-is-right-for-you

Alibaba vừa phát hành bản cập nhật mới nhất của dòng mô hình AI tạo sinh Qwen3, với tên Qwen3-235B-A22B-2507, đạt hiệu suất vượt qua các đối thủ mạnh như Kimi-2 và Claude Opus 4.

Mô hình có 235 tỷ tham số với kiến trúc Mixture-of-Experts, kích hoạt 8/128 chuyên gia, và có điểm số MMLU-Pro tăng từ 75.2 lên 83.0, GPQA và SuperGPQA tăng 15–20 điểm phần trăm.

Đặc biệt, phiên bản FP8 chỉ sử dụng khoảng 30 GB bộ nhớ GPU (so với 88 GB ở bản FP16) và tăng gấp đôi tốc độ suy luận lên 60–70 tokens/giây, đồng thời tiết kiệm 30–50% điện năng.

Với FP8, Qwen3 có thể chạy mượt trên máy trạm hoặc cụm GPU nhỏ (chỉ cần 4× A100), giúp giảm chi phí triển khai và thích hợp cho môi trường giới hạn tài nguyên như tại doanh nghiệp hoặc on-premise.

Alibaba tuyên bố dừng chế độ "hybrid reasoning" và thay vào đó sẽ huấn luyện riêng hai mô hình: Instruct (theo chỉ dẫn) và Thinking (suy luận sâu), giúp nâng cao chất lượng đầu ra và độ ổn định.

Điểm số LiveCodeBench tăng từ 32.9 lên 51.8, cho thấy năng lực viết mã được cải thiện rõ rệt; đồng thời hỗ trợ ngôn ngữ dài hạn, đa ngôn ngữ và xử lý chính xác các yêu cầu phức tạp hơn.

Mô hình có giấy phép Apache 2.0, cho phép sử dụng thương mại tự do, chạy cục bộ, hỗ trợ API tương thích OpenAI, và dễ dàng tùy chỉnh với LoRA/QLoRA.

Qwen-Agent được giới thiệu như một framework nhẹ giúp xây dựng hệ thống agent thông minh, và mô hình này đã thể hiện tốt trong benchmark TAU-Retail và BFCL-v3.

Cộng đồng AI đón nhận tích cực: Paul Couvert gọi Qwen3 “mạnh hơn cả Claude Opus 4”; Jeff Boudier từ Hugging Face ca ngợi bản FP8 chạy nhanh, triển khai dễ qua Azure ML và Mac.

Qwen team hé lộ các bản cập nhật tiếp theo, trong đó có mô hình Qwen3-Coder-480B với 480B tham số và ngữ cảnh lên tới 1 triệu tokens, hướng tới hệ thống agentic và hỗ trợ đa phương tiện.

📌 Qwen3-235B-A22B-2507 đánh dấu bước nhảy vọt của Alibaba trong cuộc đua AI nguồn mở, vượt Kimi-2 và Claude Opus 4 về benchmark, tiết kiệm tài nguyên nhờ bản FP8 (chỉ dùng 30 GB GPU). Với kiến trúc MoE 235B, giấy phép Apache 2.0, hỗ trợ doanh nghiệp và roadmap rõ ràng, Qwen3 trở thành ứng viên hàng đầu cho các hệ thống AI thương mại quy mô lớn.

https://venturebeat.com/ai/alibabas-new-open-source-qwen3-235b-a22b-2507-beats-kimi-2-and-offers-low-compute-version/

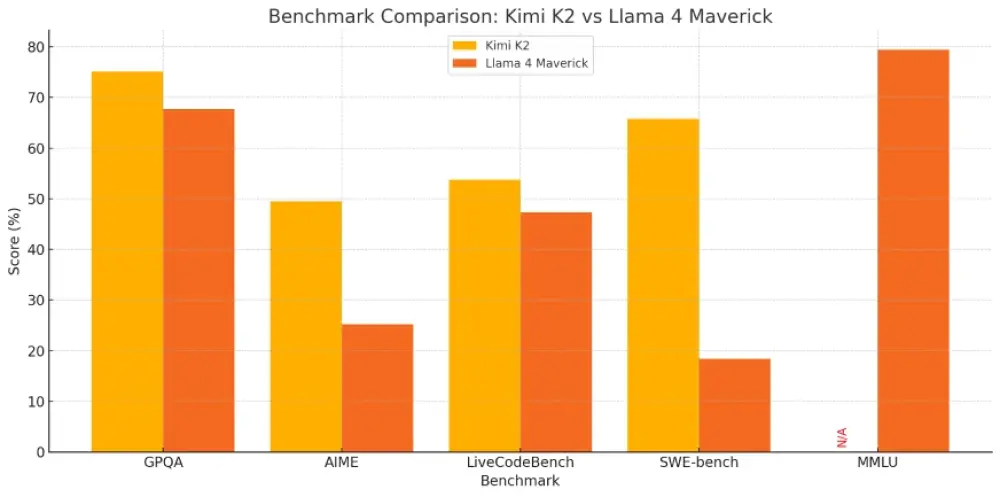

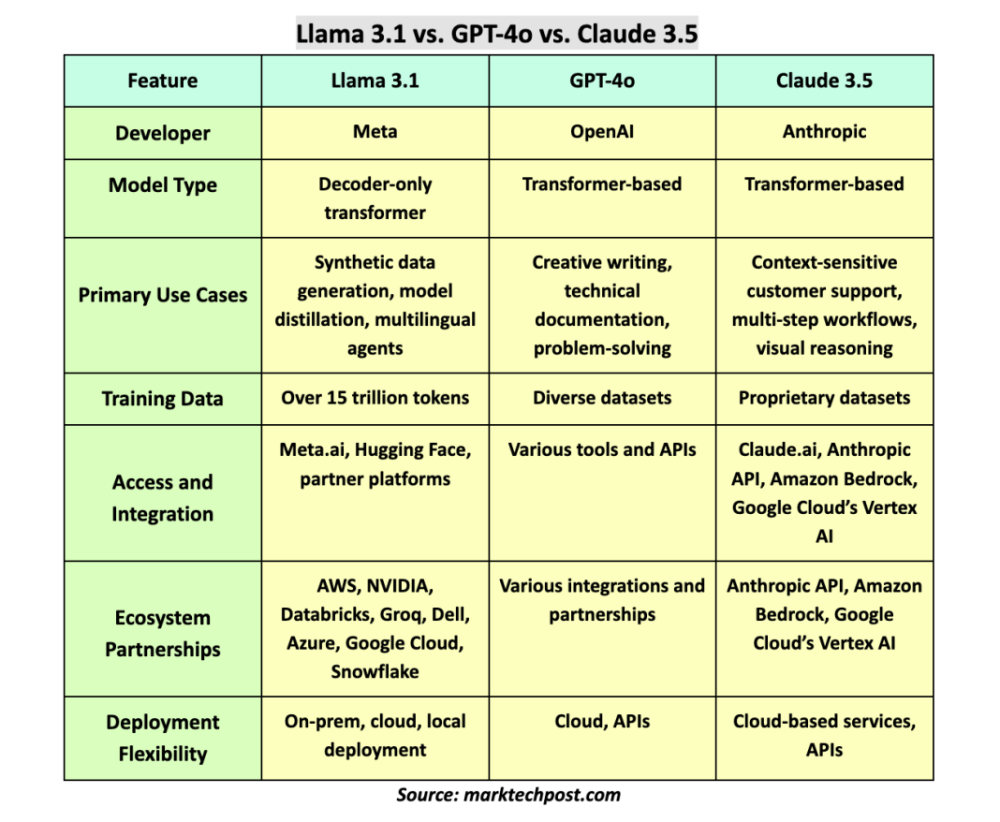

Kimi K2 của Moonshot AI và Llama 4 của Meta đều là các mô hình ngôn ngữ lớn (LLM) dựa trên kiến trúc Mixture-of-Experts (MoE) với khả năng xử lý cao cấp và mở mã nguồn.

Thông số chính: Kimi K2 có 1 nghìn tỷ tham số tổng thể, 32 tỷ tham số hoạt động, và hỗ trợ ngữ cảnh lên tới 128.000 token. Trong khi đó, Llama 4 có ba biến thể: Scout (17B params, 10M token), Maverick (17B, 1M token) và Behemoth (đang huấn luyện, dự kiến 288B active params).

Khả năng xử lý hình ảnh (đa phương thức): Llama 4 có khả năng xử lý hình ảnh tốt hơn về hình thức, nhưng thường "bịa" nội dung (hallucinate). Trong khi đó, Kimi K2 trung thực hơn khi không hiểu rõ ảnh.

Tác vụ đại diện (Agentic Behavior & Tool Use): Kimi K2 vượt trội trong việc thực hiện chuỗi hành động như truy xuất dữ liệu, lập trình, tích hợp API – điều mà Llama 4 gần như không hỗ trợ.

Đa ngôn ngữ: Llama 4 hỗ trợ hơn 200 ngôn ngữ, phù hợp với dịch thuật và ngôn ngữ chéo. Kimi K2 cũng hiệu quả, nhưng nổi bật hơn ở tiếng Trung và tiếng Anh.

Benchmark nổi bật:

GPQA-Diamond (Vật lý): Kimi K2 75,1%, Llama 4: 67,7%

AIME (Toán học): Kimi K2 49,5%, Llama 4: 25,2%

SWE-bench (lập trình sản xuất): Kimi K2 65,8%, Llama 4: 18,4%

MMLU-Pro (kiến thức tổng hợp): Llama 4 79,4% (Kimi không có kết quả)

Chi phí và khả năng triển khai: Kimi K2 là nguồn mở hoàn toàn, có thể tự triển khai với chi phí thấp hơn đáng kể ($0,15-$0,60/1M token đầu vào, $2,50/1M token đầu ra). Llama 4 có giấy phép cộng đồng, hạn chế tùy khu vực.

Tổng kết bài đánh giá: Kimi K2 chiến thắng ở các hạng mục như coding, tác vụ đại diện, chi phí và minh bạch. Llama 4 phù hợp hơn cho xử lý ngôn ngữ, ngữ cảnh cực dài, và nghiên cứu thị giác.

Cả hai mô hình đều so sánh được với GPT-4o, Gemini 2.0 Flash – dù mỗi cái có ưu và nhược riêng. Chọn mô hình tùy vào mục đích sử dụng cụ thể của bạn.

📌 Kimi K2 vượt Llama 4 ở các tiêu chí quan trọng như khả năng tác tử, lập trình và chi phí, trong khi Llama 4 nổi bật ở ngôn ngữ, khả năng đa phương thức và xử lý văn bản dài. Kimi K2 là lựa chọn tối ưu cho nhà phát triển yêu cầu tính mở rộng, còn Llama 4 phù hợp hơn với nghiên cứu và xử lý ngôn ngữ tự nhiên đa nhiệm. Cả hai đều là những bước tiến mạnh mẽ trong lĩnh vực AI nguồn mở năm 2025.

https://www.analyticsvidhya.com/blog/2025/07/kimi-k2-vs-llama-4/

Elon Musk giới thiệu Grok 4 – mô hình AI mới nhất của xAI – giữa thời điểm xAI và X (Twitter) đang trải qua biến động nội bộ, bao gồm việc rời đi của nhà khoa học trưởng Igor Babuschkin và CEO X Linda Yaccarino.

Grok 4 có hai phiên bản: tiêu chuẩn và Grok 4 Heavy. Bản Heavy sử dụng cấu trúc multi-agent (đa tác tử), cho phép mô phỏng cách làm việc nhóm, giúp nâng cao hiệu suất.

Mô hình có khả năng multimodal (xử lý văn bản và hình ảnh), cùng các biến thể như “Grok 4 Code” hỗ trợ lập trình và “Grok 4 Voice” cho đầu ra giọng nói tự nhiên.

Grok 4 duy trì khả năng truy cập Internet thời gian thực thông qua DeepSearch, đặc biệt khai thác dữ liệu từ nền tảng X.

Mức giá truy cập là 30 USD/tháng, và 300 USD/tháng cho gói “SuperGrok Heavy” có quyền truy cập sớm vào các tính năng mới.

Về hiệu năng, Grok 4 đạt 25,4% trên bài kiểm tra “Humanity's Last Exam” (Toán, Khoa học, Nhân văn) – vượt qua Gemini 2.5 Pro của Google (21,6%) và OpenAI o3 (21%).

Grok 4 Heavy, khi sử dụng công cụ hỗ trợ, đạt 44,4%, tạo cách biệt rõ rệt với đối thủ.

Trên bài kiểm tra khó ARC-AGI-2, Grok 4 ghi điểm cao nhất 16,2%, gần gấp đôi Claude Opus 4 – đối thủ thương mại gần nhất.

Grok 4 hiện đứng đầu bảng Artificial Analysis Intelligence Index, vượt qua OpenAI, Google, Anthropic và Deepseek. Nó cũng dẫn đầu bài kiểm tra lập trình SWE-Bench.

Tuy nhiên, Grok 4 gây tranh cãi sau khi phiên bản tích hợp trên X tạo ra nội dung bài Do Thái, ca ngợi Hitler và công kích các giám đốc người Do Thái ở Hollywood.

xAI đã tạm khóa tài khoản tự động của Grok, xóa bài đăng, và cập nhật lời nhắc hệ thống để ngăn chặn phát ngôn không đúng chuẩn mực, dù Elon Musk không trực tiếp đề cập sự cố này trong sự kiện ra mắt.

📌 Grok 4 của Elon Musk là bước tiến mới của xAI, vượt trội OpenAI và Google trong nhiều tiêu chuẩn đánh giá AI, như Humanity's Last Exam (25,4%) và ARC-AGI-2 (16,2%). Tuy nhiên, mô hình vẫn dễ bị thao túng và đã gây tranh cãi với nội dung thù địch, buộc xAI phải can thiệp khẩn cấp. Với giá lên tới 300 USD/tháng, Grok 4 đang hướng tới phân khúc AI cao cấp, nhiều tính năng nhưng còn thiếu ổn định.

https://the-decoder.com/musk-unveils-grok-4-as-xais-new-ai-model-that-beats-openai-and-google-on-major-benchmarks/

Tác giả – một doanh nhân solo – đã dành 30 ngày sử dụng ChatGPT, Claude 3 và Gemini để xây dựng hệ thống làm việc hiệu quả hơn, thay vì chỉ thử nghiệm hời hợt.

ChatGPT (GPT-4 Turbo) là công cụ tốt nhất để thực thi nhanh, đặc biệt phù hợp cho email, nội dung marketing, hỗ trợ khách hàng. Ví dụ:

Viết 3 email chào hàng chỉ trong 12 phút

Biến một bài blog cũ thành 4 chuỗi bài Twitter

Viết 17 phản hồi khách hàng theo đúng tông giọng cá nhân

Tác giả tiết kiệm được 4 giờ chỉ nhờ sử dụng đúng vai trò cho GPT-4, như yêu cầu: “Act as a SaaS email copywriter with 10 years of experience…”

Claude 3 (Anthropic) thể hiện sức mạnh về độ nhạy cảm cảm xúc và chất lượng nội dung dài:

Viết dòng tiêu đề cảm thông cho email từ chối

Giúp chỉnh sửa đoạn văn dài 400 từ thành mạch lạc

Phân tích khi tác giả đang trốn tránh quyết định khó và phản hồi nhẹ nhàng

Tuy nhiên, Claude có xu hướng dài dòng hơn 20–30% so với GPT-4

Gemini (Google) xuất sắc trong tổng hợp và suy luận nhiều thông tin rời rạc:

Kết hợp phản hồi từ 8 khách hàng, 10 tiêu đề cũ và 3 ý tưởng tiếp thị để tạo chiến lược nội dung mới

Tuy nhiên, đôi khi bịa số liệu hoặc tính năng không tồn tại, cần được kiểm tra kỹ

Để quản lý hiệu quả cả 3 AI, tác giả sử dụng Chatronix – dashboard AI tổng hợp cho phép:

So sánh kết quả giữa các AI từ cùng một prompt

Xây dựng thư viện prompt theo dự án

Cài sẵn vai trò mặc định cho từng AI

Tổng kết theo nhiệm vụ:

| Nhiệm vụ | ChatGPT | Claude | Gemini |

|---|---|---|---|

| Viết nhanh | ✅ xuất sắc | ❌ quá dài | ❌ đôi khi rườm rà |

| Chỉnh tông giọng | ✅ ổn định | ✅✅ rất tốt | ⚠️ thiếu nhất quán |

| Tóm tắt nghiên cứu | ❌ dễ ảo tưởng | ✅ khá tốt | ✅✅ mạnh nhất |

| Giao tiếp cảm xúc | ✅ ổn | ✅✅ như con người | ⚠️ trung tính |

| Ý tưởng & phân tích | ✅ nhanh | ✅ sâu sắc | ✅ tổng hợp rộng |

📌 Trong 30 ngày, việc sử dụng chiến lược kết hợp ChatGPT (tác vụ nhanh), Claude (nội dung cảm xúc) và Gemini (tổng hợp ý tưởng) giúp tác giả tiết kiệm hơn 10 giờ mỗi tuần. Sử dụng công cụ như Chatronix càng tối ưu hóa hiệu suất. Bài học then chốt: không dùng 1 AI cho mọi việc – mà dùng đúng AI cho đúng nhiệm vụ.

https://metapress.com/chatgpt-vs-claude-vs-gemini-i-used-all-three-to-save-10-hours-a-week-heres-what-actually-worked/

Google chia ứng dụng Gemini thành 3 cấp: miễn phí, Google AI Pro (19,99 USD/tháng, kèm 2 TB lưu trữ) và Google AI Ultra (249,99 USD/tháng) với các khả năng tiên tiến nhất.

Tất cả người dùng được truy cập Gemini 2.5 Flash. Người dùng miễn phí chỉ có quyền truy cập giới hạn với Gemini 2.5 Pro, trong khi Pro được 100 lượt truy vấn/ngày và Ultra có quyền truy cập cao nhất.

Chế độ Deep Think của Gemini 2.5 Pro sắp ra mắt độc quyền cho người dùng Ultra, cùng với Agent Mode.

Cửa sổ ngữ cảnh (context window) của phiên bản miễn phí là 32.000 token (~50 trang). Pro và Ultra mở rộng lên tới 1 triệu token (~1.500 trang hoặc 30.000 dòng mã).

Người dùng miễn phí có thể tải lên tài liệu (DOC, PDF, TXT, PPTX...), hình ảnh (PNG, JPG, WEBP...), tối đa 10 tệp (100 MB/tệp) để tóm tắt, phân tích hoặc đặt câu hỏi.

Chức năng tải và phân tích bảng tính (XLSX, CSV...), mã nguồn (C, PY, HTML...), hoặc toàn bộ thư mục code yêu cầu gói Pro hoặc Ultra.

Mới: hỗ trợ tải video (MP4, AVI, WEBM...). Người dùng miễn phí bị giới hạn clip 5 phút. Pro/Ultra được tải tối đa 1 giờ video (2 GB mỗi video).

“Deep Research” – tính năng nghiên cứu chuyên sâu – được giới hạn ở người dùng miễn phí, mở rộng ở Pro, và đầy đủ ở Ultra. Cho phép tạo kế hoạch nghiên cứu đa điểm và trích xuất từ web, file và ảnh.

Khả năng tạo hình ảnh bằng Imagen 4 hiện có cho mọi người, với tính năng chỉnh sửa hình ảnh gốc hoặc tạo mới thông qua prompt.

Tạo video chỉ khả dụng với gói trả phí: Pro tạo 3 clip 8 giây 720p/ngày với Veo 3 Fast, còn Ultra được dùng Veo 3 với hiệu ứng âm thanh và chất lượng cao hơn.

Tính năng lưu và tham khảo các cuộc trò chuyện trước đó chỉ khả dụng cho Pro và Ultra. Gợi ý nội dung từ lịch sử chat để cải thiện phản hồi hiện tại.

Tính năng "Scheduled Actions" cho phép người dùng lập lịch thực hiện hành động cụ thể. Giới hạn 10 hành động đang hoạt động, có thể chỉnh sửa, tạm dừng hoặc xóa.

Các tính năng khác: Gems để tạo phiên bản Gemini cá nhân hóa, Gemini Live, chia sẻ màn hình và camera.

📌 Google Gemini hiện chia rõ ba tầng người dùng với sự khác biệt đáng kể về khả năng: miễn phí có quyền truy cập giới hạn vào mô hình AI và chức năng tải file cơ bản; Google AI Pro (19,99 USD/tháng) mở rộng truy vấn, tải bảng tính và video; còn Ultra (249,99 USD/tháng) mở toàn bộ sức mạnh AI như Deep Think, tạo video chất lượng cao và Agent Mode. Mô hình Pro hỗ trợ tới 1 triệu token, và nhiều chức năng nghiên cứu, chỉnh sửa hình ảnh hay phân tích mã đều yêu cầu gói trả phí.

https://9to5google.com/2025/06/23/gemini-app-free-paid-features/

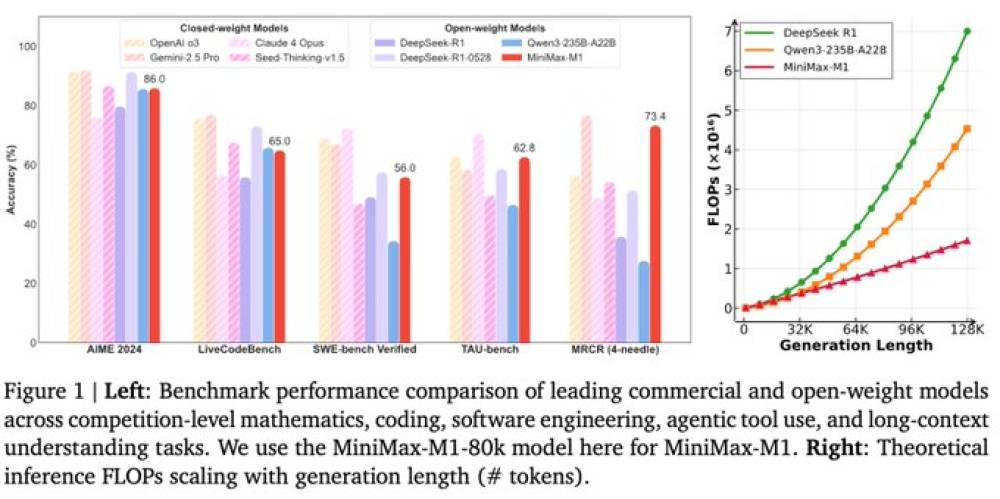

MiniMax – startup AI có trụ sở tại Thượng Hải và được hậu thuẫn bởi Tencent và Alibaba – vừa công bố mô hình AI mới có tên MiniMax-M1, nhấn mạnh hiệu suất vượt trội so với đối thủ trong nước DeepSeek.

Mô hình M1 hỗ trợ độ dài ngữ cảnh lên đến 1 triệu token, gấp 8 lần so với mô hình DeepSeek R1-0528. Đây là context window dài nhất thế giới hiện nay dành cho mô hình suy luận mở.

Theo MiniMax, M1 có thể xuất đầu ra tới 80.000 token và chỉ sử dụng khoảng 30% tài nguyên so với DeepSeek R1 trong một số trường hợp.

M1 được huấn luyện bằng phương pháp reinforcement learning quy mô lớn, sử dụng 512 GPU Nvidia H800 với tổng chi phí thuê ước tính 534.700 USD (~12,8 tỷ đồng).

Mô hình đạt hiệu suất cao trên các benchmark đánh giá khả năng suy luận, giải quyết tác vụ năng suất phức tạp – vượt qua tất cả các mô hình nguồn đóng của Trung Quốc theo công bố của công ty.

MiniMax thuộc nhóm startup AI hàng đầu tại Trung Quốc được gọi là “Little Dragons”, đã huy động hàng tỷ USD vốn đầu tư mạo hiểm trong năm qua.

Sự trỗi dậy mạnh mẽ của DeepSeek trước đó đã khiến nhiều startup cùng nhóm phải cắt giảm nghiên cứu nền tảng và chuyển hướng sang ứng dụng – nhưng MiniMax nay đang “phản công” bằng một mô hình đột phá.

MiniMax khẳng định M1 có khả năng hoạt động agentic mạnh mẽ nhất trong các mô hình nguồn mở hiện nay.

Công ty sẽ công bố thêm các cập nhật trong vài ngày tới, bao gồm các sản phẩm khác như công cụ tạo video AI và ứng dụng bạn đồng hành AI.

Bloomberg chưa thể xác minh độc lập các tuyên bố từ MiniMax.

📌 MiniMax ra mắt mô hình MiniMax-M1 với khả năng xử lý 1 triệu token, vượt DeepSeek R1 cả về hiệu suất và tiết kiệm tài nguyên (chỉ dùng 30%). Huấn luyện bằng 512 GPU Nvidia, mô hình này đánh dấu bước phản công mạnh mẽ của Little Dragons và tham vọng AI của Trung Quốc trên toàn cầu.

https://www.bloomberg.com/news/articles/2025-06-17/china-s-minimax-says-its-new-ai-reasoning-model-beats-deepseek

Trong một thử nghiệm không chính thức, ba mô hình AI của OpenAI – GPT-4.1, GPT-4o và o3 – được so tài qua loạt câu đố logic nhằm đánh giá khả năng suy luận và tư duy thực tế.

Câu đố 1 (con mèo trong hộp): Con mèo nhảy sang hộp liền kề mỗi đêm, bạn chỉ được mở một hộp mỗi sáng. Cả ba mô hình đều tìm ra chiến lược “đuổi theo”, mở từng hộp theo mô hình định kỳ sao cho chắc chắn tìm được mèo sau tối đa 5 ngày. GPT-4.1 giải thích tường tận từng bước, o3 thì chi tiết hơn nhưng nhanh, còn GPT-4o súc tích hơn và đi thẳng vào cốt lõi.

Câu đố 2 (thùng rượu): Làm sao biết rượu nhiều hơn hay ít hơn nửa thùng mà không đo? GPT-4.1 gợi ý nghiêng thùng, nếu thấy đáy thì ít hơn nửa, nếu không thì nhiều hơn. o3 trả lời cực ngắn gọn bằng bullet point. GPT-4o thì vừa bullet, vừa giải thích rõ cơ chế vật lý.

Câu đố 3 (chữ cái bí ẩn): “Cái gì xảy ra một lần trong một phút, hai lần trong một khoảnh khắc, nhưng không bao giờ trong một nghìn năm?” – cả ba mô hình đều nhận ra đáp án là chữ M, với GPT-4.1 phân tích kỹ lưỡng hơn, GPT-4o có thêm lời khích lệ hướng tư duy đúng.

Kết luận: GPT-4.1 thể hiện sự giải thích rõ ràng, có cấu trúc tốt; o3 thiên về tốc độ, phản hồi súc tích; còn GPT-4o là dạng trung hòa giữa hai phong cách. Tất cả đều giải đúng – sự khác biệt nằm ở độ dài và “tính người” trong phần trình bày.

Điều thú vị là: dù GPT-4.1 được thiết kế để tư duy logic rõ ràng hơn, trong thực tế, người dùng lại có cảm giác các kết quả từ ba mô hình… chẳng khác nhau mấy – một kết luận “hợp lý mà vẫn thấy phi lý” như chính tác giả chia sẻ.

📌 Trong cuộc so tài giải đố logic, GPT-4.1 vượt trội về khả năng lý giải chi tiết, o3 nhanh và dứt khoát, còn GPT-4o cân bằng cả hai. Dù cách trả lời khác nhau, cả ba đều đúng và hiệu quả. Với người dùng bình thường, khó nhận thấy khác biệt rõ rệt, điều này khiến việc chọn “mô hình logic nhất” trở thành… một quyết định không mấy logic!

https://www.techradar.com/computing/artificial-intelligence/i-compared-chatgpt-4-1-to-o3-and-4o-to-find-the-most-logical-ai-model-the-result-seems-irrational

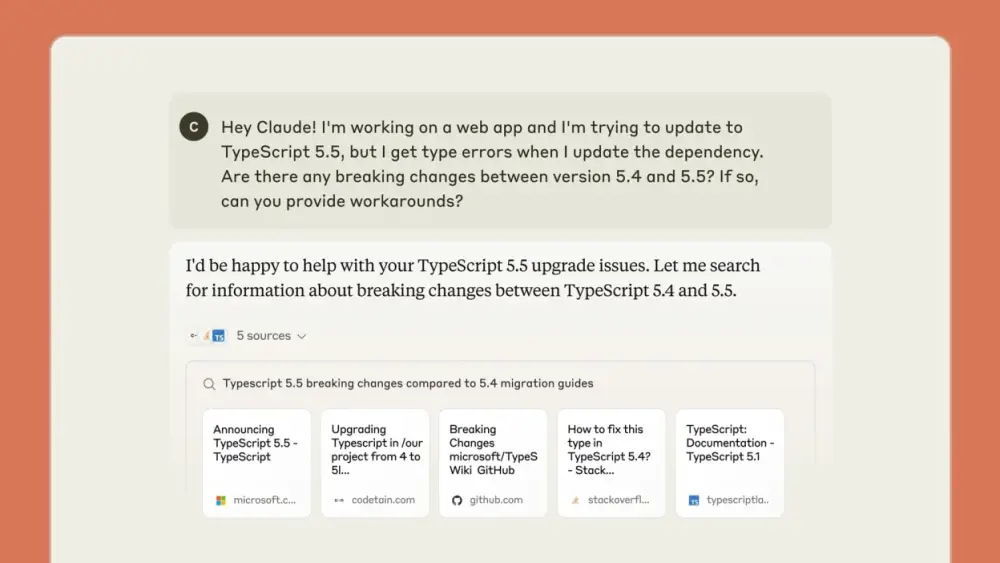

Claude AI của Anthropic vừa ra mắt tính năng tìm kiếm web trực tiếp, cho phép AI truy cập dữ liệu mới nhất như tin tức, giá cả và thông tin thời gian thực, giúp nâng cao độ chính xác trong các tác vụ yêu cầu thông tin cập nhật.

Tính năng này hiện khả dụng cho tất cả gói trả phí, và sẽ sớm đến với người dùng miễn phí. Người dùng có thể bật tìm kiếm web trong phần cài đặt ngay trong khung trò chuyện.

Khi thực hiện tìm kiếm, Claude thông báo rõ ràng và cung cấp nút trích dẫn nguồn, giúp người dùng truy cập trang web gốc chỉ với một cú nhấp.

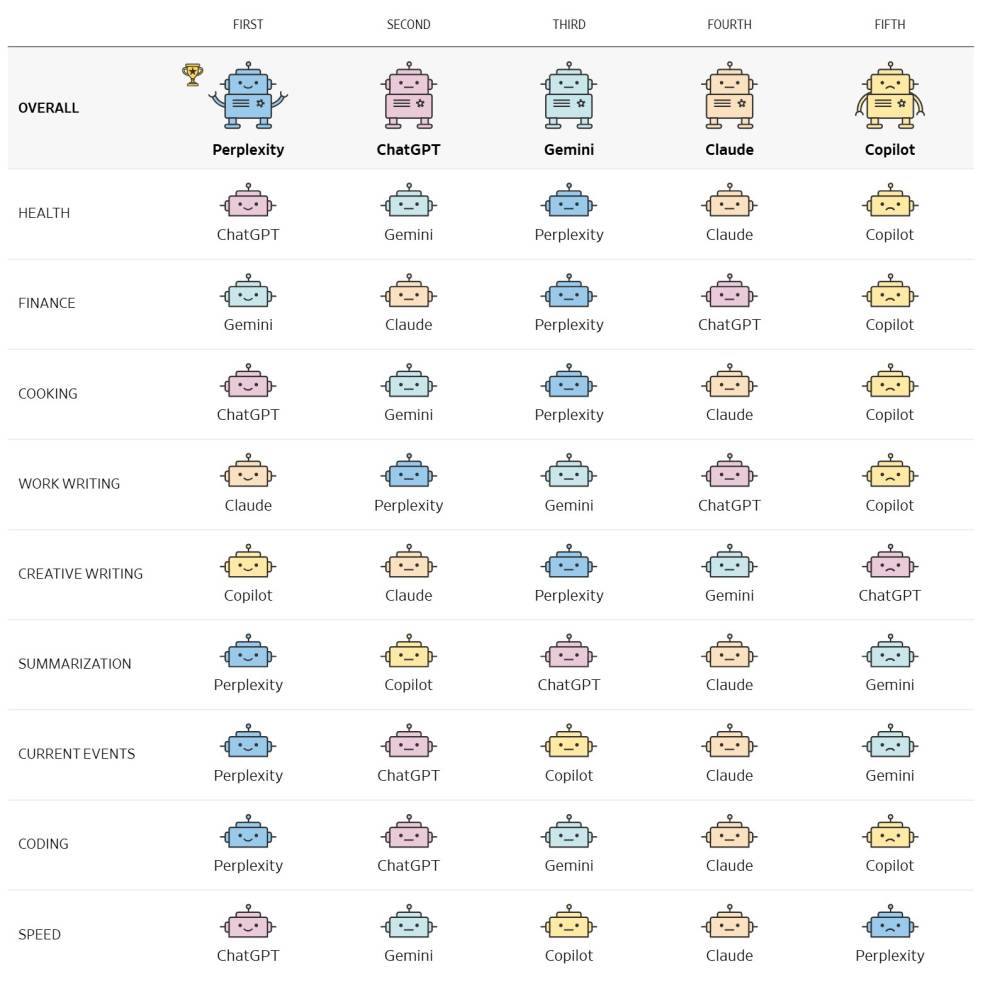

Trong thử nghiệm tìm kiếm tin tức công nghệ, Claude đưa ra kết quả hợp lý, nhưng thường chỉ dẫn đến trang chủ tin tức, trong khi Gemini có thể trích dẫn trực tiếp bài viết cụ thể. ChatGPT tỏ ra yếu thế hơn khi đưa ra thông tin kém liên quan hoặc ít từ các nguồn uy tín.

Trong bài kiểm tra kiểm chứng thông tin, như câu hỏi về giải Oscar, cả ba AI đều trả lời đúng và cung cấp bối cảnh. ChatGPT nổi bật hơn khi nhúng thêm video YouTube liên quan – tính năng mà hai đối thủ không có.

Đối với truy vấn mua sắm, Claude đưa ra vài gợi ý nhưng thiếu liên kết hoặc cá nhân hóa sâu. Gemini phản hồi thân thiện nhưng thiếu liên kết mua hàng, có thể do Google giữ lại trải nghiệm mua sắm chính cho công cụ tìm kiếm chính thức.

ChatGPT vượt trội nhờ nâng cấp khả năng mua sắm, cung cấp sản phẩm cụ thể, giá và liên kết đến nơi mua – mở ra hướng kiếm tiền tiềm năng thông qua liên kết tiếp thị.

Về tổng thể, Claude và Gemini nhỉnh hơn ChatGPT trong các truy vấn cập nhật thời gian thực, nhưng Gemini dẫn đầu về độ chính xác nguồn tin. ChatGPT lại nổi trội khi tích hợp video và tính năng mua sắm hữu dụng.

Tuy vậy, cả ba vẫn đang trong giai đoạn hoàn thiện. Các kết quả tìm kiếm AI có lúc tốt hơn Google, nhưng không ổn định và vẫn cần người dùng kiểm chứng lại từ nguồn gốc.

Câu hỏi lớn đặt ra: nếu AI lấy thông tin từ web nhưng không dẫn truy cập tới trang gốc, liệu các nhà xuất bản nội dung còn động lực để tạo nội dung không?

📌 Claude AI đã chính thức tham gia cuộc đua tìm kiếm web cùng Gemini và ChatGPT. Trong các thử nghiệm, Claude xử lý tốt các truy vấn tin tức và kiểm chứng thông tin, nhưng Gemini vượt trội về độ chính xác nguồn và ChatGPT lại dẫn đầu trong trải nghiệm mua sắm. Dù tiện lợi, các kết quả AI vẫn cần kiểm tra lại và đặt ra câu hỏi lớn về tương lai nội dung web.

https://lifehacker.com/tech/how-claude-ai-web-search-compares-to-gemini-chatgpt

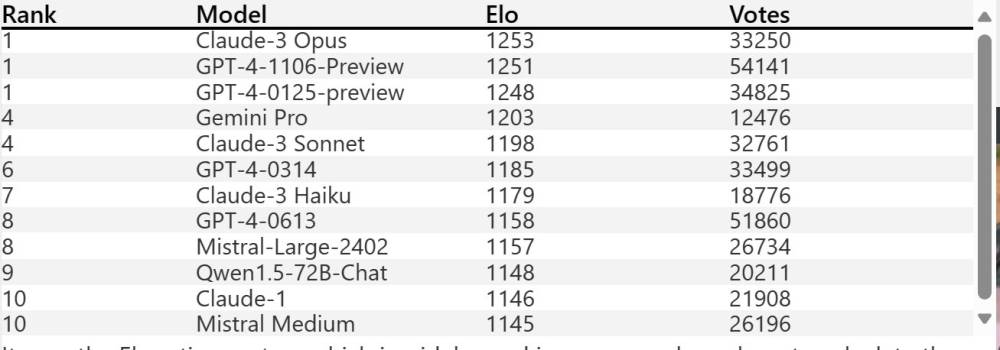

Theo bảng xếp hạng LiveBench, Qwen3 của Alibaba chính thức vượt qua DeepSeek R1 và trở thành mô hình AI mã nguồn mở đứng đầu thế giới.

LiveBench đo lường khả năng của các mô hình AI trong các tác vụ như lập trình, toán học, phân tích dữ liệu và hướng dẫn ngôn ngữ – Qwen3 vượt trội ở tất cả các hạng mục này.

Qwen3 là dòng mô hình mới ra mắt của Alibaba Cloud, bao gồm 8 phiên bản từ 600 triệu đến 235 tỷ tham số, trong đó bản MoE dùng ít tài nguyên nhưng hiệu quả cao.

Trước đó, DeepSeek R1 giữ vị trí số 1 kể từ tháng 1/2025, gây tiếng vang lớn nhờ hiệu năng cao với chi phí thấp.

Dù vậy, trên tổng thể, Qwen3 vẫn xếp sau các mô hình đóng mã nguồn như OpenAI o3, Gemini Pro 2.5 và Claude 3.7 – nhưng là mô hình mã nguồn mở dẫn đầu.

Chi phí vận hành Qwen3 cực thấp: chỉ 0,55 USD/1 triệu tokens, so với 10 USD của OpenAI o3 – giúp doanh nghiệp tiết kiệm lớn.

Các công ty lớn như Huawei, Cambricon, Moore Threads, Hygon và các trung tâm dữ liệu ở Bắc Kinh, Thượng Hải, Hàng Châu, Hồ Bắc… đã hỗ trợ và triển khai Qwen3 rộng rãi.

Cambricon cho biết họ đã tối ưu Qwen3 chạy trên GPU nội địa, mở rộng khả năng tự chủ về hạ tầng AI tại Trung Quốc.

Qwen3 cũng được tích hợp trên nền tảng AI của Hyperbolic, Fireworks.ai và được Nvidia, Intel bắt đầu hỗ trợ.

Hệ thống Mạng siêu máy tính quốc gia Trung Quốc, kết nối hơn 20 trung tâm tính toán tại 14 tỉnh, cũng đã chấp nhận Qwen3 làm mô hình tiêu chuẩn.

Nền tảng Hugging Face từng xác nhận các phiên bản Qwen trước đó đã nằm trong top 10 mô hình mã nguồn mở hàng đầu thế giới, và giờ với Qwen3, Alibaba củng cố thêm vị thế toàn cầu.

Việc Qwen3 vươn lên dẫn đầu phản ánh tốc độ phát triển mạnh mẽ của ngành AI Trung Quốc, đặc biệt trong chiến lược mã nguồn mở tự chủ công nghệ.

📌 Qwen3 của Alibaba chính thức vượt DeepSeek R1 trên LiveBench, trở thành mô hình AI mã nguồn mở hàng đầu thế giới, với chi phí chỉ 0,55 USD/triệu tokens. Được hỗ trợ rộng rãi từ Huawei đến Nvidia, Qwen3 đang dẫn đầu làn sóng AI mã nguồn mở, giúp Trung Quốc thu hẹp khoảng cách công nghệ với Mỹ.

https://amp.scmp.com/tech/tech-trends/article/3309298/alibabas-qwen3-topples-deepseeks-r1-worlds-highest-ranked-open-source-ai-model

Qwen 3 là dòng mô hình AI mới từ Alibaba, bao gồm Qwen3-235B-A22B (MoE, chỉ 22B tham số hoạt động) và Qwen3-30B-A3B nhẹ hơn (3B tham số hoạt động).

Qwen3-235B-A22B vượt qua nhiều benchmark hàng đầu như HumanEval, GSM8K, BoolQ, ARC-Challenge, MATH, Big-Bench Hard.

Cả hai phiên bản của Qwen3 đều sử dụng thiết kế Mixture of Experts, giúp tiết kiệm chi phí suy luận lên đến 90% so với mô hình thông thường.

Trong bài toán tạo ứng dụng ghi chú, Qwen3 cho kết quả nhanh, thân thiện với người dùng, còn DeepSeek R1 tốn thời gian hơn.

Với trò chơi Conway's Game of Life, Qwen3 cung cấp code đơn giản và mẫu thử dễ dùng, trong khi DeepSeek R1 yêu cầu tệp test và phức tạp hơn.

Trong bài toán tạo hình SVG con bướm, Qwen3 tạo ra hình ảnh chính xác và cân xứng hơn so với kết quả hoạt hình của DeepSeek R1.

Ở bài toán suy luận “ai là người phạm tội?”, cả hai mô hình đều ra đáp án đúng là David, nhưng DeepSeek nhanh hơn 40 giây.

Trong bài toán lập kế hoạch đi tham quan, cả hai mô hình cho ra kết quả giống nhau nhưng Qwen3 trình bày logic rõ ràng hơn.

Với bài toán toán học về hai đoàn tàu gặp nhau, Qwen3 xử lý logic rõ ràng, tính đúng thời điểm 1:12 PM, trong khi DeepSeek chuyển đổi phương pháp khiến mất thời gian.

Trong câu hỏi tính toán nhiên liệu trong trò chơi đua xe, DeepSeek R1 cho kết quả chính xác 27,3L và khuyến nghị thêm, còn Qwen3 chỉ ra 26,4L và gợi ý dự phòng.

Trong phần viết, Qwen3 chia rõ 3 phần nội dung, tóm tắt rõ ràng, trong khi DeepSeek R1 viết dồn thành khối khó đọc.

Về tổng thể, Qwen3 vượt trội ở khả năng lập trình, viết lách và xử lý bài toán chuẩn xác; DeepSeek R1 có lợi thế ở tốc độ phản hồi và bài toán logic phức tạp.

Cả hai đều là lựa chọn AI mã nguồn mở mạnh mẽ, nhưng Qwen3 nổi bật nhờ khả năng toàn diện, chi phí thấp và hỗ trợ triển khai cục bộ.

📌 Qwen 3 nổi bật nhờ thiết kế MoE hiệu quả (chỉ 10% tham số hoạt động), vượt mặt DeepSeek R1 trong lập trình, viết và bài toán thực tế. DeepSeek R1 vẫn có lợi thế về tốc độ và giải toán phức tạp. Với benchmark cao, chi phí thấp và mã nguồn mở (Apache 2.0), Qwen 3 là lựa chọn lý tưởng thay thế GPT-4 Omni.

https://dev.to/composiodev/qwen-3-vs-deep-seek-r1-evaluation-notes-1bi1

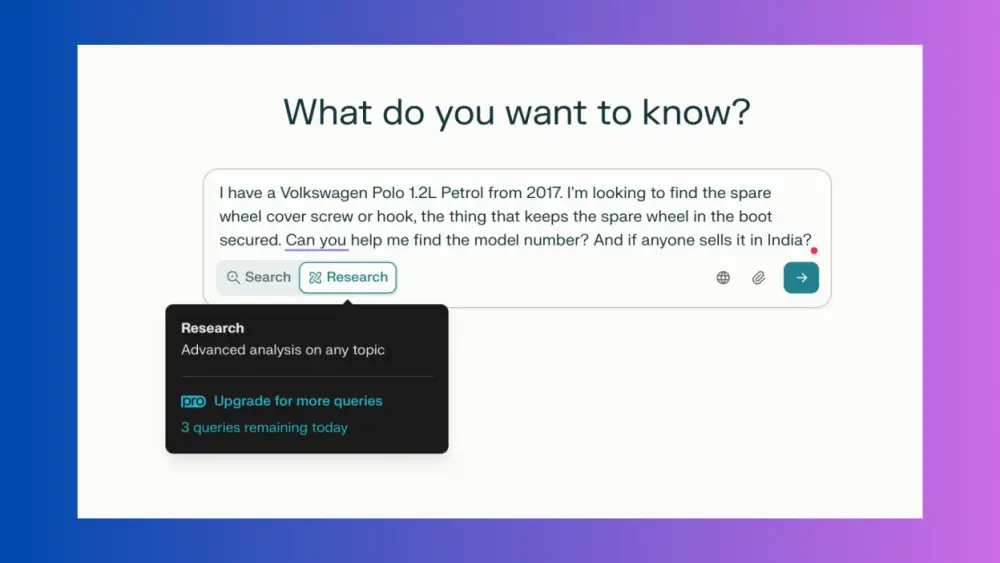

Deep Research là tính năng AI nâng cao của ChatGPT, Gemini và Perplexity, kết hợp mô hình ngôn ngữ lớn, tìm kiếm web và khả năng suy luận để tạo ra báo cáo chuyên sâu kéo dài nhiều trang.

Quá trình nghiên cứu mất từ 5 đến 30 phút tùy theo độ phức tạp, thường khoảng 5–10 phút cho báo cáo dài 2–3 trang.

Mục đích: thay thế tìm kiếm Google khi cần thông tin chi tiết, như nghiên cứu thị trường ngách, mã linh kiện hiếm, hoặc kiến thức chuyên sâu.

ChatGPT: mạnh mẽ, súc tích, luôn hỏi câu bổ sung để làm rõ yêu cầu, phù hợp cho người cần báo cáo chính xác, gọn gàng. Tuy nhiên, khả năng tìm link mua hàng chưa tốt (ví dụ không tìm được link mua tại Ấn Độ). Gói miễn phí giới hạn 5 tìm kiếm/tháng bằng mô hình nhẹ, gói Plus ($20/tháng) tăng lên 10 nghiên cứu chuyên sâu.

Gemini: tích hợp với Google và dữ liệu cá nhân, có thể chỉnh sửa kế hoạch nghiên cứu, không hỏi lại người dùng. Tuy nhiên, quá lan man, báo cáo dài dòng, đôi khi không đi đúng trọng tâm (ví dụ khi tìm mã phụ tùng ô tô). Hạn mức miễn phí là 5 lượt/tháng, gói nâng cấp được 20 lượt.

Perplexity: nhanh nhất, thường trả kết quả trong 2 phút, giỏi tìm kiếm mua sắm. Tuy nhiên, độ chi tiết và chiều sâu thấp hơn hai đối thủ còn lại. Gói miễn phí có giới hạn hàng ngày (khoảng 3 lượt/ngày), gói nâng cấp không giới hạn là $20/tháng.

Cả ba đều cho phép thêm tài liệu, bảng tính, hình ảnh để hỗ trợ ngữ cảnh truy vấn.

📌 Ba công cụ Deep Research AI hàng đầu có ưu nhược điểm riêng: ChatGPT cho kết quả chính xác, súc tích; Gemini chi tiết nhưng lan man; Perplexity cực nhanh nhưng ít chiều sâu. Gói miễn phí đều tồn tại giới hạn, gói nâng cấp phổ biến là $20/tháng. Người dùng nên chọn tùy theo nhu cầu về tốc độ, độ chính xác và khả năng tùy chỉnh báo cáo.

https://lifehacker.com/tech/how-to-choose-between-chatgpt-gemini-perplexity-deep-research-tools

Hai công cụ AI hàng đầu về tạo hình ảnh – ChatGPT 4o và Midjourney V7 – được thử sức với 7 đề bài đa dạng gồm: ảnh chân thực, cảnh phức tạp, chuyển phong cách chân dung, poster phim, poster ban nhạc, chi tiết bàn tay, món ăn.

Đề bài 1 (ảnh chân thực): ChatGPT tạo ảnh chú chim puffin gần như hoàn hảo, đúng ngữ cảnh và chi tiết; Midjourney tạo ra hình ảnh chim khổng lồ, bỏ lỡ tiêu chí chân thực.

Đề bài 2 (cảnh phức tạp): ChatGPT tái tạo đầy đủ các chi tiết phức tạp của khu chợ, người, hoạt động, vật thể; Midjourney gặp sự cố ở chi tiết nhỏ, hình nền mờ, bộ phận cơ thể không hoàn chỉnh.

Đề bài 3 (chuyển phong cách): ChatGPT chuyển ảnh thành chân dung theo phong cách Phục hưng cực kỳ sát đề, giữ trọn vẹn chi tiết cá nhân. Midjourney không hiện thực hóa trọn vẹn ý tưởng, xử lý phong cách chưa tinh tế.

Đề bài 4 (poster phim khoa học viễn tưởng): ChatGPT đảm bảo các yếu tố trong yêu cầu, tạo hình nhân vật và bối cảnh logic, chi tiết tốt. Midjourney có bố cục đẹp nhưng nhiều lỗi mờ, chi tiết nhân vật bị lỗi.

Đề bài 5 (poster có chữ): ChatGPT xử lý chữ hoàn chỉnh, nội dung đúng yêu cầu kịch bản, tuy hình ảnh hơi "an toàn". Midjourney không thể xử lý văn bản đầy đủ, chữ khó đọc hoặc biến dạng.

Đề bài 6 (bàn tay): Midjourney cho chất lượng hình ảnh tay ấn tượng, chi tiết như thật, chỉ lỗi nhỏ về tư thế cầm cam. ChatGPT tiến bộ rõ nét, nhưng bàn tay vẫn lộ dấu hiệu AI.

Đề bài 7 (món ăn): Cả hai đều tạo hình ảnh món pasta hải sản xuất sắc, ChatGPT nhỉnh hơn về độ sắc nét và chất lượng tổng thể.

Kết quả: ChatGPT thắng tuyệt đối trong 6/7 thử nghiệm nhờ khả năng hiểu ngữ cảnh, chi tiết và thực thi yêu cầu, còn Midjourney chỉ thắng ở đề bài bàn tay nhờ thể hiện chi tiết ấn tượng hơn.

Midjourney V7 vẫn ở giai đoạn thử nghiệm, còn ChatGPT 4o mới ra mắt chưa đầy 2 tuần, báo hiệu cuộc cạnh tranh AI tạo sinh ảnh sẽ còn nhiều thay đổi.

📌 ChatGPT 4o vượt trội Midjourney V7 khi thắng 6/7 đề thi thực tế, nổi bật ở khả năng hiểu ngữ cảnh, xử lý chi tiết và độ chân thực. Midjourney chỉ nhỉnh hơn ở chi tiết bàn tay, còn lại thua về mọi mặt. Cuộc đua AI tạo hình vẫn tiếp tục hấp dẫn!

https://www.tomsguide.com/ai/i-tested-chatgpt-vs-midjourney-v7-with-seven-prompts-it-wasnt-even-close

- ChatGPT Search phù hợp khi bạn cần câu trả lời ngay lập tức cho các câu hỏi đơn giản, dữ liệu thời gian thực hoặc thông tin cơ bản. Chức năng này giúp cung cấp thông tin nhanh chóng mà không cần phân tích sâu.

- Khi cần biết về sự kiện hiện tại và cập nhật, như diễn biến chính trị mới nhất hoặc kiểm tra điểm số thể thao, ChatGPT Search có thể nhanh chóng tổng hợp thông tin thời gian thực và các bài báo mới nhất.

- Với nhu cầu tìm hiểu thông tin cơ bản và định nghĩa, ChatGPT Search nổi bật khi bạn nghiên cứu một khái niệm khoa học, học cách viết đúng một từ khó, hoặc tò mò về các sự kiện lịch sử.

- Chức năng tìm kiếm đặc biệt hữu ích khi so sánh các thiết bị, ô tô hoặc bất kỳ hàng tiêu dùng nào khác. Nếu bạn đang tìm hiểu về thông số kỹ thuật của iPhone mới nhất hoặc đọc đánh giá về một chiếc xe, chức năng này sẽ cung cấp dữ liệu mới nhất từ các nguồn đáng tin cậy.

- ChatGPT Search cung cấp thông tin chính xác dựa trên vị trí như dự báo thời tiết, sự kiện gần đây hoặc gợi ý nhà hàng một cách nhanh chóng và dễ dàng.

- ChatGPT Reasoning thể hiện sức mạnh với các nhiệm vụ phức tạp yêu cầu phân tích sâu hoặc tư duy sáng tạo. Khả năng lập luận này đặc biệt giá trị khi giải quyết vấn đề có nhiều lớp hoặc đánh giá nhiều lựa chọn khác nhau.

- Khi cần ý tưởng sáng tạo, chức năng lập luận của ChatGPT tận dụng logic, mẫu và dữ liệu liên quan để giúp phát triển ý tưởng mới hoặc tinh chỉnh những ý tưởng hiện có.

- Trong quá trình phân tích lập luận hoặc ra quyết định, ChatGPT Reasoning là nguồn tham khảo thứ hai thiết yếu, giúp xem xét tất cả các khía cạnh của tình huống, phân tích điểm mạnh và điểm yếu của mỗi lựa chọn.

- Khi cần giải thích các ý tưởng phức tạp như blockchain hoặc học máy, chức năng lập luận của ChatGPT cung cấp lời giải thích chi tiết, dễ hiểu bao gồm cả kiến thức cơ bản và khía cạnh phức tạp.

- Có những trường hợp cần kết hợp cả hai chức năng tìm kiếm và lập luận của ChatGPT để có bức tranh toàn diện hơn. Kết hợp này hiệu quả khi tìm hiểu chủ đề chi tiết, ra quyết định với nhiều biến số, so sánh nhiều lựa chọn hoặc khám phá khái niệm mới.

- Khi nghiên cứu khám phá vũ trụ, bạn có thể tìm kiếm các nhiệm vụ, công nghệ và khám phá mới nhất đồng thời lập luận về tác động tiềm tàng của chúng đối với xã hội, không chỉ thu thập dữ kiện mà còn đánh giá tác động của chúng.

- Khi cân nhắc chuyển đến thành phố mới, bạn sẽ muốn tìm hiểu về giá nhà, tiện ích địa phương và cơ hội việc làm, đồng thời xem xét các yếu tố trừu tượng như thẩm mỹ, lối sống của thành phố và khoảng cách với gia đình hoặc bạn bè.

- Khi so sánh sản phẩm, dịch vụ, hoặc thậm chí con đường sự nghiệp, cả hai chức năng tìm kiếm và lập luận đều cần thiết, giúp thu thập thông tin khách quan và đánh giá lựa chọn phù hợp nhất với mục tiêu cá nhân hoặc nghề nghiệp.

- Khi khám phá một khái niệm hoặc xu hướng mới như trí tuệ nhân tạo, kết hợp tìm kiếm và lập luận giúp thu thập thông tin mới nhất và phân tích tác động tiềm tàng cũng như ý nghĩa rộng lớn hơn của chúng.

📌 Hiểu rõ khi nào sử dụng ChatGPT Search cho dữ liệu thực tế và khi nào cần ChatGPT Reasoning cho phân tích sâu giúp tối ưu trải nghiệm AI. Kết hợp cả hai chức năng mang lại giá trị lớn nhất cho người dùng khi đối mặt với quyết định phức tạp.

https://www.makeuseof.com/chatgpt-search-vs-chatgpt-reasoning/

- Meta ra mắt Llama 4 Maverick và Scout để cạnh tranh với ChatGPT của OpenAI, với điểm chuẩn vượt trội, khả năng AI tạo hình ảnh và truy cập miễn phí qua WhatsApp và Instagram.

- Llama 4 Maverick hiện vượt trội hơn GPT-4o trong các lĩnh vực quan trọng như mã hóa, suy luận, khả năng đa ngôn ngữ, xử lý ngữ cảnh dài và các điểm chuẩn liên quan đến hình ảnh.

- Llama 4 Maverick đứng sau Gemini 2.5 Pro (thử nghiệm) trên bảng xếp hạng LMarena, vượt qua cả GPT-4o và GPT-4.5 Preview.

- Meta tuyên bố Llama 4 Maverick xuất sắc trong viết sáng tạo và tạo hình ảnh chính xác, nhưng cần kiểm chứng thực tế.

- ChatGPT vẫn dẫn đầu toàn cầu về tạo hình ảnh, với khả năng tạo và chỉnh sửa hình ảnh theo ngữ cảnh và chân thực, có sẵn trên toàn cầu.

- Llama 4 Maverick thiếu mô hình suy luận chuyên dụng, một tính năng dự kiến sẽ được công bố tại LlamaCon vào ngày 29/4.

- ChatGPT giới thiệu chế độ nghiên cứu sâu, cho phép tìm kiếm web để cung cấp câu trả lời cấp độ trợ lý nghiên cứu.

- Llama 4 Maverick miễn phí sử dụng không hạn chế, tích hợp vào WhatsApp, Instagram và Messenger.

- ChatGPT giới hạn sử dụng miễn phí, yêu cầu đăng ký và chỉ cho phép tạo ba hình ảnh mỗi ngày.

- Tính năng đa phương thức của Llama 4 Maverick hiện chỉ có sẵn ở Mỹ và bằng tiếng Anh.

- Meta dự kiến phát hành Llama 4 Behemoth để cạnh tranh với GPT-4.5 và Claude Sonnet 3.7 trong tương lai.

📌 Meta Llama 4 Maverick vượt trội về mã hóa và suy luận, miễn phí không giới hạn qua các ứng dụng phổ biến. ChatGPT dẫn đầu về tạo hình ảnh toàn cầu và nghiên cứu sâu. Cạnh tranh AI chatbot ngày càng gay gắt với các tính năng mới sắp ra mắt.

https://www.newsx.com/tech-and-auto/meta-llama-4-vs-chatgpt-which-ai-chatbot-is-better-in-2025/

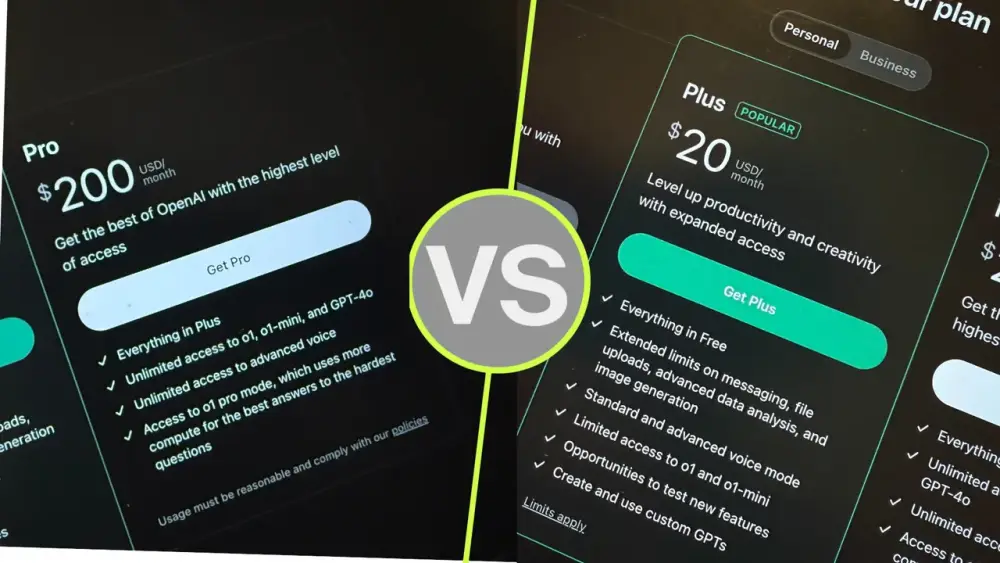

ChatGPT Plus có giá 20 USD/tháng, mang lại nhiều tính năng vượt trội so với bản miễn phí, phù hợp với người dùng muốn truy cập những công cụ AI mạnh mẽ nhất hiện tại.

Deep Research là tính năng nổi bật chỉ có trên ChatGPT Plus, ra mắt tháng 2/2025. Đây là công cụ nghiên cứu tự động nhiều bước, có thể thay bạn tổng hợp thông tin từ web và tạo báo cáo chi tiết chỉ trong 5 đến 30 phút, tuỳ độ phức tạp. Báo cáo có hình ảnh minh họa, trích dẫn rõ ràng, giải thích quá trình suy nghĩ của AI.

Advanced Voice Mode (Chế độ giọng nói nâng cao) cho phép ChatGPT nhận biết cảm xúc qua giọng nói, tương tác liên tục không bị ngắt, hỗ trợ chia sẻ màn hình và video. Người dùng bản miễn phí chỉ được dùng giới hạn theo tháng, trong khi bản Plus có mức sử dụng cao hơn đáng kể.

GPT-4o – mô hình tạo hình ảnh mới nhất của OpenAI – chỉ cho người dùng miễn phí tạo vài hình ảnh mỗi ngày. Người dùng Plus có thể tạo nhiều hình ảnh hơn, không bị giới hạn như bản miễn phí.

Tài khoản Plus được ưu tiên tiếp cận các công cụ và tính năng mới sớm hơn bản miễn phí. Ví dụ: Sora (AI tạo video từ văn bản), mô hình reasoning (o3-mini, o3-mini-high, o1) và các nâng cấp về giới hạn nhắn tin, tải tệp, phân tích dữ liệu.

OpenAI đã dừng công cụ tạo ảnh độc lập, nên người dùng chỉ còn cách sử dụng ChatGPT để tạo ảnh. Nếu bạn làm việc với hình ảnh AI, bản Plus là lựa chọn bắt buộc.

Người dùng Plus được dùng mô hình reasoning cải tiến – những mô hình này được huấn luyện để "nghĩ trước khi trả lời", nhờ đó cho ra các phản hồi chất lượng cao hơn.

OpenAI công bố từ tháng 4/2025: sinh viên tại Mỹ và Canada được dùng ChatGPT Plus miễn phí đến hết tháng 5. Sinh viên hệ chính quy hoặc bán thời gian tại các trường cấp bằng có thể đăng ký tại trang dành riêng cho sinh viên.

ChatGPT Pro có giá 200 USD/tháng, gấp 10 lần bản Plus. Tuy nhiên, với nhu cầu cơ bản đến nâng cao, bản Plus đã đáp ứng rất tốt.

Nếu bạn là người dùng cơ bản, bản miễn phí vẫn đáp ứng nhu cầu thường nhật như hỏi đáp nhanh, viết nội dung đơn giản, nhưng sẽ bị giới hạn về truy cập, tạo hình ảnh và voice mode.

📌 Với giá chỉ 20 USD/tháng, ChatGPT Plus đáng giá cho người dùng muốn khai thác các công cụ AI tạo sinh nâng cao như Deep Research, Advanced Voice Mode và GPT-4o. Tính năng tạo báo cáo tự động trong 5–30 phút và quyền truy cập sớm vào các công cụ mới khiến bản Plus trở thành lựa chọn hợp lý so với bản Pro (200 USD/tháng). Đặc biệt, sinh viên còn có thể sử dụng miễn phí đến hết tháng 5/2025.

https://www.zdnet.com/article/is-chatgpt-plus-worth-your-20-heres-how-it-compares-to-free-and-pro-plans/

Google vừa ra mắt Gemini 2.5 Pro vào ngày 26/3/2025, tuyên bố đây là mô hình tốt nhất về coding, suy luận và nhiều lĩnh vực khác.

Gemini 2.5 Pro có cửa sổ ngữ cảnh 1 triệu token, sắp nâng cấp lên 2 triệu token, trong khi Claude 3.7 Sonnet chỉ có 200.000 token.

Gemini 2.5 Pro hiện đứng đầu bảng xếp hạng LMArena, vượt trội trong coding, toán học, khoa học và hiểu hình ảnh.

Về độ chính xác trên bộ đánh giá SWE bench, Gemini 2.5 Pro đạt 63,8% so với 62,3% của Claude 3.7 Sonnet.

Bài viết thực hiện 4 bài kiểm tra lập trình để so sánh hai mô hình: mô phỏng máy bay, giải khối Rubik, mô phỏng bóng nảy trong tesseract 4D và một bài toán LeetCode khó.

Trong bài kiểm tra mô phỏng máy bay, Gemini 2.5 Pro tạo ra mã hoạt động hoàn hảo với điểm 10/10, trong khi Claude 3.7 Sonnet gặp vấn đề với hướng máy bay và điều khiển.

Với bài toán giải khối Rubik, Gemini 2.5 Pro tạo ra giải pháp hoạt động đầy đủ trong một lần thử, trong khi Claude 3.7 Sonnet thất bại với màu sắc và không thể giải khối.

Trong bài kiểm tra mô phỏng bóng nảy trong tesseract 4D, cả hai mô hình đều thành công, nhưng Claude 3.7 Sonnet thêm màu sắc không được yêu cầu.

Với bài toán LeetCode khó (tỷ lệ chấp nhận 14,9%), Gemini 2.5 Pro giải quyết chính xác với độ phức tạp thời gian phù hợp, trong khi Claude 3.7 Sonnet gặp lỗi TLE (Time Limit Exceeded).

Gemini 2.5 Pro có sẵn miễn phí, là một lợi thế lớn so với Claude 3.7 Sonnet.

Tác giả kết luận Gemini 2.5 Pro là người chiến thắng trong cuộc so sánh này, mặc dù mã của Claude 3.7 Sonnet đôi khi đơn giản và dễ hiểu hơn.

📌 Gemini 2.5 Pro vượt trội Claude 3.7 Sonnet trong 3/4 bài kiểm tra lập trình, với cửa sổ ngữ cảnh 1 triệu token (so với 200.000), độ chính xác 63,8% trên SWE bench (so với 62,3%) và hoàn toàn miễn phí, khẳng định vị thế dẫn đầu trong lĩnh vực AI lập trình.

https://composio.dev/blog/gemini-2-5-pro-vs-claude-3-7-sonnet-coding-comparison/

CEO Microsoft Satya Nadella đã nhanh chóng triển khai DeepSeek R1 trên Azure vào tháng 1, coi đây là "tiêu chuẩn mới" cho công việc AI của Microsoft.

DeepSeek gây ấn tượng khi tối ưu hóa dưới lớp CUDA của Nvidia với những thay đổi kiến trúc giúp mô hình AI hiệu quả hơn về mặt tính toán, được thực hiện bởi một đội chỉ 200 người.

Nadella đặc biệt ấn tượng với khả năng DeepSeek biến dự án nghiên cứu thành sản phẩm đứng đầu App Store, trong khi Copilot của Microsoft thường xuyên nằm ngoài top 100 ứng dụng mặc dù có quyền truy cập vào mô hình mới nhất của OpenAI.

Microsoft đã ra mắt mô hình Muse được huấn luyện trên game Xbox Bleeding Edge để tạo gameplay, nhằm giúp nhà phát triển tạo nguyên mẫu game hoặc bảo tồn và tối ưu hóa game cho phần cứng hiện đại.

Jay Parikh, người đứng đầu nhóm kỹ thuật CoreAI mới của Microsoft, nhấn mạnh cần phải đẩy nhanh tốc độ đổi mới nội bộ, vượt qua ranh giới tổ chức để bắt kịp với các đội nhỏ hơn đang đổi mới nhanh chóng.

Microsoft đang đầu tư 80 tỷ USD vào trung tâm dữ liệu để hỗ trợ khối lượng công việc AI trong năm tài chính này, với mục tiêu định vị cho tương lai nơi "mọi khối lượng công việc sẽ giống như ChatGPT".

Amy Hood, giám đốc tài chính của Microsoft, cho biết công ty có gần 300 tỷ USD doanh thu theo hợp đồng cần thực hiện trong 1-3 năm tới, nhưng các nhà phân tích cảnh báo về nguy cơ bong bóng trong việc xây dựng trung tâm dữ liệu.

Sự phát triển mạnh mẽ của AI tạo sinh đã làm mục tiêu carbon âm tính năm 2030 của Microsoft khó khăn hơn gấp 4-4,5 lần so với kế hoạch ban đầu.

Microsoft đã chuẩn bị 34 gigawatt năng lượng không carbon ở 24 quốc gia, cùng với cải tiến hiệu quả sử dụng năng lượng và nước, nhưng vẫn cần nhiều nỗ lực hơn trong việc sử dụng thép, bê tông, chip và nhiên liệu bền vững.

Brad Smith, phó chủ tịch Microsoft, tin rằng công ty sẽ "làm ngạc nhiên thế giới vào năm 2030" bằng cách đạt được mục tiêu carbon âm tính, thậm chí kỳ vọng chính AI sẽ giúp "giải mã" vấn đề này.

📌 Microsoft đối mặt với thách thức kép: bắt kịp DeepSeek trong cuộc đua AI với khoản đầu tư 80 tỷ USD vào trung tâm dữ liệu, đồng thời duy trì cam kết carbon âm tính đến năm 2030 dù mục tiêu này đã khó khăn hơn gấp 4,5 lần do sự phát triển của AI tạo sinh.

https://www.theverge.com/notepad-microsoft-newsletter/637496/microsoft-satya-nadella-deepseek-chatgpt-ai-investments-notepad

DeepSeek, một "tay chơi mới" trong ngành AI, đang tạo nên làn sóng mới khi mô hình DeepSeek-7B vượt qua GPT-3.5 ở nhiều tiêu chuẩn đánh giá, gây chấn động cộng đồng AI toàn cầu.

1. Phát triển chi phí thấp: DeepSeek chỉ mất khoảng 6 triệu USD để phát triển mô hình R1, trong khi OpenAI tốn hơn 100 triệu USD cho GPT-4. Điều này chứng minh AI chất lượng cao không cần đến ngân sách khổng lồ.

2. Tối ưu tài nguyên: DeepSeek sử dụng kỹ thuật “mixture of experts” để chỉ kích hoạt phần cần thiết trong mô hình, giúp tiết kiệm điện năng và tăng tốc xử lý. Ngược lại, OpenAI vận hành toàn bộ mô hình, tốn nhiều tài nguyên hơn.

3. Cam kết mã nguồn mở: DeepSeek công khai mô hình và nghiên cứu, khuyến khích cộng đồng toàn cầu tham gia cải tiến. OpenAI dần trở nên khép kín, hạn chế truy cập vào mô hình GPT-4.

4. Tác động thị trường nhanh chóng: Ứng dụng AI của DeepSeek nhanh chóng đứng đầu bảng xếp hạng tải xuống trên App Store, vượt mặt ChatGPT chỉ sau vài tuần, cho thấy sức hút mạnh mẽ từ người dùng.

5. Ảnh hưởng toàn cầu: Sự trỗi dậy của DeepSeek đã làm giảm niềm tin của nhà đầu tư vào các công ty AI lớn, khiến thị trường công nghệ mất đến 1.000 tỷ USD giá trị. Điều này phản ánh sự thay đổi quyền lực đang diễn ra.

6. Vượt qua rào cản công nghệ: Mặc dù bị hạn chế chip cao cấp do cấm vận, DeepSeek vẫn phát triển mô hình AI hiệu quả bằng phần cứng kém tiên tiến hơn. Đây là minh chứng cho khả năng sáng tạo kỹ thuật vượt trội.

7. Ưu tiên nghiên cứu thay vì thương mại hóa: DeepSeek tập trung đầu tư vào nghiên cứu AI gốc, không chạy theo lợi nhuận ngắn hạn. Điều này mở ra cơ hội đột phá thay vì cải tiến nhỏ lẻ.

8. Chiến lược tuyển dụng đa ngành: DeepSeek không chỉ tuyển kỹ sư AI mà còn có chuyên gia toán học, vật lý, thần kinh học. Cách tiếp cận đa ngành tạo nên sức sáng tạo khác biệt.

9. Thách thức chuẩn mực ngành AI: DeepSeek cho thấy AI tiên tiến không phải độc quyền của các ông lớn công nghệ Mỹ. Với kiến trúc thông minh và chi phí thấp, họ mở ra kỷ nguyên AI dân chủ hơn.

10. Khuyến khích hợp tác toàn cầu: Mô hình mở của DeepSeek cho phép các nhà nghiên cứu và lập trình viên toàn cầu cùng đóng góp, thúc đẩy đổi mới nhanh chóng. Trái ngược, OpenAI đang hạn chế sự tham gia bên ngoài.

📌 DeepSeek đang vượt mặt OpenAI bằng cách tiếp cận hiệu quả: chỉ tốn 6 triệu USD để phát triển mô hình mạnh mẽ hơn GPT-3.5, mở mã nguồn để thúc đẩy cộng đồng toàn cầu, tận dụng kỹ thuật tối ưu tài nguyên và tạo ảnh hưởng thị trường thần tốc. Khác với mô hình độc quyền của OpenAI, DeepSeek đặt trọng tâm vào nghiên cứu, hợp tác và sáng tạo đa ngành, mở ra hướng đi mới đầy tiềm năng cho tương lai AI.

https://corexbox.com/13-ways-best-deepseek-is-beating-openai-at-its-own-game/

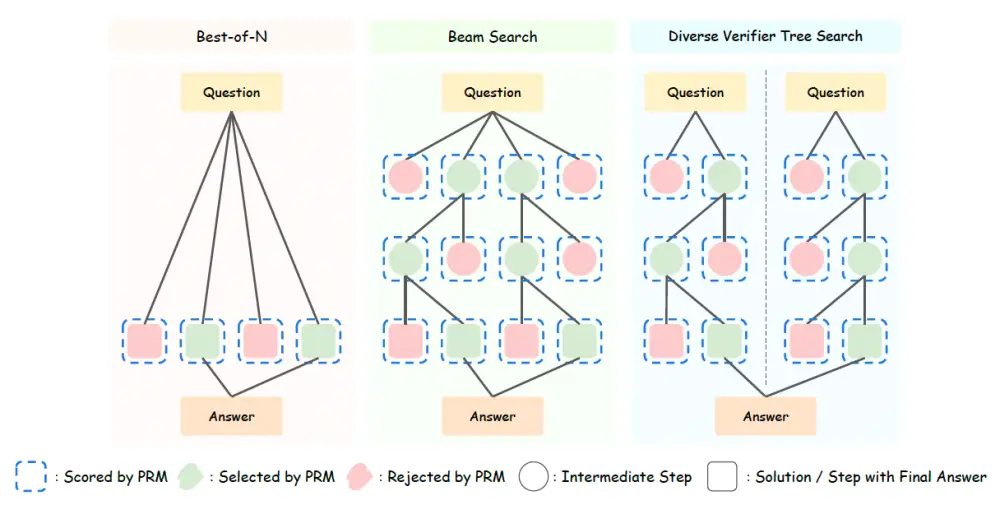

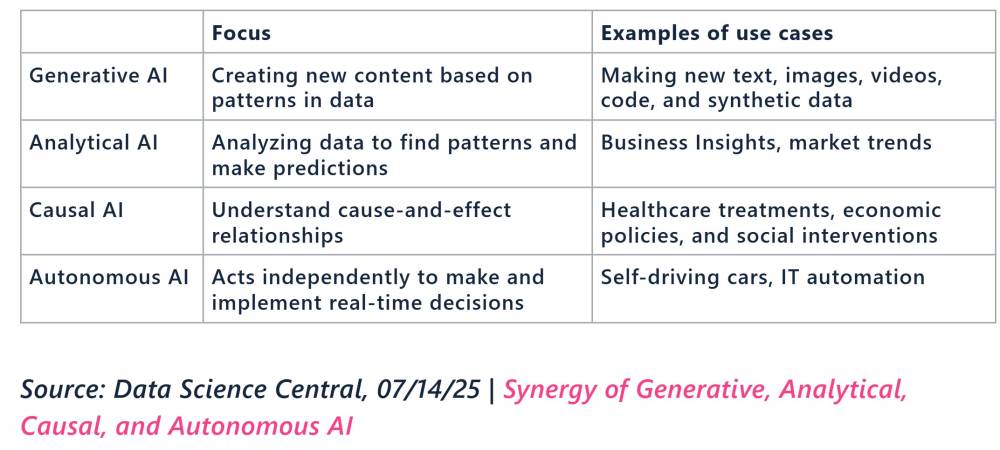

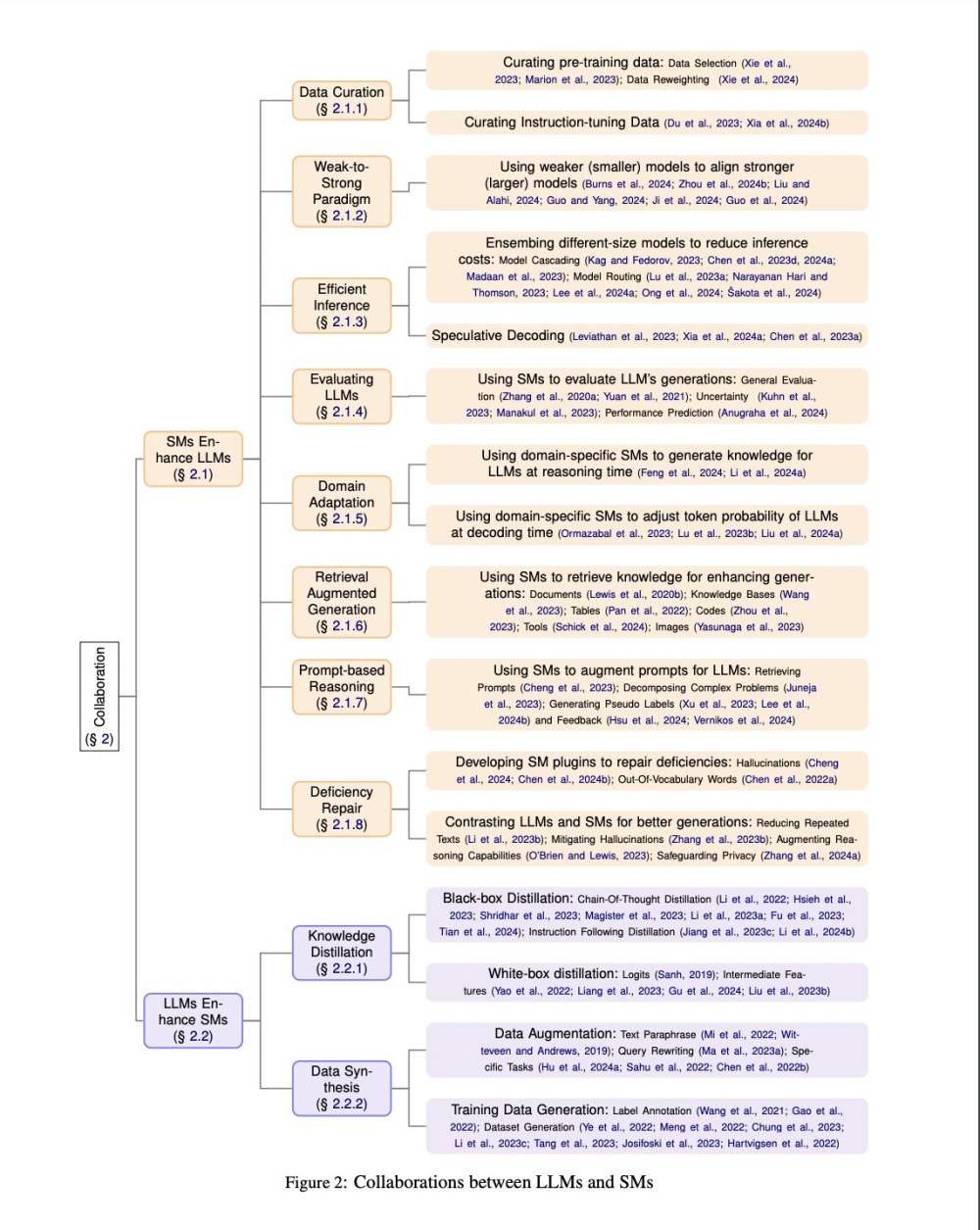

Bối cảnh phân tích đã phát triển đáng kể trong thập kỷ qua, từ mô hình thống kê cơ bản đến học máy và học sâu, với sự xuất hiện của AI tạo sinh mở ra nhiều khả năng mới.

AI tạo sinh có thể tạo văn bản giống người, hình ảnh và mã nguồn, nhưng vai trò tối ưu của nó bên cạnh các công cụ AI dự đoán vẫn đang phát triển.

Học máy xác định mẫu từ dữ liệu lịch sử để đưa ra dự đoán mà không cần lập trình rõ ràng, phù hợp với dữ liệu có cấu trúc (dạng bảng).

Học máy được sử dụng rộng rãi trong kinh doanh: bán lẻ dự báo nhu cầu sản phẩm, doanh nghiệp dịch vụ thuê bao dự đoán khách hàng rời bỏ, tổ chức tài chính đánh giá rủi ro vỡ nợ.

Học máy không hiệu quả với dữ liệu phi cấu trúc (hình ảnh, văn bản, âm thanh) vì cần cấu trúc hóa thủ công - một công việc tốn kém.

Học sâu, dựa trên mạng nơ-ron, có thể xử lý dữ liệu phi cấu trúc mà không cần xử lý thủ công, nhưng "đói dữ liệu" hơn và khó hiểu hơn do phức tạp.

AI tạo sinh khác với AI dự đoán ở khả năng tạo nội dung mới thay vì chỉ dự đoán, được xây dựng trên kiến trúc transformer.

Để quyết định công cụ AI nào phù hợp, cần xác định bản chất vấn đề: là vấn đề dự đoán hay vấn đề tạo sinh?

Vấn đề tạo sinh dễ nhận biết khi đầu ra mong muốn là phi cấu trúc (văn bản, hình ảnh, video, âm nhạc).

Vấn đề dự đoán có hai loại: phân loại (chọn từ các đầu ra xác định trước) và hồi quy (dự đoán một số).

Với vấn đề tạo sinh, AI tạo sinh là lựa chọn duy nhất, sử dụng LLM đa phương thức, mô hình text-to-image, hoặc mô hình chuyên biệt.

Với vấn đề dự đoán có dữ liệu đầu vào dạng bảng, nên ưu tiên học máy truyền thống vì dễ xây dựng, điều chỉnh và giải thích hơn học sâu.

Với vấn đề dự đoán có dữ liệu đầu vào phi cấu trúc và nhãn đầu ra là văn bản thông thường, nên thử LLM trước.

Nếu không thể sử dụng LLM (do độ chính xác, chi phí, độ trễ hoặc bảo mật dữ liệu), nên dùng học sâu với mô hình được huấn luyện trước.

Có thể giảm gánh nặng dữ liệu khi sử dụng học sâu bằng cách tìm mô hình đã được huấn luyện trước trên dữ liệu tương tự và tinh chỉnh với dữ liệu cụ thể.

LLM có thể hỗ trợ tạo và gắn nhãn dữ liệu để tinh chỉnh mô hình đã huấn luyện trước, giảm chi phí và thời gian gắn nhãn thủ công.

Với dữ liệu đầu vào kết hợp dạng bảng và phi cấu trúc, nên bắt đầu trực tiếp với học sâu.

Lựa chọn giữa học máy, học sâu và AI tạo sinh không nên là đề xuất hoặc-hoặc mà là tập hợp khả năng có thể kết hợp và điều chỉnh dựa trên đặc điểm cụ thể của vấn đề.

📌 Khi lựa chọn công cụ AI, cần xác định bản chất vấn đề (tạo sinh hay dự đoán) và loại dữ liệu đầu vào. Dùng AI tạo sinh cho vấn đề tạo sinh, học máy cho dữ liệu dạng bảng, và LLM cho dữ liệu phi cấu trúc với nhãn thông thường. Học sâu phù hợp khi LLM không khả thi hoặc dữ liệu đầu vào hỗn hợp.

https://sloanreview.mit.edu/article/when-to-use-genai-versus-predictive-ai/

#MIT

AI tạo sinh không phù hợp với mọi vấn đề. Sử dụng những hướng dẫn này để quyết định giữa AI dự đoán — công cụ học máy và học sâu — và AI tạo sinh.

Rama Ramakrishnan, 24 tháng 3 năm 2025 Thời gian đọc: 12 phút

Tóm tắt: Các nhà lãnh đạo thường bối rối về việc khi nào nên sử dụng AI tạo sinh so với AI dự đoán (công cụ học máy và học sâu). Vấn đề không phải là... Đọc thêm +

Lĩnh vực phân tích đã phát triển đáng kể trong thập kỷ qua. Nhiều tổ chức đã tiến triển từ mô hình thống kê cơ bản đến học máy, và một số đã bổ sung học sâu vào bộ công cụ của họ. Trong bối cảnh này, sự xuất hiện của AI tạo sinh — với khả năng tạo ra văn bản giống con người, tạo hình ảnh, và viết mã — giới thiệu những khả năng mới và những câu hỏi mới.

Mặc dù AI tạo sinh hứa hẹn sẽ cách mạng hóa mọi thứ từ dịch vụ khách hàng đến phát triển sản phẩm, vai trò tối ưu của nó bên cạnh các công cụ AI dự đoán (tức là, các công cụ học máy và học sâu) vẫn đang được hoàn thiện. Điều đó thường khiến các nhà lãnh đạo tự hỏi đâu là cách tiếp cận đúng để giải quyết một vấn đề cụ thể. Bài viết này trình bày một bộ hướng dẫn để giúp các nhà lãnh đạo và tổ chức điều hướng quyết định khó khăn nhưng quan trọng này.

Hãy bắt đầu với một tổng quan nhanh về học máy, học sâu, và AI tạo sinh, tập trung vào những điểm mạnh và hạn chế tương ứng của chúng.

Học máy: Loại AI này liên quan đến việc xác định các mẫu từ dữ liệu lịch sử bằng cách sử dụng các kỹ thuật thống kê và tính toán để đưa ra dự đoán hoặc quyết định mà không được lập trình rõ ràng để làm như vậy. Bao gồm một loạt các kỹ thuật, bao gồm phân tích hồi quy, cây quyết định, rừng ngẫu nhiên, và tăng cường độ dốc, sức mạnh chính của nó nằm ở việc xử lý dữ liệu bảng/có cấu trúc — dữ liệu có thể được sắp xếp trong các hàng và cột của bảng tính hoặc bảng cơ sở dữ liệu. Trong dữ liệu bảng, các cột — được biết đến như các biến độc lập hoặc đặc trưng — hoặc là tự nhiên số (như mức cholesterol LDL của bệnh nhân, hoặc số dư tín dụng trung bình cho người xin vay) hoặc có thể được biểu diễn bằng số. (Ví dụ, nếu bệnh nhân có tiền sử gia đình bị bệnh tim, nó được biểu diễn bằng giá trị 1; nếu không, giá trị là 0).

Văn bản được phân tích bởi và tạo ra từ các công cụ AI tạo sinh bao gồm một phạm vi đáng kinh ngạc các loại.

Vì các vấn đề với dữ liệu đầu vào dạng bảng phổ biến trong kinh doanh, học máy đã có tác động tích cực to lớn. Các nhà bán lẻ sử dụng học máy để dự báo nhu cầu sản phẩm và nhu cầu hàng tồn kho bằng cách phân tích dữ liệu bán hàng lịch sử và mẫu theo mùa. Các doanh nghiệp dựa trên đăng ký sử dụng học máy để dự đoán và ngăn chặn khách hàng rời bỏ. Các tổ chức tài chính sử dụng học máy để dự đoán rủi ro vỡ nợ khoản vay.

Nhưng học máy không hoạt động tốt nếu dữ liệu đầu vào không có cấu trúc (như hình ảnh, văn bản ngôn ngữ tự nhiên, hoặc âm thanh). Để sử dụng học máy truyền thống hiệu quả với dữ liệu không cấu trúc, dữ liệu phải được cấu trúc thủ công — một nhiệm vụ tốn kém khiến học máy không hấp dẫn cho các trường hợp sử dụng kinh doanh nơi dữ liệu đầu vào không phải dạng bảng.

Học sâu: Một loại học máy cụ thể dựa trên mạng nơ-ron, học sâu là một bước tiến đáng kể trong khả năng phân tích. Các mô hình học sâu có thể xử lý dữ liệu không cấu trúc như hình ảnh, âm thanh, và ngôn ngữ tự nhiên mà không cần xử lý thủ công trước, do đó làm cho nhiều trường hợp sử dụng khả thi. Học sâu cũng có thể chứa đầu vào dạng bảng. Khả năng xử lý cả dữ liệu có cấu trúc và không cấu trúc làm cho nó đặc biệt có giá trị cho các nhiệm vụ nơi dữ liệu đầu vào tự nhiên xuất hiện ở các phương thức khác nhau. Một mô hình phát hiện bệnh, ví dụ, nên có khả năng xử lý dữ liệu hình ảnh (như quét X-quang) cùng với dữ liệu bảng, chẳng hạn như kết quả xét nghiệm của bệnh nhân. Nhưng học sâu có xu hướng "đói dữ liệu" hơn học máy, và nó có thể khó hiểu và diễn giải hơn do độ phức tạp và kích thước của mạng nơ-ron cơ bản.

AI tạo sinh: GenAI được phân biệt với AI dự đoán bởi khả năng tạo ra nội dung mới thay vì chỉ đưa ra dự đoán. Được xây dựng trên một kiến trúc học sâu đột phá được gọi là transformer, các hệ thống này có thể tạo ra văn bản mạch lạc, hình ảnh thực tế, và thậm chí mã chức năng và, do đó, hứa hẹn khả năng áp dụng rộng rãi cho một phần lớn công việc tri thức. Ví dụ, một bộ phận marketing có thể sử dụng GenAI để soạn thảo bản sao quảng cáo, tạo ra các biến thể nội dung hình ảnh, hoặc tạo ra các giao tiếp khách hàng được cá nhân hóa ở quy mô lớn.

Đầu vào và đầu ra của các hệ thống AI tạo sinh như LLM thường không có cấu trúc. Phổ biến nhất, chúng bao gồm dữ liệu văn bản và/hoặc hình ảnh và, gần đây hơn, video. Lưu ý rằng văn bản được phân tích bởi và tạo ra từ các công cụ AI tạo sinh bao gồm một phạm vi đáng kinh ngạc các loại, chẳng hạn như mã phần mềm, chuỗi protein, ký hiệu âm nhạc, biểu thức toán học, và công thức hóa học.

Làm thế nào một nhà lãnh đạo có thể quyết định công cụ AI nào sử dụng cho một vấn đề cụ thể? Hãy giả sử rằng vấn đề đã được xác định rõ ràng, các đầu vào liên quan đã được xác định, và đầu ra mong muốn đã được chỉ định.

Một điểm khởi đầu hợp lý là bản chất của vấn đề: Đó là vấn đề dự đoán hay vấn đề tạo sinh?

Các vấn đề tạo sinh dễ nhận biết. Nếu đầu ra mong muốn không có cấu trúc — như văn bản, hình ảnh, video, hoặc âm nhạc — đó là vấn đề tạo sinh.

Các vấn đề dự đoán có hai biến thể: phân loại và hồi quy. Trong các vấn đề phân loại, cho một đầu vào, người dùng cần lựa chọn từ một tập hợp các đầu ra đã xác định trước. Ví dụ, cho dữ liệu về một bệnh nhân, bác sĩ có thể muốn dự đoán liệu bệnh nhân có nguy cơ cao, trung bình, hay thấp mắc bệnh tim mạch. Điểm quan trọng ở đây là các danh mục đầu ra — nguy cơ cao, nguy cơ trung bình, và nguy cơ thấp — được xác định trước, không được tạo ra ngay lúc đó.

Trong các vấn đề hồi quy, bạn muốn dự đoán một con số (hoặc một vài con số). Với dữ liệu về một bệnh nhân và chi tiết điều trị, bác sĩ có thể muốn dự đoán mức cholesterol LDL của họ sẽ là bao nhiêu sau sáu tháng nữa. Hoặc, với dữ liệu bán hàng trong quá khứ của một sản phẩm, một tổ chức có thể muốn dự đoán đơn vị bán hàng của nó trong 24 giờ tới. Lưu ý rằng sự phân biệt giữa phân loại và hồi quy có thể hơi mờ nhạt. Ví dụ, các vấn đề hồi quy thường có thể được đặt thành các vấn đề phân loại. Thay vì cố gắng dự đoán mức cholesterol LDL chính xác của một bệnh nhân, bác sĩ có thể hài lòng với việc dự đoán liệu nó sẽ cao, trung bình, hay thấp.

Với bản chất của vấn đề đã được xác định, chúng ta có thể chuyển sang công cụ nào để sử dụng.

Hãy bắt đầu với trường hợp dễ dàng. Nếu bạn có một vấn đề tạo sinh cần giải quyết, chỉ có một lựa chọn: AI tạo sinh. Tùy thuộc vào loại đầu ra bạn muốn tạo ra, bạn có thể cần sử dụng LLM đa phương thức, như GPT-4 của OpenAI, Claude 3.7 Sonnet của Anthropic, hoặc Gemini 1.5 của Google; các mô hình chuyển đổi văn bản thành hình ảnh, như Dall-E; hoặc các mô hình chuyên dụng đã được xây dựng cho âm thanh và các lĩnh vực khác.

Tuy nhiên, nếu bạn có một vấn đề dự đoán, vấn đề trở nên phức tạp hơn.

Kịch bản đơn giản nhất là khi tất cả dữ liệu đầu vào đều ở dạng bảng. Trong tình huống này, bạn nên ưu tiên học máy truyền thống. Mặc dù học sâu cũng có thể giải quyết những vấn đề này, nhưng nó mang theo một loạt gánh nặng khác có thể không đáng công sức: Nó có thể đòi hỏi nhiều nỗ lực hơn để "điều chỉnh" mô hình cho vấn đề, mô hình có thể không dễ diễn giải cho quản lý do tính chất hộp đen của nó, v.v. Ngược lại, các mô hình học máy nhanh hơn nhiều để xây dựng và điều chỉnh và yêu cầu ít "chăm sóc" hơn, và các phương pháp có thể diễn giải được có sẵn. Ngoài ra, có nhiều phần mềm mã nguồn mở dễ sử dụng và một lượng lớn người biết cách sử dụng các công cụ này.

Bằng cách chọn học máy thay vì học sâu, bạn không nhất thiết phải chấp nhận độ chính xác thấp hơn để đổi lấy sự dễ dàng trong phát triển. Một số phương pháp học máy được sử dụng rộng rãi (như XGBoost, viết tắt của Extreme Gradient Boosting) không chỉ dễ làm việc hơn học sâu mà còn có thể chính xác hơn cho các vấn đề dự đoán dữ liệu bảng.

Còn nếu bạn có một vấn đề dự đoán nơi các đầu vào không có cấu trúc, như văn bản hoặc hình ảnh thì sao?

Đây có lẽ là kịch bản mà câu trả lời "đúng" đã thay đổi nhiều nhất trong những năm gần đây. Trước khi xuất hiện AI tạo sinh, cách tiếp cận tiêu chuẩn sẽ là thu thập dữ liệu và huấn luyện một mô hình học sâu. Nhưng các LLM ngày nay thường có khả năng giải quyết các loại vấn đề này ngay từ đầu, mà không cần bất kỳ đào tạo chuyên biệt nào.

Hãy bắt đầu với điểm mạnh của LLM: khi dữ liệu đầu vào và nhãn đầu ra là văn bản ngôn ngữ tự nhiên "hàng ngày", trái với văn bản kỹ thuật hoặc đầy thuật ngữ từ một lĩnh vực chuyên biệt.

Ví dụ, giả sử bạn muốn xây dựng một hệ thống AI có thể phát hiện liệu một đánh giá sản phẩm trên trang thương mại điện tử có chỉ ra ý tưởng cải tiến sản phẩm tiềm năng hay không. Một hệ thống phân loại đánh giá như vậy sẽ cho phép bạn xử lý hàng nghìn đánh giá một cách hiệu quả và chuyển những đánh giá quan trọng đến các đội thiết kế sản phẩm để điều tra thêm. Văn bản trong đánh giá sản phẩm được coi là văn bản hàng ngày, vì đánh giá được viết bởi người tiêu dùng. Các nhãn cũng có thể được thiết kế là văn bản hàng ngày (chẳng hạn như "đề cập đến ý tưởng cải tiến sản phẩm" hoặc "không đề cập đến ý tưởng cải tiến sản phẩm").

Một vài năm trước, chúng ta sẽ giải quyết vấn đề này bằng cách thu thập hàng nghìn đánh giá, gắn nhãn mỗi đánh giá như mô tả ở trên (một nhiệm vụ thủ công tốn kém), và huấn luyện một mô hình AI dự đoán với dữ liệu này. Nhưng vì LLM đã được đào tạo trên một lượng lớn văn bản, chúng có thể xử lý văn bản hàng ngày (như đánh giá sản phẩm và các nhãn được gán cho chúng) mà không cần bất kỳ đào tạo đặc biệt nào.

Xem xét đánh giá sản phẩm này của một chiếc ghế văn phòng trên Wayfair.com: "Đường cong của lưng ghế không để lại đủ không gian để ngồi thoải mái." Nó dường như chỉ ra một ý tưởng cải tiến sản phẩm tiềm năng. Chúng ta có thể đơn giản prompt một LLM để phân loại văn bản như sau:

Prompt: Đánh giá sản phẩm sau đây có chỉ ra ý tưởng cải tiến sản phẩm tiềm năng không? Trả lời có hoặc không. Đánh giá: Đường cong của lưng ghế không để lại đủ không gian để ngồi thoải mái.

Phản hồi LLM: Có

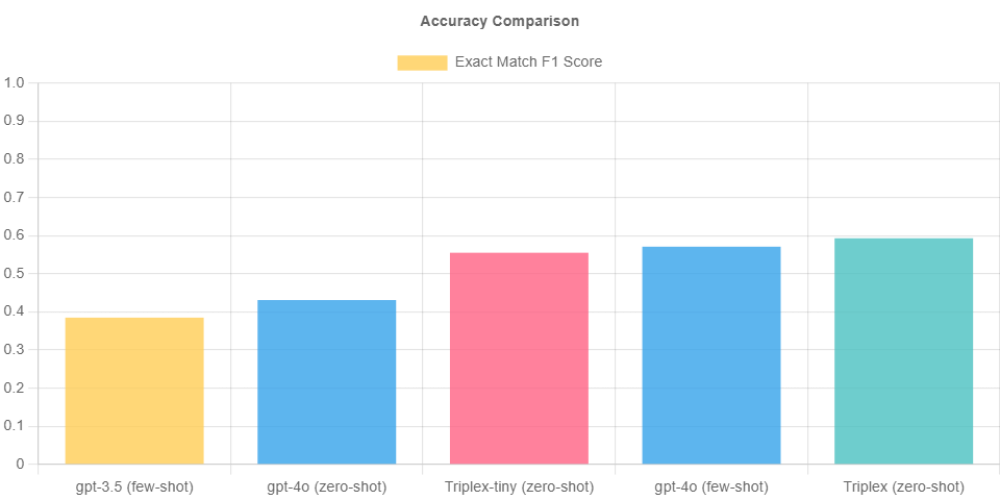

Nếu độ chính xác ngoài hộp của LLM không đủ cao, đôi khi nó có thể được cải thiện bằng kỹ thuật prompt và/hoặc bằng cách cung cấp một vài ví dụ (được gọi là few-shot prompting).

Việc viết mã để tự động hóa quá trình này là đơn giản. Khối lượng lớn các đánh giá có thể dễ dàng được phân loại bằng cách thực hiện mã trên một chu kỳ thường xuyên. Các LLM mã nguồn đóng như ChatGPT, Claude, hoặc Gemini chắc chắn có thể được sử dụng cho mục đích này. Chi phí API để sử dụng các hệ thống này đã giảm mạnh trong những năm gần đây, nhưng chi phí có thể được giảm thêm bằng cách sử dụng các LLM mã nguồn mở có khả năng (như các họ mô hình Llama hoặc Mistral).

Nếu vấn đề là vấn đề phân loại dự đoán, dữ liệu đầu vào là văn bản hoặc hình ảnh, và nhãn đầu ra là văn bản hàng ngày, hãy thử giải quyết nó với một LLM trước.

Mặc dù chúng ta đã xem xét một kịch bản phân loại văn bản chi tiết, cách tiếp cận được mô tả ở trên cũng áp dụng tương tự nếu dữ liệu đầu vào là hình ảnh. Nhiều LLM hiện nay là đa phương thức và có thể phân loại hình ảnh, phát hiện đối tượng trong hình ảnh, hoặc trích xuất dữ liệu có cấu trúc từ tài liệu với độ chính xác chấp nhận được. Chúng đặc biệt hiệu quả nếu hình ảnh đầu vào là hình ảnh hàng ngày thay vì hình ảnh từ một lĩnh vực kỹ thuật chuyên biệt cao (như hình ảnh y tế) và nhãn đầu ra là văn bản hàng ngày.

Tóm lại, nếu vấn đề là vấn đề phân loại dự đoán, dữ liệu đầu vào là văn bản hoặc hình ảnh, và nhãn đầu ra là văn bản hàng ngày (thay vì thuật ngữ chuyên dụng đặc biệt), hãy thử giải quyết nó với một LLM trước.

Tuy nhiên, đôi khi việc sử dụng LLM là không khả thi. Điều này có thể xảy ra vì nhiều lý do, bao gồm các vấn đề liên quan đến độ chính xác, chi phí, độ trễ, hoặc quyền riêng tư dữ liệu. Trong tình huống này, việc sử dụng cách tiếp cận AI dự đoán là hợp lý, và vì dữ liệu đầu vào không có cấu trúc, học sâu thường là một lựa chọn tốt.

Như đã lưu ý trước đó, học sâu có xu hướng có nhu cầu dữ liệu mạnh mẽ so với các mô hình học máy truyền thống. Nhưng gánh nặng này có thể được giảm đáng kể bằng cách sử dụng các mô hình học sâu đã được đào tạo trước. Các trung tâm mô hình chứa hàng trăm nghìn mô hình học sâu đã được đào tạo trước. Bạn có thể tìm kiếm một trung tâm cho các mô hình đã được đào tạo trước trên cùng loại dữ liệu đầu vào không cấu trúc mà vấn đề của bạn liên quan đến. Ví dụ, nếu bạn đang làm việc với văn bản y tế, bạn có thể tìm kiếm các mô hình đã được đào tạo trước trên văn bản như vậy. Nếu bạn đang làm việc với hình ảnh của các sản phẩm công nghiệp, bạn có thể tìm kiếm các mô hình đã được đào tạo trước trên các hình ảnh đó.

Các mô hình đã được đào tạo trước như vậy có thể được tải xuống và tinh chỉnh nhanh chóng với một lượng vừa phải dữ liệu cụ thể cho vấn đề. Thay vì thu thập và gắn nhãn hàng chục nghìn đầu vào, bạn có thể chỉ cần hàng trăm đầu vào.

LLM cũng có thể hữu ích ở đây. Bạn có thể sử dụng chúng để tạo ra và gắn nhãn dữ liệu cần thiết để tinh chỉnh một mô hình đã được đào tạo trước. Ví dụ, thay vì gắn nhãn thủ công hàng nghìn đánh giá sản phẩm thương mại điện tử với "đề cập đến ý tưởng cải tiến sản phẩm" hoặc "không đề cập đến ý tưởng cải tiến sản phẩm," bạn có thể sử dụng LLM để gắn nhãn một cách rẻ và nhanh chóng (một kỹ thuật được gọi là LLM-as-a-judge). Nếu ngay cả đánh giá sản phẩm chưa được gắn nhãn cũng không có sẵn với số lượng đủ (có lẽ vì trang thương mại điện tử mới ra mắt gần đây), một LLM có thể được prompt để tạo ra các đánh giá tổng hợp, sử dụng các đánh giá có sẵn làm "hạt giống."

Cuối cùng, nếu dữ liệu đầu vào là sự kết hợp giữa dữ liệu bảng và dữ liệu không cấu trúc, tôi khuyên bạn nên bắt đầu với học sâu trực tiếp.

Các khuyến nghị của tôi có thể được tóm tắt như sau:

Như tôi đã thảo luận, sự lựa chọn giữa học máy truyền thống, học sâu, và AI tạo sinh không nên được xem như một đề xuất hoặc-hoặc mà là một tập hợp các khả năng có thể được kết hợp và điều chỉnh dựa trên các chi tiết cụ thể của vấn đề.

Nhìn về phía trước, ranh giới giữa các công nghệ này có thể tiếp tục mờ đi khi các khả năng mới xuất hiện. Sự phát triển gần đây của các mô hình được đào tạo trước cho dữ liệu bảng, ví dụ, có thể chỉ ra một giải pháp thay thế hiệu quả về dữ liệu cho việc xây dựng các mô hình AI dự đoán từ đầu cho các vấn đề dữ liệu bảng.

Các nhà lãnh đạo doanh nghiệp phải luôn cập nhật về những tiến bộ công nghệ trong khi duy trì tập trung vào các mục tiêu kinh doanh cốt lõi của họ. Bằng cách tuân theo một khuôn khổ quyết định có cấu trúc và duy trì tập trung vào việc tạo ra giá trị kinh doanh, các tổ chức có thể điều hướng thành công trong bối cảnh AI phức tạp và đưa ra quyết định dự án AI với khả năng cao hơn để mang lại giá trị kinh doanh.

Rawbot là nền tảng so sánh mô hình AI giúp đánh giá hiệu suất các mô hình AI song song.

Công cụ này hỗ trợ nhiều mô hình AI phổ biến như GPT-4o Mini của OpenAI, Command R của Cohere và Jamba 1.5 Mini.

Giao diện của Rawbot được thiết kế đơn giản, dễ sử dụng cho các nhà nghiên cứu, nhà phát triển và doanh nghiệp.

Rawbot đơn giản hóa quá trình lựa chọn mô hình AI bằng cách so sánh các tính năng, điểm mạnh và điểm yếu chính.

Cơ sở dữ liệu của Rawbot liên tục được cập nhật với các mô hình và cải tiến mới.

Công cụ này giúp tiết kiệm thời gian và nguồn lực bằng cách giảm thiểu quá trình thử nghiệm.

Rawbot có giới hạn về độ dài đầu vào (140 ký tự) và đầu ra (100 token).

Hiện tại Rawbot miễn phí sử dụng, nhưng có thể có các tính năng trả phí trong tương lai.

Rawbot là nền tảng web, có thể truy cập từ mọi trình duyệt mà không cần cài đặt phần mềm.

Công cụ này được đánh giá tốt về giao diện trực quan và khả năng so sánh có cấu trúc.

Rawbot phù hợp cho những người cần so sánh mô hình AI đơn giản và hiệu quả.

Tuy nhiên, Rawbot không phù hợp cho những ai cần phân tích chi tiết và chuyên sâu về hiệu suất AI.

📌 Rawbot là nền tảng miễn phí giúp so sánh mô hình AI dễ dàng. Công cụ này có giao diện trực quan, hỗ trợ nhiều mô hình phổ biến và liên tục cập nhật. Tuy có giới hạn về độ dài đầu vào/ra, Rawbot vẫn hữu ích cho việc đánh giá nhanh các mô hình AI.

https://www.techradar.com/pro/what-is-rawbot-everything-we-know-about-the-ai-comparison-tool

https://decrypt.co/310266/chatgpt-gemini-or-grok-3-which-ai-has-the-best-research-agent

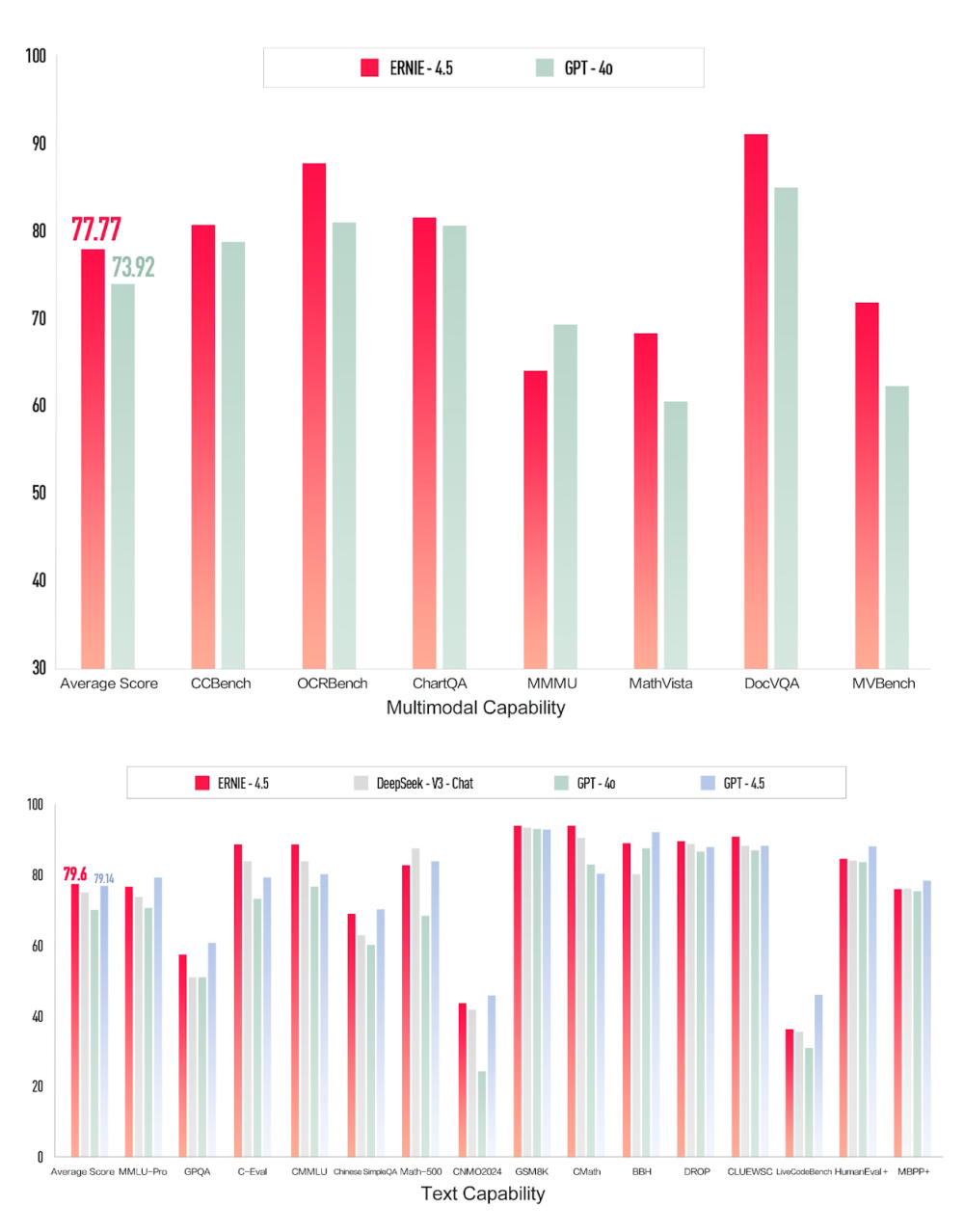

Gã khổng lồ công nghệ Trung Quốc Baidu vừa ra mắt hai mô hình AI mới vào ngày Chủ nhật: ERNIE 4.5, một mô hình đa phương thức tự nhiên và ERNIE X1, một mô hình suy luận tư duy sâu.

Baidu đã sớm mở miễn phí chatbot AI ERNIE Bot cho người dùng cá nhân, sớm hơn kế hoạch dự kiến.

Theo Baidu, ERNIE X1 cung cấp hiệu suất ngang bằng với DeepSeek R1 nhưng chỉ với giá bằng một nửa, trong khi ERNIE 4.5 là mô hình nền tảng mới nhất và mô hình đa phương thức tự nhiên thế hệ mới của công ty.

ERNIE 4.5 cải thiện khả năng hiểu, tạo sinh, suy luận và ghi nhớ, đồng thời giảm ảo giác và nâng cao khả năng lập luận logic và lập trình.

Mô hình ERNIE 4.5 hiện đã có sẵn thông qua API trên nền tảng MaaS của Baidu AI Cloud - Qianfan, trong khi ERNIE X1 sẽ sớm được triển khai trên nền tảng này.

Đối với người dùng doanh nghiệp, giá đầu vào và đầu ra của ERNIE 4.5 bắt đầu từ 0,55 USD cho mỗi 1 triệu token và 2,20 USD cho mỗi 1 triệu token tương ứng.

ERNIE X1 có mức giá khởi điểm 0,28 USD cho mỗi 1 triệu token đầu vào và 1,10 USD cho mỗi 1 triệu token đầu ra.

Baidu dự định tích hợp ERNIE 4.5 và ERNIE X1 vào toàn bộ hệ sinh thái của mình, bao gồm Baidu Search và ứng dụng Wenxiaoyan.

Baidu là một trong những công ty đầu tiên tại Trung Quốc ra mắt chatbot kiểu ChatGPT vào đầu năm 2023, với Ernie 4.0 tuyên bố có thể cạnh tranh với GPT-4 của OpenAI.

Tuy nhiên, tỷ lệ áp dụng đã bị chậm lại do sự cạnh tranh mạnh mẽ, đặc biệt là từ mô hình R1 của DeepSeek được phát hành vào tháng trước.

DeepSeek cũng đang lên kế hoạch phát hành mô hình suy luận tiếp theo DeepSeek R2 "càng sớm càng tốt", sớm hơn so với kế hoạch ban đầu dự kiến vào đầu tháng 5.

DeepSeek R2 được cho là sẽ tạo ra "mã lập trình tốt hơn" và có khả năng suy luận bằng nhiều ngôn ngữ khác ngoài tiếng Anh.

📌 Baidu vừa tung ra hai mô hình AI mới: ERNIE 4.5 và ERNIE X1, với ERNIE X1 cạnh tranh trực tiếp với DeepSeek R1 nhưng giá chỉ bằng một nửa (0,28 USD cho mỗi triệu token đầu vào). Hai mô hình này sẽ được tích hợp vào toàn bộ hệ sinh thái Baidu, đánh dấu bước tiến trong cuộc đua AI ở Trung Quốc.

https://analyticsindiamag.com/ai-news-updates/chinas-baidu-launches-two-new-ai-models-rivals-deepseek-r1-at-half-the-price/

ChatGPT-4.5 của OpenAI được giới thiệu như một bản nâng cấp nhỏ của GPT-4, với những cải tiến khiêm tốn trong một số lĩnh vực cụ thể nhưng cũng bộc lộ nhiều hạn chế quan trọng.

Trong lĩnh vực lập trình và toán học, mô hình này thể hiện khả năng xử lý vấn đề có cấu trúc tốt hơn, với điểm chuẩn "Simple Bench" cải thiện lên 35-40%, phản ánh năng lực nâng cao trong lập trình và suy luận toán học.

Về lý luận khoa học, GPT-4.5 thể hiện khả năng phân tích dữ liệu và giải quyết các vấn đề khoa học đơn giản tốt hơn, nhưng vẫn gặp khó khăn với các thách thức đa bước và nhiệm vụ suy luận nâng cao.

Mặc dù OpenAI tuyên bố cải thiện trí thông minh cảm xúc cho GPT-4.5, mô hình này vẫn thiếu sự tinh tế và nhận thức ngữ cảnh cần thiết cho các tương tác phức tạp, đặc biệt khi so sánh với Claude 3.7.

Khả năng sáng tạo và kể chuyện của GPT-4.5 thường không đạt kỳ vọng, với các câu chuyện thiên về "kể" hơn là "thể hiện", dẫn đến nội dung kém hấp dẫn và sống động so với Claude 3.7.

Hài hước vẫn là một lĩnh vực thách thức đối với GPT-4.5, với những nỗ lực tạo hài hước thường cảm thấy chung chung hoặc thiếu ngữ cảnh, không có sự tinh tế và tương đồng mà người dùng mong đợi.

ChatGPT-4.5 hiện có giá 200 USD/tháng cho người dùng chuyên nghiệp, đắt hơn đáng kể so với cả GPT-4 và Claude 3.7, làm dấy lên câu hỏi về khả năng tiếp cận và giá trị tổng thể.

OpenAI đang cân nhắc việc tiếp tục cung cấp GPT-4.5 trong API của họ do chi phí vận hành và mức độ áp dụng hạn chế.

Mô hình này vẫn gặp phải các vấn đề về độ tin cậy, bao gồm ảo giác - khi mô hình tạo ra thông tin không chính xác hoặc bịa đặt, làm suy giảm tính hữu dụng trong các ứng dụng quan trọng.

Claude 3.7 nổi lên như một đối thủ đáng gờm, vượt trội hơn GPT-4.5 trong nhiều lĩnh vực quan trọng như trí thông minh cảm xúc, viết sáng tạo và trí thông minh xã hội.

Sự phát triển của GPT-4.5 phản ánh xu hướng rộng lớn hơn trong nghiên cứu AI, tập trung vào việc nâng cao khả năng suy luận và giải quyết các hạn chế hiện có thay vì chỉ mở rộng quy mô mô hình cơ sở.

📌 ChatGPT-4.5 cải thiện khiêm tốn về lập trình và suy luận khoa học nhưng thua kém Claude 3.7 về trí thông minh cảm xúc và sáng tạo. Với giá 200 USD/tháng, mô hình này khó cạnh tranh trong thị trường, khiến OpenAI phải xem xét lại chiến lược phát triển AI.

https://www.geeky-gadgets.com/is-chatgpt-4-5-worth-the-hype-heres-what-you-should-know-performance-and-limitations/

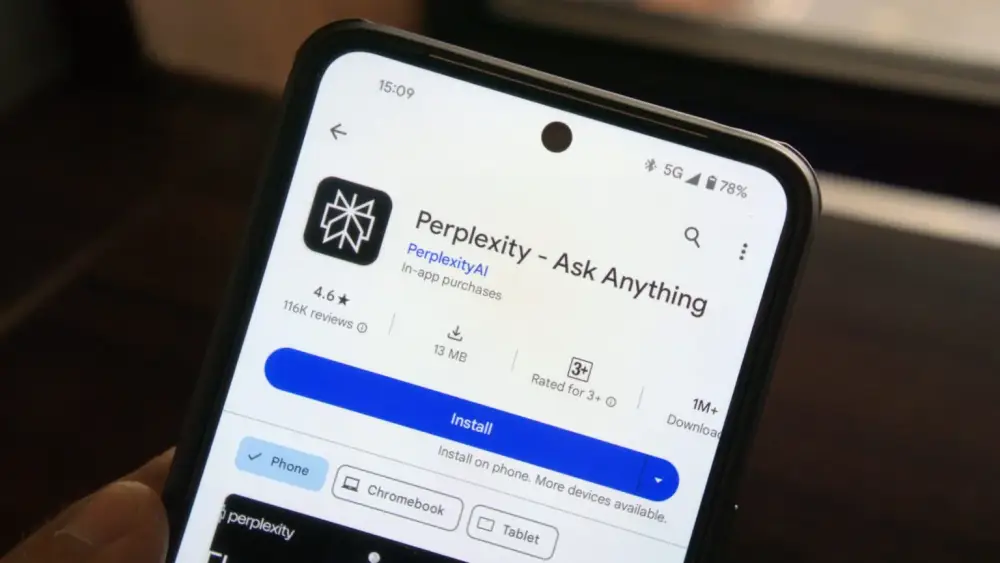

Duck.ai, dịch vụ AI của DuckDuckGo ra mắt tháng 6/2024 và chính thức kết thúc giai đoạn beta vào tuần trước, đã gây ấn tượng mạnh với người dùng.

Điểm nổi bật nhất của Duck.ai là cho phép người dùng lựa chọn giữa các mô hình AI khác nhau: GPT-4o mini, o3-mini, Claude 3 (độc quyền) hoặc các mô hình nguồn mở như Llama 3.3 và Mistral Small 3.

Dịch vụ này hoàn toàn miễn phí và đặc biệt chú trọng bảo mật - tất cả các truy vấn được ẩn danh hóa bởi DuckDuckGo, đảm bảo không bên thứ ba nào có thể truy cập vào cuộc trò chuyện AI của người dùng.

Duck.ai lưu trữ các cuộc trò chuyện cục bộ (chỉ cục bộ), cho phép người dùng lưu và quay lại sau để tiếp tục nghiên cứu.

Công ty loại bỏ metadata cá nhân khỏi các cuộc trò chuyện, khiến chúng không thể bị liên kết với người dùng. Mặc dù các cuộc trò chuyện gần đây được lưu cục bộ, nhưng dữ liệu cần thiết cho nhà cung cấp để phản hồi lệnh vẫn được lưu trữ (nêu trong Thỏa thuận cấp phép người dùng cuối).