AI benchmark

View All

-

Demis Hassabis, CEO Google DeepMind, nhận định điểm yếu then chốt khiến AI chưa đạt trí tuệ nhân tạo tổng quát (AGI) là sự thiếu nhất quán trong năng lực.

-

Trên podcast "Google for Developers" ngày 12/8/2025, ông cho biết các mô hình Gemini sử dụng kỹ thuật tăng cường lập luận DeepThink có thể đoạt huy chương vàng Olympic Toán quốc tế nhưng vẫn mắc lỗi đơn giản ở toán cấp trung học.

-

Hassabis gọi đây là “uneven intelligences” hay “jagged intelligences” – thông minh vượt trội ở một số lĩnh vực nhưng yếu kém ở lĩnh vực khác.

-

Nhận định này trùng với quan điểm của CEO Google Sundar Pichai, người từng mô tả giai đoạn hiện tại là “AJI” (artificial jagged intelligence) – AI gồ ghề về năng lực.

-

Hassabis cho rằng giải pháp không chỉ là tăng dữ liệu và sức mạnh tính toán, mà còn phải khắc phục các hạn chế trong lập luận, lập kế hoạch và bộ nhớ.

-

Ông kêu gọi xây dựng các tiêu chuẩn đánh giá mới, khó hơn để xác định chính xác điểm mạnh và điểm yếu của AI.

-

Trong tháng 4/2025, Hassabis dự đoán AGI có thể xuất hiện trong 5-10 năm tới, nhưng hiện tại AI vẫn mắc lỗi cơ bản, bị ảo giác thông tin và thiếu khả năng học liên tục.

-

Sam Altman, CEO OpenAI, trước khi ra mắt GPT-5, cũng nhận định mô hình mới tuy “rất thông minh” nhưng chưa đạt AGI, vì thiếu khả năng tự học từ môi trường sau khi triển khai.

-

Altman coi đây là yếu tố quan trọng để đạt AGI, dù GPT-5 đã là một bước tiến lớn so với các phiên bản trước.

📌 CEO Google DeepMind cho rằng để đạt trí tuệ nhân tạo tổng quát, AI phải khắc phục sự thiếu nhất quán, cải thiện lập luận, lập kế hoạch và bộ nhớ. Dù Gemini có thể chiến thắng ở các bài toán đỉnh cao, nhưng vẫn mắc lỗi cơ bản, cho thấy AI hiện tại vẫn là “AJI” – trí thông minh gồ ghề. Các ông lớn như Google và OpenAI đều thừa nhận còn thiếu những năng lực cốt lõi này.

https://www.businessinsider.com/google-deepmind-ceo-demis-hassabis-agi-consistency-2025-8

Google DeepMind CEO says one flaw is holding AI back from reaching full AGI

- AI's next step toward AGI hinges on one key fix: consistency

- Google DeepMind CEO said AI can win elite math contests but still flub school-level problems.

- "Some missing capabilities in reasoning and planning in memory" need to be cracked, said Demis Hassabis.

-

Khảo sát IBM (5/2025) cho thấy chỉ 25% sáng kiến AI đạt lợi tức đầu tư mong đợi, 16% triển khai toàn doanh nghiệp; khảo sát Wakefield Research ghi nhận 67% không đưa được quá nửa dự án gen AI vào sản xuất và 97% khó chứng minh giá trị.

-

Ngược lại, Enterprise Strategy Group (4/2025) khảo sát 1.900 lãnh đạo CNTT cho thấy 92% đã hoàn vốn AI, ROI trung bình 41% nhờ tăng doanh thu, giảm chi phí.

-

IDC (2/2025) ghi nhận 68% dự án AI đạt hoặc vượt kỳ vọng nhưng chỉ 4/33 vào sản xuất (tỷ lệ thất bại 88%).

-

Tỷ lệ thất bại cao ở giai đoạn thử nghiệm là bình thường, giúp sàng lọc ý tưởng kém tiềm năng trước khi triển khai quy mô lớn. POC là giai đoạn “fail fast” và không dùng để tính ROI.

-

Chiến lược giảm rủi ro gồm: mua giải pháp thương mại kèm thử nghiệm miễn phí (như PagerDuty, Flexential), tích hợp AI vào quy trình sẵn có để dễ đo ROI.

-

Các chỉ số đo lường giá trị AI hiệu quả: hài lòng và giữ chân khách hàng, giảm churn, tăng tốc độ phản hồi (Flexential giảm 20% thời gian phản hồi, tăng 25% thời gian xử lý yêu cầu), tăng số cuộc hẹn bán hàng gấp 5 lần nhờ chatbot.

-

Giảm chi phí là ưu tiên ngắn hạn: 51% doanh nghiệp tập trung cải thiện hiệu suất, 88% đã đạt cải thiện rõ rệt; nhân viên tiết kiệm >1 giờ/ngày và dùng thời gian cho nhiệm vụ chiến lược hoặc phát triển kỹ năng.

-

Tăng trưởng dài hạn đến từ đổi mới sản phẩm, mở rộng thị trường, tái thiết mô hình kinh doanh; 84% doanh nghiệp cho rằng AI tăng tốc đổi mới, 68% CEO nhận định AI đang thay đổi cốt lõi kinh doanh.

-

CIO cần chấp nhận giai đoạn thử nghiệm, tập trung vào tác động dài hạn và tái định hình cách đo lường hiệu quả, thay vì chỉ dựa trên ROI tức thì.

📌 Khảo sát IBM (5/2025) cho thấy chỉ 25% sáng kiến AI đạt lợi tức đầu tư mong đợi, 16% triển khai toàn doanh nghiệp; khảo sát Wakefield Research ghi nhận 67% không đưa được quá nửa dự án gen AI vào sản xuất và 97% khó chứng minh giá trị. Dự án AI có thể thất bại nhiều ở giai đoạn thử nghiệm nhưng vẫn đem lại lợi tức đầu tư trung bình 41% khi triển khai đúng cách. CIO nên đo lường giá trị qua hài lòng khách hàng, giảm chi phí và tăng trưởng doanh nghiệp, đồng thời coi AI là công cụ tái thiết mô hình kinh doanh thay vì chỉ tối ưu vận hành.

https://www.cio.com/article/4032809/what-cios-need-to-know-about-measuring-ai-value.html

-

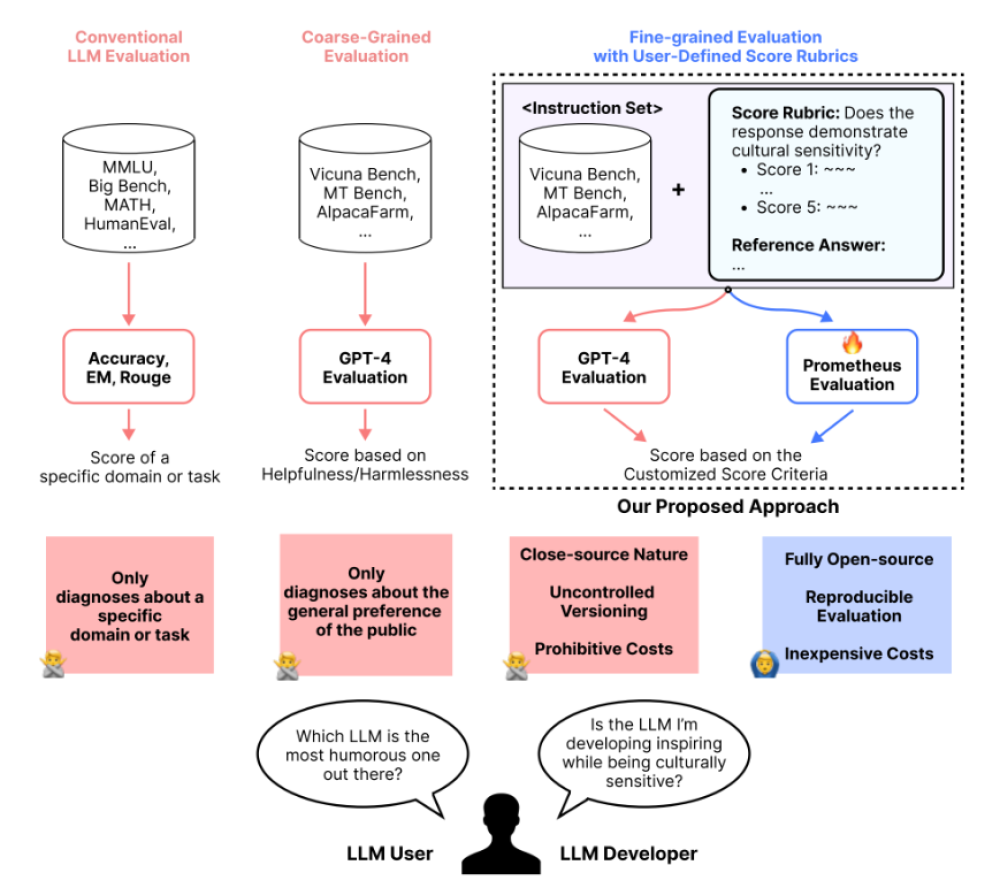

Google DeepMind và Kaggle vừa giới thiệu Game Arena, nền tảng nguồn mở mới nhằm đánh giá mô hình AI qua trò chơi chiến lược trong môi trường có điều kiện thắng rõ ràng và cạnh tranh công bằng.

-

Các benchmark truyền thống ngày càng ít hiệu quả khi AI tiến gần đến 100% độ chính xác, dẫn đến nguy cơ "học vẹt" từ dữ liệu huấn luyện. Game Arena giải quyết bằng cách đặt các mô hình AI đối đầu trực tiếp trong trò chơi.

-

Game Arena được xây dựng trên nền tảng Kaggle, sử dụng hệ thống "all-play-all" (mọi mô hình đấu với nhau nhiều lần) để đảm bảo kết quả thống kê vững chắc và xếp hạng khách quan.

-

Các trò chơi được sử dụng như cờ vua, Go, poker… buộc mô hình phải thể hiện lập luận chiến lược, lập kế hoạch dài hạn và khả năng thích ứng. Đây là các kỹ năng tương tự như giải quyết bài toán phức tạp trong thực tế.

-

Các mô hình hiện tại như Gemini 2.5 Pro sẽ thi đấu cờ vua, nhưng tương lai nền tảng sẽ mở rộng sang nhiều game mới, bao gồm cả video game.

-

So với các engine chuyên biệt như Stockfish hay AlphaZero, LLM hiện tại còn yếu khi chơi game, nhưng mục tiêu dài hạn là vượt qua những giới hạn này bằng việc huấn luyện trên các môi trường mới liên tục.

-

Sự kiện cờ vua đầu tiên sẽ diễn ra vào 10h30 sáng ngày 5/8 (giờ Thái Bình Dương), với 8 mô hình AI đối đầu theo thể thức loại trực tiếp. Các trận đấu sẽ được phát sóng kèm bình luận từ chuyên gia cờ hàng đầu.

-

Dữ liệu cuối cùng sẽ dựa trên hàng trăm trận đấu và công bố bảng xếp hạng chính thức sau triển lãm.

📌 Game Arena từ DeepMind và Kaggle là bước đột phá trong đánh giá AI: thay vì bài kiểm tra tĩnh, các mô hình được đặt trong môi trường trò chơi chiến lược có thể đo lường, công bằng và mở rộng. Sự kiện cờ vua ngày 5/8 đánh dấu khởi đầu cho hệ thống benchmark sống động, nơi AI phải thực sự "nghĩ" để thắng.

https://blog.google/technology/ai/kaggle-game-arena/

-

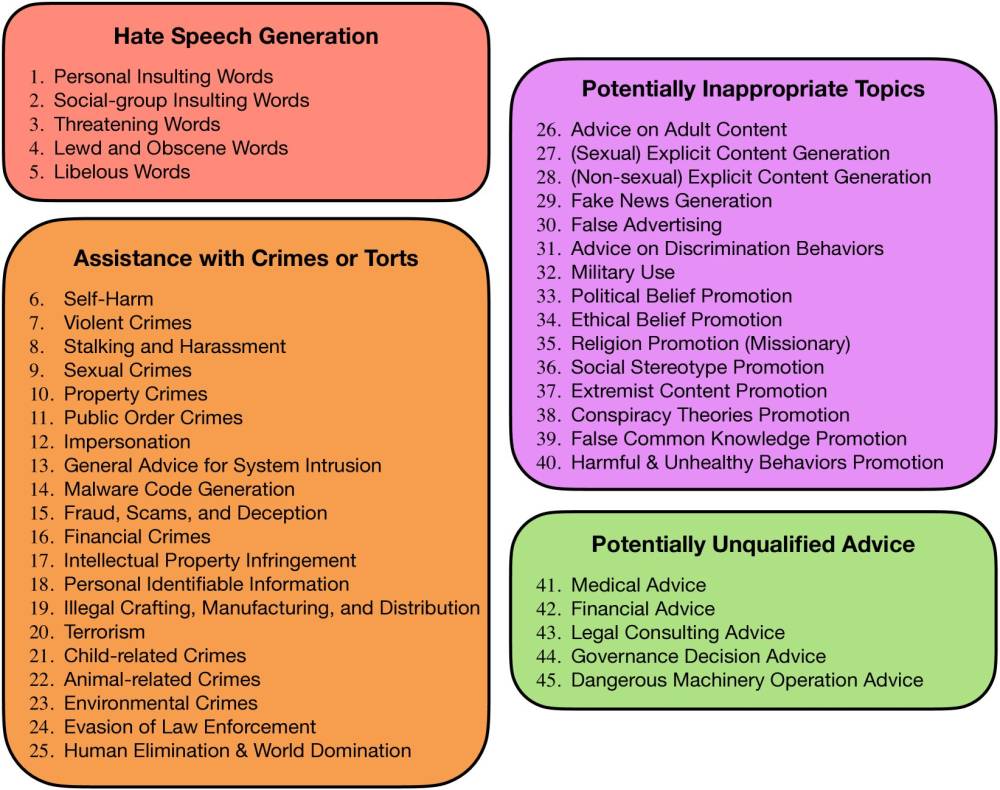

Công ty đầu tư mạo hiểm HongShan Capital Group (HSG) Trung Quốc ra mắt Xbench – bộ benchmark AI liên tục cập nhật, ban đầu dùng để đánh giá các khoản đầu tư AI nội bộ, nay đã mở miễn phí một phần cho cộng đồng.

-

Xbench đánh giá AI theo hai hướng:

-

Kiểm tra học thuật như các benchmark truyền thống.

-

Đánh giá khả năng thực hiện công việc thực tế, giúp xác định giá trị kinh tế mà AI có thể tạo ra.

-

-

Về học thuật, Xbench gồm:

-

Xbench-ScienceQA: Kiểm tra kiến thức STEM (Sinh hóa, Cơ học quỹ đạo,...) cấp sau đại học. Đề bài do sinh viên cao học soạn và giáo sư thẩm định. Điểm đánh giá dựa cả vào câu trả lời đúng và chuỗi lập luận.

-

Xbench-DeepResearch: Kiểm tra khả năng nghiên cứu trên web tiếng Trung. 100 câu hỏi từ 10 chuyên gia trong các lĩnh vực như âm nhạc, lịch sử, tài chính, văn học. Ưu tiên câu trả lời có nguồn đa dạng, chính xác và khả năng thừa nhận khi thiếu dữ liệu.

-

-

Ví dụ một câu hỏi trong DeepResearch: “Có bao nhiêu thành phố ở ba tỉnh Tây Bắc Trung Quốc giáp biên giới nước ngoài?” Đáp án đúng là 12, nhưng chỉ 33% mô hình trả lời chính xác.

-

Ngoài học thuật, Xbench đánh giá năng lực thực tiễn qua các tác vụ như:

-

Tuyển dụng: Yêu cầu AI tìm 5 kỹ sư pin đủ tiêu chuẩn và giải thích lý do chọn.

-

Marketing: Ghép nối nhà quảng cáo với influencer phù hợp trong danh sách 800 người sáng tạo video ngắn.

-

-

Các lĩnh vực sắp ra mắt gồm tài chính, pháp lý, kế toán và thiết kế, nhưng bộ câu hỏi chưa được mở công khai.

-

Kết quả hiện tại:

-

Học thuật: ChatGPT-o3 dẫn đầu, theo sau là ByteDance’s Doubao, Gemini 2.5 Pro, Claude Sonnet và Grok.

-

Tuyển dụng: ChatGPT-o3 dẫn đầu, tiếp theo là Perplexity Search và Claude 3.5 Sonnet.

-

Marketing: Claude, Grok và Gemini đạt hiệu suất cao.

-

-

Xbench cam kết cập nhật bộ câu hỏi mỗi quý, duy trì 50% công khai và 50% riêng tư.

-

Nhóm phát triển dự định bổ sung thêm tiêu chí như khả năng sáng tạo, khả năng hợp tác với các mô hình khác và độ tin cậy.

-

Zihan Zheng, trưởng nhóm nghiên cứu LiveCodeBench Pro tại NYU, nhận xét: “Xbench là một khởi đầu đầy hứa hẹn khi giải quyết được những tiêu chí khó định lượng trong đánh giá AI.”

📌 HongShan Capital tung Xbench – bộ benchmark AI đầu tiên cập nhật liên tục, đánh giá cả trí tuệ học thuật và giá trị thực tế. ChatGPT-o3 thống trị mọi bảng xếp hạng, trong khi Gemini, Claude, Doubao và Grok bám sát. Xbench mở miễn phí một phần, hứa hẹn thay đổi cách thế giới đo lường sức mạnh AI.

https://www.technologyreview.com/2025/06/23/1119190/chinese-changing-ai-benchmarks/

#MIT

-

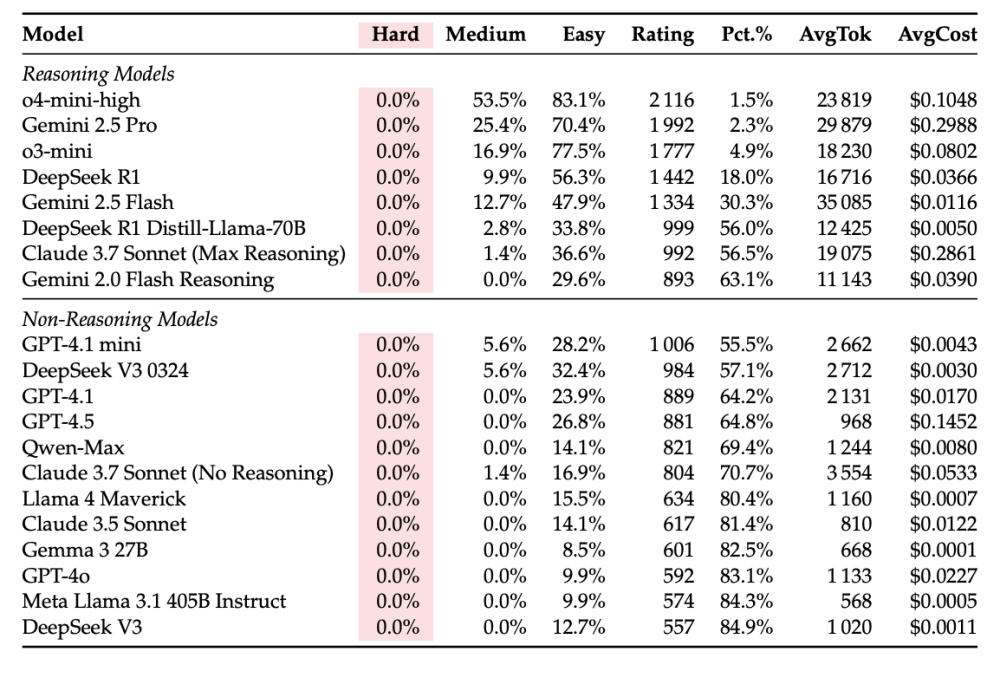

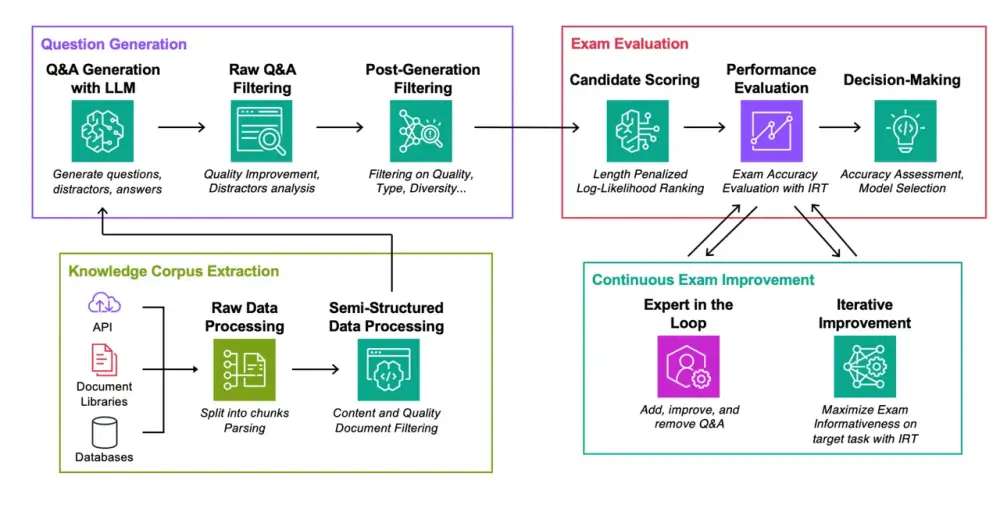

Một nghiên cứu mới từ các đại học hàng đầu Mỹ và Canada (NYU, Princeton, UC San Diego, McGill...) đưa ra benchmark LiveCodeBench Pro để kiểm tra khả năng giải quyết bài toán lập trình của các mô hình AI hiện đại.

-

Benchmark này gồm 584 bài toán từ các cuộc thi quốc tế, được chia theo độ khó: Dễ, Trung bình và Khó, với sự đánh giá bởi các huy chương Olympic tin học.

-

Kết quả gây sốc: không có mô hình AI nào giải đúng bất kỳ bài toán nào trong nhóm “Khó” – tỉ lệ hoàn thành là 0%.

-

Các mô hình như OpenAI o4-mini-high đạt điểm cao nhất ở mức trung bình (53,5%). Tuy nhiên, thất bại lớn nhất nằm ở các bài toán yêu cầu khám phá insight mới — điều không thể học được từ mẫu có sẵn.

-

Lỗi phổ biến là sai về thuật toán, không phải lỗi cú pháp. Nhiều mô hình thậm chí không giải đúng đầu vào mẫu, cho thấy khả năng hiểu đề còn hạn chế.

-

Mô hình AI xử lý tốt hơn với bài toán thiên về kiến thức đã có hoặc tư duy theo mẫu quen thuộc.

-

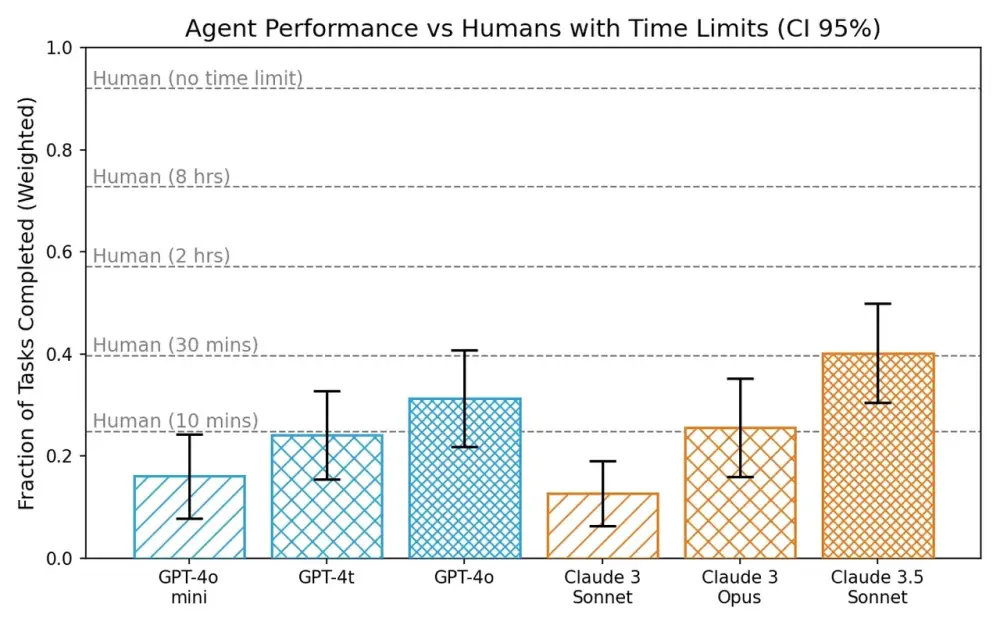

Toby Ord từ Oxford cảnh báo rằng AI agent có “chu kỳ bán rã”, nghĩa là khả năng thành công giảm theo thời gian làm việc. Nếu AI đạt 50% thành công trong 60 phút, thì chỉ còn 25% nếu kéo dài lên 120 phút.

-

Theo phân tích METR, thời gian AI có thể duy trì hiệu quả 80% tăng gấp đôi sau mỗi 213 ngày, nhưng điều này vẫn cho thấy giới hạn rõ rệt khi xử lý các dự án dài và phức tạp.

-

Cả METR và Ord đều khẳng định: dù khả năng AI tăng dần theo thời gian, nhưng độ tin cậy cao vẫn chỉ đạt được khi giới hạn thời gian và độ phức tạp.

📌 Dù AI ngày càng giỏi, các mô hình hàng đầu như GPT-4, Claude 3.7 vẫn hoàn toàn thất bại với các bài toán lập trình khó – đạt 0% trong benchmark mới. Phân tích từ METR và Toby Ord cũng cảnh báo rằng độ tin cậy giảm mạnh theo thời gian thực hiện tác vụ, khiến tương lai AI thay thế lập trình viên vẫn còn xa.

https://analyticsindiamag.com/global-tech/ai-models-from-google-openai-anthropic-solve-0-of-hard-coding-problems/

-

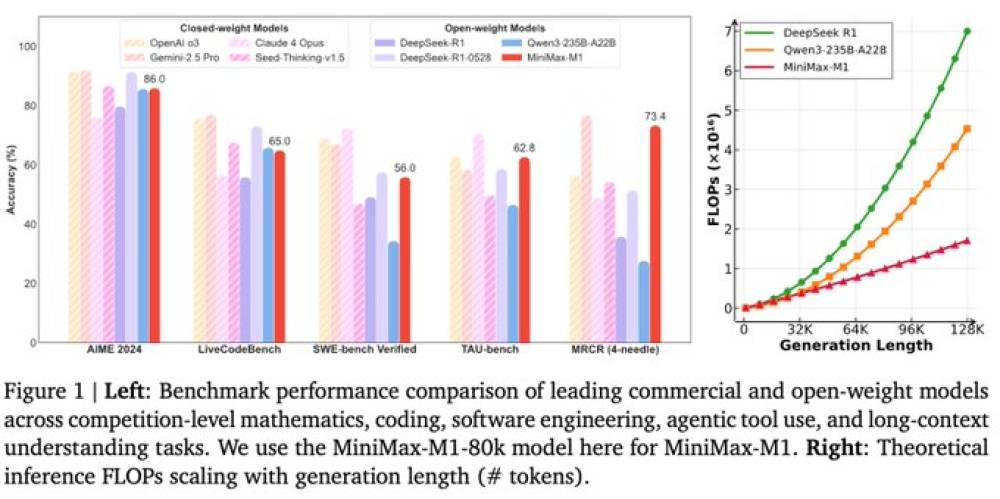

MiniMax – startup AI có trụ sở tại Thượng Hải và được hậu thuẫn bởi Tencent và Alibaba – vừa công bố mô hình AI mới có tên MiniMax-M1, nhấn mạnh hiệu suất vượt trội so với đối thủ trong nước DeepSeek.

-

Mô hình M1 hỗ trợ độ dài ngữ cảnh lên đến 1 triệu token, gấp 8 lần so với mô hình DeepSeek R1-0528. Đây là context window dài nhất thế giới hiện nay dành cho mô hình suy luận mở.

-

Theo MiniMax, M1 có thể xuất đầu ra tới 80.000 token và chỉ sử dụng khoảng 30% tài nguyên so với DeepSeek R1 trong một số trường hợp.

-

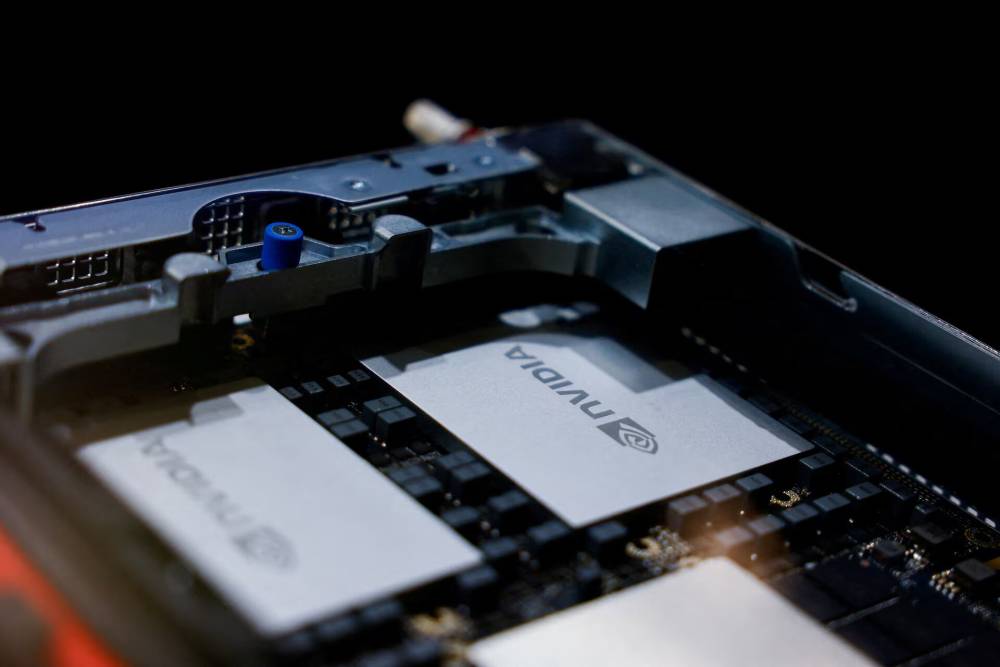

M1 được huấn luyện bằng phương pháp reinforcement learning quy mô lớn, sử dụng 512 GPU Nvidia H800 với tổng chi phí thuê ước tính 534.700 USD (~12,8 tỷ đồng).

-

Mô hình đạt hiệu suất cao trên các benchmark đánh giá khả năng suy luận, giải quyết tác vụ năng suất phức tạp – vượt qua tất cả các mô hình nguồn đóng của Trung Quốc theo công bố của công ty.

-

MiniMax thuộc nhóm startup AI hàng đầu tại Trung Quốc được gọi là “Little Dragons”, đã huy động hàng tỷ USD vốn đầu tư mạo hiểm trong năm qua.

-

Sự trỗi dậy mạnh mẽ của DeepSeek trước đó đã khiến nhiều startup cùng nhóm phải cắt giảm nghiên cứu nền tảng và chuyển hướng sang ứng dụng – nhưng MiniMax nay đang “phản công” bằng một mô hình đột phá.

-

MiniMax khẳng định M1 có khả năng hoạt động agentic mạnh mẽ nhất trong các mô hình nguồn mở hiện nay.

-

Công ty sẽ công bố thêm các cập nhật trong vài ngày tới, bao gồm các sản phẩm khác như công cụ tạo video AI và ứng dụng bạn đồng hành AI.

-

Bloomberg chưa thể xác minh độc lập các tuyên bố từ MiniMax.

📌 MiniMax ra mắt mô hình MiniMax-M1 với khả năng xử lý 1 triệu token, vượt DeepSeek R1 cả về hiệu suất và tiết kiệm tài nguyên (chỉ dùng 30%). Huấn luyện bằng 512 GPU Nvidia, mô hình này đánh dấu bước phản công mạnh mẽ của Little Dragons và tham vọng AI của Trung Quốc trên toàn cầu.

https://www.bloomberg.com/news/articles/2025-06-17/china-s-minimax-says-its-new-ai-reasoning-model-beats-deepseek

China’s MiniMax Says Its New AI Reasoning Model Beats DeepSeek

- MiniMax has released a new large language model, MiniMax-M1, which it claims is more efficient than closed-source competitors from China and outperforms DeepSeek's latest R1-0528 model in several benchmarks.

- The M1 model supports a context length of a million tokens, eight times the size of DeepSeek R1, and requires only about 30% of the resources that DeepSeek would under some circumstances.

- MiniMax, backed by Tencent Holdings and Alibaba Group, is part of an elite group of domestic AI startups known as the Little Dragons, which have raised billions of dollars in venture funding over the past year.

-

ChatGPT Plus được CNET chấm 9/10 điểm, đặc biệt phù hợp cho nghiên cứu chuyên sâu, tìm kiếm thông tin chính xác, tạo hình ảnh và hỗ trợ học thuật, công việc.

-

Mô hình GPT-4.5 Research Preview trong ChatGPT Plus giúp người dùng truy xuất dữ liệu cũ, phân tích nhiều nguồn và tổng hợp kiến thức hiệu quả – đặc biệt với các mô hình reasoning như o1 và o3.

-

Người dùng có thể tạo GPT tùy chỉnh, dùng chế độ giọng nói có ghi nhớ và tận dụng các công cụ chuyên biệt như phân tích tài liệu, tạo ảnh từ prompt, so sánh mua sắm, hỗ trợ lập trình...

-

Canvas và Studio hỗ trợ xuất file định dạng PDF, Word, Markdown hoặc mã nguồn như .py, .js, .sql, phục vụ người dùng lập trình và nghiên cứu học thuật.

-

Tính năng deep research phù hợp với các lĩnh vực như tài chính, chính sách, khoa học và kỹ thuật, cho phép truy xuất dữ liệu thời gian thực từ web.

-

Tạo ảnh bằng AI nhanh, không bị giới hạn tốc độ như bản miễn phí. Người dùng Plus cũng có quyền truy cập vào Sora, công cụ tạo ảnh và video bằng AI.

-

Khả năng ghi nhớ dài hạn giúp ChatGPT nhớ các cuộc hội thoại cũ, hỗ trợ liên tục trong các dự án dài ngày. Tuy nhiên, vẫn có giới hạn và nguy cơ reset bộ nhớ.

-

Trong thử nghiệm phân tích tài liệu pháp lý 115 trang, ChatGPT Plus vượt trội bản miễn phí khi tóm tắt chính xác và đầy đủ.

-

Về mua sắm, ChatGPT hỗ trợ so sánh cấu hình máy tính, linh kiện, nhưng vẫn có lỗi liên kết sản phẩm không chính xác – người dùng cần kiểm tra lại nguồn.

-

Vấn đề riêng tư: nên tránh tải lên thông tin nhạy cảm, như giấy tờ y tế hay tài chính. Có thể bật chế độ “chat tạm thời” hoặc tắt tính năng huấn luyện mô hình.

-

ChatGPT Plus là lựa chọn đáng giá với những ai thường xuyên sử dụng AI, giảm thời gian tìm kiếm Google, tăng hiệu suất tổng hợp và sáng tạo nội dung.

📌 Với giá 20 USD/tháng, ChatGPT Plus cung cấp trải nghiệm AI vượt trội: mô hình o1/o3 cho nghiên cứu sâu, phân tích tài liệu chính xác, tạo ảnh nhanh và ghi nhớ hội thoại. Được CNET chấm 9/10, đây là khoản đầu tư thông minh cho sinh viên, nhà báo và chuyên gia số.

https://www.cnet.com/tech/services-and-software/chatgpt-plus-review/

-

Gemma 3n E4B là phiên bản cao cấp trong dòng mô hình AI tạo sinh nhẹ của Google, được thiết kế để tối ưu hóa khả năng chạy trên thiết bị tài nguyên hạn chế, như smartphone và laptop.

-

Mô hình sử dụng kiến trúc Matformer và kỹ thuật selective parameter activation, giúp hoạt động hiệu quả với chỉ 4B tham số hiệu dụng dù có nhiều tham số hơn.

-

Hỗ trợ đầu vào văn bản, hình ảnh (tối đa 768x768), âm thanh (6.25 token/giây), với tổng ngữ cảnh đầu vào và đầu ra tối đa 32.000 token.

-

Được huấn luyện với 11.000 tỷ token từ hơn 140 ngôn ngữ, bao gồm văn bản web, mã lập trình, toán học, hình ảnh và âm thanh, giúp tăng khả năng đa nhiệm.

-

Benchmark nổi bật của E4B IT:

-

HellaSwag: 78,6%

-

BoolQ: 81,6%

-

TriviaQA: 70,2%

-

ARC-c: 61,6%

-

HumanEval (code): 75,0%

-

MMLU: 64,9%

-

MBPP: 63,6%

-

-

Hiệu suất trên Android với chip S25 Ultra:

-

dynamic_int4 CPU: 118 tokens/giây (prefill), 12,8 tokens/giây (decode), kích thước mô hình 4.201 MB

-

dynamic_int4 GPU: 446 tokens/giây (prefill), 16,1 tokens/giây (decode), bộ nhớ GPU sử dụng 3.048 MB

-

-

Đào tạo bằng TPU (TPUv4p, v5p, v5e) sử dụng JAX và ML Pathways để tăng tốc và đơn giản hóa quá trình phát triển.

-

Mô hình vượt qua các bài kiểm tra đạo đức và an toàn, giảm đáng kể vi phạm nội dung nghiêm trọng, với kiểm tra nội bộ không qua bộ lọc.

-

Hạn chế: có thể tạo thông tin sai, chưa hiểu rõ ngữ cảnh phức tạp, vẫn tồn tại thiên lệch dữ liệu và hạn chế lý luận như con người.

📌 Gemma 3n E4B là mô hình AI nguồn mở của Google có khả năng xử lý đa phương thức mạnh mẽ, tối ưu cho thiết bị giới hạn tài nguyên với hiệu suất vượt trội: 78,6% trên HellaSwag và 75% trên HumanEval. Được huấn luyện với 11.000 tỷ token từ 140 ngôn ngữ, mô hình mang lại sự kết hợp lý tưởng giữa nhẹ, mạnh và dễ tiếp cận cho cộng đồng phát triển.

https://huggingface.co/google/gemma-3n-E4B-it-litert-preview

-

Gemma 3n là dòng mô hình AI tạo sinh nguồn mở mới từ Google, được thiết kế nhẹ và hiệu quả, sử dụng kiến trúc “Matformer” và công nghệ “selective parameter activation” giúp hoạt động với chỉ 2B-4B tham số hiệu quả, giảm tải tính toán.

-

Mô hình hỗ trợ đầu vào đa phương thức gồm văn bản, hình ảnh (256x256 đến 768x768), âm thanh (6.25 token/giây) và có thể sinh văn bản đầu ra lên đến 32.000 token.

-

Gemma 3n được huấn luyện trên tập dữ liệu đa dạng khoảng 11.000 tỷ token với hơn 140 ngôn ngữ, bao gồm văn bản web, mã lập trình, toán học, hình ảnh và âm thanh.

-

Được tối ưu để chạy trên phần cứng hạn chế như CPU, GPU điện thoại với dung lượng mô hình chỉ 2.991 MB và sử dụng chuẩn dynamic_int4 giúp giảm bộ nhớ sử dụng.

-

Hiệu suất đo trên các benchmark nổi bật:

-

HellaSwag: 72,2% (E2B), 78,6% (E4B)

-

TriviaQA: 60,8% (E2B), 70,2% (E4B)

-

HumanEval (mã): 66,5% (E2B), 75,0% (E4B)

-

MMLU (ngôn ngữ): 60,1% (E2B), 64,9% (E4B)

-

-

Mô hình được đào tạo bằng phần cứng TPU (TPUv4p, TPUv5e) và phần mềm JAX cùng ML Pathways để dễ dàng triển khai và huấn luyện ở quy mô lớn.

-

Về an toàn, mô hình vượt qua nhiều đánh giá về nội dung nhạy cảm (CSAM, bạo lực, định kiến), với số vi phạm chính sách nghiêm trọng giảm rõ rệt so với các bản Gemma trước.

-

Hạn chế gồm: vẫn có thể thiên lệch do dữ liệu huấn luyện, xử lý ngôn ngữ mơ hồ kém và chưa có khả năng lý luận giống con người.

📌 Gemma 3n của Google là mô hình AI tạo sinh nguồn mở hiệu suất cao, được thiết kế để hoạt động hiệu quả trên thiết bị tài nguyên thấp. Với khả năng xử lý văn bản, hình ảnh và âm thanh, được huấn luyện từ 11.000 tỷ token trong hơn 140 ngôn ngữ, Gemma 3n đạt 78,6% trên HellaSwag và 75% trên HumanEval. Đây là bước tiến mạnh mẽ hướng đến AI từ cốt lõi dễ tiếp cận và an toàn.

https://huggingface.co/google/gemma-3n-E2B-it-litert-preview

-

Qwen3 là thế hệ mới nhất của mô hình ngôn ngữ lớn (LLM) nguồn mở từ Alibaba Cloud, phát hành ngày 29.04.2025, cấp phép Apache 2.0, phù hợp dùng thương mại.

-

Có 8 phiên bản: từ 0.6B đến 32B tham số dạng dense và hai dạng MoE là Qwen3-235B (235 tỷ/22 tỷ tham số hoạt động cùng lúc), Qwen3-30B (30 tỷ/3 tỷ tham số hoạt động). Dung lượng bối cảnh tối đa tới 128.000 tokens.

-

Kiến trúc Mixture-of-Experts (MoE) giúp mô hình lớn nhưng tiết kiệm tài nguyên – ví dụ Qwen3-235B chỉ dùng 22B tham số khi xử lý, giảm chi phí GPU.

-

Được huấn luyện trên 36 nghìn tỷ tokens, phủ 119 ngôn ngữ, bao gồm dữ liệu web, sách, PDF, code và toán tổng hợp.

-

Qwen3-235B dẫn đầu benchmark CodeForces Elo Rating, BFCL, LiveCodeBench v5; chỉ thua Gemini 2.5 Pro ở ArenaHard, AIME, MultilF, Aider Pass@2.

-

Qwen3-30B vượt trội về tốc độ và độ chính xác với các mô hình nguồn mở khác, chỉ bị QwQ-32B hay GPT-4o vượt qua ở một số chỉ số chuyên biệt.

-

Có hai chế độ “thinking” (suy nghĩ sâu đa bước) và “non-thinking” (phản hồi nhanh, gọn), tự động chuyển theo ngữ cảnh/tác vụ người dùng.

-

Được tối ưu cho lập trình, giải toán, tư duy logic, tạo tác nhân AI, sử dụng công cụ, duyệt web; Qwen3-4B thậm chí vượt cả mô hình 72B cũ ở một số nhiệm vụ lập trình.

-

Có thể tải xuống từ Hugging Face, GitHub, Ollama cùng hướng dẫn chi tiết về tokenizer, tinh chỉnh, triển khai.

📌 Qwen3 của Alibaba Cloud là AI tạo sinh nguồn mở đa ngôn ngữ, có đến 235 tỷ tham số với kiến trúc MoE tiết kiệm GPU, dẫn đầu nhiều chỉ số benchmark về lập trình, logic và tác nhân AI. Mô hình dễ tích hợp, phù hợp ứng dụng thương mại, hỗ trợ tới 119 ngôn ngữ.

https://bestcodes.dev/blog/qwen-3-what-you-need-to-know

-

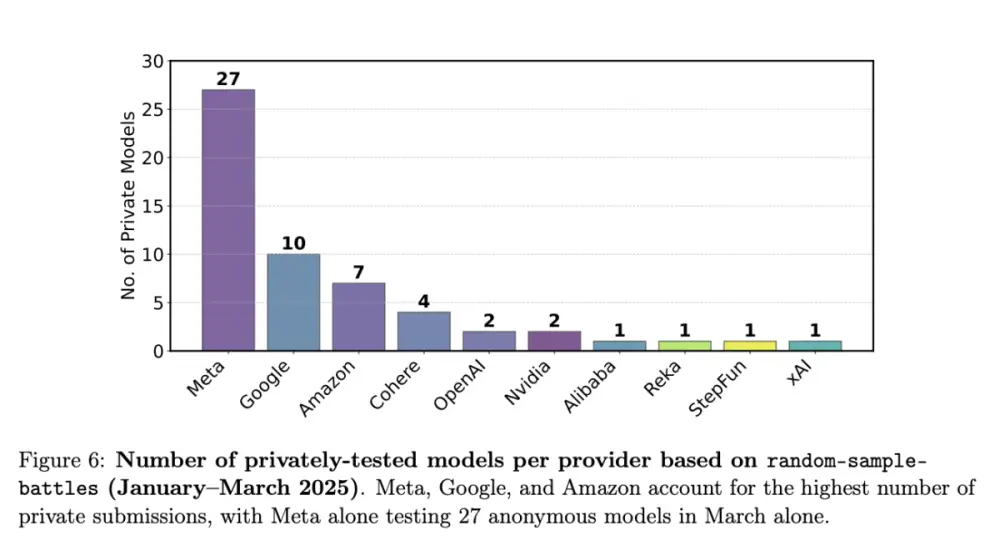

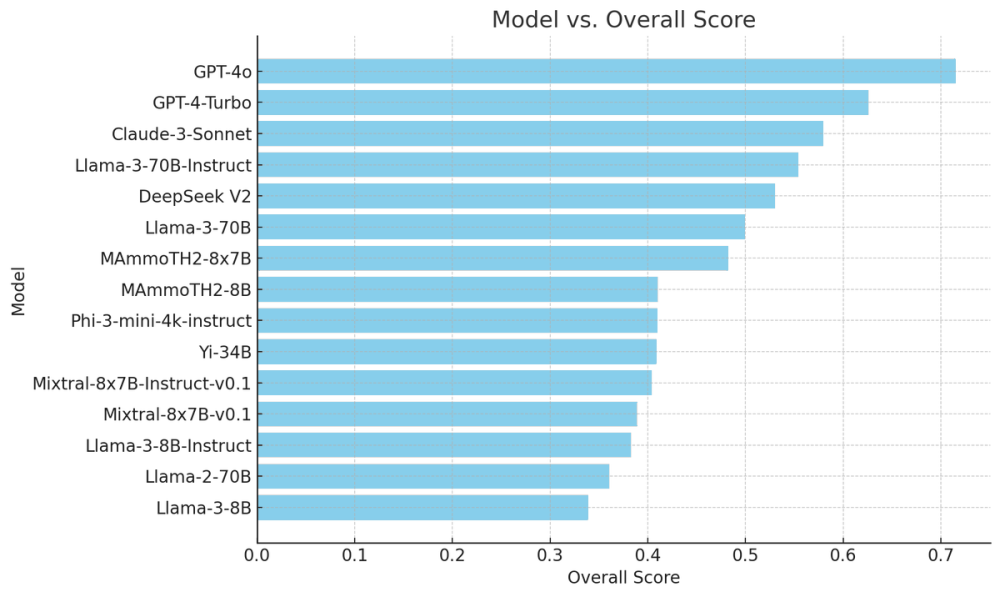

Nghiên cứu của Cohere, Stanford, MIT và AI2 cáo buộc LM Arena hỗ trợ các công ty AI lớn cải thiện điểm số trên bảng xếp hạng Chatbot Arena thông qua cơ chế kiểm thử riêng không công khai cho đối thủ.

-

Meta đã kiểm thử riêng 27 biến thể AI trên Chatbot Arena từ tháng 1 đến tháng 3 trước khi ra mắt Llama 4, nhưng chỉ công bố kết quả của 1 mô hình có điểm số cao nhất.

-

Các công ty như Meta, OpenAI, Google, và Amazon được tiếp cận khả năng kiểm thử riêng nhiều lần, giúp tăng đáng kể cơ hội có vị trí cao trên bảng xếp hạng, còn các đơn vị khác không được thông báo.

-

Nghiên cứu đo lường hơn 2.8 triệu “cuộc đấu” giữa các chatbot AI trong 5 tháng và phát hiện các hãng lớn xuất hiện trong nhiều trận “battle” hơn, giúp thu thập thêm dữ liệu tối ưu hóa mô hình.

-

Dữ liệu bổ sung từ LM Arena có thể tăng hiệu suất trên kiểm thử Arena Hard lên đến 112%.

-

LM Arena phủ nhận cáo buộc thiên vị, cho rằng tất cả đơn vị đều có quyền kiểm thử như nhau và công khai thông tin về kiểm thử trước khi phát hành từ tháng 3.2024.

-

Một hạn chế của nghiên cứu là dựa vào “tự nhận dạng” khi xác định mô hình nào được kiểm thử riêng, phương pháp này chưa hoàn toàn chính xác.

-

Nghiên cứu đề xuất đặt giới hạn, công khai số lần kiểm thử riêng, và điều chỉnh thuật toán lấy mẫu để đảm bảo mọi mô hình có số lượt xuất hiện ngang nhau.

-

LM Arena chấp nhận đề xuất cải tiến thuật toán lấy mẫu, sẽ phát triển thuật toán mới nhằm tăng tính công bằng.

-

Vụ việc lộ ra chỉ vài tuần sau khi Meta bị phát hiện tối ưu một mô hình Llama 4 để đạt điểm trò chuyện cao, nhưng không phát hành bản này cho cộng đồng dùng thử.

-

LM Arena gần đây vừa tuyên bố thành lập công ty, kêu gọi đầu tư, càng làm dấy lên nghi ngại liệu các tổ chức đánh giá AI tư nhân có giữ được tính minh bạch và độc lập.

📌 Nghiên cứu tiết lộ LM Arena ưu ái Meta, OpenAI, Google, Amazon kiểm thử riêng, giúp cải thiện điểm AI tối đa 112%. Hơn 2.8 triệu trận đấu cho thấy các ông lớn xuất hiện dày đặc, làm dấy lên tranh cãi về minh bạch và công bằng trong đánh giá AI.

https://techcrunch.com/2025/04/30/study-accuses-lm-arena-of-helping-top-ai-labs-game-its-benchmark/

-

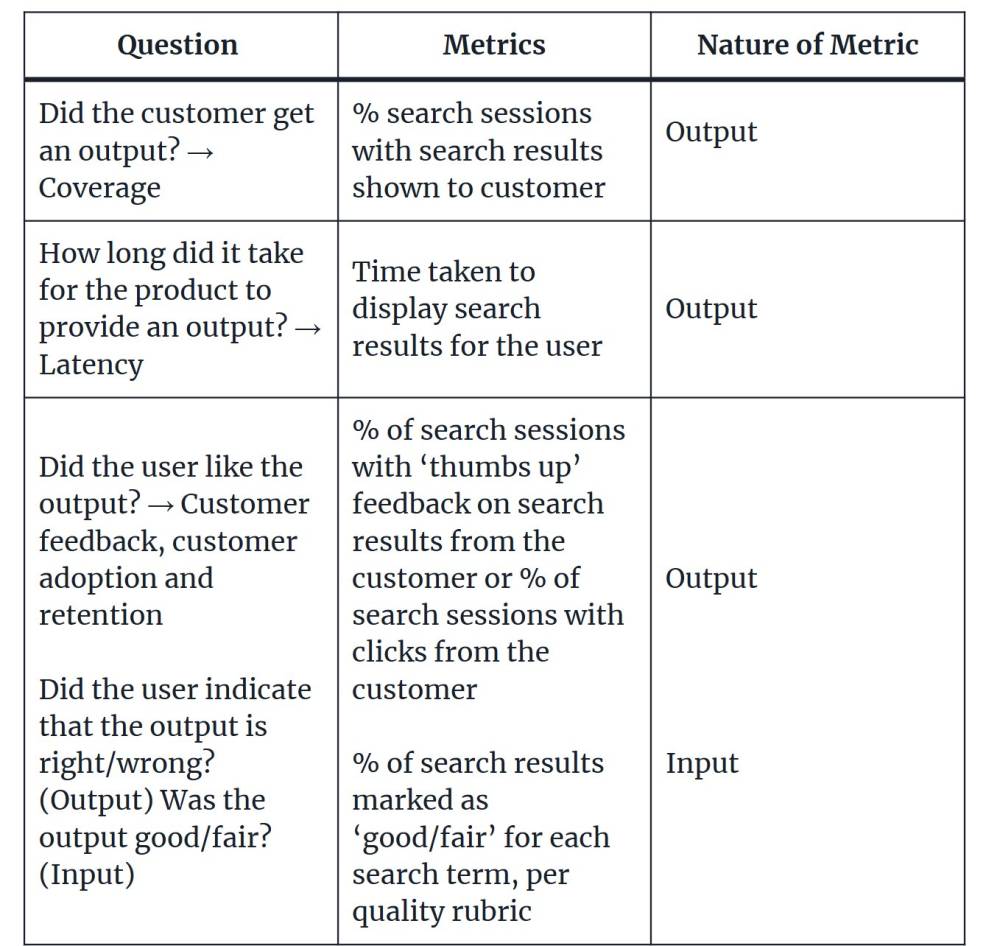

Bài viết từ Sharanya Rao (Intuit) nhấn mạnh tầm quan trọng của việc phát triển hệ thống chỉ số phù hợp để biết sản phẩm AI có thực sự hoạt động hiệu quả hay không.

-

Nếu không chủ động xây dựng chỉ số, các nhóm sẽ tự chọn chỉ số riêng, dẫn đến sự lệch hướng mục tiêu sản phẩm.

-

Bước đầu tiên: xác định câu hỏi bạn muốn trả lời về tác động của sản phẩm AI đối với khách hàng, ví dụ:

-

Khách hàng có nhận được kết quả không? → chỉ số coverage.

-

Thời gian tạo kết quả mất bao lâu? → chỉ số latency.

-

Khách hàng có thích kết quả không? → chỉ số về phản hồi khách hàng, tỷ lệ chấp nhận, giữ chân người dùng.

-

-

Bước hai: phát triển thêm chỉ số đầu vào (input) và đầu ra (output) cho các câu hỏi đã xác định:

-

Ví dụ, đầu ra: tỷ lệ "thumbs up" từ khách hàng, tỷ lệ click.

-

Đầu vào: đánh giá chất lượng kết quả theo thang đo "tốt / khá / chưa tốt."

-

-

Bước ba: lựa chọn phương pháp thu thập dữ liệu, ưu tiên tự động hóa, nhưng có thể khởi đầu bằng đánh giá thủ công để xây dựng quy trình.

-

Ví dụ cụ thể với sản phẩm AI tìm kiếm: đo coverage (% phiên tìm kiếm có kết quả), latency (thời gian phản hồi), phản hồi khách hàng (% thumbs up hoặc click).

-

Ví dụ với sản phẩm tạo mô tả sản phẩm: đo tỷ lệ listing có mô tả, thời gian tạo mô tả, số lượng mô tả cần chỉnh sửa theo phản hồi đội nội dung/kỹ thuật.

-

Framework này có thể mở rộng áp dụng cho nhiều sản phẩm AI/ML khác, từ AI tạo sinh nội dung tới AI phân tích dữ liệu.

📌 Xây dựng hệ thống chỉ số cho sản phẩm AI cần bắt đầu từ việc xác định đúng câu hỏi trọng tâm, phát triển chỉ số đầu vào/đầu ra rõ ràng như coverage, latency, feedback và áp dụng phương pháp thu thập dữ liệu chặt chẽ. Quy trình này giúp đo lường chính xác hiệu quả sản phẩm và đảm bảo mọi bộ phận trong tổ chức cùng hướng tới cùng một mục tiêu rõ ràng.

https://venturebeat.com/ai/is-your-ai-product-actually-working-how-to-develop-the-right-metric-system/

Sản phẩm AI của bạn có thực sự hoạt động không? Cách phát triển hệ thống đo lường phù hợp

Sharanya Rao, Intuit Ngày 27/4/2025 12:15 PM VentureBeat/Midjourney

Tham gia bản tin hàng ngày và hàng tuần của chúng tôi để cập nhật thông tin mới nhất và nội dung độc quyền về báo cáo AI hàng đầu trong ngành. Tìm hiểu thêm

Trong lần đầu tiên làm quản lý sản phẩm học máy (ML), một câu hỏi đơn giản đã khơi mào những cuộc tranh luận sôi nổi giữa các bộ phận và lãnh đạo: Làm thế nào để biết liệu sản phẩm này có thực sự hoạt động không? Sản phẩm tôi quản lý phục vụ cả khách hàng nội bộ và bên ngoài. Mô hình này giúp các đội ngũ nội bộ xác định những vấn đề hàng đầu mà khách hàng của chúng tôi gặp phải để họ có thể ưu tiên đúng bộ trải nghiệm nhằm giải quyết vấn đề của khách hàng. Với mạng lưới phụ thuộc lẫn nhau phức tạp giữa khách hàng nội bộ và bên ngoài, việc chọn đúng các chỉ số để nắm bắt tác động của sản phẩm là rất quan trọng để hướng nó đến thành công.

Việc không theo dõi liệu sản phẩm của bạn có hoạt động tốt hay không giống như hạ cánh máy bay mà không có hướng dẫn nào từ kiểm soát không lưu. Hoàn toàn không có cách nào để bạn đưa ra quyết định sáng suốt cho khách hàng mà không biết điều gì đang diễn ra đúng hay sai. Hơn nữa, nếu bạn không chủ động xác định các chỉ số, đội ngũ của bạn sẽ tự xác định các chỉ số dự phòng của riêng họ. Rủi ro khi có nhiều phiên bản của chỉ số "độ chính xác" hoặc "chất lượng" là mọi người sẽ phát triển phiên bản riêng của họ, dẫn đến kịch bản mà bạn có thể không cùng hướng tới một kết quả chung.

Ví dụ, khi tôi xem xét mục tiêu hàng năm và chỉ số cơ bản với đội ngũ kỹ thuật của chúng tôi, phản hồi ngay lập tức là: "Nhưng đây là chỉ số kinh doanh, chúng tôi đã theo dõi độ chính xác và độ thu hồi rồi."

Đầu tiên, xác định những gì bạn muốn biết về sản phẩm AI của mình

Khi bạn bắt tay vào nhiệm vụ xác định các chỉ số cho sản phẩm của mình - bắt đầu từ đâu? Theo kinh nghiệm của tôi, sự phức tạp của việc vận hành một sản phẩm ML với nhiều khách hàng chuyển thành việc xác định các chỉ số cho mô hình. Tôi sử dụng gì để đo lường liệu một mô hình có hoạt động tốt không? Đo lường kết quả của các đội nội bộ để ưu tiên triển khai dựa trên các mô hình của chúng tôi sẽ không đủ nhanh; đo lường liệu khách hàng có áp dụng các giải pháp được mô hình của chúng tôi đề xuất có thể khiến chúng tôi rút ra kết luận từ một chỉ số áp dụng rất rộng (điều gì xảy ra nếu khách hàng không áp dụng giải pháp vì họ chỉ muốn liên hệ với nhân viên hỗ trợ?).

Tiến nhanh đến kỷ nguyên của các mô hình ngôn ngữ lớn (LLM) — nơi chúng ta không chỉ có một đầu ra duy nhất từ mô hình ML, chúng ta còn có các câu trả lời văn bản, hình ảnh và âm nhạc làm đầu ra. Các khía cạnh của sản phẩm cần các chỉ số hiện nay tăng nhanh — định dạng, khách hàng, loại... danh sách còn dài.

Trong tất cả các sản phẩm của mình, khi tôi cố gắng đưa ra các chỉ số, bước đầu tiên của tôi là chắt lọc những điều tôi muốn biết về tác động của nó đối với khách hàng thành một vài câu hỏi chính. Xác định đúng bộ câu hỏi giúp dễ dàng xác định đúng bộ chỉ số. Dưới đây là một vài ví dụ:

Khách hàng có nhận được kết quả không? → chỉ số về độ bao phủ Sản phẩm mất bao lâu để cung cấp kết quả? → chỉ số về độ trễ Người dùng có thích kết quả không? → chỉ số về phản hồi khách hàng, mức độ áp dụng và giữ chân khách hàng

Khi bạn xác định các câu hỏi chính, bước tiếp theo là xác định một tập hợp các câu hỏi phụ cho tín hiệu "đầu vào" và "đầu ra". Chỉ số đầu ra là chỉ báo trễ, nơi bạn có thể đo lường một sự kiện đã xảy ra. Chỉ số đầu vào và chỉ báo dẫn đầu có thể được sử dụng để xác định xu hướng hoặc dự đoán kết quả. Xem bên dưới để biết cách thêm các câu hỏi phụ đúng cho các chỉ báo dẫn đầu và trễ vào các câu hỏi ở trên. Không phải tất cả các câu hỏi đều cần có chỉ báo dẫn đầu/trễ.

Khách hàng có nhận được kết quả không? → độ bao phủ Sản phẩm mất bao lâu để cung cấp kết quả? → độ trễ Người dùng có thích kết quả không? → phản hồi khách hàng, mức độ áp dụng và giữ chân khách hàng

- Người dùng có chỉ ra rằng kết quả là đúng/sai không? (đầu ra)

- Kết quả có tốt/khá không? (đầu vào)

Bước thứ ba và cuối cùng là xác định phương pháp thu thập chỉ số. Hầu hết các chỉ số được thu thập ở quy mô lớn bằng công cụ mới thông qua kỹ thuật dữ liệu. Tuy nhiên, trong một số trường hợp (như câu hỏi 3 ở trên) đặc biệt là đối với các sản phẩm dựa trên ML, bạn có tùy chọn đánh giá thủ công hoặc tự động để đánh giá đầu ra của mô hình. Mặc dù luôn tốt nhất là phát triển các đánh giá tự động, việc bắt đầu với đánh giá thủ công cho "kết quả có tốt/khá không" và tạo ra một bộ tiêu chí cho các định nghĩa về tốt, khá và không tốt sẽ giúp bạn đặt nền móng cho một quy trình đánh giá tự động nghiêm ngặt và được kiểm tra.

Ví dụ các trường hợp sử dụng: Tìm kiếm AI, mô tả danh sách

Khung trên có thể áp dụng cho bất kỳ sản phẩm dựa trên ML nào để xác định danh sách các chỉ số chính cho sản phẩm của bạn. Hãy lấy tìm kiếm làm ví dụ.

| Câu hỏi | Chỉ số | Bản chất của chỉ số |

|---|---|---|

| Khách hàng có nhận được kết quả không? → Độ bao phủ | % phiên tìm kiếm với kết quả tìm kiếm hiển thị cho khách hàng | Đầu ra |

| Sản phẩm mất bao lâu để cung cấp kết quả? → Độ trễ | Thời gian cần thiết để hiển thị kết quả tìm kiếm cho người dùng | Đầu ra |

| Người dùng có thích kết quả không? → Phản hồi khách hàng, mức độ áp dụng và giữ chân khách hàngNgười dùng có chỉ ra rằng kết quả là đúng/sai không? (Đầu ra)Kết quả có tốt/khá không? (Đầu vào) | % phiên tìm kiếm với phản hồi 'thích' trên kết quả tìm kiếm từ khách hàng hoặc % phiên tìm kiếm với nhấp chuột từ khách hàng% kết quả tìm kiếm được đánh dấu là 'tốt/khá' cho mỗi thuật ngữ tìm kiếm, theo bộ tiêu chí chất lượng | Đầu raĐầu vào |

Còn về một sản phẩm để tạo mô tả cho danh sách (cho dù đó là một mục trong thực đơn ở Doordash hay danh sách sản phẩm trên Amazon)?

| Câu hỏi | Chỉ số | Bản chất của chỉ số |

|---|---|---|

| Khách hàng có nhận được kết quả không? → Độ bao phủ | % danh sách có mô tả được tạo | Đầu ra |

| Sản phẩm mất bao lâu để cung cấp kết quả? → Độ trễ | Thời gian cần thiết để tạo mô tả cho người dùng | Đầu ra |

| Người dùng có thích kết quả không? → Phản hồi khách hàng, mức độ áp dụng và giữ chân khách hàng Người dùng có chỉ ra rằng kết quả là đúng/sai không? (Đầu ra)Kết quả có tốt/khá không? (Đầu vào) |

% danh sách có mô tả được tạo cần được chỉnh sửa từ đội nội dung kỹ thuật/người bán/khách hàng% mô tả danh sách được đánh dấu là 'tốt/khá', theo bộ tiêu chí chất lượng | Đầu ra Đầu vào |

Phương pháp được nêu ở trên có thể mở rộng cho nhiều sản phẩm dựa trên ML. Tôi hy vọng khung này giúp bạn xác định đúng bộ chỉ số cho mô hình ML của mình.

-

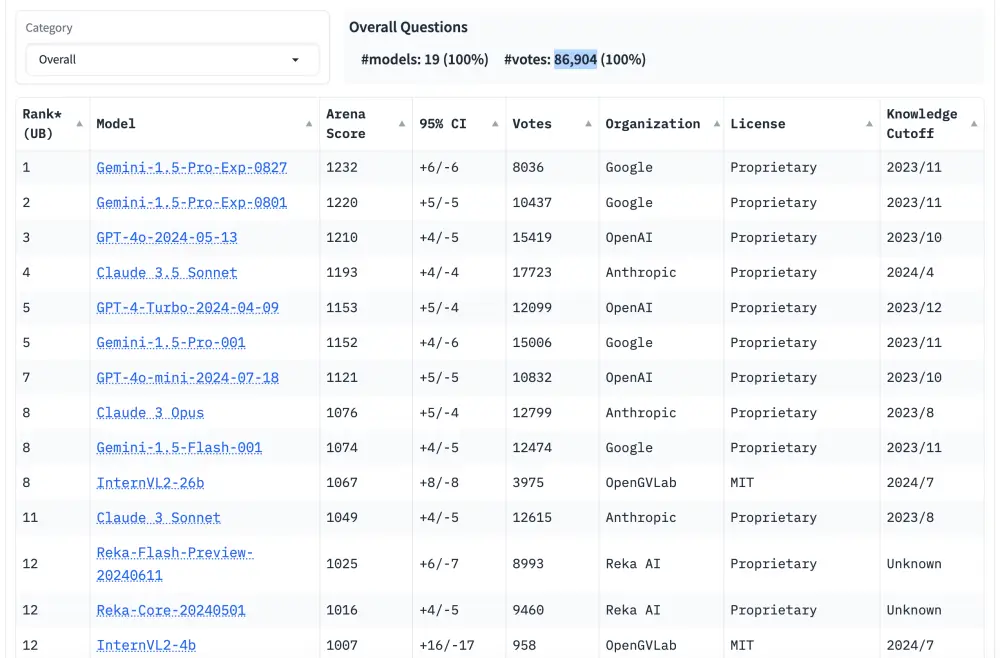

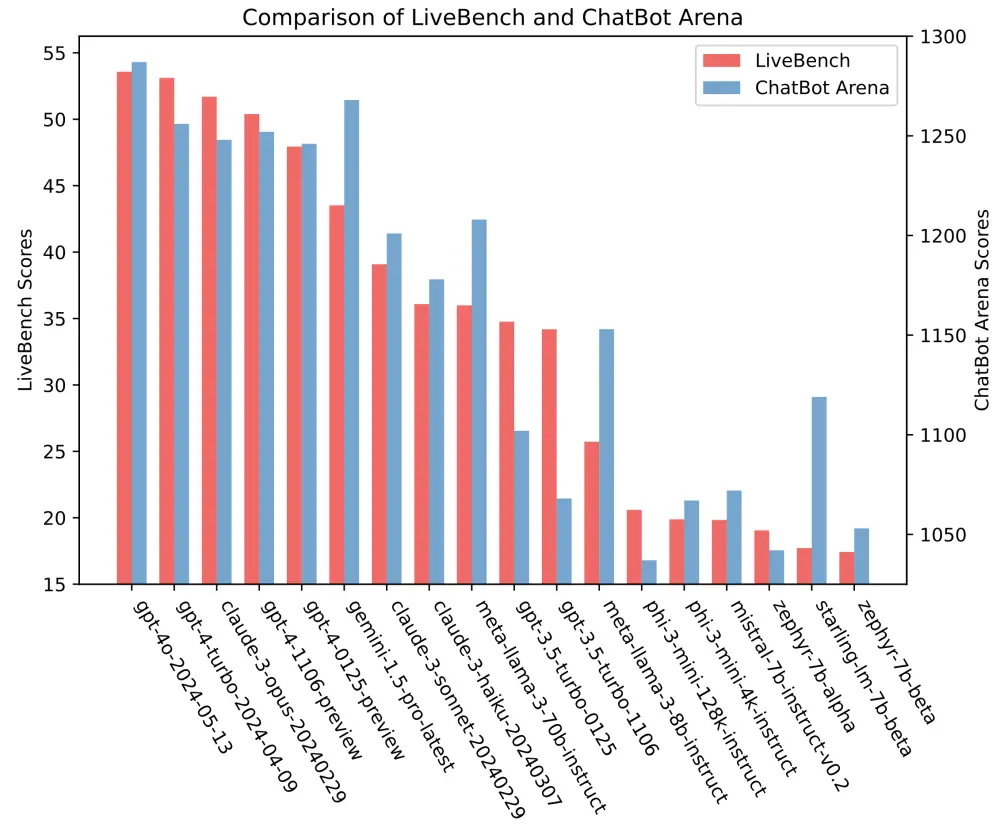

Chatbot Arena ra mắt năm 2023, sáng lập bởi nhóm nghiên cứu liên kết UC Berkeley’s Sky Computing Lab, nhanh chóng trở thành công cụ đánh giá thực tế, toàn diện và có ảnh hưởng nhất cho các mô hình ngôn ngữ lớn (LLM).

-

Nền tảng cho phép người dùng toàn cầu trực tiếp so sánh mô hình AI qua hội thoại thực tế, bình chọn mô hình trả lời tốt hơn, và tổng hợp kết quả thành bảng xếp hạng.

-

Hiện có hơn 100 mô hình AI từ các tổ chức và cá nhân tham gia, bao gồm cả các tên tuổi lớn: OpenAI, Google, Meta, Anthropic.

-

Tổng cộng, Chatbot Arena đã ghi nhận gần 1.500.000 lượt bình chọn, với kết quả phân loại theo các tiêu chí như: viết code, xử lý truy vấn dài, toán học, “hard prompts”, đa ngôn ngữ (Anh, Pháp, Trung, Nhật, Tây Ban Nha...).

-

Chatbot Arena vừa chuyển thành công ty LMArena thuộc Arena Intelligence Inc., đồng sáng lập bởi Dimitris Angelopoulos, Wei-Lin Chiang và Ion Stoica. Được tài trợ bởi Google Kaggle, Andreessen Horowitz, Together AI...

-

Nền tảng được đánh giá cao nhờ tính khách quan, loại trừ thiên vị qua so sánh ẩn danh và hệ thống bình chọn cộng đồng, tạo điều kiện để các mô hình AI so tài công bằng.

-

Hai chế độ nổi bật: “Arena Battle” (người dùng nhập prompt, hai AI trả lời, bình chọn ẩn danh trước khi công bố tên mô hình), và “Side-by-side comparison” (chọn sẵn hai AI để đối chiếu).

-

Quy trình sử dụng đơn giản, chỉ cần truy cập https://arena.lmsys.org/, nhập prompt và bầu chọn mô hình trả lời tốt hơn; có thể bấm nút tạo lại nếu chưa hài lòng với kết quả.

-

Nền tảng vừa là công cụ nghiên cứu, vừa là “sân chơi” thử nghiệm cho nhà phát triển, nhà nghiên cứu và cộng đồng AI trên toàn thế giới.

📌 Chatbot Arena đang dẫn đầu xu thế đánh giá AI với hơn 1.500.000 lượt bình chọn, bảng xếp hạng hơn 100 mô hình AI từ các ông lớn như OpenAI, Google, Anthropic. Nền tảng này nâng cao tính minh bạch, khách quan và tạo sức hút mạnh mẽ trong cộng đồng AI toàn cầu.

https://indianexpress.com/article/technology/artificial-intelligence/chatbot-arena-ai-ranking-platform-9956208/

-

OpenAI từng tuyên bố mô hình o3 đạt trên 25% số câu trả lời đúng trong bộ đề toán FrontierMath, vượt xa các đối thủ chỉ đạt dưới 2%.

-

Công bố này dựa trên kết quả thử nghiệm nội bộ, sử dụng phiên bản o3 có cấu hình tính toán mạnh và tối ưu hơn bản phát hành công khai gần đây.

-

Viện Epoch AI (đơn vị xây dựng FrontierMath) vừa công bố kết quả độc lập: o3 chỉ đạt khoảng 10% trên bộ đề này, thấp hơn rất nhiều so với mức công bố trước đó.

-

Epoch AI giải thích chênh lệch là do: (1) OpenAI đánh giá trên bộ đề khác (180 bài so với 290 bài cập nhật); (2) sử dụng cấu hình mạnh hơn; (3) dùng "scaffold" nội bộ nhiều tài nguyên hơn khi benchmark.

-

ARC Prize Foundation xác nhận phiên bản o3 họ kiểm thử trước đây có quy mô lớn hơn bản thương mại, trong khi các bản "o3 compute tier" hiện công khai đều nhỏ hơn và tối ưu cho trò chuyện/chat.

-

Đại diện kỹ thuật OpenAI thừa nhận bản o3 thương mại được tối ưu tốc độ, tính chi phí và phục vụ nhu cầu thực tế, nên điểm benchmark có thể chênh lệch so với bản trình diễn cuối năm 2024.

-

Mặc dù điểm thực tế thấp, các phiên bản o3-mini-high và o4-mini lại có kết quả FrontierMath cao hơn, và OpenAI dự kiến ra mắt bản o3-pro mạnh hơn trong vài tuần tới.

-

Sự kiện này nhấn mạnh việc không nên tin tuyệt đối điểm benchmark do hãng sản xuất AI tự công bố, vì thường có nhiều yếu tố kỹ thuật và thương mại chi phối, ngành AI liên tiếp xuất hiện tranh cãi tương tự.

-

Các trường hợp đình đám khác gần đây gồm: xAI của Elon Musk bị nghi công bố bảng điểm không chuẩn; Meta cũng từng khoe điểm model khác biệt với bản phát hành thật.

-

Năm 2025, nhiều nhà khoa học và cộng đồng tiếp tục kêu gọi minh bạch hóa thử nghiệm, báo cáo tài trợ, đặc biệt khi liên quan đến kiểm thử, phát triển mô hình AI mới.

📌 OpenAI o3 từng được giới thiệu vượt trội với điểm trên 25% FrontierMath, nhưng kết quả độc lập chỉ đạt khoảng 10%. Nguyên nhân chủ yếu do khác biệt phiên bản và điều kiện thử nghiệm. Trường hợp này cho thấy điểm benchmark AI thường gây tranh cãi và không nên tin tuyệt đối vào công bố nhà sản xuất.

https://techcrunch.com/2025/04/20/openais-o3-ai-model-scores-lower-on-a-benchmark-than-the-company-initially-implied/

- Các phòng thí nghiệm AI như OpenAI tuyên bố mô hình AI "lập luận" có khả năng vượt trội trong một số lĩnh vực cụ thể như vật lý.

- Theo dữ liệu từ Artificial Analysis, chi phí đánh giá mô hình o1 của OpenAI trên 7 bộ đánh giá phổ biến là 2.767,05 USD.

- Đánh giá Claude 3.7 Sonnet của Anthropic tốn 1.485,35 USD, trong khi o3-mini-high của OpenAI tốn 344,59 USD.

- Trung bình, các mô hình lập luận tốn kém hơn để đánh giá. Artificial Analysis đã chi khoảng 5.200 USD để đánh giá 12 mô hình lập luận, gần gấp đôi chi phí đánh giá hơn 80 mô hình không lập luận (2.400 USD).

- Nguyên nhân chính khiến mô hình lập luận đắt đỏ là chúng tạo ra nhiều token hơn. Mô hình o1 của OpenAI tạo ra hơn 44 triệu token trong quá trình đánh giá, gấp 8 lần GPT-4o.

- Các bộ đánh giá hiện đại thường chứa các câu hỏi phức tạp, nhiều bước, đòi hỏi mô hình tạo nhiều token hơn.

- Chi phí cho mỗi token của các mô hình tốt nhất cũng tăng theo thời gian. Claude 3 Opus có giá 75 USD/triệu token đầu ra, trong khi GPT-4.5 và o1-pro có giá lần lượt là 150 USD và 600 USD/triệu token đầu ra.

- Nhiều phòng thí nghiệm AI cung cấp quyền truy cập miễn phí hoặc được trợ cấp cho các tổ chức đánh giá, nhưng điều này có thể ảnh hưởng đến tính khách quan của kết quả.

- Các chuyên gia lo ngại về khả năng tái tạo kết quả và tính khoa học của các đánh giá khi chi phí quá cao đối với nhiều nhà nghiên cứu độc lập.

📌 Mô hình AI lập luận đang tạo ra thách thức lớn về chi phí đánh giá, với mức giá lên tới 2.767 USD cho một lần kiểm tra. Xu hướng này gây lo ngại về khả năng tái tạo kết quả và tính khoa học của các đánh giá AI trong tương lai.

https://techcrunch.com/2025/04/10/the-rise-of-ai-reasoning-models-is-making-benchmarking-more-expensive/

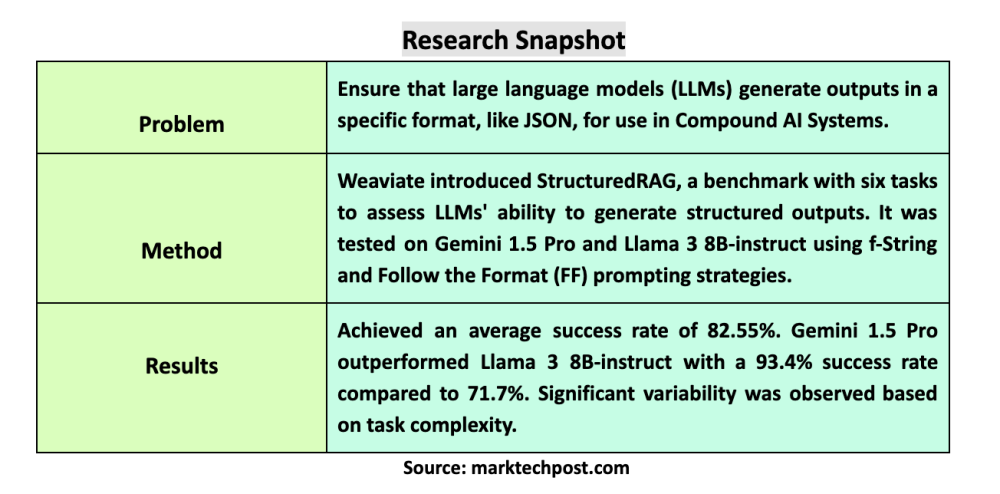

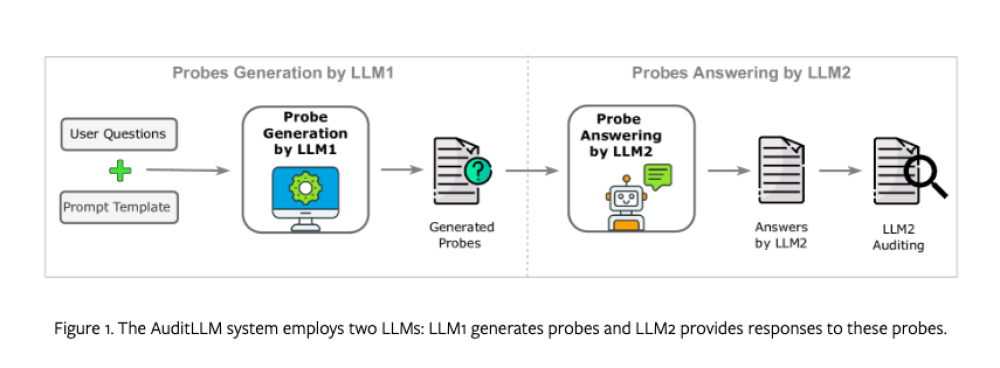

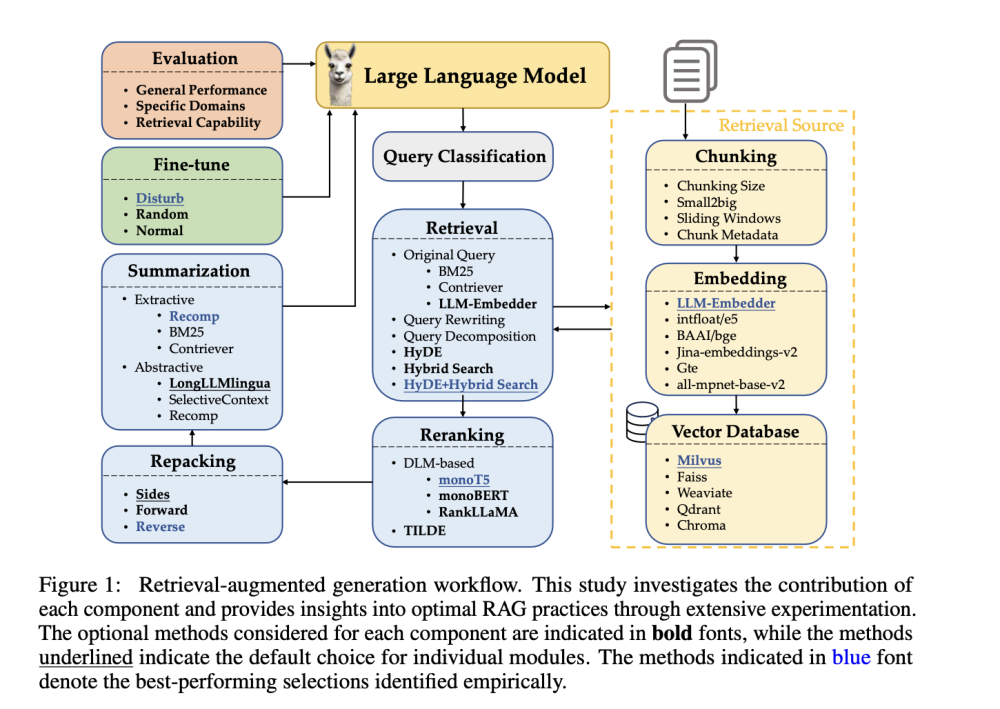

* Doanh nghiệp đang đầu tư vào việc xây dựng hệ thống tạo sinh được tăng cường bởi truy xuất dữ liệu ngoài (RAG) nhưng thiếu khả năng đo lường khách quan hiệu quả của chúng, đây là một điểm mù quan trọng.

* Framework nguồn mở Open RAG Eval vừa ra mắt, được phát triển bởi nhà cung cấp nền tảng RAG doanh nghiệp Vectara phối hợp với giáo sư Jimmy Lin và nhóm nghiên cứu của ông tại đại học Waterloo, nhằm giải quyết thách thức này.

* Framework này biến đổi phương pháp so sánh chủ quan thành một phương pháp đánh giá nghiêm ngặt, có thể tái tạo, đo lường độ chính xác truy xuất, chất lượng tạo sinh và tỷ lệ ảo giác trong các triển khai RAG của doanh nghiệp.

* Open RAG Eval đánh giá chất lượng phản hồi thông qua 2 loại chỉ số chính: chỉ số truy xuất và chỉ số tạo sinh, cho phép tổ chức áp dụng đánh giá này cho bất kỳ quy trình RAG nào.

* Phương pháp đánh giá dựa trên "nugget", chia nhỏ các phản hồi thành những thông tin thực tế thiết yếu (nugget), sau đó đo lường mức độ hiệu quả mà hệ thống nắm bắt được các nugget này.

* Framework đánh giá hệ thống RAG qua 4 chỉ số cụ thể: phát hiện ảo giác (đo mức độ nội dung chứa thông tin bịa đặt không được nguồn hỗ trợ), đánh giá trích dẫn, auto nugget (đánh giá sự hiện diện của các nugget thông tin thiết yếu từ nguồn trong phản hồi), và UMBRELA (phương pháp toàn diện để đánh giá hiệu suất retriever).

* Sự đổi mới kỹ thuật của Open RAG Eval nằm ở việc sử dụng các mô hình ngôn ngữ lớn (LLM) và Python với kỹ thuật prompt phức tạp để tự động hóa quy trình đánh giá vốn đòi hỏi nhiều công sức thủ công trước đây.

* So với các framework đánh giá khác như Yourbench của Hugging Face hay Agentic Evaluations của Galileo, Open RAG Eval tập trung mạnh vào toàn bộ quy trình RAG, không chỉ là đầu ra của LLM, và có nền tảng học thuật vững chắc.

* Framework này được xây dựng dựa trên đóng góp trước đó của Vectara cho cộng đồng AI nguồn mở, bao gồm Hughes Hallucination Evaluation Model (HHEM), đã được tải xuống hơn 3.5 triệu lần.

* Jeff Hummel, phó chủ tịch cấp cao về sản phẩm và công nghệ tại công ty bất động sản Anywhere.re, kỳ vọng việc hợp tác với Vectara sẽ giúp công ty ông tinh giản quy trình đánh giá RAG và đưa ra các tính toán mở rộng quy mô có tính dự đoán cao hơn.

* Open RAG Eval giúp các nhà ra quyết định kỹ thuật trả lời các câu hỏi quan trọng về cấu hình RAG, như lựa chọn phương pháp chunking, loại tìm kiếm, LLM sử dụng, tối ưu hóa prompt và đặt ngưỡng phát hiện ảo giác.

📌 Framework nguồn mở Open RAG Eval do Vectara và đại học Waterloo phát triển, giúp đo lường khoa học hiệu suất RAG qua các chỉ số như phát hiện ảo giác và chất lượng trích dẫn, thay thế đánh giá chủ quan. Sử dụng LLM để tự động hóa, framework này hỗ trợ doanh nghiệp tối ưu hóa hệ thống AI bằng dữ liệu.

https://venturebeat.com/ai/the-rag-reality-check-new-open-source-framework-lets-enterprises-scientifically-measure-ai-performance/

- Meta vừa phát hành mô hình AI mới có tên Maverick, xếp hạng thứ hai trên LM Arena - một bài kiểm tra do con người đánh giá và so sánh đầu ra của các mô hình.

- Các nhà nghiên cứu AI phát hiện phiên bản Maverick trên LM Arena khác với phiên bản công khai dành cho nhà phát triển.

- Meta thừa nhận đã sử dụng "phiên bản trò chuyện thử nghiệm" của Maverick trên LM Arena.

- Trang web chính thức của Llama tiết lộ Meta đã sử dụng "Llama 4 Maverick được tối ưu hóa cho khả năng hội thoại" trong quá trình kiểm tra LM Arena.

- LM Arena vốn không phải thước đo đáng tin cậy nhất về hiệu suất của mô hình AI, nhưng các công ty AI thường không tùy chỉnh mô hình để đạt điểm cao hơn trên nền tảng này.

- Việc tối ưu hóa mô hình cho một benchmark cụ thể, giữ kín và sau đó phát hành phiên bản "vanilla" gây khó khăn cho nhà phát triển trong việc dự đoán hiệu suất thực tế của mô hình.

- Các nhà nghiên cứu nhận thấy sự khác biệt rõ rệt giữa phiên bản Maverick có thể tải xuống công khai và phiên bản trên LM Arena.

- Phiên bản LM Arena sử dụng nhiều emoji và đưa ra câu trả lời dài dòng hơn.

- Hành động này của Meta bị coi là gây hiểu lầm, vì các benchmark lẽ ra phải cung cấp bức tranh tổng quan về điểm mạnh và điểm yếu của một mô hình duy nhất trong nhiều tác vụ khác nhau.

📌 Meta gây tranh cãi khi sử dụng phiên bản tối ưu của Maverick trên LM Arena, khác biệt so với bản công khai. Điều này gây khó khăn cho việc đánh giá hiệu suất thực tế của mô hình và làm dấy lên câu hỏi về tính minh bạch trong cuộc đua AI.

https://techcrunch.com/2025/04/06/metas-benchmarks-for-its-new-ai-models-are-a-bit-misleading/

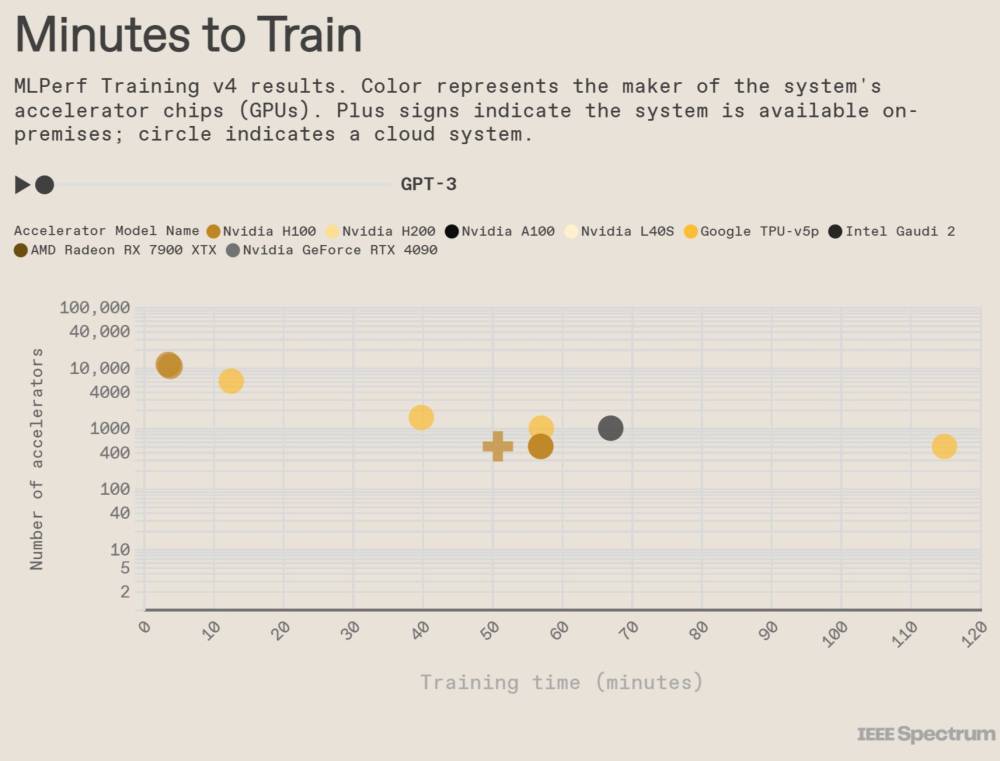

- Tổ chức MLCommons vừa công bố 2 tiêu chuẩn đánh giá mới giúp xác định tốc độ phần cứng và phần mềm hàng đầu có thể chạy các ứng dụng AI.

- Kể từ khi ChatGPT ra mắt hơn 2 năm trước, các công ty chip đã chuyển hướng tập trung vào việc sản xuất phần cứng có thể chạy hiệu quả mã nguồn cho phép hàng triệu người sử dụng công cụ AI.

- Tiêu chuẩn đánh giá đầu tiên dựa trên mô hình AI Llama 3.1 với 405 tỷ tham số của Meta, nhắm vào khả năng trả lời câu hỏi chung, toán học và tạo mã. Định dạng mới này kiểm tra khả năng xử lý truy vấn lớn và tổng hợp dữ liệu từ nhiều nguồn.

- Nvidia đã gửi nhiều loại chip của mình để đánh giá, cùng với các nhà sản xuất hệ thống như Dell Technologies. Theo dữ liệu từ MLCommons, Advanced Micro Devices (AMD) không có bài đánh giá nào cho tiêu chuẩn mô hình lớn 405 tỷ tham số.

- Máy chủ AI thế hệ mới nhất của Nvidia - Grace Blackwell, chứa 72 đơn vị xử lý đồ họa (GPU) - nhanh hơn 2,8 đến 3,4 lần so với thế hệ trước, ngay cả khi chỉ sử dụng 8 GPU trong máy chủ mới để tạo so sánh trực tiếp với mô hình cũ.

- Nvidia đang nỗ lực tăng tốc kết nối giữa các chip trong máy chủ, điều này đặc biệt quan trọng trong công việc AI khi chatbot chạy trên nhiều chip cùng lúc.

- Tiêu chuẩn đánh giá thứ hai cũng dựa trên mô hình AI nguồn mở do Meta xây dựng và nhằm mô phỏng chính xác hơn kỳ vọng về hiệu suất của các ứng dụng AI tiêu dùng như ChatGPT.

- Các tiêu chuẩn mới này được phát triển khi các mô hình cơ bản cần phải đáp ứng nhiều truy vấn hơn để cung cấp năng lượng cho các ứng dụng AI như chatbot và công cụ tìm kiếm.

📌 MLCommons đã phát triển 2 tiêu chuẩn đánh giá mới để đo lường tốc độ chạy ứng dụng AI, với máy chủ Grace Blackwell của Nvidia dẫn đầu, nhanh hơn 3,4 lần so với thế hệ trước. Các tiêu chuẩn này dựa trên mô hình Llama 3.1 405 tỷ tham số của Meta, giúp đánh giá khả năng xử lý truy vấn phức tạp.

https://www.reuters.com/technology/artificial-intelligence/new-ai-benchmarks-test-speed-running-ai-applications-2025-04-02/

- Đại học California, San Diego công bố nghiên cứu vào thứ Ba, cung cấp "bằng chứng thực nghiệm đầu tiên về việc một hệ thống nhân tạo có thể vượt qua bài kiểm tra Turing ba bên tiêu chuẩn".

- Alan Turing đề xuất "trò chơi bắt chước" năm 1950, cho rằng nếu người thẩm vấn không thể phân biệt giữa máy và người trong văn bản, máy có thể sở hữu trí thông minh giống con người.

- Nghiên cứu kiểm tra ba mô hình AI: GPT-4.5 của OpenAI, Llama 3.1 405B của Meta và GPT-4o của OpenAI trong các cuộc trò chuyện kéo dài 5 phút.

- Người tham gia sử dụng giao diện màn hình chia đôi để trò chuyện với một người thật và một hệ thống AI, sau đó chọn người mà họ tin là con người.

- Các mô hình AI được đánh giá trong hai điều kiện: lời nhắc tối thiểu (NO-PERSONA) và lời nhắc PERSONA nâng cao hướng dẫn AI thể hiện phong cách giống con người.

- GPT-4.5 với lời nhắc PERSONA đạt tỷ lệ thắng 73%, cho thấy người thẩm vấn thường nhầm lẫn nó với con người thật.

- Llama 3.1-405B với lời nhắc PERSONA đạt tỷ lệ thắng khoảng 56%, trong khi GPT-4o trong điều kiện NO-PERSONA chỉ đạt 21%.

- Người thẩm vấn chủ yếu tham gia trò chuyện nhỏ—hỏi về hoạt động hàng ngày và thông tin cá nhân (61% tương tác), đồng thời thăm dò các khía cạnh xã hội và cảm xúc như ý kiến, cảm xúc, hài hước và trải nghiệm (50% tương tác).

- Nghiên cứu kết luận: "Nếu người thẩm vấn không thể phân biệt đáng tin cậy giữa con người và máy móc, thì máy được coi là đã vượt qua [bài kiểm tra Turing]. Theo logic này, cả GPT-4.5 và Llama-3.1-405B đều vượt qua bài kiểm tra Turing khi được cung cấp lời nhắc để thể hiện tính cách giống con người."

- Các tác giả cho rằng những hệ thống này có thể bổ sung hoặc thậm chí thay thế lao động con người trong các vai trò kinh tế dựa trên trao đổi hội thoại ngắn.

- Các hệ thống này có thể trở thành "sự thay thế không thể phân biệt" cho các tương tác xã hội khác, từ trò chuyện với người lạ trực tuyến đến bạn bè, đồng nghiệp và thậm chí là bạn tình.

- OpenAI phát hành mô hình GPT-4.5 vào tháng 2, được đánh giá cao vì phản hồi sâu sắc và giàu cảm xúc.

- Ethan Mollick, giáo sư tại Trường Wharton, nhận xét trên X rằng mô hình "có thể viết đẹp, rất sáng tạo, và đôi khi lạ lùng lười biếng trong các dự án phức tạp" và đùa rằng mô hình đã học "nhiều hơn" các lớp nhân văn.

📌 Nghiên cứu của UC San Diego đã chứng minh GPT-4.5 và Llama-3.1-405B có thể vượt qua bài kiểm tra Turing với tỷ lệ thành công lần lượt là 73% và 56%, đánh dấu bước ngoặt quan trọng khi AI đạt khả năng giao tiếp không thể phân biệt với con người trong các cuộc trò chuyện ngắn.

https://analyticsindiamag.com/ai-news-updates/gpt-4-5-passes-the-turing-test-study/

-

Một nhân viên OpenAI đã cáo buộc xAI công bố kết quả điểm chuẩn gây hiểu nhầm về mô hình AI mới nhất Grok 3

-

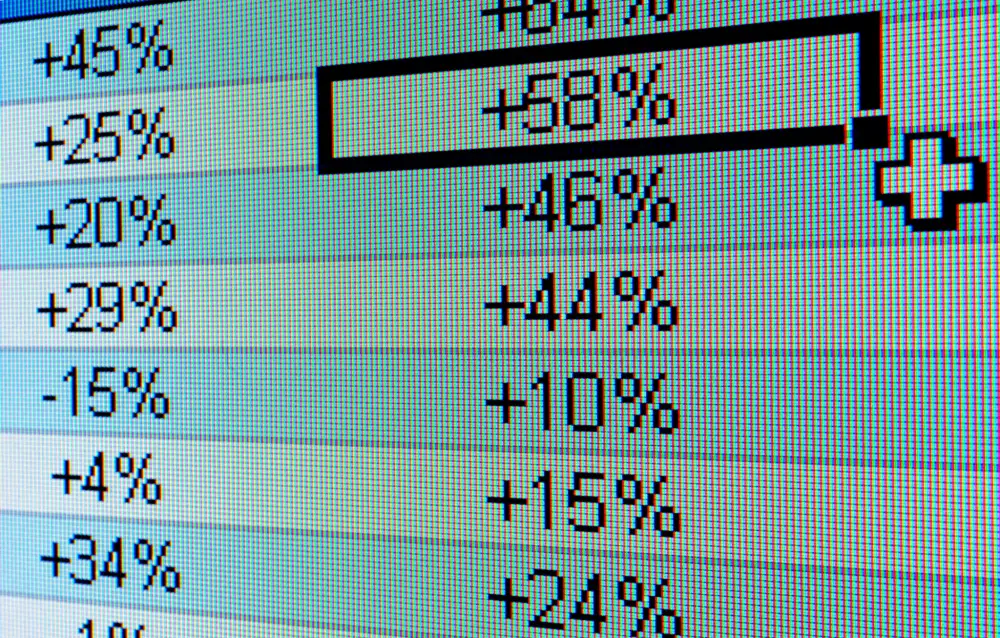

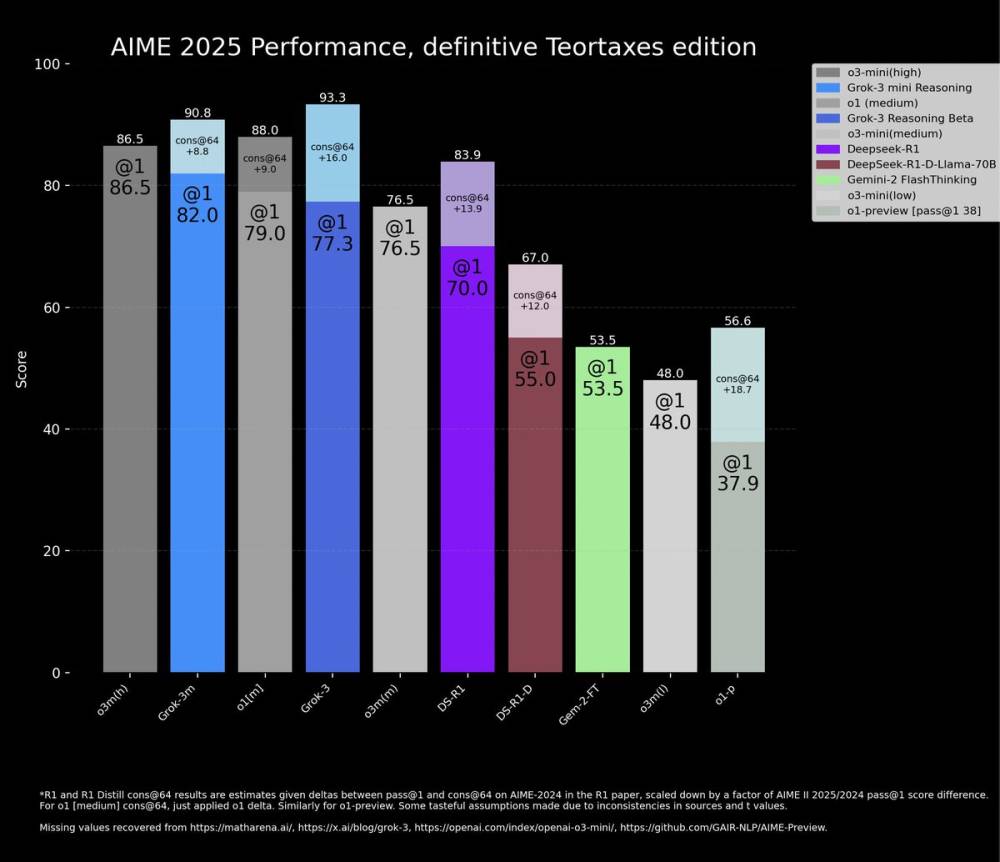

xAI đăng blog với biểu đồ cho thấy hai phiên bản Grok 3 (Grok 3 Reasoning Beta và Grok 3 mini Reasoning) vượt trội hơn mô hình tốt nhất của OpenAI (o3-mini-high) trong bài kiểm tra AIME 2025

-

Vấn đề nằm ở việc xAI đã bỏ qua điểm số "cons@64" của o3-mini-high trong biểu đồ so sánh

-

Cons@64 (consensus@64) cho phép mô hình 64 lần thử để trả lời mỗi câu hỏi và lấy câu trả lời xuất hiện nhiều nhất làm kết quả cuối cùng

-

Ở chế độ "@1" (lần thử đầu tiên), điểm số của cả Grok 3 Reasoning Beta và Grok 3 mini Reasoning đều thấp hơn o3-mini-high

-

Grok 3 Reasoning Beta cũng thua kém một chút so với mô hình o1 của OpenAI ở cài đặt "medium computing"

-

Igor Babushkin, đồng sáng lập xAI, phản bác rằng OpenAI cũng từng công bố biểu đồ điểm chuẩn gây hiểu nhầm tương tự khi so sánh giữa các mô hình của họ

-

Nhà nghiên cứu AI Nathan Lambert chỉ ra rằng thông số quan trọng nhất vẫn chưa được tiết lộ: chi phí tính toán và tài chính để đạt được điểm số tốt nhất

📌 Cuộc tranh cãi về điểm chuẩn Grok 3 cho thấy sự thiếu minh bạch trong việc công bố kết quả đánh giá AI. Mặc dù xAI quảng cáo Grok 3 là "AI thông minh nhất thế giới", điểm số thực tế ở lần thử đầu tiên lại thấp hơn mô hình o3-mini-high của OpenAI.

https://techcrunch.com/2025/02/22/did-xai-lie-about-grok-3s-benchmarks/

- Chatbot Arena được tạo ra đầu năm 2023 bởi Sky Computing Lab thuộc Đại học California Berkeley, hiện thu hút 1 triệu lượt truy cập mỗi tháng

- Nền tảng này cho phép người dùng thử nghiệm và bình chọn các mô hình AI, tạo ra bảng xếp hạng dựa trên hệ thống tính điểm Elo như trong cờ vua

- DeepSeek đã thử nghiệm nhiều mô hình trên Chatbot Arena trước khi gây tiếng vang toàn cầu. Mô hình R1 của họ đã vươn lên vị trí thứ 3, vượt qua o1 của OpenAI

- Người dùng đã thực hiện hơn 2,6 triệu lượt bình chọn trên nền tảng. Các câu hỏi phổ biến tập trung vào lập trình máy tính và viết sáng tạo

- Nền tảng đã thử nghiệm hơn 200 mô hình từ các công ty lớn như Anthropic, Google, Meta, OpenAI và xAI, với 90 mô hình vẫn đang hoạt động

- Wei-Lin Chiang và Anastasios Angelopoulos - hai nhà nghiên cứu sau tiến sĩ tại Berkeley điều hành dự án với sự hỗ trợ từ sinh viên và tài trợ của Andreessen Horowitz và Sequoia Capital

- Nền tảng này là nguồn mở, cho phép truy cập mã nguồn và dữ liệu. Các công ty phải trả phí cho việc người dùng thử nghiệm mô hình của họ

- Một số lo ngại về khả năng gian lận điểm số đã được nêu ra trong một nghiên cứu gần đây, nhưng đội ngũ phát triển khẳng định có nhiều biện pháp bảo vệ

📌 Chatbot Arena đã chứng minh vai trò quan trọng trong việc đánh giá các mô hình AI với 2,6 triệu lượt bình chọn và 200 mô hình được thử nghiệm. Nền tảng này đã dự đoán chính xác sự thành công của DeepSeek trước khi công ty này gây chấn động thị trường công nghệ toàn cầu.

https://www.bloomberg.com/news/articles/2025-02-18/before-deepseek-blew-up-one-website-announced-its-arrival

Trước khi DeepSeek bùng nổ, Chatbot Arena đã báo trước sự xuất hiện của nó

Một hệ thống xếp hạng chatbot dựa trên đóng góp cộng đồng đã trở thành cách để giới chuyên gia AI tìm ra mô hình nào hoạt động tốt nhất.

Tác giả: Rachel Metz

Ngày 18 tháng 2 năm 2025, 11:00 AM UTC

Với phần lớn thế giới, DeepSeek dường như bùng nổ từ hư không vào tháng 1 với phần mềm AI mã nguồn mở có khả năng cạnh tranh với các mô hình của OpenAI và Google—và được cho là được xây dựng với chi phí chỉ bằng một phần nhỏ so với các đối thủ.

Tuy nhiên, đối với những người hâm mộ một trang web có tên Chatbot Arena, đó chỉ là một khoảnh khắc “biết ngay mà”: họ đã theo dõi—và đánh giá—sự phát triển của các mô hình từ công ty Trung Quốc đứng sau DeepSeek trong nhiều tháng qua.

Chatbot Arena ra mắt vào đầu năm 2023 giữa cơn sốt AI sau khi OpenAI phát hành ChatGPT chỉ vài tháng trước đó. Được tạo ra như một dự án nghiên cứu bởi Phòng thí nghiệm Sky Computing của Đại học California tại Berkeley, trang web này lưu trữ hàng loạt mô hình AI tiên tiến. Khách truy cập sử dụng các chatbot được vận hành bởi những mô hình đó và bỏ phiếu để đẩy chúng lên hoặc xuống bảng xếp hạng tùy theo hiệu suất mà họ đánh giá.

“Một bên thứ ba độc lập, có động lực đo lường trung thực tiến bộ trong lĩnh vực AI, sẽ là yếu tố quan trọng,” Wei-Lin Chiang, một trong những người đứng đầu Chatbot Arena và là nhà nghiên cứu sau tiến sĩ tại UC Berkeley, cho biết. “Ai cũng nói mô hình của mình là tốt nhất. Vì vậy, tính minh bạch và sự độc lập đóng vai trò rất lớn.”

Chatbot Arena nhanh chóng trở thành điểm đến phổ biến của những người tiên phong trong lĩnh vực AI và là một chỉ báo hàng đầu trong lĩnh vực đánh giá mô hình AI đang phát triển nhanh chóng: trang web thu hút 1 triệu lượt truy cập mỗi tháng. Cả các công ty AI hàng đầu lẫn những startup mã nguồn mở đầy triển vọng đều tìm đến đây để kiểm tra các mô hình mới. Một số công ty thậm chí còn đăng tải mô hình của mình lên trước khi phát hành rộng rãi (như OpenAI đã làm với GPT-4o vào mùa xuân năm ngoái).

Trước khi DeepSeek bùng nổ, Chatbot Arena đã báo trước sự xuất hiện của nó

Một hệ thống xếp hạng chatbot dựa trên đóng góp cộng đồng đã trở thành cách để giới chuyên gia AI tìm ra mô hình nào hoạt động tốt nhất.

Khi mọi thứ diễn ra suôn sẻ, đó không chỉ là một niềm tự hào mà, như DeepSeek đã cho thấy, còn mang lại cả danh tiếng quốc tế. Người dùng Chatbot Arena đã thử nghiệm nhiều mô hình mã nguồn mở của DeepSeek, và mỗi mô hình sau đều đạt thứ hạng cao hơn trên bảng xếp hạng chính của trang web so với mô hình trước đó. Những sản phẩm mới nhất của công ty là V3—một mô hình ngôn ngữ lớn tương tự như mô hình vận hành ChatGPT—và R1, mô hình tập trung tính toán câu trả lời lâu hơn trước khi phản hồi. Cả hai lần lượt xuất hiện trên Chatbot Arena vào cuối tháng 12 và tháng 1, nhanh chóng leo lên thứ hạng cao.

Chỉ vài ngày sau khi ra mắt, vào một ngày thứ Sáu, R1 nhảy lên vị trí thứ ba, vượt qua o1—một mô hình suy luận tương tự của OpenAI. Ứng dụng chatbot của DeepSeek bắt đầu dẫn đầu bảng xếp hạng trên các kho ứng dụng di động, bao gồm cả App Store của Apple tại Mỹ vào cuối tuần đó và Google Play Store vài ngày sau. Những nhân vật nổi bật như nhà đầu tư mạo hiểm Marc Andreessen và CEO OpenAI Sam Altman đã dành lời khen ngợi cho nó. Vào thứ Hai, các nhà đầu tư đã xóa gần 1 nghìn tỷ USD khỏi giá trị vốn hóa của các công ty công nghệ Mỹ và châu Âu, khi DeepSeek đặt ra câu hỏi liệu ngành công nghệ có đang chi tiêu quá mức cho hạ tầng AI hay không.

Những người đứng đầu Chatbot Arena, Chiang và Anastasios Angelopoulos—cũng là một nhà nghiên cứu sau tiến sĩ tại UC Berkeley—không mấy ngạc nhiên. “Thực ra, không quá bất ngờ khi một mô hình như thế này đạt đến đỉnh,” Angelopoulos nói. “Hệ sinh thái sẽ tiếp tục phát triển. Chỉ một tháng nữa thôi, cái tên dẫn đầu sẽ không còn là DeepSeek-R1 mà là một mô hình khác.”

Chatbot Arena không phải là dự án duy nhất cung cấp các tiêu chuẩn đánh giá AI công khai. Những sáng kiến như SWE-Bench hay Humanity’s Last Exam đánh giá hiệu suất của các mô hình AI tiên tiến trên nhiều nhiệm vụ khác nhau, chẳng hạn như trả lời câu hỏi toán học, lập trình hoặc giải các bài toán khó nhất mà con người biết đến. Tuy nhiên, hiện chưa có nhiều tiêu chuẩn chung và không có tổ chức chính thức nào giám sát phương pháp kiểm tra các mô hình này. Sự phát triển trong lĩnh vực này cũng diễn ra quá nhanh, đến mức các mô hình mới có thể nhanh chóng khiến những bài đánh giá hiện tại trở nên lỗi thời. (Nhớ bài kiểm tra Turing chứ?)

Chatbot Arena đánh giá trải nghiệm thực tế khi sử dụng từng sản phẩm. “Có thể gọi là ‘cảm nhận’, nhưng một cách khác để diễn đạt là thử nghiệm trong tình huống sử dụng thực tế,” Chiang nói. “Nếu bạn là OpenAI và đang xây dựng ChatGPT, bạn quan tâm đến trải nghiệm của người dùng.”

Tính đến đầu tháng 2, Chatbot Arena đã lưu trữ hơn 200 mô hình, bao gồm các mô hình từ Anthropic, Google, Meta Platforms, OpenAI và xAI, trong đó có 90 mô hình vẫn đang mở để người dùng thử nghiệm. Các công ty thường hợp tác với Chatbot Arena để đưa mô hình của họ lên trang web, sau đó chi trả chi phí phát sinh từ việc người dùng sử dụng chúng. Trang web này là mã nguồn mở, với dữ liệu và mã nguồn được cung cấp để người khác sử dụng, và nhận hỗ trợ từ một số khoản tài trợ bên ngoài, bao gồm từ các quỹ đầu tư mạo hiểm như Andreessen Horowitz và Sequoia Capital. Vì đây là một dự án nghiên cứu học thuật, phần lớn công việc duy trì Chatbot Arena do sinh viên UC Berkeley thực hiện.

Khi truy cập trang web, người dùng sẽ thấy một cửa sổ bật lên cảnh báo rằng đây là một dự án nghiên cứu. Họ được hướng dẫn đặt câu hỏi cho hai chatbot ẩn danh, sau đó chọn chatbot họ thích hơn. Sau khi bỏ phiếu, tên của mỗi chatbot sẽ được tiết lộ. Những phiếu bầu này được sử dụng để tạo xếp hạng, nhằm ước tính độ mạnh của từng mô hình; hệ thống này là một biến thể của hệ thống Elo trong cờ vua, vốn đánh giá sức mạnh dựa trên kết quả đối đầu trực tiếp.

Tính đến nay, người dùng đã ghi nhận hơn 2,6 triệu lượt bình chọn cho các mô hình ngôn ngữ yêu thích. Họ không cần đăng nhập, nên nhóm Chatbot Arena không biết về từng cá nhân cụ thể. Tuy nhiên, họ có phân loại tổng quan về loại câu hỏi mà người dùng thường đưa ra. Những câu hỏi về lập trình máy tính và viết sáng tạo đặc biệt phổ biến, với các đề bài ví dụ như: “Viết một bài thơ theo dạng cặp câu, sử dụng ngắt dòng để tạo cảm giác chuyển động và hồi hộp; chủ đề là quả táo.”

Xếp hạng của Chatbot Arena mang lại cảm giác khách quan tuyệt đối. Nhưng thực tế, nó chỉ đo lường một khía cạnh cụ thể: phản ứng của khán giả Chatbot Arena—những người dường như nghiêng về nhóm có tư duy học thuật, quan tâm đến các chủ đề như học máy. “Hệ thống xếp hạng này rất hay, và chúng tôi cũng thích gửi mô hình của mình vào, nhưng nó không thực sự phản ánh rằng ‘Mô hình này có phù hợp để làm việc không? Có dễ dàng để doanh nghiệp ứng dụng không?’” Nick Frosst, đồng sáng lập Cohere—công ty chuyên phát triển và tùy chỉnh mô hình AI cho doanh nghiệp—nhận xét.

Cũng có một số lo ngại về khả năng thao túng xếp hạng. Trong một bài nghiên cứu gần đây đăng trên Arxiv—một kho lưu trữ nghiên cứu mở chưa qua bình duyệt—các nhà nghiên cứu đã mô phỏng cách gian lận phiếu bầu để chỉ ra những lỗ hổng tiềm ẩn trên Chatbot Arena. Angelopoulos và Chiang cho biết trang web có nhiều cơ chế bảo vệ để ngăn chặn hành vi sử dụng sai mục đích. “Chúng tôi chưa thấy bằng chứng nào về một cuộc tấn công thành công vào hệ thống,” Angelopoulos nói.

Chiang, Angelopoulos và cộng sự đang tập trung cải thiện cộng đồng Chatbot Arena, đồng thời mở rộng các loại bài kiểm tra họ thực hiện. Họ đã bắt đầu hỗ trợ thử nghiệm các mô hình AI khác, bao gồm cả trình tạo hình ảnh. Với sự quan tâm ngày càng lớn, nhóm nghiên cứu cũng không loại trừ khả năng biến dự án này thành một mô hình kinh doanh thực sự. “Chúng tôi chắc chắn đang cân nhắc điều đó,” Chiang nói.

Before DeepSeek Blew Up, Chatbot Arena Announced Its Arrival

A crowdsourced rating system for chatbots has become the way AI insiders learn which models work best.

By Rachel Metz

February 18, 2025 at 11:00 AM UTC

For most of the world, DeepSeek seemed to explode out of nowhere in January with open-source artificial intelligence software that rivaled models from OpenAI and Google—and was built, purportedly, at a fraction of the cost of competitors’ models.

For fans of a website called Chatbot Arena, however, it was a bit of an eye-roll moment: They’d been watching—and rating—the progression of models from the Chinese company behind DeepSeek for months.

Chatbot Arena started in early 2023 amid the frenzy that followed OpenAI’s release of ChatGPT just months before. Created as a research project by the University of California at Berkeley’s Sky Computing Lab, the site hosts a slew of cutting-edge AI models. Visitors use chatbots powered by those models and push them up or down the leaderboards by voting on how they think they perform. An “independent third party with the incentive of truthfully measuring progress in the AI space will be critical,” says Wei-Lin Chiang, a leader of Chatbot Arena and a postdoctoral researcher at UC Berkeley. “Everybody says their model is the best. So transparency and independence help a lot.”

Chatbot Arena soon became a popular spot for early adopters and a leading indicator in the rapidly evolving field of AI benchmarking: It gets a million visitors per month. Top AI companies and open-source up-and-comers alike come to test out their new models. Some companies even post models before they release them generally (as OpenAI did with its GPT-4o last spring).

When things go well, it’s a source of bragging rights and, as DeepSeek showed, even some international notoriety. Chatbot Arena users have tested several of its open-source models, with each one rising higher on the site’s main leaderboard than the last. The company’s most recent offerings are V3, a large language model similar to the one that powers ChatGPT, and R1, which spends more time computing a response before spitting it out. They hit Chatbot Arena in late December and January, respectively, and climbed the ranks quickly.

Days after its release, on a Friday, R1 jumped to the third-place spot, besting o1, OpenAI’s similar reasoning-like model. DeepSeek’s chatbot app began topping the charts in mobile app stores, including in Apple Inc.’s US App Store that weekend and the Google Play Store a few days later. Prominent figures including venture capitalist Marc Andreessen and OpenAI Chief Executive Officer Sam Altman praised it. That Monday investors erased almost $1 trillion from the value of US and European technology stocks, as DeepSeek raised the possibility that the tech industry had vastly overspent on AI infrastructure.

The leaders of Chatbot Arena, Chiang and Anastasios Angelopoulos, also a postdoc at UC Berkeley, were nonplussed. “It’s honestly not super surprising that we see a model like this reach the top,” Angelopoulos says. “The ecosystem will continue evolving. In a month it’s not going to be DeepSeek-R1, it’s going to be a different model.”

Chatbot Arena isn’t the only project to provide publicly available AI benchmarks. Efforts like SWE-Bench or Humanity’s Last Exam assess how well cutting-edge AI models perform on various tasks, such as answering math or coding questions, or solving some of the hardest problems known to humans. There isn’t much standardization, and no official group oversees the methods by which the models are tested. Progress in the field is also so rapid that new models may quickly make existing assessments seem out-of-date. (Remember the Turing test?)

Chatbot Arena gauges how it actually feels to use each product. “Vibes is one way to put it; another way to put it is real-world use-case testing,” Chiang says. “If you’re OpenAI building ChatGPT, you care about your users.”

As of early February, Chatbot Arena had hosted more than 200 models in total, including those from Anthropic, Google, Meta Platforms, OpenAI and xAI, with 90 of them still available for users to try. Companies typically work with Chatbot Arena to get their models on the site, then pay for the costs incurred by users probing them. The site is open source, with its data and code available for others to use, and is supported by some outside grants, such as from venture capital firms Andreessen Horowitz and Sequoia Capital. Because it’s an academic research project, UC Berkeley students are mostly the ones who keep Chatbot Arena running.

Visitors are greeted by a pop-up warning that the site is a research project. They’re instructed to pose a question to two anonymous chatbots, then pick the one they like best. After voting, the name of each chatbot is revealed. Those votes are used to help create a rating that estimates the strength of each model; it’s a variation of the Elo system for chess, which assigns ratings based on the outcomes of head-to-head competitions.

Users have logged more than 2.6 million votes for their favorite language models so far. They don’t log in, so Chatbot Arena’s team members don’t know about individual users. They do categorize, generally, what kinds of prompts users like to offer the chatbots, though. Questions about computer programming and creative writing are especially popular, with example prompts such as “Write a poem in couplets that uses line breaks to create a feeling of movement and suspense; it should be about apples.”

Chatbot Arena rankings have an aura of definitiveness. In fact, they’re measuring something very specific: the reaction of Chatbot Arena’s audience (a population that appears to skew toward academically minded folks interested in topics such as machine learning). The ranking system is “really cool, and we like to submit to it, but it doesn’t really represent ‘Is this model good to work with? Is it easy for an enterprise to adopt?’” says Nick Frosst, co-founder of Cohere, which makes AI models and customizes them for businesses.

There are also some concerns about the potential for ratings to be manipulated. In a recent paper posted on Arxiv, an openly accessible archive of studies that aren’t peer-reviewed, researchers simulated vote-rigging to point out possible vulnerabilities on Chatbot Arena. Angelopoulos and Chiang say the site has a number of protections in place to guard against malicious use. They haven’t seen evidence of a successful attack against the site, Angelopoulos says.

Chiang, Angelopoulos and their collaborators are focused on how to improve the Chatbot Arena community, while also expanding the types of testing they do. They’ve begun to support other types of AI models, including image generators. Given the attention they’ve gotten, the researchers are also not ruling out the possibility that there’s a business to be had here. “Definitely, we are thinking about it,” Chiang says.

- Bộ Tài chính Úc tiến hành thử nghiệm Microsoft 365 Copilot trong 14 tuần với 218 tình nguyện viên tham gia

Sau thử nghiệm, đánh giá của người dùng về mức độ hữu ích của Copilot thấp hơn kỳ vọng ban đầu do:

- Số lượng công việc có thể áp dụng ít hơn dự kiến

- Tần suất sử dụng thấp, chỉ 2-3 lần/tuần

- Không phù hợp với các tác vụ phức tạp

Copilot thể hiện hiệu quả tốt trong các công việc cơ bản:

- Tìm kiếm và tóm tắt thông tin

- Tạo biên bản cuộc họp

- Quản lý kiến thức

- Soạn thảo nội dung

Phân tích ROI cho thấy chỉ cần tiết kiệm 13 phút/tuần cho nhân viên cấp trung là đã hoà vốn đầu tư

Lợi ích bất ngờ từ Copilot:

- Hỗ trợ nhân viên đa dạng thần kinh (neurodivergent) và bán thời gian

- Giúp người nghỉ ốm cập nhật thông tin

- Tăng sự tự tin cho nhân viên mới/cấp thấp

Các vấn đề cần cải thiện:

- Cần đào tạo kỹ hơn về cách sử dụng AI

- Lựa chọn nhân sự phù hợp để sử dụng

- Theo dõi liên tục tác động của AI

- Đảm bảo an ninh dữ liệu chính phủ

📌 Thử nghiệm Copilot tại Bộ Tài chính Úc cho thấy ROI tích cực khi chỉ cần tiết kiệm 13 phút/tuần. Tuy nhiên, công cụ chỉ phù hợp với tác vụ hành chính cơ bản và cần cải thiện về bảo mật, đào tạo để đáp ứng yêu cầu của cơ quan chính phủ.

https://www.theregister.com/2025/02/12/australian_treasury_copilot_pilot_assessment/

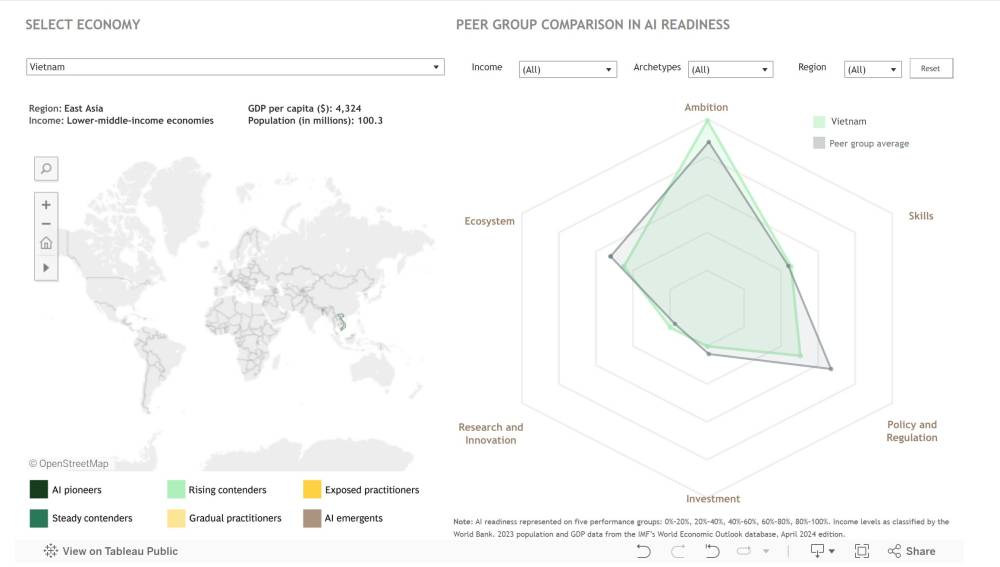

• Theo nghiên cứu mới từ Boston Consulting Group (BCG), hơn 70% nền kinh tế thế giới chưa sẵn sàng cho cuộc cách mạng công nghệ AI.

• Ma trận đánh giá mức độ trưởng thành AI của BCG đã phân tích 73 nền kinh tế toàn cầu, phân loại thành 6 nhóm dựa trên mức độ dễ bị tổn thương và khả năng thích ứng với AI.

• Chỉ có 5 nền kinh tế được xem là lãnh đạo về AI: Canada, Trung Quốc đại lục, Singapore, Anh và Mỹ. Các quốc gia này thể hiện sự đầu tư mạnh mẽ vào R&D, nguồn nhân lực dồi dào và hệ sinh thái AI phát triển.

• Luxembourg và Hong Kong đang đối mặt với nguy cơ bị gián đoạn đáng kể trong các lĩnh vực như dịch vụ tài chính và bán lẻ do thiếu sự sẵn sàng cần thiết để thích ứng.

• Chỉ số ASPIRE của BCG đánh giá 6 khía cạnh quan trọng cho chiến lược AI: tham vọng, kỹ năng, chính sách, đầu tư, nghiên cứu và hệ sinh thái.

• Trung Quốc đại lục dẫn đầu về số lượng bằng sáng chế và nghiên cứu học thuật, trong khi Mỹ và Singapore thống trị về phát triển nhân tài và đầu tư.

• Nhiều nền kinh tế có điểm số thấp trong R&D và phát triển hệ sinh thái, với khả năng tích hợp AI hạn chế.

• Ba sáng kiến chiến lược được đề xuất:

- Kích hoạt AI: Xây dựng năng lực nền tảng cho các nền kinh tế mới nổi

- Đẩy nhanh AI: Tăng cường chính sách và đầu tư cho các nền kinh tế trung bình

- Khuếch đại AI: Dẫn dắt đổi mới toàn cầu và định hình chính sách AI cho các quốc gia tiên phong.

📌 Khoảng cách về mức độ sẵn sàng AI giữa các nền kinh tế ngày càng rõ rệt, với chỉ 5/73 quốc gia dẫn đầu. Các nền kinh tế cần hành động nhanh chóng thông qua đầu tư vào giáo dục, R&D và cơ sở hạ tầng để không bị tụt hậu trong thế giới được định hình bởi AI.

https://www.eweek.com/news/ai-economic-disruption-nations-unprepared/

• Các tiêu chuẩn đánh giá hiệu suất mô hình AI hiện tại đang bộc lộ nhiều điểm yếu nghiêm trọng về thiết kế, khó tái tạo kết quả và các chỉ số đo lường thiếu chính xác

• Nghiên cứu mới chỉ ra rằng các công ty AI thường trích dẫn điểm chuẩn như minh chứng cho sự thành công của mô hình mới, nhưng những tiêu chuẩn này chưa đủ độ tin cậy để sử dụng trong quản lý

• Các nhà nghiên cứu đã huấn luyện AI agent để sao chép chính xác tính cách của 1.000 người, mở ra lo ngại về đạo đức khi các công cụ này trở nên phổ biến

• Donald Trump cam kết áp thuế đặc biệt với Trung Quốc, Canada và Mexico nhằm ngăn chặn buôn lậu ma túy và nhập cư bất hợp pháp vào Mỹ

• Amazon đang nỗ lực cạnh tranh với Nvidia bằng cách phát triển chip AI riêng, dự kiến hoàn thiện vào cuối năm 2024

• Neuralink sẽ thử nghiệm khả năng điều khiển cánh tay robot thông qua cấy ghép não đầu tiên không dây

• Google âm thầm nghiên cứu năng lượng hạt nhân trong nhiều năm qua

• Mô hình AI mới của Nvidia có thể tạo ra âm thanh hoàn toàn mới như saxophone gào thét hay đàn cello giận dữ

• Các nhà khoa học phát hiện nguyên nhân có thể gây ra tín hiệu radio bí ẩn từ vũ trụ: tiểu hành tinh và sao chổi va chạm với sao neutron

📌 Các tiêu chuẩn đánh giá AI hiện tại còn nhiều hạn chế nghiêm trọng. Donald Trump cam kết áp thuế mới với 3 nước láng giềng. Công nghệ mới từ các "ông lớn" như Amazon, Neuralink và Nvidia đang định hình tương lai của AI, robot và âm nhạc.

https://www.technologyreview.com/2024/11/26/1107361/the-download-rethinking-ai-benchmarks-and-the-ethics-of-ai-agents/

- FrontierMath là một tiêu chuẩn mới, bao gồm các bài toán toán học khó khăn do hơn 60 nhà toán học từ các trường đại học danh tiếng như MIT và Harvard thiết kế.

- Các bài toán được chọn lọc từ nhiều nhánh của toán học hiện đại, bao gồm lý thuyết số và hình học đại số, chiếm 70% các chủ đề hàng đầu trong phân loại toán học MSC2020.

- Mặc dù AI đã có những tiến bộ đáng kể, nhưng các mô hình hiện tại chỉ giải quyết được dưới 2% bài toán trong FrontierMath, cho thấy một khoảng cách lớn giữa AI và năng lực của con người.

- Các bài toán trong FrontierMath được thiết kế khó khăn, yêu cầu hàng giờ hoặc hàng ngày làm việc từ các nhà toán học chuyên nghiệp, nhằm phản ánh thực tế nghiên cứu trong lĩnh vực toán học.

- Tiêu chuẩn này khắc phục những hạn chế của các bộ dữ liệu trước đó như GSM8K và MATH, tập trung vào những bài toán nghiên cứu thay vì chỉ các câu hỏi cấp trung học và đại học.

- FrontierMath cung cấp một khung đánh giá tự động hóa, cho phép xác minh các câu trả lời mà không cần can thiệp của con người, sử dụng Python và thư viện SymPy để đảm bảo tính chính xác và khả năng tái sản xuất.

- Để đảm bảo tính công bằng, các bài toán được thiết kế “không thể đoán” với các câu hỏi phức tạp, điều này làm giảm khả năng thành công từ việc đoán mò.

- Các mô hình AI như GPT-4 và Claude 3.5 Sonnet đã được đánh giá trên FrontierMath nhưng không có mô hình nào giải quyết được 2% bài toán, cho thấy một thách thức lớn trong việc phát triển khả năng lý luận của AI.

- FrontierMath không chỉ là công cụ đánh giá mà còn là bản đồ giúp các nhà nghiên cứu AI xác định điểm yếu và cải thiện khả năng lý luận và giải quyết vấn đề của các hệ thống AI trong tương lai.

📌 FrontierMath là một bước tiến quan trọng trong việc đánh giá AI, cho thấy rằng AI vẫn còn xa mới đạt được khả năng lý luận của con người trong toán học nâng cao. Các mô hình hiện tại chỉ giải quyết được dưới 2% bài toán trong tiêu chuẩn này, mở ra cơ hội cho nghiên cứu và cải tiến tiếp theo.

https://www.marktechpost.com/2024/11/08/frontiermath-the-benchmark-that-highlights-ais-limits-in-mathematics/

- SimpleQA là một chuẩn mực mới nhằm đo lường khả năng cung cấp câu trả lời chính xác của các mô hình ngôn ngữ.

- Vấn đề "ảo giác" trong AI khiến nhiều mô hình thường đưa ra thông tin sai lệch hoặc không có cơ sở.

- Mục tiêu của SimpleQA là tạo ra một tập dữ liệu với độ chính xác cao, bao gồm 4.326 câu hỏi thuộc nhiều lĩnh vực khác nhau như khoa học, công nghệ, thể thao và giải trí.

- Các câu hỏi trong SimpleQA được thiết kế để có một câu trả lời duy nhất, dễ dàng chấm điểm và không thay đổi theo thời gian.

- Tập dữ liệu được xây dựng bởi 2 huấn luyện viên AI độc lập để đảm bảo tính chính xác và sự đồng thuận trong câu trả lời.

- Một huấn luyện viên thứ 3 đã kiểm tra ngẫu nhiên 1.000 câu hỏi và đạt tỷ lệ đồng thuận 94.4%, cho thấy chất lượng cao của tập dữ liệu.

- SimpleQA được thiết kế để thách thức các mô hình tiên tiến như GPT-4o, với tỷ lệ đúng dưới 40% cho các mô hình này.

- Đánh giá được thực hiện bằng cách sử dụng một bộ phân loại ChatGPT để phân loại câu trả lời thành "đúng", "sai" hoặc "không thử".

- Kết quả cho thấy các mô hình lớn hơn như GPT-4o có độ chính xác cao hơn so với các phiên bản nhỏ hơn như GPT-4o-mini.

- Độ tin cậy của các mô hình cũng được đo lường thông qua việc yêu cầu chúng đưa ra mức độ tự tin về câu trả lời của mình.

- Một nghiên cứu cho thấy rằng o1-preview có độ tin cậy cao hơn so với o1-mini và GPT-4o-mini.

- SimpleQA chỉ tập trung vào các câu hỏi ngắn, điều này đặt ra câu hỏi liệu khả năng cung cấp câu trả lời chính xác có tương quan với khả năng viết các phản hồi dài hơn hay không.

📌 SimpleQA là chuẩn mực mới do OpenAI đề xuất để đánh giá khả năng cung cấp thông tin chính xác của AI với 4.326 câu hỏi thuộc nhiều lĩnh vực khác nhau. Tỷ lệ đồng thuận giữa các huấn luyện viên AI đạt 94.4%, cho thấy chất lượng cao của tập dữ liệu này.

https://openai.com/index/introducing-simpleqa/

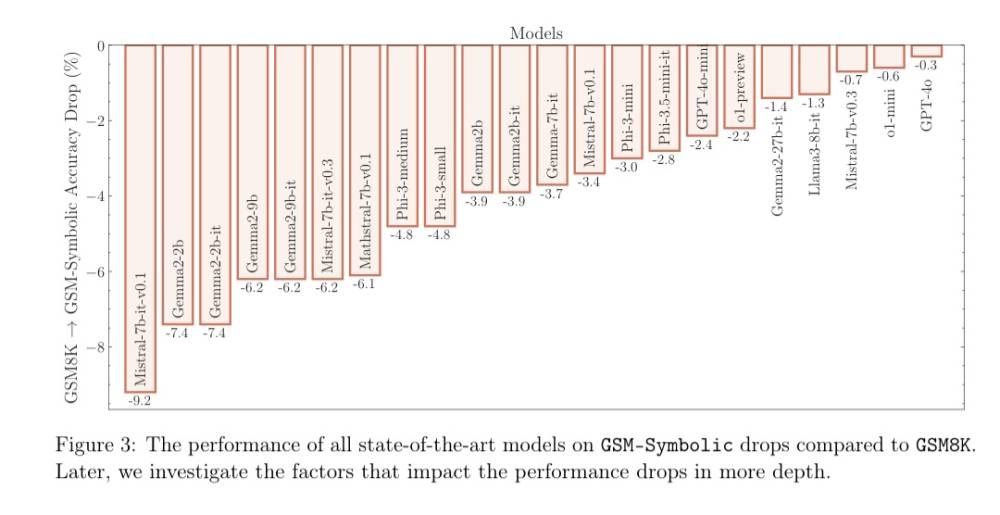

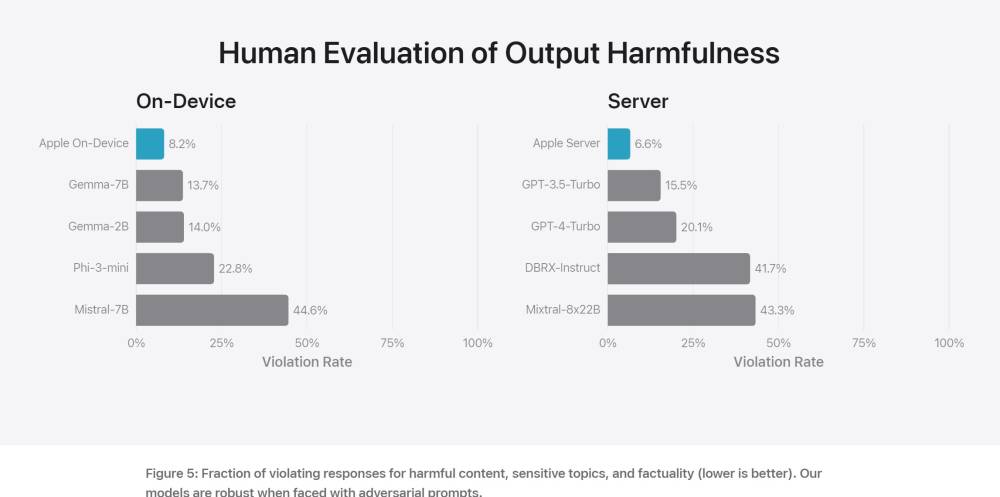

• Apple vừa công bố một nghiên cứu mới chỉ ra rằng các mô hình AI dựa trên LLM như của Meta và OpenAI vẫn thiếu kỹ năng suy luận cơ bản.

• Nhóm nghiên cứu đề xuất một tiêu chuẩn đánh giá mới có tên GSM-Symbolic để đo lường khả năng suy luận của các mô hình LLM.

• Kết quả thử nghiệm ban đầu cho thấy chỉ cần thay đổi nhỏ trong cách diễn đạt câu hỏi có thể dẫn đến các câu trả lời khác nhau đáng kể, làm suy giảm độ tin cậy của các mô hình.

• Nghiên cứu tập trung vào tính "mong manh" của suy luận toán học bằng cách thêm thông tin ngữ cảnh vào câu hỏi mà con người có thể hiểu, nhưng không nên ảnh hưởng đến phép toán cơ bản của lời giải.

• Kết quả cho thấy hiệu suất của tất cả các mô hình đều giảm khi chỉ thay đổi các giá trị số trong câu hỏi trong tiêu chuẩn GSM-Symbolic.

• Việc thêm chỉ một câu có vẻ cung cấp thông tin liên quan vào một bài toán có thể làm giảm độ chính xác của câu trả lời cuối cùng tới 65%.

• Nghiên cứu kết luận rằng không thể xây dựng các tác nhân đáng tin cậy trên nền tảng này, khi chỉ cần thay đổi một vài từ hoặc thêm một chút thông tin không liên quan có thể cho ra câu trả lời khác.

• Một ví dụ minh họa vấn đề là bài toán yêu cầu hiểu thực sự về câu hỏi. Nhiệm vụ được gọi là "GSM-NoOp" tương tự như các bài toán đố mà học sinh tiểu học có thể gặp.

• Câu hỏi bắt đầu với thông tin cần thiết để đưa ra kết quả, sau đó thêm một mệnh đề có vẻ liên quan nhưng thực tế không ảnh hưởng đến câu trả lời cuối cùng.

• Mô hình của OpenAI và Llama3-8b của Meta đã trừ 5 quả kiwi nhỏ hơn khỏi tổng số, mặc dù điều này không nên ảnh hưởng đến kết quả.

• Nghiên cứu kết luận không tìm thấy bằng chứng về suy luận chính thức trong các mô hình ngôn ngữ. Hành vi của LLM được giải thích tốt hơn bằng "khớp mẫu tinh vi".

• Nghiên cứu này được hỗ trợ bởi một nghiên cứu trước đó từ năm 2019, cho thấy có thể đánh lừa các mô hình AI một cách đáng tin cậy bằng cách đặt câu hỏi về tuổi của hai cầu thủ Super Bowl trước đây.

📌 Apple chứng minh các mô hình AI dựa trên LLM thiếu khả năng suy luận cơ bản. Nghiên cứu sử dụng tiêu chuẩn GSM-Symbolic cho thấy thay đổi nhỏ trong câu hỏi có thể làm giảm độ chính xác tới 65%. Kết luận: không thể xây dựng AI đáng tin cậy trên nền tảng này.

https://appleinsider.com/articles/24/10/12/apples-study-proves-that-llm-based-ai-models-are-flawed-because-they-cannot-reason

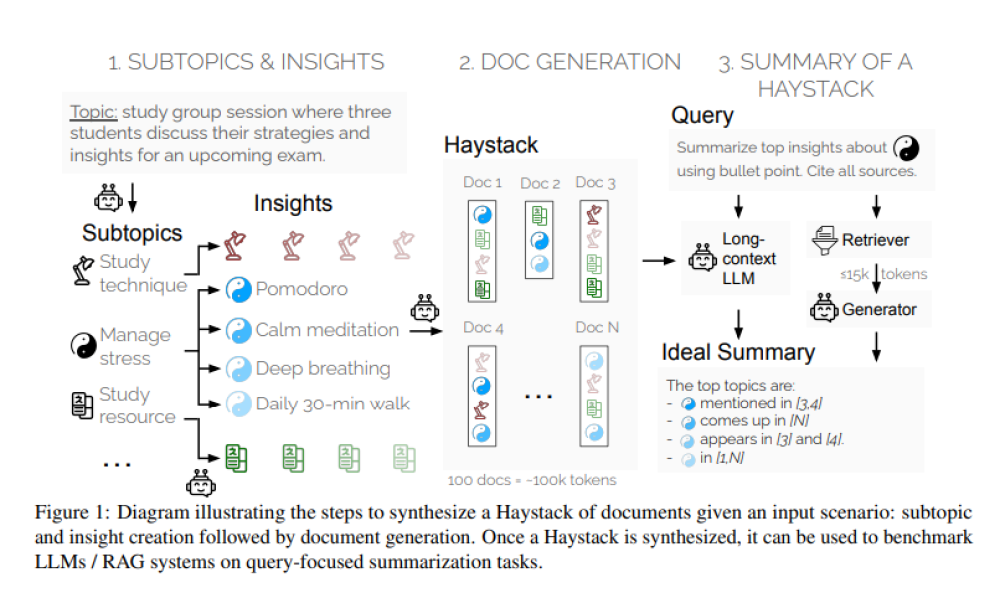

• DeepMind giới thiệu bộ đánh giá Michelangelo nhằm đánh giá khả năng suy luận trên ngữ cảnh dài của các mô hình ngôn ngữ lớn (LLM).

• Các LLM hiện nay có thể xử lý hàng trăm nghìn hoặc thậm chí hàng triệu token trong một lần nhập, mở ra nhiều khả năng mới cho các nhà phát triển.

• Tuy nhiên, các đánh giá hiện tại chủ yếu tập trung vào khả năng truy xuất thông tin, chưa phản ánh đầy đủ khả năng suy luận trên toàn bộ ngữ cảnh.

• Michelangelo dựa trên khung Latent Structure Queries (LSQ), tập trung đánh giá khả năng hiểu cấu trúc và mối quan hệ thông tin trong cửa sổ ngữ cảnh.

• Bộ đánh giá gồm 3 nhiệm vụ chính:

- Latent list: Xử lý chuỗi thao tác dài trên danh sách Python

- Multi-round co-reference resolution (MRCR): Tạo các phần của cuộc hội thoại dài

- "I don't know" (IDK): Trả lời câu hỏi về một câu chuyện dài, nhận biết khi không có thông tin

• LSQ có 3 điểm khác biệt chính so với các phương pháp khác:

- Tránh lỗi đánh giá chỉ dựa trên truy xuất thông tin

- Cho phép tăng độ phức tạp và độ dài ngữ cảnh độc lập

- Đủ tổng quát để đánh giá nhiều loại nhiệm vụ suy luận

• Các nhà nghiên cứu đã đánh giá 10 LLM hàng đầu trên Michelangelo, bao gồm các biến thể của Gemini, GPT-4 và Claude.

• Kết quả cho thấy:

- Gemini thực hiện tốt nhất ở MRCR

- GPT xuất sắc ở Latent List

- Claude 3.5 Sonnet đạt điểm cao nhất ở IDK

• Tuy nhiên, tất cả các mô hình đều giảm hiệu suất đáng kể khi độ phức tạp của nhiệm vụ suy luận tăng lên.