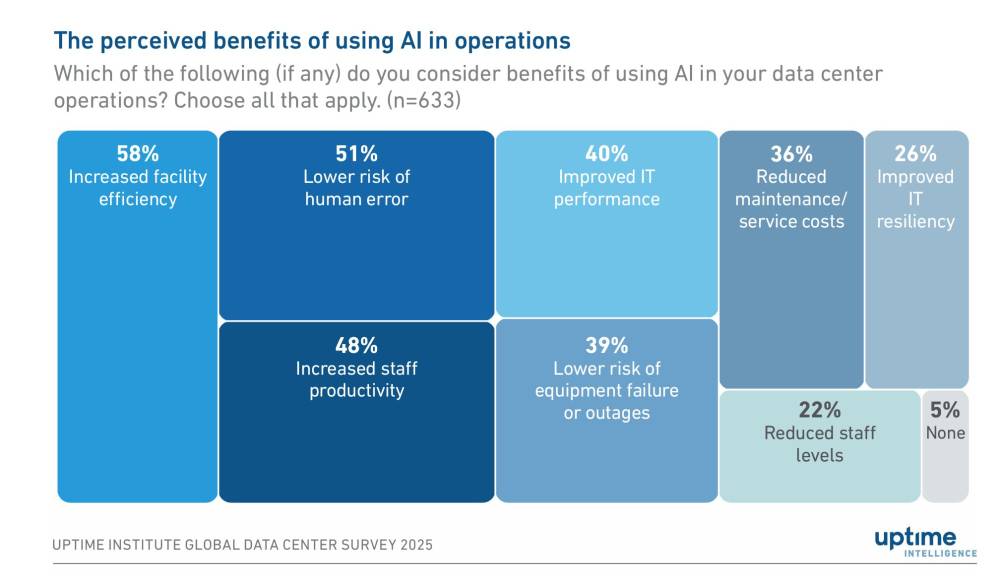

McKinsey: Năm 2030, toàn cầu cần khoảng 6.700 tỷ USD cho trung tâm dữ liệu, riêng phục vụ AI chiếm 5.200 tỷ USD

-

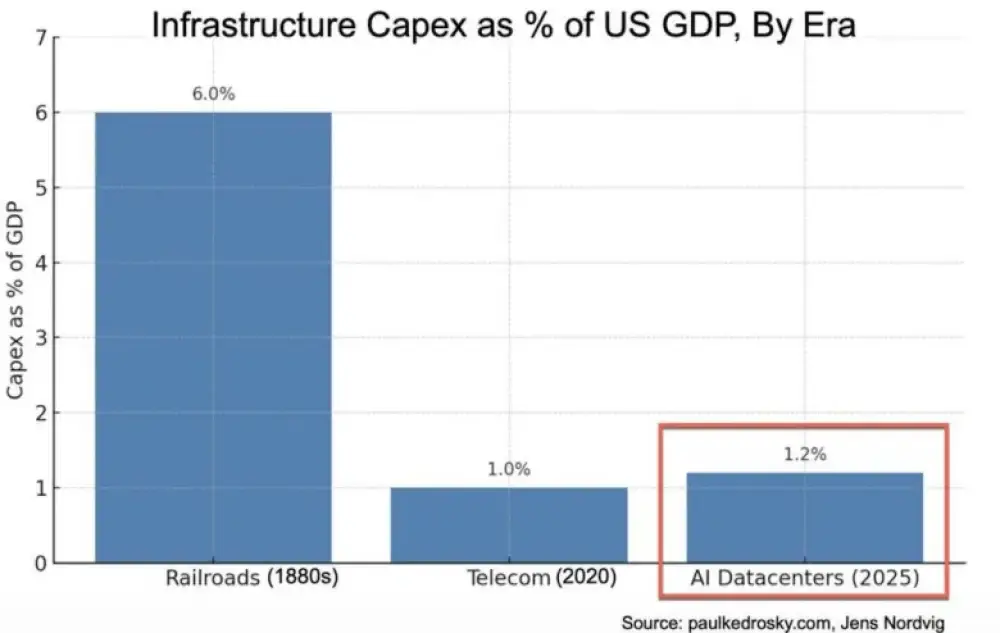

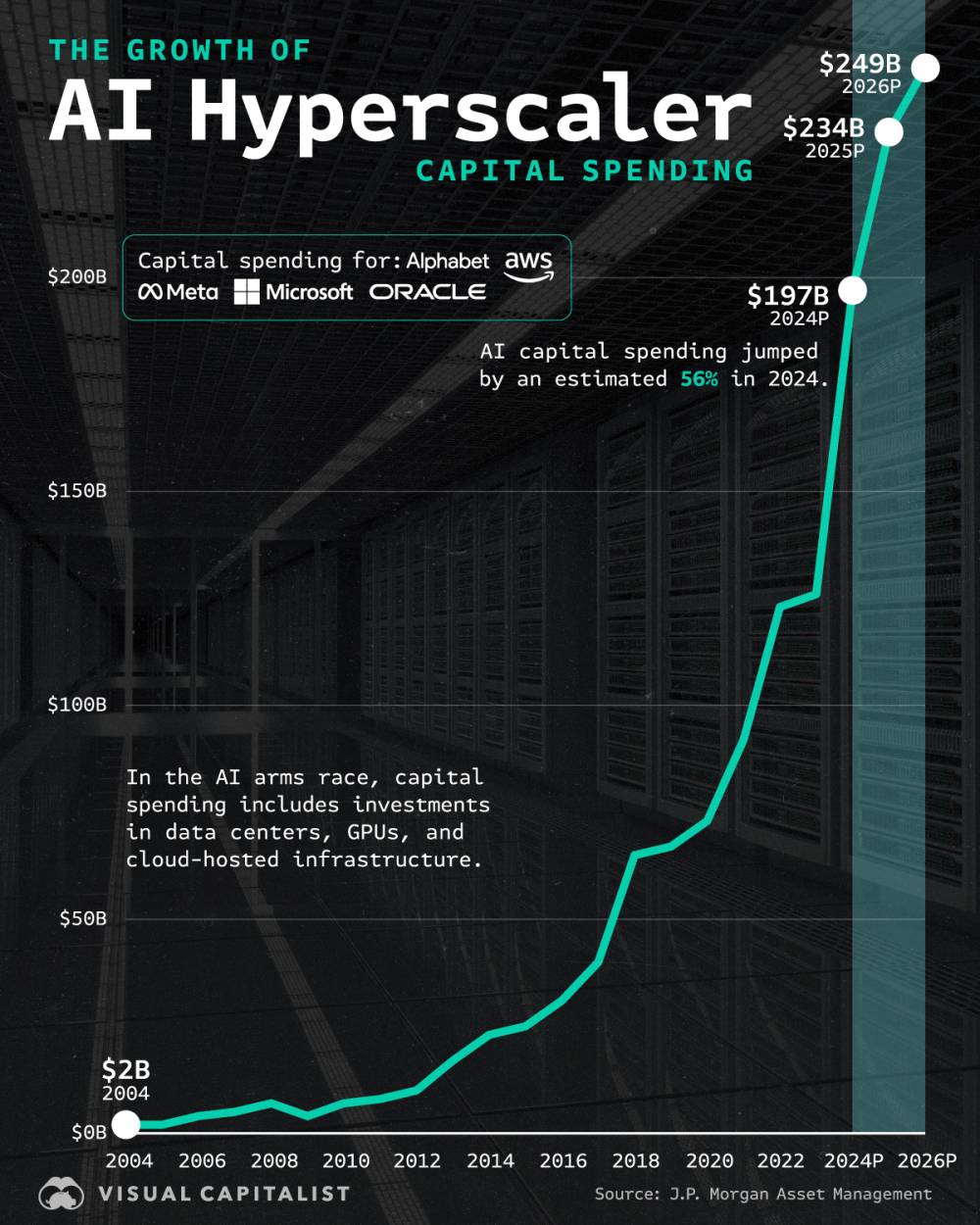

AI tạo sinh đang thúc đẩy nhu cầu tính toán cực lớn, buộc doanh nghiệp phải đầu tư hàng nghìn tỷ USD vào hạ tầng trung tâm dữ liệu.

-

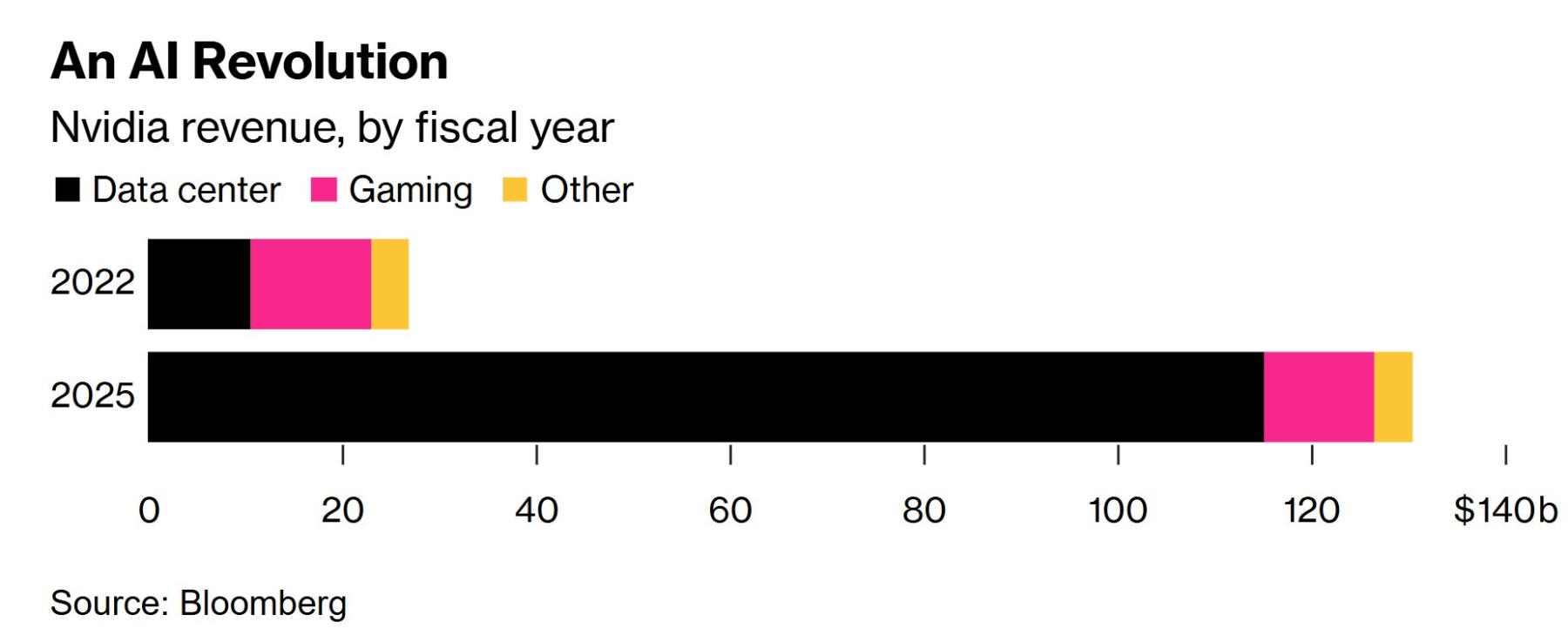

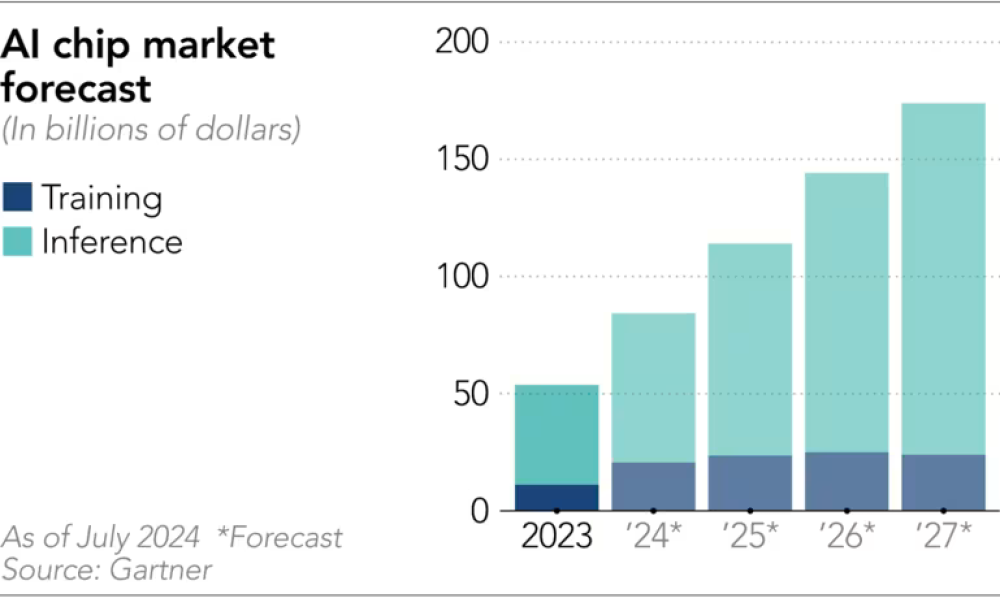

Dự báo đến năm 2030, toàn cầu cần khoảng 6.700 tỷ USD cho trung tâm dữ liệu, riêng phục vụ AI chiếm 5.200 tỷ USD, còn lại 1.500 tỷ USD cho các ứng dụng IT truyền thống.

-

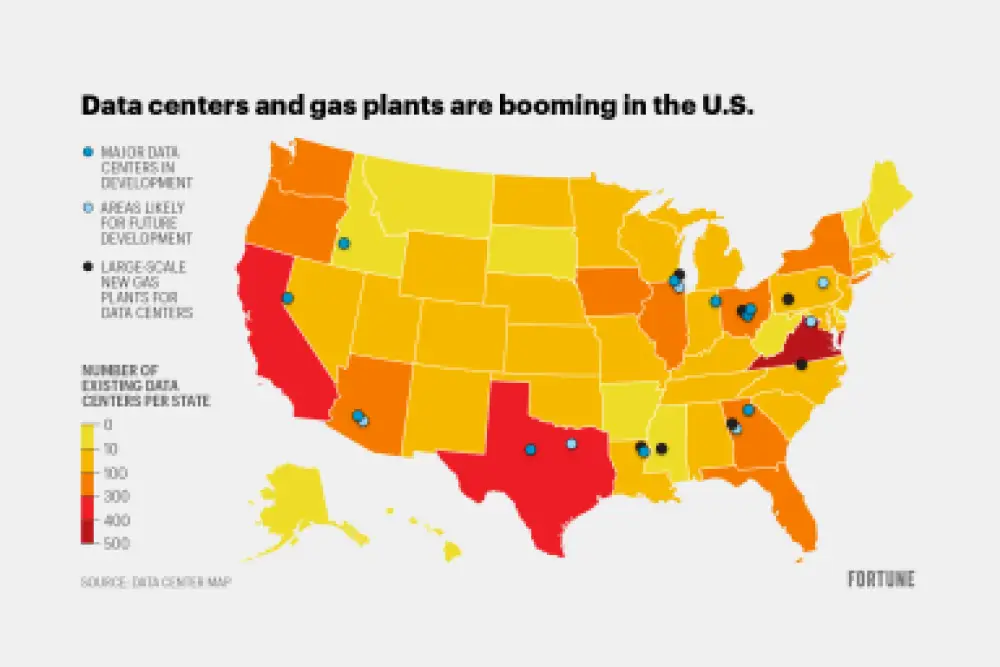

Nhu cầu trung tâm dữ liệu có thể tăng gần gấp ba vào năm 2030, với khoảng 70% đến từ AI.

-

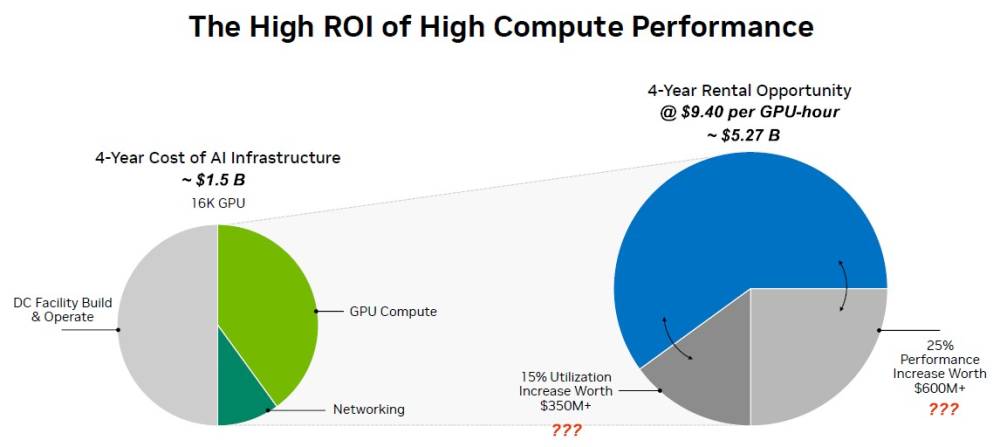

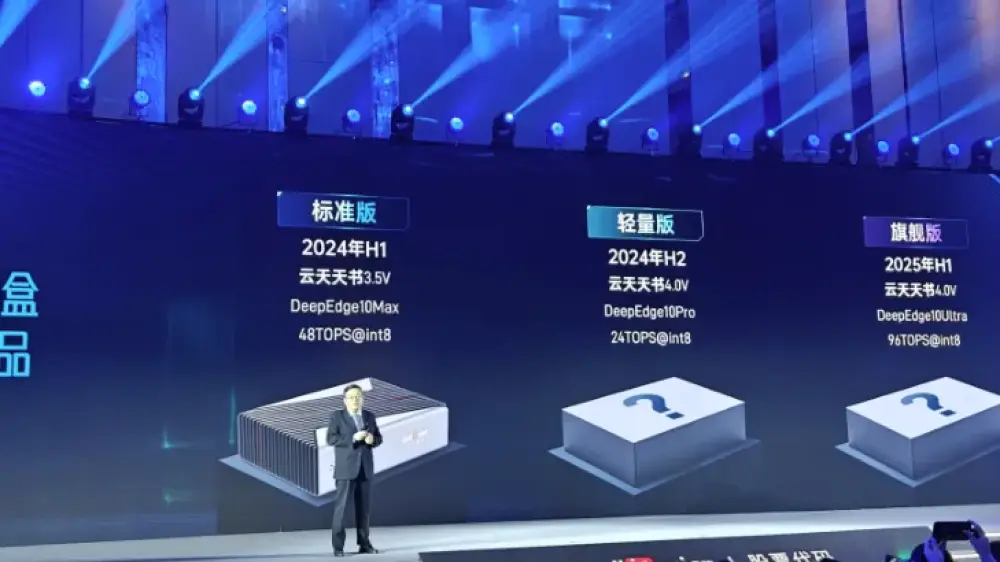

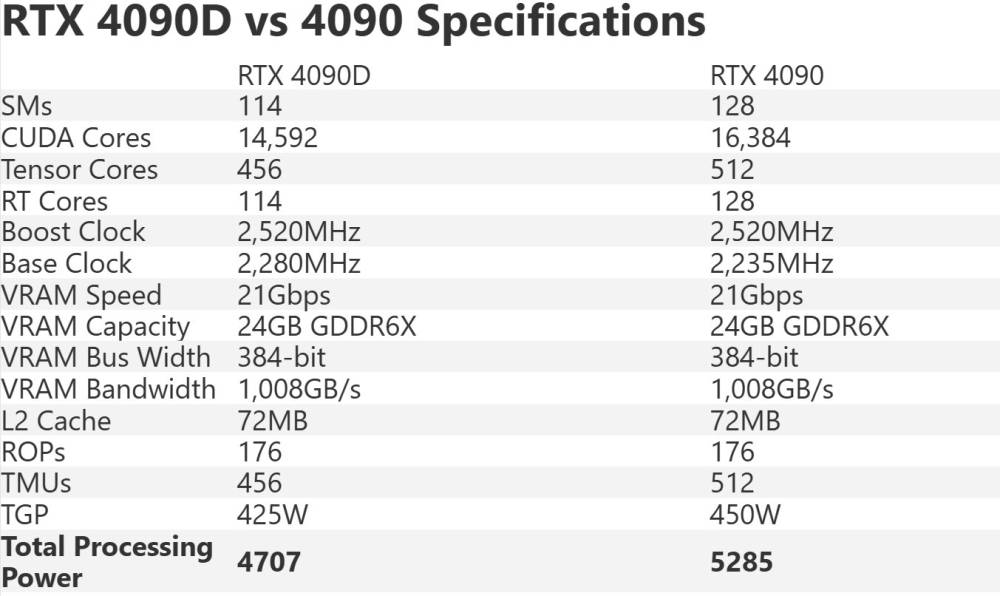

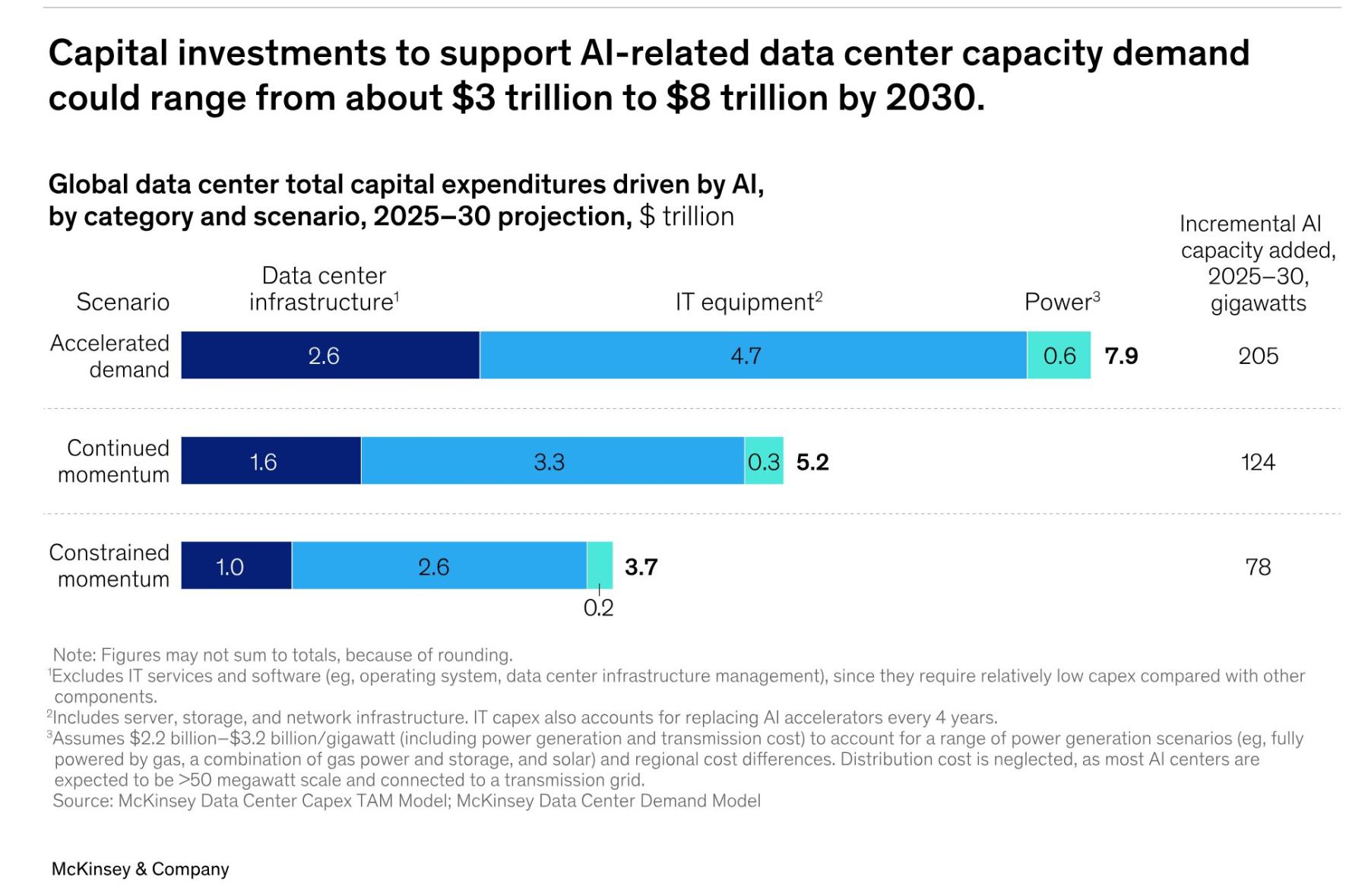

Ba kịch bản đầu tư đến năm 2030: thấp nhất 3.700 tỷ USD (78 GW công suất), trung bình 5.200 tỷ USD (125 GW), cao nhất 7.900 tỷ USD (205 GW).

-

60% vốn đầu tư (3.100 tỷ USD) dành cho công ty bán dẫn, phần cứng; 25% (1.300 tỷ USD) cho năng lượng, làm mát; 15% (800 tỷ USD) cho xây dựng, phát triển mặt bằng.

-

Các “builder” (nhà phát triển, xây dựng) đối mặt thiếu nhân lực, hạn chế vị trí; giải pháp là thiết kế mô-đun, lắp ráp ngoài công trường.

-

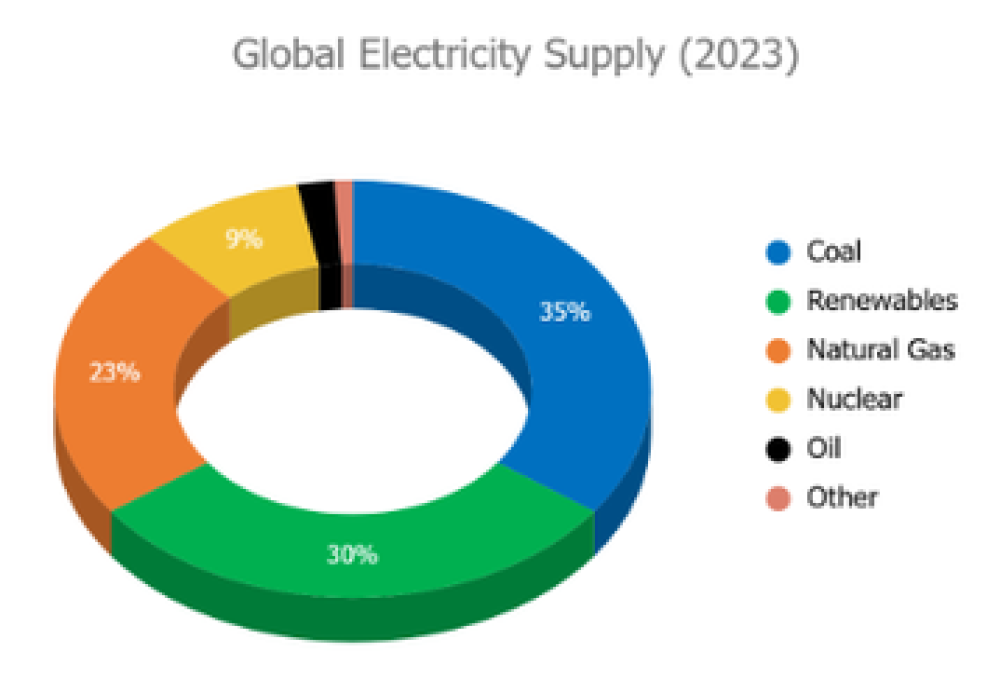

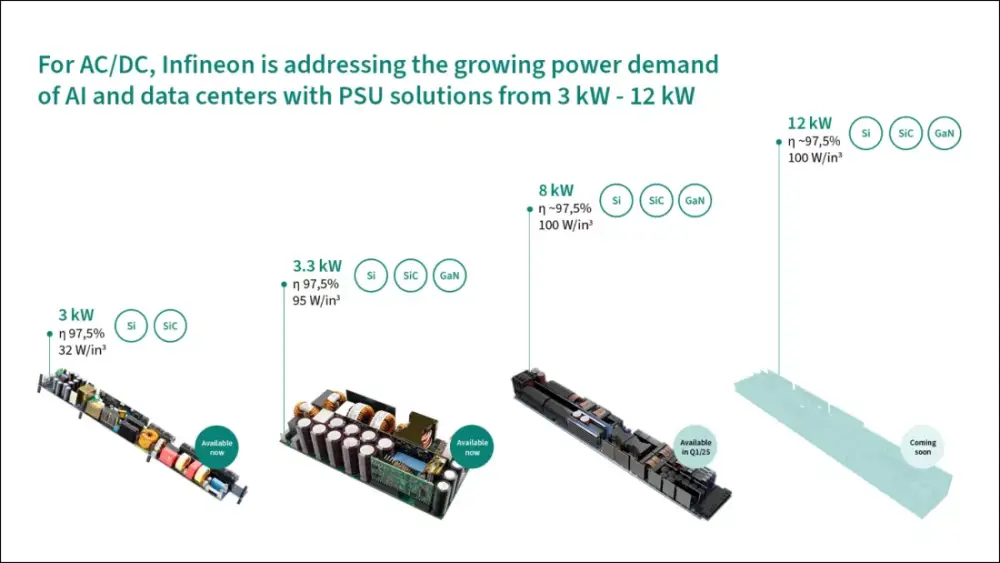

“Energizer” (công ty điện, làm mát) đầu tư mạnh vào năng lượng sạch, dự kiến năng lượng tái tạo chiếm 45-50% vào năm 2030, tăng từ mức 33% hiện nay.

-

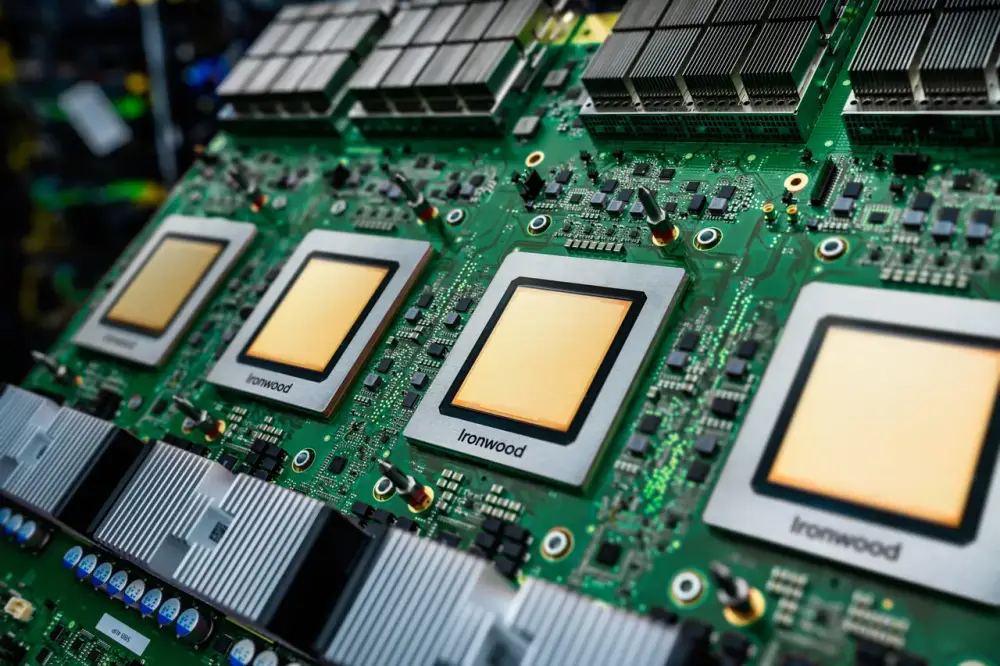

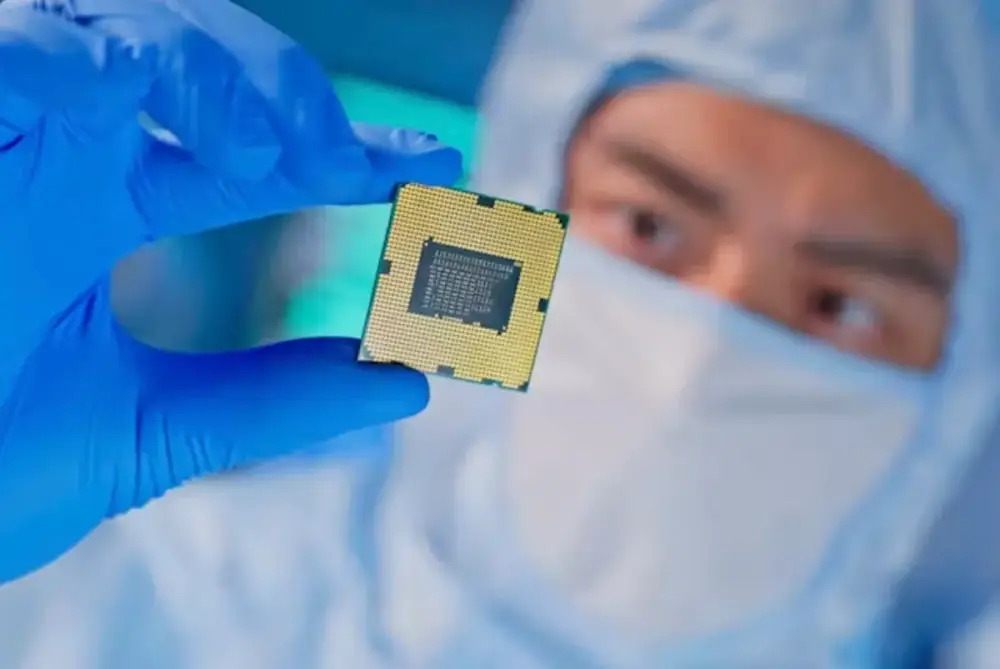

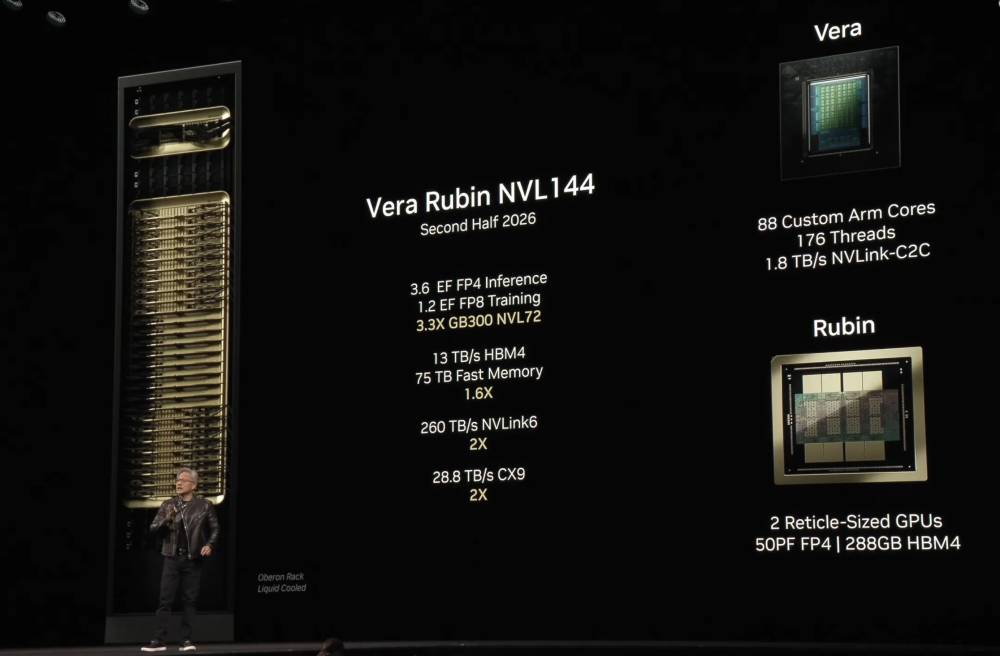

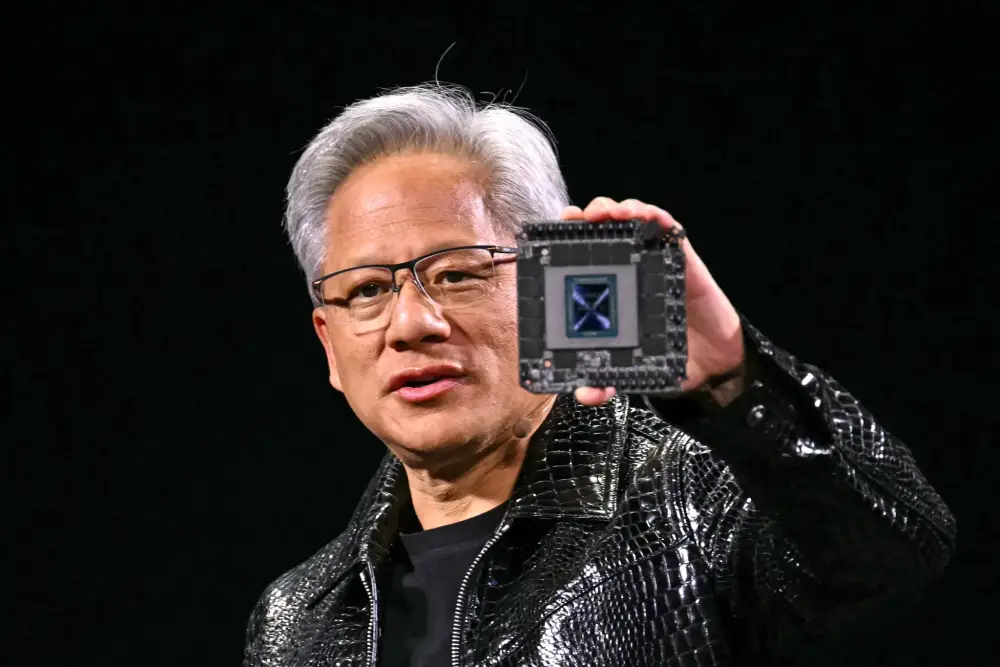

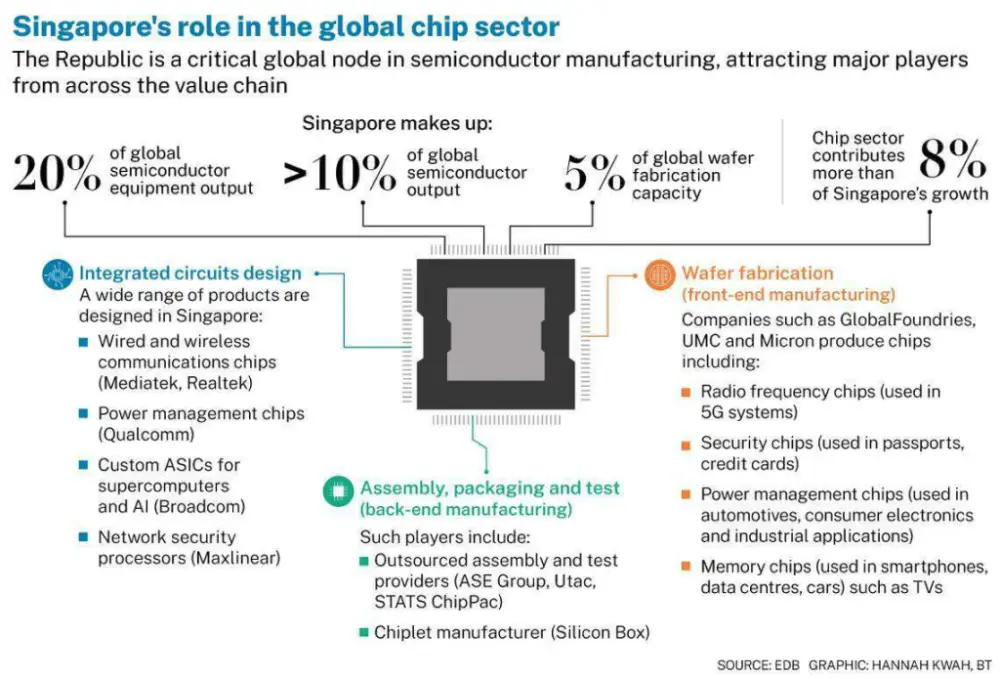

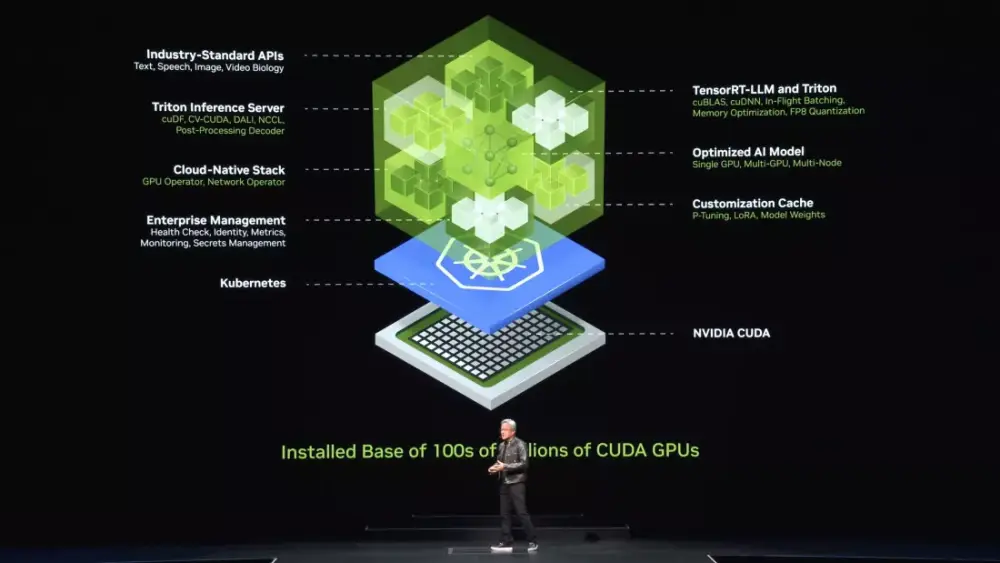

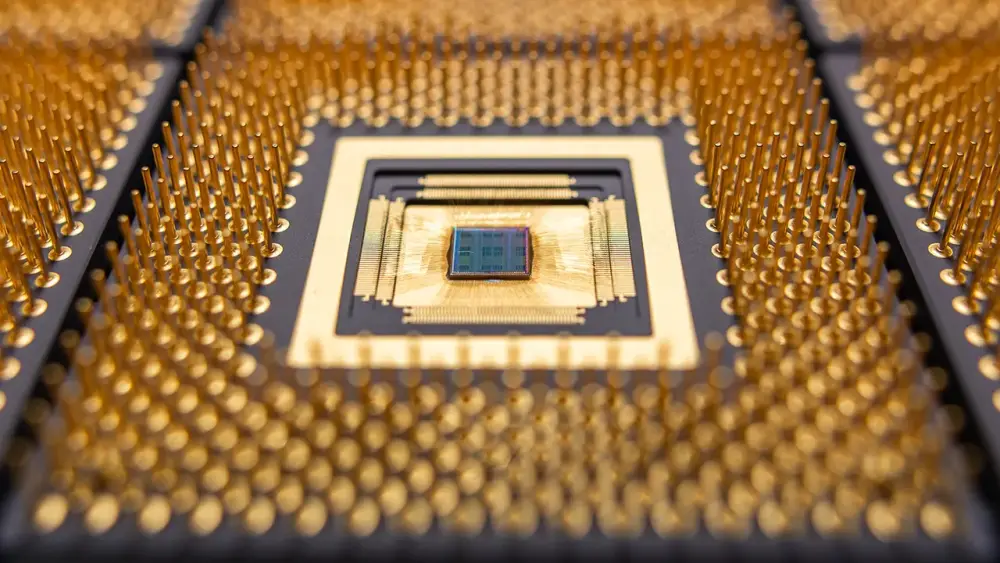

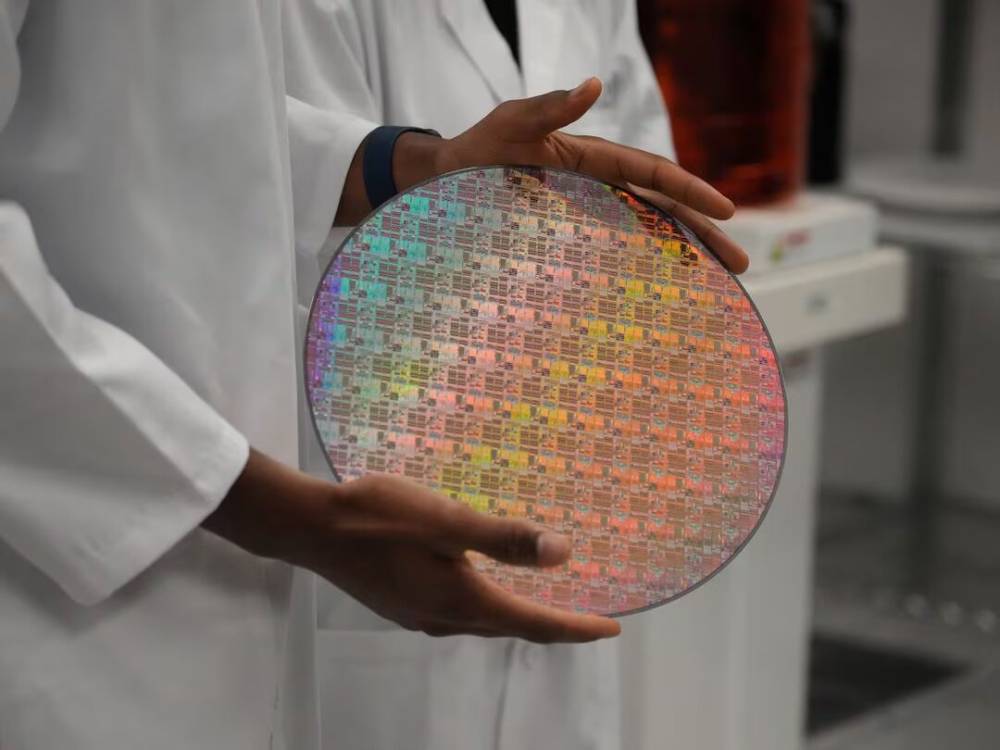

“Technology developers and designers” (công ty bán dẫn, phần cứng) chi phối nguồn cung chip, đối mặt rủi ro tắc nghẽn, cần mở rộng sản xuất và đa dạng hóa chuỗi cung ứng.

-

“Operators” (nhà vận hành trung tâm dữ liệu) phải tối ưu hiệu quả năng lượng, đầu tư giải pháp làm mát, phát triển AI tiết kiệm tài nguyên.

-

“AI architects” (nhà phát triển mô hình AI) đối mặt chi phí inference tăng vọt, giải pháp là tối ưu kiến trúc, áp dụng kỹ thuật sparse activation, distillation.

-

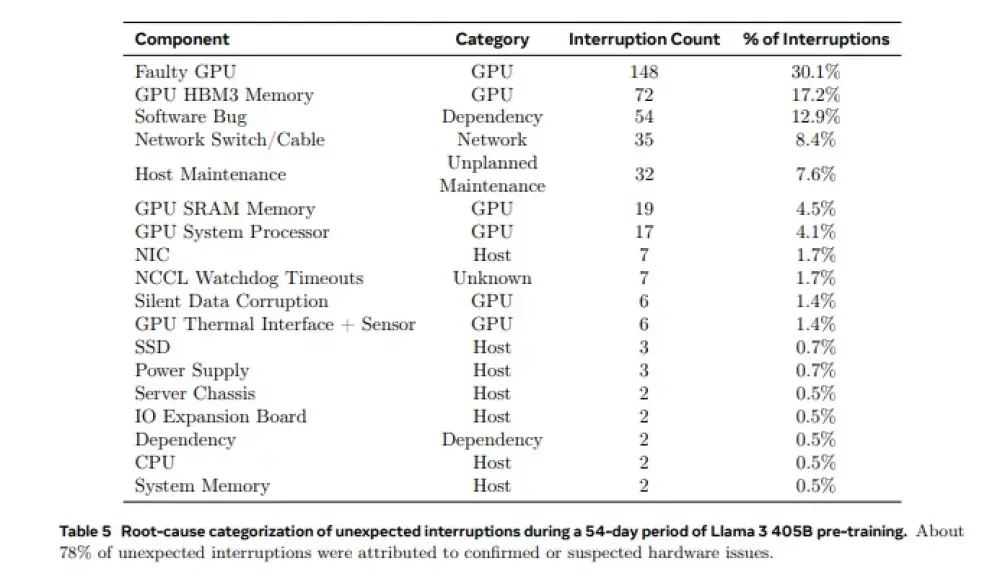

Rủi ro lớn: gián đoạn công nghệ, tắc nghẽn chuỗi cung ứng, căng thẳng địa chính trị, khó dự báo ROI khiến CEO ngần ngại đầu tư tối đa.

-

Để vượt lên, doanh nghiệp cần dự báo nhu cầu sớm, đầu tư công nghệ tiết kiệm năng lượng, xây dựng chuỗi cung ứng linh hoạt và chọn vị trí tối ưu.

📌 Đầu tư cho trung tâm dữ liệu AI toàn cầu đến năm 2030 dự kiến lên tới gần 7.000 tỷ USD, trong đó riêng AI chiếm 5.200 tỷ USD. Ba nhóm hưởng lợi lớn là công ty bán dẫn, năng lượng và xây dựng, nhưng phải đối mặt rủi ro thiếu nguồn cung, công nghệ biến động và ROI khó lường. Ai dự báo, tối ưu và đầu tư linh hoạt sẽ dẫn đầu cuộc đua AI.

https://www.mckinsey.com/industries/technology-media-and-telecommunications/our-insights/the-cost-of-compute-a-7-trillion-dollar-race-to-scale-data-centers

#McKinsey

Chi phí tính toán: Cuộc đua 7.000 tỷ đô la để mở rộng quy mô trung tâm dữ liệu

Ngày 28 tháng 4, 2025 | Bài viết

AI đang thúc đẩy nhu cầu cao về năng lực tính toán, khiến các công ty đầu tư hàng tỷ đô la vào cơ sở hạ tầng. Nhưng với nhu cầu tương lai không chắc chắn, các nhà đầu tư cần đưa ra quyết định có tính toán.

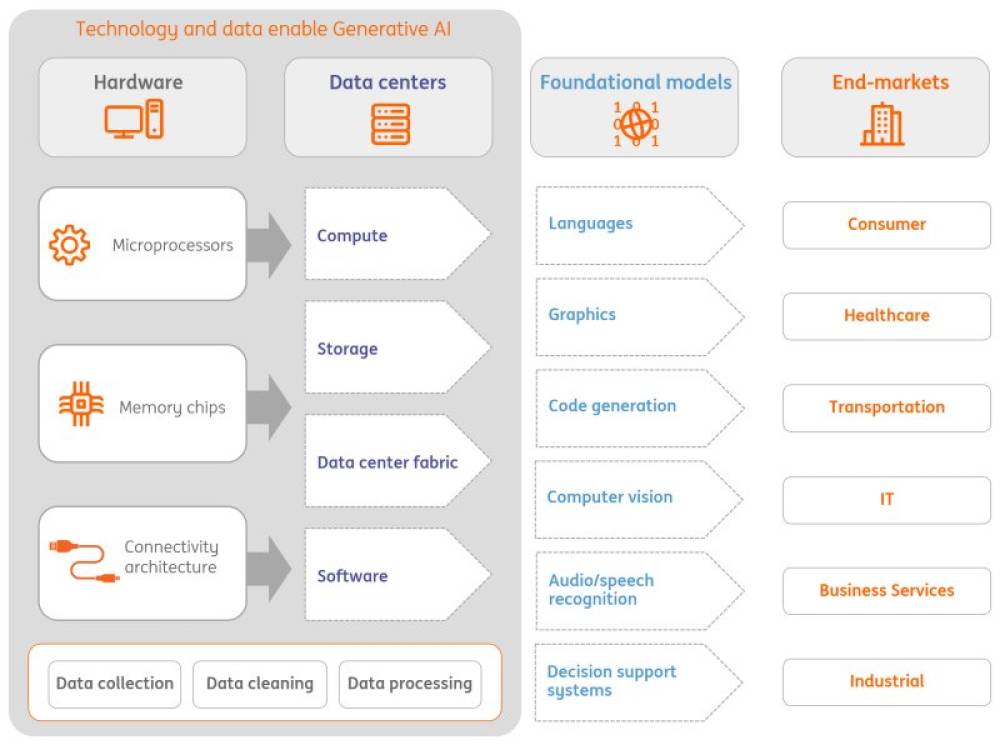

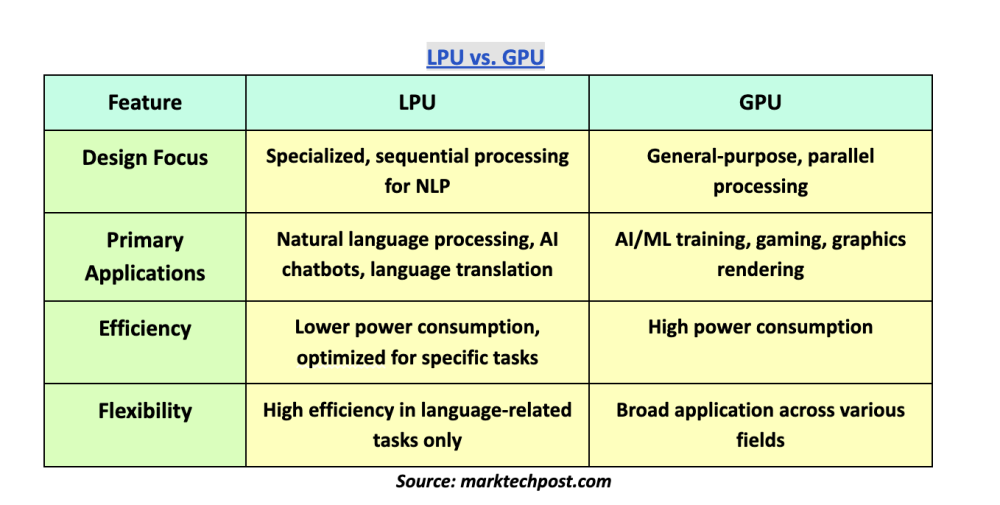

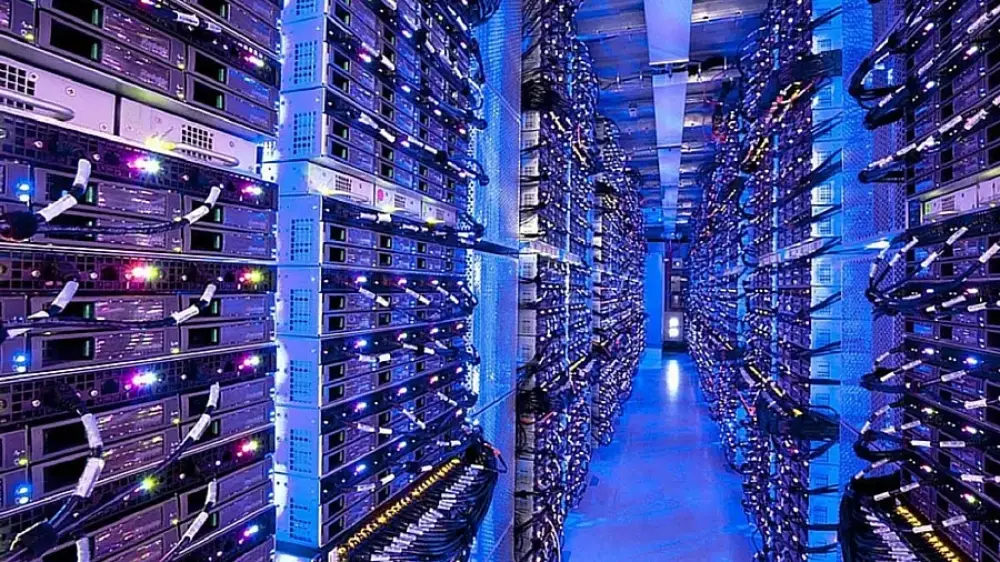

Trong bối cảnh bùng nổ AI, sức mạnh tính toán đang nổi lên như một trong những nguồn tài nguyên quan trọng nhất của thập kỷ này. Tại các trung tâm dữ liệu trên toàn cầu, hàng triệu máy chủ hoạt động 24/7 để xử lý các mô hình nền tảng và ứng dụng học máy làm nền tảng cho AI. Phần cứng, bộ xử lý, bộ nhớ, lưu trữ và năng lượng cần thiết để vận hành các trung tâm dữ liệu này được gọi chung là sức mạnh tính toán—và nhu cầu về nó là không thể thỏa mãn.

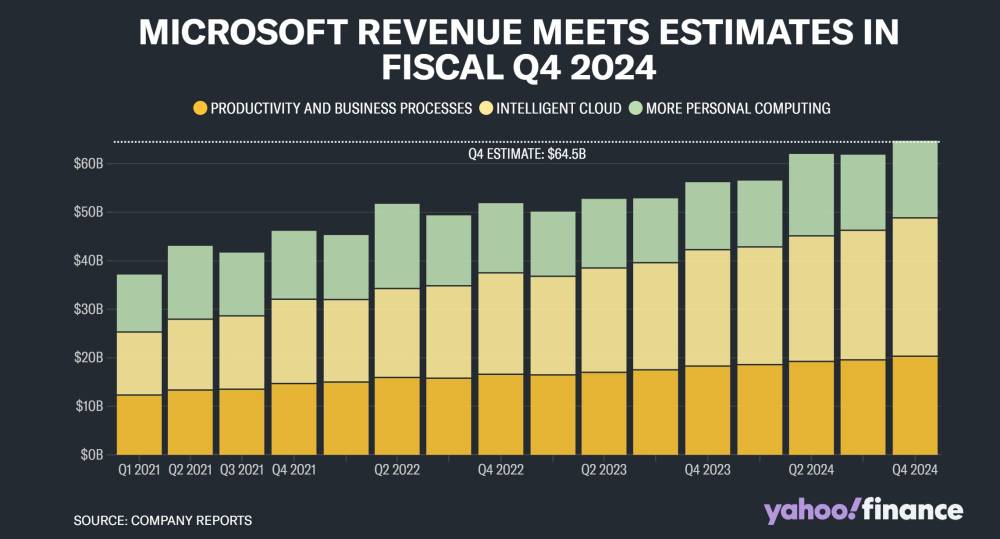

Nghiên cứu của chúng tôi cho thấy đến năm 2030, các trung tâm dữ liệu dự kiến sẽ cần 6.700 tỷ đô la trên toàn cầu để theo kịp nhu cầu về sức mạnh tính toán. Các trung tâm dữ liệu được trang bị để xử lý tải AI dự kiến sẽ cần 5.200 tỷ đô la chi phí đầu tư, trong khi các trung tâm phục vụ ứng dụng CNTT truyền thống dự kiến cần 1.500 tỷ đô la chi phí đầu tư (xem sidebar "Còn các tải công việc không phải AI thì sao?"). Nhìn chung, đó là gần 7.000 tỷ đô la chi phí vốn cần thiết vào năm 2030—một con số đáng kinh ngạc theo bất kỳ thước đo nào.

Side bar: Còn các tải công việc không phải AI thì sao?

Trong khi các tải công việc AI chiếm ưu thế trong cuộc trò chuyện, các tải xử lý không phải AI vẫn chiếm một phần đáng kể hoạt động trung tâm dữ liệu. Những tải này bao gồm các tác vụ CNTT doanh nghiệp truyền thống như lưu trữ web, hệ thống hoạch định tài nguyên doanh nghiệp, email và lưu trữ tệp. Các tải không phải AI ít yêu cầu tính toán cao và có thể hoạt động hiệu quả trên các đơn vị xử lý trung tâm thay vì các đơn vị xử lý đồ họa chuyên biệt hoặc bộ tăng tốc AI mà tải công việc AI đòi hỏi. Chúng cũng thường có mô hình sử dụng dễ dự đoán hơn và mật độ năng lượng thấp hơn, cho phép yêu cầu làm mát và năng lượng ít đòi hỏi hơn. Kết quả là, các trung tâm dữ liệu tập trung vào xử lý không phải AI thường có nhu cầu cơ sở hạ tầng, cường độ vốn và cân nhắc hoạt động khác so với những trung tâm được tối ưu hóa cho AI.

Còn các tải công việc không phải AI thì sao?

Để đáp ứng nhu cầu này, các công ty trong chuỗi giá trị sức mạnh tính toán phải cân bằng giữa việc triển khai vốn nhanh chóng và làm điều đó một cách thận trọng. Để cải thiện khả năng đầu tư trung tâm dữ liệu mang lại lợi nhuận cao, các công ty có thể thực hiện các dự án theo từng giai đoạn, đánh giá ROI ở mỗi bước. Tuy nhiên, thiếu rõ ràng về nhu cầu tương lai khiến các tính toán đầu tư chính xác trở nên khó khăn.

Chuỗi giá trị sức mạnh tính toán rất phức tạp—từ các nhà phát triển bất động sản xây dựng trung tâm dữ liệu đến các công ty tiện ích cung cấp năng lượng, đến các công ty bán dẫn sản xuất chip đến các nhà cung cấp điện toán đám mây lớn lưu trữ hàng nghìn tỷ terabyte dữ liệu. Các lãnh đạo trong chuỗi giá trị này biết rằng họ phải đầu tư vào sức mạnh tính toán để đẩy nhanh tăng trưởng AI. Nhưng thách thức của họ rất lớn: quyết định phân bổ bao nhiêu vốn cho dự án nào, tất cả trong khi vẫn không chắc chắn về cách tăng trưởng và phát triển trong tương lai của AI sẽ ảnh hưởng đến nhu cầu sức mạnh tính toán. Các nhà cung cấp điện toán đám mây lớn sẽ tiếp tục gánh vác gánh nặng chi phí, hay các doanh nghiệp, chính phủ và tổ chức tài chính sẽ tham gia với các mô hình tài chính mới? Nhu cầu về trung tâm dữ liệu sẽ tăng lên trong bối cảnh tiếp tục gia tăng sử dụng AI, hay sẽ giảm khi tiến bộ công nghệ làm cho AI ít tốn kém hơn về mặt tính toán?

Một điều chắc chắn là: Cổ phần đang rất cao. Đầu tư quá mức vào cơ sở hạ tầng trung tâm dữ liệu có nguy cơ làm mắc kẹt tài sản, trong khi đầu tư không đủ đồng nghĩa với việc tụt hậu. Bài viết này, dựa trên nghiên cứu và phân tích của McKinsey, cung cấp cho các công ty trong chuỗi giá trị sức mạnh tính toán tổng quan về bối cảnh đầu tư trong năm năm tới. Mặc dù có sự nghiêm túc đằng sau các dự báo này, chúng tôi thừa nhận rằng AI là một lĩnh vực đang phát triển một cách triệt để. Phân tích của chúng tôi được xây dựng trên các giả thuyết được nghiên cứu kỹ lưỡng, nhưng có những điều không chắc chắn quan trọng chưa thể lượng hóa được.

Dự đoán đường cong nhu cầu sức mạnh tính toán

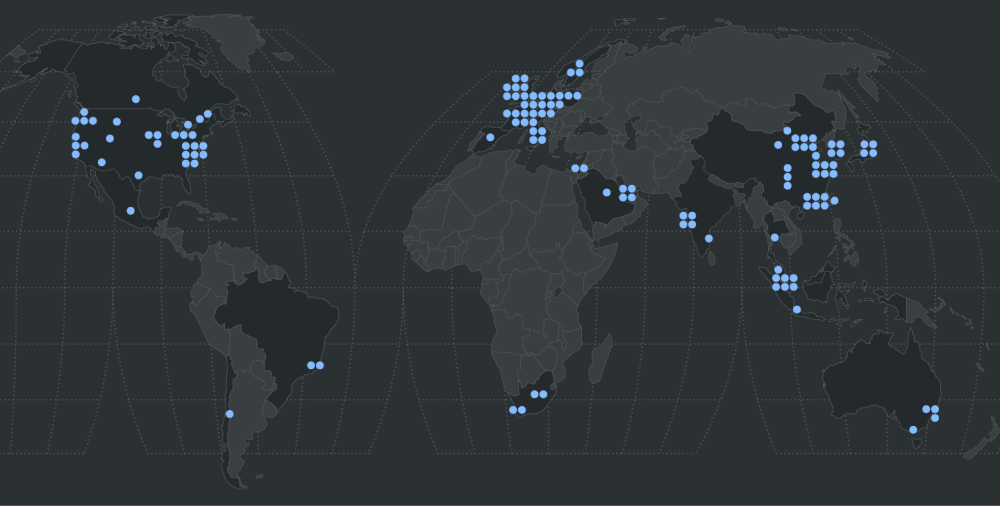

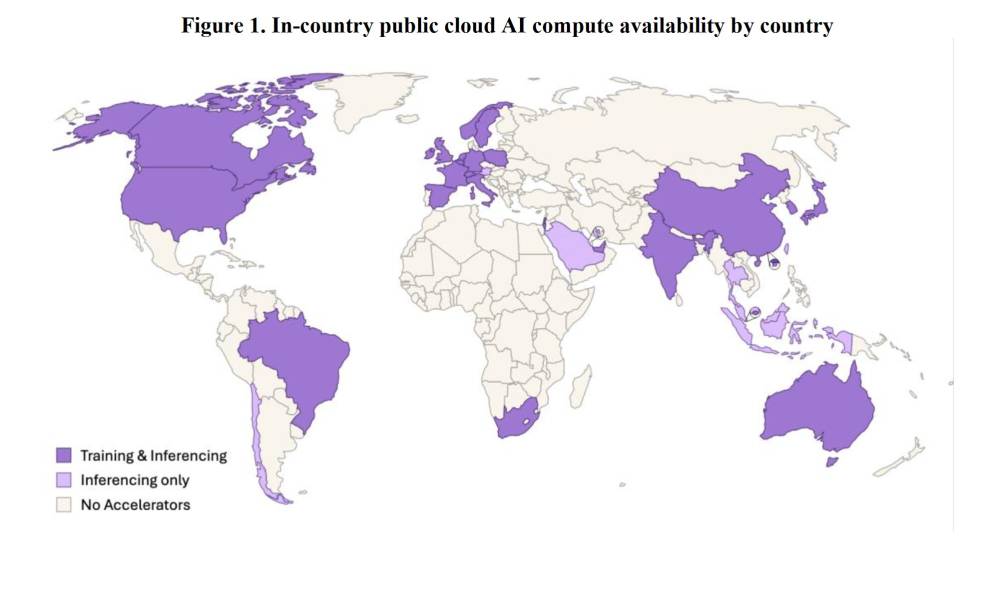

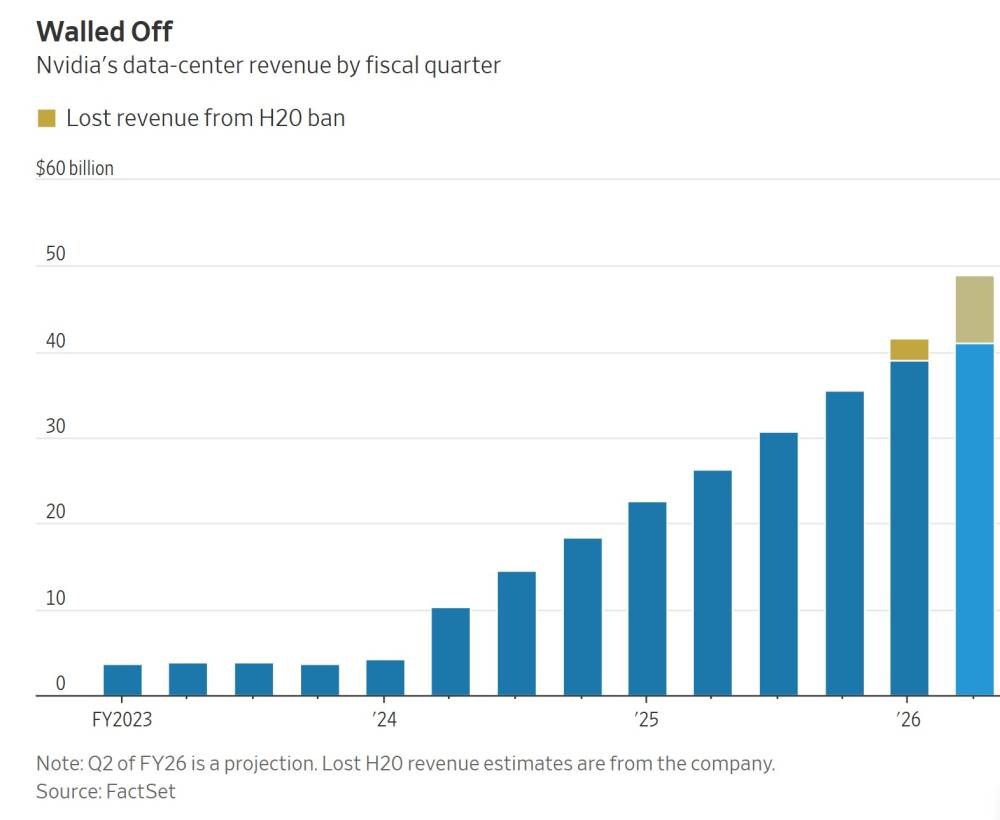

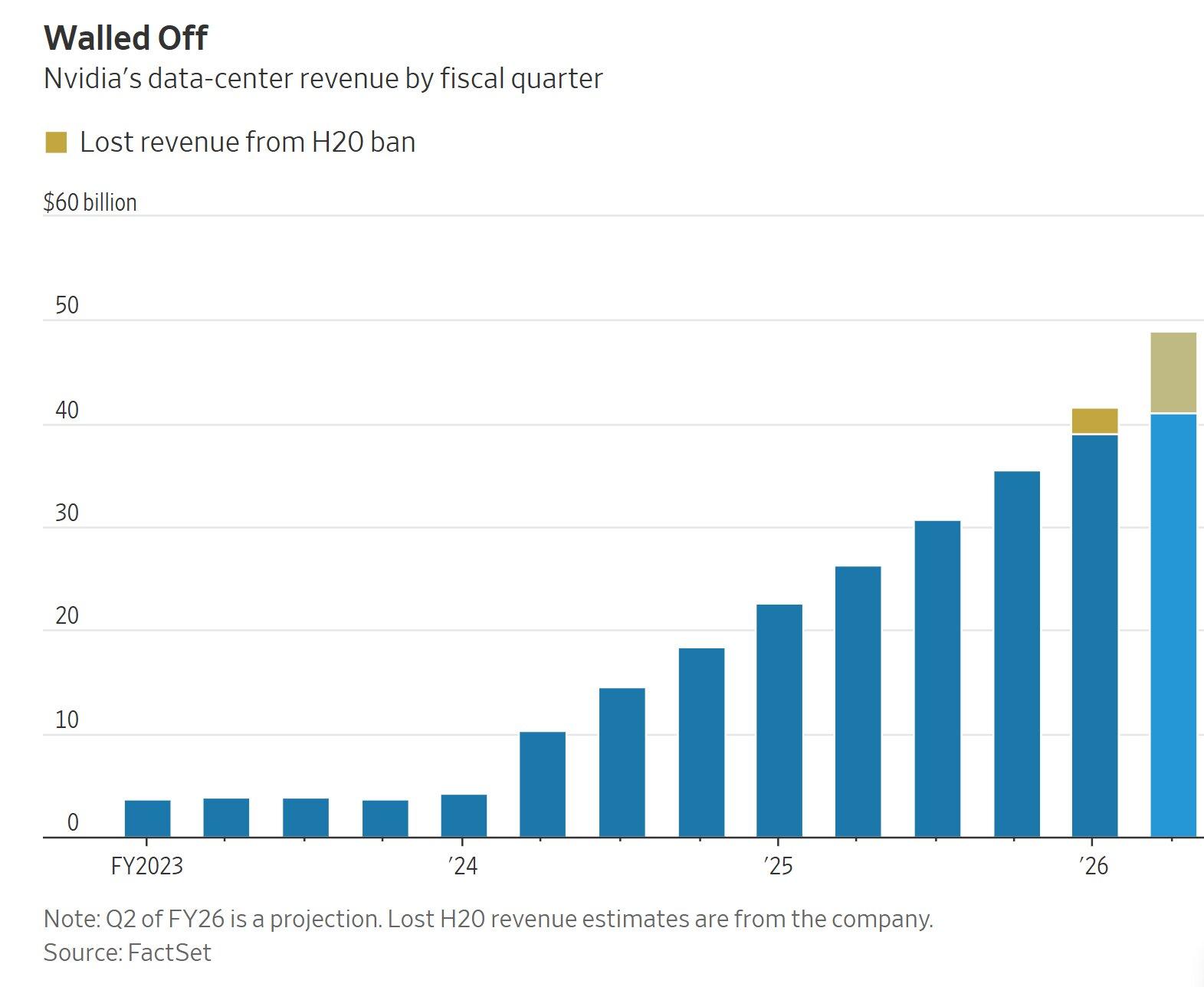

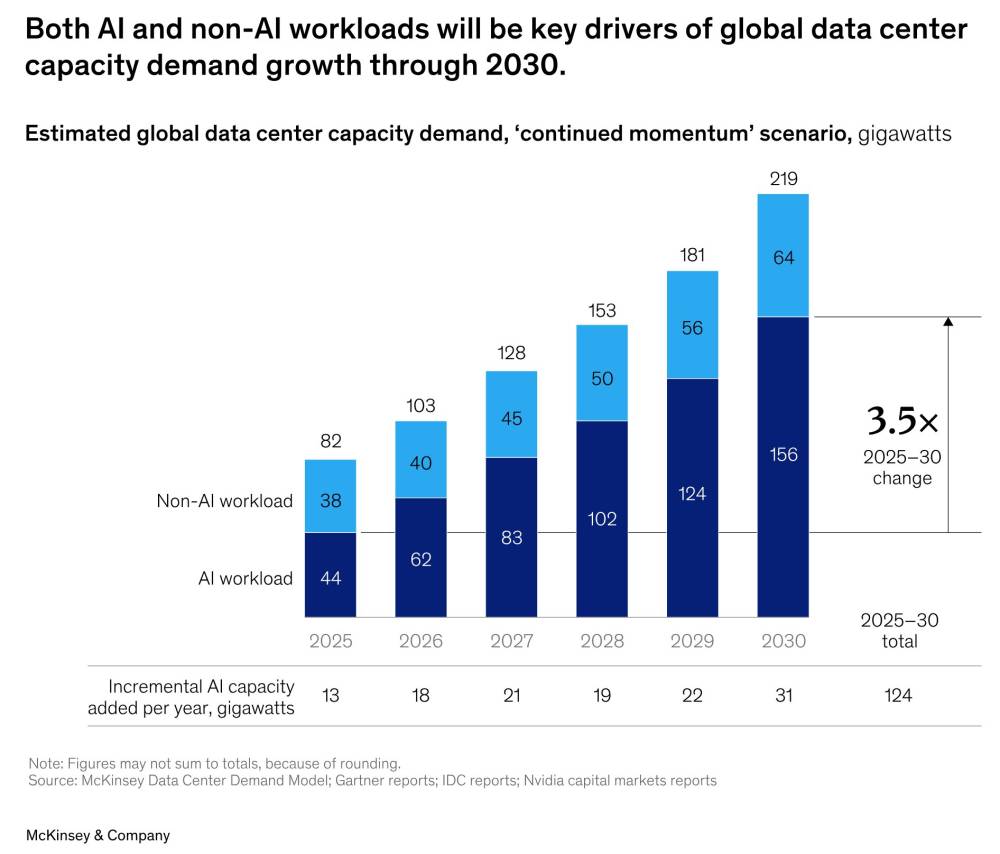

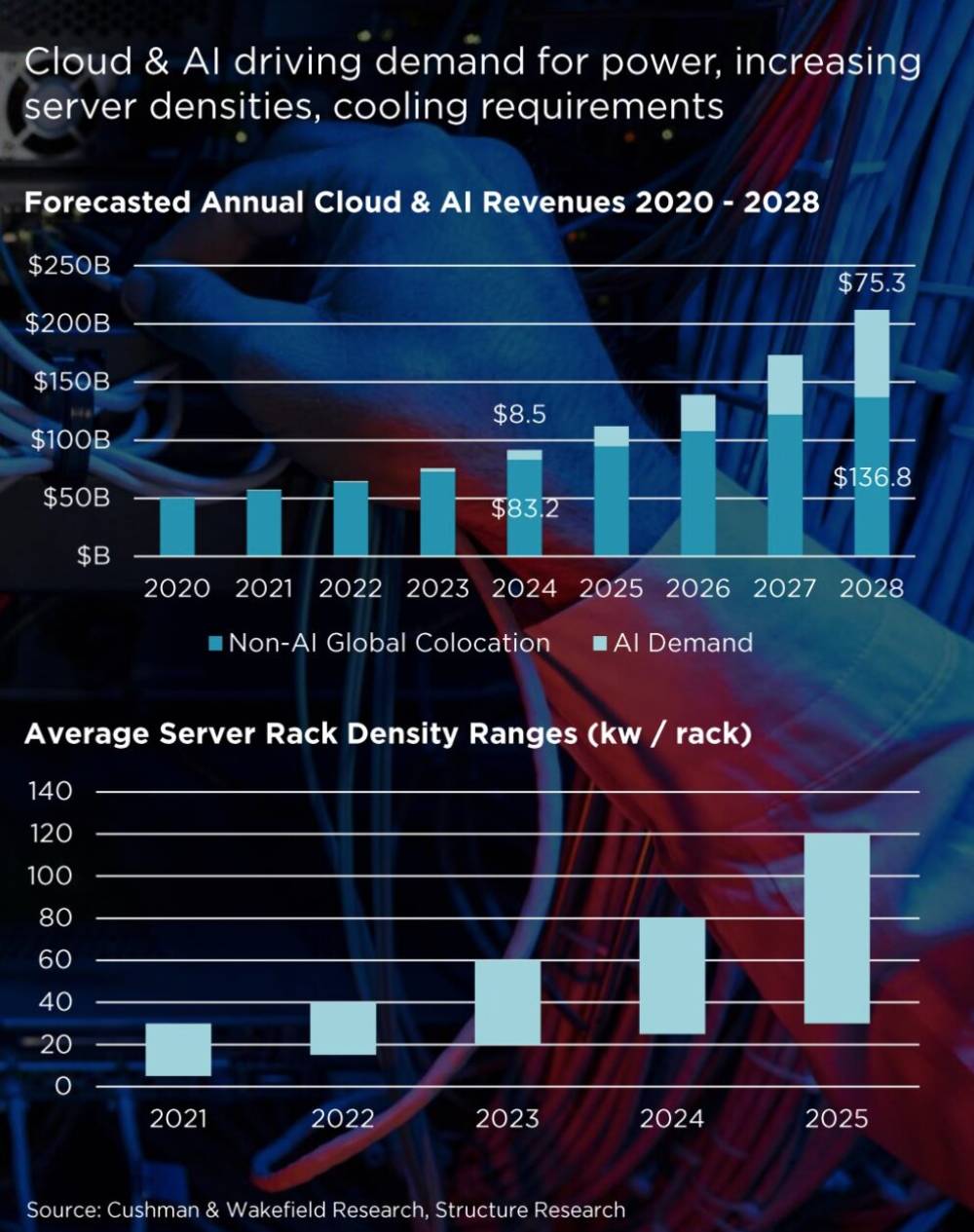

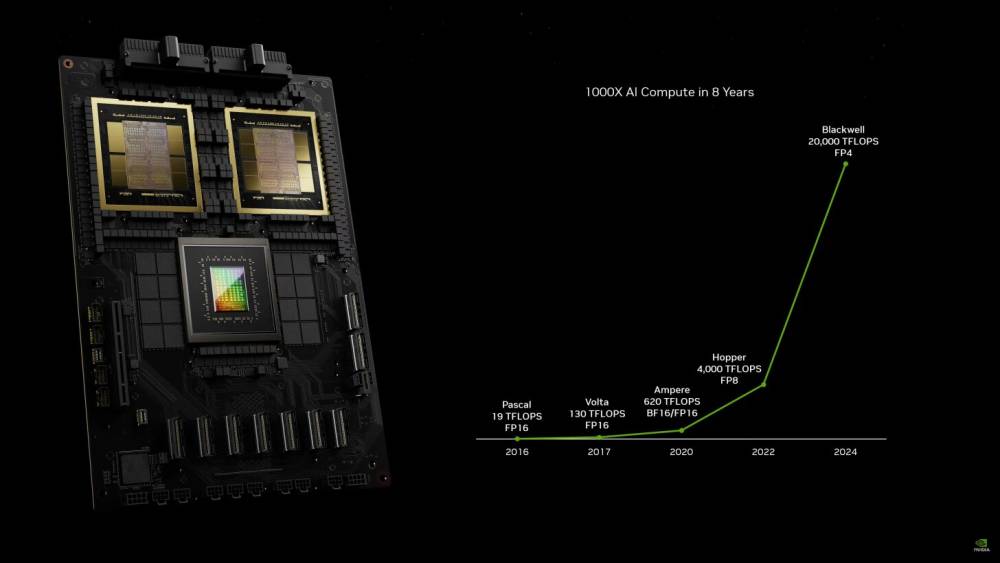

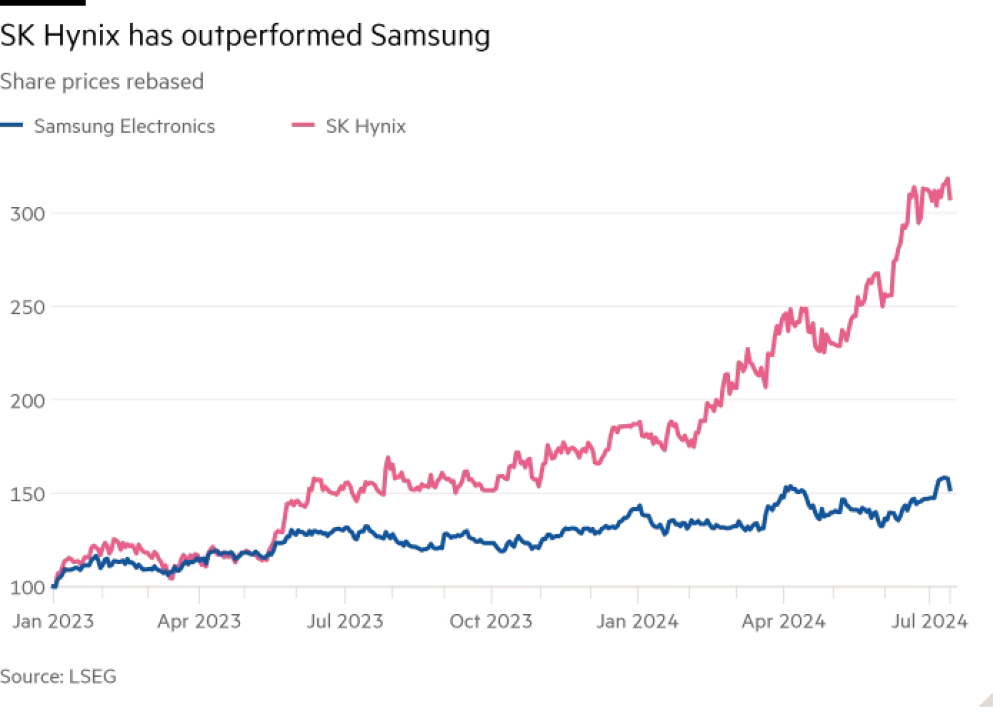

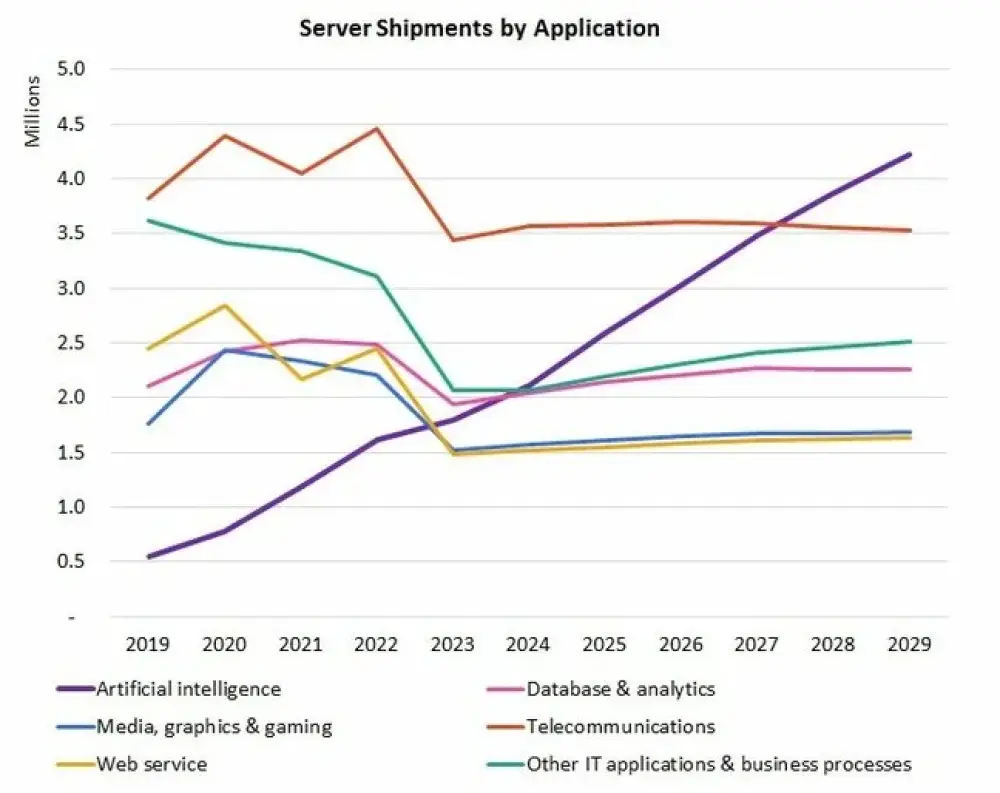

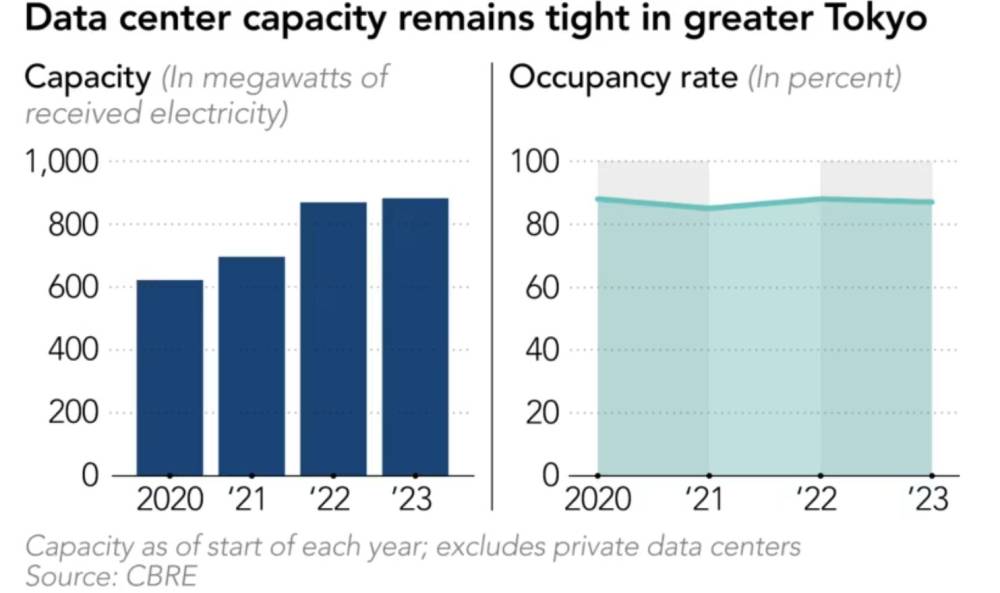

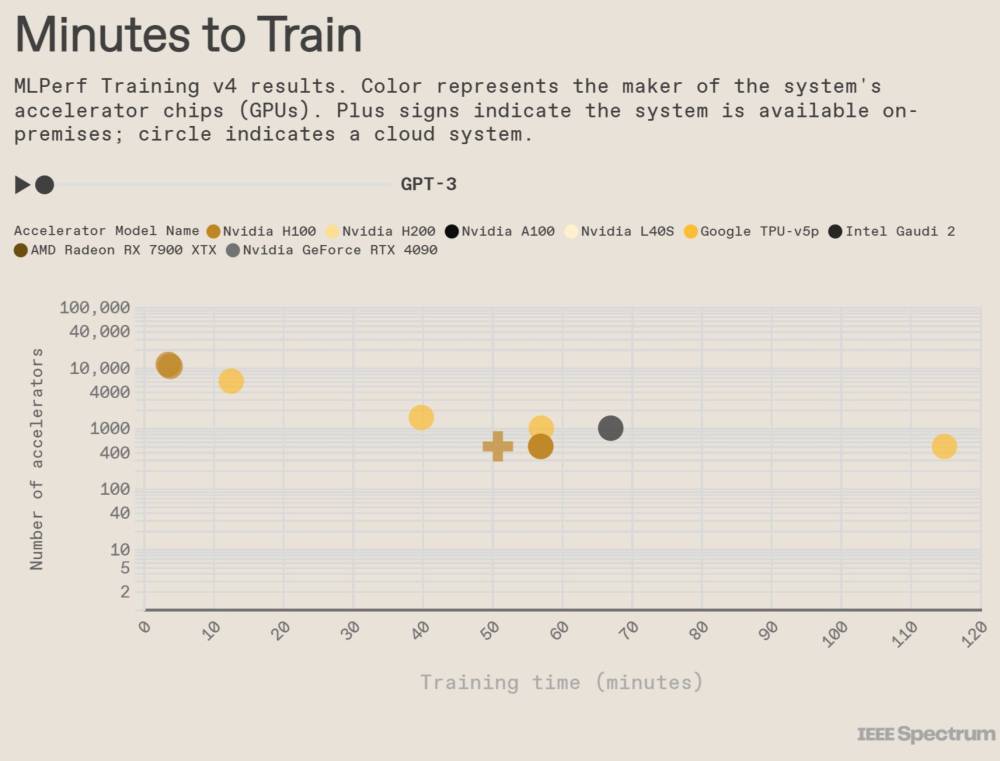

Để quyết định đầu tư bao nhiêu vào sức mạnh tính toán, các công ty trước tiên nên dự báo chính xác nhu cầu trong tương lai—một nhiệm vụ đầy thách thức khi ngành AI đang thay đổi nhanh chóng. Nghiên cứu của chúng tôi cho thấy nhu cầu toàn cầu về năng lực trung tâm dữ liệu có thể tăng gần gấp 3 lần vào năm 2030, với khoảng 70% nhu cầu đó đến từ tải công việc AI (Biểu đồ 1). Tuy nhiên, dự báo này phụ thuộc vào 2 yếu tố không chắc chắn:

Các trường hợp sử dụng AI. Giá trị trong AI nằm ở tầng ứng dụng—cách các doanh nghiệp biến AI thành tác động kinh doanh thực tế. Nếu các công ty không tạo ra giá trị có ý nghĩa từ AI, nhu cầu về sức mạnh tính toán có thể không đạt được kỳ vọng. Ngược lại, các ứng dụng AI đột phá có thể thúc đẩy nhu cầu lớn hơn nhiều so với dự báo hiện tại.

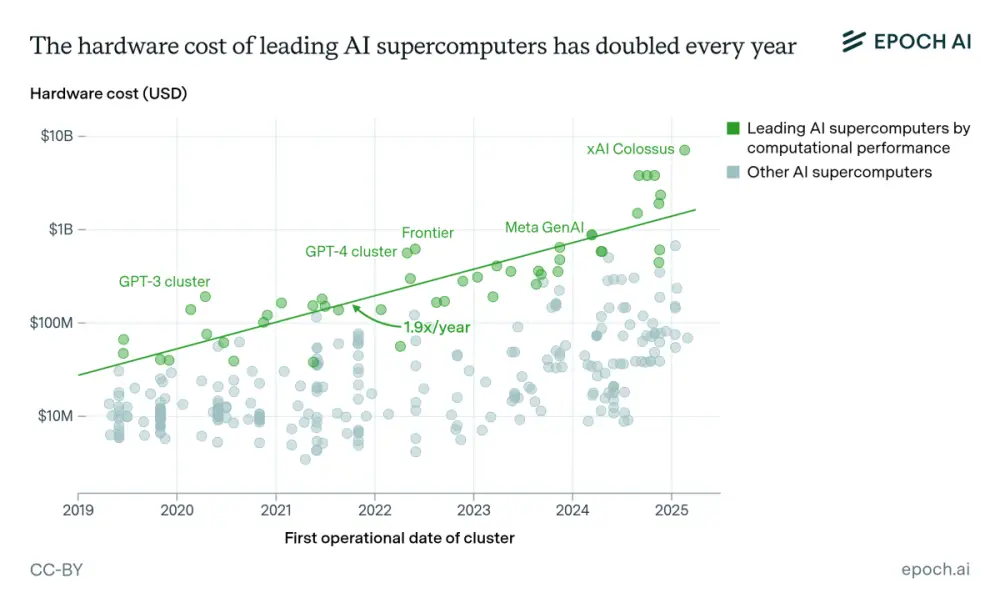

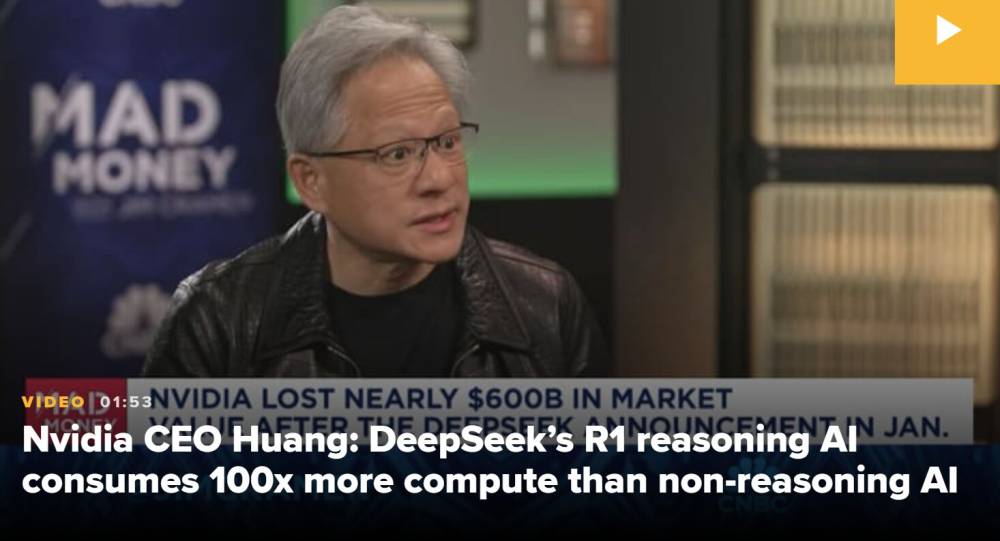

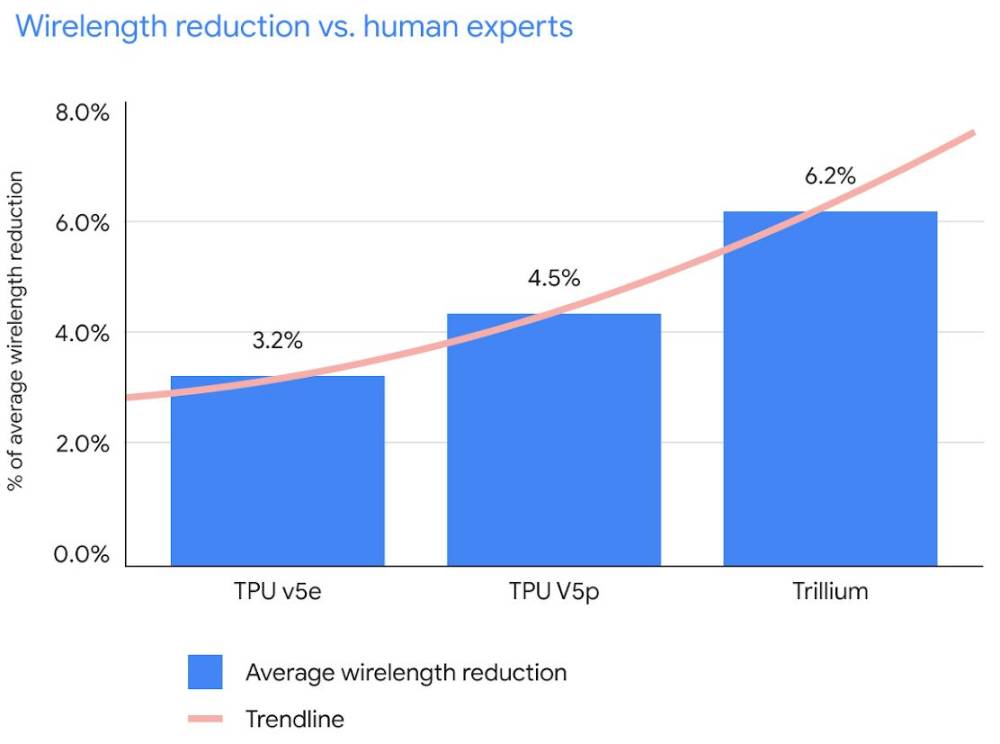

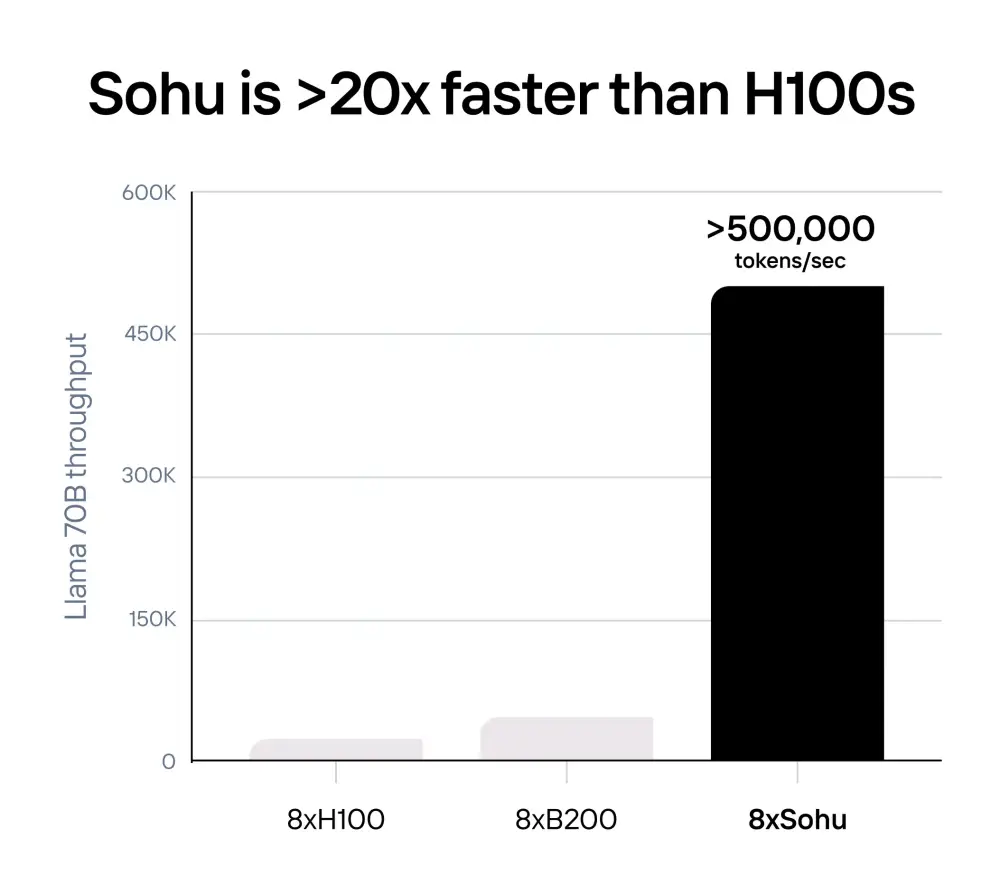

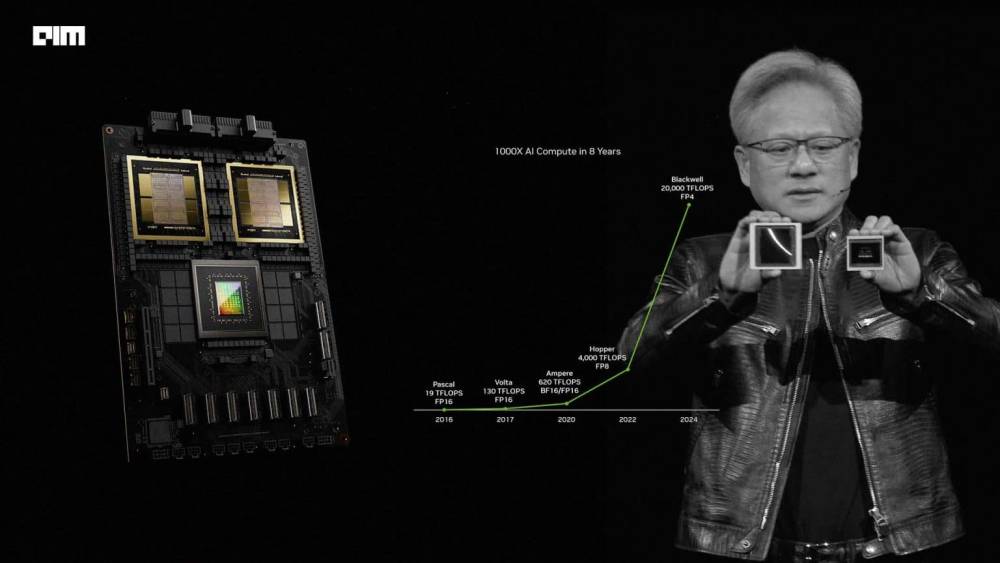

Chu kỳ đổi mới nhanh và gián đoạn. Tiến bộ liên tục trong công nghệ AI, như bộ xử lý, kiến trúc mô hình ngôn ngữ lớn (LLM) và tiêu thụ năng lượng, có thể nâng cao đáng kể hiệu quả. Ví dụ, vào tháng 2 năm 2025, công ty LLM Trung Quốc DeepSeek báo cáo rằng mô hình V3 của họ đạt được những cải tiến đáng kể về hiệu quả đào tạo và suy luận, đáng chú ý là giảm chi phí đào tạo khoảng 18 lần và chi phí suy luận khoảng 36 lần so với GPT-4o. Tuy nhiên, phân tích sơ bộ cho thấy những loại lợi ích hiệu quả này có thể sẽ bị bù đắp bởi việc tăng thử nghiệm và đào tạo trong thị trường AI rộng hơn. Kết quả là, lợi ích hiệu quả có thể không ảnh hưởng đáng kể đến nhu cầu sức mạnh tính toán tổng thể trong dài hạn.

Biểu đồ 1 Cả tải công việc AI và không phải AI sẽ là yếu tố thúc đẩy chính cho tăng trưởng nhu cầu năng lực trung tâm dữ liệu toàn cầu đến năm 2030.

Chỉ riêng nhu cầu AI sẽ cần 5.200 tỷ đô la đầu tư

Quy mô đầu tư

Để hiểu quy mô đầu tư hàng nghìn tỷ đô la cần thiết vào năm 2030, hãy xem xét những thống kê không liên quan sau đây minh họa quy mô vốn cần thiết:

Chúng tôi tính toán rằng các công ty trong chuỗi giá trị sức mạnh tính toán sẽ cần đầu tư 5.200 tỷ đô la vào trung tâm dữ liệu vào năm 2030 để đáp ứng nhu cầu AI toàn cầu. Chúng tôi dựa con số này trên phân tích mở rộng và các giả định chính, bao gồm dự báo 156 gigawatt (GW) nhu cầu năng lực trung tâm dữ liệu liên quan đến AI vào năm 2030, với 125 GW tăng thêm được bổ sung từ 2025 đến 2030. Con số 5.200 tỷ đô la này phản ánh quy mô đầu tư cần thiết để đáp ứng nhu cầu ngày càng tăng về sức mạnh tính toán AI—một cam kết vốn đáng kể nhấn mạnh tầm quan trọng của thách thức phía trước (xem sidebar "Quy mô đầu tư").

Sidebar "Quy mô đầu tư":

Lao động. 500 tỷ đô la chi phí lao động tương đương với khoảng 12 tỷ giờ lao động (6 triệu người làm việc toàn thời gian trong cả năm).

Cáp quang. 150 tỷ đô la cáp quang tương đương với việc lắp đặt 3 triệu dặm cáp quang—đủ để bao quanh Trái Đất 120 lần.

Sản xuất điện. 300 tỷ đô la sản xuất điện tương đương với việc bổ sung 150 đến 200 gigawatt khí đốt, đủ để cung cấp điện cho 150 triệu hộ gia đình trong một năm—nhiều hơn tổng số hộ gia đình ở Hoa Kỳ.

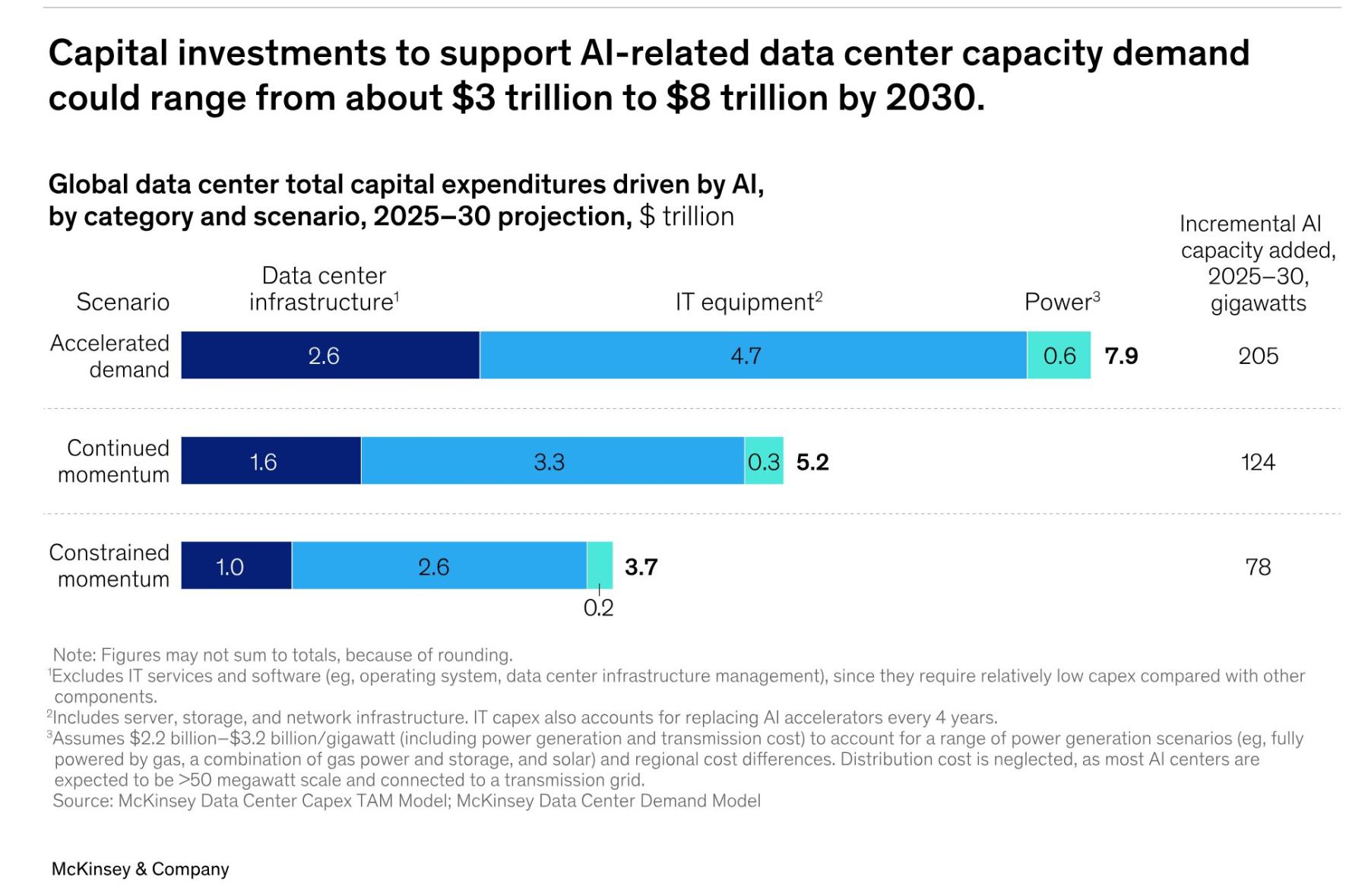

Trong bối cảnh không chắc chắn về nhu cầu tương lai đối với sức mạnh tính toán, chúng tôi đã tạo ra 3 kịch bản đầu tư từ nhu cầu hạn chế đến tăng tốc (Biểu đồ 2). Trong kịch bản đầu tiên trong 3 kịch bản của chúng tôi, tăng trưởng tăng tốc đáng kể và 205 GW năng lực trung tâm dữ liệu liên quan đến AI tăng thêm được bổ sung từ 2025 đến 2030. Điều này sẽ đòi hỏi ước tính 7.900 tỷ đô la chi phí vốn. Kịch bản thứ hai là kịch bản chúng tôi sử dụng trong bài viết này: Nhu cầu tăng, nhưng không nhiều như trong kịch bản đầu tiên, và chi phí vốn dự kiến là 5.200 tỷ đô la. Trong kịch bản thứ ba của chúng tôi, trong đó nhu cầu bị hạn chế hơn, với 78 GW tăng thêm được bổ sung trong 5 năm tới, tổng chi phí vốn là 3.700 tỷ đô la (xem sidebar "Phương pháp luận").

Side Bar: Phương pháp luận

Ước tính chi phí vốn trong bài viết này được lấy từ mô hình nhu cầu trung tâm dữ liệu độc quyền của McKinsey, dự báo năng lực trung tâm dữ liệu theo nhiều kịch bản hình thành từ các yếu tố như hạn chế cung ứng bán dẫn, áp dụng AI doanh nghiệp, cải tiến hiệu quả và thách thức quy định. Yêu cầu đầu tư được tính toán bằng cách chuyển đổi dự báo nhu cầu về năng lực gigawatt thành chi phí vốn trên các danh mục chi phí chính, bao gồm năng lượng (ví dụ: sản xuất, truyền tải), cơ sở hạ tầng trung tâm dữ liệu (ví dụ: điện, cơ khí, địa điểm, vỏ) và thiết bị CNTT (ví dụ: bộ tăng tốc AI, mạng, lưu trữ).

Biểu đồ 2 Đầu tư vốn để hỗ trợ nhu cầu năng lực trung tâm dữ liệu liên quan đến AI có thể dao động từ khoảng 3.000 tỷ đến 8.000 tỷ đô la vào năm 2030.

Trong bất kỳ kịch bản nào, đây là những con số đầu tư đáng kinh ngạc. Chúng được thúc đẩy bởi một số yếu tố:

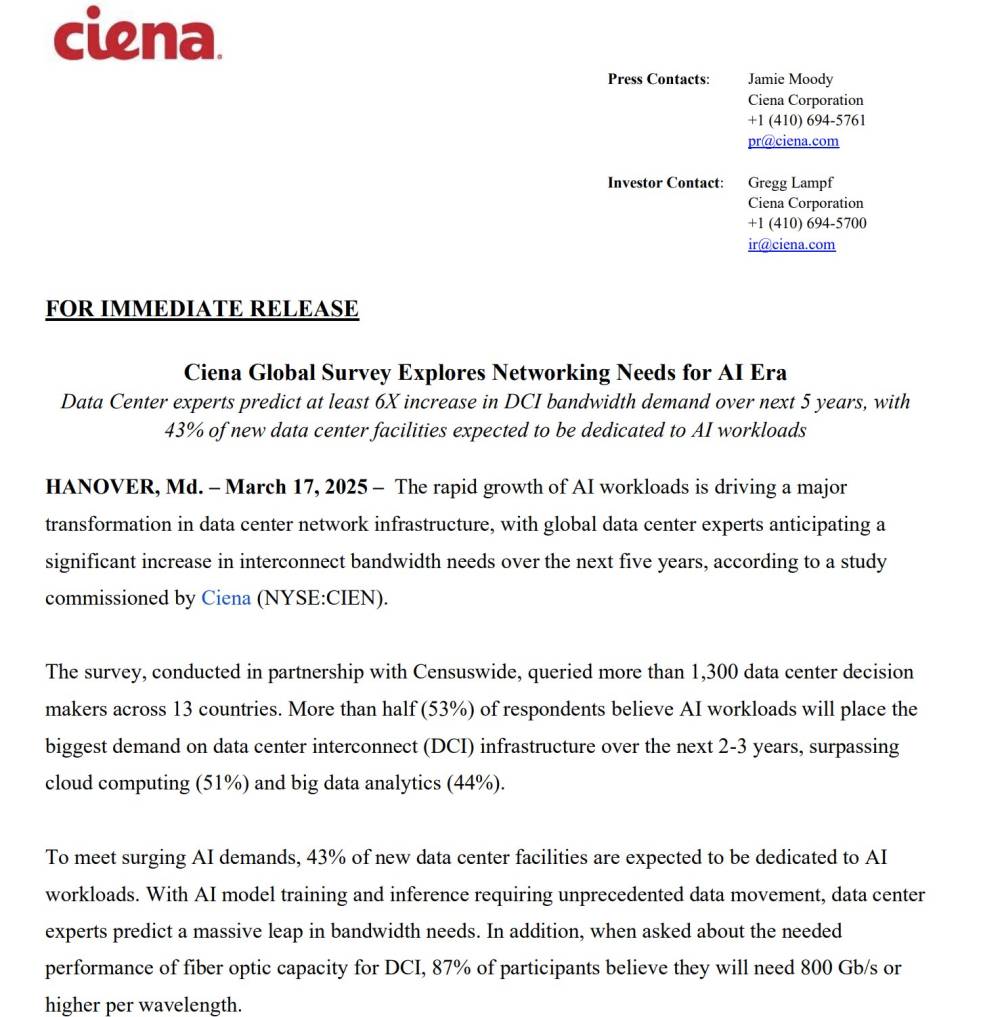

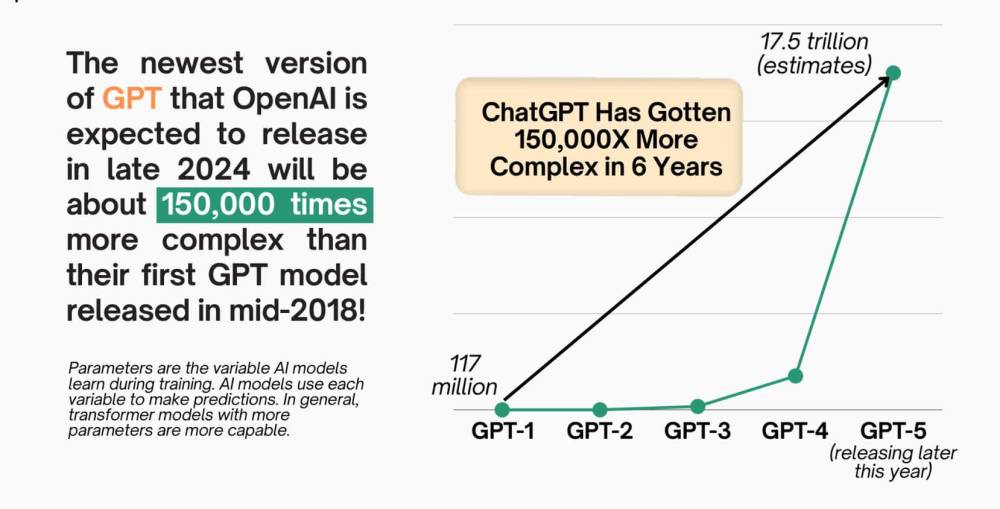

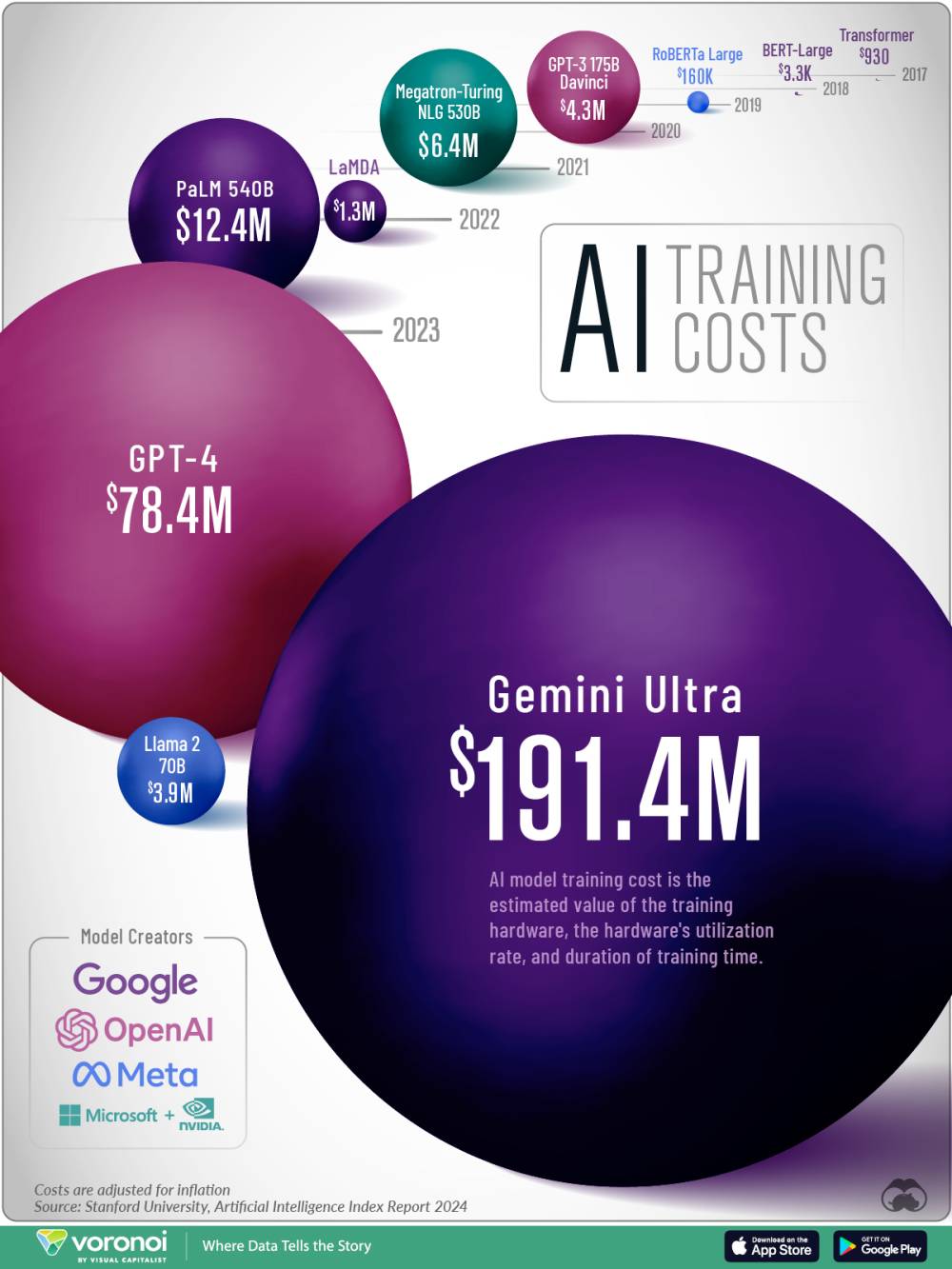

Áp dụng hàng loạt AI tạo sinh. Các mô hình nền tảng làm nền tảng cho AI tạo sinh đòi hỏi nguồn lực sức mạnh tính toán đáng kể để đào tạo và vận hành. Cả tải công việc đào tạo và suy luận đều đóng góp vào tăng trưởng cơ sở hạ tầng, với suy luận dự kiến sẽ trở thành tải công việc chủ đạo vào năm 2030.

Tích hợp doanh nghiệp. Triển khai các ứng dụng được hỗ trợ bởi AI trên nhiều ngành—từ ô tô đến dịch vụ tài chính—đòi hỏi sức mạnh điện toán đám mây lớn. Khi các trường hợp sử dụng tăng lên, các ứng dụng AI sẽ trở nên tinh vi hơn, tích hợp các mô hình nền tảng chuyên biệt được điều chỉnh cho các lĩnh vực cụ thể.

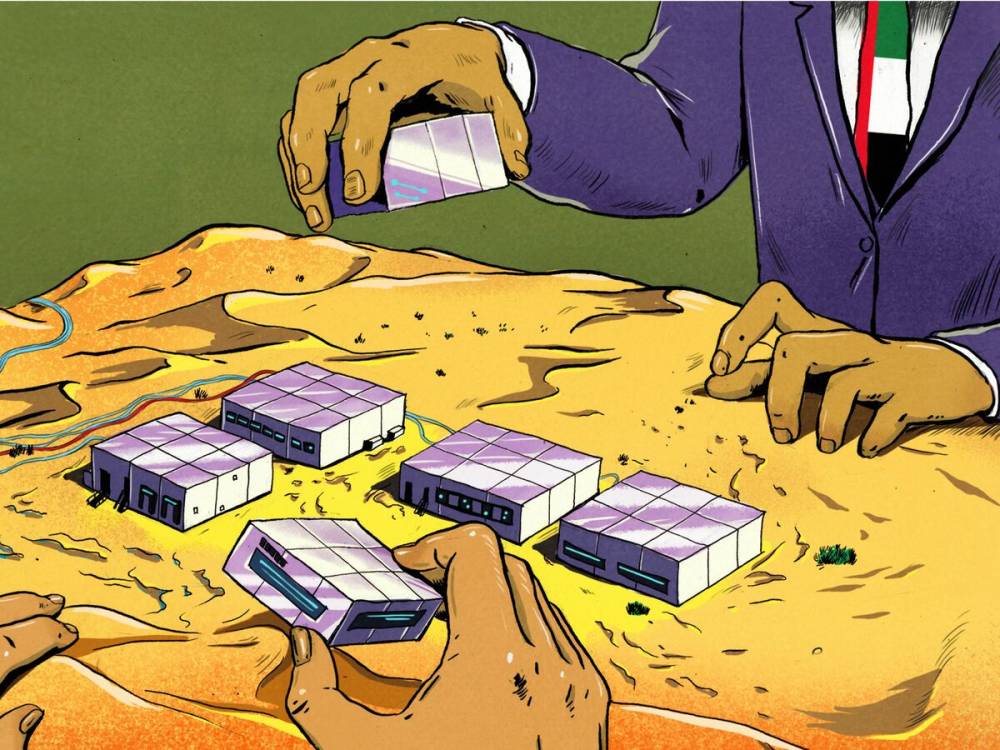

Cuộc đua cơ sở hạ tầng cạnh tranh. Các nhà cung cấp điện toán đám mây lớn và doanh nghiệp đang đua nhau xây dựng năng lực AI độc quyền để giành lợi thế cạnh tranh, điều này thúc đẩy việc xây dựng ngày càng nhiều trung tâm dữ liệu. Những "nhà xây dựng" này (như được mô tả chi tiết hơn dưới đây) hy vọng giành được lợi thế cạnh tranh bằng cách đạt quy mô, tối ưu hóa trên các ngăn xếp công nghệ trung tâm dữ liệu và cuối cùng là giảm chi phí tính toán.

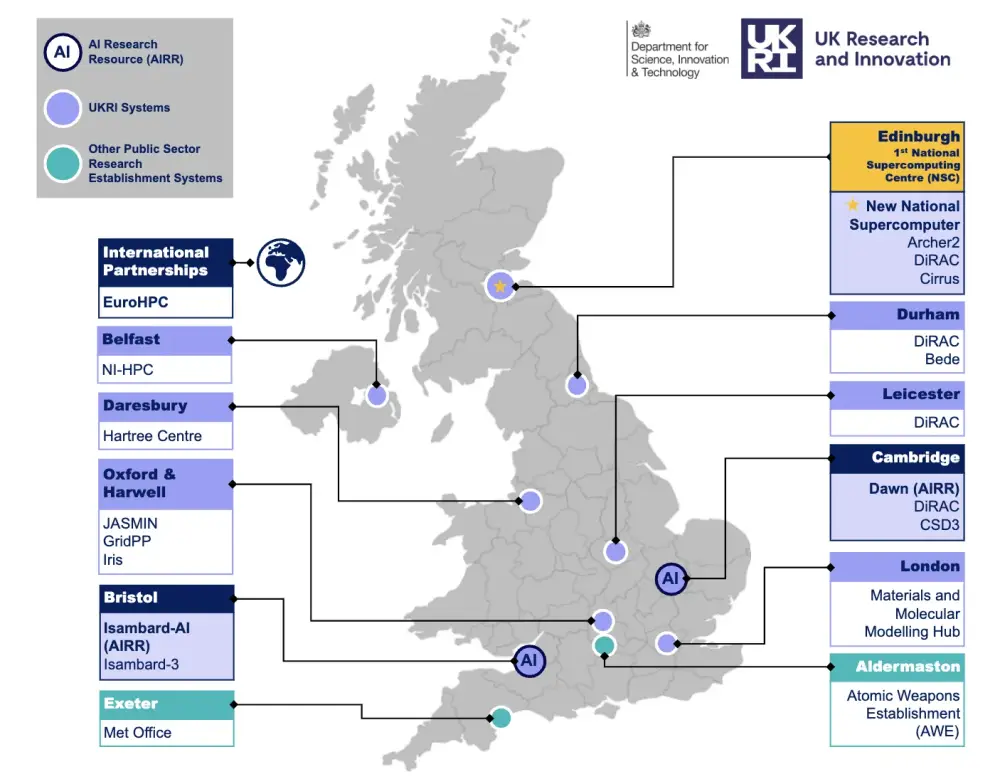

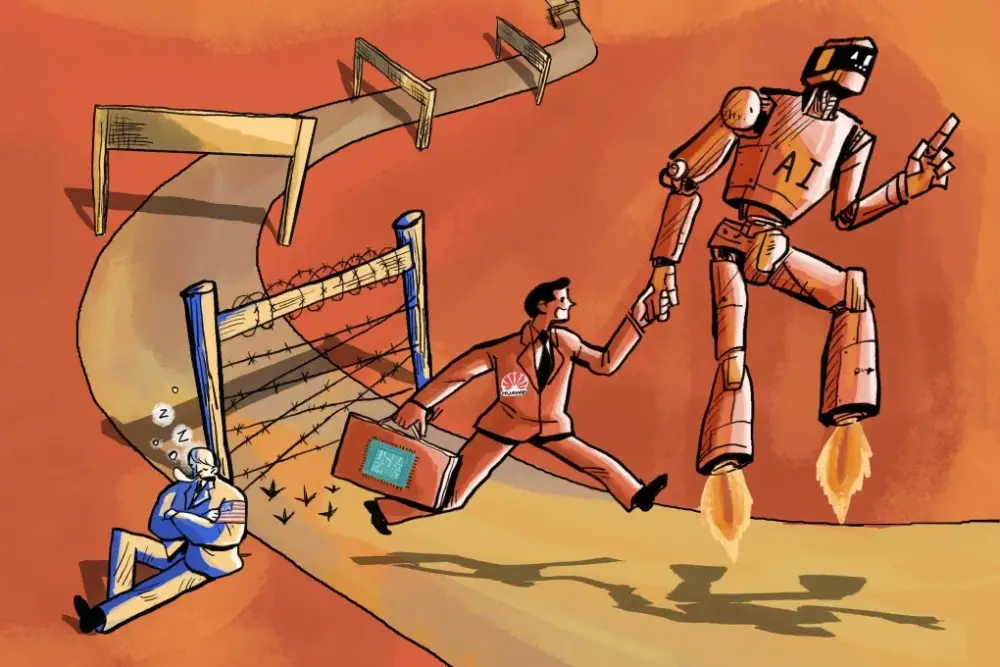

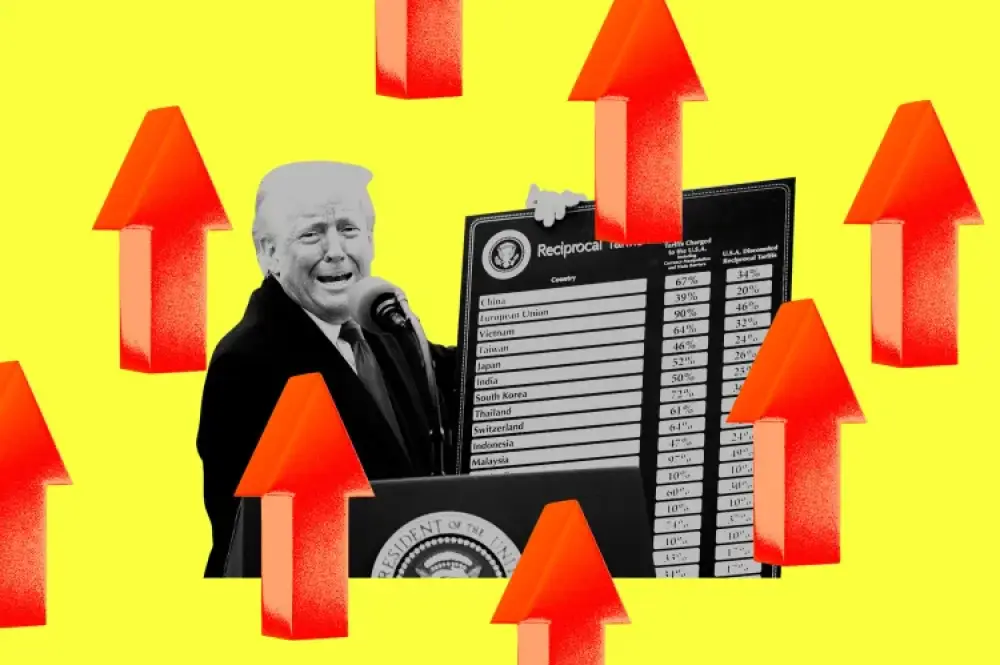

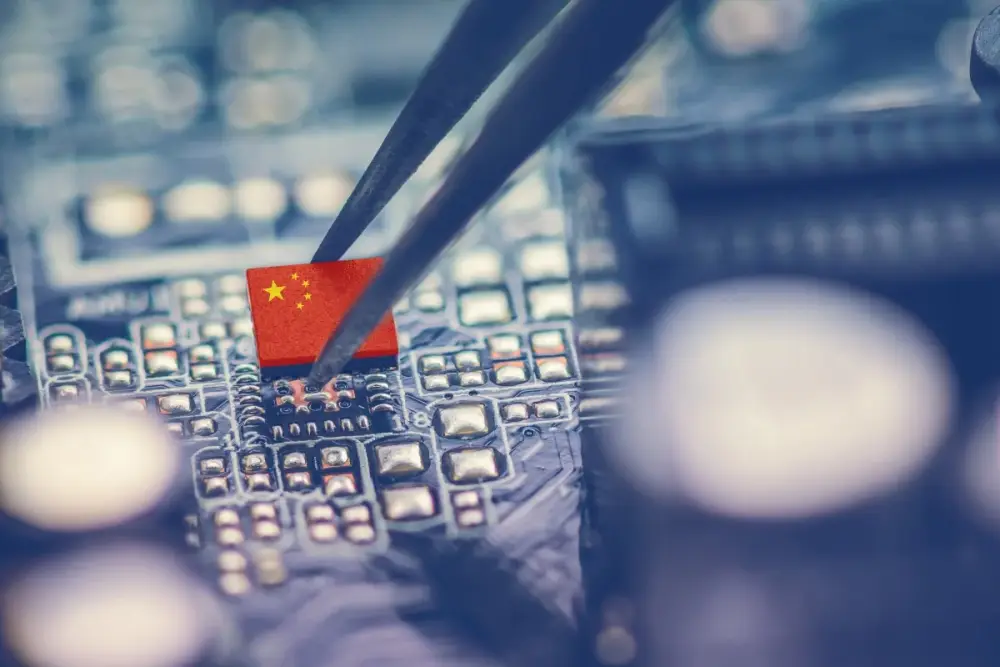

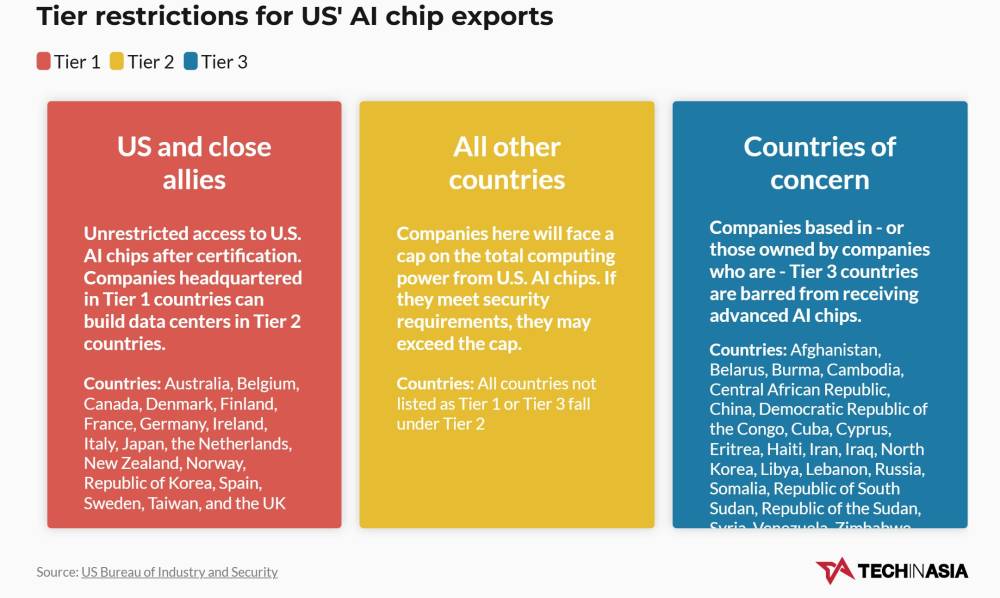

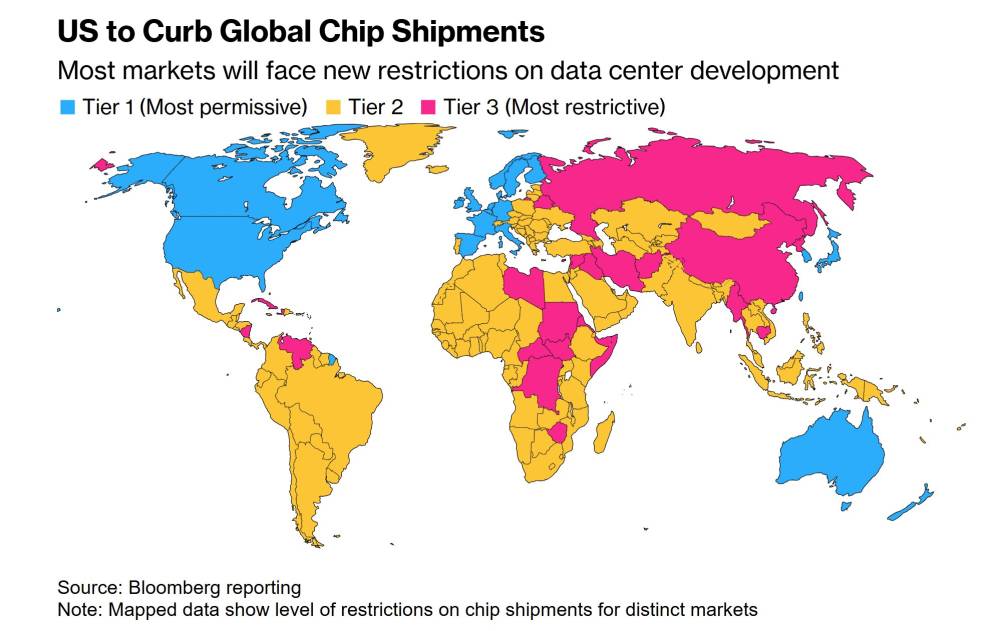

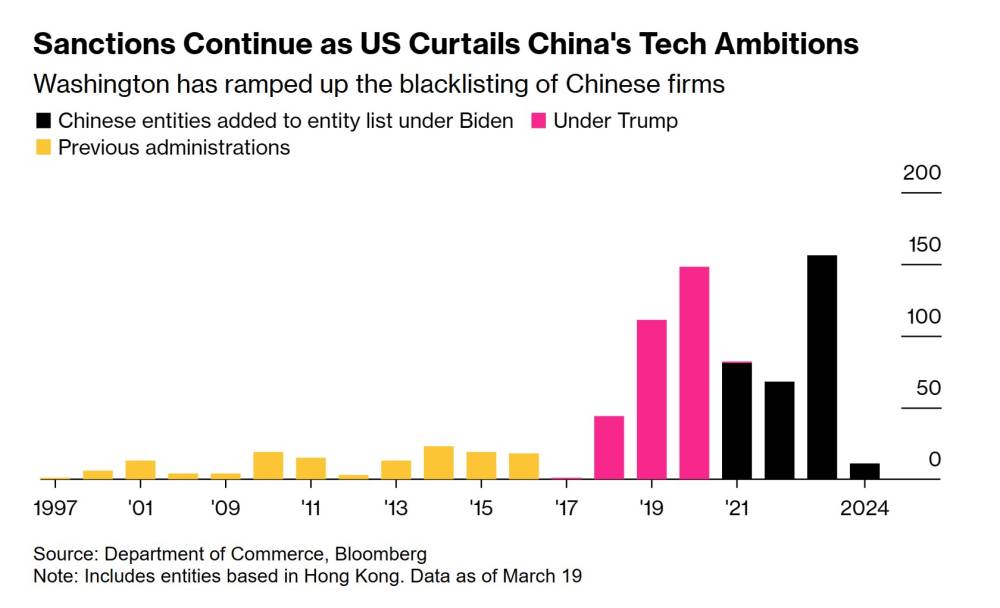

Ưu tiên địa chính trị. Các chính phủ đang đầu tư mạnh mẽ vào cơ sở hạ tầng AI để tăng cường an ninh, lãnh đạo kinh tế và độc lập công nghệ.

Đầu tư đang đi đâu?

Để đánh giá dự báo đầu tư 5.200 tỷ đô la cho cơ sở hạ tầng AI của chúng tôi, điều quan trọng cần lưu ý là phân tích của chúng tôi có thể đếm thiếu tổng đầu tư vốn cần thiết, vì ước tính của chúng tôi chỉ định lượng đầu tư vốn cho 3 trong 5 nguyên mẫu nhà đầu tư sức mạnh tính toán—nhà xây dựng, nhà cung cấp năng lượng và nhà phát triển và thiết kế công nghệ—trực tiếp tài trợ cơ sở hạ tầng và công nghệ nền tảng cần thiết cho tăng trưởng AI (xem sidebar "5 loại nhà đầu tư trung tâm dữ liệu"). Khoảng 15% (0,8 nghìn tỷ đô la) đầu tư sẽ chảy vào nhà xây dựng cho đất đai, vật liệu và phát triển địa điểm. 25% khác (1,3 nghìn tỷ đô la) sẽ được phân bổ cho nhà cung cấp năng lượng cho sản xuất và truyền tải điện, làm mát và thiết bị điện. Phần lớn nhất của đầu tư, 60% (3,1 nghìn tỷ đô la), sẽ dành cho nhà phát triển và thiết kế công nghệ, sản xuất chip và phần cứng máy tính cho trung tâm dữ liệu. Hai nguyên mẫu nhà đầu tư khác, nhà vận hành, như nhà cung cấp điện toán đám mây lớn và nhà cung cấp dịch vụ đặt chỗ, và kiến trúc sư AI, xây dựng mô hình và ứng dụng AI, cũng đầu tư vào sức mạnh tính toán, đặc biệt là trong các lĩnh vực như tự động hóa được AI hỗ trợ và phần mềm trung tâm dữ liệu. Nhưng việc định lượng đầu tư sức mạnh tính toán của họ là một thách thức vì nó trùng lặp với chi tiêu R&D rộng hơn của họ.

Side bar: 5 loại nhà đầu tư trung tâm dữ liệu

Khi AI thúc đẩy sự gia tăng nhu cầu sức mạnh tính toán, năm loại tổ chức đang dẫn đầu các khoản đầu tư vốn lớn cần thiết để mở rộng quy mô trung tâm dữ liệu:

Nhà xây dựng: nhà phát triển bất động sản, công ty thiết kế và xây dựng mở rộng và nâng cấp trung tâm dữ liệu, như Turner Construction và AECOM

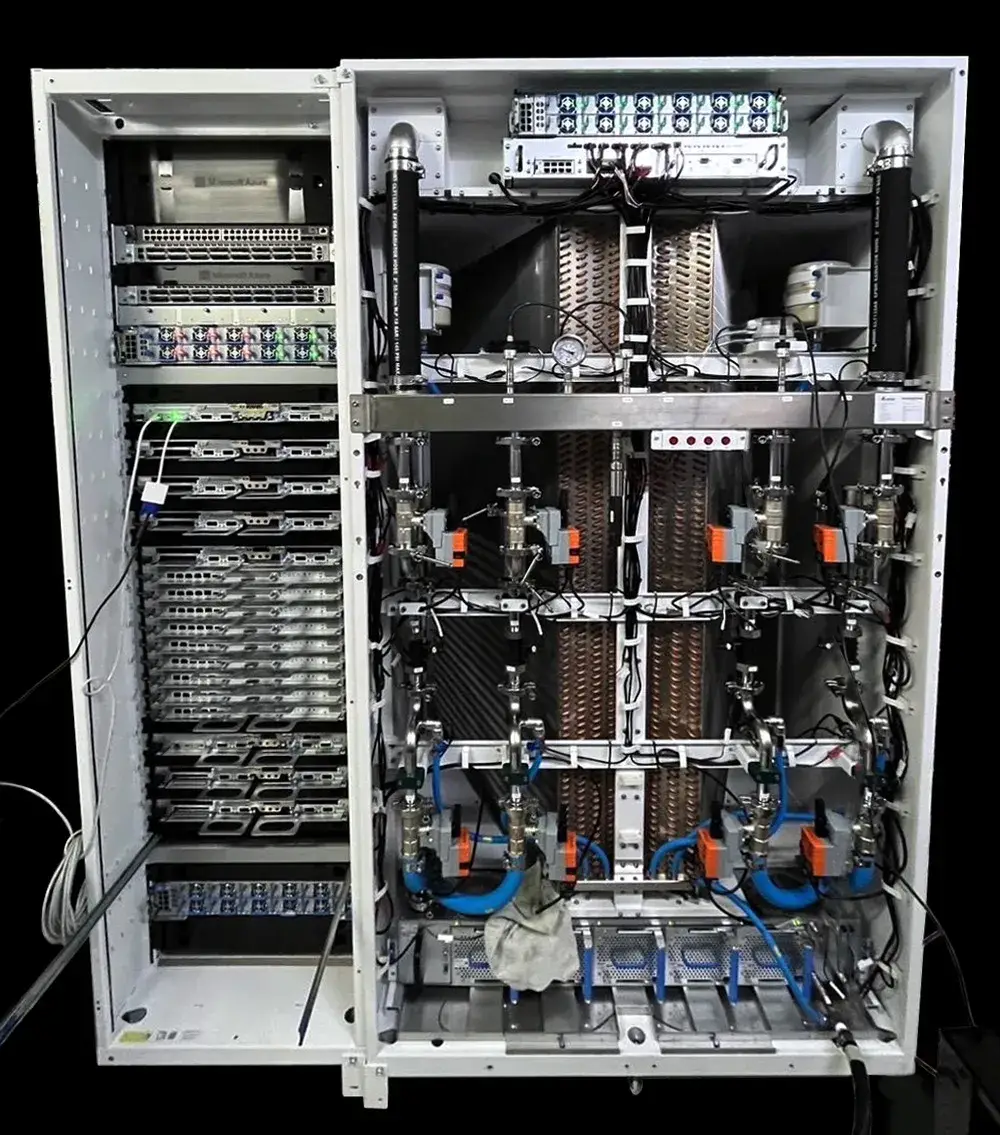

Nhà cung cấp năng lượng: các công ty cung cấp điện và hệ thống làm mát thiết yếu cho hoạt động trung tâm dữ liệu, bao gồm các tiện ích như Duke Energy và Entergy và nhà cung cấp cơ sở hạ tầng và thiết bị như Schneider Electric và Vertiv

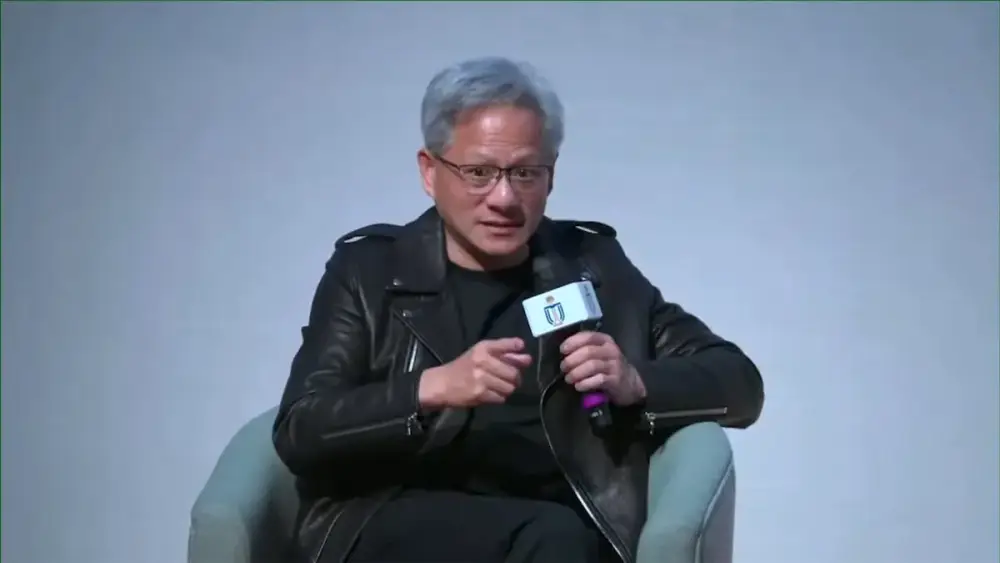

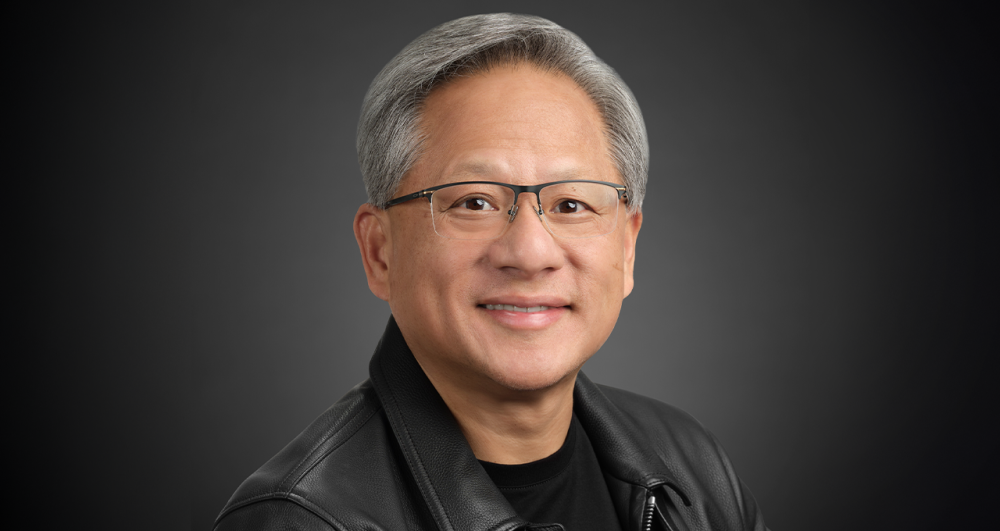

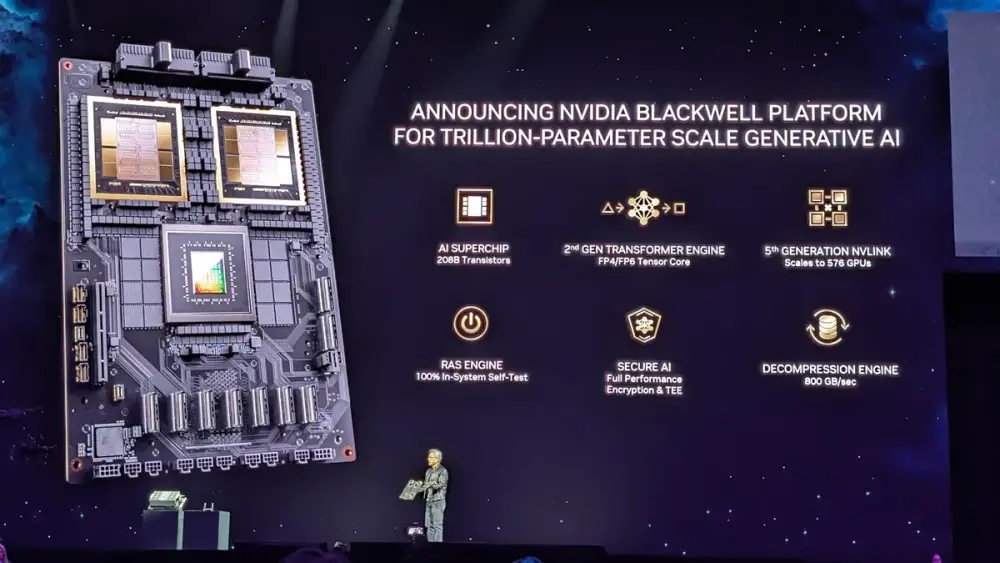

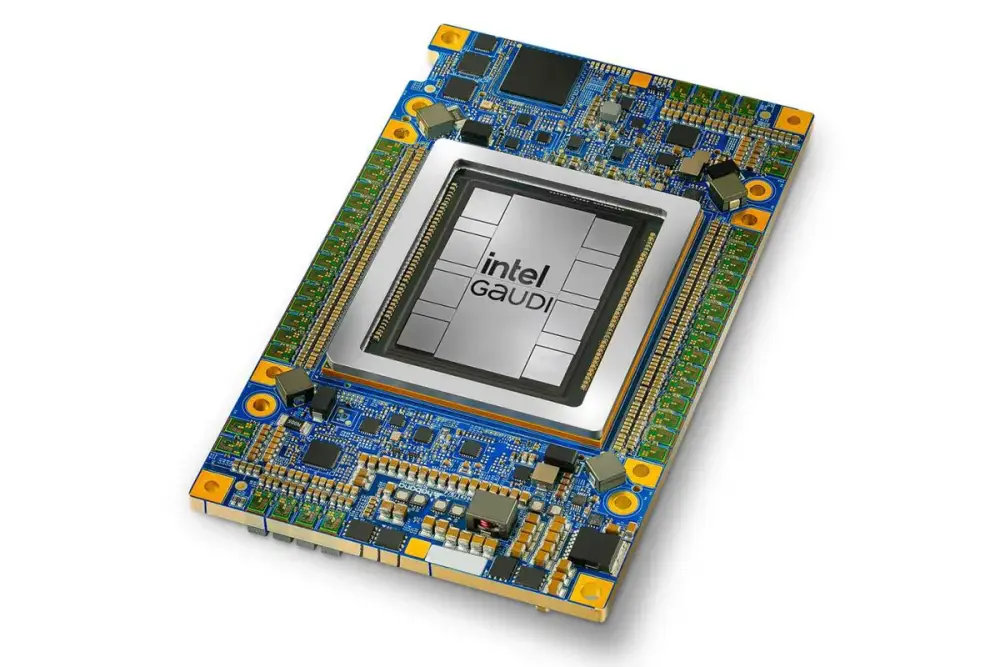

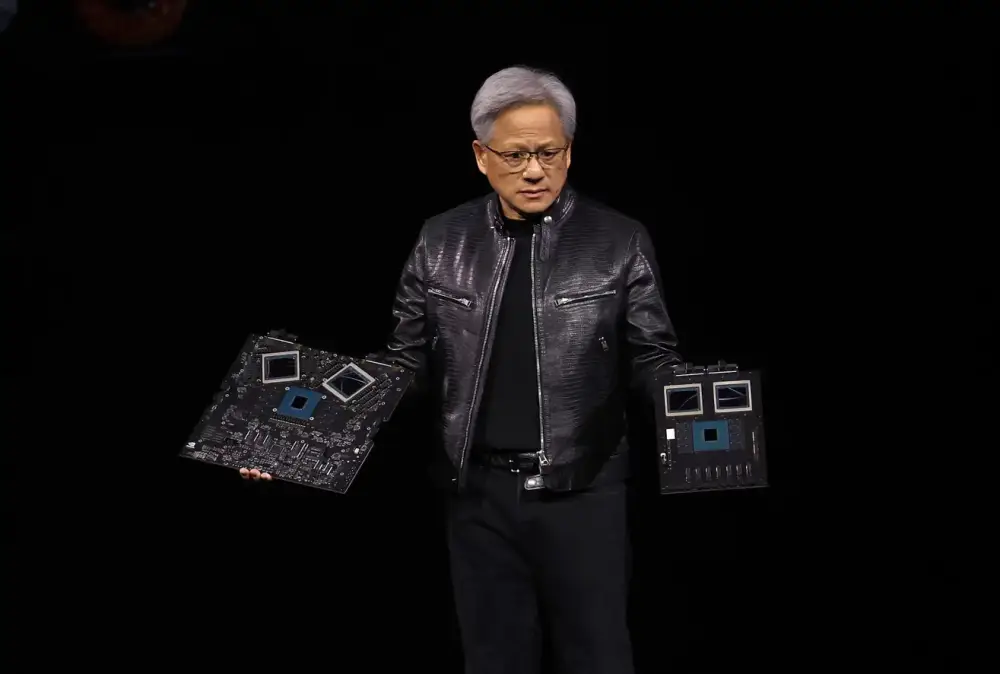

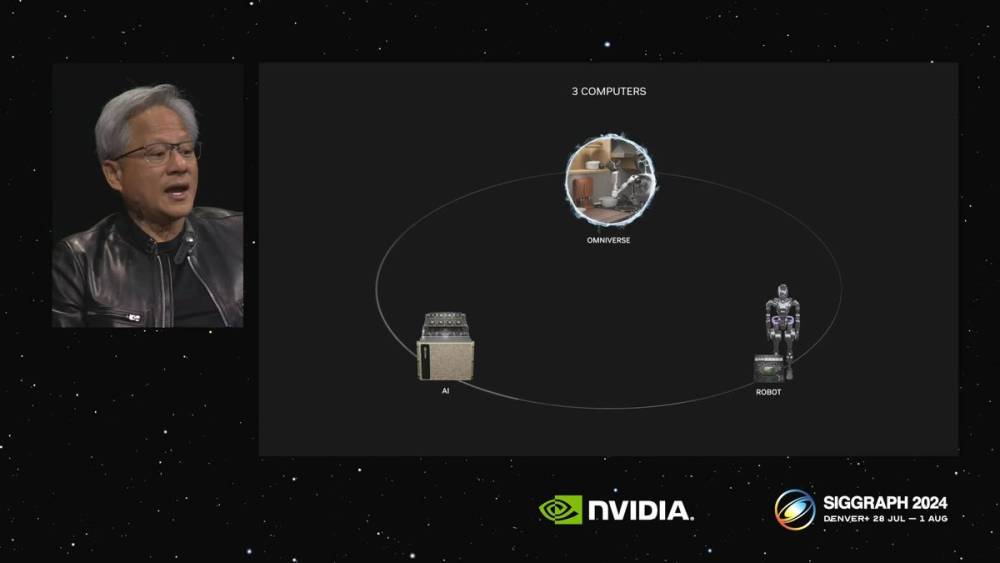

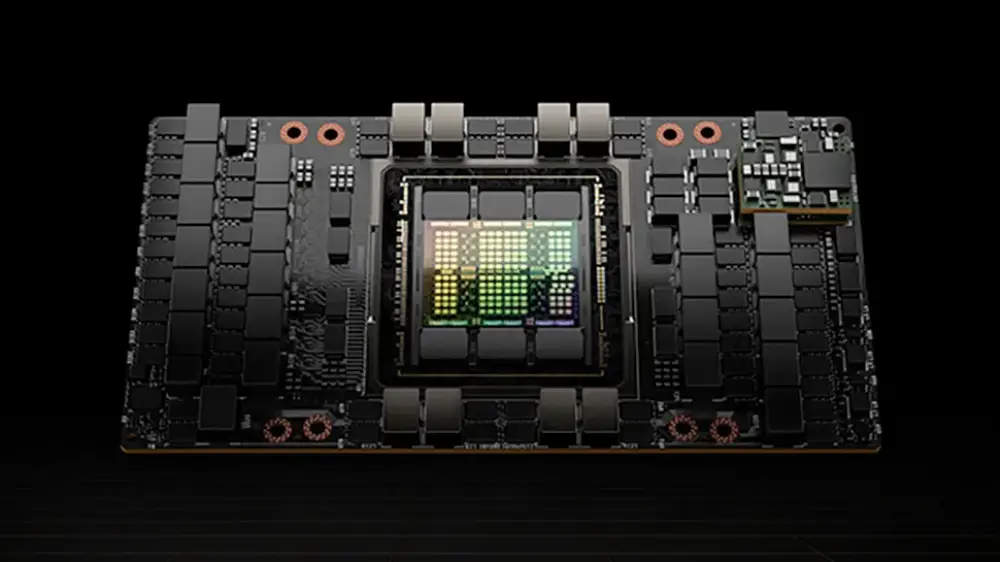

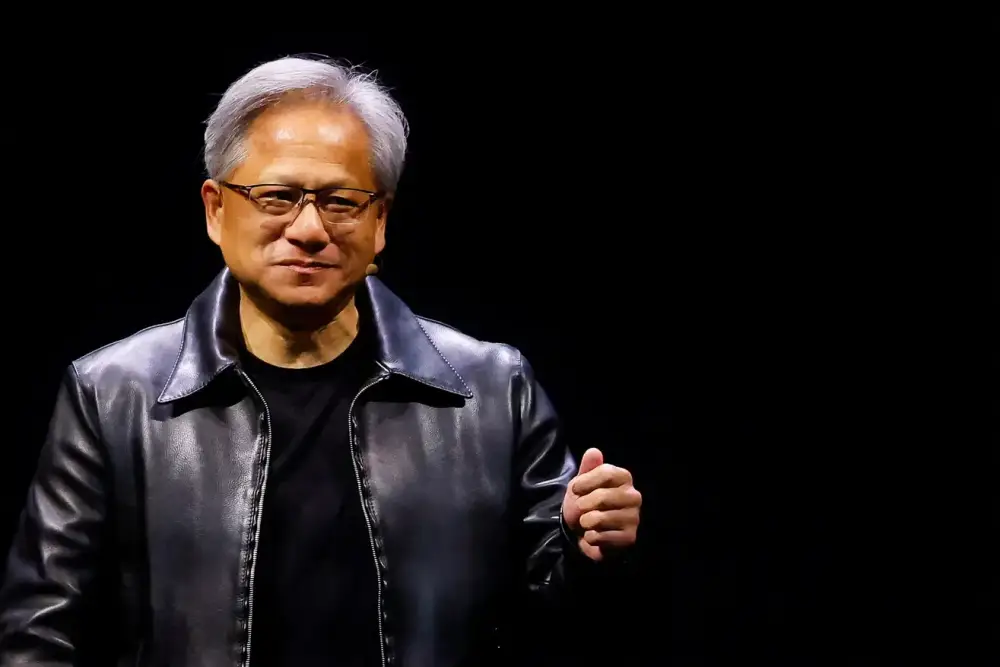

Nhà phát triển và thiết kế công nghệ: các công ty bán dẫn phát triển chip cung cấp năng lượng cho tải công việc AI, như NVIDIA và Intel, và nhà cung cấp phần cứng máy tính như Foxconn và Flex

Nhà vận hành: nhà cung cấp đám mây và công ty đặt chỗ sở hữu và vận hành trung tâm dữ liệu quy mô lớn, như Amazon Web Services, Google Cloud và Equinix

Kiến trúc sư AI: các công ty phát triển mô hình và cơ sở hạ tầng AI, bao gồm OpenAI và Anthropic

Mặc dù có những yêu cầu vốn dự kiến này, nghiên cứu của chúng tôi cho thấy mức đầu tư hiện tại kém hơn nhu cầu. Trong hàng chục cuộc phỏng vấn khách hàng, chúng tôi nhận thấy các CEO ngần ngại đầu tư vào năng lực sức mạnh tính toán ở mức tối đa vì họ có tầm nhìn hạn chế về nhu cầu tương lai. Sự không chắc chắn về việc liệu việc áp dụng AI sẽ tiếp tục tăng nhanh và thực tế là các dự án cơ sở hạ tầng có thời gian dẫn dắt dài khiến các công ty khó đưa ra quyết định đầu tư sáng suốt. Nhiều công ty không chắc liệu chi phí vốn lớn cho cơ sở hạ tầng AI ngày nay sẽ tạo ra ROI đo lường được trong tương lai. Vậy làm thế nào để các nhà lãnh đạo kinh doanh tự tin tiến hành đầu tư của họ? Bước đầu tiên, họ có thể xác định vị trí của tổ chức mình trong hệ sinh thái sức mạnh tính toán.

5 nguyên mẫu nhà đầu tư cơ sở hạ tầng AI

Ai là những nhà đầu tư đứng sau cuộc đua hàng nghìn tỷ đô la để tài trợ cho sức mạnh tính toán AI? Chúng tôi đã xác định năm nguyên mẫu nhà đầu tư chính, mỗi nguyên mẫu đang điều hướng những thách thức và cơ hội riêng biệt, và chi tiết họ có thể chi bao nhiêu trong năm năm tới.

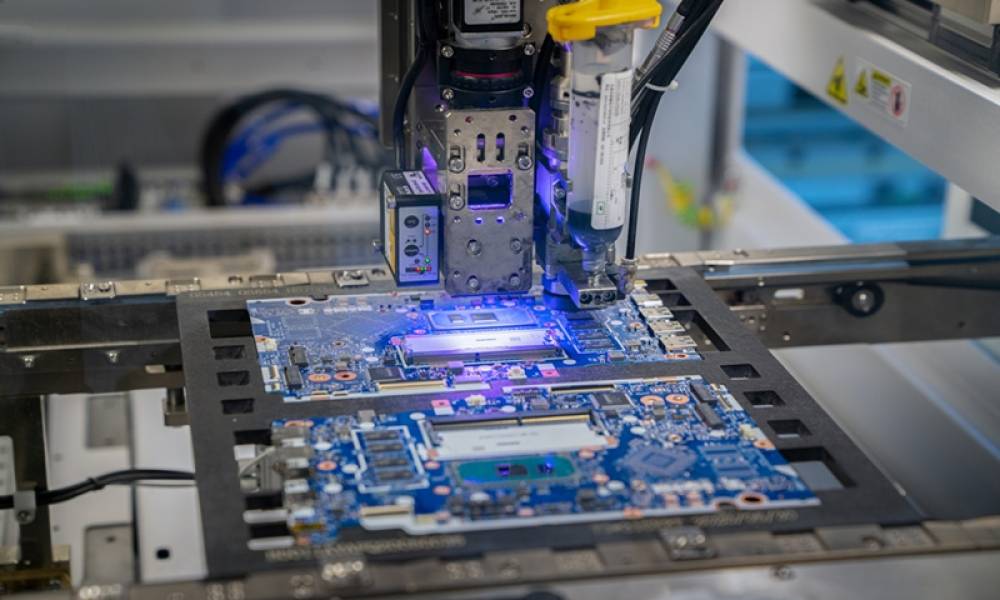

1. Nhà xây dựng

Họ là ai: nhà phát triển bất động sản, công ty thiết kế và xây dựng mở rộng năng lực trung tâm dữ liệu Chi phí vốn tải công việc AI: 800 tỷ đô la Chi phí vốn tải công việc không phải AI: 100 tỷ đô la Đầu tư chính: thu mua đất đai và vật liệu, lao động có kỹ năng, phát triển địa điểm

Cơ hội. Nhà xây dựng tối ưu hóa lựa chọn địa điểm có thể bảo đảm vị trí đắc địa, giảm thời gian xây dựng và tích hợp phản hồi hoạt động sớm, đảm bảo triển khai nhanh hơn và hiệu quả trung tâm dữ liệu cao hơn.

Thách thức. Thiếu hụt lao động có thể ảnh hưởng đến sự sẵn có của kỹ thuật viên và công nhân xây dựng, trong khi hạn chế vị trí có thể giới hạn các lựa chọn lựa chọn địa điểm. Đồng thời, mật độ điện giá đỡ tăng có thể tạo ra thách thức về không gian và làm mát.

Giải pháp. Nhà xây dựng có tầm nhìn xa có thể tìm giải pháp cho các thách thức cốt lõi, thêm sự chắc chắn vào quyết định đầu tư của họ. Ví dụ, một số đang giải quyết vấn đề thiếu lao động bằng cách áp dụng thiết kế mô-đun hóa giúp hợp lý hóa quy trình xây dựng, chẳng hạn như xây dựng các thành phần lớn bên ngoài công trường có thể được lắp ráp tại chỗ.

2. Nhà cung cấp năng lượng

Họ là ai: tiện ích, nhà cung cấp năng lượng, nhà sản xuất thiết bị làm mát/điện và nhà điều hành viễn thông xây dựng cơ sở hạ tầng điện và kết nối cho trung tâm dữ liệu AI Chi phí vốn tải công việc AI: 1.300 tỷ đô la Chi phí vốn tải công việc không phải AI: 200 tỷ đô la Đầu tư chính: sản xuất điện (nhà máy, đường dây truyền tải), giải pháp làm mát (làm mát bằng không khí, làm mát bằng chất lỏng trực tiếp đến chip, làm mát bằng ngâm), cơ sở hạ tầng điện (máy biến áp, máy phát điện), kết nối mạng (cáp quang, cáp)

Cơ hội. Nhà cung cấp năng lượng mở rộng quy mô cơ sở hạ tầng điện và đổi mới trong giải pháp năng lượng bền vững sẽ có vị thế tốt nhất để hưởng lợi từ nhu cầu năng lượng ngày càng tăng của các nhà cung cấp điện toán đám mây lớn.

Thách thức. Cung cấp điện cho trung tâm dữ liệu có thể bị đình trệ do điểm yếu lưới điện hiện có và giải quyết thách thức quản lý nhiệt từ mật độ bộ xử lý tăng vẫn là một trở ngại. Nhà cung cấp năng lượng cũng phải đối mặt với yêu cầu chuyển đổi năng lượng sạch và quy trình phê duyệt kết nối lưới điện kéo dài.

Giải pháp. Với hơn 1 nghìn tỷ đô la đầu tư, nhà cung cấp năng lượng đang tìm cách cung cấp điện đáng tin cậy trong khi thúc đẩy ROI. Họ đang đầu tư đáng kể vào công nghệ sản xuất điện mới nổi—bao gồm hạt nhân, địa nhiệt, thu giữ và lưu trữ carbon, và lưu trữ năng lượng dài hạn. Họ cũng đang tăng gấp đôi nỗ lực đưa càng nhiều công suất lên mạng càng nhanh càng tốt trên cả nguồn tái tạo và cơ sở hạ tầng năng lượng truyền thống, như khí đốt và nhiên liệu hóa thạch. Điều thay đổi bây giờ là quy mô của nhu cầu đó, mang lại sự cấp bách mới để xây dựng công suất điện với tốc độ chưa từng có. Khi nhu cầu—đặc biệt là đối với năng lượng sạch—tăng vọt, sản xuất điện dự kiến sẽ tăng trưởng nhanh chóng, với năng lượng tái tạo dự kiến chiếm khoảng 45 đến 50% hỗn hợp năng lượng vào năm 2030, tăng từ khoảng một phần ba hiện nay.

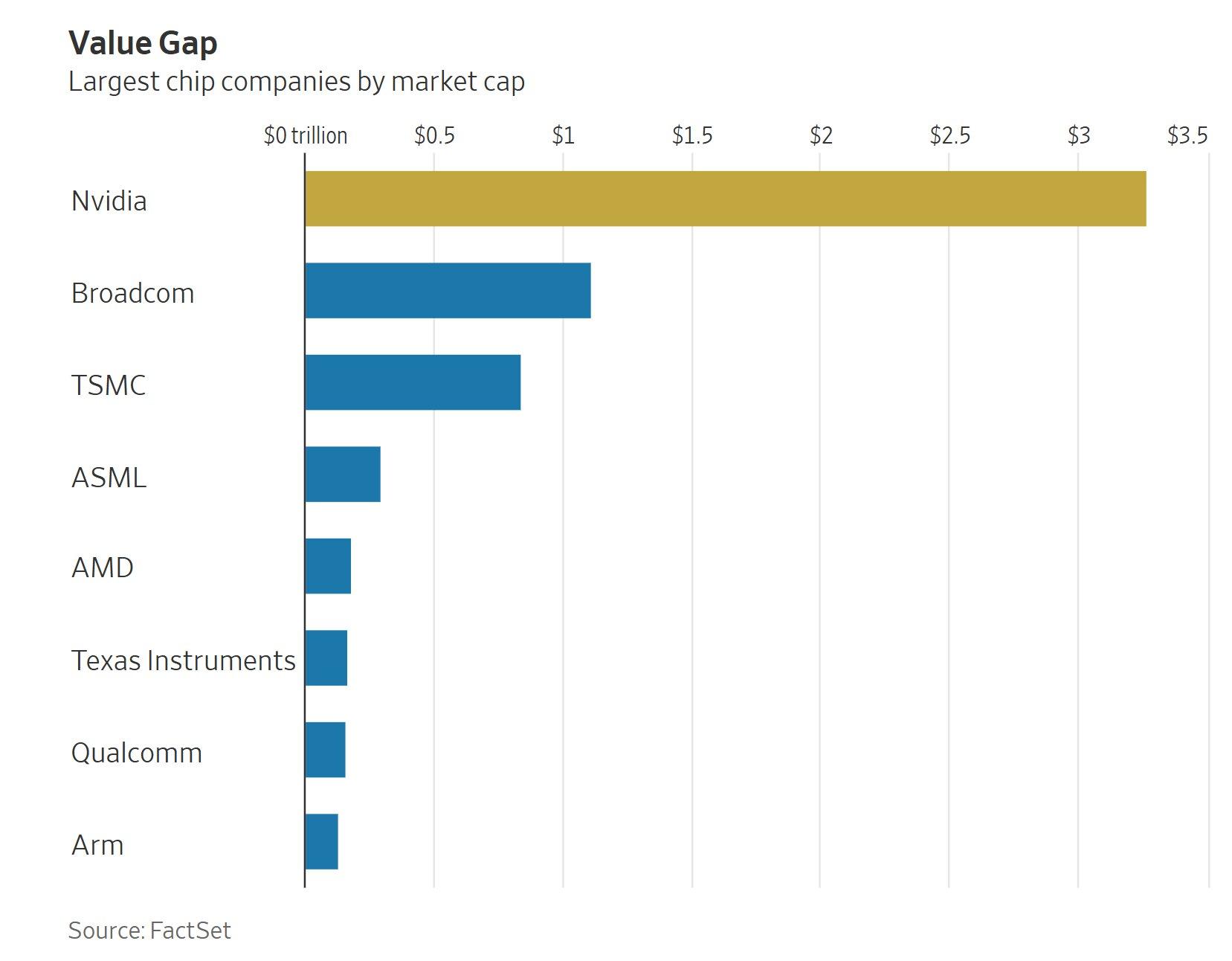

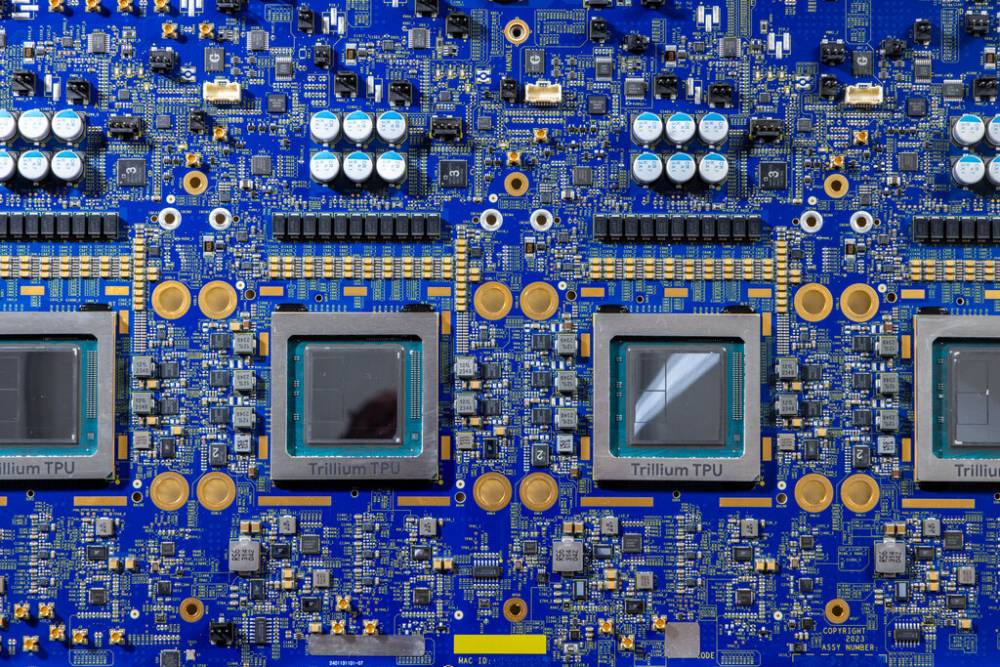

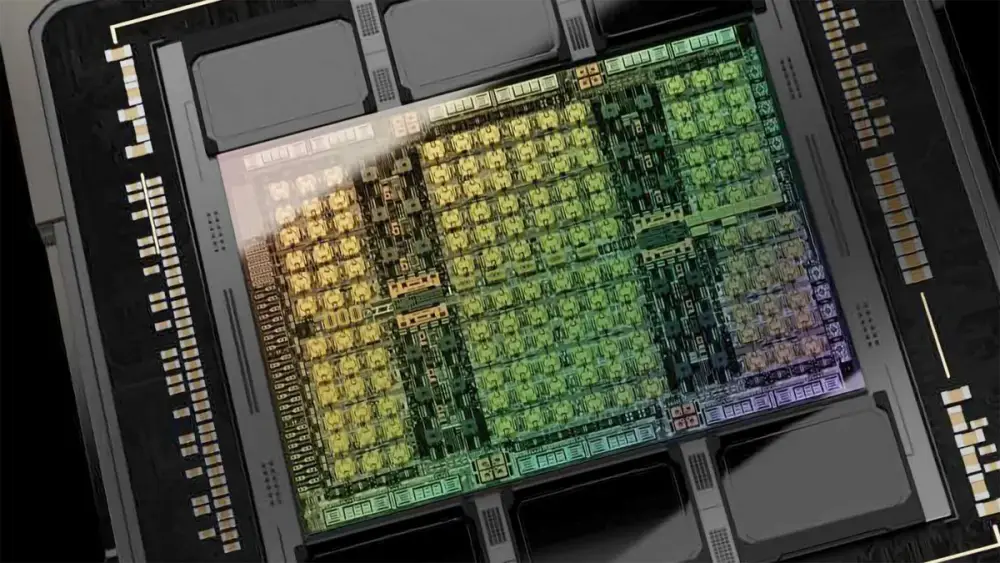

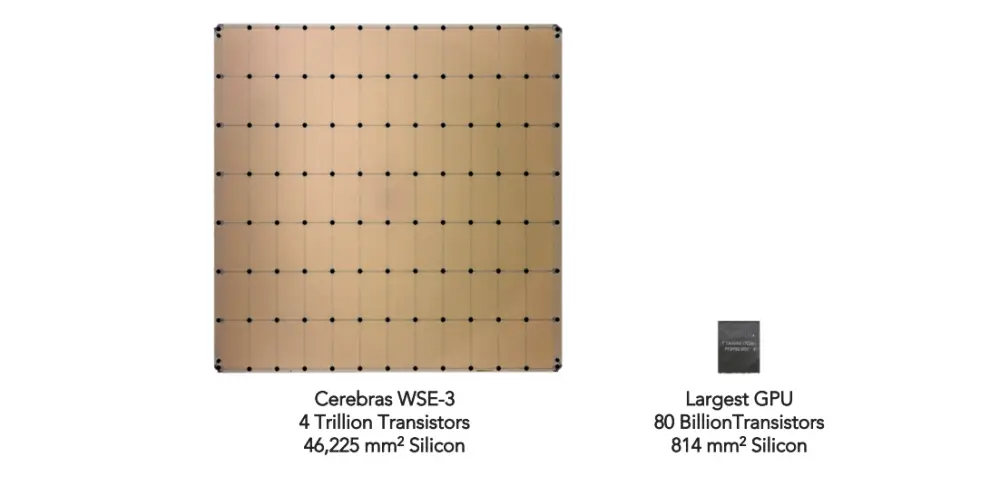

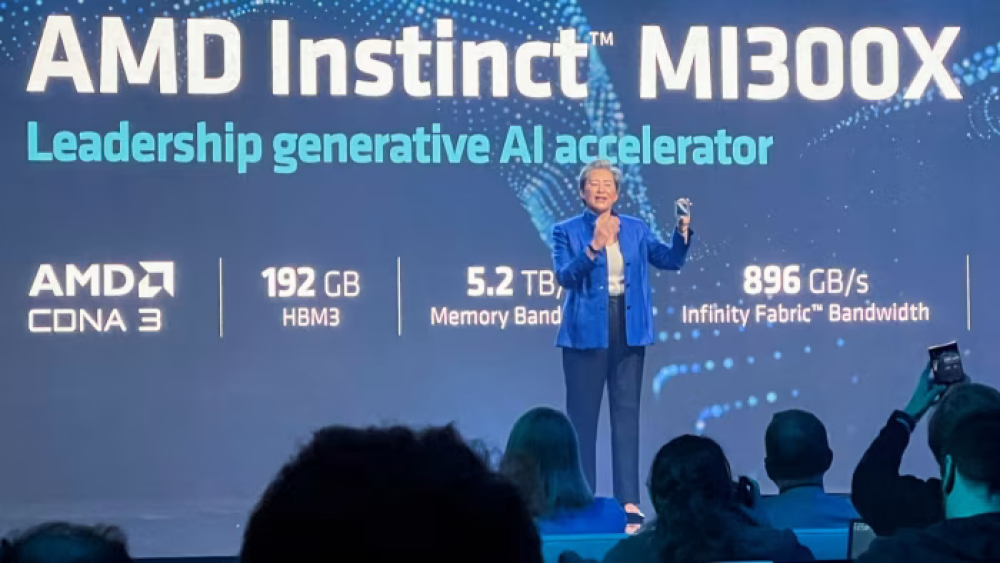

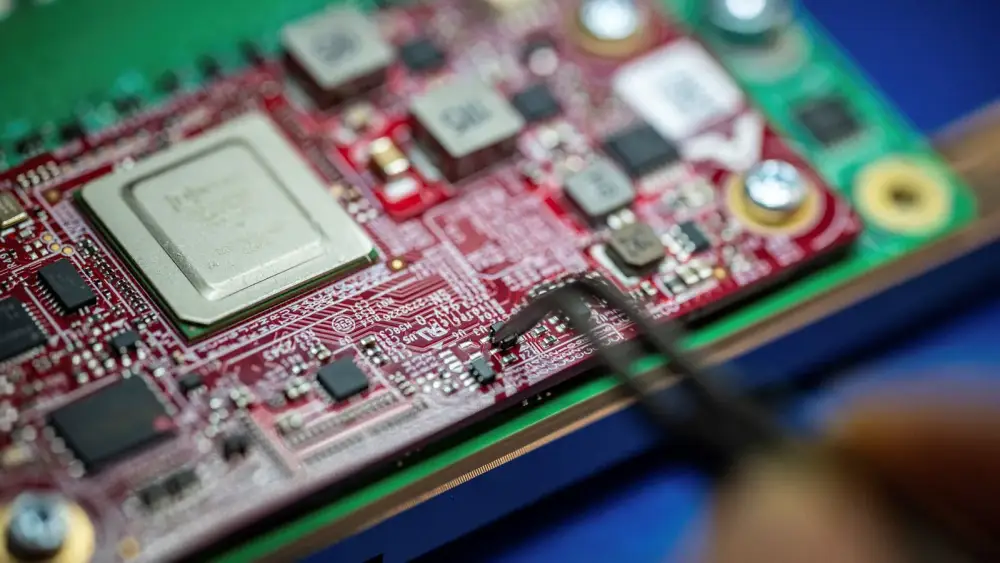

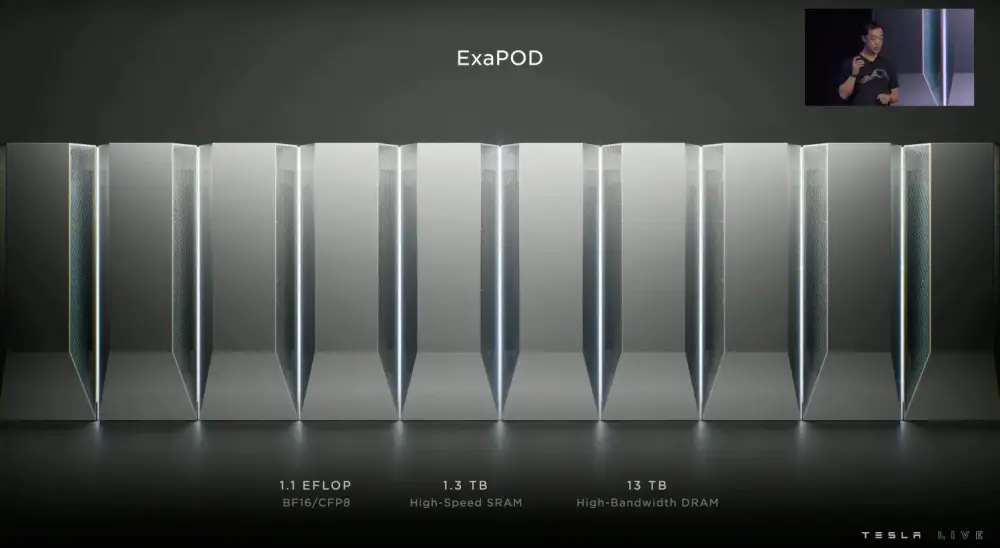

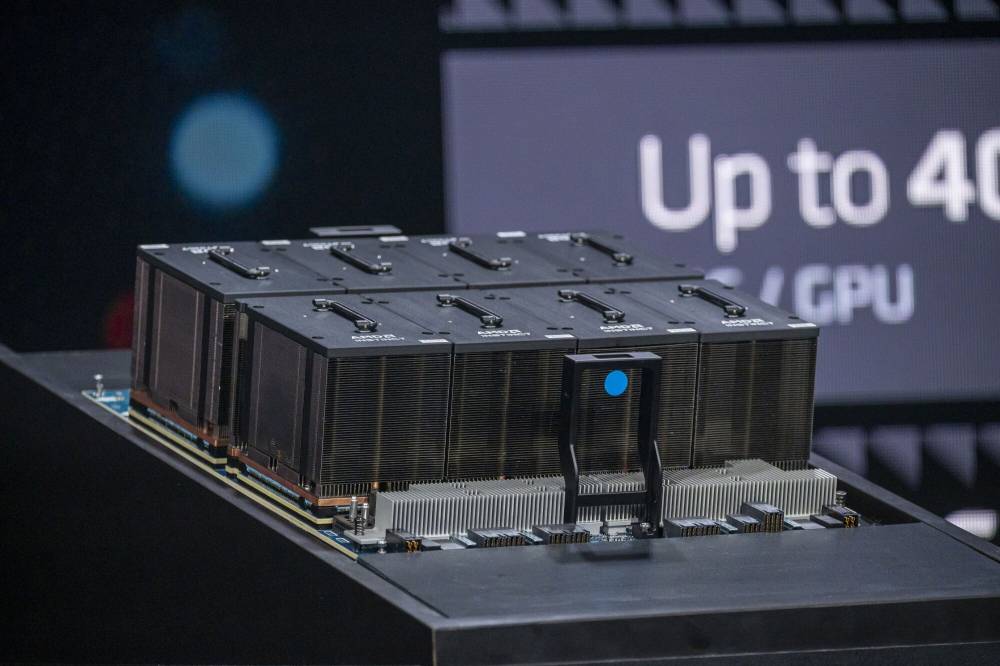

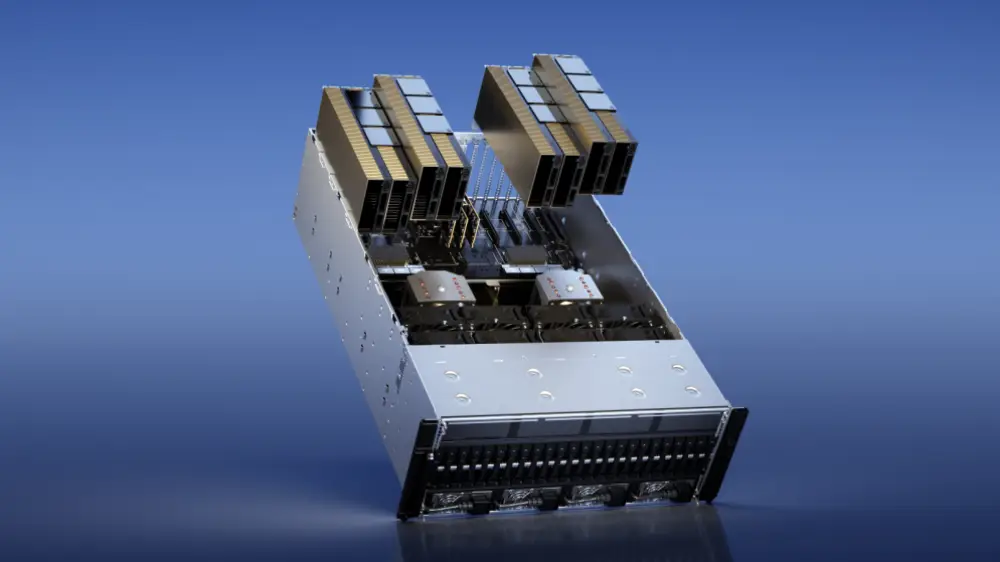

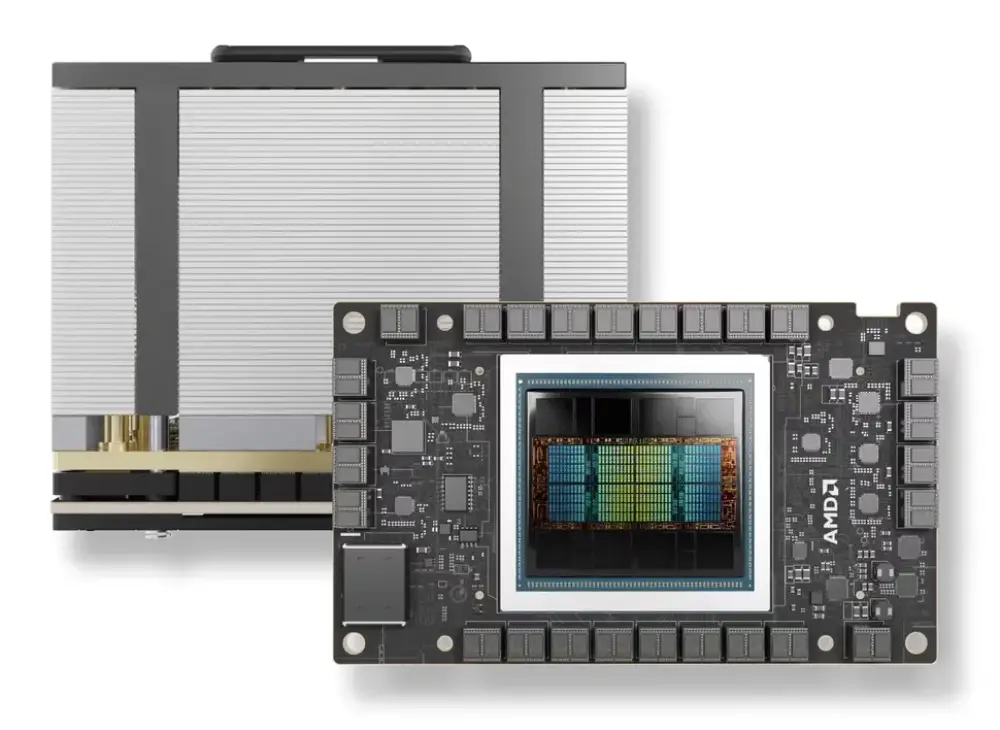

3. Nhà phát triển và thiết kế công nghệ

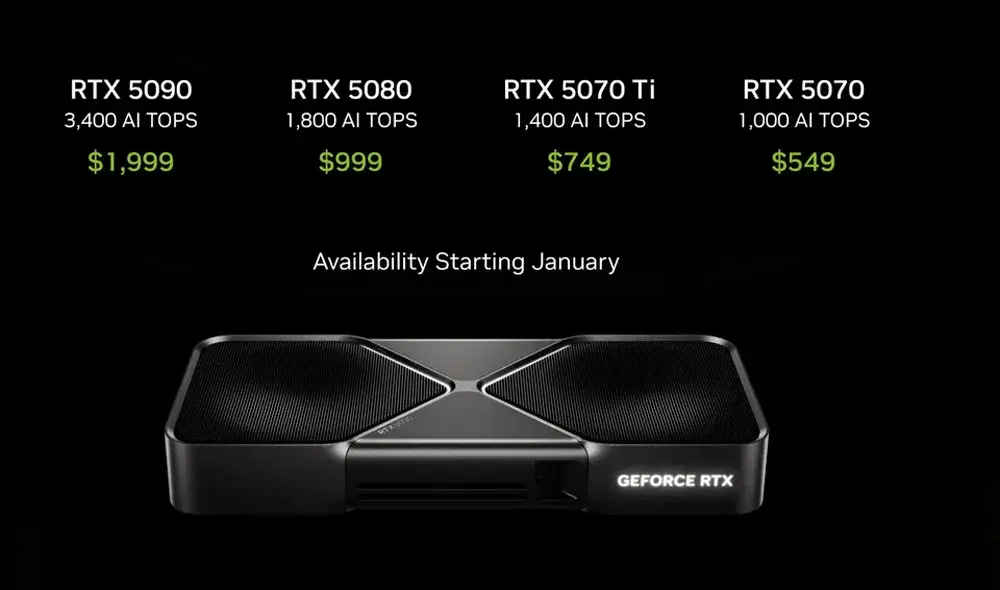

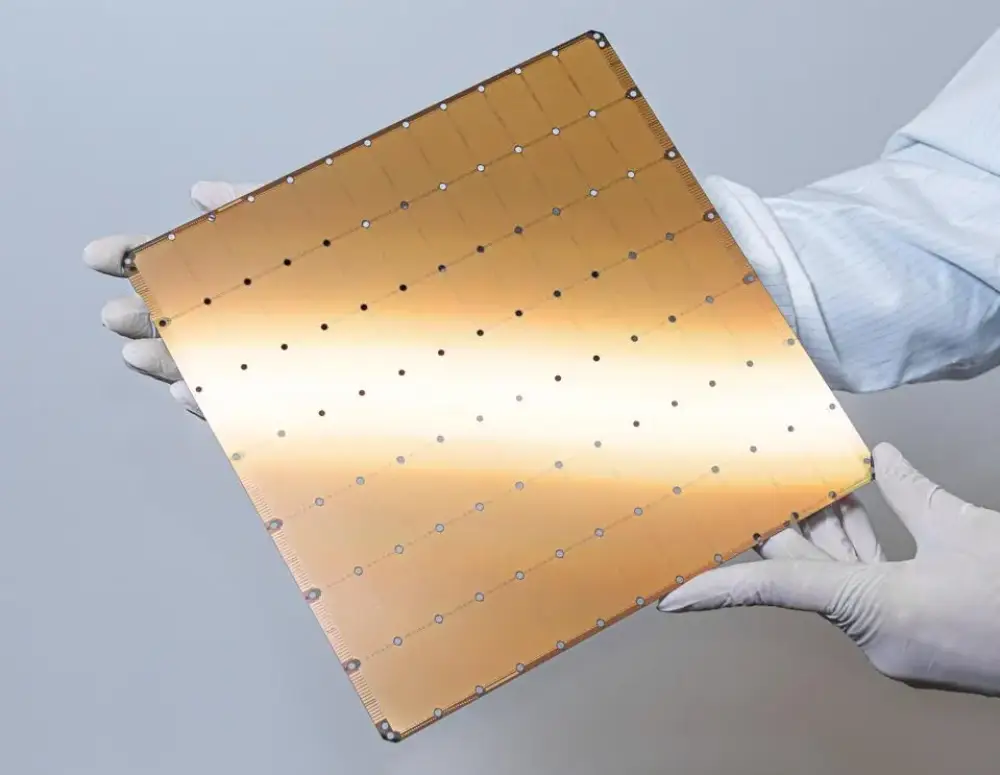

Họ là ai: các công ty bán dẫn và nhà cung cấp CNTT sản xuất chip và phần cứng máy tính cho trung tâm dữ liệu Chi phí vốn tải công việc AI: 3.100 tỷ đô la Chi phí vốn tải công việc không phải AI: 1.100 tỷ đô la Đầu tư chính: GPU, CPU, bộ nhớ, máy chủ và phần cứng giá đỡ

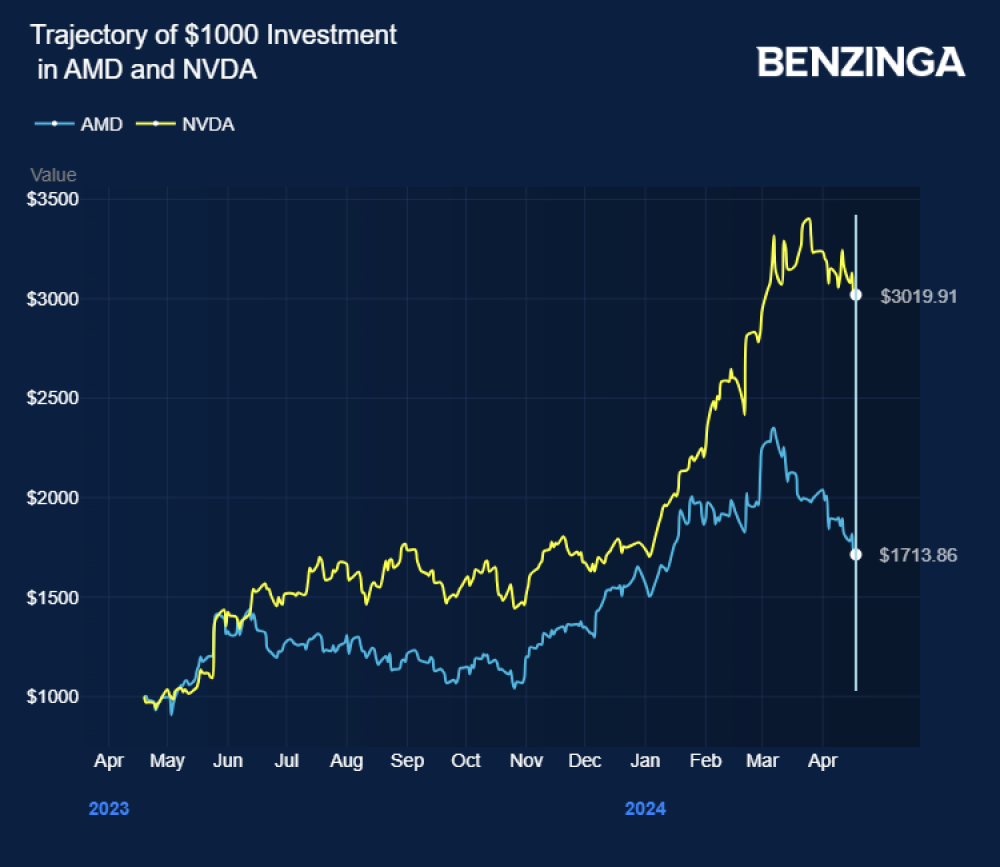

Cơ hội. Nhà phát triển và thiết kế công nghệ đầu tư vào công nghệ sẵn sàng cho tương lai có khả năng mở rộng được hỗ trợ bởi tầm nhìn nhu cầu rõ ràng có thể giành được lợi thế cạnh tranh trong điện toán AI.

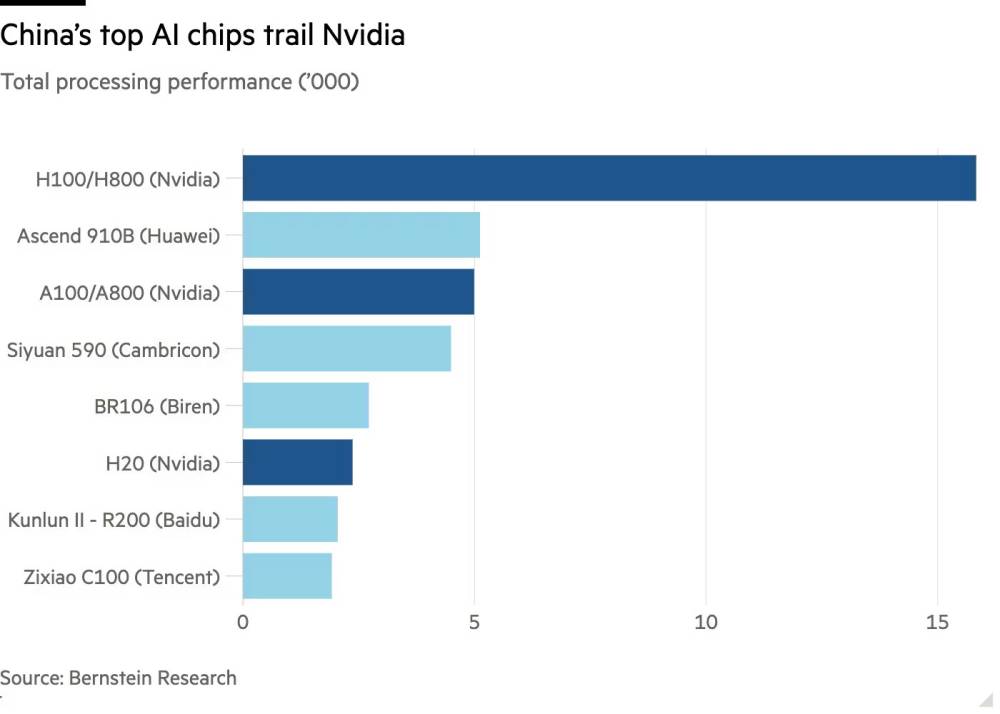

Thách thức. Một số lượng nhỏ các công ty bán dẫn kiểm soát nguồn cung thị trường, làm suy yếu cạnh tranh. Xây dựng công suất vẫn không đủ để đáp ứng nhu cầu hiện tại, trong khi đồng thời, sự thay đổi trong phương pháp đào tạo mô hình AI và tải công việc khiến khó dự đoán nhu cầu tương lai cho các chip cụ thể.

Giải pháp. Nhà phát triển và thiết kế công nghệ có nhiều lợi ích nhất trong cuộc đua sức mạnh tính toán vì họ là những người cung cấp bộ xử lý và phần cứng thực hiện việc tính toán thực tế. Nhu cầu về sản phẩm của họ hiện đang cao, nhưng nhu cầu đầu tư của họ cũng lớn nhất—hơn 3 nghìn tỷ đô la trong năm năm tới. Một số lượng nhỏ các công ty bán dẫn có ảnh hưởng không tương xứng đến nguồn cung ngành, khiến họ trở thành điểm nghẽn tiềm tàng trong tăng trưởng sức mạnh tính toán. Nhà phát triển và thiết kế công nghệ có thể giảm thiểu rủi ro này bằng cách mở rộng công suất sản xuất và đa dạng hóa chuỗi cung ứng để ngăn chặn tắc nghẽn.

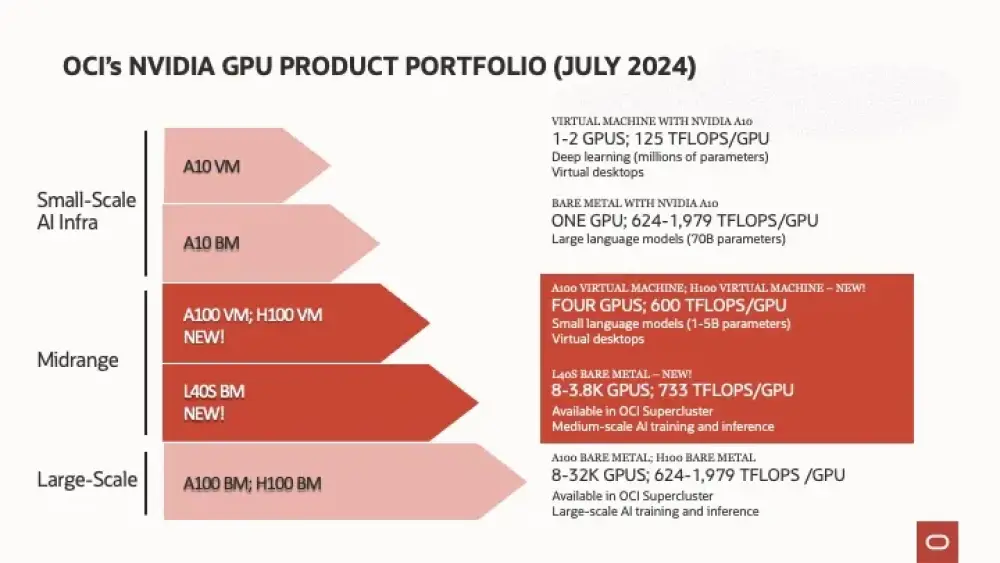

4. Nhà vận hành

Họ là ai: nhà cung cấp điện toán đám mây lớn, nhà cung cấp dịch vụ đặt chỗ, nền tảng GPU-dưới dạng dịch vụ và doanh nghiệp tối ưu hóa tài nguyên điện toán của họ bằng cách cải thiện mức độ sử dụng và hiệu quả máy chủ Chi phí vốn tải công việc AI: không được bao gồm trong phân tích này Chi phí vốn tải công việc không phải AI: không được bao gồm trong phân tích này Đầu tư chính: phần mềm trung tâm dữ liệu, tự động hóa được AI hỗ trợ, silicon tùy chỉnh

Cơ hội. Nhà vận hành mở rộng quy mô hiệu quả trong khi cân bằng ROI, hiệu suất và sử dụng năng lượng có thể thúc đẩy vị trí dẫn đầu ngành dài hạn.

Thách thức. Các ứng dụng được AI lưu trữ chưa trưởng thành có thể làm mờ tính toán ROI dài hạn. Sự không hiệu quả trong hoạt động trung tâm dữ liệu đang thúc đẩy chi phí tăng lên, nhưng sự không chắc chắn trong nhu cầu AI tiếp tục phá vỡ quy hoạch cơ sở hạ tầng dài hạn và quyết định mua sắm.

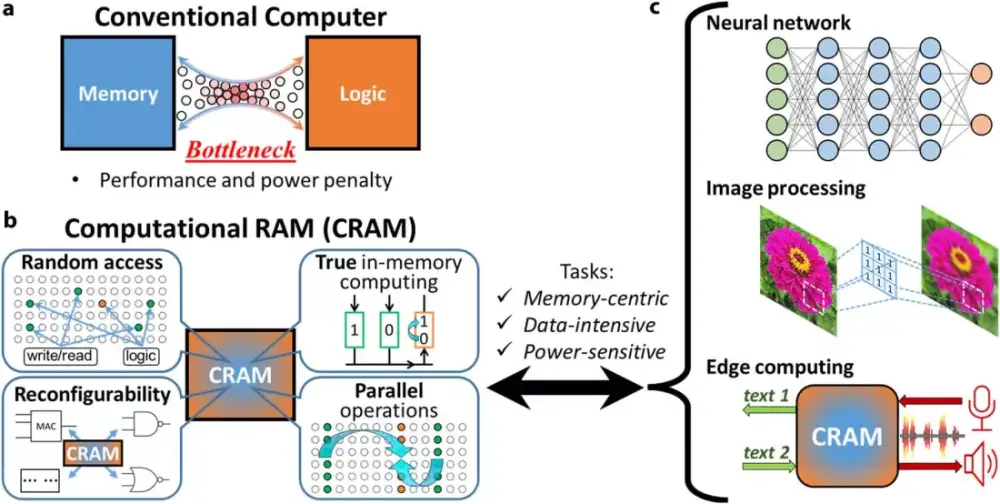

Giải pháp. Trong khi trung tâm dữ liệu ngày nay hoạt động ở mức hiệu quả cao, tốc độ đổi mới AI nhanh chóng sẽ đòi hỏi nhà điều hành tối ưu hóa cả tiêu thụ năng lượng và quản lý tải công việc. Một số nhà điều hành đang cải thiện hiệu quả năng lượng trong trung tâm dữ liệu của họ bằng cách đầu tư vào giải pháp làm mát hiệu quả hơn và tăng khả năng xếp chồng giá đỡ để giảm yêu cầu không gian mà không hy sinh sức mạnh xử lý, ví dụ. Những người khác đang đầu tư vào phát triển mô hình AI để tạo ra kiến trúc cần ít sức mạnh tính toán hơn để được đào tạo và vận hành.

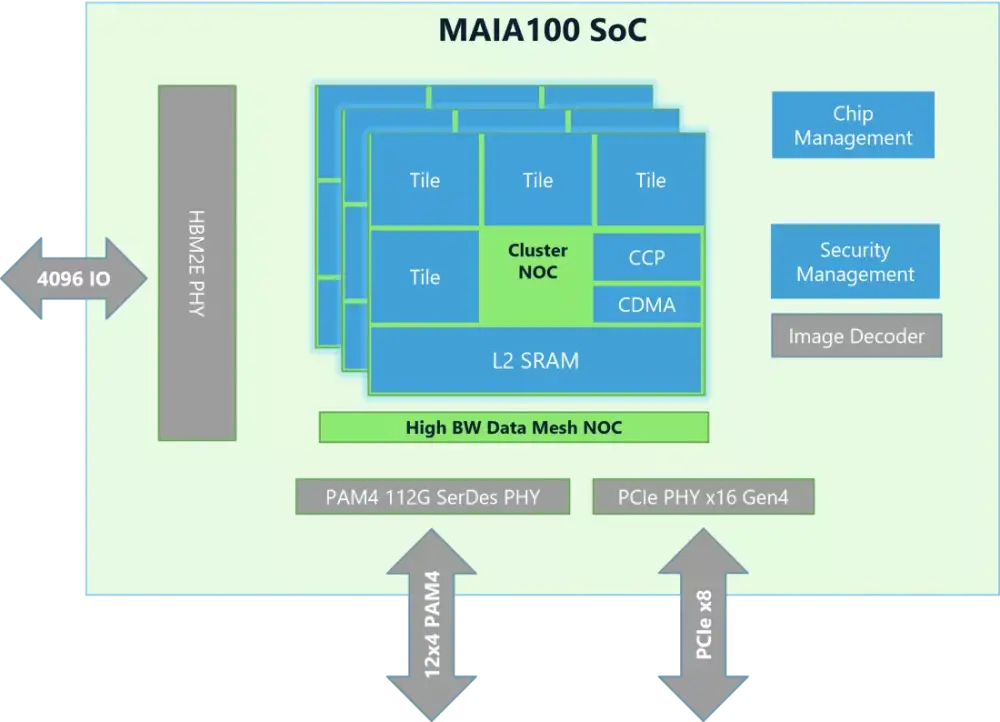

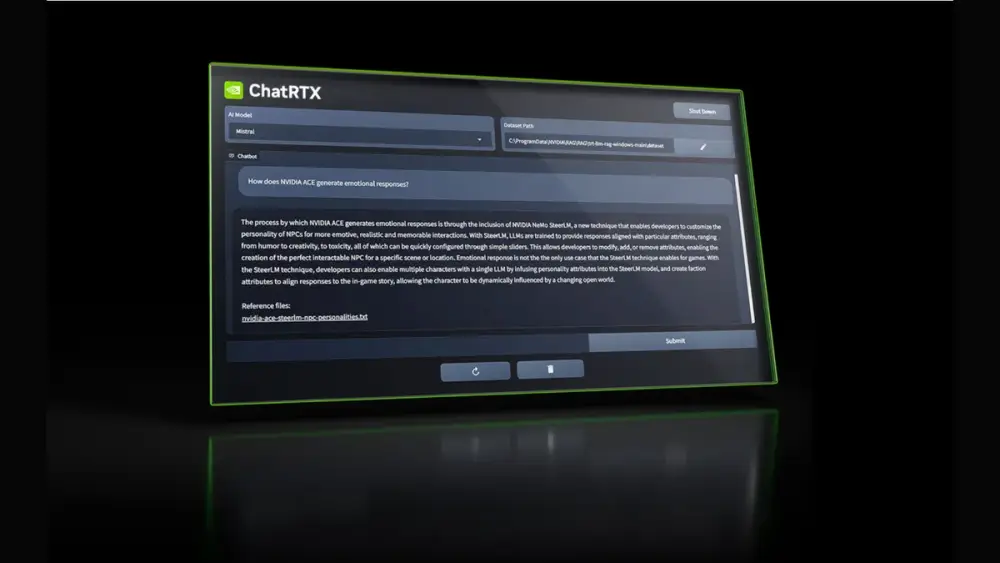

5. Kiến trúc sư AI

Họ là ai: nhà phát triển mô hình AI, nhà cung cấp mô hình nền tảng và doanh nghiệp xây dựng khả năng AI độc quyền Chi phí vốn tải công việc AI: không được bao gồm trong phân tích này Chi phí vốn tải công việc không phải AI: không được bao gồm trong phân tích này Đầu tư chính: cơ sở hạ tầng đào tạo và suy luận mô hình, nghiên cứu thuật toán

Cơ hội. Kiến trúc sư AI phát triển kiến trúc cân bằng hiệu suất với yêu cầu tính toán thấp hơn sẽ dẫn đầu làn sóng áp dụng AI tiếp theo. Doanh nghiệp đầu tư vào khả năng AI độc quyền có thể giành được tính cạnh tranh bằng cách phát triển các mô hình chuyên biệt phù hợp với nhu cầu của họ.

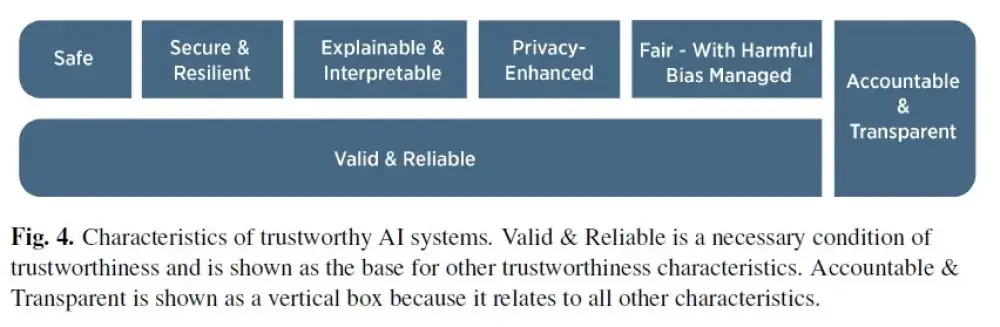

Thách thức. Các vấn đề quản trị AI, bao gồm sự thiên vị, an ninh và quy định, tăng thêm sự phức tạp và có thể làm chậm phát triển. Trong khi đó, suy luận đặt ra một thành phần chi phí không thể dự đoán lớn, và doanh nghiệp đang gặp khó khăn trong việc chứng minh ROI rõ ràng từ đầu tư AI.

Giải pháp. Nhu cầu tính toán ngày càng tăng của các mô hình AI quy mô lớn đang thúc đẩy chi phí đào tạo chúng tăng lên, đặc biệt là về suy luận, hoặc quá trình mà các mô hình AI đã được đào tạo áp dụng kiến thức đã học vào dữ liệu mới, chưa được thấy để đưa ra dự đoán hoặc quyết định. Các mô hình có khả năng suy luận nâng cao, như OpenAI's o1, đòi hỏi chi phí suy luận cao hơn đáng kể. Ví dụ, chi phí suy luận trên OpenAI's o1 cao gấp sáu lần so với GPT-4o không suy luận của công ty. Để giảm chi phí suy luận, các công ty AI hàng đầu đang tối ưu hóa kiến trúc mô hình của họ bằng cách sử dụng kỹ thuật như kích hoạt thưa thớt và chưng cất. Những giải pháp này giảm sức mạnh tính toán cần thiết khi mô hình AI tạo ra phản hồi, làm cho hoạt động hiệu quả hơn.

Những cân nhắc quan trọng cho tăng trưởng cơ sở hạ tầng AI

Khi các công ty lập kế hoạch đầu tư cơ sở hạ tầng AI, họ sẽ phải điều hướng một loạt các kết quả tiềm năng. Trong kịch bản nhu cầu hạn chế, năng lực trung tâm dữ liệu liên quan đến AI có thể đòi hỏi 3.700 tỷ đô la chi phí vốn—bị giới hạn bởi các hạn chế chuỗi cung ứng, gián đoạn công nghệ và sự không chắc chắn địa chính trị. Tuy nhiên, những rào cản này được giảm thiểu trong kịch bản nhu cầu tăng tốc, dẫn đến đầu tư cao tới 7.900 tỷ đô la. Theo dõi bối cảnh đang phát triển là rất quan trọng để đưa ra quyết định đầu tư chiến lược có thông tin. Một số điều không chắc chắn mà nhà đầu tư phải xem xét bao gồm:

Gián đoạn công nghệ. Đột phá trong kiến trúc mô hình, bao gồm lợi ích hiệu quả trong sử dụng tính toán, có thể giảm nhu cầu phần cứng và năng lượng dự kiến.

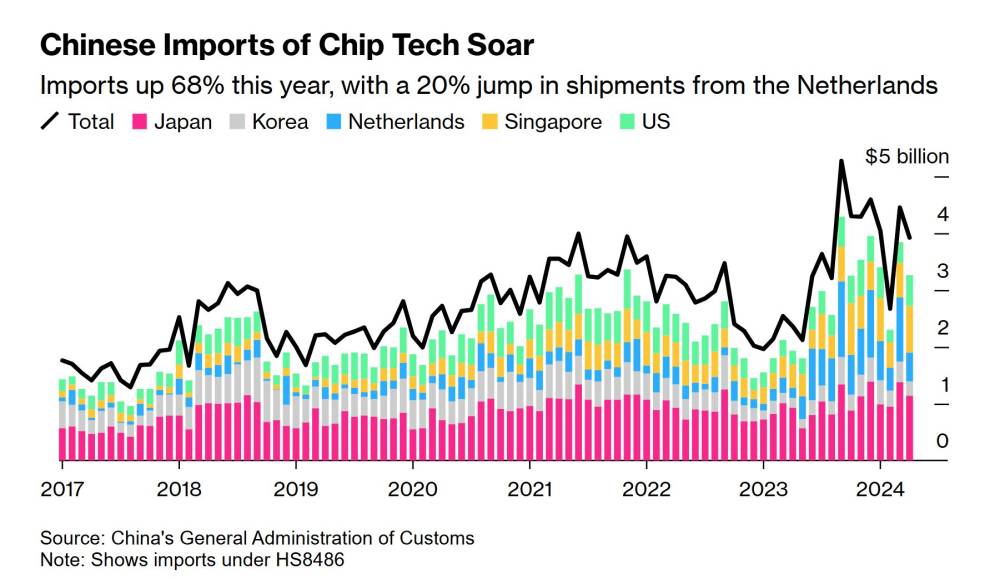

Hạn chế chuỗi cung ứng. Thiếu hụt lao động, tắc nghẽn chuỗi cung ứng và rào cản quy định có thể trì hoãn kết nối lưới điện, sự sẵn có của chip và mở rộng trung tâm dữ liệu—làm chậm tổng thể áp dụng và đổi mới AI. Để giải quyết tắc nghẽn chuỗi cung ứng cho các chip quan trọng, các công ty bán dẫn đang đầu tư vốn đáng kể để xây dựng các cơ sở sản xuất mới, nhưng việc xây dựng này có thể bị đình trệ do hạn chế quy định và thời gian dẫn dắt dài từ nhà cung cấp thiết bị đầu vào.

Căng thẳng địa chính trị. Thuế quan và kiểm soát xuất khẩu công nghệ dao động có thể đưa ra sự không chắc chắn trong nhu cầu sức mạnh tính toán, có thể ảnh hưởng đến đầu tư cơ sở hạ tầng và tăng trưởng AI.

Cuộc đua cho lợi thế cạnh tranh

Những người chiến thắng của kỷ nguyên điện toán do AI thúc đẩy sẽ là các công ty dự đoán nhu cầu sức mạnh tính toán và đầu tư phù hợp. Các công ty trong chuỗi giá trị sức mạnh tính toán chủ động bảo đảm tài nguyên quan trọng—đất đai, vật liệu, công suất năng lượng và sức mạnh tính toán—có thể giành được lợi thế cạnh tranh đáng kể. Để đầu tư với sự tự tin, họ có thể thực hiện cách tiếp cận ba mũi nhọn.

Đầu tiên, nhà đầu tư sẽ cần hiểu dự báo nhu cầu trong bối cảnh không chắc chắn. Các công ty nên đánh giá nhu cầu điện toán AI sớm, dự đoán sự thay đổi tiềm năng trong nhu cầu và thiết kế chiến lược đầu tư có thể mở rộng có thể thích ứng khi các mô hình và trường hợp sử dụng AI phát triển. Thứ hai, nhà đầu tư nên tìm cách đổi mới về hiệu quả tính toán. Để làm điều này, họ có thể ưu tiên đầu tư vào công nghệ điện toán hiệu quả về chi phí và năng lượng, tối ưu hóa hiệu suất trong khi quản lý tiêu thụ điện năng và chi phí cơ sở hạ tầng. Thứ ba, họ có thể xây dựng khả năng phục hồi phía cung để duy trì tăng trưởng cơ sở hạ tầng AI mà không mở rộng quá mức vốn. Điều này sẽ đòi hỏi nhà đầu tư bảo đảm đầu vào quan trọng như năng lượng và chip, tối ưu hóa lựa chọn địa điểm và xây dựng tính linh hoạt vào chuỗi cung ứng của họ.

Đạt được sự cân bằng đúng giữa tăng trưởng và hiệu quả vốn sẽ là rất quan trọng. Đầu tư chiến lược không chỉ là cuộc đua để mở rộng quy mô cơ sở hạ tầng dữ liệu—đó là cuộc đua để định hình tương lai của chính AI.