AI tạo sinh khát điện và nước, thách thức đối với lưới điện già cỗi của Mỹ

• AI tạo sinh đang tạo ra nhu cầu điện năng khổng lồ, gây áp lực lên lưới điện già cỗi của Mỹ. Một truy vấn ChatGPT tiêu thụ gần gấp 10 lần năng lượng so với tìm kiếm Google thông thường.

• Dự kiến đến năm 2030, các trung tâm dữ liệu sẽ chiếm 16% tổng lượng điện tiêu thụ của Mỹ, tăng từ mức 2,5% trước khi ChatGPT ra mắt năm 2022.

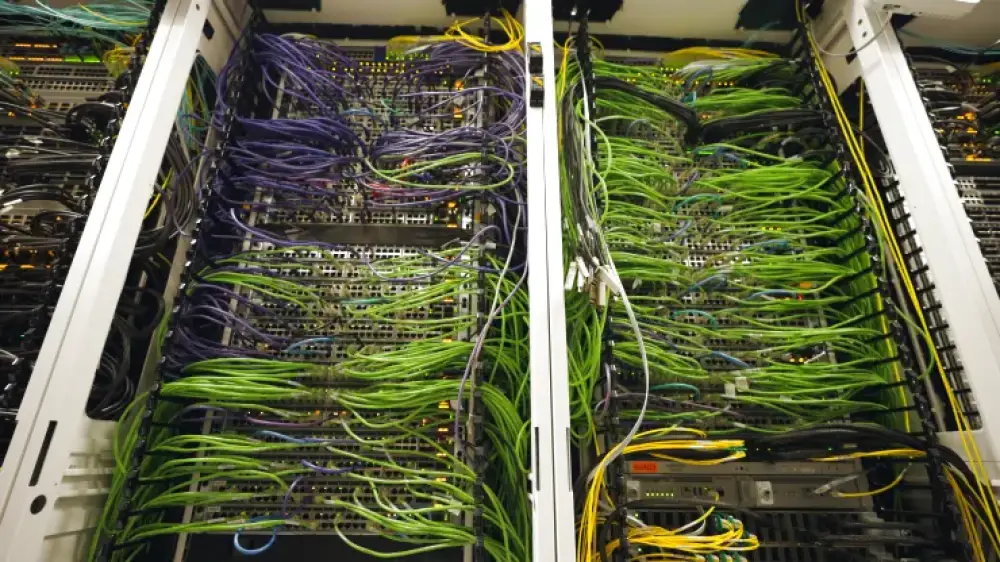

• Nhu cầu về trung tâm dữ liệu dự kiến tăng 15-20% mỗi năm đến năm 2030. Nhiều trung tâm dữ liệu mới đang được xây dựng để đáp ứng nhu cầu AI.

• Các công ty công nghệ lớn đang tìm kiếm địa điểm có nguồn năng lượng tái tạo gần kề hoặc cơ sở hạ tầng có thể tận dụng, như chuyển đổi nhà máy nhiệt điện than sang khí đốt tự nhiên.

• Một số công ty AI đang thử nghiệm các cách tạo ra điện tại chỗ, bao gồm đầu tư vào năng lượng mặt trời, phân hạch hạt nhân, và địa nhiệt.

• Lưới điện già cỗi gặp khó khăn trong việc đáp ứng tải. Giải pháp bao gồm mở rộng đường dây truyền tải và sử dụng phần mềm dự đoán để giảm sự cố tại các máy biến áp.

• Các trung tâm dữ liệu AI cũng cần lượng nước lớn để làm mát. Dự kiến đến năm 2027 sẽ cần 4,2-6,6 tỷ mét khối nước, nhiều hơn tổng lượng nước sử dụng hàng năm của nửa Vương quốc Anh.

• Một số giải pháp làm mát bao gồm sử dụng máy điều hòa không khí lớn không cần nước và làm mát trực tiếp chip bằng chất lỏng.

• Các công ty như Apple, Samsung và Qualcomm đang thúc đẩy AI trên thiết bị để giảm bớt gánh nặng cho các trung tâm dữ liệu.

• Ngành công nghiệp đang nỗ lực cải thiện hiệu quả năng lượng. Chip AI mới nhất của Nvidia có thể chạy các mô hình AI tạo sinh với mức tiêu thụ điện thấp hơn 25 lần so với thế hệ trước.

📌 AI tạo sinh đang tạo ra nhu cầu điện và nước khổng lồ, thách thức lưới điện già cỗi của Mỹ. Đến năm 2030, trung tâm dữ liệu có thể chiếm 16% tổng lượng điện tiêu thụ của Mỹ. Ngành công nghiệp đang tìm kiếm các giải pháp như cải thiện hiệu quả, nguồn năng lượng tại chỗ và phương pháp làm mát mới.

https://www.cnbc.com/2024/07/28/how-the-massive-power-draw-of-generative-ai-is-overtaxing-our-grid.html

Thảo luận

Follow Us

Tin phổ biến