AMD giới thiệu OLMo - dòng mô hình ngôn ngữ lớn 1 tỷ tham số đầu tiên hoàn toàn nguồn mở

• AMD vừa công bố OLMo, dòng mô hình ngôn ngữ lớn (LLM) 1 tỷ tham số đầu tiên được công ty phát triển và đào tạo nội bộ

• OLMo được đào tạo trên hàng nghìn tỷ token sử dụng cụm GPU Instinct MI250 của AMD

• Đây là LLM thứ hai AMD tự phát triển, sau mô hình nhỏ AMD-135M ra mắt tháng 9/2024

• OLMo dựa trên mô hình cùng tên do AI2 (trước đây là Viện Allen về Trí tuệ nhân tạo) phát triển ban đầu

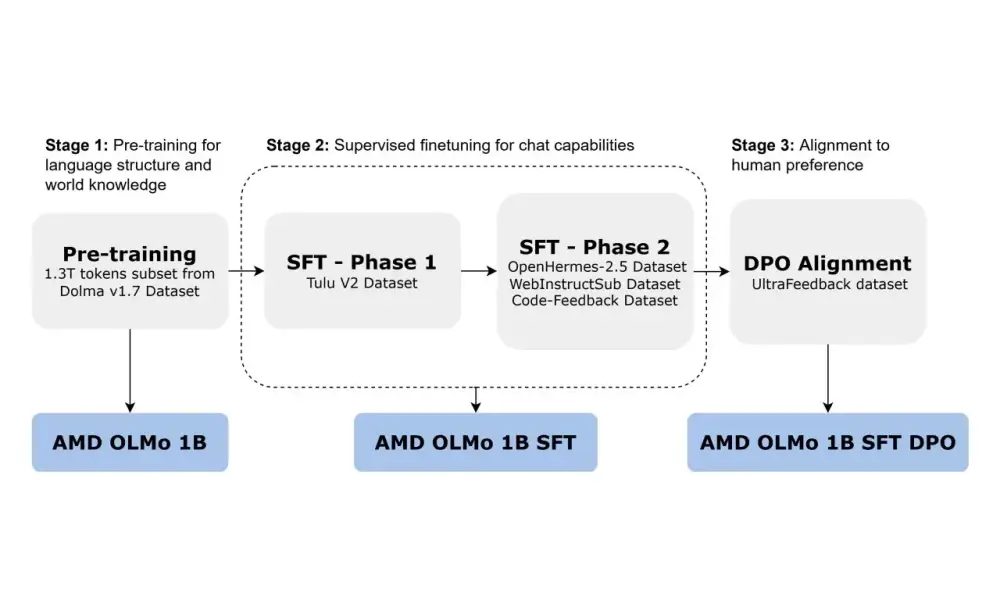

• AMD OLMo có 3 biến thể:

- OLMo 1B: Được tiền đào tạo trên 1,3 nghìn tỷ token từ tập dữ liệu Dolma v1.7

- OLMo 1B SFT: Được tinh chỉnh có giám sát trên các bộ dữ liệu Tulu V2, OpenHermes-2.5, WebInstructSub và Code-Feedback

- OLMo 1B SFT DPO: Được tinh chỉnh thêm để phản ánh tốt hơn sở thích của con người thông qua tối ưu hóa ưu tiên trực tiếp

• Các mô hình này sử dụng kiến trúc transformer chỉ giải mã, phù hợp cho ứng dụng chatbot

• So với các mô hình nguồn mở cùng kích thước:

- OLMo 1B đạt độ chính xác trung bình 48,77% trên các tác vụ suy luận tổng quát, tương đương OLMo-0724-hf (49,3%) nhưng với chi phí đào tạo chỉ bằng một nửa

- Cải thiện độ chính xác trên ARC-Easy (+6,36%), ARC-Challenge (+1,02%) và SciQ (+0,50%)

• So với các mô hình cơ sở được tinh chỉnh theo hướng dẫn:

- OLMo 1B SFT cải thiện đáng kể độ chính xác trên MMLU (+5,09%) và GSM8k (+15,32%)

- Hiệu suất trên GSM8k (18,2%) vượt trội so với mô hình cơ sở tốt nhất tiếp theo (TinyLlama-1.1B-Chat-v1.0 ở mức 2,81%)

• AMD mở mã nguồn toàn bộ dữ liệu, trọng số, công thức đào tạo và mã của OLMo nhằm thúc đẩy sự đổi mới trong cộng đồng

• Động thái này cũng nhằm quảng bá sức mạnh của bộ xử lý AMD so với các đối thủ như Nvidia và Intel trong lĩnh vực AI

📌 AMD ra mắt OLMo - dòng LLM 1 tỷ tham số nguồn mở đầu tiên, đạt hiệu suất vượt trội so với các mô hình cùng phân khúc trên nhiều tiêu chuẩn đánh giá. Với 3 biến thể và quá trình đào tạo 3 giai đoạn, OLMo thể hiện khả năng suy luận và tuân theo hướng dẫn tốt hơn, đồng thời quảng bá sức mạnh GPU Instinct của AMD trong lĩnh vực AI.

https://thelettertwo.com/2024/11/03/amd-unveils-olmo-its-first-fully-open-1b-parameter-llm-series/

Thảo luận

Follow Us

Tin phổ biến