Apple vừa mở mã nguồn mô hình ngôn ngữ DCLM Baseline-7B, vượt trội hơn cả mô hình LLaMA-2 của Meta

- Apple vừa công bố mở mã nguồn mô hình ngôn ngữ DCLM Baseline-7B, một phần của dự án Decentralized Compute Language Models (DCLM).

- Mô hình này được huấn luyện trên tập dữ liệu khổng lồ gồm 1,5 nghìn tỷ token, bao gồm cả dữ liệu từ trang web, sách và bài báo.

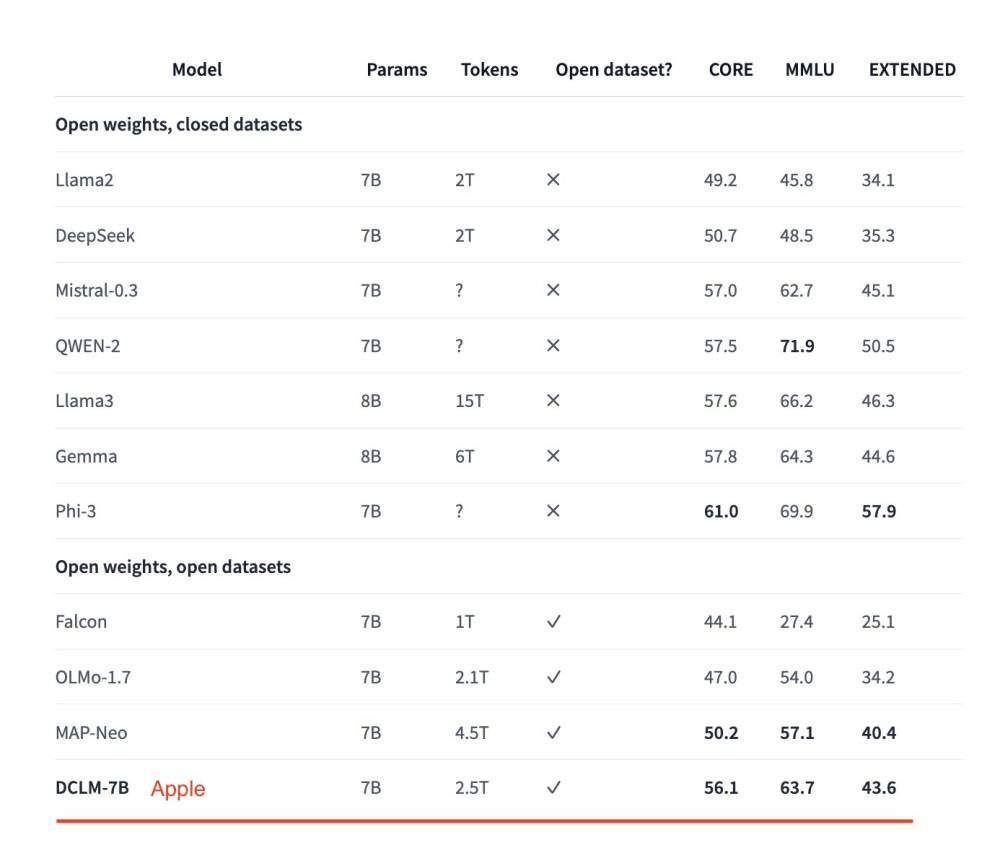

- Kết quả cho thấy DCLM Baseline-7B vượt trội hơn cả mô hình LLaMA-2 7B của Meta trên các bài kiểm tra chuẩn như MMLU (71,6% so với 69,0%) và HellaSwag (79,2% so với 77,8%).

- DCLM Baseline-7B cũng đạt điểm cao hơn trên bài kiểm tra TruthfulQA với 61,4% so với 58,1% của LLaMA-2 7B.

- Apple hy vọng việc mở mã nguồn sẽ thúc đẩy nghiên cứu và phát triển các mô hình ngôn ngữ phi tập trung (decentralized language models).

- Hiện tại mô hình và mã nguồn của DCLM Baseline-7B đã được công bố trên kho lưu trữ GitHub của Apple.

- Đây là một bước tiến quan trọng của Apple trong lĩnh vực AI, đặc biệt là các mô hình ngôn ngữ quy mô lớn.

📌 Apple vừa tạo tiếng vang lớn khi mở mã nguồn mô hình ngôn ngữ DCLM Baseline-7B, vượt trội hơn cả LLaMA-2 7B của Meta trên các bài kiểm tra chuẩn như MMLU (71,6%) và HellaSwag (79,2%). Bước đi này hứa hẹn thúc đẩy mạnh mẽ nghiên cứu về các mô hình ngôn ngữ phi tập trung.

Citations:

[1] https://analyticsindiamag.com/ai-news-updates/apple-open-sources-dclm-baseline-7b-outperforms-metas-llama-2/

Thảo luận

Follow Us

Tin phổ biến