Bài báo AI từ Trung Quốc giới thiệu MiniCPM: mô hình ngôn ngữ nhỏ sáng tạo thông qua phương pháp đào tạo có thể mở rộng

- Các nhà nghiên cứu từ Đại học Thanh Hoa và Modelbest Inc. giới thiệu MiniCPM, hai mô hình ngôn ngữ nhỏ (SLM) với 2.4B và 1.2B tham số phi nhúng.

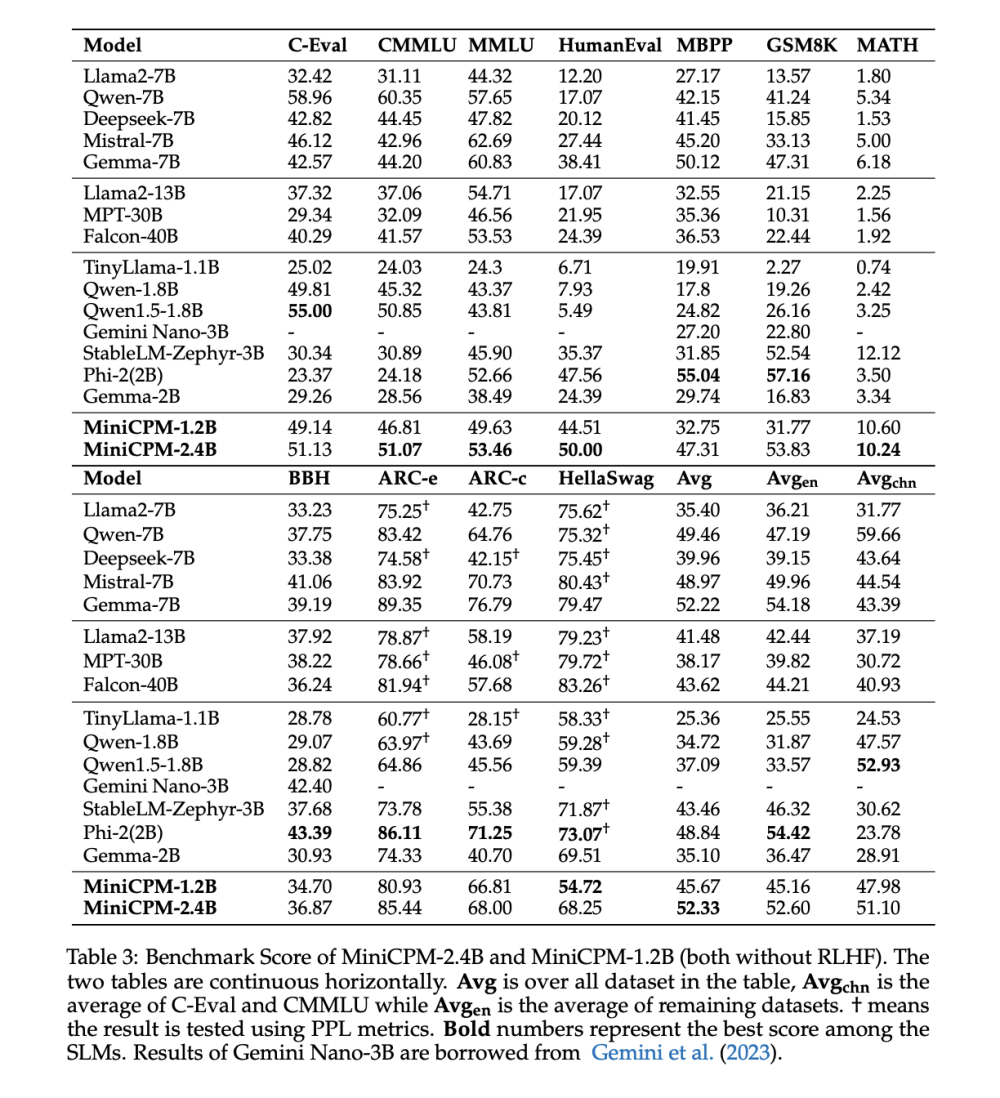

- MiniCPM vượt trội hơn các mô hình lớn hơn như Mistral-7B-v0.1 và Llama2-13B ở hầu hết các lĩnh vực, đặc biệt là tiếng Trung.

- Phương pháp đào tạo có thể mở rộng của MiniCPM cho thấy tiềm năng cho cả quy mô mô hình và dữ liệu, với các ứng dụng tiềm năng trong phát triển mô hình ngôn ngữ lớn (LLM).

- Bộ lập lịch WSD cải thiện đào tạo liên tục và tạo điều kiện thuận lợi cho việc nghiên cứu luật mở rộng hiệu quả.

- Họ MiniCPM bao gồm các phiên bản DPO, ngữ cảnh dài và MoE, với các hướng tương lai nhằm phân tích sự mất mát.

- Phát triển LLM với hàng nghìn tỷ tham số tốn kém và đòi hỏi nhiều tài nguyên, thúc đẩy sự quan tâm đến việc khám phá SLM như một lựa chọn hiệu quả hơn.

- LLM gặp thách thức do chi phí đào tạo khổng lồ và hiệu quả hoạt động kém. Hiểu các cơ chế đào tạo của chúng là khó nắm bắt, khiến các thử nghiệm trở nên đắt đỏ.

- Triển khai các mô hình lớn như vậy trên các thiết bị như PC hoặc điện thoại thông minh thường không thực tế hoặc không hiệu quả.

📌 Các nhà nghiên cứu từ Đại học Thanh Hoa và Modelbest Inc. giới thiệu MiniCPM, hai mô hình ngôn ngữ nhỏ (SLM) với 2,4 tỷ và 1,2 tỷ tham số, vượt trội hơn các mô hình lớn hơn ở hầu hết các lĩnh vực. Phương pháp đào tạo có thể mở rộng của nó cho thấy tiềm năng cho cả quy mô mô hình và dữ liệu, mở ra triển vọng ứng dụng trong phát triển LLM. Họ MiniCPM đa dạng hứa hẹn các hướng phát triển trong tương lai.

Citations:

[1] https://www.marktechpost.com/2024/04/12/this-ai-paper-from-china-introduces-minicpm-introducing-innovative-small-language-models-through-scalable-training-approaches/

Thảo luận

Follow Us

Tin phổ biến