Biến Chatbot AI thành trợ lý RAG thông minh với Open WebUI và Ollama

- Open WebUI là một giao diện web nguồn mở để tương tác với các LLM như Ollama, OpenAI API. Nó hỗ trợ kỹ thuật RAG giúp LLM tạo ra câu trả lời vượt ra ngoài dữ liệu huấn luyện.

- RAG chuyển đổi câu hỏi thành dạng nhúng (embedding), so khớp với cơ sở dữ liệu vector chứa thông tin nội bộ. Nếu tìm thấy, câu hỏi và thông tin khớp sẽ được đưa vào LLM để tạo câu trả lời phù hợp ngữ cảnh.

- Bài viết hướng dẫn triển khai Open WebUI trên Docker, yêu cầu GPU tối thiểu 6GB VRAM hoặc máy Mac 16GB RAM. Cần cài đặt Docker Engine/Desktop và chạy lệnh để tạo container Open WebUI.

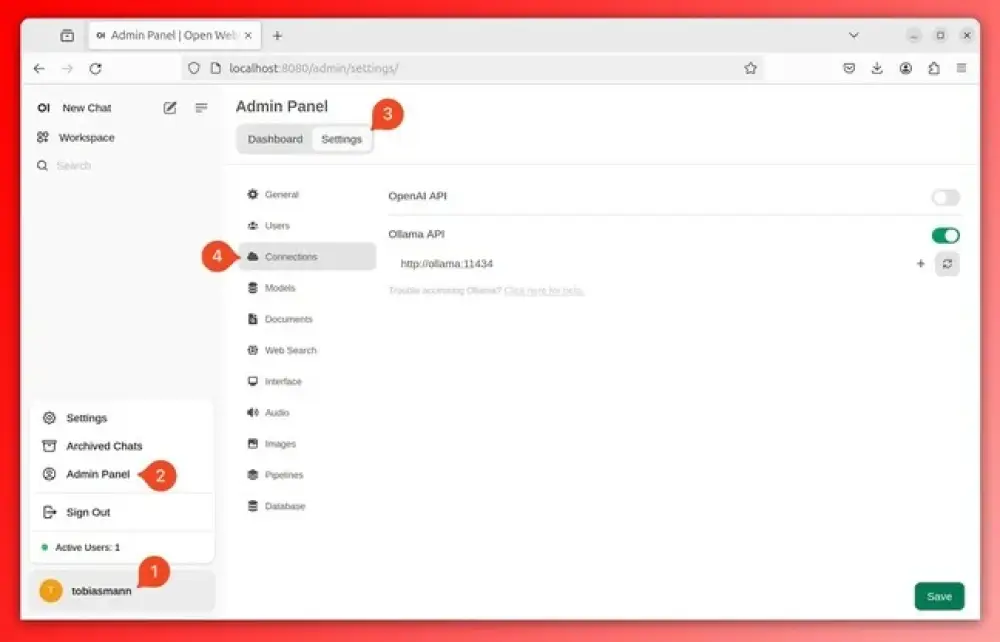

- Truy cập dashboard tại http://localhost:8080, tạo tài khoản admin. Kết nối Open WebUI với Ollama qua API. Tải và chọn model LLM như Llama3-8B.

- Tải lên tài liệu PDF hướng dẫn cài đặt Podman. Gán thẻ (tag) cho tài liệu. Nhập câu hỏi kèm dấu # và chọn thẻ/tài liệu liên quan. LLM sẽ tạo câu trả lời dựa trên thông tin trong tài liệu được chọn.

- Bật chức năng tìm kiếm web trong Open WebUI, lấy API key và Engine ID từ Google Programmable Search Engine. Nhập chúng vào phần cài đặt tìm kiếm web. Giờ đây có thể hỏi Open WebUI về các sự kiện xảy ra sau khi model được huấn luyện.

📌 Open WebUI và Ollama giúp tích hợp các LLM với kỹ thuật RAG, biến chúng thành chatbot AI thông minh hơn. Chỉ với vài bước cài đặt Docker và thiết lập, người dùng đã có thể tạo trợ lý ảo có khả năng truy xuất thông tin từ tài liệu nội bộ lẫn nguồn web bên ngoài để đưa ra câu trả lời chính xác, phù hợp ngữ cảnh.

https://www.theregister.com/2024/06/15/ai_rag_guide/

Thảo luận

Follow Us

Tin phổ biến