BoT: Phương pháp mới tăng cường khả năng lập luận của mô hình ngôn ngữ lớn

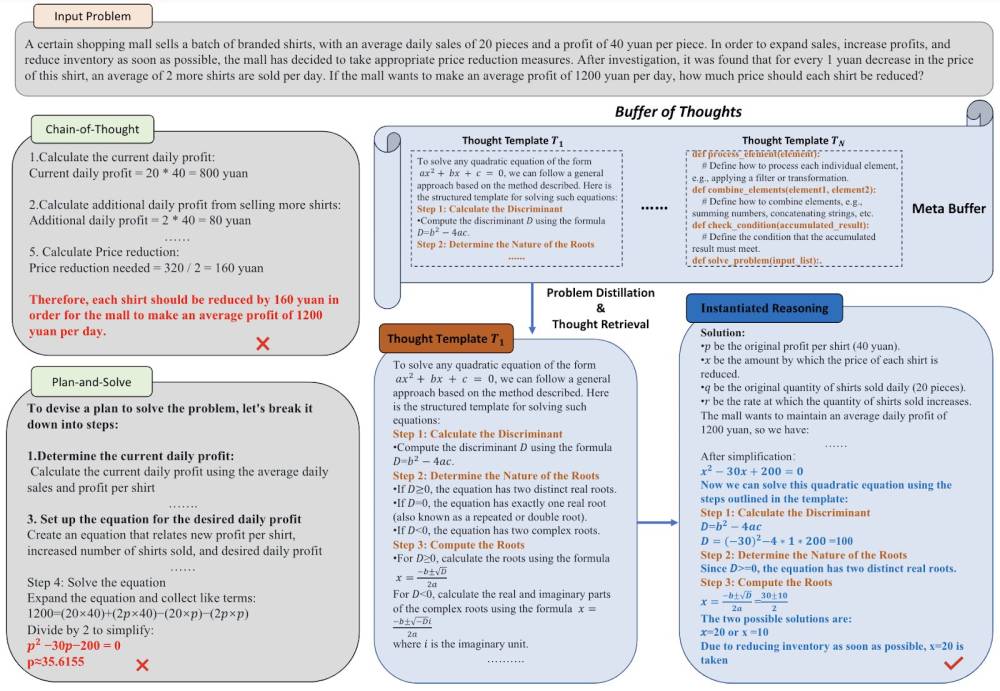

- BoT là framework linh hoạt để tăng cường khả năng lập luận của LLM, giúp cải thiện độ chính xác, hiệu quả và khả năng phục hồi trên nhiều tác vụ.

- Thành phần chính của BoT là meta-buffer, một thư viện nhỏ lưu trữ các ý tưởng cấp cao có thể tổng quát hóa (thought-templates) được trích xuất từ các quy trình giải quyết vấn đề khác nhau.

- Các thought-templates này có thể tái sử dụng cho các tác vụ khác, tạo điều kiện thuận lợi cho lập luận hiệu quả được tăng cường bởi suy nghĩ.

- BoT bao gồm bộ quản lý buffer để cập nhật meta-buffer một cách động, giúp tăng dung lượng meta-buffer khi hoàn thành nhiều tác vụ hơn.

- Lợi ích chính của BoT: Tăng độ chính xác bằng cách sử dụng thought-templates chung, tối ưu hóa quá trình lập luận bằng cách sử dụng trực tiếp các cấu trúc lập luận trong quá khứ, tăng khả năng giải quyết vấn đề tương tự một cách nhất quán.

- Kết quả thử nghiệm trên 10 tác vụ lập luận khó cho thấy BoT vượt trội hơn các phương pháp SOTA trước đây: 51% trên Checkmate-in-One, 11% trên Game of 24 và 20% trên Geometric Shapes, với chi phí trung bình chỉ bằng 12% so với các phương pháp đa truy vấn.

- Hạn chế: BoT ít hiệu quả với các vấn đề đòi hỏi sự sáng tạo giống con người. Chất lượng thought-templates có thể không tối ưu nếu sử dụng mô hình yếu để khởi tạo meta-buffer.

- Hướng phát triển: Kết hợp BoT với tài nguyên bên ngoài để tạo hệ thống miền mở như mô hình agent, tối ưu hóa quá trình chưng cất thought-templates để cải thiện khả năng làm mẫu cho các hoạt động phức tạp hơn.

📌 BoT là phương pháp đột phá giúp tăng cường đáng kể độ chính xác lên đến 51%, hiệu quả và khả năng phục hồi của LLM trên nhiều tác vụ lập luận khó, chỉ với 12% chi phí so với các kỹ thuật đa truy vấn trước đây, mở ra tiềm năng ứng dụng trong thực tế.

https://www.marktechpost.com/2024/06/09/buffer-of-thoughts-bot-a-novel-thought-augmented-reasoning-ai-approach-for-enhancing-accuracy-efficiency-and-robustness-of-llms/

Thảo luận

Follow Us

Tin phổ biến