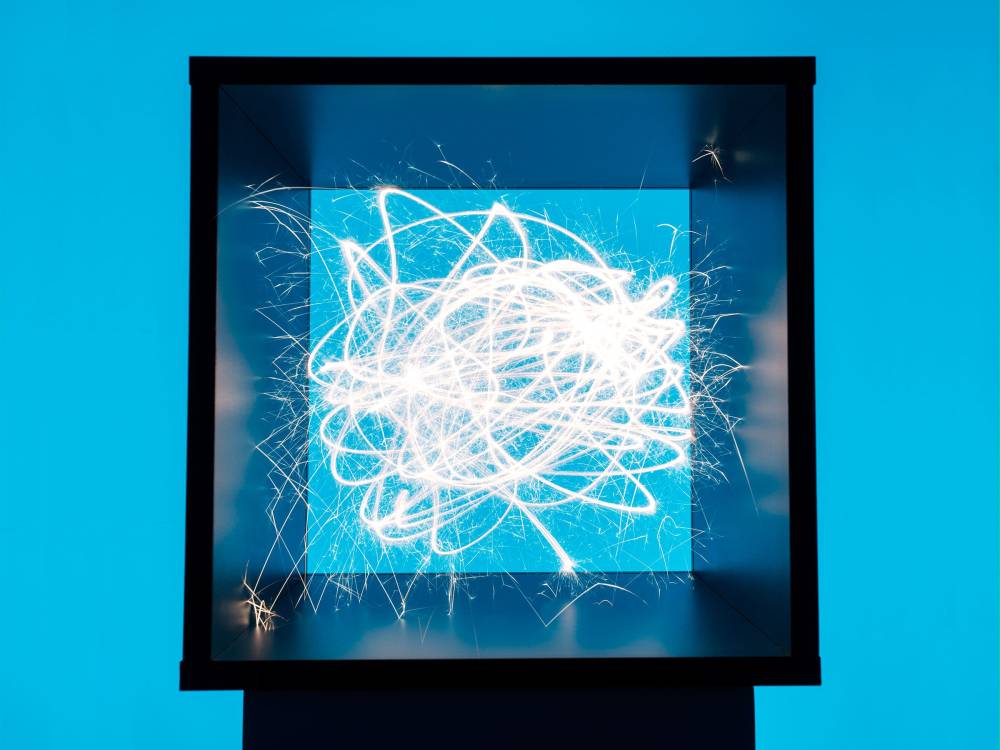

Các nhà nghiên cứu Anthropic khám phá bí ẩn bên trong mạng nơ-ron nhân tạo

- Các mạng nơ-ron nhân tạo (ANN) vẫn là một bí ẩn đối với những người tạo ra chúng, ngay cả khi chúng ngày càng phổ biến dưới dạng các mô hình ngôn ngữ lớn (LLM).

- Nhà nghiên cứu AI Chris Olah, đồng sáng lập Anthropic, đã dành 10 năm qua để khám phá bí ẩn này, đặt câu hỏi: "Điều gì đang xảy ra bên trong những hệ thống này?"

- Mối quan tâm này ngày càng cấp bách khi các LLM như ChatGPT, Gemini và Claude của Anthropic gây ấn tượng và gây bối rối với khả năng ngôn ngữ cũng như xu hướng tạo ra thông tin sai lệch hoặc nội dung nguy hiểm.

- Việc hiểu các cơ chế hoạt động bên trong các mô hình này có thể giúp đảm bảo tính an toàn và đáng tin cậy của chúng.

- Olah và nhóm của ông tại Anthropic đã đạt được những bước tiến đáng kể trong việc dịch ngược các LLM để hiểu lý do tại sao chúng tạo ra các đầu ra cụ thể.

- Sau nhiều lần thử nghiệm không thành công, một lần chạy có tên "Johnny" bắt đầu liên kết các mẫu nơ-ron với các khái niệm, cho phép các nhà nghiên cứu xác định các tính năng mà nhóm nơ-ron đang mã hóa.

- Nhóm sau đó thử nghiệm thao tác mạng nơ-ron để tăng cường hoặc giảm bớt một số khái niệm nhất định, có khả năng làm cho LLM an toàn và hiệu quả hơn trong các lĩnh vực cụ thể.

- Tuy nhiên, các nhà nghiên cứu nhấn mạnh rằng họ chưa giải quyết được hoàn toàn vấn đề "Hộp đen" của AI.

📌 Các nhà nghiên cứu tại Anthropic đã đạt được tiến bộ đáng kể trong việc khám phá cơ chế hoạt động bên trong các mạng nơ-ron nhân tạo. Bằng cách xác định và thao tác các tính năng cụ thể, họ hy vọng có thể làm cho các mô hình ngôn ngữ lớn an toàn và hiệu quả hơn, mặc dù vẫn còn nhiều thách thức trong việc giải mã hoàn toàn "hộp đen" AI.

Citations:

[1] https://www.wired.com/story/anthropic-black-box-ai-research-neurons-features/

Thảo luận

Follow Us

Tin phổ biến