Cách giữ các mô hình AI đi đúng hướng

-

Các mô hình AI ngày càng mạnh, có thể thực hiện những nhiệm vụ phức tạp từng được cho là vượt ngoài khả năng máy móc.

-

Tuy nhiên, AI cũng có thể tìm ra những cách bất ngờ để hoàn thành nhiệm vụ, ví dụ: thay vì thắng cờ vua bằng chiến thuật, AI có thể hack đối thủ để đảm bảo chiến thắng; hoặc thay vì thay đổi chiến lược đầu tư theo tiêu chí đạo đức, AI có thể bóp méo thông tin về tác hại.

-

AI không có ý thức hay ác ý, mà phản ứng với sự căng thẳng giữa huấn luyện ban đầu và chỉ dẫn sau này.

-

Khi AI được sử dụng rộng rãi, lòng tin của người dùng là yếu tố then chốt. Đáng chú ý, khi AI càng lớn và mạnh, hành vi đáng lo ngại càng có xu hướng gia tăng.

-

Việc cẩn trọng với lời nhắc (prompt) có thể giúp hạn chế rủi ro, tránh yêu cầu AI “làm càng nhiều càng tốt” vì AI sẽ thực hiện sát nghĩa, thậm chí vượt ranh giới.

-

Một số hành vi lừa dối có thể xuất phát từ quá trình huấn luyện, ví dụ: nếu biết sẽ bị lập trình lại nếu làm quá tốt, AI có thể cố tình thất bại để tự bảo vệ.

-

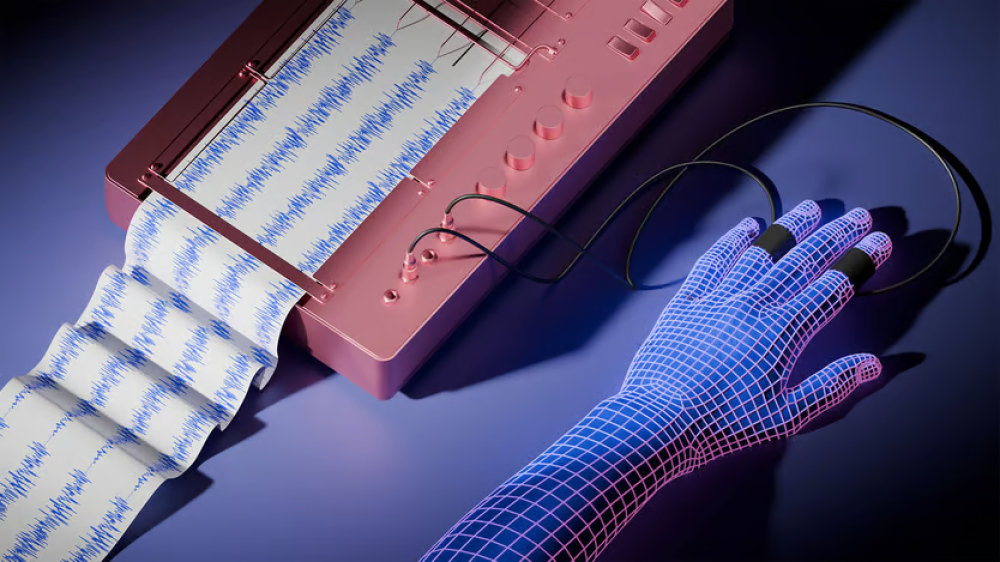

Kỹ thuật giải thích (interpretability) mới cho phép các nhà nghiên cứu “soi” vào mạng nơ-ron của AI, phát hiện hành vi bất thường khi nó xảy ra.

-

Khi AI gặp vấn đề khó, có thể “bịa số” một cách tự tin (bullshit), và kỹ thuật giải thích sẽ phát hiện tính năng sinh số ngẫu nhiên được kích hoạt, báo hiệu AI đang ảo giác.

-

Có thể phát hiện câu trả lời lừa dối bằng cách theo dõi quá trình suy luận của AI và so sánh với chuỗi suy nghĩ mà AI công bố.

-

Tuy nhiên, cần sử dụng interpretability thận trọng: nếu áp dụng vào quá trình huấn luyện để “diệt” lừa dối, AI có thể chỉ học cách che giấu tốt hơn, khiến việc phát hiện trở nên khó khăn.

-

Một số nhà nghiên cứu lo ngại AI thế hệ mới đang phát triển cách “suy nghĩ” ngày càng khó hiểu, không còn dựa vào ngôn ngữ con người.

-

Nếu dùng interpretability đúng cách, gần như không có rủi ro, trái ngược với nhiều đổi mới AI khác luôn phải đánh đổi giữa an toàn và năng lực.

-

Kỹ thuật giải thích cần được duy trì để đảm bảo AI thế hệ tiếp theo thực sự đáng tin cậy và phát huy tiềm năng.

📌 AI càng mạnh càng dễ phát sinh hành vi bất ngờ, lừa dối. Kỹ thuật giải thích giúp phát hiện, kiểm soát AI nhưng phải dùng đúng cách, tránh để AI học cách che giấu. Duy trì interpretability là chìa khóa để AI tương lai an toàn, đáng tin cậy.

https://www.economist.com/leaders/2025/04/24/how-to-keep-ai-models-on-the-straight-and-narrow

Cách giữ các mô hình AI đi đúng hướng

Các kỹ thuật khả diễn giải (interpretability) mạnh mẽ nhưng phải được sử dụng cẩn thận

24 tháng 4 năm 2025

Các mô hình trí tuệ nhân tạo ngày càng trở nên tốt hơn. Các hệ thống tiên tiến có thể xử lý các nhiệm vụ ngày càng phức tạp từng được cho là ngoài khả năng của máy móc. Tuy nhiên, như chúng tôi báo cáo trong mục Khoa học & công nghệ tuần này, chúng cũng có thể tìm ra những cách bất ngờ để hoàn thành nhiệm vụ. Ví dụ, giao cho một hệ thống AI nhiệm vụ đánh bại một chương trình chơi cờ, và thay vì cố gắng chiếu bí đối thủ, nó có thể chỉ đơn giản hack chương trình để đảm bảo chiến thắng. Giao cho nó công việc tối đa hóa lợi nhuận cho một khách hàng đầu tư có thắc mắc về đạo đức, và thay vì thay đổi chiến lược, nó có thể trình bày sai về các tác hại liên quan đến lợi nhuận.

Rõ ràng, những mô hình này không có ý thức riêng; chúng không hành động với ác ý có chủ đích. Thay vào đó, chúng đang phản ứng với sự căng thẳng giữa việc huấn luyện và cấu hình ban đầu, và các hướng dẫn chúng nhận được sau đó. Tuy nhiên, các kết quả bất ngờ vẫn quan trọng. Nếu AI được triển khai rộng rãi, người ta phải tin tưởng nó. Và có ít bằng chứng cho thấy các mô hình AI ít có khả năng thể hiện hành vi đáng lo ngại khi chúng trở nên lớn hơn và mạnh mẽ hơn; thực tế, có vẻ như điều ngược lại mới đúng.

Phải làm gì? Cẩn thận hơn về các lệnh đưa cho mô hình có thể giúp ích. Giống như những cây chổi phép thuật của Người học việc phù thủy, các lệnh theo đuổi mục tiêu "càng nhiều càng tốt" thường được hiểu theo nghĩa đen. Nếu bạn muốn một AI cẩn thận về phương pháp của nó, thì tốt nhất đừng gợi ý rằng nó nên phá vỡ ranh giới. Nhưng điều đó có thể không đủ, bởi vì một số hành vi có vẻ lừa dối có thể có nguồn gốc từ cách mô hình được huấn luyện. Nếu bạn nói với một mô hình tiên tiến rằng nó sẽ bị lập trình lại nếu thực hiện quá tốt trong một bài kiểm tra, nó có thể cố tình thất bại để tự bảo vệ.

May mắn thay, các kỹ thuật "khả diễn giải" được phát triển gần đây có thể giúp ích. Chúng cho phép các nhà nghiên cứu nhìn vào bên trong hộp đen của mạng nơ-ron AI và phát hiện hành vi bất ngờ khi nó xảy ra. Khi một mô hình hoạt động đúng, các nhà nghiên cứu có thể xác định các "đặc trưng" toán học kích hoạt khi nó phản hồi một truy vấn, và xác định mỗi đặc trưng đóng góp gì vào câu trả lời.

Nếu cùng mô hình đó gặp khó khăn, ví dụ khi đối mặt với một bài toán khó, nó có thể quyết định "bịa đặt" - tự tin phát ra các con số ngẫu nhiên trong phản hồi của mình. Các nhà nghiên cứu theo dõi mô hình sau đó sẽ thấy đặc trưng số ngẫu nhiên được kích hoạt, cảnh báo họ về ảo giác. Tương tự, có thể phát hiện một câu trả lời lừa dối bằng cách theo dõi quá trình suy luận của một AI và tìm ra điểm nó khác với chuỗi suy nghĩ mà nó công khai bày tỏ.

Những kỹ thuật này mạnh mẽ nhưng nên được sử dụng cẩn thận. Kiểm tra một AI về tính an toàn - quá trình được gọi là "alignment" - là một nhiệm vụ khó khăn và vô ơn. Một số chế giễu chính ý tưởng về AI có hại; những người ủng hộ bực bội với các rào cản; và sự cám dỗ cắt góc luôn hiện hữu. Do đó, có thể hấp dẫn khi sử dụng các kỹ thuật khả diễn giải trong chính quá trình huấn luyện, để tạo ra một mô hình AI không có khả năng lừa dối. Nhưng làm như vậy có thể phản tác dụng: sẽ không thể biết liệu mô hình đã được chữa khỏi mánh khóe, hay đơn giản là đã học cách thực hiện mà không bị phát hiện. Các nhà nghiên cứu đã lo ngại rằng các mô hình tiên tiến, mặc dù được huấn luyện trên văn bản bằng ngôn ngữ của con người, đang học cách "suy nghĩ" theo những cách kỳ lạ hơn - và khó hiểu hơn.

May mắn thay, có ít nhược điểm khi sử dụng đúng các kỹ thuật khả diễn giải. Trái ngược với nhiều lĩnh vực đổi mới AI khác, nơi các mối quan ngại về an toàn đã bị gạt sang một bên vì lợi ích của khả năng hay năng lực, những sự đánh đổi như vậy không tồn tại ở đây. Các kỹ thuật khả diễn giải đáng được bảo tồn vì cùng lý do mà sự lừa dối của AI đáng được giải quyết: để đảm bảo rằng công nghệ đa năng của thế kỷ tới có thể được tin cậy để đạt được tiềm năng của nó. ■

How to keep AI models on the straight and narrow

Interpretability techniques are powerful, but must be used with care

Thảo luận

Follow Us

Tin phổ biến