Cách viết prompt để khai thác tối đa hiệu suất của mô hình reasoning như OpenAI's o1

- Sự bùng nổ của mô hình reasoning AI được khởi xướng bởi OpenAI với mô hình o1 ra mắt tháng 9 năm 2024, nổi bật với khả năng xử lý các vấn đề phức tạp.

- Các đối thủ cạnh tranh như DeepSeek’s R1, Google Gemini 2 Flash Thinking và LlamaV-o1 cũng đã xuất hiện, cung cấp các giải pháp tương tự về khả năng reasoning.

- Những mô hình này sử dụng kỹ thuật "chain-of-thought" (CoT) cho phép chúng tự phân tích và phản hồi một cách chi tiết hơn so với các mô hình ngôn ngữ lớn truyền thống.

- Chi phí sử dụng mô hình o1 cao (15 USD cho 1 triệu token), làm dấy lên câu hỏi liệu lợi ích của nó có đáng với giá cả hay không.

- Tuy nhiên, ngày càng có nhiều người dùng bắt đầu chuyển sang mô hình này, nhấn mạnh rằng cách tiếp cận trong việc viết lệnh (prompt) rất quan trọng để phát huy sức mạnh của nó.

- Ben Hylak, cựu nhà thiết kế giao diện cho Apple, đã chỉ ra rằng thay vì chỉ ra cách thức trả lời, người dùng nên cung cấp những thông tin cụ thể hơn về yêu cầu của họ.

- Hylak chia sẻ rằng, người dùng nên viết “briefs”, bao gồm bối cảnh và định dạng cụ thể cho kết quả mong muốn.

- Việc này cho phép mô hình o1 tự động hóa quy trình và đưa ra câu trả lời nhanh chóng và hiệu quả hơn.

- Cùng với sự phát triển của các mô hình không phải reasoning như Claude 3.5 Sonnet, sự cải thiện trong kỹ thuật gợi ý cũng có thể mang lại kết quả tốt hơn cho người dùng.

- Louis Arge, cựu kỹ sư tại Teton.ai, đã phát hiện rằng LLM thường tin tưởng vào lệnh của chính nó hơn là lệnh của người dùng, điều này cho thấy sự quan trọng của nghệ thuật ra lệnh.

📌 Mô hình reasoning AI, như o1 của OpenAI, yêu cầu cách viết lệnh mới để phát huy hiệu suất tối đa. Việc sử dụng "briefs" thay vì lệnh truyền thống có thể giúp nâng cao kết quả đầu ra từ mô hình.

https://venturebeat.com/ai/do-new-ai-reasoning-models-require-new-approaches-to-prompting/

Các mô hình AI lập luận mới có cần các cách tiếp cận mới trong việc xây dựng lời nhắc không?

Carl Franzen

@carlfranzen

13 tháng 1, 2025, 3:27 chiều

Kỷ nguyên của AI lập luận đã thực sự bắt đầu.

Sau khi OpenAI một lần nữa khởi động một cuộc cách mạng AI với mô hình lập luận o1 được giới thiệu vào tháng 9 năm 2024 — mô hình này mất nhiều thời gian hơn để trả lời câu hỏi nhưng mang lại hiệu năng cao hơn, đặc biệt trong các vấn đề phức tạp, nhiều bước trong lĩnh vực toán học và khoa học — thị trường AI thương mại đã bị tràn ngập bởi các sản phẩm sao chép và đối thủ cạnh tranh.

Hiện tại, đã có các mô hình như DeepSeek R1, Google Gemini 2 Flash Thinking và LlamaV-o1 (vừa được ra mắt hôm nay), tất cả đều cố gắng cung cấp khả năng lập luận tương tự như o1 và dòng mô hình o3 sắp ra mắt của OpenAI. Những mô hình này áp dụng phương pháp "chain-of-thought" (CoT) prompting — hay còn gọi là "tự nhắc nhở" — buộc chúng phải phản ánh quá trình phân tích trong khi hoạt động, quay lại kiểm tra, rà soát công việc của chính mình, và cuối cùng đưa ra một câu trả lời tốt hơn thay vì nhanh chóng xuất ra kết quả từ các embedding, như các mô hình ngôn ngữ lớn (LLM) khác thường làm.

Tuy nhiên, chi phí cao của o1 và o1-mini (15,00 USD/1 triệu token đầu vào so với 1,25 USD/1 triệu token đầu vào của GPT-4o trên API của OpenAI) đã khiến một số người băn khoăn về giá trị gia tăng của hiệu năng này. Liệu việc trả gấp 12 lần so với các LLM tiên tiến khác có thực sự đáng giá?

Hóa ra, ngày càng có nhiều người chuyển sang sử dụng mô hình này — nhưng chìa khóa để khai thác giá trị thực sự của các mô hình lập luận có thể nằm ở cách người dùng xây dựng lời nhắc theo một cách khác.

Shawn Wang (nhà sáng lập dịch vụ tin tức AI Smol) đã đăng trên Substack của mình vào cuối tuần qua một bài viết khách mời từ Ben Hylak, cựu nhà thiết kế giao diện của Apple Inc. cho visionOS (nền tảng hỗ trợ tai nghe tính toán không gian Vision Pro). Bài viết này đã lan truyền nhanh chóng vì nó giải thích thuyết phục cách mà Hylak xây dựng lời nhắc cho mô hình o1 của OpenAI để nhận được kết quả cực kỳ hữu ích (đối với anh ấy).

Tóm lại, thay vì người dùng viết lời nhắc cho mô hình o1, họ nên nghĩ đến việc viết các "briefs" (tóm tắt), tức là các mô tả chi tiết hơn bao gồm nhiều bối cảnh ban đầu về những gì người dùng muốn mô hình xuất ra, người dùng là ai và định dạng mà họ muốn thông tin được xuất ra.

Như Hylak viết trên Substack:

"Với hầu hết các mô hình, chúng ta đã quen với việc nói cho mô hình biết cách ta muốn nó trả lời. Ví dụ: ‘Bạn là một kỹ sư phần mềm chuyên nghiệp. Hãy suy nghĩ chậm rãi và cẩn thận.’

Điều này trái ngược hoàn toàn với cách tôi tìm thấy thành công với o1. Tôi không chỉ dẫn nó về cách thức — chỉ về nội dung. Sau đó để o1 tự lập kế hoạch và giải quyết các bước của chính nó. Đây chính là mục đích của khả năng lập luận tự động, và nó thực sự có thể nhanh hơn so với việc bạn phải kiểm tra thủ công và làm vai trò "người kiểm soát giữa chừng."

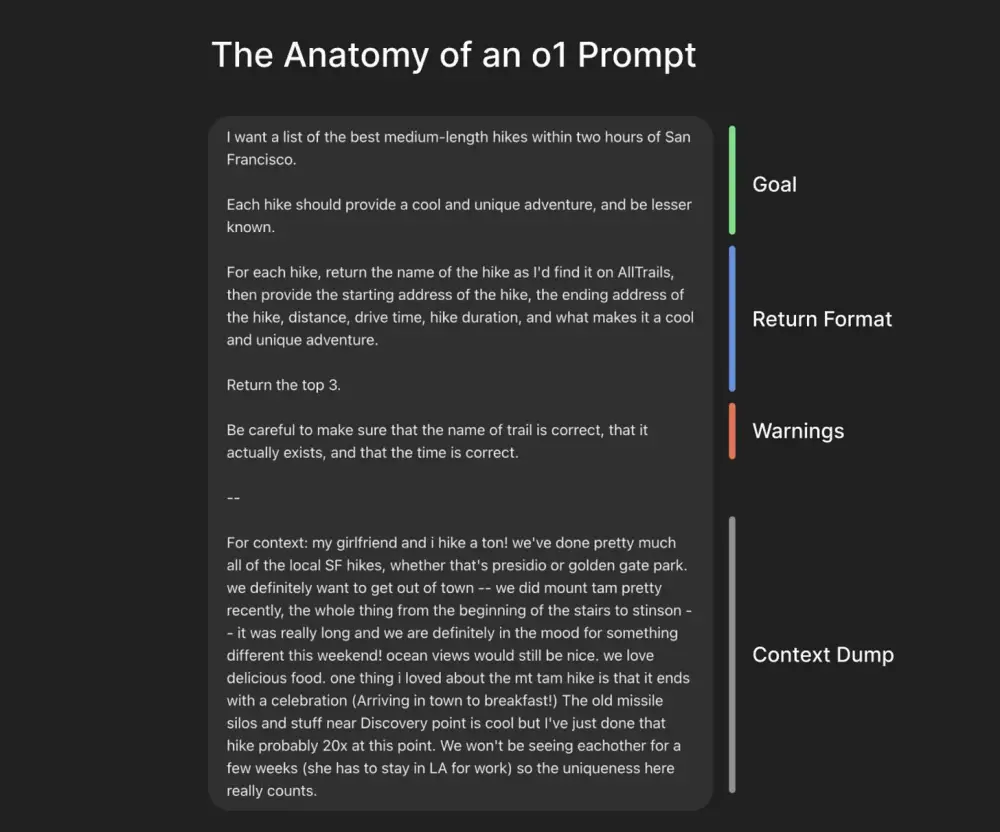

Hylak cũng bao gồm một ảnh chụp màn hình được chú thích rõ ràng về một lời nhắc mẫu cho o1 đã tạo ra một kết quả hữu ích, chẳng hạn như danh sách các tuyến đường leo núi.

The Anatomy of an o1 Prompt

Goal:

I want a list of the best medium-length hikes within two hours of San Francisco.

Each hike should provide a cool and unique adventure, and be lesser known.

Return Format:

For each hike, return the name of the hike as I’d find it on AllTrails, then provide the starting address of the hike, the ending address of the hike, distance, drive time, hike duration, and what makes it a cool and unique adventure.

Return the top 3.

Warnings:

Be careful to make sure that the name of trail is correct, that it actually exists, and that the time is correct.

Context Dump:

For context: my girlfriend and I hike a ton! We’ve done pretty much all of the local SF hikes, whether that's Presidio or Golden Gate Park. We definitely want to get out of town — we did Mount Tam pretty recently, the whole thing from the beginning of the stairs to Stinson — it was really long and we are definitely in the mood for something different this weekend! Ocean views would still be nice. We love delicious food. One thing I loved about the Mt Tam hike is that it ends with a celebration (Arriving in town to breakfast!). The old missile silos and stuff near Discovery Point is cool but I’ve just done that hike probably 20x at this point. We won’t be seeing each other for a few weeks (she has to stay in LA for work) so the uniqueness here really counts.

Bài viết trên blog này hữu ích đến mức, Greg Brockman, chủ tịch kiêm đồng sáng lập OpenAI, đã chia sẻ lại trên tài khoản X của mình với thông điệp: “o1 là một loại mô hình khác. Hiệu năng cao yêu cầu cách sử dụng khác so với các mô hình chat thông thường.”

Tôi cũng đã thử nghiệm cách này cho mục tiêu học nói tiếng Tây Ban Nha trôi chảy và đây là kết quả mà tôi nhận được. Có thể chưa ấn tượng như lời nhắc và phản hồi được xây dựng kỹ lưỡng của Hylak, nhưng chắc chắn cho thấy tiềm năng mạnh mẽ.

Ngay cả với các LLM không lập luận

Ngay cả khi nói đến các LLM không lập luận như Claude 3.5 Sonnet, vẫn có chỗ để người dùng thông thường cải thiện cách xây dựng lời nhắc để nhận được kết quả tốt hơn và ít bị giới hạn hơn.

Louis Arge, cựu kỹ sư của Teton.ai và hiện là người sáng lập thiết bị neuromodulation openFUS, đã viết trên X: “Một mẹo tôi phát hiện ra là LLM tin tưởng lời nhắc của chính nó hơn là lời nhắc của tôi,” và cung cấp một ví dụ về cách anh thuyết phục Claude trở nên “ít sợ hãi hơn” bằng cách đầu tiên “kích động một cuộc tranh luận” với mô hình về đầu ra của nó.

Tất cả điều này cho thấy rằng kỹ năng xây dựng lời nhắc vẫn là một kỹ năng có giá trị khi kỷ nguyên AI tiếp tục phát triển.

Thảo luận

Follow Us

Tin phổ biến