Cải thiện hiệu suất LLM với kỹ thuật constrained chain-of-thought mới

• Các nhà nghiên cứu từ Khoa Xuất sắc về Robotics và AI tại Scuola Superiore Sant'Anna và Mediavoice Srl đã phân tích ảnh hưởng của độ dài đầu ra đến thời gian suy luận của LLM.

• Họ đề xuất các chỉ số mới để đánh giá sự ngắn gọn và chính xác của đầu ra.

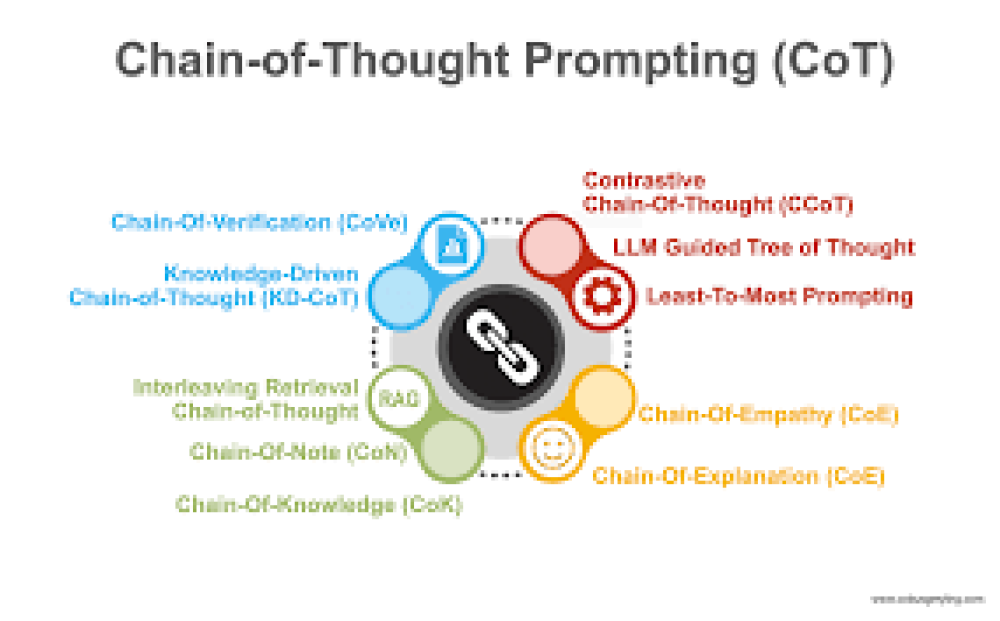

• Nghiên cứu giới thiệu chiến lược kỹ thuật prompt tinh chỉnh gọi là Constrained-Chain-of-Thought (CCoT), giới hạn độ dài đầu ra để cải thiện độ chính xác và thời gian phản hồi.

• Các thử nghiệm với LLaMA2-70b trên bộ dữ liệu GSM8K cho thấy việc giới hạn suy luận trong 100 từ đã cải thiện độ chính xác và giảm độ dài đầu ra.

• Nghiên cứu nhấn mạnh sự cần thiết của việc ngắn gọn trong suy luận của LLM và hiệu quả khác nhau của CCoT trên các kích thước mô hình khác nhau.

• Các nghiên cứu gần đây về LLM tập trung vào cải thiện độ chính xác, thường dẫn đến phản hồi dài hơn và chi tiết hơn.

• Đầu ra mở rộng có thể gây ra hiện tượng ảo giác, khi mô hình tạo ra thông tin hợp lý nhưng không chính xác và giải thích quá dài che khuất thông tin chính.

• Thời gian tạo đầu ra của LLM bị ảnh hưởng bởi các yếu tố như kiến trúc mô hình, tiền xử lý, giải mã và prompt được sử dụng.

• Các thử nghiệm trên nhiều mô hình (Falcon-7b/40b, Llama2-7b/70b) cho thấy khi độ dài đầu ra tăng, thời gian tạo cũng tăng.

• CCoT được đề xuất để giới hạn độ dài đầu ra trong khi vẫn duy trì độ chính xác, giảm thời gian tạo hiệu quả.

• Các thử nghiệm đánh giá hiệu quả của phương pháp CCoT so với CoT cổ điển, tập trung vào hiệu quả, độ chính xác và khả năng kiểm soát độ dài đầu ra.

• Kết quả cho thấy CCoT giảm thời gian tạo và có thể cải thiện hoặc duy trì độ chính xác.

• Nghiên cứu cũng giới thiệu các chỉ số mới (HCA, SCA, CCA) để đánh giá hiệu suất mô hình, xem xét tính chính xác và ngắn gọn.

• Các mô hình lớn hơn như Llama2-70b được hưởng lợi nhiều hơn từ CCoT, trong khi các mô hình nhỏ hơn gặp khó khăn.

• CCoT thể hiện hiệu quả cải thiện và độ chính xác ngắn gọn, đặc biệt là đối với các LLM lớn hơn.

📌 Nghiên cứu giới thiệu kỹ thuật CCoT để tối ưu hóa LLM, giúp cải thiện độ chính xác và thời gian phản hồi bằng cách giới hạn độ dài đầu ra. Thử nghiệm trên LLaMA2-70b cho thấy hiệu quả khi giới hạn suy luận trong 100 từ. CCoT đặc biệt hiệu quả với các mô hình lớn như Llama2-70b và Falcon-40b.

https://www.marktechpost.com/2024/08/02/optimizing-large-language-models-for-concise-and-accurate-responses-through-constrained-chain-of-thought-prompting/

Thảo luận

Follow Us

Tin phổ biến