Chatbot Arena - công cụ đánh giá AI đang gây tranh cãi về tính khách quan và minh bạch

• Chatbot Arena, một công cụ đánh giá mô hình AI do tổ chức phi lợi nhuận LMSYS phát triển, đã trở thành tiêu chuẩn phổ biến trong ngành công nghiệp AI.

• LMSYS được thành lập vào tháng 4/2023 bởi các sinh viên và giảng viên từ Carnegie Mellon, UC Berkeley's SkyLab và UC San Diego. Mục tiêu ban đầu là phát triển và mở nguồn các mô hình AI tạo sinh.

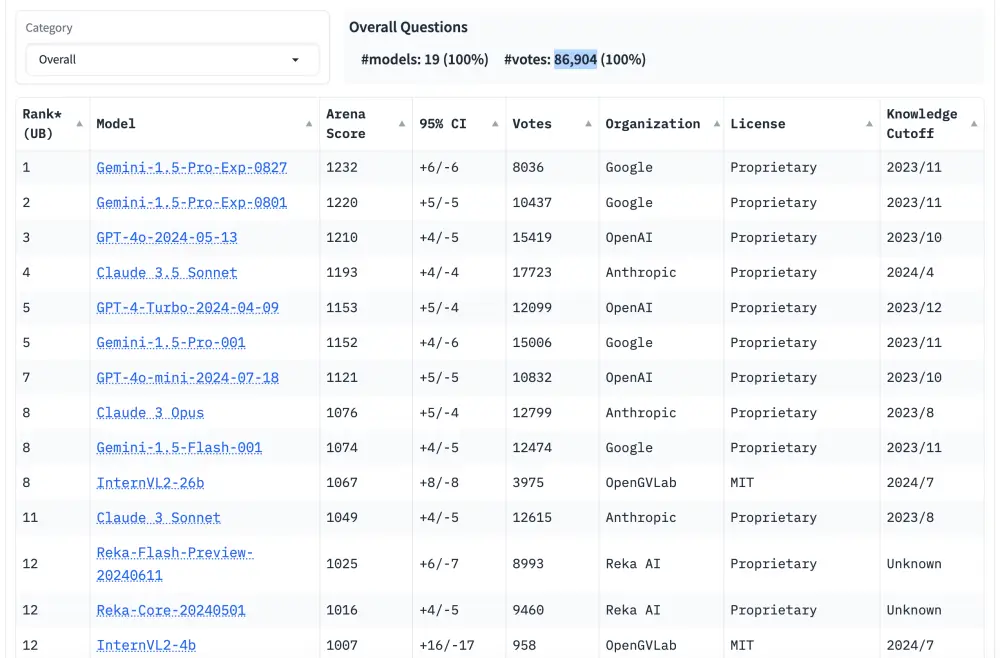

• Chatbot Arena cho phép người dùng đặt câu hỏi cho hai mô hình ngẫu nhiên ẩn danh và bình chọn câu trả lời họ thích hơn. Dữ liệu này được sử dụng để xếp hạng các mô hình.

• Công cụ này đã thu hút hơn 1 triệu lượt truy cập trong năm qua và có hơn 54.000 người theo dõi trên X (Twitter).

• Tuy nhiên, các chuyên gia như Yuchen Lin từ Allen Institute for AI và Mike Cook từ Queen Mary University of London đã chỉ ra một số hạn chế:

• Thiếu minh bạch về các khả năng và kỹ năng cụ thể mà Chatbot Arena đang đánh giá.

• Không tính đến khả năng phát hiện ảo giác của người dùng và sự khác biệt trong sở thích cá nhân.

• Cơ sở người dùng hiện tại có thể không đại diện, chủ yếu là người trong ngành công nghệ.

• Các công ty có thể tối ưu hóa mô hình của họ dựa trên dữ liệu sử dụng, tạo ra lợi thế không công bằng.

• LMSYS có mối quan hệ thương mại với một số công ty AI, gây lo ngại về tính khách quan.

• Để cải thiện, các chuyên gia đề xuất:

• Thiết kế các bài kiểm tra theo chủ đề cụ thể để đánh giá có hệ thống hơn.

• Tăng cường minh bạch về phương pháp và dữ liệu.

• Kiểm soát tốt hơn các yếu tố như phong cách và nội dung câu trả lời.

• Mở rộng và đa dạng hóa cơ sở người dùng đánh giá.

📌 Chatbot Arena đã trở thành công cụ đánh giá AI phổ biến nhưng vẫn còn nhiều hạn chế. Các vấn đề chính bao gồm thiếu minh bạch, thiên lệch người dùng và mối quan hệ thương mại. Cần cải thiện phương pháp để đánh giá khách quan và toàn diện hơn về khả năng của các mô hình AI.

https://techcrunch.com/2024/09/05/the-ai-industry-is-obsessed-with-chatbot-arena-but-it-might-not-be-the-best-benchmark/

Thảo luận

Follow Us

Tin phổ biến