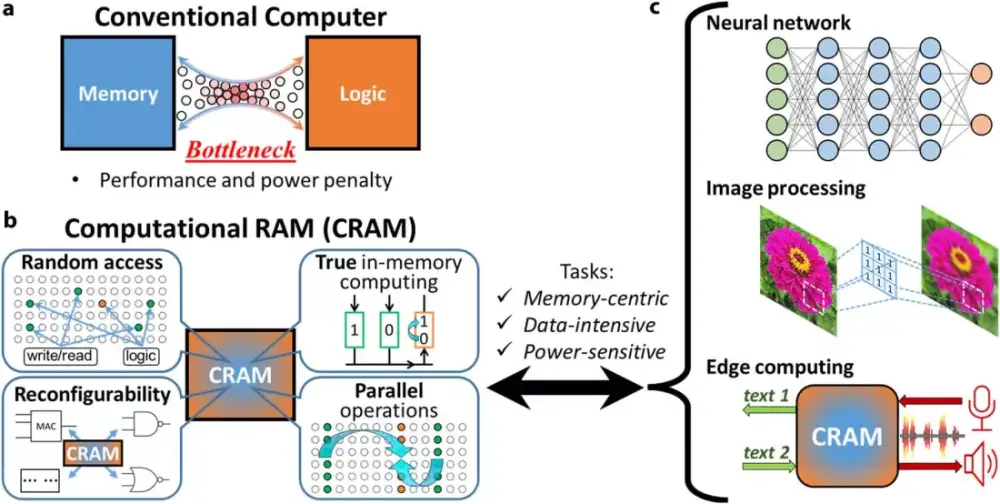

Công nghệ CRAM đột phá loại bỏ mô hình von Neumann, giúp AI tiết kiệm năng lượng gấp 1.000 lần

• Các nhà nghiên cứu từ Đại học Minnesota đã phát triển một chip prototype "bộ nhớ truy cập ngẫu nhiên tính toán" (CRAM) có thể giảm nhu cầu năng lượng cho các ứng dụng AI tới 1.000 lần hoặc hơn so với các phương pháp hiện tại.

• Trong một mô phỏng, công nghệ CRAM cho thấy khả năng tiết kiệm năng lượng lên tới 2.500 lần.

• CRAM hoàn toàn đảo ngược mô hình von Neumann truyền thống bằng cách thực hiện tính toán trực tiếp trong bộ nhớ sử dụng các thiết bị spintronics gọi là magnetic tunnel junctions (MTJs).

• Thay vì dựa vào điện tích để lưu trữ dữ liệu, các thiết bị spintronics tận dụng spin của electron, mang lại giải pháp hiệu quả hơn so với các chip dựa trên transistor truyền thống.

• Bằng cách loại bỏ việc truyền dữ liệu tốn nhiều năng lượng giữa logic và bộ nhớ, công nghệ CRAM có thể đóng vai trò quan trọng trong việc giúp AI tiết kiệm năng lượng hơn rất nhiều.

• Cơ quan Năng lượng Quốc tế dự báo vào tháng 3 rằng mức tiêu thụ điện toàn cầu cho đào tạo và ứng dụng AI có thể tăng hơn gấp đôi từ 460 terawatt-giờ năm 2022 lên hơn 1.000 terawatt-giờ vào năm 2026 - gần bằng mức tiêu thụ của toàn bộ Nhật Bản.

• Nền tảng của đột phá này đã được phát triển trong hơn 20 năm, bắt đầu từ công trình tiên phong của giáo sư kỹ thuật Jian-Ping Wang về việc sử dụng các nanodevice MTJ cho mục đích tính toán.

• Giáo sư Wang thừa nhận rằng các đề xuất ban đầu của họ về việc loại bỏ mô hình von Neumann đã bị coi là "điên rồ" cách đây hai thập kỷ.

• Nhóm nghiên cứu Minnesota đã kiên trì phát triển dựa trên nghiên cứu MTJ được cấp bằng sáng chế của Wang, cho phép sử dụng RAM từ tính (MRAM) hiện đang được sử dụng trong đồng hồ thông minh và các hệ thống nhúng khác.

• Các nhà nghiên cứu vẫn cần giải quyết những thách thức về khả năng mở rộng, sản xuất và tích hợp với silicon hiện có.

• Họ đang lên kế hoạch hợp tác demo với các công ty hàng đầu trong ngành bán dẫn để giúp CRAM trở thành hiện thực thương mại.

📌 Công nghệ CRAM đột phá từ Đại học Minnesota có thể giảm nhu cầu năng lượng cho AI tới 1.000 lần bằng cách tính toán trực tiếp trong bộ nhớ. Dự kiến tiêu thụ điện toàn cầu cho AI sẽ tăng từ 460 lên 1.000 terawatt-giờ vào năm 2026, công nghệ này hứa hẹn mang lại giải pháp tiết kiệm năng lượng đáng kể.

https://www.techspot.com/news/104005-breakthrough-cram-technology-ditches-von-neumann-model-makes.html

Thảo luận

Follow Us

Tin phổ biến