DAPO của ByteDance: Hệ thống học tăng cường nguồn mở dành cho LLM giúp cải thiện khả năng lập luận toán học

-

Các nhà nghiên cứu từ ByteDance, đại học Thanh Hoa và đại học Hồng Kông đã giới thiệu DAPO (Dynamic Sampling Policy Optimization) - hệ thống học tăng cường nguồn mở quy mô lớn nhằm nâng cao khả năng lập luận của mô hình ngôn ngữ lớn.

-

Học tăng cường (RL) đã trở thành phương pháp then chốt để cải thiện khả năng lập luận của LLM cho các tác vụ phức tạp, nhưng cộng đồng nghiên cứu gặp khó khăn trong việc tái tạo kỹ thuật tiên tiến do các công ty lớn không công bố đầy đủ chi tiết đào tạo.

-

DAPO giải quyết vấn đề này bằng cách công khai chia sẻ tất cả chi tiết thuật toán, quy trình đào tạo và bộ dữ liệu, được xây dựng trên nền tảng verl, bao gồm mã đào tạo và bộ dữ liệu DAPO-Math-17K được thiết kế đặc biệt cho các tác vụ lập luận toán học.

-

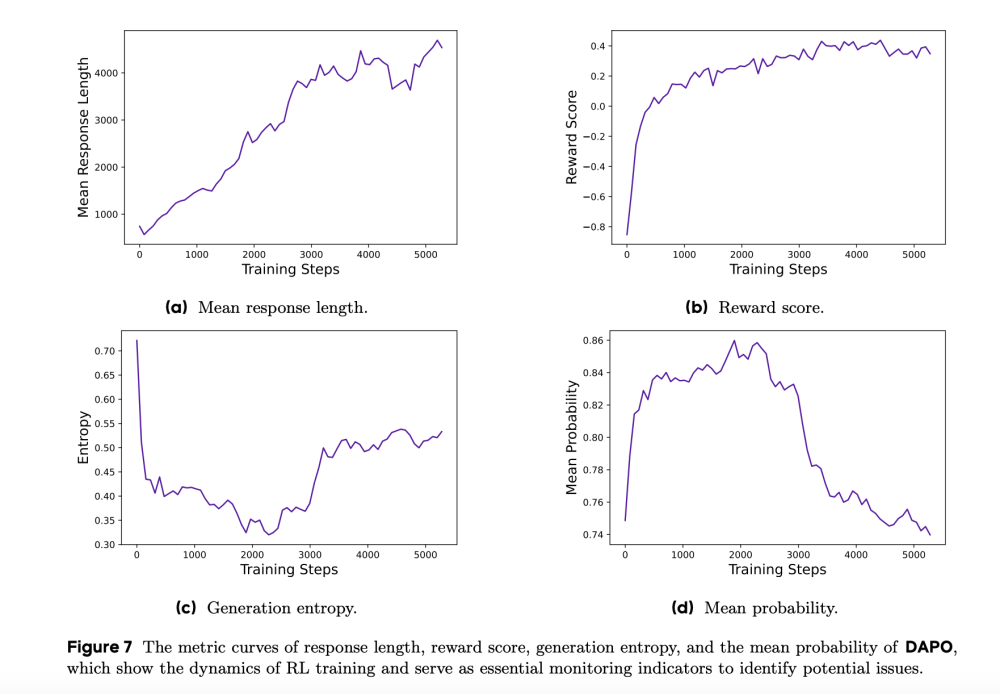

Hệ thống giới thiệu bốn cải tiến kỹ thuật: "Clip-Higher" ngăn chặn sự sụp đổ entropy và khuyến khích đa dạng kết quả, "Dynamic Sampling" lọc mẫu dựa trên mức độ hữu ích, "Token-level Policy Gradient Loss" tập trung vào điều chỉnh cấp token thay vì toàn bộ mẫu, và "Overlong Reward Shaping" phạt nhẹ các phản hồi quá dài.

-

Trong thử nghiệm thực tế, DAPO đã đạt điểm số 50 trên bộ dữ liệu AIME 2024 khi sử dụng mô hình Qwen2.5-32B, vượt trội hơn phương pháp DeepSeek-R1-Zero-Qwen-32B (47 điểm) với chỉ khoảng một nửa số bước đào tạo.

-

Phân tích hệ thống cho thấy sự cải thiện từng bước của các kỹ thuật được giới thiệu, từ mức cơ sở 30 điểm (chỉ sử dụng GRPO) lên tới 50 điểm với phương pháp DAPO đầy đủ.

-

Ngoài kết quả định lượng, quá trình đào tạo DAPO còn cung cấp hiểu biết sâu sắc về sự phát triển của các mẫu lập luận. Ban đầu, các mô hình thể hiện ít hành vi phản ánh, thường tiến triển tuyến tính qua các tác vụ mà không xem xét lại các bước trước đó.

-

Tuy nhiên, sau thời gian đào tạo, các mô hình dần thể hiện nhiều hành vi phản ánh hơn, chứng minh khả năng tự đánh giá lặp lại, cho thấy khả năng của học tăng cường không chỉ nâng cao các cách lập luận hiện có mà còn phát triển chiến lược nhận thức mới.

-

Việc công khai mã nguồn DAPO đại diện cho một đóng góp quan trọng cho cộng đồng học tăng cường, loại bỏ rào cản từ các phương pháp không thể tiếp cận trước đây.

-

Nỗ lực hợp tác giữa ByteDance, đại học Thanh Hoa và đại học Hồng Kông thể hiện tiềm năng của nghiên cứu minh bạch và hợp tác để thúc đẩy hiểu biết chung và khả năng thực tiễn của hệ thống học tăng cường quy mô lớn.

📌 DAPO - hệ thống học tăng cường nguồn mở do ByteDance phát triển đã đạt 50 điểm trên bộ đánh giá AIME 2024 với mô hình Qwen2.5-32B, vượt trội hơn các phương pháp trước đó nhờ bốn cải tiến kỹ thuật: Clip-Higher, Dynamic Sampling, Token-level Policy Gradient Loss và Overlong Reward Shaping.

https://www.marktechpost.com/2025/03/17/bytedance-research-releases-dapo-a-fully-open-sourced-llm-reinforcement-learning-system-at-scale/

Thảo luận

Follow Us

Tin phổ biến