DeepSeek-V3: Mô hình AI cực lớn mã nguồn mở đánh bại Llama và Qwen ngay từ khi ra mắt

- DeepSeek, một công ty khởi nghiệp AI Trung Quốc, đã ra mắt mô hình DeepSeek-V3, mô hình AI mã nguồn mở lớn nhất với 671B thông số.

- DeepSeek-V3 sử dụng kiến trúc mixture-of-experts, cho phép chọn lọc các thông số để thực hiện nhiệm vụ hiệu quả và chính xác.

- Mô hình này đã vượt qua các mô hình mã nguồn mở hàng đầu hiện tại như Llama 3.1-405B và Qwen 2.5-72B, có hiệu suất gần tương đương với các mô hình đóng của Anthropic và OpenAI.

- DeepSeek-V3 áp dụng kiến trúc multi-head latent attention (MLA) cùng với DeepSeekMoE, cho phép sử dụng 37B thông số cho mỗi token.

- Hai cải tiến chính trong mô hình bao gồm chiến lược tải cân bằng không mất thêm chi phí và khả năng dự đoán nhiều token cùng lúc (MTP), giúp model hoạt động nhanh gấp 3 lần, tạo ra 60 token mỗi giây.

- Trong quá trình huấn luyện, DeepSeek-V3 được huấn luyện trên 14.8T token chất lượng cao và đa dạng, với chiều dài ngữ cảnh tối đa được mở rộng đến 128K.

- Tổng chi phí huấn luyện DeepSeek-V3 vào khoảng 5,57 triệu USD, thấp hơn nhiều so với hàng trăm triệu USD thường thấy ở các mô hình ngôn ngữ lớn khác.

- DeepSeek-V3 đạt điểm số cao nhất trong các bài kiểm tra liên quan đến tiếng Trung và toán học, với điểm số 90.2 trong bài kiểm tra Math-500.

- Mô hình này hiện có sẵn trên GitHub theo giấy phép MIT và có thể được thử nghiệm qua nền tảng DeepSeek Chat.

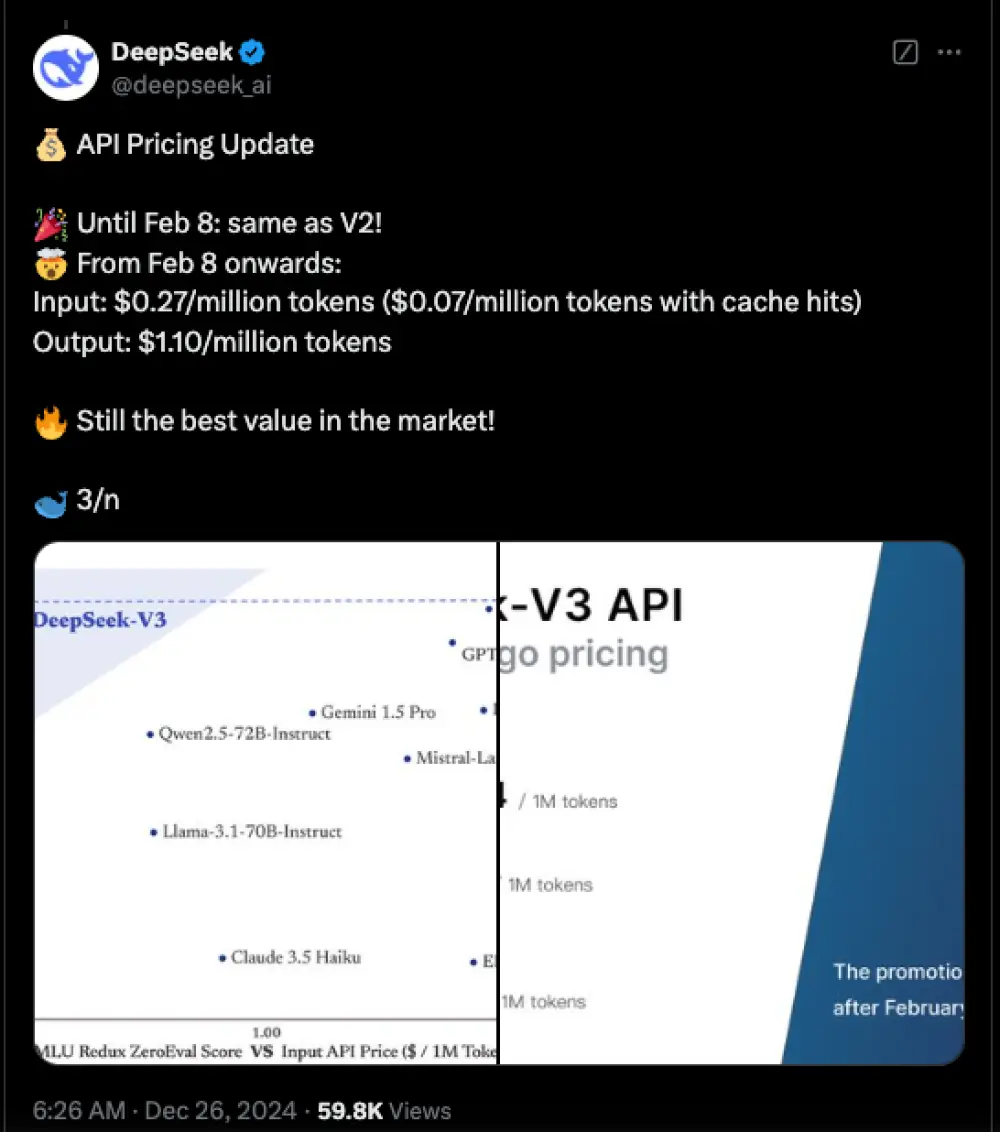

- Giá trị API của DeepSeek sẽ giữ nguyên cho đến ngày 8 tháng 2, sau đó sẽ tính phí 0.27 USD/triệu token đầu vào.

📌 DeepSeek-V3 ra mắt với 671B thông số và thực hiện 2788K giờ GPU, vượt qua Llama và Qwen, khẳng định vị thế của AI mã nguồn mở với hiệu suất ấn tượng trong các bài kiểm tra toán học và ngôn ngữ.

https://venturebeat.com/ai/deepseek-v3-ultra-large-open-source-ai-outperforms-llama-and-qwen-on-launch/

Thảo luận

Follow Us

Tin phổ biến