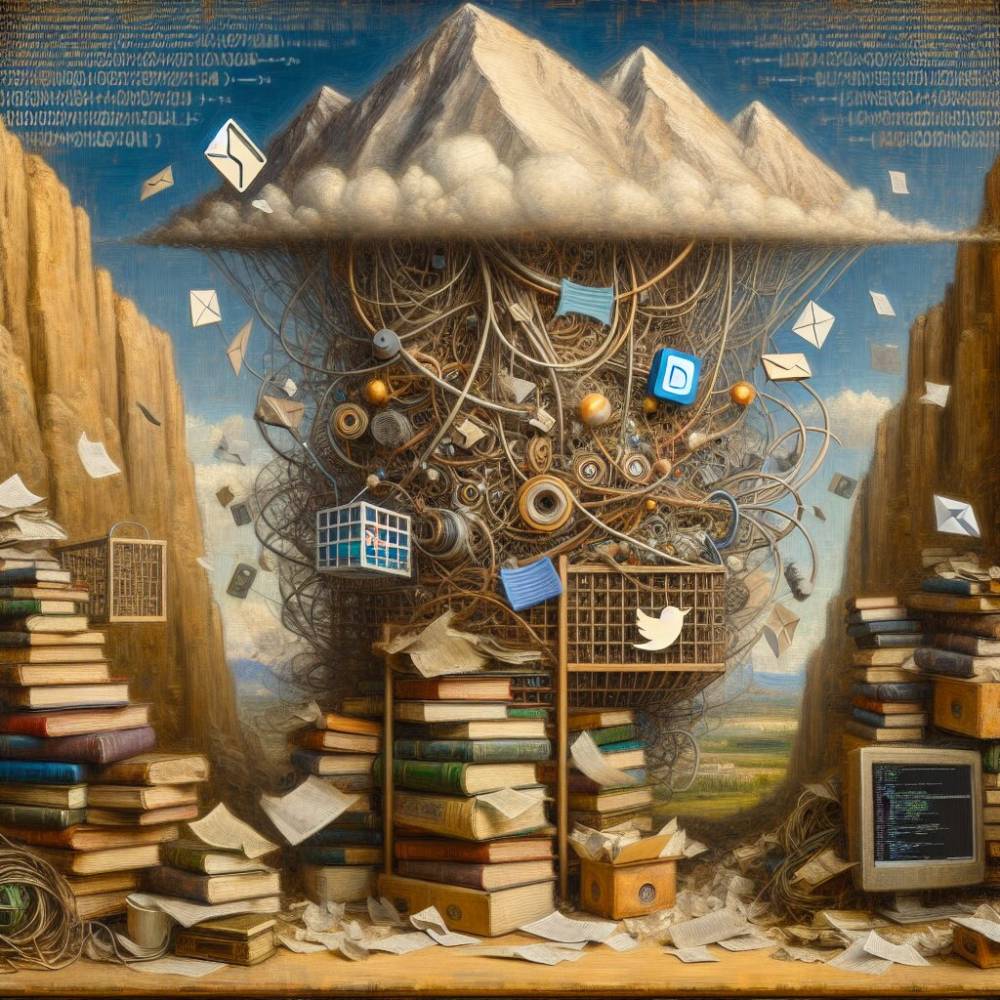

Dữ liệu huấn luyện LLM đang cạn kiệt: chúng ta gần đến giới hạn đến mức nào?

- **Tweet của Mark Cummins**: Đề cập đến việc chúng ta đang gần cạn kiệt nguồn dữ liệu văn bản toàn cầu cần thiết cho việc huấn luyện các mô hình ngôn ngữ lớn (LLM) do sự gia tăng tiêu thụ dữ liệu và yêu cầu khắt khe của các LLM thế hệ mới.

- **Dữ liệu web**: Phần văn bản tiếng Anh của tập dữ liệu FineWeb, một phần của dữ liệu web Common Crawl, có khoảng 15 nghìn tỷ token. Khi thêm nội dung web không phải tiếng Anh chất lượng cao, tập dữ liệu này có thể tăng gấp đôi kích thước.

- **Kho mã nguồn**: Khoảng 0,78 nghìn tỷ token được đóng góp bởi mã nguồn công khai, như trong tập dữ liệu Stack v2. Tổng lượng mã nguồn trên toàn thế giới ước tính lên đến hàng chục nghìn tỷ token.

- **Ấn phẩm học thuật và bằng sáng chế**: Tổng khối lượng của các ấn phẩm học thuật và bằng sáng chế là khoảng 1 nghìn tỷ token, một phần dữ liệu văn bản độc đáo nhưng đáng kể.

- **Sách**: Các bộ sưu tập sách kỹ thuật số từ các trang như Google Books và Anna’s Archive có hơn 21 nghìn tỷ token. Khi tính đến mọi cuốn sách khác biệt trên thế giới, tổng số token có thể lên đến 400 nghìn tỷ.

- **Lưu trữ mạng xã hội**: Nội dung do người dùng tạo trên các nền tảng như Weibo và Twitter chiếm khoảng 49 nghìn tỷ token. Facebook nổi bật với 140 nghìn tỷ token, nhưng đây là nguồn tài nguyên khó tiếp cận do các vấn đề về quyền riêng tư và đạo đức.

- **Chuyển đổi âm thanh thành văn bản**: Các nguồn âm thanh công khai như YouTube và TikTok đóng góp khoảng 12 nghìn tỷ token vào tập dữ liệu huấn luyện.

- **Giao tiếp cá nhân**: Email và các cuộc trò chuyện tức thời lưu trữ có tổng cộng khoảng 1.800 nghìn tỷ token. Việc tiếp cận dữ liệu này bị hạn chế, gây ra các vấn đề về quyền riêng tư và đạo đức.

- **Giới hạn hiện tại**: Các tập dữ liệu huấn luyện LLM hiện tại gần đạt mức 15 nghìn tỷ token, đại diện cho lượng văn bản tiếng Anh chất lượng cao có sẵn. Việc tiếp cận các nguồn khác như sách, chuyển đổi âm thanh và các ngôn ngữ khác có thể tăng tổng số token lên 60 nghìn tỷ.

- **Dữ liệu tổng hợp**: Do hạn chế về nguồn dữ liệu văn bản có thể chấp nhận về mặt đạo đức, việc tạo dữ liệu tổng hợp trở thành hướng đi quan trọng cho nghiên cứu AI trong tương lai. Các kho dữ liệu tư nhân của Google và Facebook có số lượng token lên đến hàng nghìn tỷ, nhưng không thể tiếp cận được.

📌 Sự cạn kiệt dữ liệu huấn luyện LLM đang đến gần, với các tập dữ liệu hiện tại gần đạt mức 15 nghìn tỷ token. Việc tạo dữ liệu tổng hợp trở nên quan trọng để duy trì sự phát triển AI, với các nguồn dữ liệu tư nhân không thể tiếp cận và các vấn đề đạo đức cần được giải quyết.

https://www.marktechpost.com/2024/05/14/large-language-model-llm-training-data-is-running-out-how-close-are-we-to-the-limit/

Thảo luận

Follow Us

Tin phổ biến