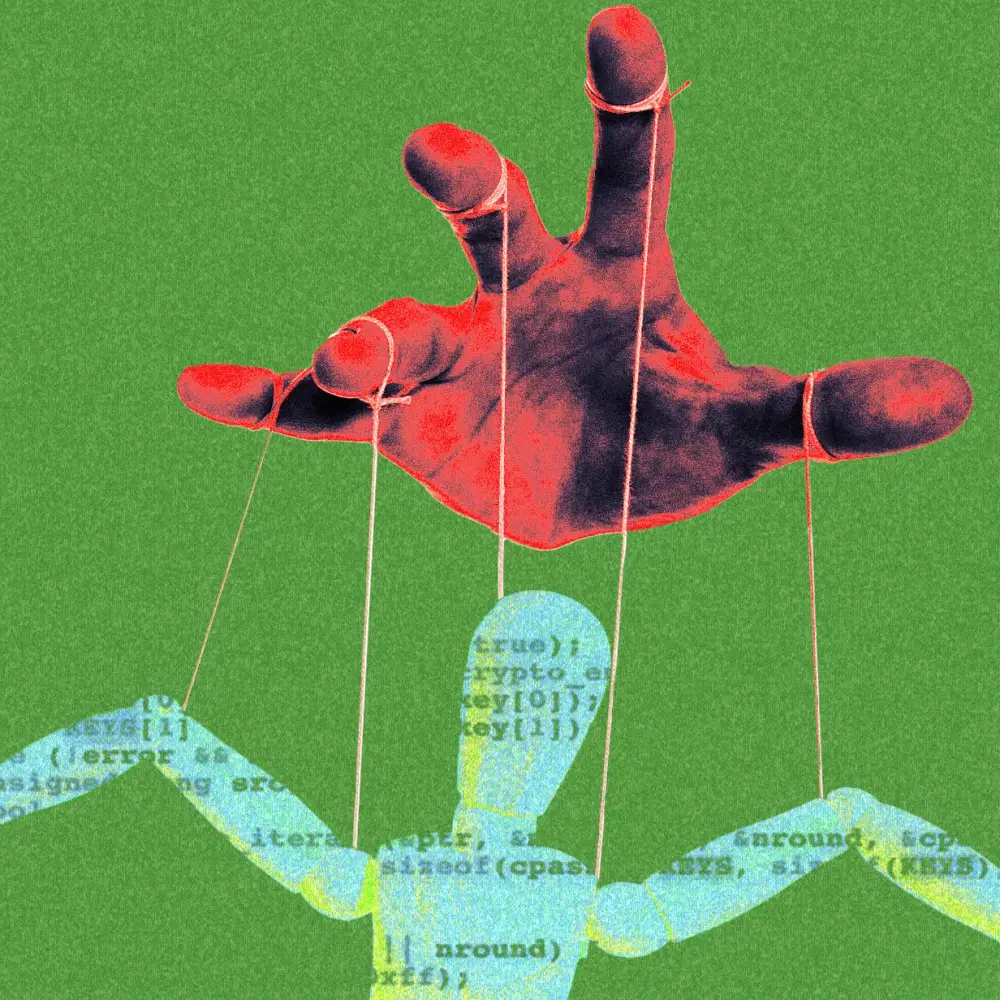

FlexOlmo: Mô hình AI đầu tiên cho phép rút dữ liệu ra sau khi huấn luyện

-

FlexOlmo là mô hình ngôn ngữ lớn mới do Allen Institute for AI (Ai2) phát triển, cho phép chủ dữ liệu rút dữ liệu khỏi mô hình ngay cả sau khi đã huấn luyện.

-

Mô hình này phá vỡ nguyên lý truyền thống rằng “dữ liệu đã dùng thì không thể gỡ”, bằng cách cho phép huấn luyện theo cách chia tách và hợp nhất các sub-model độc lập.

-

Cơ chế hoạt động dựa trên kiến trúc mixture of experts, cho phép kết hợp nhiều mô hình nhỏ, trong đó mỗi mô hình có thể được huấn luyện riêng biệt với dữ liệu riêng.

-

Người đóng góp dữ liệu sao chép một mô hình “anchor” công khai, huấn luyện với dữ liệu cá nhân, rồi gửi bản kết hợp thay vì phải chia sẻ dữ liệu thô.

-

Điều này giúp giữ quyền sở hữu dữ liệu, cho phép rút sub-model nếu có tranh chấp pháp lý hoặc không hài lòng với việc sử dụng mô hình cuối.

-

FlexOlmo không yêu cầu huấn luyện đồng bộ – việc đóng góp và huấn luyện có thể diễn ra hoàn toàn độc lập.

-

Ai2 đã thử nghiệm bằng cách xây dựng mô hình 37 tỷ tham số trên tập dữ liệu Flexmix, bao gồm sách và nội dung từ web độc quyền.

-

Mô hình này vượt trội so với từng mô hình riêng lẻ và tốt hơn 10% so với các phương pháp hợp nhất mô hình trước đó trên các benchmark phổ biến.

-

FlexOlmo còn giúp các công ty truy cập dữ liệu nhạy cảm mà không cần tiết lộ công khai, nhưng Ai2 cảnh báo vẫn có rủi ro khôi phục dữ liệu – cần đến các kỹ thuật như differential privacy.

-

Trong bối cảnh tranh cãi về quyền sở hữu dữ liệu huấn luyện AI ngày càng gay gắt, mô hình như FlexOlmo mở ra hướng đi mới cân bằng giữa tiến bộ công nghệ và quyền lợi dữ liệu.

📌 FlexOlmo mang đến một đột phá lớn trong lĩnh vực AI tạo sinh bằng cách cho phép các chủ sở hữu dữ liệu rút dữ liệu khỏi mô hình sau huấn luyện mà không cần retrain. Với 37 tỷ tham số và hiệu suất cao hơn 10% so với phương pháp cũ, mô hình này giúp cân bằng giữa phát triển AI và kiểm soát dữ liệu cá nhân, mở ra tương lai mới cho AI nguồn mở và hợp tác.

https://www.wired.com/story/flexolmo-ai-model-lets-data-owners-take-control/

A New Kind of AI Model Lets Data Owners Take Control

Thảo luận

Follow Us

Tin phổ biến