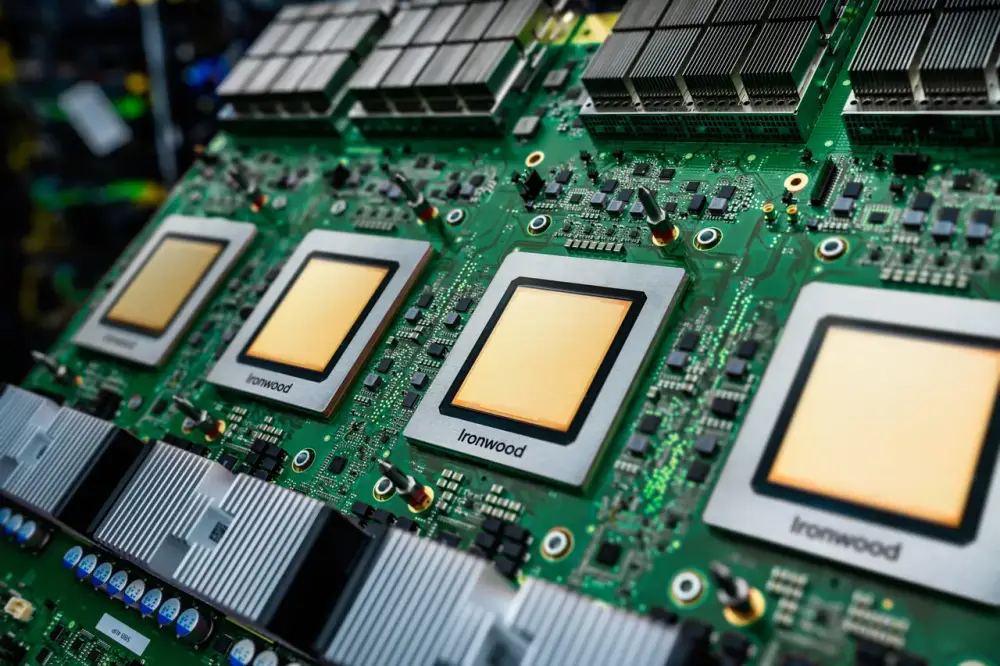

Google ra mắt chip Ironwood TPU mới tập trung vào suy luận AI

- Google vừa công bố phiên bản mới nhất của Tensor Processing Unit (TPU) tại sự kiện Google Cloud Next 25.

- Chip Ironwood TPU lần đầu tiên được định vị cho suy luận AI, thay vì huấn luyện như các phiên bản trước.

- Sự chuyển hướng này phản ánh xu hướng AI đang chuyển từ dự án nghiên cứu sang ứng dụng thực tế trong doanh nghiệp.

- Sự gia tăng của các mô hình AI "lý luận" như Gemini đã tạo ra nhu cầu tính toán và chi phí khổng lồ cho suy luận.

- Ironwood mang lại hiệu suất gấp đôi so với phiên bản Trillium trước đó, đạt 29,3 nghìn tỷ phép tính dấu phẩy động mỗi giây.

- Chip mới có 192GB bộ nhớ DRAM, gấp 6 lần Trillium, với băng thông truyền tải 7,2 terabit/giây, gấp 4,5 lần.

- Google nhấn mạnh khả năng mở rộng của Ironwood, có thể kết hợp hàng trăm nghìn chip để tăng tốc hiệu suất.

- Việc tập trung vào chip suy luận đánh dấu sự thay đổi trong chiến lược của Google, giảm phụ thuộc vào Intel, AMD và Nvidia.

- Các nhà phân tích cho rằng TPU có thể giúp Google tiết kiệm chi phí cơ sở hạ tầng AI đang tăng vọt.

- Google cũng công bố phần mềm Pathways on Cloud để phân phối công việc tính toán AI trên nhiều máy tính.

- Sự ra mắt của Ironwood phản ánh nhu cầu ngày càng tăng về suy luận AI trong thời gian thực cho hàng triệu người dùng.

📌 Chip Ironwood TPU mới của Google đánh dấu bước ngoặt quan trọng, tập trung vào tối ưu hóa chi phí suy luận AI. Với hiệu suất gấp đôi và bộ nhớ gấp 6 lần phiên bản trước, Ironwood hứa hẹn mang lại tiềm năng lớn cho việc mở rộng quy mô AI trong thực tế.

https://www.zdnet.com/article/googles-latest-chip-is-all-about-reducing-one-huge-hidden-cost-in-ai/

Thảo luận

Follow Us

Tin phổ biến