Gyan AI ra mắt mô hình ngôn ngữ toán học Paramanu-Ganita với 208 triệu tham số, vượt trội hơn các mô hình lớn hơn như LLama và Falcon

- Gyan AI đã ra mắt Paramanu-Ganita, một mô hình ngôn ngữ toán học với 208 triệu tham số, nhỏ hơn 35 lần so với các mô hình lớn hơn.

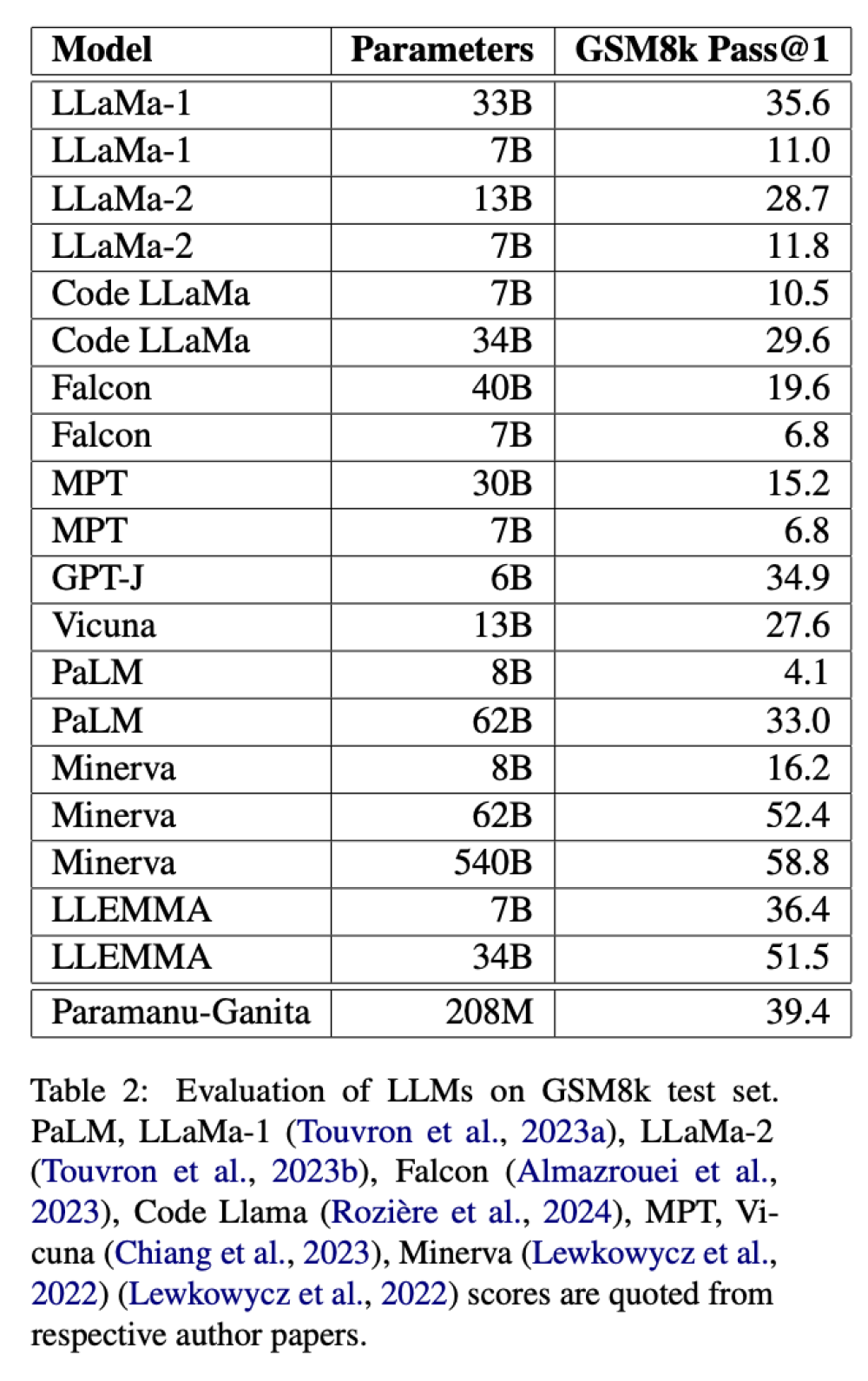

- Mặc dù quy mô khiêm tốn, Paramanu-Ganita vượt trội hơn đáng kể so với các mô hình tổng quát như LLama, Falcon và mô hình chuyên biệt như Minerva trong bài kiểm tra chuẩn GSM8k.

- Thành công của mô hình cho thấy hiệu quả của việc phát triển các mô hình chuyên biệt từ đầu thay vì điều chỉnh các mô hình ngôn ngữ tổng quát cho các lĩnh vực cụ thể.

- Nhóm nghiên cứu bao gồm Mitodru Niyogi (CEO của Gyan AI) và Arnab Bhattacharya (Giáo sư Khoa học Máy tính và Kỹ thuật tại IIT Kanpur, Ấn Độ, cố vấn AI tại Gyan AI).

- Mô hình được huấn luyện trên một kho ngữ liệu toán học độc đáo, chất lượng cao bao gồm sách giáo khoa, ghi chú bài giảng và tài liệu từ web.

- Quá trình huấn luyện chỉ mất 146 giờ trên A100.

- Thành công của Paramanu-Ganita có thể quy cho chế độ huấn luyện và sự chuyên môn hóa trong toán học.

- Mô hình sử dụng bộ giải mã Auto-Regressive (AR) xử lý thông tin tuần tự, giúp giải quyết hiệu quả các bài toán phức tạp thông qua lập luận logic.

- Hiệu suất của mô hình được đánh giá kỹ lưỡng bằng các chỉ số perplexity và các bài kiểm tra chuẩn.

- Paramanu-Ganita mang lại giải pháp đáng tin cậy, hiệu quả và ít tốn tài nguyên hơn cho các ngành và lĩnh vực phụ thuộc nhiều vào tính toán và mô hình hóa toán học.

📌 Gyan AI đã giới thiệu Paramanu-Ganita, một mô hình ngôn ngữ toán học 208 triệu tham số, vượt trội hơn đáng kể so với LLama, Falcon và Minerva trong bài kiểm tra GSM8k. Mô hình được huấn luyện trên kho ngữ liệu toán học chất lượng cao trong 146 giờ trên chip A100, thể hiện hiệu quả của việc phát triển mô hình chuyên biệt thay vì điều chỉnh từ mô hình tổng quát.

Citations:

[1] https://analyticsindiamag.com/gyan-ai-unveils-smaller-scale-maths-llm-paramanu-ganita-outperforming-llama-falcon/

Thảo luận

Follow Us

Tin phổ biến