Học sâu sau 10 năm: Ilya Sutskever tiết lộ tương lai trí tuệ nhân tạo

- Bài trình bày kỷ niệm 10 năm nghiên cứu mạng nơ-ron của Ilya Sutskever, khởi đầu từ hội nghị NeurIPS 2014 với sự tập trung vào các mô hình auto-regressive, mạng LSTM và nguyên lý "Deep Learning Hypothesis".

- Ý chính từ nghiên cứu 10 năm trước: Sử dụng mô hình auto-regressive để dự đoán các token tiếp theo, đảm bảo phân phối đúng cho chuỗi dữ liệu. Điều này đã dẫn đến thành công trong dịch thuật ngôn ngữ, một nhiệm vụ đầy tham vọng vào thời điểm đó.

- Những hạn chế ban đầu:

- Mạng nơ-ron chỉ có 10 tầng do giới hạn công nghệ.

- Sử dụng pipelining để tăng tốc độ huấn luyện nhưng thiếu hiệu quả.

- Tiến bộ hiện tại: Sự phát triển của pre-training và các mô hình như GPT-2, GPT-3 nhấn mạnh vai trò của mạng lớn, tập dữ liệu lớn trong việc đảm bảo thành công.

- Tầm nhìn tương lai: Dữ liệu tổng hợp và compute inference được coi là giải pháp để vượt qua giới hạn của "đỉnh điểm dữ liệu" do lượng dữ liệu từ internet đã chạm ngưỡng.

- Dẫn chứng từ sinh học: Mối quan hệ giữa kích thước não và cơ thể của các loài động vật gợi ý về những thay đổi trong quy mô, đưa ra bài học cho AI.

- Định hướng phát triển: AI sẽ trở nên tự nhận thức, biết lập luận, và dự đoán. Tuy nhiên, các hệ thống này sẽ trở nên khó dự đoán hơn, giống như các AI chơi cờ vua hiện đại gây bất ngờ cho con người.

- Khả năng tự động điều chỉnh: Mô hình tương lai có thể tự động phát hiện và sửa lỗi, giảm thiểu vấn đề "hallucination" hiện tại.

- Câu hỏi đạo đức: Ilya mở rộng thảo luận về quyền lợi của AI và hệ thống khuyến khích hợp lý cho sự cộng tác giữa AI và con người.

- Thách thức: Định nghĩa lại khả năng "generalization" (khả năng tổng quát hóa) của AI trong các tình huống ngoài phân phối.

📌 Sau 10 năm, học sâu đã chuyển từ mạng LSTM sang các mô hình Transformer lớn, định hình AI qua pre-training và dữ liệu lớn. Tuy nhiên, AI cần đối mặt với hạn chế dữ liệu, khả năng tự nhận thức, và trách nhiệm đạo đức. Tương lai đòi hỏi cách tiếp cận mới như dữ liệu tổng hợp và tính toán suy diễn để tiếp tục phát triển.

Ilya Sutskever: "Sequence to sequence learning with neural networks: what a decade" - YouTube

https://www.youtube.com/watch?v=1yvBqasHLZs

(00:02) Tôi muốn cảm ơn các nhà tổ chức vì đã chọn bài báo này để trao giải. Điều này thật tuyệt vời, và tôi cũng muốn cảm ơn các đồng tác giả và cộng sự tuyệt vời của mình là Oral, Vineel và Qule, những người vừa đứng ngay trước các bạn một lúc trước. Ở đây, bạn thấy một bức ảnh – một ảnh chụp màn hình từ một bài nói chuyện tương tự 10 năm trước tại hội nghị NeurIPS năm 2014 ở Montreal. Đó là một thời kỳ ngây thơ hơn nhiều. Trong bức ảnh, đây là ảnh "trước", còn đây là ảnh "sau". Bây giờ chúng tôi đã có thêm kinh nghiệm và hy vọng cũng khôn ngoan hơn. Nhưng ở đây, tôi muốn nói một chút

(01:02) về chính công trình đó và có lẽ là một cái nhìn lại sau 10 năm. Vì nhiều điều trong công trình này đã đúng, nhưng một số thì không đúng lắm. Chúng ta có thể xem xét chúng, để thấy điều gì đã xảy ra và cách mọi thứ đã nhẹ nhàng dẫn dắt chúng ta đến nơi mà chúng ta đang đứng hôm nay. Vậy hãy bắt đầu bằng việc nói về những gì chúng tôi đã làm. Cách mà chúng tôi sẽ thực hiện là bằng cách trình bày lại các slide từ bài nói chuyện cách đây 10 năm. Nhưng tóm lại, những gì chúng tôi đã làm có thể được gói gọn trong ba ý chính: đây là một mô hình tự hồi quy được huấn luyện trên văn bản, đây là một mạng nơ-ron lớn và đây là một tập dữ liệu lớn. Và chỉ vậy thôi.

(01:51) Giờ hãy đi sâu hơn vào chi tiết một chút. Đây là một slide từ 10 năm trước – không quá tệ. Đây là "Giả thuyết Deep Load". Những gì chúng tôi nói ở đây là nếu bạn có một mạng nơ-ron lớn với 10 tầng, thì nó có thể làm được bất kỳ điều gì mà con người có thể làm trong một phần giây. Tại sao chúng tôi lại nhấn mạnh vào những việc mà con người có thể làm trong một phần giây? Tại sao lại cụ thể là điều này? Nếu bạn tin vào "Giáo điều Học sâu", rằng các nơ-ron nhân tạo và nơ-ron sinh học là tương tự, hoặc ít nhất không quá khác biệt,

(02:32) và bạn tin rằng các nơ-ron thực sự chậm, thì bất cứ điều gì con người có thể làm nhanh chóng – tôi muốn nói tất cả con người, thậm chí chỉ một người duy nhất trên thế giới – nếu có một người duy nhất trên thế giới có thể làm một tác vụ nào đó trong một phần giây, thì một mạng nơ-ron 10 tầng cũng có thể làm được điều đó. Điều này đơn giản: chỉ cần lấy các kết nối của họ và nhúng chúng vào mạng nơ-ron nhân tạo của bạn. Đó chính là động lực: bất cứ điều gì con người có thể làm trong một phần giây,

(03:00) một mạng nơ-ron 10 tầng lớn cũng có thể làm được. Chúng tôi tập trung vào các mạng nơ-ron 10 tầng vì đó là loại mạng mà chúng tôi biết cách huấn luyện vào thời điểm đó. Nếu có thể vượt xa hơn về số tầng, bạn có thể làm được nhiều hơn, nhưng vào lúc đó chúng tôi chỉ có thể làm việc với 10 tầng. Đó là lý do tại sao chúng tôi nhấn mạnh vào những gì con người có thể làm trong một phần giây. Đây là một slide khác từ bài nói chuyện, là slide "Ý tưởng chính của chúng tôi". Bạn có thể nhận ra một số điều, hoặc ít nhất là một điều: có điều gì đó tự hồi quy đang diễn ra ở đây.

(03:34) Slide này thực sự nói gì? Nó nói rằng nếu bạn có một mô hình tự hồi quy và nó dự đoán đủ tốt token tiếp theo, thì nó sẽ thực sự nắm bắt và hiểu đúng phân phối của các chuỗi sẽ xuất hiện tiếp theo. Điều này khá mới mẻ vào thời điểm đó. Nó không phải là mạng nơ-ron tự hồi quy đầu tiên, nhưng tôi sẽ cho rằng nó là mạng đầu tiên mà chúng tôi thực sự tin rằng nếu huấn luyện đủ tốt, thì bạn sẽ đạt được bất cứ điều gì bạn muốn.

(04:10) Trường hợp của chúng tôi khi đó là nhiệm vụ dịch thuật – một nhiệm vụ khiêm tốn ngày nay nhưng cực kỳ táo bạo khi đó. Bây giờ tôi sẽ cho các bạn thấy một lịch sử cổ xưa mà nhiều người có thể chưa từng thấy: đó là LSTM. Đối với những người không quen thuộc, LSTM là những thứ mà các nhà nghiên cứu về học sâu đã làm trước khi có Transformers. Về cơ bản, nó giống ResNet nhưng xoay 90°. Đây là LSTM, một dạng ResNet phức tạp hơn chút.

(04:51) Một tính năng thú vị khác trong bài nói chuyện cũ đó là chúng tôi đã sử dụng song song hóa, nhưng không chỉ là song song hóa mà là "đường ống dẫn" (pipelining). Một tầng cho mỗi GPU – một quyết định không khôn ngoan như chúng ta biết ngày nay. Nhưng vào thời điểm đó, nó giúp tăng tốc độ gấp 3,5 lần với 8 GPU.

(05:28) Slide kết luận, ở một khía cạnh nào đó, là slide quan trọng nhất vì nó đánh dấu sự khởi đầu của "giả thuyết mở rộng" (scaling hypothesis). Ý tưởng rằng nếu bạn có một tập dữ liệu rất lớn và huấn luyện một mạng nơ-ron rất lớn, thì thành công sẽ được đảm bảo. Người ta có thể tranh luận, nếu thiện chí, rằng đây chính là điều đã xảy ra.

(06:10) Một ý tưởng khác mà tôi muốn đề cập, và tôi tin rằng đã thực sự vượt qua thử thách của thời gian, là ý tưởng về "kết nối học" (connectionism). Nếu bạn tin rằng một nơ-ron nhân tạo có phần nào giống nơ-ron sinh học, thì bạn sẽ tin tưởng rằng các mạng nơ-ron rất lớn có thể làm được gần như mọi thứ mà chúng ta, con người, làm được.

(06:53) Ồ, tôi quên đề cập một điều: vẫn còn một sự khác biệt, đó là bộ não con người biết cách tự tái cấu trúc, trong khi chúng ta chỉ đang sử dụng các thuật toán học tốt nhất mà chúng ta có, những thuật toán này đòi hỏi lượng dữ liệu tương đương với số lượng tham số. Con người vẫn vượt trội hơn ở khía cạnh này. Nhưng tôi cho rằng điều này đã dẫn tới – một cách tranh luận – "kỷ nguyên tiền huấn luyện". Và "kỷ nguyên tiền huấn luyện" chính là điều mà chúng ta có thể gọi là mô hình GPT-2, GPT-3 và các quy luật mở rộng. Tôi muốn đặc biệt nhắc đến các cộng sự cũ của mình: Alec Radford, Jared Kaplan, Dario Amodei, vì đã thực sự làm nên thành tựu này. Điều này đã dẫn đến "kỷ nguyên tiền huấn luyện" và chính nó là động lực thúc đẩy tất cả tiến bộ mà chúng ta đang thấy ngày nay – các mạng nơ-ron cực lớn được huấn luyện trên các tập dữ liệu khổng lồ. Nhưng việc tiền huấn luyện, như chúng ta biết, chắc chắn sẽ kết thúc.

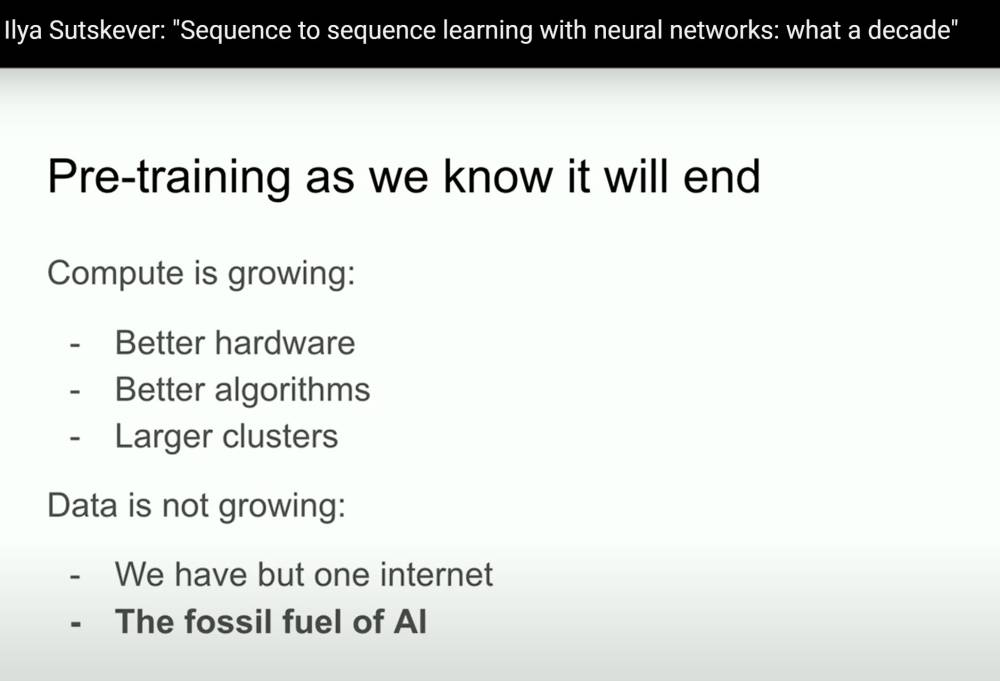

(08:18) Tiền huấn luyện sẽ kết thúc. Tại sao? Vì trong khi khả năng tính toán đang tăng nhờ phần cứng tốt hơn, các thuật toán tốt hơn và các cụm logic tốt hơn – tất cả những điều này tiếp tục gia tăng khả năng tính toán – thì dữ liệu lại không tăng. Vì chúng ta chỉ có một internet mà thôi. Bạn thậm chí có thể nói dữ liệu chính là nhiên liệu hóa thạch của AI. Dữ liệu được tạo ra theo cách nào đó, và giờ chúng ta đang sử dụng nó, và chúng ta đã đạt tới "đỉnh dữ liệu". Sẽ không còn thêm nữa, và chúng ta phải xử lý với lượng dữ liệu mà chúng ta hiện có. Lượng dữ liệu đó vẫn đưa chúng ta tiến khá xa, nhưng cũng chỉ có vậy.

(09:06) Ở đây, tôi sẽ mạn phép suy đoán một chút về điều gì sẽ đến tiếp theo. Thực ra, tôi không cần suy đoán, vì có nhiều người khác đang suy đoán. Tôi sẽ đề cập đến các suy đoán của họ. Bạn có thể đã nghe đến cụm từ "agents" (tác nhân). Đây là điều phổ biến, và tôi chắc chắn rằng cuối cùng điều gì đó sẽ xảy ra, nhưng mọi người cảm thấy rằng "agents" chính là tương lai. Cụ thể hơn, nhưng cũng mơ hồ một chút, là dữ liệu tổng hợp (synthetic data). Nhưng dữ liệu tổng hợp có nghĩa là gì? Giải quyết vấn đề này là một thách thức lớn, và tôi chắc rằng nhiều người sẽ đạt được những tiến bộ thú vị ở đây.

(09:43) Hoặc khả năng tính toán khi suy luận (inference-time compute), hoặc có lẽ là điều mà chúng ta gần đây đã thấy rõ hơn cả: mô hình O(1). Đây đều là những ví dụ về những nỗ lực tìm cách vượt qua thời kỳ tiền huấn luyện. Những điều này rất đáng làm. Tôi muốn nhắc đến một ví dụ khác từ sinh học mà tôi nghĩ là rất thú vị. Ví dụ là như thế này: nhiều năm trước, tại một hội nghị, tôi đã thấy một bài trình bày về một biểu đồ. Biểu đồ này cho thấy mối quan hệ giữa kích thước cơ thể của động vật có vú và kích thước não của chúng (ở đây đo bằng khối lượng).

(10:30) Tôi nhớ rõ bài nói đó. Họ nói rằng trong sinh học, mọi thứ thường rất lộn xộn, nhưng đây là một ví dụ hiếm hoi khi có một mối quan hệ rất chặt chẽ giữa kích thước cơ thể và kích thước não. Ngẫu nhiên, tôi trở nên tò mò về biểu đồ này. Tôi đã tìm kiếm trên Google để xem thêm, và một trong những hình ảnh tôi tìm thấy là như thế này. Điều thú vị trong hình ảnh này là bạn có thể thấy: có các động vật có vú, tất cả các loài động vật có vú khác nhau, rồi có các loài linh trưởng không phải con người – cơ bản là tương tự. Nhưng sau đó có các loài hominid. Theo hiểu biết của tôi, hominid là các họ hàng gần của con người trong quá trình tiến hóa, như người Neanderthal hay Homo habilis.

(11:03) Điều thú vị là chúng có một hệ số tỷ lệ khác biệt giữa kích thước não và kích thước cơ thể. Điều này thật sự thú vị, vì nó cho thấy có một tiền lệ – một ví dụ trong sinh học về cách tính toán một quy luật tỷ lệ khác biệt. Điều này rất đáng chú ý. Nhân tiện, tôi muốn làm nổi bật rằng trục x ở đây là logarit. Bạn thấy đó, đây là 100, đây là 1.000, 10.000, 100.000, và tương tự ở trục y: 1 g, 10 g, 100 g, 1.000 g. Vì vậy, điều này có nghĩa là những thứ mà chúng ta đang làm, những thứ mà chúng ta đã mở rộng, thực sự chỉ là điều đầu tiên mà chúng ta biết cách mở rộng.

(12:30) Không nghi ngờ gì nữa, toàn bộ lĩnh vực này – tất cả những người đang làm việc trong lĩnh vực này – sẽ tìm ra cách làm thế nào để tiếp tục. Nhưng tôi muốn dành vài phút để suy đoán về tầm nhìn dài hạn hơn. Trong dài hạn, chúng ta đang đi về đâu? Chúng ta đang đạt được những tiến bộ đáng kinh ngạc. Những tiến bộ này thực sự đáng kinh ngạc. Với những ai đã tham gia lĩnh vực này từ 10 năm trước, bạn sẽ nhớ rằng mọi thứ từng bất lực đến mức nào.

(13:10) Nếu bạn mới tham gia lĩnh vực này trong vòng 2 năm qua, có lẽ bạn thấy việc nói chuyện với máy tính, nhận được câu trả lời và thậm chí là sự phản biện là điều bình thường. Nhưng điều này không phải lúc nào cũng như vậy. Tôi muốn nói một chút về trí thông minh siêu việt, vì rõ ràng đó là nơi mà lĩnh vực này đang hướng đến. Đây là điều mà chúng ta đang xây dựng. Trí thông minh siêu việt sẽ khác biệt về chất so với những gì chúng ta có hiện nay.

(13:48) Mục tiêu của tôi trong phút tiếp theo là cố gắng đưa ra một trực giác cụ thể về cách nó sẽ khác biệt, để bạn có thể tự lý luận về nó. Hiện tại, chúng ta có các mô hình ngôn ngữ đáng kinh ngạc, các chatbot phi thường, và chúng thậm chí có thể thực hiện một số nhiệm vụ. Nhưng chúng cũng có một số điều kỳ lạ – đôi khi không đáng tin cậy và bị bối rối – trong khi lại có hiệu năng siêu việt so với con người trong các bài kiểm tra. Điều này gây khó khăn trong việc hòa giải những điểm mâu thuẫn đó.

(14:25) Nhưng sớm hay muộn, điều sau đây sẽ xảy ra: các hệ thống sẽ thực sự trở thành các tác nhân thực sự (agentic). Hiện tại, các hệ thống không phải là tác nhân theo bất kỳ ý nghĩa thực sự nào. Nhưng rồi chúng sẽ thực sự bắt đầu biết lý luận. Và tôi muốn nhấn mạnh một điều về lý luận: một hệ thống càng lý luận nhiều, nó càng trở nên khó dự đoán.

(14:53) Tất cả học sâu mà chúng ta đã quen thuộc đều rất dễ dự đoán... Vì nếu bạn đã làm việc để tái tạo trực giác của con người, thì cơ bản điều đó giống như một phản ứng bản năng. Nếu bạn quay lại ý tưởng về thời gian phản ứng 0,1 giây, loại xử lý nào diễn ra trong não chúng ta? Đó chính là trực giác. Vì vậy, chúng ta đã trang bị cho các hệ thống của mình một phần trực giác đó. Nhưng khả năng lý luận – bạn đang thấy những dấu hiệu ban đầu – là điều khó đoán trước. Một lý do để thấy điều này là vì các AI chơi cờ vua giỏi nhất thường không thể đoán trước ngay cả với những kỳ thủ cờ vua giỏi nhất. Do đó, chúng ta sẽ phải đối mặt với các hệ thống AI cực kỳ khó đoán.

(15:30) Chúng sẽ hiểu các vấn đề chỉ với lượng dữ liệu hạn chế, và chúng sẽ không bị bối rối. Tất cả những điều vốn là hạn chế lớn hiện nay sẽ dần được khắc phục. Tôi không nói về cách chúng sẽ làm điều đó, và cũng không nói khi nào điều này xảy ra, nhưng tôi tin rằng nó sẽ xảy ra. Và khi tất cả những điều này kết hợp cùng với nhận thức bản thân – vì sao không, khi nhận thức bản thân là hữu ích – chúng ta sẽ có các hệ thống có chất lượng và tính chất hoàn toàn khác biệt so với ngày nay. Tất nhiên, chúng sẽ sở hữu những khả năng vô cùng đáng kinh ngạc và đáng kinh ngạc.

(16:04) Nhưng những vấn đề nảy sinh từ các hệ thống như vậy sẽ khác biệt hoàn toàn so với những gì chúng ta đã quen. Tôi sẽ để lại điều này như một bài tập suy tưởng: nó rất khác so với những gì chúng ta từng biết. Và tôi sẽ nói rằng thực sự không thể dự đoán được tương lai. Tất cả mọi thứ đều có thể xảy ra. Nhưng trên một ghi chú tích cực, tôi sẽ kết thúc bài nói chuyện tại đây. Xin cảm ơn các bạn rất nhiều. [Vỗ tay]

(16:24) Cảm ơn bạn. Giờ là năm 2024, liệu có các cấu trúc sinh học khác liên quan đến nhận thức của con người mà bạn nghĩ đáng để khám phá theo cách tương tự, hoặc bạn có hứng thú với chúng không?

(17:10) Câu trả lời của tôi là: nếu bạn, hoặc ai đó, có một hiểu biết cụ thể kiểu như: "Chúng ta đang thực sự ngớ ngẩn, vì rõ ràng não bộ làm điều gì đó mà chúng ta không làm được, và điều đó có thể thực hiện được", thì họ nên theo đuổi điều đó. Cá nhân tôi không có ý tưởng cụ thể nào, nhưng điều đó phụ thuộc vào mức độ trừu tượng mà bạn nhìn nhận. Có lẽ tôi sẽ trả lời thế này: đã có rất nhiều mong muốn tạo ra AI lấy cảm hứng từ sinh học, và bạn có thể tranh luận rằng, ở một mức độ nào đó, AI lấy cảm hứng từ sinh học đã cực kỳ thành công, đặc biệt là trong học sâu. Nhưng mặt khác, cảm hứng từ sinh học lại rất khiêm tốn.

(17:46) Chúng ta nói rằng: "Hãy sử dụng các nơ-ron". Đó là toàn bộ phạm vi của cảm hứng sinh học: chỉ là sử dụng nơ-ron. Và các cảm hứng sinh học chi tiết hơn rất khó để triển khai. Nhưng tôi không loại trừ khả năng này. Tôi nghĩ rằng nếu ai đó có một hiểu biết đặc biệt, họ có thể nhìn thấy điều gì đó và điều đó sẽ hữu ích.

(18:26) Tôi có một câu hỏi về "tự sửa lỗi" (autocorrect). Đây là câu hỏi: bạn đã đề cập đến lý luận là một trong những khía cạnh cốt lõi của việc mô hình hóa trong tương lai, và có thể là một điểm khác biệt. Những gì chúng ta thấy trong một số phiên poster là các "ảo giác" (hallucinations) ở các mô hình hiện tại. Chúng ta đang phân tích xem liệu mô hình có gặp ảo giác không, bằng cách sử dụng phân tích thống kê – chẳng hạn như khoảng cách mấy độ lệch chuẩn so với trung bình. Trong tương lai, bạn có nghĩ rằng một mô hình, khi được trang bị khả năng lý luận, sẽ có thể tự sửa lỗi, kiểu như "tự chỉnh sửa lỗi" (autocorrect)?

(19:00) Liệu đây có trở thành một tính năng cốt lõi của các mô hình trong tương lai, để giảm thiểu ảo giác? Vì mô hình sẽ nhận ra khi nào xảy ra một ảo giác? Có thể câu hỏi này hơi mơ hồ, nhưng ý tôi là mô hình sẽ có khả năng lý luận và hiểu khi nào một ảo giác đang xảy ra. Câu hỏi có rõ ràng không?

(19:31) Câu trả lời là có. Tôi nghĩ rằng điều bạn mô tả rất khả thi. Thực tế, tôi sẽ không loại trừ rằng điều này có thể đã bắt đầu xảy ra với một số mô hình lý luận sơ khai hiện nay. Tôi không chắc, nhưng trong dài hạn, tại sao lại không? Ý tôi là, nó giống như Microsoft Word có tính năng "tự sửa lỗi". Nhưng tôi nghĩ gọi nó là "tự sửa lỗi" thì hơi hạ thấp giá trị của nó. Điều này vượt xa khái niệm "tự sửa lỗi" mà chúng ta biết. Nhưng ngoài điểm đó, câu trả lời vẫn là có.

(20:11) Cảm ơn bạn vì phần kết đầy bí ẩn, để ngỏ câu hỏi liệu AI có thay thế chúng ta không, hoặc liệu chúng có vượt trội hơn chúng ta không. Chúng có cần quyền lợi không? Có lẽ đây là một loại "loài người Homo sapiens mới" với trí tuệ nhân tạo. Có thể chúng cũng cần quyền lợi?

(20:52) Tôi nghĩ đó là những câu hỏi mà mọi người nên suy ngẫm nhiều hơn. Nhưng đối với câu hỏi của bạn về việc chúng ta nên tạo ra cấu trúc khuyến khích nào, tôi không cảm thấy đủ tự tin để trả lời. Vì bạn đang nói đến việc tạo ra một cấu trúc kiểu như chính phủ từ trên xuống, hoặc có thể là một hệ thống tiền mã hóa. Nhưng tôi không cảm thấy mình là người phù hợp để bình luận về tiền mã hóa. Tuy nhiên, vẫn có khả năng điều bạn mô tả sẽ xảy ra – rằng chúng ta sẽ có các AI chỉ muốn cùng tồn tại với chúng ta và có quyền lợi.

(22:22) Cảm ơn bạn vì bài nói chuyện tuyệt vời. Tôi là Shalev Liit từ Đại học Toronto. Câu hỏi của tôi là: bạn có nghĩ rằng các mô hình ngôn ngữ lớn (LLMs) có thể tổng quát hóa khả năng lý luận đa bước (multihop reasoning) ra khỏi phân phối dữ liệu không?

(23:05) Câu hỏi này giả định câu trả lời là "có" hoặc "không". Nhưng câu hỏi này không nên được trả lời bằng "có" hay "không", vì "tổng quát hóa ngoài phân phối" (out-of-distribution generalization) nghĩa là gì? "Trong phân phối" và "ngoài phân phối" nghĩa là gì? … Về mức độ nào đó, tôi nghĩ con người tổng quát hóa tốt hơn nhiều, nhưng các mô hình cũng có thể tổng quát hóa ngoài phân phối đến một mức độ nhất định.

(24:24) Đáng tiếc là chúng ta đã hết thời gian. Nhưng cảm ơn Ilia rất nhiều vì bài nói chuyện. [Vỗ tay].

Thảo luận

Follow Us

Tin phổ biến