IBM ra mắt PowerLM-3B và PowerMoE-3B: Mô hình ngôn ngữ 3 tỷ tham số

• IBM vừa công bố PowerLM-3B và PowerMoE-3B, hai mô hình ngôn ngữ mới với 3 tỷ tham số, nhằm cải thiện hiệu quả và khả năng mở rộng trong huấn luyện mô hình ngôn ngữ quy mô lớn.

• Các mô hình này được xây dựng dựa trên Power scheduler của IBM, giải quyết những thách thức chính trong việc huấn luyện mô hình quy mô lớn như tối ưu hóa siêu tham số và lập lịch tốc độ học.

• Power scheduler của IBM giới thiệu phương pháp linh hoạt điều chỉnh tốc độ học dựa trên số lượng token huấn luyện và kích thước batch, không cần xác định trước số bước huấn luyện.

• PowerLM-3B là mô hình transformer dày đặc với 3 tỷ tham số, được huấn luyện trên 1,25 nghìn tỷ token từ dữ liệu nguồn mở chất lượng cao và dữ liệu tổng hợp.

• PowerMoE-3B sử dụng kiến trúc mixture-of-experts (MoE) của IBM, chỉ kích hoạt 800 triệu tham số trong tổng số 3 tỷ tham số khi suy luận, giúp giảm đáng kể chi phí tính toán.

• PowerMoE-3B được huấn luyện trên 2,5 nghìn tỷ token, đạt hiệu suất tương đương các mô hình dày đặc có nhiều tham số hơn.

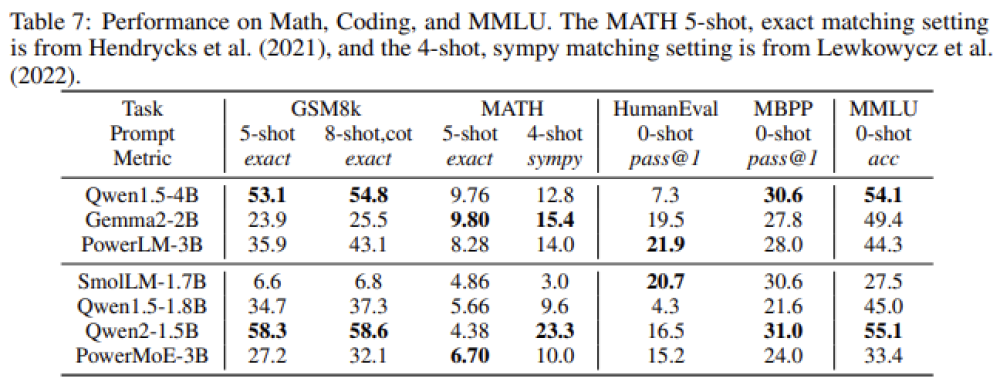

• Cả hai mô hình đều thể hiện hiệu suất cạnh tranh trên nhiều tác vụ xử lý ngôn ngữ tự nhiên như trả lời câu hỏi trắc nghiệm, suy luận thông thường và tạo mã.

• PowerLM-3B đạt điểm cao trong các bài kiểm tra như ARC và PIQA, vượt trội so với nhiều mô hình có số lượng tham số tương tự.

• PowerMoE-3B xuất sắc trong các tác vụ đòi hỏi hiệu quả tính toán, đạt kết quả cạnh tranh với chi phí suy luận thấp hơn nhiều.

• Kết quả cho thấy tiềm năng của Power scheduler và kiến trúc MoE của IBM trong việc cách mạng hóa cách huấn luyện và triển khai các mô hình ngôn ngữ lớn.

• Bằng cách tối ưu hóa tốc độ học và giảm yêu cầu tính toán, các mô hình này mở ra hướng đi mới cho các tổ chức muốn tận dụng mô hình ngôn ngữ tiên tiến mà không phải chịu chi phí khổng lồ.

📌 IBM ra mắt PowerLM-3B và PowerMoE-3B với 3 tỷ tham số, sử dụng Power scheduler để tối ưu huấn luyện. PowerLM-3B huấn luyện trên 1,25 nghìn tỷ token, PowerMoE-3B trên 2,5 nghìn tỷ token. Cả hai đạt hiệu suất cạnh tranh trong nhiều tác vụ NLP, mở ra hướng đi mới cho AI hiệu quả và tiết kiệm chi phí.

https://www.marktechpost.com/2024/09/11/powerlm-3b-and-powermoe-3b-released-by-ibm-revolutionizing-language-models-with-3-billion-parameters-and-advanced-power-scheduler-for-efficient-large-scale-ai-training/

Thảo luận

Follow Us

Tin phổ biến