Kết thúc cuộc đua tìm mô hình ngôn ngữ lớn mã nguồn mở tốt nhất

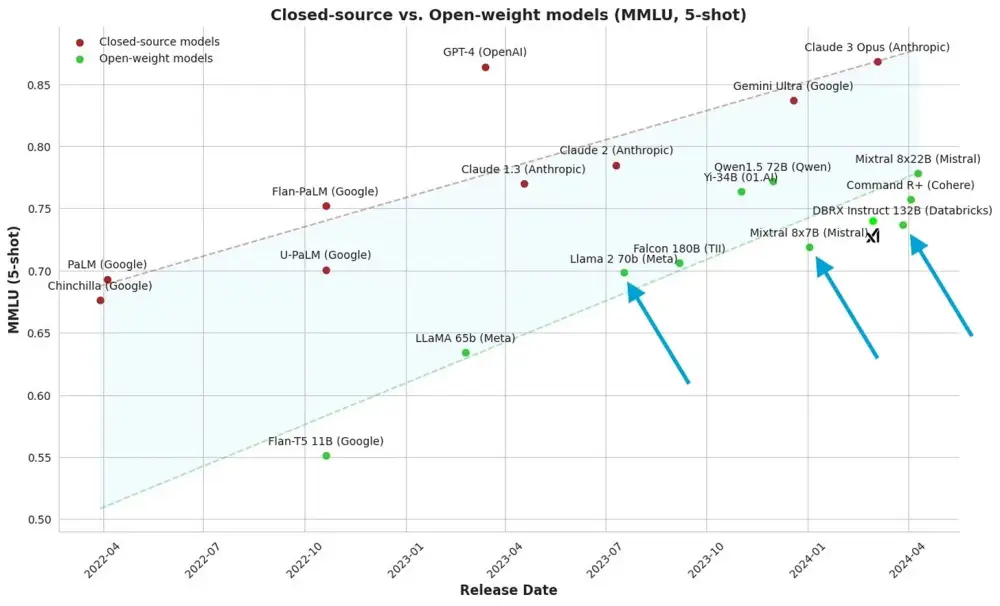

- Tác giả đã 3 lần công bố mô hình ngôn ngữ lớn mã nguồn mở tốt nhất: Llama 2, Mixtral và DBRX. Mỗi phiên bản là bước tiến đáng kể về hiệu suất trên mỗi tham số (với ngân sách tính toán cố định).

- Mô hình 70 tỷ tham số nắm bắt nhiều chi tiết hơn hẳn mô hình 7 tỷ tham số được huấn luyện tương tự. Biểu đồ từ Maxime Labonne cho thấy sự dịch chuyển từ Llama 2 sang Mixtral chủ yếu là về nén hiệu suất.

- Các mô hình Yi và Qwen không được áp dụng rộng rãi do thiên kiến trong tường thuật về mô hình mã nguồn mở. Chúng đáng lẽ có thể được gọi là mô hình ngôn ngữ lớn tiên tiến nhất.

- Khi chuẩn hóa theo tính toán, hầu hết lợi ích từ Llama 2 đến từ việc mở rộng quy mô tính toán. MMLU chỉ là một phép đo, nhưng nó cho thấy tính toán đơn giản có thể mang lại hiệu suất như thế nào.

- Sự khác biệt cốt lõi giữa các mô hình ngôn ngữ lớn mở và đóng là lượng dữ liệu huấn luyện. DBRX là mô hình mở duy nhất được xác nhận huấn luyện trên lượng lớn token, khoảng 2-3 nghìn tỷ, thay đổi lớn so với các nhà cung cấp mô hình công nghiệp.

📌 Cuộc đua tìm ra mô hình ngôn ngữ lớn mã nguồn mở tốt nhất đã kết thúc với Llama 2, Mixtral và DBRX. Tuy nhiên, xu hướng hiện nay là tập trung vào các mô hình hiệu quả tính toán. Sự khác biệt chính giữa mô hình mở và đóng nằm ở lượng dữ liệu huấn luyện, với DBRX là mô hình mở duy nhất sử dụng tới hàng nghìn tỷ token.

Citations:

[1] https://www.interconnects.ai/p/compute-efficient-open-llms

Thảo luận

Follow Us

Tin phổ biến