Lamini AI đạt 95% độ chính xác và giảm 90% ảo giác trong mô hình ngôn ngữ lớn

- Lamini AI đã giới thiệu Lamini Memory Tuning, một kỹ thuật đột phá trong các mô hình ngôn ngữ lớn (LLMs), nâng cao độ chính xác lên 95% và giảm ảo giác từ 50% xuống chỉ còn 5%.

- Kỹ thuật này sử dụng hàng triệu bộ điều chỉnh chuyên gia (như Low-Rank Adapters hoặc LoRAs) với các sự kiện chính xác trên bất kỳ LLM nguồn mở nào, như Llama 3 hoặc Mistral 3.

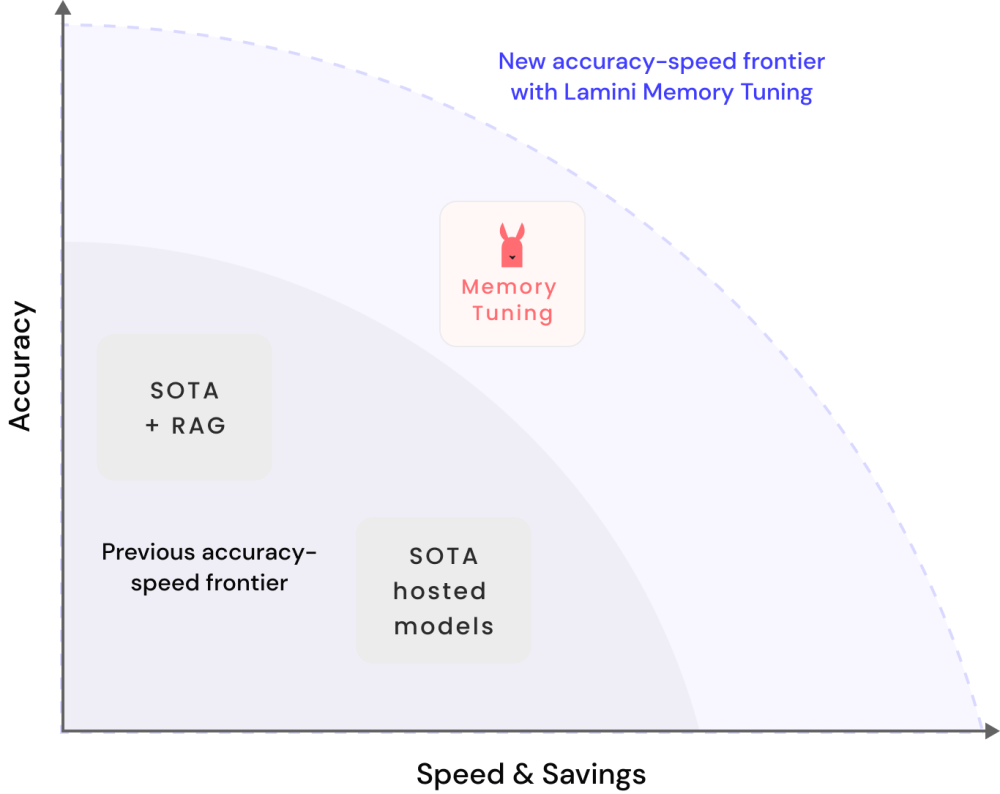

- Lamini Memory Tuning nhúng các sự kiện vào mô hình để truy xuất thông tin liên quan nhất trong quá trình suy luận, giảm đáng kể độ trễ và chi phí trong khi duy trì độ chính xác và tốc độ cao.

- Một công ty Fortune 500 đã sử dụng Lamini Memory Tuning để đạt được độ chính xác 95% trong các ứng dụng quan trọng, so với 50% của các phương pháp trước đó.

- Các phương pháp truyền thống như Prompting và Retrieval-Augmented Generation (RAG) cải thiện độ chính xác của LLM nhưng không loại bỏ hoàn toàn ảo giác.

- Lamini Memory Tuning kết hợp các kỹ thuật truy xuất thông tin với AI, dạy mô hình rằng câu trả lời gần đúng cũng sai như câu trả lời hoàn toàn sai.

- Kỹ thuật này tạo ra một hỗn hợp lớn các chuyên gia trí nhớ (MoMEs) tương tự như các chỉ số chuyên biệt trong hệ thống truy xuất thông tin, được chọn động trong quá trình suy luận.

- Kết quả là một mô hình kích hoạt thưa thớt có khả năng mở rộng đến nhiều tham số trong khi duy trì chi phí suy luận thấp, mở rộng ứng dụng thực tế của LLMs vào các lĩnh vực trước đây bị cản trở bởi ảo giác.

- Lamini Memory Tuning hứa hẹn độ chính xác cao hơn, chi phí thấp hơn và chu kỳ phát triển nhanh hơn, cho phép áp dụng và triển khai rộng rãi trong nhiều ngành công nghiệp.

📌 Lamini Memory Tuning của Lamini AI đạt 95% độ chính xác và giảm 90% ảo giác trong các mô hình ngôn ngữ lớn, mở ra tiềm năng cho các giải pháp AI tự động và chính xác cao trong nhiều ngành công nghiệp.

https://www.marktechpost.com/2024/06/17/lamini-ais-memory-tuning-achieves-95-accuracy-and-reduces-hallucinations-by-90-in-large-language-models/

Thảo luận

Follow Us

Tin phổ biến