Llama-3-8B-Instruct-80K-QLoRA: mô hình mới từ các nhà nghiên cứu Trung Quốc, mở rộng độ dài ngữ cảnh của Llama-3 từ 8K lên 80K token

- Các nhà nghiên cứu từ Học viện Trí tuệ Nhân tạo Bắc Kinh và Đại học Renmin Trung Quốc giới thiệu Llama-3-8B-Instruct-80K-QLoRA.

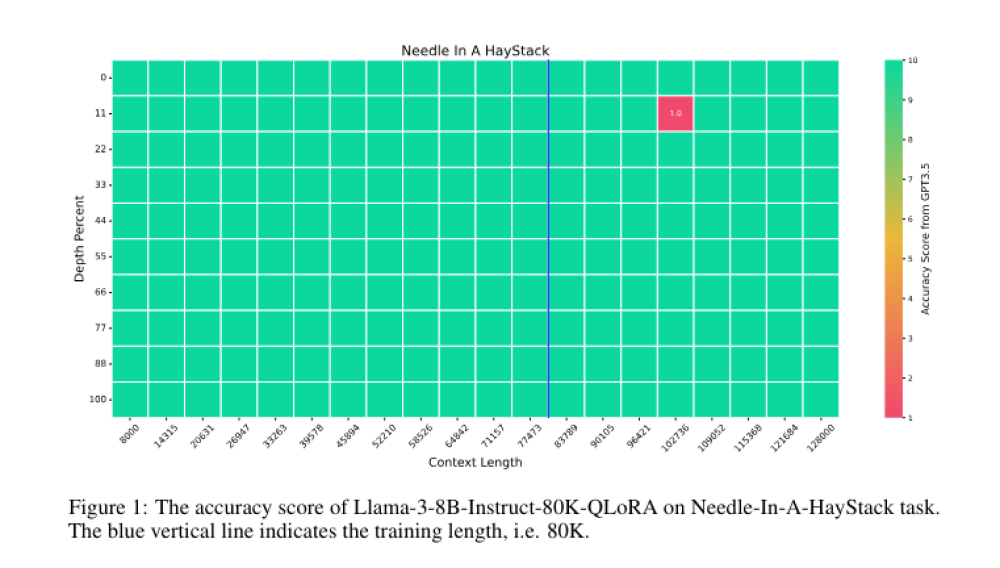

- Mô hình mở rộng đáng kể độ dài ngữ cảnh của Llama-3 gốc từ 8K lên 80K token.

- Phương pháp này nổi bật với khả năng duy trì hiểu biết ngữ cảnh qua các chuỗi văn bản dài đồng thời giảm yêu cầu tính toán.

- Sử dụng GPT-4 để tạo 3.5K mẫu huấn luyện cho các tác vụ Single-Detail QA, Multi-Detail QA và Biography Summarization.

- Fine-tune Llama-3-8B-Instruct-80K-QLoRA bằng QLoRA, áp dụng LoRA trên các lớp projection và huấn luyện lớp embedding.

- Kết hợp dữ liệu RedPajama, LongAlpaca và dữ liệu tổng hợp để tránh quên và tăng cường hiểu biết ngữ cảnh.

- Hiệu suất của mô hình trên các bài kiểm tra như LongBench và InfBench cho thấy khả năng xử lý chính xác các chuỗi văn bản dài.

- Nghiên cứu này thúc đẩy nghiên cứu NLP bằng cách cung cấp mô hình hiểu và xử lý ngữ cảnh dài một cách hiệu quả.

📌 Llama-3-8B-Instruct-80K-QLoRA là bước tiến quan trọng trong việc mở rộng khả năng hiểu ngữ cảnh của AI, xử lý hiệu quả văn bản dài 80 nghìn token, mở đường cho các ứng dụng NLP tiên tiến hơn.

Citations:

[1] https://www.marktechpost.com/2024/05/02/this-ai-paper-introduces-llama-3-8b-instruct-80k-qlora-new-horizons-in-ai-contextual-understanding/

Thảo luận

Follow Us

Tin phổ biến