LongVILA cải thiện hiệu suất và khả năng mở rộng cho các tác vụ video dài lên đến 2 triệu token

• LongVILA là một giải pháp toàn diện cho các mô hình ngôn ngữ thị giác (VLM) xử lý ngữ cảnh dài, được phát triển bởi các nhà nghiên cứu từ NVIDIA, MIT, UC Berkeley và UT Austin.

• Thách thức chính trong phát triển VLM nâng cao là cho phép các mô hình xử lý và hiểu hiệu quả các chuỗi video dài chứa thông tin ngữ cảnh mở rộng.

• LongVILA giới thiệu hệ thống Song song hóa chuỗi đa phương thức (MM-SP), cho phép mô hình xử lý chuỗi dài tới 2 triệu token bằng 256 GPU.

• MM-SP đạt tốc độ nhanh hơn 2,1x - 5,7x so với Song song hóa chuỗi kiểu vòng và cải thiện 1,1x - 1,4x so với Megatron-LM.

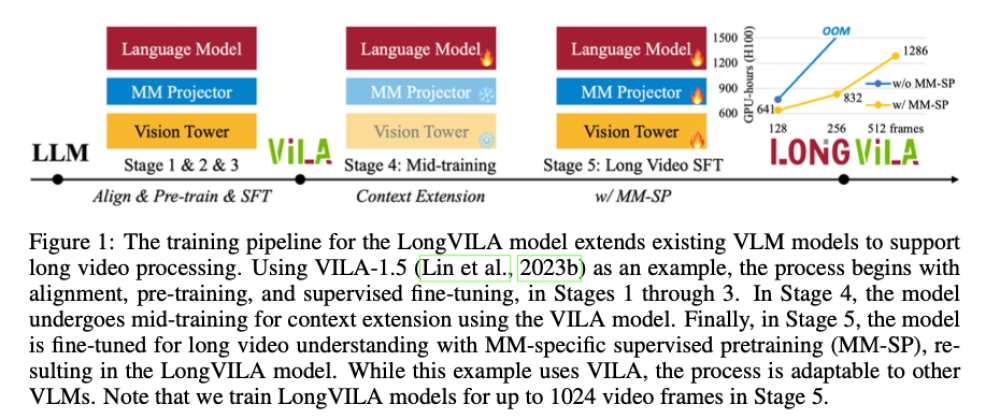

• Quy trình đào tạo 5 giai đoạn của LongVILA bao gồm: căn chỉnh đa phương thức, tiền huấn luyện quy mô lớn, tinh chỉnh giám sát ngắn, mở rộng ngữ cảnh và tinh chỉnh giám sát dài.

• Một bộ dữ liệu mới gồm 15.292 video, mỗi video dài khoảng 10 phút, được phát triển để hỗ trợ giai đoạn tinh chỉnh giám sát cuối cùng.

• LongVILA đạt độ chính xác 99,5% khi xử lý video có độ dài ngữ cảnh 274.000 token, vượt xa khả năng của các mô hình trước đó.

• LongVILA-8B vượt trội so với các mô hình tiên tiến hiện có trên các điểm chuẩn cho các tác vụ video có độ dài khác nhau.

• Phương pháp này cải thiện khả năng mở rộng và hiệu quả của các mô hình ngôn ngữ thị giác, đặt ra tiêu chuẩn mới cho hiệu suất trong các tác vụ video dài.

• LongVILA giải quyết thách thức quan trọng trong xử lý chuỗi video dài, đóng góp đáng kể vào sự tiến bộ của nghiên cứu AI.

📌 LongVILA là bước đột phá trong xử lý video dài, với khả năng xử lý 2 triệu token trên 256 GPU, đạt độ chính xác 99,5% cho video 274.000 token. Giải pháp này vượt trội so với các phương pháp hiện có, mở ra tiềm năng mới cho ứng dụng AI trong phân tích video chuyên sâu.

https://www.marktechpost.com/2024/08/23/processing-2-hour-videos-seamlessly-this-ai-paper-unveils-longvila-advancing-long-context-visual-language-models-for-long-videos/

Thảo luận

Follow Us

Tin phổ biến