Mistral AI ra mắt Small 3 - Đối thủ nguồn mở của GPT-4o mini chỉ cần 32GB RAM để vận hành

- Mistral AI vừa ra mắt mô hình Small 3 với 24B tham số vào ngày 30/1/2025, được tối ưu hóa về độ trễ và hiệu quả

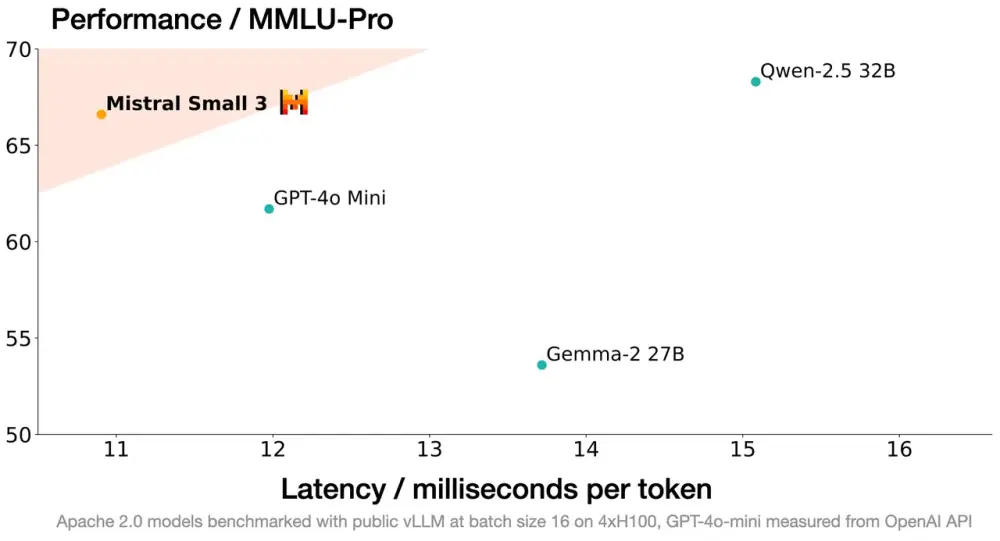

- Mô hình này có khả năng cạnh tranh với các mô hình lớn như Llama 3.3 70B và Qwen 32B

- Small 3 đạt độ chính xác trên 81% trong bài kiểm tra MMLU mà không cần huấn luyện tăng cường (RL) hay dữ liệu tổng hợp

- Ưu điểm nổi bật là có thể chạy cục bộ trên MacBook với RAM tối thiểu 32GB

- Mistral đã tiến hành kiểm tra với hơn 1.000 câu hỏi về lập trình và kiến thức chung thông qua đánh giá viên bên thứ ba

- Kết quả cho thấy đa số người dùng thích Small 3 hơn Gemma-2 27B và Qwen-2.5 32B

- Các ứng dụng tiềm năng:

+ Xây dựng trợ lý ảo phục vụ khách hàng

+ Phát hiện gian lận trong dịch vụ tài chính

+ Tư vấn pháp lý và chăm sóc sức khỏe

+ Lĩnh vực robot và sản xuất

+ Phù hợp với người đam mê và tổ chức xử lý thông tin nhạy cảm

- Mô hình được phát hành dưới giấy phép Apache 2.0 và có thể truy cập trên nền tảng HuggingFace

📌 Small 3 của Mistral AI là mô hình nguồn mở 24B tham số, chạy được trên MacBook 32GB RAM, đạt độ chính xác 81% trong MMLU, cạnh tranh trực tiếp với GPT-4o mini và các mô hình lớn khác trong lĩnh vực tư vấn, phát hiện gian lận và chăm sóc sức khỏe.

https://www.zdnet.com/article/mistral-ai-says-its-small-3-model-is-a-local-open-source-alternative-to-gpt-4o-mini/

Thảo luận

Follow Us

Tin phổ biến