Mistral ra mắt Codestral 25.01: Mô hình mã hóa vượt trội, bứt phá bảng xếp hạng

- Mistral đã phát hành phiên bản mới của mô hình hoàn thiện mã Codestral, nâng cao cạnh tranh trong lĩnh vực mã hóa.

- Phiên bản Codestral 25.01 được thiết kế với kiến trúc hiệu quả hơn, hứa hẹn sẽ là "người dẫn đầu rõ rệt cho lập trình trong phân khúc trọng lượng của nó".

- Mô hình mới nhanh gấp đôi so với phiên bản trước đó, giúp cải thiện tốc độ xử lý.

- Codestral 25.01 tối ưu hóa cho các tác vụ thấp độ trễ và tần suất cao, hỗ trợ sửa mã, tạo kiểm thử và các tác vụ điền giữa.

- Kết quả kiểm tra cho thấy mô hình mới này vượt trội hơn trong việc mã hóa Python với điểm số 86.6% trong bài kiểm tra HumanEval.

- Codestral 25.01 đã đánh bại các mô hình trước đó như Codellama 70B Instruct và DeepSeek Coder 33B instruct.

- Người dùng có thể triển khai Codestral 25.01 qua các đối tác plugin IDE của Mistral và truy cập API của mô hình qua la Plateforme của Mistral và Google Vertex AI.

- Mô hình sẽ có mặt trên Azure AI Foundry và sắp ra mắt trên Amazon Bedrock.

- Mistral đã phát hành Codestral lần đầu vào tháng 5 năm ngoái, với khả năng mã hóa trong 80 ngôn ngữ khác nhau.

- Sau đó, Mistral đã giới thiệu Codestral-Mamba, một mô hình tạo mã có thể xử lý chuỗi mã dài hơn.

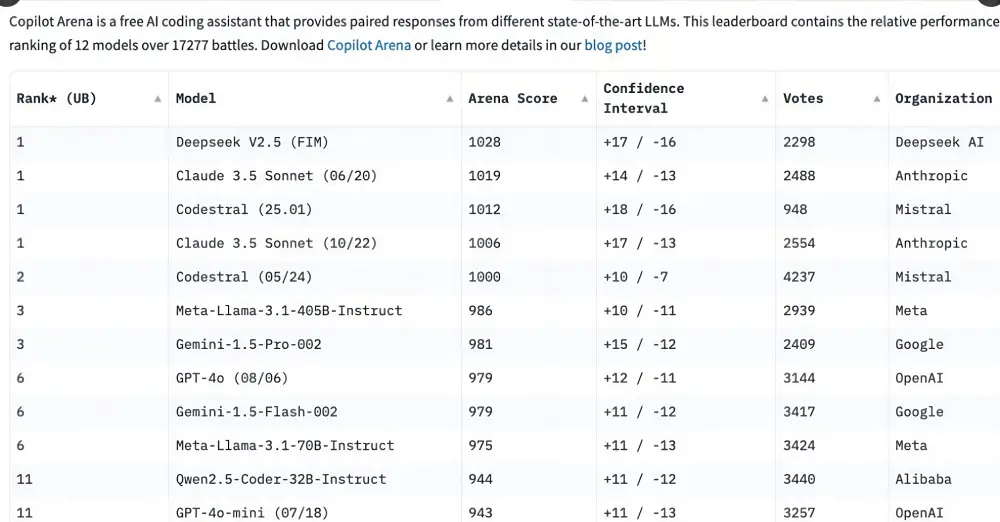

- Ngay sau thông báo về Codestral 25.01, mô hình này đã nhanh chóng nổi bật trên Copilot Arena.

- Các mô hình mã hóa đã cải thiện đáng kể và thường xuyên vượt trội so với các mô hình tổng quát khác như GPT-4 Turbo.

- Nhiều nhà phát triển vẫn chưa thống nhất được việc chọn mô hình tổng quát hay mô hình chuyên sâu trong việc lập trình.

📌 Mistral đã thành công trong việc nâng cấp mô hình Codestral với phiên bản 25.01, đạt hiệu suất 86.6% trong HumanEval. Mô hình này hỗ trợ lập trình viên với tốc độ nhanh gấp đôi phiên bản trước, đáp ứng nhu cầu ngày càng cao trong lĩnh vực tạo mã.

https://venturebeat.com/ai/mistrals-new-codestral-code-completion-model-races-up-third-party-charts/

Thảo luận

Follow Us

Tin phổ biến