MIT: 70% dữ liệu video AI đến từ một nguồn duy nhất, 90% dữ liệu AI đến từ phương Tây

• Nhóm Data Provenance Initiative, bao gồm hơn 50 nhà nghiên cứu từ học viện và công nghiệp, đã kiểm tra gần 4.000 bộ dữ liệu công khai trải dài trên 600 ngôn ngữ, 67 quốc gia trong 3 thập kỷ.

• Đầu những năm 2010, dữ liệu AI đến từ nhiều nguồn đa dạng như bách khoa toàn thư, web, biên bản nghị viện, báo cáo thời tiết. Các bộ dữ liệu được tuyển chọn cẩn thận cho từng nhiệm vụ cụ thể.

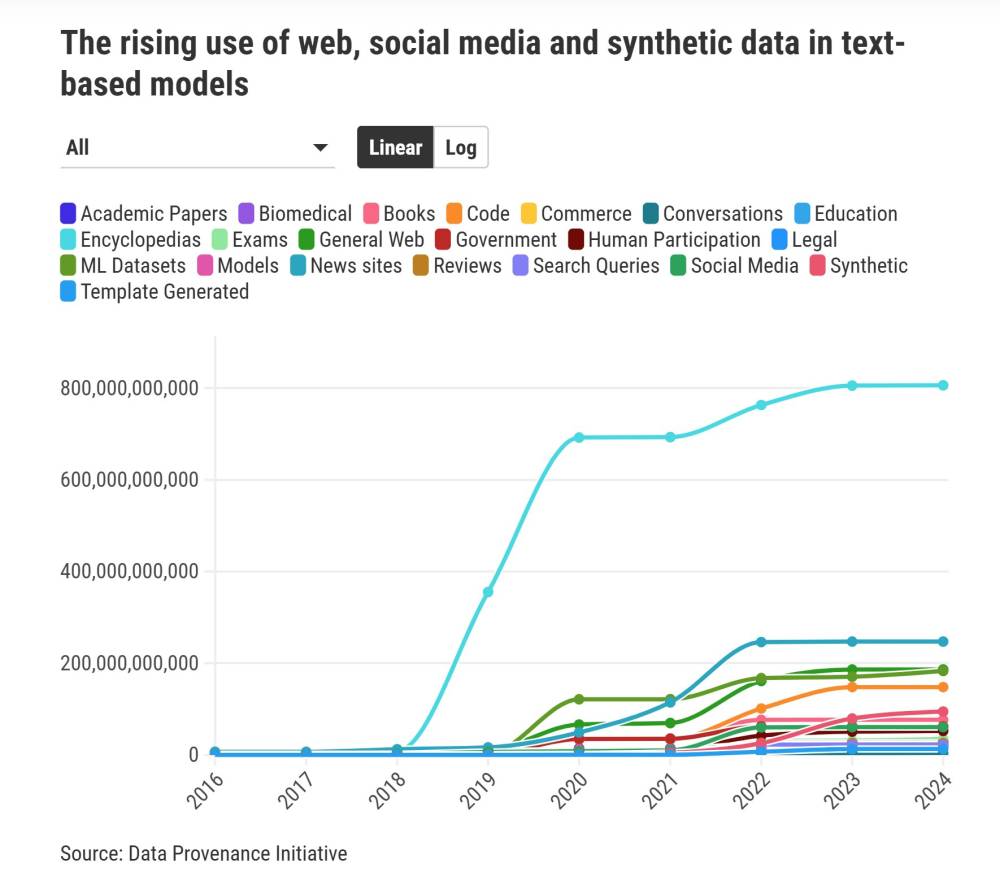

• Sau năm 2017, khi kiến trúc transformer ra đời, ngành AI bắt đầu thu thập dữ liệu ồ ạt từ internet. Từ 2018, web trở thành nguồn chính cho dữ liệu âm thanh, hình ảnh và video.

• YouTube hiện chiếm hơn 70% dữ liệu cho các mô hình video và giọng nói, tạo lợi thế lớn cho Alphabet (công ty mẹ của Google).

• Hơn 90% bộ dữ liệu được phân tích đến từ châu Âu và Bắc Mỹ, chưa đến 4% đến từ châu Phi.

• Các công ty lớn như OpenAI và Google đã ký các thỏa thuận độc quyền chia sẻ dữ liệu với các nhà xuất bản, diễn đàn lớn như Reddit và các nền tảng mạng xã hội.

• Nhiều bộ dữ liệu có giấy phép hạn chế hoặc điều khoản đính kèm, hạn chế việc sử dụng cho mục đích thương mại.

• Sự thống trị của tiếng Anh trong dữ liệu huấn luyện một phần do internet vẫn sử dụng hơn 90% tiếng Anh.

• Các mô hình AI đa phương thức có thể chỉ thể hiện được góc nhìn phương Tây, như trong trường hợp mô tả đám cưới, do thiếu dữ liệu từ các nền văn hóa khác.

📌 Quyền lực dữ liệu AI đang tập trung vào một số ít công ty công nghệ lớn với YouTube chiếm 70% dữ liệu video/âm thanh. 90% dữ liệu đến từ phương Tây, tạo nguy cơ áp đặt góc nhìn phương Tây lên công nghệ AI toàn cầu.

https://www.technologyreview.com/2024/12/18/1108796/this-is-where-the-data-to-build-ai-comes-from/

#MIT

Nguồn dữ liệu để xây dựng AI đến từ đâu

Các phát hiện mới cho thấy nguồn dữ liệu đang tập trung quyền lực vào tay các công ty công nghệ mạnh nhất.

Bởi Melissa Heikkilä & Stephanie Arnett

Ngày 18 tháng 12 năm 2024

AI phụ thuộc hoàn toàn vào dữ liệu. Khối lượng dữ liệu khổng lồ cần thiết để huấn luyện các thuật toán quyết định những gì AI có thể làm. Nhưng vấn đề nằm ở chỗ: các nhà phát triển và nhà nghiên cứu AI không thực sự biết rõ về nguồn gốc của dữ liệu mà họ đang sử dụng. Việc thu thập dữ liệu cho AI hiện tại vẫn còn khá sơ sài so với sự tinh vi của việc phát triển mô hình AI. Các tập dữ liệu lớn thường thiếu thông tin rõ ràng về nội dung của chúng và nguồn gốc từ đâu.

Sáng kiến Nguồn gốc Dữ liệu (Data Provenance Initiative), một nhóm hơn 50 nhà nghiên cứu từ cả giới học thuật và ngành công nghiệp, đã cố gắng giải quyết vấn đề này. Họ đặt ra câu hỏi đơn giản: Dữ liệu để xây dựng AI đến từ đâu?

Nhóm đã kiểm tra gần 4.000 tập dữ liệu công khai trải dài hơn 600 ngôn ngữ, 67 quốc gia và ba thập kỷ. Các dữ liệu này đến từ 800 nguồn khác nhau và gần 700 tổ chức.

Các phát hiện chính: Tập trung quyền lực vào các công ty lớn

Những phát hiện được chia sẻ độc quyền với MIT Technology Review cho thấy một xu hướng đáng lo ngại: việc thu thập dữ liệu AI đang tập trung quyền lực một cách áp đảo vào tay một số ít công ty công nghệ lớn.

Vào đầu những năm 2010, các tập dữ liệu đến từ nhiều nguồn đa dạng, như bách khoa toàn thư, biên bản nghị viện, báo cáo thời tiết, và các cuộc gọi hội nghị. Lúc đó, dữ liệu được chọn lọc và thu thập để phù hợp với từng nhiệm vụ cụ thể.

Tuy nhiên, sau khi các kiến trúc transformers — nền tảng của các mô hình ngôn ngữ lớn — ra đời vào năm 2017, hiệu suất AI càng cao khi mô hình và tập dữ liệu càng lớn. Từ năm 2018, web đã trở thành nguồn dữ liệu chi phối, dẫn đến sự chênh lệch ngày càng lớn giữa dữ liệu thu thập tự động và dữ liệu được chọn lọc kỹ càng.

"Trong việc phát triển mô hình nền tảng, quy mô và tính đa dạng của dữ liệu từ web là yếu tố quan trọng nhất," Shayne Longpre, một nhà nghiên cứu tại MIT, nhận định.

Sự tập trung dữ liệu trên YouTube

Với các mô hình AI tạo sinh đa phương thức, chẳng hạn như video và hình ảnh, YouTube đã trở thành nguồn dữ liệu lớn nhất. Đối với các mô hình video, hơn 70% dữ liệu âm thanh và hình ảnh đều đến từ một nguồn duy nhất: YouTube.

Việc này mang lại lợi thế to lớn cho Google, công ty mẹ của YouTube. Trong khi dữ liệu văn bản được phân tán trên nhiều nền tảng, dữ liệu video lại tập trung cực kỳ cao vào một nền tảng duy nhất. Điều này đặt ra câu hỏi về việc Google sẽ làm thế nào để chia sẻ dữ liệu này với các đối thủ cạnh tranh.

"Chúng ta không nên coi dữ liệu là một tài nguyên tự nhiên, mà là thứ được tạo ra qua các quy trình cụ thể," Sarah Myers West, giám đốc điều hành tại AI Now Institute, cho biết.

Tính đại diện và sự thiếu công bằng

Sự tập trung dữ liệu vào một số ít nền tảng cũng đặt ra câu hỏi liệu những mô hình AI này có phản ánh đầy đủ kinh nghiệm và sự đa dạng của con người hay không.

Ví dụ, các video trên YouTube thường được tải lên để nhắm đến một khán giả cụ thể, với cách hành xử trong video mang tính chất biểu diễn. Sara Hooker, phó chủ tịch nghiên cứu tại Cohere, nhận định: "Dữ liệu này có nắm bắt được tất cả các sắc thái của con người và cách chúng ta tồn tại không?"

Ngoài ra, hơn 90% dữ liệu mà nhóm nghiên cứu phân tích đến từ Châu Âu và Bắc Mỹ, trong khi chưa đến 4% đến từ Châu Phi. Điều này dẫn đến việc các mô hình AI chỉ phản ánh một phần thế giới, bỏ qua các ngôn ngữ và văn hóa khác.

Hooker cũng lưu ý rằng khi các mô hình AI được yêu cầu tạo ra hình ảnh hoặc âm thanh về một sự kiện như đám cưới, chúng thường chỉ thể hiện được các đám cưới phương Tây. Điều này củng cố định kiến và áp đặt một thế giới quan tập trung vào Mỹ, đồng thời loại trừ các ngôn ngữ và văn hóa khác.

Rủi ro từ sự không rõ ràng

Các công ty AI thường không công khai dữ liệu mà họ đã sử dụng để huấn luyện mô hình. Một phần là để bảo vệ lợi thế cạnh tranh, nhưng cũng vì bản chất phức tạp và không minh bạch của cách dữ liệu được đóng gói và phân phối.

"Sự thiếu nhất quán trong nguồn gốc dữ liệu khiến các nhà phát triển khó đưa ra quyết định đúng về dữ liệu cần sử dụng," Hooker nói. Điều này cũng khiến gần như không thể chắc chắn rằng các mô hình đã không sử dụng dữ liệu có bản quyền.

Gần đây, các công ty lớn như OpenAI và Google đã ký hợp đồng độc quyền với các nhà xuất bản, diễn đàn lớn như Reddit và các nền tảng mạng xã hội. Điều này tạo ra một hệ sinh thái dữ liệu không bình đẳng, khi các công ty nhỏ hơn, phi lợi nhuận hoặc các nhà nghiên cứu khó có thể tiếp cận nguồn dữ liệu này.

Kết luận

Các phát hiện này nêu bật những thách thức quan trọng trong việc xây dựng AI công bằng và toàn diện, đồng thời cảnh báo rằng việc tập trung quyền lực dữ liệu vào tay một số ít công ty có thể tái định hình cơ sở hạ tầng của thế giới theo hướng phục vụ lợi ích của họ. "Chúng ta đang sử dụng những mô hình này trên toàn cầu, nhưng thế giới thực sự không được phản ánh đầy đủ trong các mô hình," Hooker kết luận.

Thảo luận

Follow Us

Tin phổ biến