Mô hình AI DenseAV đang tự học nói chuyện bằng cách xem video

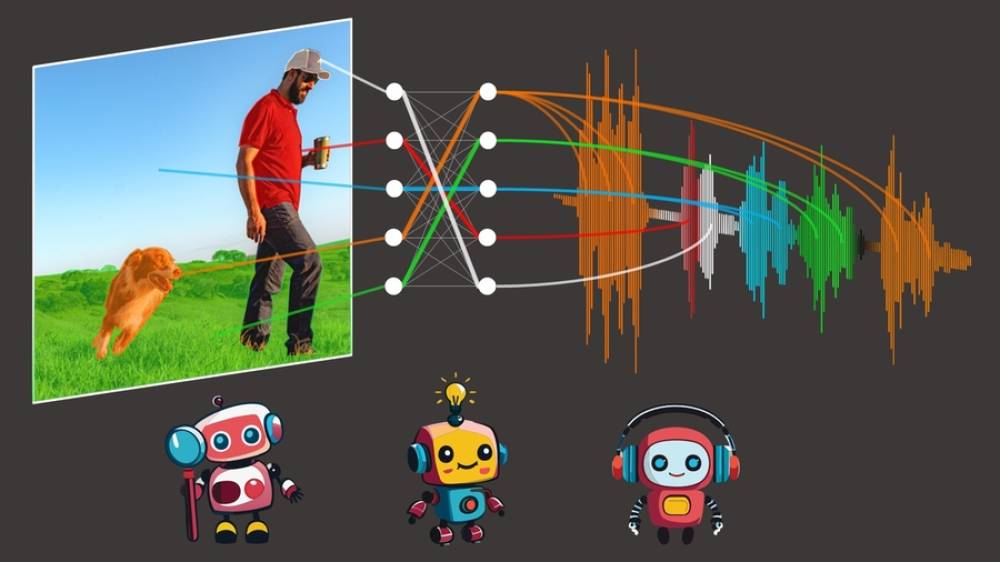

- DenseAV là một mô hình AI có thể học ý nghĩa của từ và vị trí âm thanh mà không cần dữ liệu có nhãn, chỉ bằng cách xem video.

- Nó sử dụng học tương phản audio-video để liên kết âm thanh cụ thể với thế giới quan sát được.

- DenseAV so sánh cặp tín hiệu âm thanh và hình ảnh, xác định dữ liệu quan trọng và đánh giá tín hiệu nào khớp.

- Ý tưởng này đến với Mark Hamilton, một nghiên cứu sinh tiến sĩ tại MIT, khi xem cảnh chim cánh cụt ngã trong phim "March of the Penguins".

- Mục tiêu là để mô hình học ngôn ngữ bằng cách dự đoán những gì nó thấy từ những gì nó nghe và ngược lại.

- Các nhà nghiên cứu tập trung vào các điểm ảnh mà mô hình nhìn vào khi nghe thấy âm thanh cụ thể để khám phá ý nghĩa của từ.

- DenseAV được trang bị "bộ não hai bên", một bên tập trung vào ngôn ngữ và bên kia tập trung vào âm thanh như tiếng mèo kêu.

- Lượng lớn nội dung video sẵn có có nghĩa là AI có thể được đào tạo trên các video hướng dẫn.

- Ứng dụng thú vị khác là hiểu ngôn ngữ mới, như giao tiếp của cá heo hoặc cá voi.

- Bước tiếp theo là tạo ra các hệ thống có thể học từ dữ liệu chỉ video hoặc chỉ âm thanh.

📌 DenseAV đại diện cho một bước tiến quan trọng trong AI, cho thấy khả năng học ngôn ngữ và âm thanh chỉ từ video mà không cần sự can thiệp của con người. Điều này mở ra nhiều ứng dụng tiềm năng như đào tạo AI trên video hướng dẫn và thậm chí hiểu các dạng giao tiếp mới của động vật.

https://www.tomsguide.com/ai/this-ai-model-is-learning-to-speak-by-watching-videos-heres-how

Thảo luận

Follow Us

Tin phổ biến