Mô hình ngôn ngữ nhỏ: Giải pháp hiệu quả cho xử lý thời gian thực và tác vụ chuyên biệt

- AI đã phát triển mạnh mẽ với các mô hình ngôn ngữ lớn (LLMs) như LaPM 540B và Llama-3.1 405B, nhưng yêu cầu tính toán cao của chúng gây khó khăn trong ứng dụng thực tế.

- Các LLMs thường dựa vào điện toán đám mây, cần bộ nhớ GPU lớn, gây lo ngại về quyền riêng tư và không thể triển khai ngay trên thiết bị.

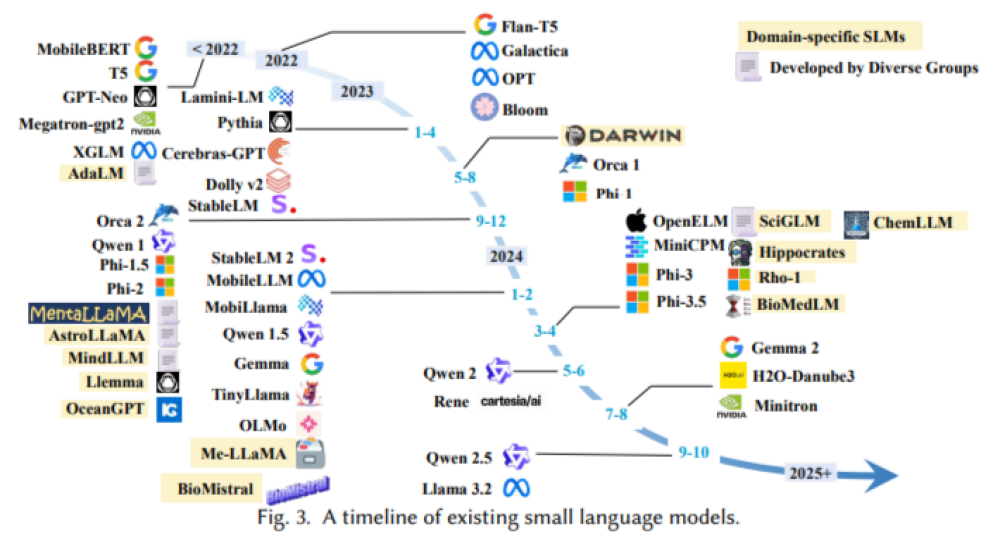

- Mô hình ngôn ngữ nhỏ (SLMs) được nghiên cứu như một lựa chọn hiệu quả, có khả năng thực hiện các tác vụ chuyên biệt với yêu cầu tính toán thấp hơn.

- Vấn đề chính với LLMs là chi phí tính toán cao và độ trễ lớn, đặc biệt trong các ứng dụng chuyên biệt.

- Ví dụ, mô hình Llama-3.1 với 405 tỷ tham số yêu cầu hơn 200 GB bộ nhớ GPU, không phù hợp cho thiết bị di động hoặc hệ thống biên.

- Thời gian xử lý 100 token trên bộ xử lý Snapdragon 685 với mô hình Llama-2 7B có thể mất tới 80 giây, gây cản trở cho các ứng dụng thời gian thực.

- Chi phí hoạt động cao của LLMs hạn chế khả năng sử dụng, vì việc tinh chỉnh cho các lĩnh vực chuyên biệt cần nguồn lực lớn.

- Các phương pháp hiện tại như API đám mây, nhóm dữ liệu và cắt tỉa mô hình không hoàn toàn giải quyết vấn đề độ trễ và quyền riêng tư.

- Nghiên cứu từ Đại học Pennsylvania, UTHealth Houston, Amazon và Rensselaer Polytechnic Institute đã khảo sát về SLMs, phát triển một khung hệ thống để cân bằng hiệu quả với khả năng tương tự LLMs.

- Các kiến trúc nhỏ gọn và kỹ thuật xử lý dữ liệu tiên tiến giúp SLMs hoạt động trong môi trường tiết kiệm năng lượng.

- Các cải tiến như attention theo nhóm (GQA), attention đa đầu (MLA), và Flash Attention cải thiện hiệu suất mà không cần bộ nhớ lớn.

- Kỹ thuật chia sẻ tham số và thích ứng thấp hạng đảm bảo SLMs có thể xử lý các tác vụ phức tạp trong các lĩnh vực như y tế, tài chính.

- Kết quả thực nghiệm cho thấy SLMs có thể đạt được hiệu suất gần tương đương LLMs với độ trễ và mức sử dụng bộ nhớ thấp hơn.

- Trong các bài kiểm tra, SLMs cho thấy giảm độ trễ và cải thiện quyền riêng tư dữ liệu nhờ xử lý cục bộ.

- SLMs có thể duy trì tới 90% độ chính xác của LLMs trong các ứng dụng chuyên biệt với yêu cầu phần cứng thấp hơn.

📌 Nghiên cứu về mô hình ngôn ngữ nhỏ cung cấp một khung khả thi, giải quyết các vấn đề trong việc triển khai LLMs tại những môi trường hạn chế. SLMs hứa hẹn mở rộng khả năng xử lý ngôn ngữ tiên tiến vào thiết bị tiêu tốn ít năng lượng, đảm bảo tính khả thi và bền vững trong các ứng dụng thực tế.

https://www.marktechpost.com/2024/11/09/a-deep-dive-into-small-language-models-efficient-alternatives-to-large-language-models-for-real-time-processing-and-specialized-tasks/

Thảo luận

Follow Us

Tin phổ biến