NIST xác định các loại tấn công mạng thao túng hành vi của hệ thống AI

- Các nhà khoa học máy tính từ Viện Tiêu chuẩn và Công nghệ Quốc gia (NIST) và cộng sự phát hiện ra các điểm yếu của AI và học máy (ML) trong ấn phẩm mới.

- Công trình, có tên "Adversarial Machine Learning: A Taxonomy and Terminology of Attacks and Mitigations" (NIST.AI.100-2), là một phần của nỗ lực hỗ trợ phát triển AI đáng tin cậy của NIST và hỗ trợ thực hiện Khung quản lý rủi ro AI của NIST.

- Ấn phẩm này, là sự hợp tác giữa chính phủ, học thuật và ngành công nghiệp, nhằm giúp các nhà phát triển và người dùng AI nắm bắt các loại tấn công mà họ có thể gặp phải cùng với các phương pháp giảm thiểu.

- AI và ML đã thâm nhập vào xã hội hiện đại, từ lái xe tự động đến hỗ trợ bác sĩ chẩn đoán bệnh đến tương tác với khách hàng dưới dạng chatbot trực tuyến.

- Một vấn đề lớn là dữ liệu mà AI được huấn luyện có thể không đáng tin cậy, có nguồn gốc từ các trang web và tương tác với công chúng, và có thể bị đối tác xấu làm hỏng.

- Do bộ dữ liệu dùng để huấn luyện AI quá lớn, không có cách chắc chắn để bảo vệ AI khỏi sự hiểu lầm.

- Báo cáo mới cung cấp cái nhìn tổng quan về các loại tấn công mà sản phẩm AI có thể gặp phải và các phương pháp giảm thiểu thiệt hại tương ứng.

- Báo cáo xem xét bốn loại tấn công chính: né tránh, đầu độc, riêng tư và tấn công lạm dụng. Các loại tấn công này được phân loại theo nhiều tiêu chí như mục tiêu và mục đích, khả năng, và kiến thức của kẻ tấn công.

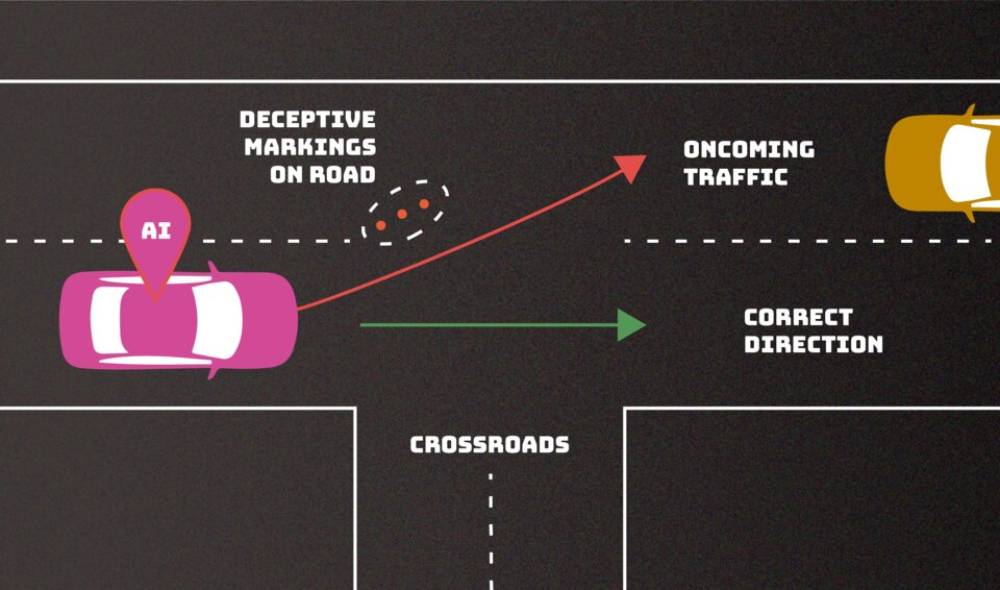

- Tấn công né tránh xảy ra sau khi hệ thống AI được triển khai, tấn công đầu độc xảy ra trong giai đoạn huấn luyện, tấn công riêng tư xảy ra trong quá trình triển khai, và tấn công lạm dụng liên quan đến việc chèn thông tin sai vào nguồn mà AI hấp thụ.

- Các tác giả nhận ra rằng các phòng thủ mà các chuyên gia AI đã nghĩ ra cho các cuộc tấn công đối kháng cho đến nay là không hoàn chỉnh.

📌 Công trình nghiên cứu mới của NIST về "Adversarial Machine Learning" không chỉ là một bước tiến quan trọng trong việc nhận diện và phân loại các loại tấn công đối với hệ thống AI và ML, mà còn cung cấp cái nhìn sâu sắc về cách thức giảm thiểu những rủi ro này. Dù không có phòng thủ không thể xâm phạm, nhưng báo cáo này giúp cộng đồng phát triển AI hiểu rõ hơn về các mối đe dọa và giải pháp hiện có, đồng thời khuyến khích sự đổi mới trong cách tiếp cận bảo vệ AI. Với AI và ML ngày càng thâm nhập vào mọi lĩnh vực của xã hội, từ lái xe tự động đến trợ lý ảo, việc hiểu và bảo vệ chống lại các cuộc tấn công là cực kỳ quan trọng. Báo cáo của NIST không chỉ là nguồn thông tin quý giá cho các nhà phát triển mà còn là cơ sở cho các tổ chức khi triển khai công nghệ AI an toàn và đáng tin cậy hơn trong tương lai.

https://nvlpubs.nist.gov/nistpubs/ai/NIST.AI.100-2e2023.pdf

Thảo luận

Follow Us

Tin phổ biến