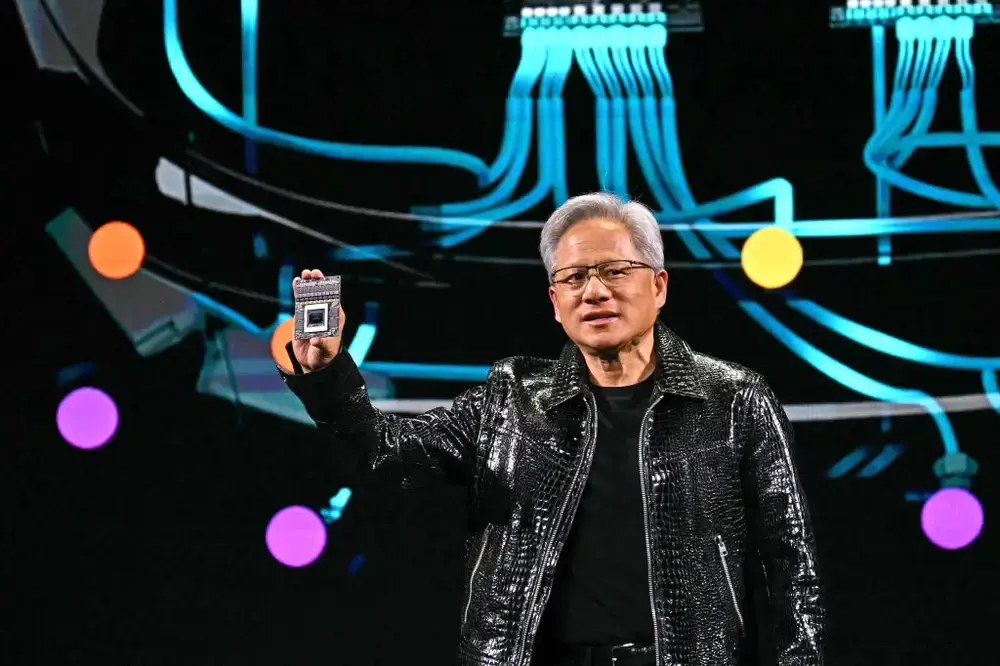

Nvidia CEO Jensen Huang: Các mô hình lý luận như DeepSeek R1 cần nhiều tài nguyên tính toán hơn gấp 100 lần

-

Jensen Huang, giám đốc điều hành Nvidia, tuyên bố các mô hình lý luận AI cần nhiều tài nguyên tính toán gấp 100 lần so với các mô hình truyền thống.

-

Mặc dù Nvidia vượt qua kỳ vọng về doanh thu, các nhà đầu tư vẫn phản ứng dè dặt sau khi DeepSeek ra mắt các mô hình nguồn mở hiệu quả cao vào tháng trước.

-

Huang gọi DeepSeek là "một đổi mới xuất sắc" và nhấn mạnh rằng hầu hết mọi nhà phát triển AI đang áp dụng R1 hoặc các kỹ thuật tương tự để nâng cao hiệu suất mô hình.

-

Trong một cuộc phỏng vấn tuần trước, Huang cho rằng các nhà đầu tư đã hiểu sai hiện tượng DeepSeek và tác động của nó đối với Nvidia.

-

Các nhà cung cấp dịch vụ đám mây đã xác nhận với Business Insider rằng nhu cầu về chip mạnh mẽ nhất của Nvidia sẽ tiếp tục tăng.

-

Theo nhà phân tích Dan Morgan của Synovus, tác động lâu dài của DeepSeek là thúc đẩy xu hướng hướng tới "các mô hình lý luận tiêu tốn nhiều tài nguyên".

-

Jensen Huang tiết lộ rằng "phần lớn" nhu cầu tính toán của Nvidia hiện nay đến từ suy luận (inference) - loại hình tính toán AI tinh chỉnh mô hình và tạo ra phản hồi lý luận.

-

Dòng chip Blackwell mới nhất của Nvidia được thiết kế để nâng cao khả năng suy luận lên một tầm cao mới.

-

Cạnh tranh trong lĩnh vực chip AI đang gia tăng. Các công ty khởi nghiệp như Tenstorrent đã huy động được gần 700 triệu USD và Etched đã nhận được 120 triệu USD vốn đầu tư mới vào năm ngoái.

-

Các nhà phân tích bắt đầu lo ngại về vị thế thống trị của Nvidia trước sự cạnh tranh từ các chip AI tùy chỉnh của các công ty đám mây như Google và Amazon.

-

Lucas Keh, nhà phân tích của Third Bridge, cho biết: "Chúng tôi nghe nói rằng thị phần của họ trong lĩnh vực suy luận có thể giảm xuống 50% khi thị trường phát triển."

📌 Nvidia vẫn dẫn đầu thị trường chip AI nhưng đối mặt với áp lực cạnh tranh gia tăng, đặc biệt trong lĩnh vực suy luận (inference). Các mô hình lý luận mới như DeepSeek R1 đòi hỏi tài nguyên tính toán lớn hơn 100 lần, nhưng các đối thủ đang nhắm vào thị trường tiềm năng này với các giải pháp hiệu quả hơn.

https://www.businessinsider.com/nvidia-ceo-jensen-huang-says-reasoning-models-require-more-compute-2025-2

Thảo luận

Follow Us

Tin phổ biến