Nvidia tăng gấp 3, Intel gấp đôi hiệu năng suy luận AI tạo sinh trên chuẩn đánh giá MLPerf mới

- MLPerf 4.0 là bản cập nhật mới nhất của chuẩn đánh giá hiệu năng suy luận AI, lần đầu tiên bao gồm mô hình ngôn ngữ lớn Llama 2 70 tỷ tham số và tạo ảnh với Stable Diffusion.

- Nvidia gần như tăng gấp 3 lần hiệu năng suy luận cho tóm tắt văn bản với mô hình GPT-J trên GPU H100 Hopper, chỉ trong vòng 6 tháng.

- GPU H200 mới của Nvidia cho kết quả nhanh hơn đến 45% so với H100 khi đánh giá bằng Llama 2.

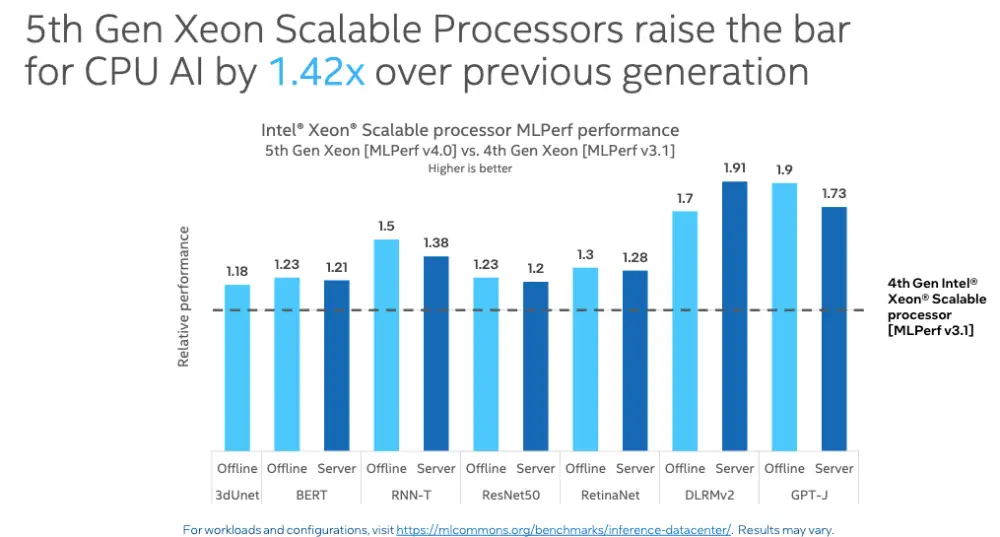

- Bộ xử lý Intel Xeon thế hệ thứ 5 nhanh hơn 1,42 lần so với thế hệ thứ 4 trên nhiều hạng mục MLPerf, và nhanh hơn đến 1,9 lần với GPT-J.

- Mặc dù kết quả thực tế của Intel Habana Gaudi thua kém Nvidia H100, công ty cho rằng nó cung cấp hiệu năng trên đơn vị giá tốt hơn.

- MLPerf giúp đo lường và cải thiện tốc độ, hiệu quả và độ chính xác cho AI, đồng thời hỗ trợ doanh nghiệp đưa ra quyết định sáng suốt khi mua hệ thống.

📌 Chuẩn đánh giá MLPerf 4.0 mới nhất cho thấy Nvidia đã tăng gấp 3 lần hiệu năng suy luận AI tạo sinh chỉ trong 6 tháng với GPU H100, trong khi Intel Xeon thế hệ thứ 5 nhanh hơn đến 1,9 lần so với thế hệ trước. Việc đo lường chuẩn hóa hiệu năng AI giúp thúc đẩy cải tiến và hỗ trợ các doanh nghiệp đưa ra lựa chọn đúng đắn.

https://venturebeat.com/ai/nvidia-triples-and-intel-doubles-generative-ai-inference-performance-on-new-mlperf-benchmark/

Thảo luận

Follow Us

Tin phổ biến