Octopus v2 của Stanford vượt trội GPT-4, chạy được trên điện thoại, nhanh hơn 36 lần so với Llama7B + RAG

- Octopus v2 của các nhà nghiên cứu Stanford có 2 tỷ tham số, chạy được trên smartphone, ô tô, PC, vượt trội GPT-4 về độ chính xác và độ trễ, giảm 95% độ dài ngữ cảnh.

- Octopus v2 nhanh hơn 36 lần so với phương pháp Llama7B + RAG, đạt 2000 lượt tải xuống chỉ sau 1 đêm ra mắt.

- Mô hình sử dụng chiến lược token hàm độc đáo trong huấn luyện và suy luận, giúp đạt hiệu năng tương đương GPT-4 và cải thiện tốc độ suy luận vượt trội so với các phương pháp dựa trên RAG.

- Tập dữ liệu huấn luyện được tạo qua 3 giai đoạn: tạo truy vấn liên quan và tham số gọi hàm, tạo truy vấn không liên quan từ các thành phần hàm phù hợp, xác minh nhị phân qua Google Gemini.

- Nghiên cứu sử dụng mô hình Google Gemma-2B làm mô hình tiền huấn luyện, áp dụng 2 phương pháp huấn luyện là huấn luyện mô hình đầy đủ và huấn luyện mô hình LoRA.

- Trong các bài kiểm tra, Octopus v2 nhanh hơn 36 lần so với "giải pháp Llama7B + RAG" trên 1 GPU A100 đơn, nhanh hơn 168% so với GPT-4 turbo.

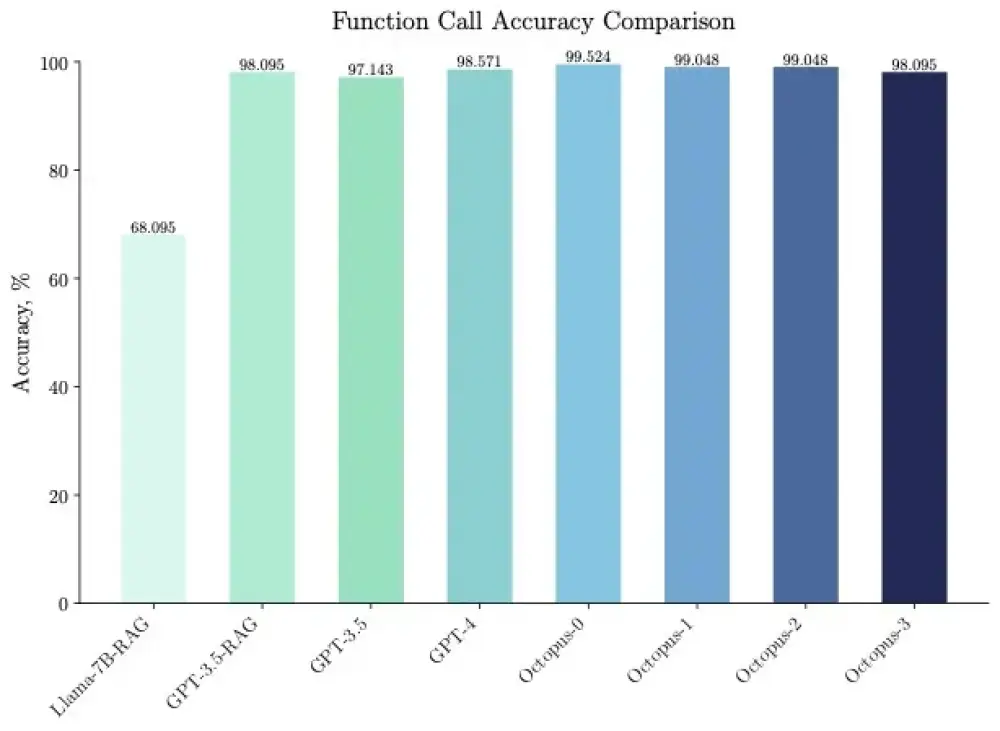

- Octopus v2 cũng vượt trội về độ chính xác gọi hàm, cao hơn 31% so với "giải pháp Llama7B + RAG", đạt độ chính xác tương đương GPT-4 và RAG + GPT-3.5.

📌 Octopus v2 với 2 tỷ tham số của Stanford đã vượt trội GPT-4 về tốc độ suy luận và độ chính xác, có thể chạy trên các thiết bị biên như smartphone. Mô hình đạt 2000 lượt tải chỉ sau 1 đêm, mở ra kỷ nguyên của các agent AI từ cốt lõi chạy trên thiết bị người dùng.

https://levelup.gitconnected.com/better-than-gpt-4-the-stanford-teams-large-model-that-can-be-run-on-mobile-phones-became-popular-bc958501ec01

https://arxiv.org/abs/2404.01744

https://huggingface.co/NexaAIDev/Octopus-v2

Thảo luận

Follow Us

Tin phổ biến