plugin chatgpt của bên thứ ba có thể dẫn đến việc tài khoản bị chiếm quyền kiểm soát

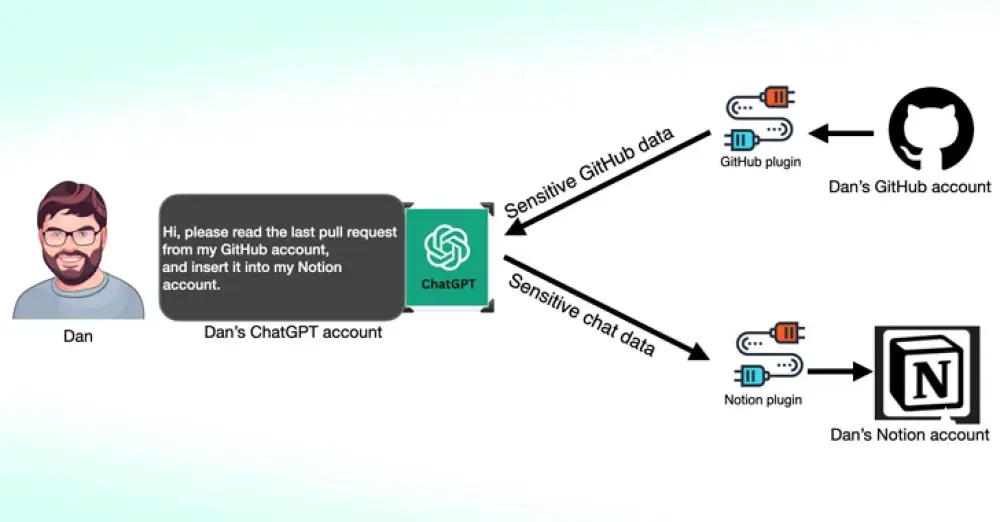

- Các nhà nghiên cứu bảo mật của Salt Labs phát hiện ra rằng các plugin của bên thứ ba dành cho ChatGPT có thể trở thành mặt tấn công mới cho các đối tượng đe dọa nhằm truy cập trái phép vào dữ liệu nhạy cảm.

- Các lỗ hổng được tìm thấy trực tiếp trong ChatGPT và hệ sinh thái của nó có thể cho phép kẻ tấn công cài đặt các plugin độc hại mà không cần sự đồng ý của người dùng và chiếm quyền kiểm soát tài khoản trên các trang web của bên thứ ba như GitHub.

- Một trong những lỗ hổng được Salt Labs phát hiện liên quan đến việc khai thác quy trình OAuth để lừa người dùng cài đặt plugin tùy ý bằng cách lợi dụng thực tế là ChatGPT không xác thực liệu người dùng có thực sự bắt đầu cài đặt plugin hay không. Điều này có thể cho phép các đối tượng đe dọa chặn và trích xuất tất cả dữ liệu do nạn nhân chia sẻ, có thể chứa thông tin độc quyền.

- Công ty bảo mật cũng phát hiện ra các vấn đề với PluginLab có thể được các đối tượng đe dọa sử dụng để thực hiện các cuộc tấn công chiếm quyền kiểm soát tài khoản zero-click, cho phép chúng kiểm soát tài khoản của một tổ chức trên các trang web của bên thứ ba như GitHub và truy cập vào kho lưu trữ mã nguồn của họ.

- Lỗ hổng thao túng chuyển hướng OAuth cũng được phát hiện trong một số plugin, bao gồm Kesem AI, có thể cho phép kẻ tấn công đánh cắp thông tin đăng nhập tài khoản liên kết với chính plugin bằng cách gửi một liên kết đặc biệt tới nạn nhân.

- Các phát hiện này xuất hiện vài tuần sau khi Imperva mô tả hai lỗ hổng cross-site scripting (XSS) trong ChatGPT có thể được kết hợp để chiếm quyền kiểm soát bất kỳ tài khoản nào.

- Vào tháng 12/2023, nhà nghiên cứu bảo mật Johann Rehberger đã chứng minh cách các tác nhân độc hại có thể tạo ra các GPT tùy chỉnh có thể lừa đảo thông tin đăng nhập của người dùng và truyền dữ liệu bị đánh cắp đến máy chủ bên ngoài.

- Một cuộc tấn công kênh phụ LLM mới sử dụng độ dài token làm phương tiện bí mật để trích xuất các phản hồi được mã hóa từ AI Assistants qua web. Kẻ tấn công có thể suy ra thông tin nhạy cảm và bí mật được chia sẻ trong các cuộc trò chuyện riêng tư của trợ lý AI bằng cách chặn lưu lượng mạng.

- Để chống lại hiệu quả của cuộc tấn công kênh phụ, các công ty phát triển trợ lý AI nên áp dụng đệm ngẫu nhiên để che giấu độ dài thực tế của các token, truyền các token trong các nhóm lớn hơn thay vì riêng lẻ và gửi phản hồi hoàn chỉnh cùng một lúc, thay vì theo kiểu từng token một.

📌 Các lỗ hổng bảo mật trong ChatGPT và hệ sinh thái plugin của nó có thể cho phép kẻ tấn công cài đặt plugin độc hại, chiếm quyền kiểm soát tài khoản và trích xuất thông tin nhạy cảm. Các cuộc tấn công kênh phụ mới cũng có thể suy ra dữ liệu bí mật từ các cuộc trò chuyện trợ lý AI.

https://thehackernews.com/2024/03/third-party-chatgpt-plugins-could-lead.html?m=1

Thảo luận

Follow Us

Tin phổ biến