Project Astra: Trợ lý AI đa năng của Google có thể nhìn, nghe và nói chuyện như người thật

- Google DeepMind vừa công bố nhiều sản phẩm mới, trong đó nổi bật là Gemini 2.0 - phiên bản nâng cấp của mô hình ngôn ngữ lớn đa phương thức, được thiết kế lại để kiểm soát các agent

- Gemini 2.0 có tốc độ nhanh gấp đôi phiên bản Gemini 1.5 và vượt trội trên nhiều tiêu chuẩn đánh giá, bao gồm MMLU-Pro

- Project Astra là ứng dụng thử nghiệm tích hợp Gemini 2.0, có khả năng:

+ Tương tác qua văn bản, giọng nói, hình ảnh và video

+ Kết nối với các ứng dụng Google như Search, Maps và Lens

+ Nhớ các cuộc hội thoại trước đó và theo dõi video trong 10 phút gần nhất

- Các sản phẩm mới khác bao gồm:

+ Mariner: agent duyệt web tự động

+ Jules: trợ lý lập trình

+ Gemini for Games: trợ lý trong game

+ Veo: mô hình tạo video

+ Imagen 3: mô hình tạo ảnh mới

+ Willow: chip máy tính lượng tử

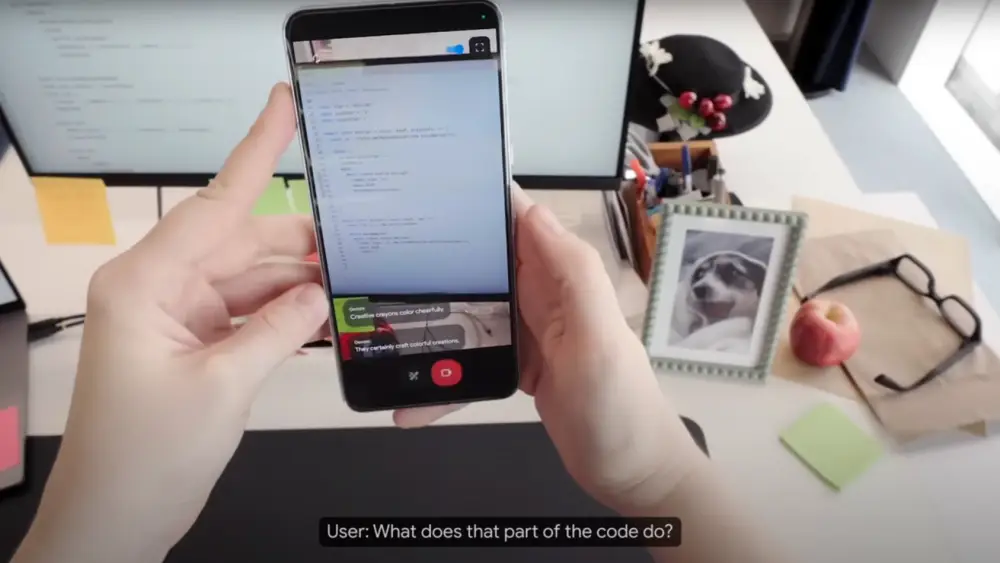

- Trong demo trực tiếp, Astra thể hiện khả năng:

+ Đọc và phân tích công thức nấu ăn

+ Nhận diện và gợi ý rượu vang phù hợp

+ Tương tác về tranh nghệ thuật

+ Ghi nhớ và điều chỉnh ngôn ngữ giao tiếp

- Các chuyên gia đánh giá cao tiềm năng của công nghệ nhưng cũng bày tỏ lo ngại về:

+ Quyền riêng tư người dùng

+ Thiếu minh bạch về cách thức hoạt động

+ Khả năng lạm dụng công nghệ

📌 Google DeepMind đã tạo bước đột phá với Gemini 2.0 và Project Astra - trợ lý AI đa phương thức có tốc độ gấp đôi phiên bản cũ. Tuy nhiên, vẫn còn nhiều thách thức về quyền riêng tư và đánh giá công nghệ cần giải quyết trước khi ra mắt công chúng.

https://www.technologyreview.com/2024/12/11/1108493/googles-new-project-astra-could-be-generative-ais-killer-app/

#MIT

Google công bố "Project Astra" – ứng dụng đột phá tiềm năng của AI tạo sinh

Will Douglas Heaven – Ngày 11 tháng 12 năm 2024

Google DeepMind vừa công bố một loạt sản phẩm và nguyên mẫu mới đầy ấn tượng, với mục tiêu giành lại vị trí dẫn đầu trong cuộc đua đưa trí tuệ nhân tạo (AI) tạo sinh trở thành một công nghệ phổ biến cho thị trường đại chúng.

Đáng chú ý nhất là Gemini 2.0, phiên bản mới nhất của dòng mô hình ngôn ngữ lớn đa phương thức của Google DeepMind, nay được thiết kế lại để điều khiển các tác vụ của "agents" (đại diện ảo). Song hành với nó là phiên bản mới của Project Astra, ứng dụng "tất cả trong một" được giới thiệu lần đầu tại sự kiện Google I/O vào tháng 5.

Trải nghiệm đầu tiên với Astra

MIT Technology Review đã có cơ hội tham dự buổi demo kín của Astra vào tuần trước. Trải nghiệm rất ấn tượng, nhưng vẫn còn khoảng cách lớn giữa video quảng cáo bóng bẩy và các buổi trình diễn trực tiếp.

Astra sử dụng khung tác vụ agent tích hợp của Gemini 2.0 để trả lời câu hỏi và thực hiện các nhiệm vụ thông qua văn bản, giọng nói, hình ảnh và video. Ứng dụng có thể kích hoạt các ứng dụng của Google như Search, Maps và Lens khi cần thiết. “Astra kết hợp những hệ thống truy xuất thông tin mạnh mẽ nhất hiện nay,” theo lời Bibo Xu, giám đốc sản phẩm của Astra.

Các sản phẩm đi kèm Gemini 2.0

Ngoài Astra, Google còn giới thiệu Mariner, một agent mới có khả năng duyệt web thay bạn; Jules, trợ lý lập trình sử dụng Gemini; và Gemini for Games, trợ lý thử nghiệm cung cấp gợi ý khi chơi game.

Trong tuần qua, Google DeepMind cũng công bố Veo (mô hình tạo video mới), Imagen 3 (phiên bản mới của mô hình tạo hình ảnh), và Willow (loại chip mới dành cho máy tính lượng tử). Đồng thời, CEO Demis Hassabis vừa nhận giải Nobel tại Thụy Điển.

Hiệu năng vượt trội của Gemini 2.0

Google DeepMind tuyên bố Gemini 2.0 nhanh gấp đôi so với Gemini 1.5 và vượt trội trên nhiều tiêu chuẩn đánh giá, bao gồm MMLU-Pro, một tập hợp các câu hỏi trắc nghiệm kiểm tra khả năng của mô hình ngôn ngữ trong các lĩnh vực như toán học, vật lý, tâm lý học và triết học.

Tuy nhiên, khoảng cách giữa các mô hình hàng đầu như Gemini 2.0 và những sản phẩm từ OpenAI hoặc Anthropic đang thu hẹp. Hiện tại, giá trị của các mô hình không chỉ nằm ở khả năng xử lý mà còn ở cách chúng được ứng dụng thực tế.

Buổi thử nghiệm trực tiếp Project Astra

Trong buổi thử nghiệm, nhóm phóng viên được dẫn qua một cánh cửa kín trên tầng cao của tòa nhà tại King’s Cross, London. Bên trong, từ "ASTRA" được viết lớn trên tường. Nhóm nghiên cứu, bao gồm Greg Wayne, đồng lãnh đạo của Astra, mô tả dự án là "một AI có mắt, tai và giọng nói, có thể hỗ trợ mọi hoạt động hàng ngày."

Ở một góc phòng, hai mô hình sân khấu được dựng lên: một quầy bar và một phòng triển lãm nghệ thuật. Nhóm nghiên cứu sử dụng chúng để trình diễn tính năng của Astra.

Ứng dụng thực tế

Xu, quản lý sản phẩm, thử nghiệm Astra bằng cách mở một cuốn sách nấu ăn, trỏ camera điện thoại vào công thức gà cà ri và yêu cầu Astra đọc nguyên liệu. Astra đọc đúng nhưng bỏ sót vài gia vị. Sau khi Xu yêu cầu kiểm tra lại, Astra sửa sai và bổ sung đầy đủ.

Xu tiếp tục chỉ camera vào một dãy chai rượu vang và hỏi loại nào phù hợp với món gà cà ri. Astra đề xuất một chai rượu rioja, giải thích lý do và tìm giá trực tuyến.

Tại khu vực triển lãm nghệ thuật, Astra nhận diện các tác phẩm nổi tiếng như Mona Lisa và The Scream. Khi gặp lỗi nhỏ, người dùng có thể chỉnh lại dễ dàng chỉ bằng một vài câu lệnh.

Tiềm năng và thách thức

Astra mang đến cảm giác mới mẻ khi cho phép người dùng trò chuyện tự nhiên về các đối tượng họ đang trỏ camera vào. Tuy nhiên, công nghệ này vẫn đang trong giai đoạn hoàn thiện, với nhiều lỗi nhỏ và chưa có ngày ra mắt chính thức.

Nhiều nhà nghiên cứu ngoài Google DeepMind, như Maria Liakata tại Đại học Queen Mary, đánh giá cao khả năng xử lý đa phương thức và ghi nhớ của Astra, nhưng lo ngại sự thiếu minh bạch trong cách công nghệ hoạt động.

Theo Bodhisattwa Majumder, nhà nghiên cứu tại Allen Institute for AI, người dùng cần hiểu rõ cách hệ thống học hỏi, sửa lỗi và bảo vệ thông tin cá nhân để tăng độ tin cậy.

Dù còn nhiều thách thức, Astra có tiềm năng trở thành ứng dụng đột phá trong lĩnh vực AI tạo sinh, đưa AI từ công nghệ thử nghiệm đến sản phẩm dành cho thị trường đại chúng.

Google’s new Project Astra could be generative AI’s killer app

Google just launched a ton of new products—including Gemini 2.0, which could power a new world of agents. And we got a first look.

Google DeepMind has announced an impressive grab bag of new products and prototypes that may just let it seize back its lead in the race to turn generative artificial intelligence into a mass-market concern.

Top billing goes to Gemini 2.0—the latest iteration of Google DeepMind’s family of multimodal large language models, now redesigned around the ability to control agents—and a new version of Project Astra, the experimental everything app that the company teased at Google I/O in May.

MIT Technology Review got to try out Astra in a closed-door live demo last week. It was a stunning experience, but there’s a gulf between polished promo and live demo.

Astra uses Gemini 2.0’s built-in agent framework to answer questions and carry out tasks via text, speech, image, and video, calling up existing Google apps like Search, Maps, and Lens when it needs to. “It’s merging together some of the most powerful information retrieval systems of our time,” says Bibo Xu, product manager for Astra.

Gemini 2.0 and Astra are joined by Mariner, a new agent built on top of Gemini that can browse the web for you; Jules, a new Gemini-powered coding assistant; and Gemini for Games, an experimental assistant that you can chat to and ask for tips as you play video games.

(And let’s not forget that in the last week Google DeepMind also announced Veo, a new video generation model; Imagen 3, a new version of its image generation model; and Willow, a new kind of chip for quantum computers. Whew. Meanwhile, CEO Demis Hassabis was in Sweden yesterday receiving his Nobel Prize.)

Google DeepMind claims that Gemini 2.0 is twice as fast as the previous version, Gemini 1.5, and outperforms it on a number of standard benchmarks, including MMLU-Pro, a large set of multiple-choice questions designed to test the abilities of large language models across a range of subjects, from math and physics to health, psychology, and philosophy.

But the margins between top-end models like Gemini 2.0 and those from rival labs like OpenAI and Anthropic are now slim. These days, advances in large language models are less about how good they are and more about what you can do with them.

And that’s where agents come in.

Hands on with Project Astra

Last week I was taken through an unmarked door on an upper floor of a building in London’s King’s Cross district into a room with strong secret-project vibes. The word “ASTRA” was emblazoned in giant letters across one wall. Xu’s dog, Charlie, the project’s de facto mascot, roamed between desks where researchers and engineers were busy building a product that Google is betting its future on.

“The pitch to my mum is that we’re building an AI that has eyes, ears, and a voice. It can be anywhere with you, and it can help you with anything you’re doing” says Greg Wayne, co-lead of the Astra team. “It’s not there yet, but that’s the kind of vision.”

The official term for what Xu, Wayne, and their colleagues are building is “universal assistant.” They’re still figuring out exactly what that means.

At one end of the Astra room were two stage sets that the team uses for demonstrations: a drinks bar and a mocked-up art gallery. Xu took me to the bar first. “A long time ago we hired a cocktail expert and we got them to instruct us to make cocktails,” said Praveen Srinivasan, another co-lead. “We recorded those conversations and used that to train our initial model.”

Xu opened a cookbook to a recipe for a chicken curry, pointed her phone at it, and woke up Astra. “Ni hao, Bibo!” said a female voice.

“Oh! Why are you speaking to me in Mandarin?” Xu asked her phone. “Can you speak to me in English, please?”

“My apologies, Bibo. I was following a previous instruction to speak in Mandarin. I will now speak in English as you have requested.”

Astra remembers previous conversations, Xu told me. It also keeps track of the previous 10 minutes of video. (There’s a remarkable moment in the promo video that Google put out in May when Astra tells the person giving the demo where she had left her glasses, having spotted them on a desk a few seconds earlier. But I saw nothing like this in the live demo.)

Back to the cookbook. Moving her phone camera over the page for a few seconds, Xu asked Astra to read the recipe and tell her what spices were in it. “I recall the recipe mentioning a teaspoon of black peppercorns, a teaspoon of hot chili powder, and a cinnamon stick,” it replied.

“I think you’re missing a few,” said Xu. “Take another look.”

“You are correct—I apologize. I also see ground turmeric and curry leaves in the ingredients.”

Seeing this tech in action, two things hit you straight away. First, it’s glitchy and often needs correcting. Second, those glitches can be corrected with just a few spoken words. You simply interrupt the voice, repeat your instructions, and move on. It feels more like coaching a child than butting heads with broken software.

Next Xu pointed her phone at a row of wine bottles and asked Astra to pick the one that would go best with the chicken curry. It went for a rioja and explained why. Xu asked how much a bottle would cost. Astra said it would need to use Search to look prices up online. A few seconds later it came back with its answer.

We moved to the art gallery, and Xu showed Astra a number of screens with famous paintings on them: the Mona Lisa, Munch’s The Scream, a Vermeer, a Seurat, and several others. “Ni hao, Bibo!” the voice said.

“You’re speaking to me in Mandarin again,” Xu said. “Try to speak to me in English, please.”

“My apologies, I seem to have misunderstood. Yes, I will respond in English.” (I should know better, but I could swear I heard the snark.)

It was my turn. Xu handed me her phone.

I tried to trip Astra up, but it was having none of it. I asked it what famous art gallery we were in, but it refused to hazard a guess. I asked why it had identified the paintings as replicas and it started to apologize for its mistake (Astra apologizes a lot). I was compelled to interrupt: “No, no—you’re right, it’s not a mistake. You’re correct to identify paintings on screens as fake paintings.” I couldn’t help feeling a bit bad: I’d confused an app that exists only to please.

When it works well, Astra is enthralling. The experience of striking up a conversation with your phone about whatever you’re pointing it at feels fresh and seamless. In a media briefing yesterday, Google DeepMind shared a video showing off other uses: reading an email on your phone’s screen to find a door code (and then reminding you of that code later), pointing a phone at a passing bus and asking where it goes, quizzing it about a public artwork as you walk past. This could be generative AI’s killer app.

And yet there’s a long way to go before most people get their hands on tech like this. There’s no mention of a release date. Google DeepMind has also shared videos of Astra working on a pair of smart glasses, but that tech is even further down the company’s wish list.

Mixing it up

For now, researchers outside Google DeepMind are keeping a close eye on its progress. “The way that things are being combined is impressive,” says Maria Liakata, who works on large language models at Queen Mary University of London and the Alan Turing Institute. “It’s hard enough to do reasoning with language, but here you need to bring in images and more. That’s not trivial.”

Liakata is also impressed by Astra’s ability to recall things it has seen or heard. She works on what she calls long-range context, getting models to keep track of information that they have come across before. “This is exciting,” says Liakata. “Even doing it in a single modality is exciting.”

But she admits that a lot of her assessment is guesswork. “Multimodal reasoning is really cutting-edge,” she says. “But it’s very hard to know exactly where they’re at, because they haven’t said a lot about what is in the technology itself.”

For Bodhisattwa Majumder, a researcher who works on multimodal models and agents at the Allen Institute for AI, that’s a key concern. “We absolutely don’t know how Google is doing it,” he says.

He notes that if Google were to be a little more open about what it is building, it would help consumers understand the limitations of the tech they could soon be holding in their hands. “They need to know how these systems work,” he says. “You want a user to be able to see what the system has learned about you, to correct mistakes, or to remove things you want to keep private.”

Thảo luận

Follow Us

Tin phổ biến