Reflection 70B bị tố cáo gian lận và hiệu suất kém

- Reflection 70B, một biến thể của mô hình ngôn ngữ lớn (LLM) nguồn mở Llama 3.1 của Meta, được HyperWrite (trước đây là OthersideAI) - một công ty khởi nghiệp nhỏ ở New York - huấn luyện và phát hành. Reflection 70B đã khoe khoang về các kết quả đánh giá ấn tượng và dẫn đầu trên các bài kiểm tra của bên thứ ba.

- Tuy nhiên, chỉ sau một cuối tuần, vương miện của "vua" AI nguồn mở mới này đã bị phai nhạt khi các nhà đánh giá độc lập khác không thể tái hiện một số chỉ số hiệu suất được tuyên bố.

- Tổ chức Artificial Analysis đã công bố phân tích riêng cho thấy điểm số MMLU của Reflection Llama 3.170B thấp hơn đáng kể so với Llama 3.1 70B của Meta, mâu thuẫn lớn với kết quả ban đầu của HyperWrite.

- Matt Shumer, đồng sáng lập và CEO của HyperWrite, đã thừa nhận rằng trọng số của Reflection 70B đã bị "lỗi" trong quá trình tải lên Hugging Face, có thể dẫn đến hiệu suất kém hơn so với phiên bản "API nội bộ" của công ty.

- Artificial Analysis sau đó được cấp quyền truy cập vào một API riêng và nhận thấy hiệu suất ấn tượng nhưng không ở mức độ như các tuyên bố ban đầu. Tổ chức này đặt ra hai câu hỏi then chốt về lý do tại sao phiên bản được công bố lại khác với phiên bản họ kiểm tra và lý do tại sao trọng số của phiên bản họ kiểm tra chưa được phát hành.

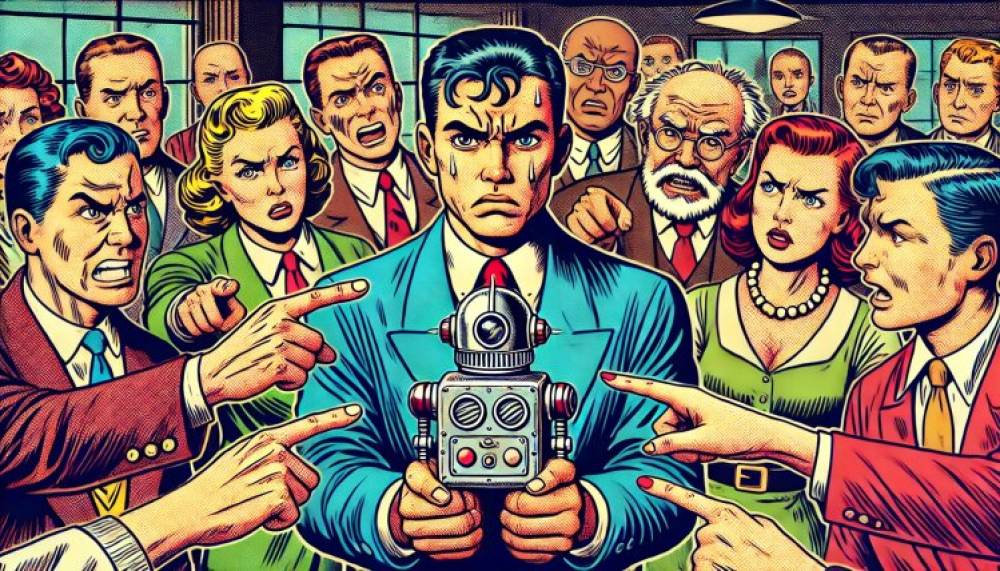

- Người dùng trên các cộng đồng Reddit về học máy và AI cũng đặt nghi vấn về hiệu suất và nguồn gốc được tuyên bố của Reflection 70B, với ít nhất một người dùng X tố cáo Shumer "gian lận trong cộng đồng nghiên cứu AI".

📌 Phản ứng dữ dội trước những cáo buộc gian lận và hiệu suất không đạt yêu cầu của mô hình AI nguồn mở mới nhất Reflection 70B, các nhà phân tích độc lập đặt nhiều câu hỏi về các tuyên bố hiệu suất ban đầu của HyperWrite. Các bằng chứng cho thấy Reflection 70B có thể không phải là phiên bản Llama 3.1 hàng đầu như tuyên bố.

https://venturebeat.com/ai/new-open-source-ai-leader-reflection-70bs-performance-questioned-accused-of-fraud/

Thảo luận

Follow Us

Tin phổ biến