Researchers from Tsinghua University Introduce LLM4VG: A Novel AI Benchmark for Evaluating LLMs on Video Grounding Tasks

- Nghiên cứu mới về LLMs trong phân tích video cho thấy tiềm năng lớn trong việc xác định đoạn video dựa trên mô tả văn bản.

- Thách thức chính của Video Grounding (VG) là xác định chính xác ranh giới thời gian của các đoạn video.

- LLMs đã thành công trong nhiều lĩnh vực nhưng hiệu quả trong VG vẫn cần được khám phá thêm.

- Nghiên cứu từ Đại học Thanh Hoa giới thiệu 'LLM4VG', một chuẩn mực đánh giá hiệu suất LLMs trong VG.

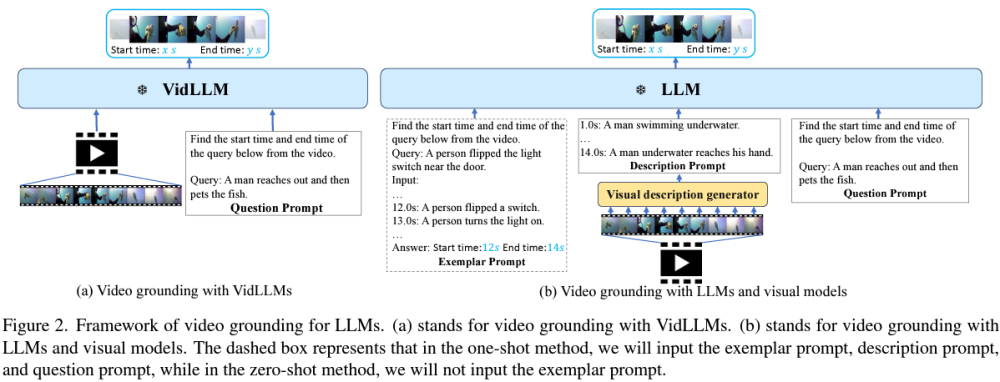

- Hai chiến lược được xem xét: VidLLMs được huấn luyện trực tiếp trên dữ liệu text-video và kết hợp LLMs thông thường với mô hình hình ảnh đã huấn luyện trước.

- Các mô hình đồ họa chuyển đổi nội dung video thành mô tả văn bản, giúp kết nối thông tin hình ảnh và văn bản.

- VidLLMs chưa đạt hiệu suất VG mong muốn, trong khi kết hợp LLMs với mô hình hình ảnh cho thấy khả năng ban đầu.

📌 Nghiên cứu này mở đường cho việc đánh giá sâu rộng về khả năng của LLMs trong nhiệm vụ Video Grounding, đề cập đến việc cần có những phương pháp tiên tiến hơn trong huấn luyện mô hình và thiết kế câu hỏi. VidLLMs cần hiểu sâu hơn về yếu tố thời gian, trong khi việc tích hợp LLMs với mô hình hình ảnh mở ra hướng đi mới, là bước tiến quan trọng trong lĩnh vực này. Kết quả nghiên cứu không chỉ làm sáng tỏ tình trạng hiện tại của LLMs trong nhiệm vụ Video Grounding mà còn tạo đà cho những tiến bộ tương lai, có tiềm năng làm thay đổi cách phân tích và hiểu nội dung video.

Thảo luận

Follow Us

Tin phổ biến

TAG

AI giáo dục

AI sinh-y-duoc

AI nghệ thuật

AI pháp lý-quản trị-chủ quyền

AI models

AI xã hội

AI prompts

AI kiến thức-khóa học

AI công nghiệp-lĩnh vực

AI edge

AI viễn thông

AI tools

AI chính phủ

AI cybersecurity

AI so sánh

AI đạo đức

AI tips

AI market

AI quân sự

AI an toàn-an ninh-techwar

AI việc làm

AI doanh nghiệp

OpenAI ChatGPT

AI môi trường-năng lượng

AI skill-talent

AI & công nghệ khác

AI nghiên cứu

AI chips-hardware-compute

AI vs con người

AI coding assistant

AI mở-nguồn mở

AI năng suất

AI startup-M&A

AI tương lai

AI báo chí

AI data

AI bản quyền

AI PC

AI riêng tư

AI deepfake-ảo giác-ANTT

AI ảnh-video-music-âm thanh

AI minh bạch

AI nhỏ

AI nông nghiệp-thực phẩm

AI ngân hàng-tài chính

AI giao thông

AI smartphone

AI robotics-auto-agents

AI consumer devices

AI manufacturing

AI benchmark

Telecom

AI thành công-thất bại

Digital

Semi-Cloud-DC-Green

HTS

STI

FAQ