Sau 7 tháng chờ đợi, ChatGPT chính thức ra mắt tính năng phân tích video thời gian thực

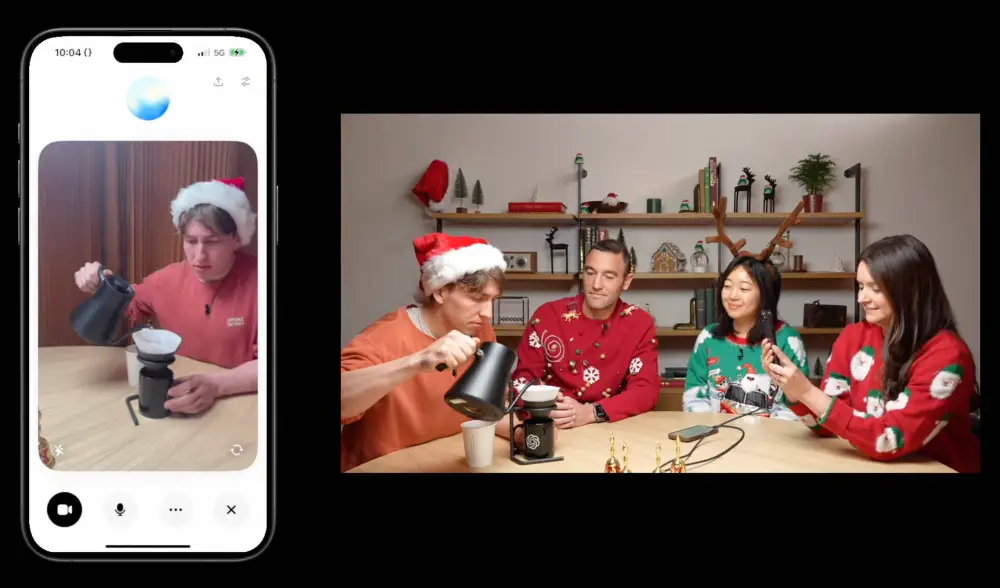

- OpenAI chính thức triển khai tính năng phân tích video thời gian thực cho ChatGPT, sau 7 tháng kể từ lần demo đầu tiên

- Tính năng Advanced Voice Mode mới cho phép:

+ Người dùng ChatGPT Plus, Team và Pro có thể hướng camera điện thoại vào vật thể để nhận phản hồi tức thì

+ Chia sẻ màn hình để ChatGPT hiểu và giải thích menu cài đặt hoặc gợi ý giải bài toán

+ Kích hoạt bằng cách nhấn biểu tượng voice cạnh thanh chat, sau đó chọn biểu tượng video

- Lộ trình triển khai:

+ Bắt đầu từ ngày 12/12/2024

+ Hoàn tất trong vòng 1 tuần

+ Người dùng ChatGPT Enterprise và Edu phải đợi đến tháng 1/2025

+ Chưa có kế hoạch triển khai tại EU, Thụy Sĩ, Iceland, Na Uy và Liechtenstein

- Trong demo trên CNN "60 Minutes":

+ Chủ tịch OpenAI Greg Brockman đã thử nghiệm tính năng với Anderson Cooper

+ ChatGPT có thể nhận diện và phân tích bản vẽ giải phẫu của Cooper

+ Tuy nhiên vẫn còn sai sót khi giải bài toán hình học, cho thấy khả năng ảo giác

- Đối thủ cạnh tranh:

+ Google đang thử nghiệm Project Astra với nhóm người dùng tin cậy trên Android

+ Meta cũng đang phát triển tính năng tương tự

- OpenAI cũng ra mắt "Santa Mode":

+ Thêm giọng nói ông già Noel vào ChatGPT

+ Kích hoạt bằng biểu tượng bông tuyết cạnh thanh prompt

📌 Sau nhiều lần trì hoãn, OpenAI cuối cùng đã triển khai tính năng phân tích video thời gian thực cho ChatGPT Plus, Team và Pro. Tính năng này cho phép tương tác bằng giọng nói, phân tích hình ảnh trực tiếp và chia sẻ màn hình, mặc dù vẫn còn một số hạn chế về độ chính xác và phạm vi triển khai.

https://techcrunch.com/2024/12/12/chatgpt-now-understands-real-time-video-seven-months-after-openai-first-demoed-it/

Thảo luận

Follow Us

Tin phổ biến