Skywork Team ra mắt Skywork-MOE: 146 tỷ tham số và hiệu suất vượt trội

- Skywork Team, thuộc Kunlun Inc., đã giới thiệu Skywork-MoE, một mô hình Mixture-of-Experts (MoE) hiệu suất cao với 146 tỷ tham số và 16 chuyên gia.

- Skywork-MoE được xây dựng dựa trên kiến trúc của mô hình Skywork-13B trước đó, sử dụng các điểm kiểm tra dày đặc làm thiết lập ban đầu.

- Mô hình này tích hợp hai kỹ thuật đào tạo mới: chuẩn hóa logit cổng và hệ số mất mát phụ trợ thích ứng, nhằm nâng cao hiệu suất và hiệu quả của mô hình.

- Skywork-MoE được đào tạo từ các điểm kiểm tra dày đặc của mô hình Skywork-13B, khởi tạo từ các mô hình dày đặc đã được đào tạo trước trên 3,2 nghìn tỷ token và tiếp tục đào tạo trên thêm 2 nghìn tỷ token.

- Kỹ thuật chuẩn hóa logit cổng đảm bảo phân phối đầu ra cổng rõ ràng, tăng cường sự đa dạng của các chuyên gia. Phương pháp này bao gồm việc chuẩn hóa các đầu ra của lớp cổng trước khi áp dụng hàm softmax, giúp đạt được phân phối sắc nét và tập trung hơn.

- Hệ số mất mát phụ trợ thích ứng cho phép điều chỉnh theo từng lớp, duy trì tải cân bằng giữa các chuyên gia và ngăn chặn bất kỳ chuyên gia nào bị quá tải. Các điều chỉnh này dựa trên việc giám sát tỷ lệ rơi token và điều chỉnh các hệ số tương ứng.

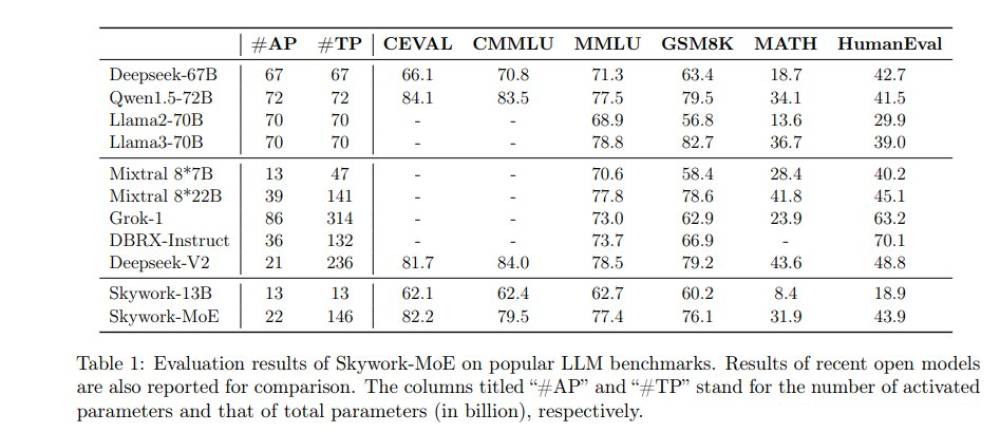

- Hiệu suất của Skywork-MoE được đánh giá trên nhiều tiêu chuẩn khác nhau. Mô hình đạt 82,2 điểm trên tiêu chuẩn CEVAL và 79,5 điểm trên tiêu chuẩn CMMLU, vượt qua mô hình Deepseek-67B.

- Trên tiêu chuẩn MMLU, Skywork-MoE đạt 77,4 điểm, cạnh tranh với các mô hình có dung lượng cao hơn như Qwen1.5-72B.

- Đối với các nhiệm vụ suy luận toán học, Skywork-MoE đạt 76,1 điểm trên GSM8K và 31,9 điểm trên MATH, vượt qua các mô hình như Llama2-70B và Mixtral 8*7B.

- Skywork-MoE thể hiện hiệu suất mạnh mẽ trong các nhiệm vụ tổng hợp mã với 43,9 điểm trên tiêu chuẩn HumanEval, vượt qua tất cả các mô hình dày đặc trong so sánh và chỉ thua kém một chút so với mô hình Deepseek-V2.

- Những kết quả này nhấn mạnh khả năng của mô hình trong việc xử lý hiệu quả các nhiệm vụ suy luận định lượng và logic phức tạp.

📌 Skywork-MoE, với 146 tỷ tham số và các phương pháp đào tạo tiên tiến, đã đạt được hiệu suất mạnh mẽ trên nhiều tiêu chuẩn, chứng minh hiệu quả của các kỹ thuật chuẩn hóa logit cổng và hệ số mất mát phụ trợ thích ứng. Mô hình này đặt ra một tiêu chuẩn mới cho hiệu quả và hiệu suất của các mô hình MoE trong xử lý ngôn ngữ quy mô lớn.

https://www.marktechpost.com/2024/06/05/skywork-team-introduces-skywork-moe-a-high-performance-mixture-of-experts-moe-model-with-146b-parameters-16-experts-and-22b-activated-parameters/

Thảo luận

Follow Us

Tin phổ biến